Bài đăng này được đồng viết với Chaoyang He, Al Nevarez và Salman Avestimehr từ FedML.

Nhiều tổ chức đang triển khai học máy (ML) để nâng cao khả năng ra quyết định kinh doanh của họ thông qua tự động hóa và sử dụng các bộ dữ liệu phân tán lớn. Với khả năng truy cập dữ liệu ngày càng tăng, ML có tiềm năng cung cấp những hiểu biết và cơ hội kinh doanh tuyệt vời. Tuy nhiên, việc chia sẻ thông tin nhạy cảm thô, chưa được vệ sinh ở các địa điểm khác nhau gây ra rủi ro đáng kể về bảo mật và quyền riêng tư, đặc biệt là trong các ngành được quản lý như chăm sóc sức khỏe.

Để giải quyết vấn đề này, học liên kết (FL) là một kỹ thuật đào tạo ML mang tính cộng tác và phi tập trung nhằm mang lại sự riêng tư cho dữ liệu trong khi vẫn duy trì độ chính xác và trung thực. Không giống như đào tạo ML truyền thống, đào tạo FL diễn ra ở một vị trí khách hàng biệt lập bằng cách sử dụng phiên bảo mật độc lập. Máy khách chỉ chia sẻ các tham số mô hình đầu ra của mình với một máy chủ tập trung, được gọi là máy chủ điều phối đào tạo hoặc máy chủ tổng hợp chứ không chia sẻ dữ liệu thực tế được sử dụng để đào tạo mô hình. Cách tiếp cận này làm giảm bớt nhiều lo ngại về quyền riêng tư dữ liệu đồng thời cho phép cộng tác hiệu quả trong quá trình đào tạo mô hình.

Mặc dù FL là một bước hướng tới việc đạt được sự riêng tư và bảo mật dữ liệu tốt hơn nhưng đó không phải là một giải pháp đảm bảo. Mạng không an toàn thiếu kiểm soát truy cập và mã hóa vẫn có thể tiết lộ thông tin nhạy cảm cho kẻ tấn công. Ngoài ra, thông tin được đào tạo cục bộ có thể làm lộ dữ liệu riêng tư nếu được xây dựng lại thông qua một cuộc tấn công suy luận. Để giảm thiểu những rủi ro này, mô hình FL sử dụng các thuật toán đào tạo được cá nhân hóa cũng như việc che giấu và tham số hóa hiệu quả trước khi chia sẻ thông tin với điều phối viên đào tạo. Kiểm soát mạng mạnh mẽ tại các địa điểm cục bộ và tập trung có thể làm giảm hơn nữa rủi ro suy luận và rò rỉ.

Trong bài đăng này, chúng tôi chia sẻ cách tiếp cận FL bằng cách sử dụng FedML, Dịch vụ Kubernetes đàn hồi của Amazon (Amazon EKS) và Amazon SageMaker để cải thiện kết quả của bệnh nhân đồng thời giải quyết các vấn đề về quyền riêng tư và bảo mật dữ liệu.

Sự cần thiết của việc học tập liên kết trong chăm sóc sức khỏe

Chăm sóc sức khỏe phụ thuộc rất nhiều vào các nguồn dữ liệu phân tán để đưa ra dự đoán và đánh giá chính xác về việc chăm sóc bệnh nhân. Việc hạn chế các nguồn dữ liệu có sẵn để bảo vệ quyền riêng tư sẽ ảnh hưởng tiêu cực đến độ chính xác của kết quả và cuối cùng là chất lượng chăm sóc bệnh nhân. Do đó, ML tạo ra những thách thức cho khách hàng AWS, những người cần đảm bảo quyền riêng tư và bảo mật trên các thực thể phân tán mà không ảnh hưởng đến kết quả của bệnh nhân.

Các tổ chức chăm sóc sức khỏe phải tuân thủ các quy định nghiêm ngặt, chẳng hạn như Đạo luật về trách nhiệm giải trình và cung cấp thông tin bảo hiểm y tế (HIPAA) tại Hoa Kỳ, trong khi triển khai các giải pháp FL. Việc đảm bảo quyền riêng tư, bảo mật và tuân thủ dữ liệu càng trở nên quan trọng hơn trong lĩnh vực chăm sóc sức khỏe, đòi hỏi phải mã hóa mạnh mẽ, kiểm soát quyền truy cập, cơ chế kiểm tra và giao thức liên lạc an toàn. Ngoài ra, các bộ dữ liệu chăm sóc sức khỏe thường chứa các loại dữ liệu phức tạp và không đồng nhất, khiến việc tiêu chuẩn hóa dữ liệu và khả năng tương tác trở thành một thách thức trong cài đặt FL.

Tổng quan về ca sử dụng

Trường hợp sử dụng được nêu trong bài đăng này là dữ liệu về bệnh tim ở các tổ chức khác nhau, trên đó mô hình ML sẽ chạy các thuật toán phân loại để dự đoán bệnh tim ở bệnh nhân. Vì dữ liệu này được lấy từ nhiều tổ chức nên chúng tôi sử dụng phương pháp học tập liên kết để đối chiếu các phát hiện.

Sản phẩm Dữ liệu về bệnh tim từ Kho lưu trữ máy học của Đại học California Irvine là một bộ dữ liệu được sử dụng rộng rãi cho nghiên cứu tim mạch và mô hình dự đoán. Nó bao gồm 303 mẫu, mỗi mẫu đại diện cho một bệnh nhân và chứa sự kết hợp của các thuộc tính lâm sàng và nhân khẩu học, cũng như sự hiện diện hay vắng mặt của bệnh tim.

Bộ dữ liệu đa biến này có 76 thuộc tính trong thông tin bệnh nhân, trong đó 14 thuộc tính được sử dụng phổ biến nhất để phát triển và đánh giá các thuật toán ML nhằm dự đoán sự hiện diện của bệnh tim dựa trên các thuộc tính đã cho.

Khung FedML

Có rất nhiều lựa chọn về khung FL, nhưng chúng tôi quyết định sử dụng Khung FedML cho trường hợp sử dụng này vì nó là nguồn mở và hỗ trợ một số mô hình FL. FedML cung cấp thư viện nguồn mở phổ biến, nền tảng MLOps và hệ sinh thái ứng dụng cho FL. Những điều này tạo điều kiện thuận lợi cho việc phát triển và triển khai các giải pháp FL. Nó cung cấp một bộ công cụ, thư viện và thuật toán toàn diện cho phép các nhà nghiên cứu và người thực hành triển khai và thử nghiệm các thuật toán FL trong môi trường phân tán. FedML giải quyết các thách thức về quyền riêng tư dữ liệu, giao tiếp và tổng hợp mô hình trong FL, cung cấp giao diện thân thiện với người dùng và các thành phần có thể tùy chỉnh. Với trọng tâm là cộng tác và chia sẻ kiến thức, FedML đặt mục tiêu đẩy nhanh việc áp dụng FL và thúc đẩy đổi mới trong lĩnh vực mới nổi này. Khung FedML không phụ thuộc vào mô hình, bao gồm hỗ trợ mới được bổ sung gần đây cho các mô hình ngôn ngữ lớn (LLM). Để biết thêm thông tin, hãy tham khảo Phát hành FedLLM: Xây dựng mô hình ngôn ngữ lớn của riêng bạn trên dữ liệu độc quyền bằng Nền tảng FedML.

Bạch tuộc FedML

Hệ thống phân cấp và tính không đồng nhất là thách thức chính trong các trường hợp sử dụng FL trong đời thực, trong đó các kho dữ liệu khác nhau có thể có cơ sở hạ tầng khác nhau với CPU và GPU. Trong những tình huống như vậy, bạn có thể sử dụng Bạch tuộc FedML.

FedML Octopus là nền tảng cấp công nghiệp của FL đa silo dành cho đào tạo nhiều tổ chức và nhiều tài khoản. Kết hợp với FedML MLOps, nó cho phép các nhà phát triển hoặc tổ chức tiến hành cộng tác mở từ mọi nơi, mọi quy mô một cách an toàn. FedML Octopus chạy mô hình đào tạo phân tán bên trong mỗi kho dữ liệu và sử dụng các khóa đào tạo đồng bộ hoặc không đồng bộ.

FedML MLOps

FedML MLOps cho phép phát triển mã cục bộ mà sau này có thể được triển khai ở bất kỳ đâu bằng cách sử dụng khung FedML. Trước khi bắt đầu đào tạo, bạn phải tạo tài khoản FedML, cũng như tạo và tải lên các gói máy chủ và máy khách trong FedML Octopus. Để biết thêm chi tiết, hãy tham khảo bước và Giới thiệu FedML Octopus: mở rộng quy mô học tập liên kết vào sản xuất với MLOps đơn giản hóa.

Tổng quan về giải pháp

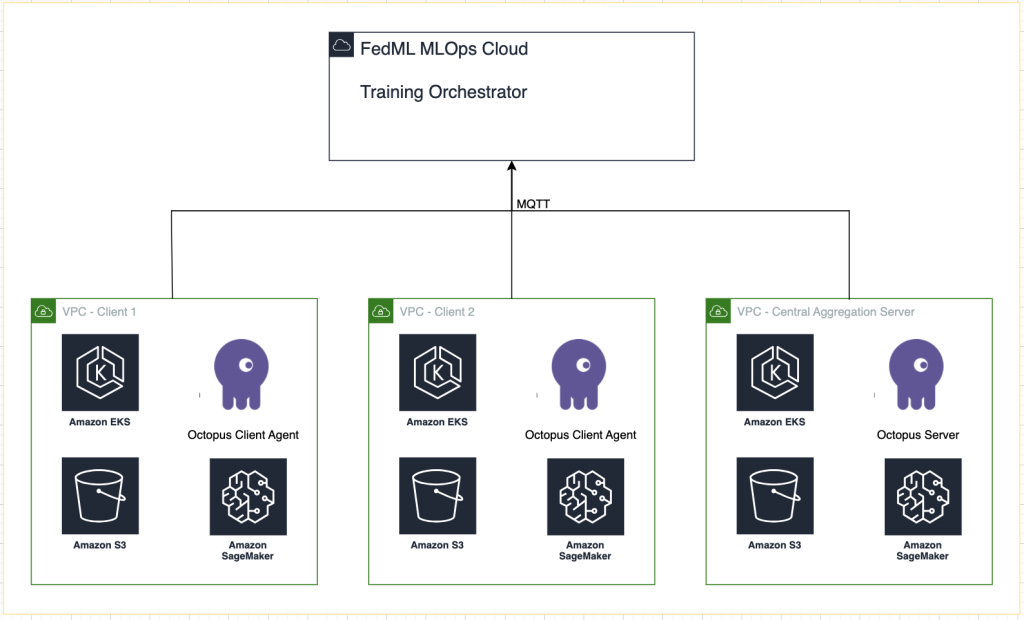

Chúng tôi triển khai FedML thành nhiều cụm EKS được tích hợp với SageMaker để theo dõi thử nghiệm. Chúng tôi sử dụng Bản thiết kế Amazon EKS cho Terraform để triển khai cơ sở hạ tầng cần thiết. Bản thiết kế EKS giúp soạn thảo các cụm EKS hoàn chỉnh được khởi động hoàn toàn bằng phần mềm vận hành cần thiết để triển khai và vận hành khối lượng công việc. Với Bản thiết kế EKS, cấu hình cho trạng thái mong muốn của môi trường EKS, chẳng hạn như mặt phẳng điều khiển, nút công nhân và tiện ích bổ sung Kubernetes, được mô tả dưới dạng bản thiết kế cơ sở hạ tầng dưới dạng mã (IaC). Sau khi đặt cấu hình, bản thiết kế có thể được sử dụng để tạo môi trường nhất quán trên nhiều tài khoản và Khu vực AWS bằng cách sử dụng tính năng tự động triển khai liên tục.

Nội dung được chia sẻ trong bài đăng này phản ánh các tình huống và trải nghiệm thực tế nhưng điều quan trọng cần lưu ý là việc triển khai các tình huống này ở các địa điểm khác nhau có thể khác nhau. Mặc dù chúng tôi sử dụng một tài khoản AWS duy nhất với các VPC riêng biệt nhưng điều quan trọng là phải hiểu rằng các trường hợp và cấu hình riêng lẻ có thể khác nhau. Do đó, thông tin được cung cấp phải được sử dụng làm hướng dẫn chung và có thể yêu cầu điều chỉnh dựa trên các yêu cầu cụ thể và điều kiện địa phương.

Sơ đồ sau minh họa kiến trúc giải pháp của chúng tôi.

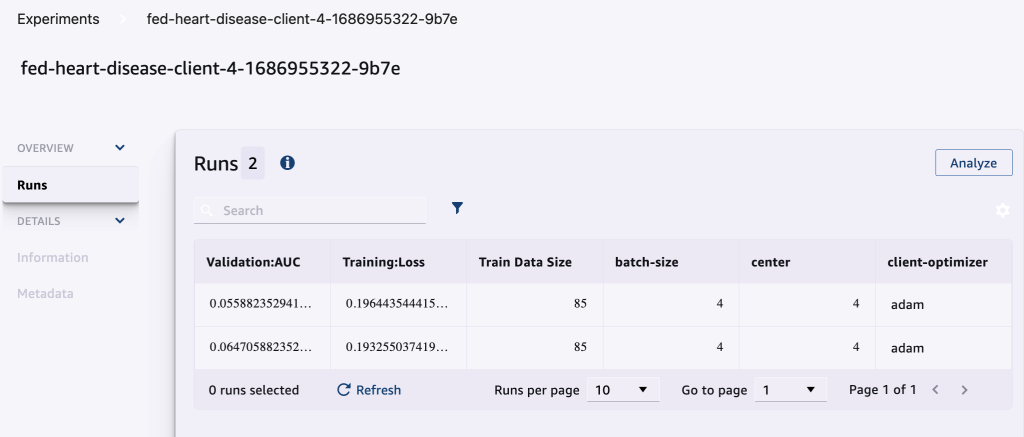

Ngoài tính năng theo dõi do FedML MLOps cung cấp cho mỗi lần đào tạo, chúng tôi còn sử dụng Thử nghiệm Amazon SageMaker để theo dõi hiệu suất của từng mô hình khách hàng và mô hình (tổng hợp) tập trung.

Thử nghiệm SageMaker là một khả năng của SageMaker cho phép bạn tạo, quản lý, phân tích và so sánh các thử nghiệm ML của mình. Bằng cách ghi lại chi tiết, thông số và kết quả thí nghiệm, các nhà nghiên cứu có thể tái tạo và xác nhận chính xác công việc của họ. Nó cho phép so sánh và phân tích hiệu quả các phương pháp tiếp cận khác nhau, giúp đưa ra quyết định sáng suốt. Ngoài ra, các thử nghiệm theo dõi tạo điều kiện thuận lợi cho việc cải tiến lặp đi lặp lại bằng cách cung cấp thông tin chuyên sâu về tiến trình của các mô hình và cho phép các nhà nghiên cứu học hỏi từ các lần lặp lại trước đó, cuối cùng là đẩy nhanh quá trình phát triển các giải pháp hiệu quả hơn.

Chúng tôi gửi nội dung sau tới SageMaker Experiment cho mỗi lần chạy:

- Số liệu đánh giá mô hình – Mất tập luyện và Diện tích dưới đường cong (AUC)

- Siêu tham số – Kỷ nguyên, tốc độ học tập, kích thước lô, trình tối ưu hóa và giảm trọng lượng

Điều kiện tiên quyết

Để làm theo bài đăng này, bạn phải có các điều kiện tiên quyết sau:

Triển khai giải pháp

Để bắt đầu, hãy sao chép cục bộ kho lưu trữ mã mẫu:

Sau đó triển khai cơ sở hạ tầng ca sử dụng bằng các lệnh sau:

Mẫu Terraform có thể mất 20–30 phút để triển khai đầy đủ. Sau khi được triển khai, hãy làm theo các bước trong phần tiếp theo để chạy ứng dụng FL.

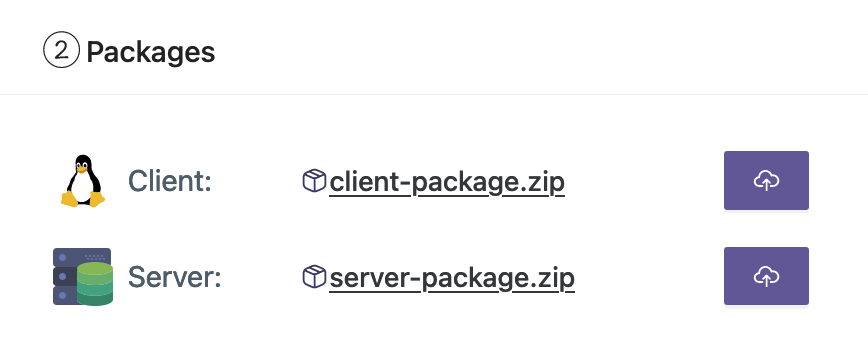

Tạo gói triển khai MLOps

Là một phần của tài liệu FedML, chúng tôi cần tạo các gói máy khách và máy chủ mà nền tảng MLOps sẽ phân phối đến máy chủ và máy khách để bắt đầu đào tạo.

Để tạo các gói này, hãy chạy tập lệnh sau được tìm thấy trong thư mục gốc:

Điều này sẽ tạo các gói tương ứng trong thư mục sau trong thư mục gốc của dự án:

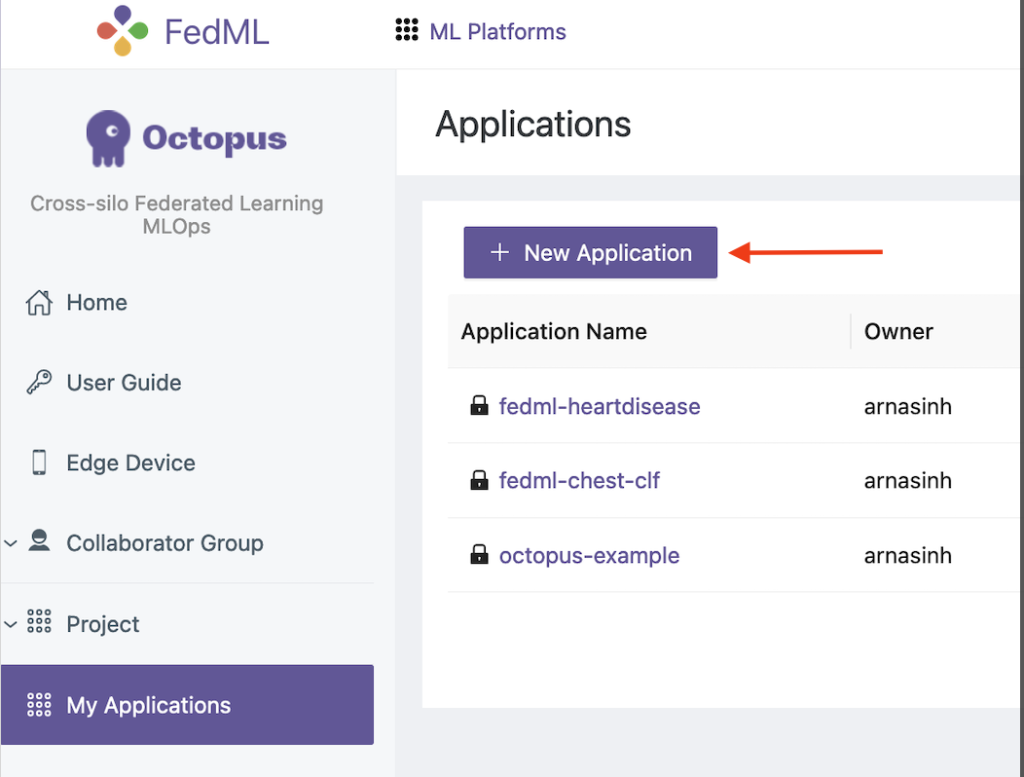

Tải các gói lên nền tảng FedML MLOps

Hoàn tất các bước sau để tải gói lên:

- Trên giao diện người dùng FedML, chọn Đơn ứng tuyển của tôi trong khung điều hướng.

- Chọn Ứng dụng mới.

- Tải gói máy khách và máy chủ lên từ máy trạm của bạn.

- Bạn cũng có thể điều chỉnh các siêu tham số hoặc tạo các tham số mới.

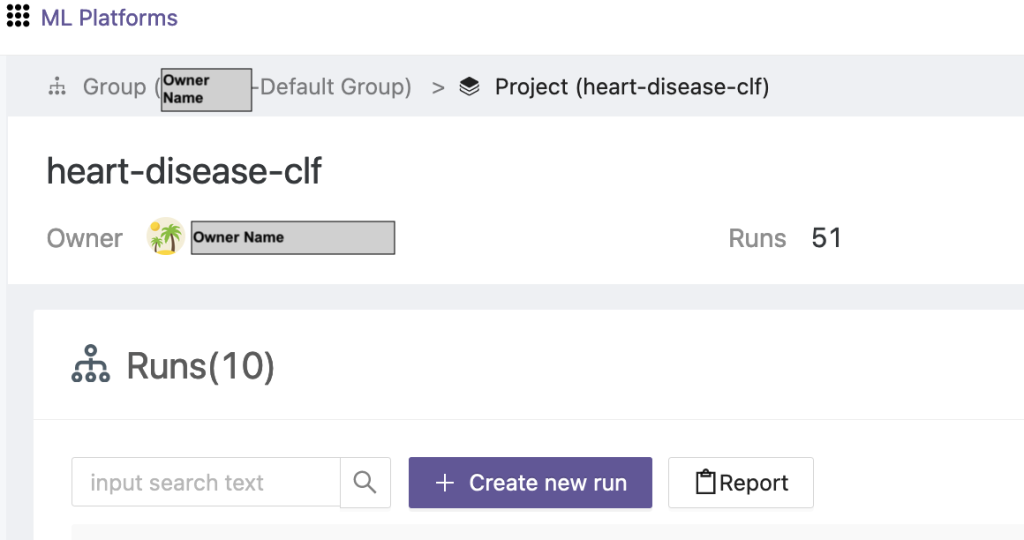

Kích hoạt đào tạo liên đoàn

Để chạy đào tạo liên kết, hãy hoàn thành các bước sau:

- Trên giao diện người dùng FedML, chọn Danh sách dự án trong khung điều hướng.

- Chọn Tạo một dự án mới.

- Nhập tên nhóm và tên dự án, sau đó chọn OK.

- Chọn dự án mới được tạo và chọn Tạo lần chạy mới để kích hoạt một hoạt động đào tạo.

- Chọn các thiết bị máy khách biên và máy chủ tổng hợp trung tâm cho đợt đào tạo này.

- Chọn ứng dụng bạn đã tạo ở các bước trước.

- Cập nhật bất kỳ siêu tham số nào hoặc sử dụng cài đặt mặc định.

- Chọn Bắt đầu để bắt đầu đào tạo.

- Chọn tình trạng đào tạo tab và đợi quá trình đào tạo hoàn tất. Bạn cũng có thể điều hướng đến các tab có sẵn.

- Khi quá trình đào tạo hoàn tất, hãy chọn WELFARE tab để xem thời lượng đào tạo trên các máy chủ biên và các sự kiện tổng hợp của bạn.

Xem kết quả và chi tiết thử nghiệm

Khi quá trình đào tạo hoàn tất, bạn có thể xem kết quả bằng FedML và SageMaker.

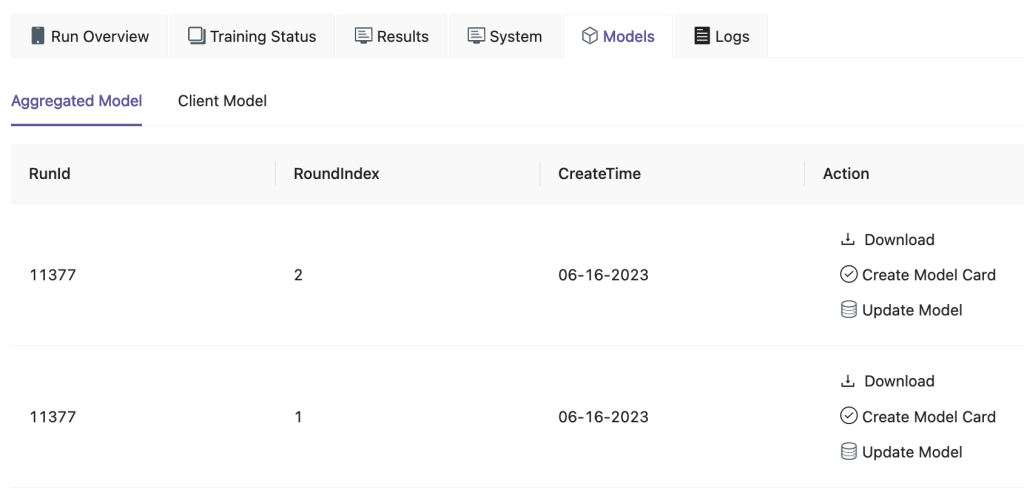

Trên giao diện người dùng FedML, trên mô hình tab, bạn có thể xem mô hình tổng hợp và máy khách. Bạn cũng có thể tải xuống các mô hình này từ trang web.

Bạn cũng có thể đăng nhập vào Xưởng sản xuất Amazon SageMaker Và chọn Thí nghiệm trong khung điều hướng.

Ảnh chụp màn hình sau đây hiển thị các thử nghiệm đã ghi lại.

Mã theo dõi thử nghiệm

Trong phần này, chúng ta khám phá mã tích hợp theo dõi thử nghiệm SageMaker với chương trình đào tạo khung FL.

Trong trình chỉnh sửa bạn chọn, hãy mở thư mục sau để xem các chỉnh sửa đối với mã để chèn mã theo dõi thử nghiệm SageMaker như một phần của khóa đào tạo:

Để theo dõi quá trình đào tạo, chúng tôi tạo thử nghiệm SageMaker với các thông số và số liệu được ghi lại bằng cách sử dụng log_parameter và log_metric lệnh như được nêu trong mẫu mã sau.

Một mục trong config/fedml_config.yaml tệp khai báo tiền tố thử nghiệm, được tham chiếu trong mã để tạo tên thử nghiệm duy nhất: sm_experiment_name: "fed-heart-disease". Bạn có thể cập nhật giá trị này thành bất kỳ giá trị nào bạn chọn.

Ví dụ: xem đoạn mã sau để biết heart_disease_trainer.py, được mỗi khách hàng sử dụng để huấn luyện mô hình trên tập dữ liệu của riêng họ:

Đối với mỗi lần chạy của khách hàng, chi tiết thử nghiệm được theo dõi bằng mã sau trong heart_disease_trainer.py:

Tương tự, bạn có thể sử dụng mã trong heart_disease_aggregator.py để chạy thử nghiệm trên dữ liệu cục bộ sau khi cập nhật trọng số mô hình. Các chi tiết được ghi lại sau mỗi lần giao tiếp với khách hàng.

Làm sạch

Khi bạn hoàn thành giải pháp, hãy đảm bảo dọn sạch các tài nguyên được sử dụng để đảm bảo sử dụng tài nguyên và quản lý chi phí hiệu quả, đồng thời tránh các chi phí và lãng phí tài nguyên không cần thiết. Tích cực dọn dẹp môi trường, chẳng hạn như xóa các phiên bản không sử dụng, dừng các dịch vụ không cần thiết và xóa dữ liệu tạm thời, góp phần tạo nên một cơ sở hạ tầng sạch sẽ và có tổ chức. Bạn có thể sử dụng đoạn mã sau để dọn sạch tài nguyên của mình:

Tổng kết

Bằng cách sử dụng Amazon EKS làm cơ sở hạ tầng và FedML làm khuôn khổ cho FL, chúng tôi có thể cung cấp môi trường được quản lý và mở rộng để đào tạo và triển khai các mô hình dùng chung đồng thời tôn trọng quyền riêng tư của dữ liệu. Với tính chất phi tập trung của FL, các tổ chức có thể cộng tác an toàn, khai thác tiềm năng của dữ liệu phân tán và cải thiện các mô hình ML mà không ảnh hưởng đến quyền riêng tư của dữ liệu.

Như mọi khi, AWS hoan nghênh phản hồi của bạn. Hãy để lại suy nghĩ và câu hỏi của bạn trong phần bình luận.

Về các tác giả

Randy DeFauw là Kiến trúc sư giải pháp chính cấp cao tại AWS. Anh ấy có bằng MSEE của Đại học Michigan, nơi anh ấy nghiên cứu về thị giác máy tính cho xe tự hành. Ông cũng có bằng MBA của Đại học Bang Colorado. Randy đã đảm nhiệm nhiều vị trí khác nhau trong lĩnh vực công nghệ, từ kỹ thuật phần mềm đến quản lý sản phẩm. Anh ấy bước vào không gian dữ liệu lớn vào năm 2013 và tiếp tục khám phá lĩnh vực đó. Anh ấy đang tích cực thực hiện các dự án trong không gian ML và đã trình bày tại nhiều hội nghị, bao gồm Strata và GlueCon.

Randy DeFauw là Kiến trúc sư giải pháp chính cấp cao tại AWS. Anh ấy có bằng MSEE của Đại học Michigan, nơi anh ấy nghiên cứu về thị giác máy tính cho xe tự hành. Ông cũng có bằng MBA của Đại học Bang Colorado. Randy đã đảm nhiệm nhiều vị trí khác nhau trong lĩnh vực công nghệ, từ kỹ thuật phần mềm đến quản lý sản phẩm. Anh ấy bước vào không gian dữ liệu lớn vào năm 2013 và tiếp tục khám phá lĩnh vực đó. Anh ấy đang tích cực thực hiện các dự án trong không gian ML và đã trình bày tại nhiều hội nghị, bao gồm Strata và GlueCon.

Arnab Sinha là Kiến trúc sư giải pháp cấp cao của AWS, đóng vai trò là CTO hiện trường để giúp các tổ chức thiết kế và xây dựng các giải pháp có thể mở rộng nhằm hỗ trợ kết quả kinh doanh trong quá trình di chuyển trung tâm dữ liệu, chuyển đổi kỹ thuật số và hiện đại hóa ứng dụng, dữ liệu lớn và học máy. Ông đã hỗ trợ khách hàng trong nhiều ngành công nghiệp, bao gồm năng lượng, bán lẻ, sản xuất, chăm sóc sức khỏe và khoa học đời sống. Arnab có tất cả các Chứng chỉ AWS, bao gồm Chứng chỉ Chuyên môn ML. Trước khi gia nhập AWS, Arnab là người dẫn đầu về công nghệ và trước đây giữ vai trò lãnh đạo kiến trúc và kỹ thuật.

Arnab Sinha là Kiến trúc sư giải pháp cấp cao của AWS, đóng vai trò là CTO hiện trường để giúp các tổ chức thiết kế và xây dựng các giải pháp có thể mở rộng nhằm hỗ trợ kết quả kinh doanh trong quá trình di chuyển trung tâm dữ liệu, chuyển đổi kỹ thuật số và hiện đại hóa ứng dụng, dữ liệu lớn và học máy. Ông đã hỗ trợ khách hàng trong nhiều ngành công nghiệp, bao gồm năng lượng, bán lẻ, sản xuất, chăm sóc sức khỏe và khoa học đời sống. Arnab có tất cả các Chứng chỉ AWS, bao gồm Chứng chỉ Chuyên môn ML. Trước khi gia nhập AWS, Arnab là người dẫn đầu về công nghệ và trước đây giữ vai trò lãnh đạo kiến trúc và kỹ thuật.

Prachi Kulkarni là Kiến trúc sư giải pháp cấp cao tại AWS. Chuyên môn của cô là học máy và cô đang tích cực nghiên cứu thiết kế các giải pháp sử dụng nhiều dịch vụ AWS ML, dữ liệu lớn và phân tích. Prachi có kinh nghiệm trong nhiều lĩnh vực, bao gồm chăm sóc sức khỏe, phúc lợi, bán lẻ và giáo dục, đồng thời đã làm việc ở nhiều vị trí khác nhau về kỹ thuật và kiến trúc sản phẩm, quản lý cũng như thành công của khách hàng.

Prachi Kulkarni là Kiến trúc sư giải pháp cấp cao tại AWS. Chuyên môn của cô là học máy và cô đang tích cực nghiên cứu thiết kế các giải pháp sử dụng nhiều dịch vụ AWS ML, dữ liệu lớn và phân tích. Prachi có kinh nghiệm trong nhiều lĩnh vực, bao gồm chăm sóc sức khỏe, phúc lợi, bán lẻ và giáo dục, đồng thời đã làm việc ở nhiều vị trí khác nhau về kỹ thuật và kiến trúc sản phẩm, quản lý cũng như thành công của khách hàng.

Tamer Sherif là Kiến trúc sư giải pháp chính tại AWS, với nền tảng kiến thức đa dạng về lĩnh vực dịch vụ tư vấn doanh nghiệp và công nghệ, với hơn 17 năm làm Kiến trúc sư giải pháp. Với việc tập trung vào cơ sở hạ tầng, chuyên môn của Tamer bao gồm nhiều ngành dọc, bao gồm thương mại, chăm sóc sức khỏe, ô tô, khu vực công, sản xuất, dầu khí, dịch vụ truyền thông, v.v. Trình độ thông thạo của anh mở rộng sang nhiều lĩnh vực khác nhau, chẳng hạn như kiến trúc đám mây, điện toán biên, kết nối mạng, lưu trữ, ảo hóa, năng suất kinh doanh và lãnh đạo kỹ thuật.

Tamer Sherif là Kiến trúc sư giải pháp chính tại AWS, với nền tảng kiến thức đa dạng về lĩnh vực dịch vụ tư vấn doanh nghiệp và công nghệ, với hơn 17 năm làm Kiến trúc sư giải pháp. Với việc tập trung vào cơ sở hạ tầng, chuyên môn của Tamer bao gồm nhiều ngành dọc, bao gồm thương mại, chăm sóc sức khỏe, ô tô, khu vực công, sản xuất, dầu khí, dịch vụ truyền thông, v.v. Trình độ thông thạo của anh mở rộng sang nhiều lĩnh vực khác nhau, chẳng hạn như kiến trúc đám mây, điện toán biên, kết nối mạng, lưu trữ, ảo hóa, năng suất kinh doanh và lãnh đạo kỹ thuật.

Hans Nesbitt là Kiến trúc sư giải pháp cấp cao tại AWS có trụ sở tại Nam California. Anh làm việc với các khách hàng trên khắp miền Tây Hoa Kỳ để tạo ra các kiến trúc đám mây có khả năng mở rộng, linh hoạt và linh hoạt cao. Khi rảnh rỗi, anh thích dành thời gian cho gia đình, nấu ăn và chơi guitar.

Hans Nesbitt là Kiến trúc sư giải pháp cấp cao tại AWS có trụ sở tại Nam California. Anh làm việc với các khách hàng trên khắp miền Tây Hoa Kỳ để tạo ra các kiến trúc đám mây có khả năng mở rộng, linh hoạt và linh hoạt cao. Khi rảnh rỗi, anh thích dành thời gian cho gia đình, nấu ăn và chơi guitar.

Triều Dương Hà là Người đồng sáng lập và CTO của FedML, Inc., một công ty khởi nghiệp hoạt động vì cộng đồng xây dựng AI mở và hợp tác từ mọi nơi, mọi quy mô. Nghiên cứu của ông tập trung vào các thuật toán, hệ thống và ứng dụng học máy phân tán và liên kết. Ông nhận bằng Tiến sĩ Khoa học Máy tính tại Đại học Nam California.

Triều Dương Hà là Người đồng sáng lập và CTO của FedML, Inc., một công ty khởi nghiệp hoạt động vì cộng đồng xây dựng AI mở và hợp tác từ mọi nơi, mọi quy mô. Nghiên cứu của ông tập trung vào các thuật toán, hệ thống và ứng dụng học máy phân tán và liên kết. Ông nhận bằng Tiến sĩ Khoa học Máy tính tại Đại học Nam California.

Al Nevarez là Giám đốc Quản lý Sản phẩm tại FedML. Trước FedML, ông là giám đốc sản phẩm nhóm tại Google và là giám đốc cấp cao về khoa học dữ liệu tại LinkedIn. Anh ấy có một số bằng sáng chế liên quan đến sản phẩm dữ liệu và anh ấy học ngành kỹ thuật tại Đại học Stanford.

Al Nevarez là Giám đốc Quản lý Sản phẩm tại FedML. Trước FedML, ông là giám đốc sản phẩm nhóm tại Google và là giám đốc cấp cao về khoa học dữ liệu tại LinkedIn. Anh ấy có một số bằng sáng chế liên quan đến sản phẩm dữ liệu và anh ấy học ngành kỹ thuật tại Đại học Stanford.

Salman Avestimehr là Đồng sáng lập và Giám đốc điều hành của FedML. Ông từng là Giáo sư Trưởng khoa tại USC, Giám đốc Trung tâm USC-Amazon về AI đáng tin cậy và Học giả Amazon về Alexa AI. Ông là chuyên gia về học máy liên kết và phi tập trung, lý thuyết thông tin, bảo mật và quyền riêng tư. Ông là thành viên của IEEE và nhận bằng Tiến sĩ về EECS tại UC Berkeley.

Salman Avestimehr là Đồng sáng lập và Giám đốc điều hành của FedML. Ông từng là Giáo sư Trưởng khoa tại USC, Giám đốc Trung tâm USC-Amazon về AI đáng tin cậy và Học giả Amazon về Alexa AI. Ông là chuyên gia về học máy liên kết và phi tập trung, lý thuyết thông tin, bảo mật và quyền riêng tư. Ông là thành viên của IEEE và nhận bằng Tiến sĩ về EECS tại UC Berkeley.

Samir Lad là một nhà công nghệ doanh nghiệp thành đạt của AWS, người làm việc chặt chẽ với các giám đốc điều hành cấp C của khách hàng. Là cựu giám đốc điều hành C-Suite, người đã thúc đẩy chuyển đổi ở nhiều công ty Fortune 100, Samir chia sẻ những kinh nghiệm quý giá của mình để giúp khách hàng thành công trong hành trình chuyển đổi của riêng họ.

Samir Lad là một nhà công nghệ doanh nghiệp thành đạt của AWS, người làm việc chặt chẽ với các giám đốc điều hành cấp C của khách hàng. Là cựu giám đốc điều hành C-Suite, người đã thúc đẩy chuyển đổi ở nhiều công ty Fortune 100, Samir chia sẻ những kinh nghiệm quý giá của mình để giúp khách hàng thành công trong hành trình chuyển đổi của riêng họ.

Stephen Kraemer là cố vấn Hội đồng quản trị và CxO, đồng thời là cựu giám đốc điều hành tại AWS. Stephen ủng hộ văn hóa và khả năng lãnh đạo là nền tảng của thành công. Ông tuyên bố bảo mật và đổi mới là động lực thúc đẩy chuyển đổi đám mây cho phép các tổ chức dựa trên dữ liệu, có tính cạnh tranh cao.

Stephen Kraemer là cố vấn Hội đồng quản trị và CxO, đồng thời là cựu giám đốc điều hành tại AWS. Stephen ủng hộ văn hóa và khả năng lãnh đạo là nền tảng của thành công. Ông tuyên bố bảo mật và đổi mới là động lực thúc đẩy chuyển đổi đám mây cho phép các tổ chức dựa trên dữ liệu, có tính cạnh tranh cao.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/federated-learning-on-aws-using-fedml-amazon-eks-and-amazon-sagemaker/