이 게시물은 BigBasket의 Santosh Waddi 및 Nanda Kishore Thatikonda와 공동으로 작성되었습니다.

큰 바구니 인도 최대의 온라인 식품 및 식료품점입니다. 그들은 빠른 상거래, 정기 배송 및 일일 구독과 같은 다양한 전자 상거래 채널에서 운영됩니다. 실제 매장이나 자동판매기에서도 구매할 수 있습니다. 그들은 50,000개 브랜드에 걸쳐 1,000개 이상의 다양한 제품을 제공하며 500개 이상의 도시와 마을에서 운영되고 있습니다. BigBasket은 천만 명 이상의 고객에게 서비스를 제공합니다.

이 게시물에서는 BigBasket이 어떻게 사용되었는지 논의합니다. 아마존 세이지 메이커 FMCG(Fast-Moving Consumer Goods) 제품 식별을 위한 컴퓨터 비전 모델을 교육하여 교육 시간을 약 50% 단축하고 비용을 20% 절감했습니다.

고객의 과제

오늘날 인도의 대부분의 슈퍼마켓과 실제 매장에서는 계산대에서 수동 계산을 제공합니다. 여기에는 두 가지 문제가 있습니다.

- 매장 운영팀의 규모가 커짐에 따라 추가 인력, 무게 스티커, 반복적인 교육이 필요합니다.

- 대부분의 매장에서 계산대는 계량 카운터와 다르므로 고객 구매 여정에 마찰이 가중됩니다. 고객은 종종 중량 스티커를 잃어버리고 결제 과정을 진행하기 전에 중량 측정기로 돌아가 다시 스티커를 찾아야 합니다.

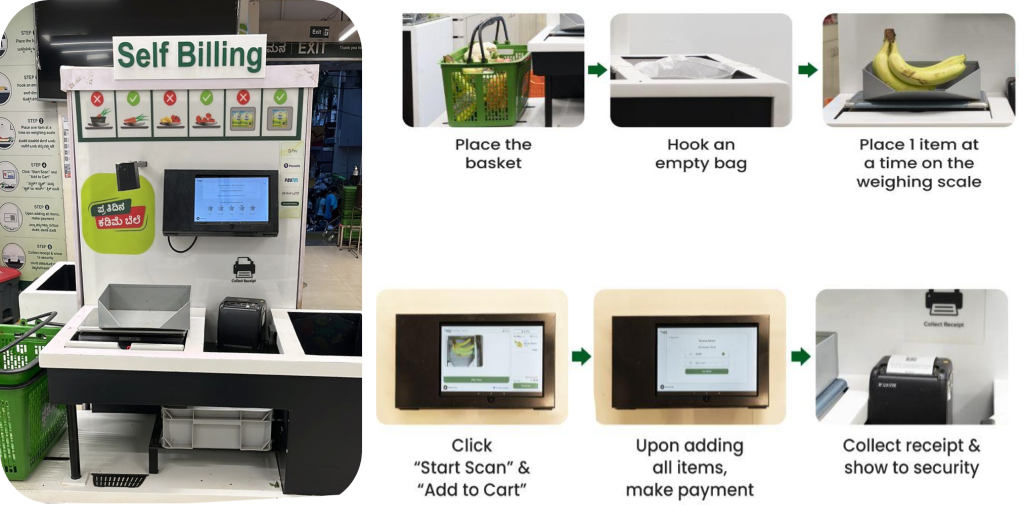

셀프 체크아웃 프로세스

BigBasket은 카메라를 사용하여 품목을 고유하게 구별하는 AI 기반 체크아웃 시스템을 실제 매장에 도입했습니다. 다음 그림은 체크아웃 프로세스의 개요를 제공합니다.

BigBasket 팀은 AI 기반 결제를 지원하기 위해 컴퓨터 비전 객체 인식을 위한 오픈 소스 사내 ML 알고리즘을 실행하고 있었습니다. 프레쇼 (물리적) 상점. 우리는 기존 설정을 운영하는 데 다음과 같은 과제에 직면했습니다.

- 신제품이 지속적으로 출시됨에 따라 컴퓨터 비전 모델에는 신제품 정보를 지속적으로 통합해야 했습니다. 시스템은 12,000개 이상의 SKU(재고 관리 단위)로 구성된 대규모 카탈로그를 처리해야 했으며, 새로운 SKU는 매월 600개가 넘는 속도로 지속적으로 추가되었습니다.

- 신제품에 보조를 맞추기 위해 최신 교육 데이터를 사용하여 매달 새로운 모델이 생산되었습니다. 신제품에 적응하기 위해 모델을 자주 훈련시키는 것은 비용과 시간이 많이 소요되었습니다.

- BigBasket은 또한 출시 기간을 단축하기 위해 교육 주기 시간을 단축하기를 원했습니다. SKU 증가로 인해 모델에 소요되는 시간이 선형적으로 증가했으며, 이는 훈련 빈도가 매우 높고 시간이 오래 걸리기 때문에 출시 시간에 영향을 미쳤습니다.

- 모델 교육을 위한 데이터 확대와 전체 엔드투엔드 교육 주기를 수동으로 관리하면 상당한 오버헤드가 추가되었습니다. BigBasket은 이를 타사 플랫폼에서 실행하고 있었으며 이로 인해 상당한 비용이 발생했습니다.

솔루션 개요

이러한 문제를 해결하려면 BigBasket이 SageMaker를 사용하여 기존 FMCG 제품 감지 및 분류 솔루션을 재설계하는 것이 좋습니다. 본격적인 생산으로 전환하기 전에 BigBasket은 SageMaker에서 파일럿을 시도하여 성능, 비용 및 편의성 지표를 평가했습니다.

그들의 목표는 SKU 감지를 위해 기존 컴퓨터 비전 머신러닝(ML) 모델을 미세 조정하는 것이었습니다. 우리는 CNN(Convolutional Neural Network) 아키텍처를 사용했습니다. 레스넷152 이미지 분류를 위해. 모델 훈련을 위해 SKU당 약 300개 이미지로 구성된 상당한 규모의 데이터세트가 추정되어 총 4만 개가 넘는 훈련 이미지가 생성되었습니다. 특정 SKU의 경우 더 넓은 범위의 환경 조건을 포괄하도록 데이터를 보강했습니다.

다음 다이어그램은 솔루션 아키텍처를 보여줍니다.

전체 프로세스는 다음과 같은 상위 수준 단계로 요약될 수 있습니다.

- 데이터 정리, 주석 및 보강을 수행합니다.

- 데이터를 다음 위치에 저장 아마존 단순 스토리지 서비스 (Amazon S3) 버킷.

- SageMaker를 사용하고 Luster 용 Amazon FSx 효율적인 데이터 증대를 위해

- 데이터를 학습, 검증 및 테스트 세트로 분할합니다. 우리는 Lustre를 위해 FSx를 사용했고 Amazon 관계형 데이터베이스 서비스 (Amazon RDS)를 통해 빠른 병렬 데이터 액세스가 가능합니다.

- 사용자 지정 사용 파이 토치 다른 오픈 소스 라이브러리를 포함하는 Docker 컨테이너입니다.

- SageMaker 분산 데이터 병렬성 (SMDDP) 가속 분산 훈련을 위한 것입니다.

- 모델 학습 측정항목을 기록합니다.

- 최종 모델을 S3 버킷에 복사합니다.

사용된 빅바스켓 SageMaker 노트북 ML 모델을 교육하고 기존 오픈 소스 PyTorch 및 기타 오픈 소스 종속성을 SageMaker PyTorch 컨테이너로 쉽게 포팅하고 파이프라인을 원활하게 실행할 수 있었습니다. 이것이 BigBasket 팀이 확인한 첫 번째 이점이었습니다. SageMaker 환경에서 실행할 수 있도록 코드를 호환 가능하게 만들기 위해 코드를 거의 변경할 필요가 없었기 때문입니다.

모델 네트워크는 ResNet 152 아키텍처와 완전히 연결된 레이어로 구성됩니다. 우리는 낮은 수준의 피처 레이어를 동결하고 ImageNet 모델의 전이 학습을 통해 얻은 가중치를 유지했습니다. 전체 모델 매개변수는 66만 개였으며, 훈련 가능한 매개변수는 23만 개였습니다. 이러한 전이 학습 기반 접근 방식을 통해 훈련 시 더 적은 수의 이미지를 사용할 수 있었고 더 빠른 수렴이 가능했으며 총 훈련 시간도 단축되었습니다.

내부에서 모델 구축 및 훈련 아마존 세이지 메이커 스튜디오 모델을 준비, 구축, 교육 및 조정하는 데 필요한 모든 것을 갖춘 통합 개발 환경(IDE)을 제공했습니다. 이미지 자르기, 회전, 뒤집기와 같은 기술을 사용하여 훈련 데이터를 보강하면 모델 훈련 데이터와 모델 정확도가 향상되는 데 도움이 되었습니다.

AWS 인프라용으로 특별히 설계된 최적화된 통신 알고리즘이 포함된 SMDDP 라이브러리를 사용하여 모델 훈련이 50% 가속화되었습니다. 모델 교육 및 데이터 확대 중에 데이터 읽기/쓰기 성능을 향상시키기 위해 고성능 처리량을 위해 FSx for Lustre를 사용했습니다.

시작 훈련 데이터 크기는 1.5TB가 넘었습니다. 저희는 XNUMX개를 이용했어요 아마존 엘라스틱 컴퓨트 클라우드 (아마존 EC2) p4d.24 대규모 인스턴스 8개의 GPU와 40GB GPU 메모리를 갖추고 있습니다. SageMaker 분산 교육의 경우 인스턴스는 동일한 AWS 리전 및 가용 영역에 있어야 합니다. 또한 S3 버킷에 저장된 교육 데이터는 동일한 가용 영역에 있어야 합니다. 또한 이 아키텍처를 통해 BigBasket은 다른 인스턴스 유형으로 변경하거나 현재 아키텍처에 더 많은 인스턴스를 추가하여 상당한 데이터 증가를 수용하거나 교육 시간을 더욱 단축할 수 있습니다.

SMDDP 라이브러리가 교육 시간, 비용, 복잡성을 줄이는 데 어떻게 도움이 되었는지

기존 분산 데이터 훈련에서 훈련 프레임워크는 GPU(작업자)에 순위를 할당하고 각 GPU에 모델의 복제본을 생성합니다. 각 훈련 반복 중에 전역 데이터 배치는 여러 조각(배치 샤드)으로 나누어지고 각 작업자에게 조각이 배포됩니다. 그런 다음 각 작업자는 각 GPU의 훈련 스크립트에 정의된 정방향 및 역방향 전달을 진행합니다. 마지막으로, 다른 모델 복제본의 모델 가중치와 기울기는 AllReduce라는 집단 통신 작업을 통해 반복이 끝날 때 동기화됩니다. 각 작업자와 GPU에 모델의 동기화된 복제본이 있으면 다음 반복이 시작됩니다.

SMDDP 라이브러리는 이러한 분산 데이터 병렬 훈련 프로세스의 성능을 향상시키는 집단 통신 라이브러리입니다. SMDDP 라이브러리는 AllReduce와 같은 주요 집단 통신 작업의 통신 오버헤드를 줄여줍니다. AllReduce 구현은 AWS 인프라용으로 설계되었으며 AllReduce 작업을 역방향 전달과 겹쳐서 훈련 속도를 높일 수 있습니다. 이 접근 방식은 CPU와 GPU 간의 커널 작업을 최적화하여 선형에 가까운 확장 효율성과 더 빠른 훈련 속도를 달성합니다.

다음 계산에 유의하세요.

- 글로벌 배치의 크기는 (클러스터의 노드 수) * (노드당 GPU 수) * (배치 샤드당)입니다.

- 배치 샤드(소규모 배치)는 반복마다 각 GPU(작업자)에 할당된 데이터 세트의 하위 집합입니다.

BigBasket은 SMDDP 라이브러리를 사용하여 전체 교육 시간을 단축했습니다. FSx for Lustre를 사용하여 모델 교육 및 데이터 확대 중에 데이터 읽기/쓰기 처리량을 줄였습니다. 데이터 병렬 처리를 통해 BigBasket은 다른 대안에 비해 거의 50% 더 빠르고 20% 더 저렴한 교육을 달성하여 AWS에서 최고의 성능을 제공할 수 있었습니다. SageMaker는 완료 후 훈련 파이프라인을 자동으로 종료합니다. 프로젝트는 AWS에서 50% 더 빠른 교육 시간으로 성공적으로 완료되었습니다(AWS에서는 4.5일, 레거시 플랫폼에서는 9일).

이 게시물을 작성하는 시점에서 BigBasket은 6개월 이상 생산 단계에서 완전한 솔루션을 실행하고 새로운 도시에 맞춰 시스템을 확장해 왔으며 매달 새로운 매장을 추가하고 있습니다.

“SMDDP 제품을 사용하여 분산 교육으로 마이그레이션하는 AWS와의 파트너십은 큰 승리였습니다. 교육 시간을 50% 단축했을 뿐만 아니라 비용도 20% 저렴했습니다. 전체 파트너십을 통해 AWS는 고객 집착과 결과 제공에 대한 기준을 설정했으며, 약속된 혜택을 실현하기 위해 모든 노력을 다해 협력하고 있습니다."

– Keshav Kumar, BigBasket 엔지니어링 책임자

결론

이 게시물에서는 BigBasket이 SageMaker를 사용하여 FMCG 제품 식별을 위한 컴퓨터 비전 모델을 훈련한 방법에 대해 논의했습니다. AI 기반 자동 셀프 체크아웃 시스템을 구현하면 혁신을 통해 향상된 소매 고객 경험을 제공하는 동시에 체크아웃 프로세스에서 인적 오류를 제거할 수 있습니다. SageMaker 분산 교육을 사용하여 신제품 온보딩을 가속화하면 SKU 온보딩 시간과 비용이 절감됩니다. FSx for Lustre를 통합하면 매월 수백 개의 새로운 SKU로 효율적인 모델 재교육을 위한 빠른 병렬 데이터 액세스가 가능해집니다. 전반적으로 이 AI 기반 셀프 체크아웃 솔루션은 프런트엔드 체크아웃 오류 없이 향상된 쇼핑 경험을 제공합니다. 자동화와 혁신은 소매점 결제 및 온보딩 운영을 변화시켰습니다.

SageMaker는 코드 작성, 데이터 수집, 데이터 태깅, 모델 교육, 모델 튜닝, 배포, 모니터링 등을 위한 SageMaker Studio 노트북 환경과 같은 엔드투엔드 ML 개발, 배포 및 모니터링 기능을 제공합니다. 귀하의 비즈니스가 이 게시물에 설명된 문제에 직면하고 있고 출시 시간을 단축하고 비용을 개선하려는 경우 해당 지역의 AWS 계정 팀에 연락하여 SageMaker를 시작하십시오.

저자에 관하여

산토시 와디 BigBasket의 수석 엔지니어로 AI 문제 해결에 있어 10년 이상의 전문 지식을 보유하고 있습니다. 컴퓨터 비전, 데이터 과학, 딥 러닝에 대한 탄탄한 배경 지식을 갖춘 그는 IIT 봄베이에서 대학원 학위를 취득했습니다. Santosh는 주목할만한 IEEE 간행물을 저술했으며 노련한 기술 블로그 작성자로서 삼성 재직 기간 동안 컴퓨터 비전 솔루션 개발에 상당한 공헌을 했습니다.

산토시 와디 BigBasket의 수석 엔지니어로 AI 문제 해결에 있어 10년 이상의 전문 지식을 보유하고 있습니다. 컴퓨터 비전, 데이터 과학, 딥 러닝에 대한 탄탄한 배경 지식을 갖춘 그는 IIT 봄베이에서 대학원 학위를 취득했습니다. Santosh는 주목할만한 IEEE 간행물을 저술했으며 노련한 기술 블로그 작성자로서 삼성 재직 기간 동안 컴퓨터 비전 솔루션 개발에 상당한 공헌을 했습니다.

난다 키쇼어 타티콘다 BigBasket에서 데이터 엔지니어링 및 분석을 이끄는 엔지니어링 관리자입니다. Nanda는 이상 탐지를 위한 여러 애플리케이션을 구축했으며 유사한 분야에 대한 특허를 출원했습니다. 그는 엔터프라이즈급 애플리케이션을 구축하고, 여러 조직에서 데이터 플랫폼을 구축하고, 데이터를 기반으로 한 의사 결정을 간소화하기 위한 보고 플랫폼을 구축하는 일을 해왔습니다. Nanda는 Hadoop 및 Apache Spark를 사용하여 Java/J18EE, Spring 기술, 빅 데이터 프레임워크 분야에서 2년 넘게 작업한 경험이 있습니다.

난다 키쇼어 타티콘다 BigBasket에서 데이터 엔지니어링 및 분석을 이끄는 엔지니어링 관리자입니다. Nanda는 이상 탐지를 위한 여러 애플리케이션을 구축했으며 유사한 분야에 대한 특허를 출원했습니다. 그는 엔터프라이즈급 애플리케이션을 구축하고, 여러 조직에서 데이터 플랫폼을 구축하고, 데이터를 기반으로 한 의사 결정을 간소화하기 위한 보고 플랫폼을 구축하는 일을 해왔습니다. Nanda는 Hadoop 및 Apache Spark를 사용하여 Java/J18EE, Spring 기술, 빅 데이터 프레임워크 분야에서 2년 넘게 작업한 경험이 있습니다.

수단슈 증오 AWS의 수석 AI 및 ML 전문가이며 고객과 협력하여 MLOps 및 생성 AI 여정에 대해 조언합니다. 이전 직책에서 그는 철저한 오픈 소스 기반 AI 및 게임화 플랫폼을 구축하기 위해 팀을 개념화, 생성 및 이끌었고 100개 이상의 클라이언트와 함께 이를 성공적으로 상용화했습니다. Sudhanshu는 몇 가지 특허를 보유하고 있습니다. 2권의 책, 여러 편의 논문, 블로그를 작성했습니다. 다양한 포럼에서 자신의 관점을 제시했습니다. 그는 사고의 리더이자 연사였으며 거의 25년 동안 업계에 종사해 왔습니다. 그는 전 세계 Fortune 1000대 고객과 협력해 왔으며 가장 최근에는 인도의 디지털 네이티브 고객과 협력하고 있습니다.

수단슈 증오 AWS의 수석 AI 및 ML 전문가이며 고객과 협력하여 MLOps 및 생성 AI 여정에 대해 조언합니다. 이전 직책에서 그는 철저한 오픈 소스 기반 AI 및 게임화 플랫폼을 구축하기 위해 팀을 개념화, 생성 및 이끌었고 100개 이상의 클라이언트와 함께 이를 성공적으로 상용화했습니다. Sudhanshu는 몇 가지 특허를 보유하고 있습니다. 2권의 책, 여러 편의 논문, 블로그를 작성했습니다. 다양한 포럼에서 자신의 관점을 제시했습니다. 그는 사고의 리더이자 연사였으며 거의 25년 동안 업계에 종사해 왔습니다. 그는 전 세계 Fortune 1000대 고객과 협력해 왔으며 가장 최근에는 인도의 디지털 네이티브 고객과 협력하고 있습니다.

아유시 쿠마르 AWS의 솔루션스 아키텍트입니다. 그는 다양한 AWS 고객과 협력하여 고객이 최신 최신 애플리케이션을 채택하고 클라우드 네이티브 기술을 통해 더 빠르게 혁신할 수 있도록 돕고 있습니다. 여가 시간에는 그가 부엌에서 실험을 하고 있는 모습을 볼 수 있을 것입니다.

아유시 쿠마르 AWS의 솔루션스 아키텍트입니다. 그는 다양한 AWS 고객과 협력하여 고객이 최신 최신 애플리케이션을 채택하고 클라우드 네이티브 기술을 통해 더 빠르게 혁신할 수 있도록 돕고 있습니다. 여가 시간에는 그가 부엌에서 실험을 하고 있는 모습을 볼 수 있을 것입니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://aws.amazon.com/blogs/machine-learning/how-bigbasket-improved-ai-enabled-checkout-at-their-physical-stores-using-amazon-sagemaker/