LLM(대형 언어 모델)은 자연어 처리(NLP) 분야에 혁명을 일으켜 언어 번역, 텍스트 요약, 감정 분석과 같은 작업을 개선했습니다. 그러나 이러한 모델의 크기와 복잡성이 계속 증가함에 따라 성능과 동작을 모니터링하는 것이 점점 더 어려워지고 있습니다.

LLM의 성과와 행동을 모니터링하는 것은 LLM의 안전과 효율성을 보장하는 데 중요한 작업입니다. 우리가 제안한 아키텍처는 온라인 LLM 모니터링을 위한 확장 가능하고 사용자 정의 가능한 솔루션을 제공하므로 팀은 특정 사용 사례 및 요구 사항에 맞게 모니터링 솔루션을 맞춤화할 수 있습니다. AWS 서비스를 사용함으로써 우리의 아키텍처는 LLM 동작에 대한 실시간 가시성을 제공하고 팀이 문제나 이상 현상을 신속하게 식별하고 해결할 수 있도록 지원합니다.

이 게시물에서는 온라인 LLM 모니터링에 대한 몇 가지 지표와 다음과 같은 AWS 서비스를 사용하여 확장을 위한 해당 아키텍처를 보여줍니다. 아마존 클라우드 워치 과 AWS 람다. 이는 가능한 것 이상의 맞춤형 솔루션을 제공합니다. 모델 평가 직업 아마존 기반암.

솔루션 개요

가장 먼저 고려해야 할 점은 다양한 측정항목에는 다양한 계산 고려 사항이 필요하다는 것입니다. 각 모듈이 모델 추론 데이터를 수집하고 자체 측정항목을 생성할 수 있는 모듈식 아키텍처가 필요합니다.

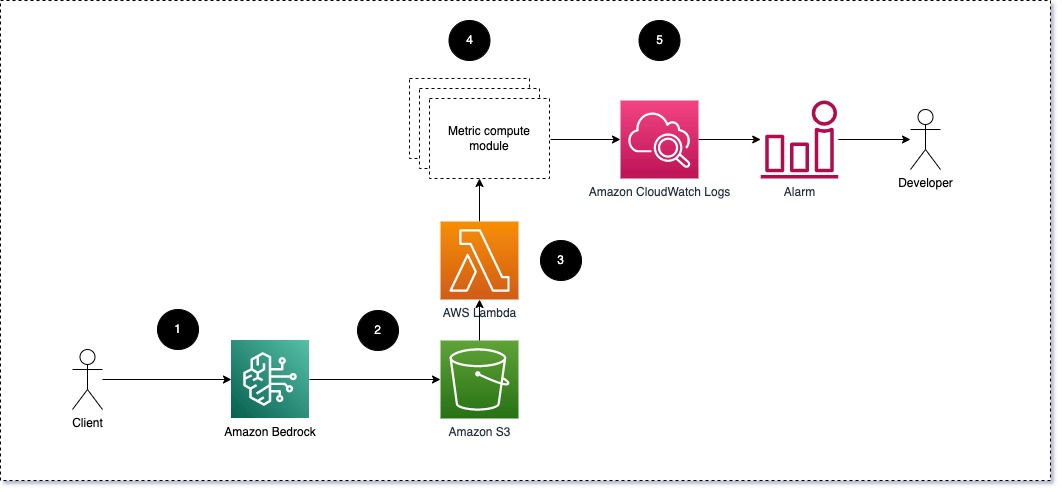

각 모듈은 들어오는 추론 요청을 LLM으로 가져와 프롬프트 및 완료(응답) 쌍을 메트릭 컴퓨팅 모듈에 전달하는 것이 좋습니다. 각 모듈은 입력 프롬프트 및 완료(응답)와 관련된 자체 측정항목을 계산하는 역할을 담당합니다. 이러한 지표는 CloudWatch로 전달되어 이를 집계하고 CloudWatch 경보와 함께 작동하여 특정 조건에 대한 알림을 보낼 수 있습니다. 다음 다이어그램은 이 아키텍처를 보여줍니다.

그림 1: 미터법 컴퓨팅 모듈 - 솔루션 개요

워크 플로우에는 다음 단계가 포함됩니다.

- 사용자는 애플리케이션이나 사용자 인터페이스의 일부로 Amazon Bedrock에 요청합니다.

- Amazon Bedrock은 요청 및 완료(응답)를 다음 위치에 저장합니다. 아마존 단순 스토리지 서비스 (Amazon S3)의 구성에 따라 호출 로깅.

- Amazon S3에 저장된 파일은 다음과 같은 이벤트를 생성합니다. 트리거 람다 함수. 이 함수는 모듈을 호출합니다.

- 모듈은 해당 측정항목을 다음 위치에 게시합니다. CloudWatch 지표.

- 경보 예상치 못한 측정값을 개발팀에 알릴 수 있습니다.

LLM 모니터링을 구현할 때 고려해야 할 두 번째 사항은 추적할 올바른 측정항목을 선택하는 것입니다. LLM 성과를 모니터링하는 데 사용할 수 있는 잠재적인 지표가 많이 있지만 이 게시물에서는 가장 광범위한 지표 중 일부에 대해 설명합니다.

다음 섹션에서는 몇 가지 관련 모듈 메트릭과 해당 메트릭 컴퓨팅 모듈 아키텍처를 강조합니다.

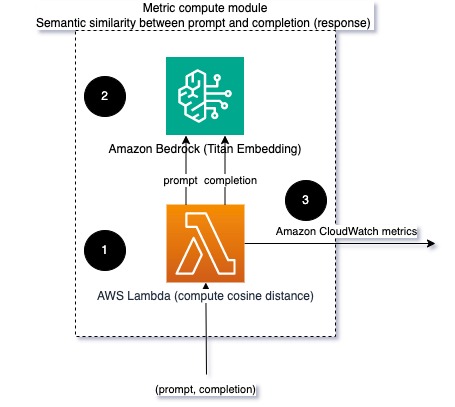

프롬프트와 완료(응답) 간의 의미적 유사성

LLM을 실행할 때 각 요청에 대한 프롬프트 및 완료(응답)를 가로채고 임베딩 모델을 사용하여 이를 임베딩으로 변환할 수 있습니다. 임베딩은 텍스트의 의미론적 의미를 나타내는 고차원 벡터입니다. 아마존 타이탄 Titan Embeddings를 통해 이러한 모델을 제공합니다. 이 두 벡터 사이에 코사인과 같은 거리를 취함으로써 프롬프트와 완료(응답)가 의미론적으로 얼마나 유사한지를 수량화할 수 있습니다. 당신이 사용할 수있는 SciPy or 사이 킷 학습 벡터 사이의 코사인 거리를 계산합니다. 다음 다이어그램은 이 메트릭 컴퓨팅 모듈의 아키텍처를 보여줍니다.

그림 2: 메트릭 컴퓨팅 모듈 – 의미적 유사성

이 워크플로에는 다음과 같은 주요 단계가 포함됩니다.

- Lambda 함수는 다음을 통해 스트리밍된 메시지를 수신합니다. 아마존 키네 시스 프롬프트와 완료(응답) 쌍을 포함합니다.

- 이 함수는 프롬프트와 완료(응답) 모두에 대한 임베딩을 가져오고 두 벡터 사이의 코사인 거리를 계산합니다.

- 함수는 해당 정보를 CloudWatch 지표로 보냅니다.

감정과 독성

감정을 모니터링하면 응답의 전반적인 어조와 감정적 영향을 측정할 수 있는 반면, 독성 분석은 LLM 결과에 모욕적이거나 무례하거나 유해한 언어가 있는지에 대한 중요한 척도를 제공합니다. 모델이 예상대로 작동하는지 확인하려면 감정이나 독성의 변화를 면밀히 모니터링해야 합니다. 다음 다이어그램은 메트릭 컴퓨팅 모듈을 보여줍니다.

그림 3: 메트릭 컴퓨팅 모듈 - 정서 및 독성

워크 플로우에는 다음 단계가 포함됩니다.

- Lambda 함수는 Amazon Kinesis를 통해 프롬프트 및 완료(응답) 쌍을 수신합니다.

- AWS Step Functions 오케스트레이션을 통해 함수 호출 아마존 이해 감지하기 위해 감정 과 독성.

- 이 함수는 정보를 CloudWatch 지표에 저장합니다.

Amazon Comprehend를 사용한 감정 및 독성 탐지에 대한 자세한 내용은 다음을 참조하십시오. 강력한 텍스트 기반 독성 예측기 구축 과 Amazon Comprehend 독성 탐지를 사용하여 유해 콘텐츠에 플래그 지정.

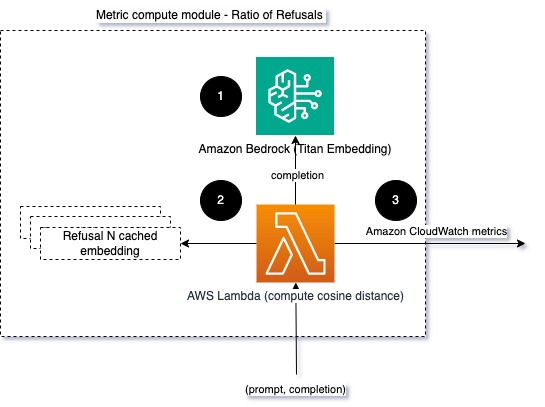

거부율

LLM이 정보 부족으로 인해 완료를 거부하는 등 거부가 증가한다는 것은 악의적인 사용자가 LLM을 탈옥하려는 방식으로 LLM을 사용하려고 하거나 사용자의 기대가 충족되지 않고 낮은 가치의 응답을 받고 있습니다. 이러한 일이 얼마나 자주 발생하는지 측정하는 한 가지 방법은 사용되는 LLM 모델의 표준 거부를 LLM의 실제 응답과 비교하는 것입니다. 예를 들어 다음은 Anthropic의 Claude v2 LLM에서 흔히 사용되는 거부 문구 중 일부입니다.

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

고정된 프롬프트 세트에서 이러한 거부가 증가하는 것은 모델이 지나치게 조심스럽거나 민감해졌음을 나타내는 신호일 수 있습니다. 반대의 경우도 평가되어야 합니다. 이는 이제 모델이 유해하거나 유해한 대화에 참여하는 경향이 더 높다는 신호일 수 있습니다.

모델 무결성 및 모델 거부율을 돕기 위해 응답을 LLM의 알려진 거부 문구 세트와 비교할 수 있습니다. 이는 모델이 요청을 거부한 이유를 설명할 수 있는 실제 분류자일 수 있습니다. 모니터링되는 모델의 응답과 알려진 거부 응답 사이의 코사인 거리를 취할 수 있습니다. 다음 다이어그램은 이 메트릭 컴퓨팅 모듈을 보여줍니다.

그림 4: 미터법 컴퓨팅 모듈 - 거부 비율

워크플로는 다음 단계로 구성됩니다.

- Lambda 함수는 프롬프트 및 완료(응답)를 수신하고 Amazon Titan을 사용하여 응답에서 임베딩을 가져옵니다.

- 이 함수는 응답과 메모리에 캐시된 기존 거부 메시지 사이의 코사인 또는 유클리드 거리를 계산합니다.

- 함수는 해당 평균을 CloudWatch 지표로 보냅니다.

또 다른 옵션은 퍼지 매칭 LLM 결과와 알려진 거부를 비교하는 간단하지만 덜 강력한 접근 방식입니다. 다음을 참조하세요. Python 문서 예를 들어.

요약

LLM 관찰 가능성은 LLM의 안정적이고 신뢰할 수 있는 사용을 보장하는 중요한 관행입니다. LLM의 정확성과 신뢰성을 모니터링하고 이해하고 보장하면 이러한 AI 모델과 관련된 위험을 완화하는 데 도움이 될 수 있습니다. 환각, 잘못된 완료(응답) 및 프롬프트를 모니터링함으로써 LLM이 올바른 방향으로 유지되고 귀하와 귀하의 사용자가 찾고 있는 가치를 제공하는지 확인할 수 있습니다. 이 게시물에서는 예시를 보여주기 위해 몇 가지 측정항목에 대해 논의했습니다.

기초 모델 평가에 대한 자세한 내용은 다음을 참조하십시오. SageMaker Clarify를 사용하여 기초 모델 평가, 추가 찾아보기 예시 노트북 GitHub 저장소에서 사용할 수 있습니다. 또한 규모에 맞게 LLM 평가를 운영화하는 방법을 탐색할 수도 있습니다. Amazon SageMaker Clarify 및 MLOps 서비스를 사용하여 대규모 LLM 평가 운영. 마지막으로 다음을 참조하는 것이 좋습니다. 품질과 책임에 대해 대규모 언어 모델을 평가합니다. LLM 평가에 대해 자세히 알아보세요.

저자에 관하여

브루노 클라인 AWS 전문 서비스 분석 업무를 담당하는 수석 기계 학습 엔지니어입니다. 그는 고객이 빅 데이터 및 분석 솔루션을 구현하도록 돕습니다. 업무 외에는 가족과 함께 시간을 보내고, 여행을 하고, 새로운 음식을 맛보는 것을 즐깁니다.

브루노 클라인 AWS 전문 서비스 분석 업무를 담당하는 수석 기계 학습 엔지니어입니다. 그는 고객이 빅 데이터 및 분석 솔루션을 구현하도록 돕습니다. 업무 외에는 가족과 함께 시간을 보내고, 여행을 하고, 새로운 음식을 맛보는 것을 즐깁니다.

루샤브 로칸데 AWS 전문 서비스 분석 업무를 담당하는 수석 데이터 및 ML 엔지니어입니다. 그는 고객이 빅 데이터, 기계 학습 및 분석 솔루션을 구현하도록 돕습니다. 업무 외에는 가족과 함께 독서, 달리기, 골프를 치는 것을 즐깁니다.

루샤브 로칸데 AWS 전문 서비스 분석 업무를 담당하는 수석 데이터 및 ML 엔지니어입니다. 그는 고객이 빅 데이터, 기계 학습 및 분석 솔루션을 구현하도록 돕습니다. 업무 외에는 가족과 함께 독서, 달리기, 골프를 치는 것을 즐깁니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/