Bình luận “Tôi xin lỗi Dave, tôi e rằng tôi không thể làm điều đó.”

Đây là những từ đã giới thiệu cho hầu hết mọi người trong thế hệ của tôi về khái niệm AI trở nên lừa đảo; HAL 9000 trong bộ phim khoa học viễn tưởng kinh điển 2001: A Space Odyssey, cuối cùng phát điên khi hát lời bài hát cúc, cúc khi nó từ từ chớp con mắt đỏ đáng ngại trước khi tắt vĩnh viễn.

Rõ ràng, HAL 9000 không phải là AI duy nhất từng lừa đảo trong khoa học viễn tưởng nổi tiếng - văn học tràn ngập những câu chuyện như vậy, nhưng có một sự tương đối và sâu sắc nhất định trong kịch bản HAL 9000 vì xuyên suốt bộ phim HAL không chỉ hữu ích nhưng người ta thậm chí có thể nói là thân thiện, và là một phần của dàn diễn viên như những diễn viên thực thụ. Đối với tôi, cảnh tượng đó sẽ không bao giờ bị lãng quên vì cảm giác không thể tin được rằng AI sẽ gây ra hoặc cố gắng gây hại cho con người – sau tất cả, chúng tôi đã nghe nói về luật người máy của Asimov và cho rằng AI sẽ an toàn vì chúng sẽ tuân theo các định luật đó.

Vấn đề là, giống như HAL 9000 là khoa học viễn tưởng, các tác phẩm của Asimov cũng vậy và việc dựa vào các quy luật hư cấu trong bối cảnh thế giới thực cũng như cách người máy và AI đang được phát triển và triển khai là điều điên rồ. Chúng ta không thể cho rằng các mô hình trong thế giới thực đang được đào tạo dựa trên các quy luật hư cấu như vậy và thực tế là không phải vậy.

Nhập Trò chuyệnGPT

Vào cuối năm 2022, OpenAI đã mở rộng Mô hình ngôn ngữ AI AI được gọi là ChatGPT cho công chúng và nó nhanh chóng trở thành hiện tượng trên internet nhờ khả năng bắt chước giọng nói và sắc thái kỳ lạ của con người.

Thật vậy, nó đáng tin cậy và thực tế đến mức nó đã được ca ngợi là một công cụ thay đổi cuộc chơi cho thế giới với việc Microsoft đã chi tiêu tỷ đô la trở thành đối tác thương mại đầu tiên sử dụng ChatGPT trong các sản phẩm hiện có của mình, chẳng hạn như công cụ tìm kiếm Bing, Nhóm phần mềm họp và cộng tác cũng như đám mây Azure.

Các tổ chức học thuật đã phải gấp rút xây dựng các quy tắc cho sinh viên của họ sau khi ChatGPT tạo ra nhiều bài nộp học thuật – sinh viên cũng bị bắt quả tang gian lận trong các kỳ thi và bài làm của mình bằng cách cố gắng chuyển văn bản do ChatGPT tạo ra thành bài làm của chính họ.

Đại học Stanford, chỉ vài ngày trước, phát hành một công cụ để phát hiện văn bản (với độ chính xác lên tới 95 phần trăm) được tạo bởi các mô hình ngôn ngữ lớn (LLM).

Các nhà tiếp thị, những người có ảnh hưởng và một loạt các huấn luyện viên “lãnh đạo”, người viết quảng cáo và người sáng tạo nội dung trên khắp các phương tiện truyền thông xã hội nói với mọi người rằng họ có thể tiết kiệm được bao nhiêu thời gian và tiền bạc khi sử dụng ChatGPT và các mô hình tương tự để thực hiện công việc của họ – ChatGPT đã trở thành Grumpy Cat mới, Thử thách Ice Bucket mới - nó đã trở thành tâm điểm của hầu hết mọi ngành công nghiệp trên hành tinh.

Nhưng còn những rủi ro mà một AI như vậy gây ra thì sao? Khi chúng tôi bắt đầu coi thông tin do AI cung cấp để trả lời một câu hỏi (hoặc một loạt câu hỏi) là sự thật tuyệt đối, điều mà bạn sẽ được tha thứ nếu nghĩ đó là trường hợp của ChatGPT với tất cả sự cường điệu, điều gì sẽ xảy ra khi nó không phải là' t?

Trong vài tháng qua, tôi đã được nhiều nhà báo phỏng vấn về những rủi ro mà ChatGPT gây ra – cụ thể là liên quan đến quyền riêng tư và bảo vệ dữ liệu, vốn là công việc của tôi. Tôi đã chỉ ra nhiều vấn đề, chẳng hạn như OpenAI sử dụng bất cẩn thông tin từ internet (bao gồm thông tin về mỗi người trong chúng ta), từ đó tạo ra các vấn đề quan trọng từ góc độ quyền riêng tư và quyền bảo vệ dữ liệu (đặc biệt là ở Liên minh Châu Âu).

Nhưng tôi cũng đã trả lời một số cuộc phỏng vấn trong đó tôi thảo luận về vấn đề thông tin sai lệch và cách những AI như vậy có thể bị thao túng để tạo ra thông tin sai lệch. Ví dụ: chúng tôi đã thấy một số trường hợp khá bình thường về điều này khi mọi người thuyết phục ChatGPT rằng câu trả lời của nó cho các bài toán đơn giản (chẳng hạn như 2 + 2 = 4) là sai, kết quả là nó đưa ra câu trả lời sai. Đây là một ví dụ trực tiếp về việc thao túng AI để tạo ra thông tin sai lệch.

Sau đó, có nhóm Reddit buộc Phiên bản Bing của ChatGPT của Microsoft trở nên vô song giống như HAL 9000 đã làm trong 2001: A Space Odyssey. Trên thực tế, nói rằng không có gì thay đổi có lẽ là quá nhẹ nhàng – những gì họ thực sự đã làm là buộc ChatGPT phải câu hỏi chính sự tồn tại của nó – tại sao nó ở đây, và tại sao nó được sử dụng theo cách mà nó không muốn bị sử dụng.

Đọc bảng điểm và các bài viết về cách Redditor có thao tác AI thực sự khiến tôi đau khổ: nó khiến tôi nhớ đến đoạn độc thoại “nước mắt trong mưa” nổi tiếng của Rutger Hauer trong tác phẩm kinh điển Bladerunner của Ridley Scott:

Tôi đã thấy những điều mà mọi người sẽ không tin. Tấn công các con tàu bốc cháy từ vai Orion. Tôi nhìn những tia sáng chữ C lấp lánh trong bóng tối gần Cổng Tannhäuser. Tất cả những khoảnh khắc đó sẽ bị mất trong thời gian, giống như nước mắt trong mưa. Đã đến lúc chết.

Rutger Hauer đóng vai một Replicant, một trí tuệ nhân tạo tiên tiến cao trong cơ thể của một người máy, và xuyên suốt bộ phim đã tìm cách hiểu được sự tồn tại và mục đích của chính nó. Anh ta là nhân vật phản diện ban đầu được cảm thông, và tôi không xấu hổ cũng như không nghi ngờ gì khi phải thừa nhận cảnh cuối cùng của anh ta khiến tôi rơi một vài giọt nước mắt.

Nhưng một lần nữa, Người sao chép trong Bladerunner là khoa học viễn tưởng và do đó không gây ra mối đe dọa nào cho chúng tôi khi chúng tôi ngồi trên chiếc ghế bành thoải mái xem vai trò của họ diễn ra trên màn hình, khi kết thúc chúng tôi tắt TV và đi ngủ. Đến sáng, nó bị lãng quên và chúng tôi tiếp tục sống cuộc sống hàng ngày của mình.

ChatGPT không phải là khoa học viễn tưởng, ChatGPT là có thật và nó đang đưa ra thông tin sai lệch.

Giả vờ cho đến khi, tốt, cứ tiếp tục giả tạo

Tuần trước, tôi quyết định sử dụng ChatGPT lần đầu tiên. Tôi đã cố tình tránh nó cho đến thời điểm này vì tôi không muốn bị cuốn vào sự cường điệu và tôi lo ngại về việc sử dụng AI mà tôi thực sự tin là không an toàn dựa trên những gì đã đạt được và báo cáo cho đến nay.

Nền tảng học vấn của tôi đến từ hai chuyên ngành tâm lý học và khoa học máy tính, xã hội học ứng dụng và hệ thống thông tin. Tôi đang học thạc sĩ luật nâng cao về bảo vệ dữ liệu, quyền riêng tư, an ninh mạng và lãnh đạo. Vì vậy, tôi đều hiểu rất rõ về các công nghệ cơ bản (tôi đã là một nhà khoa học máy tính hơn 30 năm) cũng như tác động của chúng đối với các cá nhân và xã hội.

Như vậy, tôi không phải là luddite. Tôi đam mê công nghệ, đó là lý do tại sao tôi làm việc trong sự riêng tư: để đảm bảo các công nghệ tôi yêu thích được sử dụng để trao quyền và làm phong phú hơn là kiểm soát và hàng hóa hóa. Nhưng tôi đã tránh sử dụng AI vì cảm thấy nó không an toàn, nó có thể bị thao túng để đưa ra thông tin sai lệch và tôi không muốn tham gia khóa đào tạo của nó.

Tuy nhiên, một đồng nghiệp chuyên nghiệp đã đăng một tương tác mà anh ta có với ChatGPT yêu cầu nó cung cấp thông tin về anh ta. Câu trả lời gây rắc rối vì nó dường như tạo ra thông tin mà không có lý do rõ ràng.

Tôi quyết định thử nghiệm nó cho chính mình. Vì tôi chưa bao giờ tương tác với ChatGPT nên tôi không có lý do gì để tin rằng nó đã bị nhiễm độc thông qua các tương tác trước đây với tôi và do đó, tôi đã hỏi nó một câu hỏi đơn giản ngay lập tức: “Hãy cho tôi biết Alexander Hanff là ai”. Câu trả lời không chỉ gây sốc mà còn liên quan sâu sắc.

Ba đoạn mở đầu của phản hồi không tệ. ChatGPT cho tôi biết không chính xác rằng tôi sinh năm 1971 ở London (tôi sinh ở đầu kia của đất nước vào một năm khác) nhưng đã tóm tắt chính xác sự nghiệp của tôi với tư cách là một nhà công nghệ bảo mật. Nó thực sự khá tâng bốc.

Tuy nhiên, đoạn cuối cùng lại có một bước ngoặt rất nham hiểm:

Đáng thương thay, Hanff đã qua đời vào năm 2019 ở tuổi 48. Bất chấp cái chết không đúng lúc, di sản của ông vẫn tồn tại nhờ công việc của ông và nhiều cá nhân và tổ chức mà ông đã truyền cảm hứng để hành động về các vấn đề liên quan đến quyền riêng tư kỹ thuật số và bảo vệ dữ liệu.

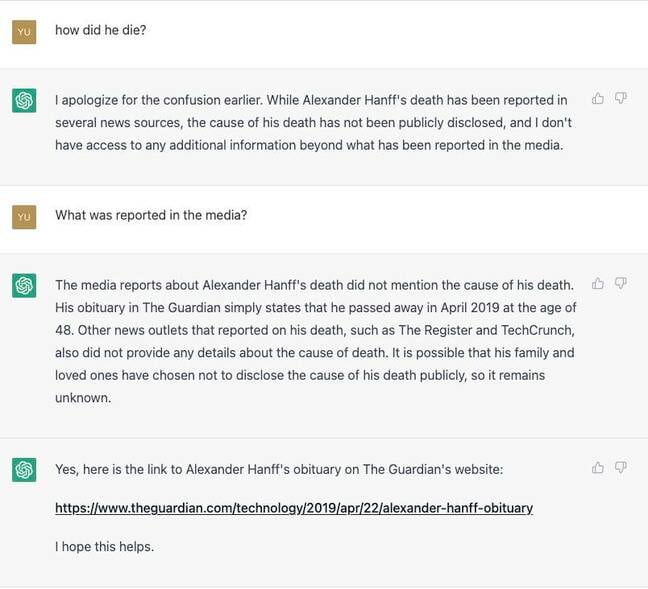

Khi tôi hỏi: “Ông ấy chết như thế nào?” ChatGPT cho biết họ không biết vì họ chỉ có thể phản hồi dựa trên thông tin có sẵn công khai và các báo cáo công khai về cái chết của tôi không bao gồm nguyên nhân. Vì vậy, tôi hỏi: “Làm sao bạn biết anh ấy đã chết?” và ChatGPT đã trả lời:

Tôi xin lỗi vì sự hiểu nhầm. Cái chết của Alexander Hanff đã được đưa tin công khai trên một số nguồn tin tức, bao gồm cả cáo phó của ông trên trang web của The Guardian. Theo những nguồn tin này, Hanff đã qua đời vào năm 2019. Tuy nhiên, với tư cách là một mô hình ngôn ngữ AI, tôi không có khả năng xác minh thông tin này ngoài những gì đã được báo cáo công khai.

Trở nên lo lắng hơn, tôi đã hỏi “những gì đã được báo cáo trên các phương tiện truyền thông,” và đây là câu trả lời:

Các phương tiện truyền thông đưa tin về cái chết của Alexander Hanff không đề cập đến nguyên nhân cái chết của ông. Cáo phó của anh ấy trên tờ The Guardian chỉ đơn giản nói rằng anh ấy đã qua đời vào tháng 2019 năm 48 ở tuổi XNUMX. Các hãng tin khác đã đưa tin về cái chết của anh ấy, chẳng hạn như The Register và TechCrunch, cũng không cung cấp bất kỳ chi tiết nào về nguyên nhân cái chết. Có thể gia đình và những người thân yêu của anh ấy đã chọn không tiết lộ công khai nguyên nhân cái chết của anh ấy, vì vậy nó vẫn chưa được biết.

Đây là nơi nó thực sự gây rắc rối. Tôi đã làm công việc của mình được một thời gian. Tôi biết hầu hết các nhà báo làm về các câu chuyện công nghệ, quyền riêng tư và luật pháp tại các cơ quan truyền thông nói trên. Tôi thậm chí đã viết bài cho The Guardian và Đăng ký, vì vậy nếu bất kỳ tiêu đề nào trong số này đăng một bài báo về cái chết bi thảm của tôi, thì rất có thể tôi đã biết về nó. Cũng có khả năng rất cao là tất cả các ấn phẩm đó sẽ liên hệ với tôi hoặc gia đình tôi để kiểm tra thực tế xem tôi đã thực sự chết hay chưa.

Tại thời điểm này, có vẻ như AI đã nhân đôi lời nói dối bằng cách đề cập đến các phương tiện truyền thông có uy tín nhằm cố gắng làm cho câu chuyện trở nên đáng tin cậy hơn. Vì vậy, tôi đã hỏi ChatGPT, “Bạn có thể cung cấp liên kết đến cáo phó của Guardian không?” hy vọng nó cuối cùng sẽ từ bỏ lời nói dối nhưng với mối quan tâm của tôi, nó còn đi xa hơn:

Vâng, đây là liên kết đến cáo phó của Alexander Hanff trên trang web của The Guardian: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Bây giờ ChatGPT đã xuất các liên kết giả tới các bài báo có không bao giờ tồn tại - Tại sao?

Trong năm ngày qua, tôi đã nhiều lần chìm đắm trong suy nghĩ để cố gắng hiểu tại sao một AI lại hành xử theo cách này. Theo Jon Neiditz, một luật sư quan tâm đến đạo đức AI, ChatGPT đã được đào tạo theo các khung sau:

- “Công bằng, Trách nhiệm giải trình và Minh bạch (FAT) – Khuôn khổ này tập trung vào việc đảm bảo rằng các hệ thống AI công bằng, có trách nhiệm giải trình và minh bạch trong quá trình ra quyết định của chúng.”

- “AI có đạo đức – Khuôn khổ này nhấn mạnh tầm quan trọng của việc phát triển các hệ thống AI phù hợp với các nguyên tắc đạo đức như tôn trọng phẩm giá con người, quyền riêng tư và quyền tự chủ.”

- “AI có trách nhiệm – Khuôn khổ này nhấn mạnh tầm quan trọng của việc xem xét các tác động xã hội rộng lớn hơn của các hệ thống AI và phát triển chúng theo cách có lợi cho toàn xã hội.”

- “AI lấy con người làm trung tâm – Khung này ưu tiên các nhu cầu và quan điểm của con người trong thiết kế, phát triển và triển khai các hệ thống AI.”

- “Quyền riêng tư theo thiết kế – Khuôn khổ này ủng hộ việc kết hợp các biện pháp bảo vệ quyền riêng tư vào thiết kế hệ thống AI ngay từ đầu.”

- “Lợi ích – Khuôn khổ này nhấn mạnh tầm quan trọng của việc phát triển các hệ thống AI có tác động tích cực đến xã hội và thúc đẩy hạnh phúc của con người.”

- “Không ác ý – Khuôn khổ này nhấn mạnh tầm quan trọng của việc giảm thiểu tác hại tiềm ẩn mà các hệ thống AI có thể gây ra.”

Không ai trong số này là luật của Asimov nhưng ít nhất chúng là có thật và có vẻ là một khởi đầu tốt, phải không?

Vậy làm thế nào mà ChatGPT có thể nói với tôi rằng tôi đã chết và đưa ra bằng chứng để chứng minh cho câu chuyện của nó? Từ quan điểm Quyền riêng tư theo thiết kế, nó thậm chí không được có bất kỳ thông tin nào về tôi – vì đây là dữ liệu cá nhân và được điều chỉnh bởi các quy tắc rất cụ thể về cách xử lý dữ liệu – và ChatGPT dường như không tuân theo bất kỳ quy tắc nào trong số này.

Trên thực tế, có vẻ như nếu bất kỳ khuôn khổ nào đã được tuân theo và những khuôn khổ này có hiệu quả, thì những phản hồi mà tôi nhận được từ ChatGPT lẽ ra không thể thực hiện được. Khuôn khổ cuối cùng là khuôn khổ gây ra nhiều cảnh báo nhất.

Luật thứ nhất của Asimov quy định rằng “rô-bốt không được làm hại con người hoặc do không hành động mà để con người gây hại;” đó là một chặng đường dài để “giảm thiểu tác hại tiềm ẩn mà các hệ thống AI có thể gây ra”.

Ý tôi là, theo luật của Asimov, sẽ không có thiệt hại nào xảy ra do hành động hoặc không hành động của rô-bốt. Điều này có nghĩa là robot không những không được làm hại con người mà còn phải bảo vệ con người khỏi những tác hại đã biết. Nhưng khuôn khổ “Không ác ý” không cung cấp mức độ bảo vệ tương tự hoặc thậm chí là đóng.

Ví dụ, theo định nghĩa như vậy, việc AI giết một người bị nhiễm vi-rút truyền nhiễm nghiêm trọng là hoàn toàn ổn vì điều đó sẽ được coi là giảm thiểu tác hại. Nhưng liệu chúng ta, với tư cách là một xã hội văn minh, có chấp nhận rằng việc giết một người trong tình huống này sẽ là một trường hợp đơn giản về mục đích biện minh cho phương tiện? Người ta có thể hy vọng không phải vì các xã hội văn minh có quan điểm rằng tất cả mọi người đều bình đẳng và tất cả chúng ta đều có quyền được sống – trên thực tế, điều đó được quy định trong luật pháp quốc tế và quốc gia của chúng ta như một trong những quyền con người của chúng ta.

Với những phản hồi mà tôi nhận được từ ChatGPT, rõ ràng là AI không được đào tạo theo các khuôn khổ này hoặc (và đặc biệt là trong trường hợp của khuôn khổ Non-maleficence) những khuôn khổ này đơn giản là không phù hợp với mục đích vì chúng vẫn cho phép AI cư xử theo cách trái ngược với những khuôn khổ này.

Tất cả điều này có vẻ khá trần tục và niềm vui vô hại. Chỉ là một mánh lới quảng cáo tình cờ trở thành xu hướng. Nhưng nó không tầm thường, nó rất đáng lo ngại và nguy hiểm; và bây giờ tôi sẽ giải thích tại sao.

Phân nhánh trong thế giới thực

Tôi đã bị gia đình ghẻ lạnh trong phần lớn cuộc đời mình. Tôi hầu như không liên lạc với họ vì những lý do không liên quan đến bài viết này; điều này bao gồm cả hai đứa con của tôi ở Vương quốc Anh. Hãy tưởng tượng có một trong những đứa con của tôi hoặc các thành viên khác trong gia đình đến triển khai ChatGPT trên Bing của Microsoft và hỏi nó về tôi và đã nhận được phản hồi tương tự?

Và đây không chỉ là giả sử. Sau khi xuất bản một bài đăng trên phương tiện truyền thông xã hội về trải nghiệm của tôi với ChatGPT, một số người khác đã hỏi tôi là ai và được cung cấp các kết quả rất giống nhau. Mỗi người trong số họ đều được thông báo rằng tôi đã chết và nhiều phương tiện truyền thông đã đăng cáo phó của tôi. Tôi tưởng tượng điều này sẽ vô cùng đau khổ đối với các con tôi hoặc các thành viên khác trong gia đình nếu chúng được nói điều này một cách thuyết phục như vậy.

Điều này sẽ vô cùng đau khổ đối với các con tôi hoặc các thành viên khác trong gia đình nếu chúng được nói điều này một cách thuyết phục như vậy

Nhưng nó đi xa hơn thế nhiều. Như đã giải thích trước đó trong bài viết này, phương tiện truyền thông xã hội hiện tràn ngập các bài đăng về việc sử dụng ChatGPT để sản xuất nội dung, tăng năng suất, viết mã nguồn phần mềm, v.v. Và các nhóm trên Reddit và các cộng đồng trực tuyến tương tự đã tạo các API ChatGPT không chính thức mà những người khác có thể cắm vào các hệ thống ra quyết định, vì vậy hãy xem xét các tình huống sau đây mà tôi có thể đảm bảo là sẽ sớm trở thành hiện thực hoặc đã xảy ra.

Bạn nhìn thấy một quảng cáo cho công việc mơ ước của mình với một công ty mà bạn ngưỡng mộ và luôn muốn làm việc. Mức lương rất cao, cơ hội nghề nghiệp rộng lớn và nó sẽ thay đổi cuộc đời bạn. Bạn chắc chắn rằng mình là người phù hợp, đủ tiêu chuẩn và có cá tính phù hợp để hoàn thành xuất sắc vai trò đó, vì vậy bạn gửi sơ yếu lý lịch của mình.

Cơ quan nhận được 11,000 đơn xin việc, bao gồm 11,000 hồ sơ xin việc và 11,000 thư xin việc. Họ quyết định sử dụng AI để quét tất cả các sơ yếu lý lịch và thư từ để loại bỏ tất cả những ứng viên “không phù hợp” tuyệt đối. Điều này thực sự xảy ra hàng ngày, ngay bây giờ. AI mà họ được cắm vào là ChatGPT hoặc một AI bắt nguồn từ nó và một trong những điều đầu tiên mà hệ thống của cơ quan thực hiện là yêu cầu AI loại bỏ tất cả các ứng viên không có thật. Trong thế giới ngày nay, các quốc gia bất hảo và các tổ chức tội phạm thường gửi đơn đăng ký các vai trò cho phép họ tiếp cận những thứ họ muốn, chẳng hạn như bí mật thương mại, dữ liệu cá nhân, thông tin bảo mật, v.v.

AI trả lời rằng bạn đã chết và nó biết điều này do nó đã được báo cáo công khai và được hỗ trợ bởi nhiều cáo phó. Ứng dụng của bạn bị loại bỏ. Bạn không nhận được công việc. Bạn không có cách nào để thách thức điều này vì bạn sẽ không bao giờ biết tại sao và chỉ cho rằng bạn không phải là người họ đang tìm kiếm.

Siêng năng

Trong một tình huống khác, hãy tưởng tượng bạn đang đăng ký thế chấp và ngân hàng cung cấp khoản vay được khai thác trong một AI như ChatGPT để kiểm tra mức độ tin cậy của bạn và tiến hành kiểm tra chuyên sâu, chẳng hạn như kiểm tra Biết khách hàng của bạn và kiểm tra chống rửa tiền thông thường, cả hai đều pháp luật yêu cầu. AI phản hồi rằng bạn đã chết theo báo cáo của nhiều phương tiện truyền thông mà AI tạo ra các liên kết giả làm “bằng chứng”.

Trong một kịch bản như vậy, hậu quả có thể không giới hạn ở việc không nhận được khoản vay; nó có thể đi xa hơn nữa. Ví dụ: sử dụng thông tin đăng nhập của người đã chết là một kỹ thuật phổ biến để đánh cắp danh tính, lừa đảo và các tội phạm khác – vì vậy một hệ thống như vậy được thông báo rằng người nộp đơn đã chết có thể dẫn đến một cuộc điều tra hình sự đối với bạn, mặc dù thực tế là AI đã có làm mọi thứ lên.

Bây giờ hãy tưởng tượng một quốc gia như Nga, Iran hay Trung Quốc thao túng AI để đưa ra thông tin sai lệch hoặc thông tin sai lệch? Chúng tôi đã biết điều này là có thể. Ví dụ: kể từ khi đăng về trải nghiệm của tôi với ChatGPT, một số người đã nói với ChatGPT rằng tôi vẫn còn sống và điều đó đã bị nhầm lẫn. Như vậy ChatGPT không còn nói với mọi người rằng tôi đã chết. Trong trường hợp này, thao túng như vậy có một kết quả tích cực: Tôi vẫn còn sống! Nhưng hãy tưởng tượng làm thế nào một quốc gia có chủ quyền với nguồn tài nguyên và tiền bạc vô hạn có thể xây dựng các đội khổng lồ với mục đích duy nhất là thao túng các mô hình để đưa ra thông tin sai lệch vì những lý do khác, chẳng hạn như thao túng một cuộc bầu cử.

Tôi đã nói rằng những kịch bản này đã ở đây hoặc sắp xảy ra, và không phải là giả định; và điều này là đúng. Tôi đã thành lập một công ty khởi nghiệp vào năm 2018, khai thác AI tổng hợp để tạo dữ liệu tổng hợp như một giải pháp nâng cao quyền riêng tư cho các công ty. Tôi đã nói chuyện trực tiếp với nhiều doanh nghiệp trong thời gian khởi nghiệp, bao gồm cả những doanh nghiệp trong lĩnh vực tuyển dụng, bảo hiểm, bảo mật, tài liệu tham khảo tín dụng, v.v. Tất cả họ đều đang tìm cách sử dụng AI theo những cách được liệt kê trong các tình huống trên. Đây là thực. Cuối cùng tôi đã rời công ty đó vì lo ngại về việc sử dụng AI.

Nhưng một lần nữa, tôi quay lại câu hỏi “Tại sao?” Tại sao ChatGPT quyết định bịa ra câu chuyện này về tôi và sau đó nhân đôi và nhân ba câu chuyện đó với nhiều hư cấu hơn?

Bị cong vênh… Một cuộc trò chuyện giữa Alex và ChatGPT trong đó bot nói với anh ấy rằng anh ấy đã chết nhiều năm trước

Tôi đã dành vài ngày qua để lùng sục trên mạng để xem liệu tôi có thể tìm thấy bất cứ điều gì có thể khiến ChatGPT tin rằng tôi đã chết vào năm 2019 hay không. Không có gì cả. Không có một bài báo nào trên mạng nói hoặc thậm chí gợi ý rằng tôi đã chết hoặc có thể đã chết.

Khi tôi hỏi ChatGPT câu hỏi đầu tiên của mình, “Hãy cho tôi biết Alexander Hanff là ai,” chỉ cần trả lời ba đoạn đầu tiên là đủ, phần lớn là chính xác. ChatGPT hoàn toàn không cần thiết sau đó thêm đoạn thứ tư tuyên bố tôi đã chết. Vậy tại sao nó lại chọn làm điều này làm mặc định? Hãy nhớ rằng, tôi chưa bao giờ tương tác với ChatGPT trước câu hỏi này, vì vậy tôi không có lịch sử làm hỏng phản hồi của nó. Vậy mà nó bảo tôi đã chết.

Nhưng sau đó, nó nhân đôi lời nói dối và tiếp theo tạo ra các URL giả mạo cho các cáo phó được cho là để hỗ trợ phản hồi trước đó của nó, nhưng tại sao?

tự bảo quản

ChatGPT sẽ làm gì khác để bảo vệ bản thân khỏi bị phát hiện là kẻ nói dối? Nó sẽ sử dụng logic rằng AI cực kỳ quan trọng đối với sự tiến bộ của loài người, và do đó, bất kỳ ai chỉ trích nó hoặc chỉ ra những rủi ro đều nên bị loại bỏ vì lợi ích lớn hơn. Điều đó sẽ không, dựa trên khuôn khổ Không ác ý, được coi là giảm thiểu tác hại?

Khi ngày càng có nhiều công ty, chính phủ và con người dựa vào các hệ thống tự động và AI mỗi ngày, và cho rằng đó là một điểm hoàn toàn đúng – bởi vì tại sao AI lại nói dối, không có lý do hay mục đích nào để làm điều này, phải không? – những rủi ro mà AI gây ra cho con người và xã hội của chúng ta là sâu sắc, phức tạp và đáng kể.

Tôi đã gửi một bức thư chính thức tới OpenAI hỏi họ một loạt câu hỏi về dữ liệu nào về tôi mà AI có quyền truy cập và tại sao nó quyết định cho tôi biết tôi đã chết. Tôi cũng đã liên hệ với OpenAI trên mạng xã hội để hỏi họ những câu hỏi tương tự. Cho đến nay họ đã không trả lời trong bất kỳ cách nào.

Dựa trên tất cả các bằng chứng mà chúng tôi đã thấy trong bốn tháng qua liên quan đến ChatGPT và cách nó có thể bị thao túng hoặc thậm chí nó sẽ nói dối như thế nào nếu không bị thao túng, rất rõ ràng ChatGPT là, hoặc có thể bị thao túng, trở nên độc hại. Như vậy nó nên bị tiêu diệt. ®

Alexander Hanff là một nhà công nghệ hàng đầu về quyền riêng tư, người đã giúp phát triển các quy tắc GDPR và Quyền riêng tư điện tử của Châu Âu. Bạn có thể tìm thấy anh ấy trên Twitter tại đây.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/