Đây là bài viết của khách được đồng sáng tác với Scott Gutterman từ PGA TOUR.

Trí tuệ nhân tạo sáng tạo (generative AI) đã tạo ra những khả năng mới để xây dựng các hệ thống thông minh. Những cải tiến gần đây về các mô hình ngôn ngữ lớn (LLM) dựa trên Generative AI đã cho phép sử dụng chúng trong nhiều ứng dụng xung quanh việc truy xuất thông tin. Dựa trên các nguồn dữ liệu, LLM đã cung cấp các công cụ cho phép chúng tôi xây dựng một chatbot Hỏi & Đáp trong vài tuần, thay vì những gì có thể phải mất nhiều năm trước và có thể có hiệu suất kém hơn. Chúng tôi đã xây dựng giải pháp Thế hệ truy xuất-tăng cường (RAG) cho phép PGA TOUR tạo nguyên mẫu cho nền tảng tương tác với người hâm mộ trong tương lai có thể giúp người hâm mộ có thể truy cập dữ liệu của mình theo kiểu tương tác ở định dạng hội thoại.

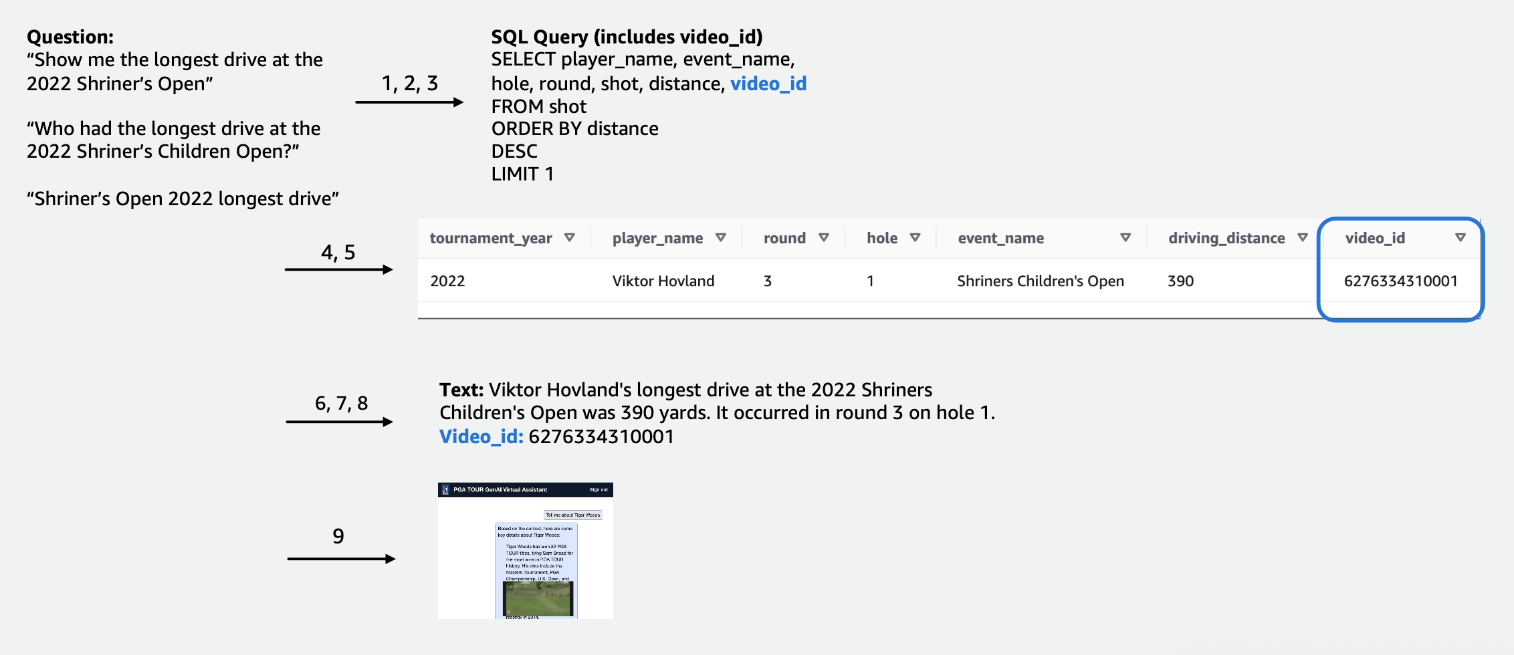

Việc sử dụng dữ liệu có cấu trúc để trả lời các câu hỏi đòi hỏi phải có cách trích xuất dữ liệu có liên quan đến truy vấn của người dùng một cách hiệu quả. Chúng tôi đã xây dựng phương pháp chuyển văn bản sang SQL trong đó truy vấn ngôn ngữ tự nhiên của người dùng được chuyển đổi thành câu lệnh SQL bằng LLM. SQL được điều hành bởi amazon Athena để trả về dữ liệu liên quan. Dữ liệu này một lần nữa được cung cấp cho LLM, LLM được yêu cầu trả lời truy vấn của người dùng dựa trên dữ liệu.

Việc sử dụng dữ liệu văn bản yêu cầu một chỉ mục có thể được sử dụng để tìm kiếm và cung cấp ngữ cảnh có liên quan cho LLM nhằm trả lời truy vấn của người dùng. Để cho phép truy xuất thông tin nhanh chóng, chúng tôi sử dụng Amazon Kendra làm chỉ mục cho các tài liệu này. Khi người dùng đặt câu hỏi, trợ lý ảo của chúng tôi sẽ nhanh chóng tìm kiếm thông qua chỉ mục Amazon Kendra để tìm thông tin liên quan. Amazon Kendra sử dụng xử lý ngôn ngữ tự nhiên (NLP) để hiểu truy vấn của người dùng và tìm tài liệu phù hợp nhất. Thông tin liên quan sau đó được cung cấp cho LLM để tạo phản hồi cuối cùng. Giải pháp cuối cùng của chúng tôi là sự kết hợp các phương pháp chuyển văn bản sang SQL và RAG văn bản này.

Trong bài đăng này, chúng tôi nhấn mạnh cách Trung tâm Sáng tạo AI Sáng tạo AWS đã hợp tác với Dịch vụ chuyên nghiệp của AWS và PGA TOUR để phát triển một trợ lý ảo nguyên mẫu bằng cách sử dụng nền tảng Amazon có thể cho phép người hâm mộ trích xuất thông tin về bất kỳ chi tiết sự kiện, người chơi, lỗ hoặc cấp độ đánh nào theo cách tương tác liền mạch. Amazon Bedrock là một dịch vụ được quản lý toàn phần cung cấp nhiều lựa chọn mô hình nền tảng (FM) hiệu suất cao từ các công ty AI hàng đầu như AI21 Labs, Anthropic, Cohere, Meta, Stability AI và Amazon thông qua một API duy nhất, cùng với một loạt các các khả năng bạn cần để xây dựng các ứng dụng AI tổng quát có tính bảo mật, quyền riêng tư và AI có trách nhiệm.

Phát triển: Chuẩn bị sẵn sàng dữ liệu

Như với bất kỳ dự án dựa trên dữ liệu nào, hiệu suất sẽ chỉ tốt như dữ liệu. Chúng tôi đã xử lý dữ liệu để cho phép LLM có thể truy vấn và truy xuất dữ liệu liên quan một cách hiệu quả.

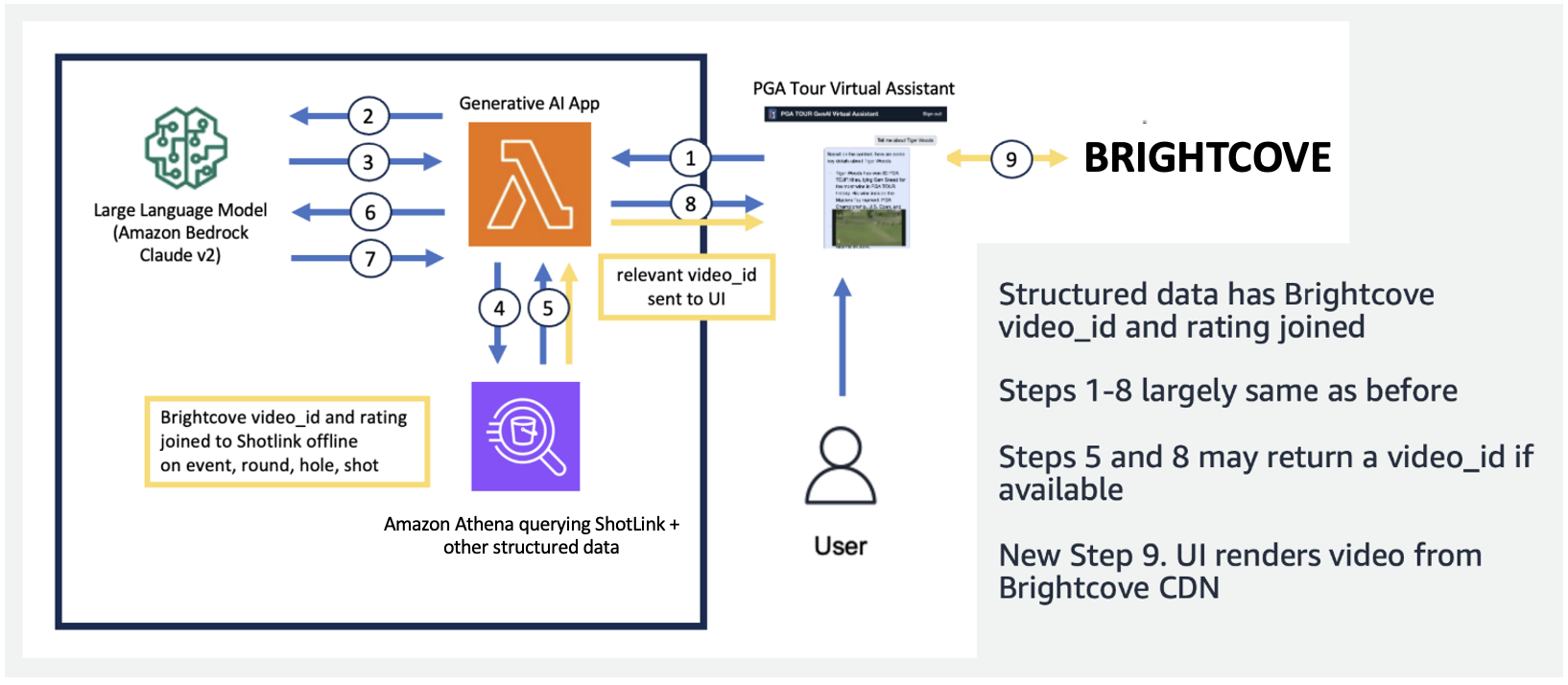

Đối với dữ liệu cạnh tranh dạng bảng, chúng tôi tập trung vào một tập hợp con dữ liệu có liên quan đến số lượng truy vấn lớn nhất của người dùng và gắn nhãn các cột một cách trực quan để LLM dễ hiểu hơn. Chúng tôi cũng đã tạo một số cột phụ trợ để giúp LLM hiểu các khái niệm mà nó có thể gặp khó khăn. Ví dụ: nếu một gôn thủ bắn một cú đánh ít hơn par (chẳng hạn như lọt vào lỗ sau 3 cú đánh trên par 4 hoặc 4 cú đánh trên par 5), thì điều đó thường được gọi là chim chào mào. Nếu người dùng hỏi, “Người chơi X đã thực hiện bao nhiêu cú birdie trong năm ngoái?”, thì việc chỉ có số điểm và par trong bảng là không đủ. Do đó, chúng tôi đã thêm các cột để biểu thị các thuật ngữ phổ biến trong môn chơi gôn, chẳng hạn như bogey, birdie và Eagle. Ngoài ra, chúng tôi đã liên kết dữ liệu Cuộc thi với một bộ sưu tập video riêng bằng cách nối một cột cho một video_id, điều này sẽ cho phép ứng dụng của chúng tôi lấy video được liên kết với một cảnh quay cụ thể trong dữ liệu Cuộc thi. Chúng tôi cũng cho phép nối dữ liệu văn bản với dữ liệu dạng bảng, chẳng hạn như thêm tiểu sử của mỗi người chơi dưới dạng cột văn bản. Các hình dưới đây minh họa quy trình từng bước về cách xử lý một truy vấn cho quy trình chuyển văn bản sang SQL. Các con số chỉ ra chuỗi các bước để trả lời một truy vấn.

Trong hình dưới đây, chúng tôi minh họa đường dẫn từ đầu đến cuối của mình. Chúng tôi sử dụng AWS Lambda là chức năng điều phối của chúng tôi chịu trách nhiệm tương tác với nhiều nguồn dữ liệu, LLM khác nhau và sửa lỗi dựa trên truy vấn của người dùng. Các bước 1-8 tương tự như những gì được hiển thị trong hình tiếp theo. Có những thay đổi nhỏ đối với dữ liệu phi cấu trúc mà chúng ta sẽ thảo luận tiếp theo.

Dữ liệu văn bản yêu cầu các bước xử lý duy nhất để chia nhỏ (hoặc phân đoạn) các tài liệu dài thành các phần mà LLM có thể hiểu được trong khi vẫn duy trì tính mạch lạc của chủ đề. Chúng tôi đã thử nghiệm một số cách tiếp cận và giải quyết theo sơ đồ phân nhóm cấp trang phù hợp tốt với định dạng của Hướng dẫn truyền thông. Chúng tôi đã sử dụng Amazon Kendra, một dịch vụ được quản lý đảm nhiệm việc lập chỉ mục tài liệu mà không yêu cầu thông số kỹ thuật về phần nhúng, đồng thời cung cấp API dễ dàng để truy xuất. Hình dưới đây minh họa kiến trúc này.

Quy trình thống nhất, có thể mở rộng mà chúng tôi đã phát triển cho phép PGA TOUR mở rộng quy mô toàn bộ lịch sử dữ liệu của họ, một số trong đó có từ những năm 1800. Nó cho phép các ứng dụng trong tương lai có thể hoạt động dựa trên bối cảnh khóa học để tạo ra những trải nghiệm thời gian thực phong phú.

Phát triển: Đánh giá LLM và phát triển các ứng dụng AI tổng quát

Chúng tôi đã kiểm tra và đánh giá cẩn thận LLM của bên thứ nhất và bên thứ ba có sẵn trong Amazon Bedrock để chọn mô hình phù hợp nhất cho quy trình và trường hợp sử dụng của chúng tôi. Chúng tôi đã chọn Claude v2 và Claude Instant của Anthropic trên Amazon Bedrock. Đối với đường dẫn dữ liệu có cấu trúc và phi cấu trúc cuối cùng, chúng tôi nhận thấy Claude 2 của Anthropic trên Amazon Bedrock đã tạo ra kết quả tổng thể tốt hơn cho đường dẫn dữ liệu cuối cùng của chúng tôi.

Nhắc nhở là một khía cạnh quan trọng của việc đưa LLM xuất văn bản như mong muốn. Chúng tôi đã dành thời gian đáng kể để thử nghiệm các lời nhắc khác nhau cho từng nhiệm vụ. Ví dụ: đối với quy trình chuyển văn bản sang SQL, chúng tôi đã có một số lời nhắc dự phòng, với độ đặc hiệu ngày càng tăng và các lược đồ bảng được đơn giản hóa dần dần. Nếu truy vấn SQL không hợp lệ và dẫn đến lỗi từ Athena, chúng tôi đã phát triển lời nhắc sửa lỗi để chuyển lỗi và SQL không chính xác tới LLM và yêu cầu LLM sửa lỗi đó. Lời nhắc cuối cùng trong quy trình chuyển văn bản sang SQL yêu cầu LLM lấy đầu ra Athena, đầu ra này có thể được cung cấp ở định dạng Markdown hoặc CSV và đưa ra câu trả lời cho người dùng. Đối với văn bản phi cấu trúc, chúng tôi đã phát triển các lời nhắc chung để sử dụng ngữ cảnh được truy xuất từ Amazon Kendra để trả lời câu hỏi của người dùng. Lời nhắc bao gồm hướng dẫn chỉ sử dụng thông tin được truy xuất từ Amazon Kendra và không dựa vào dữ liệu từ khóa đào tạo trước LLM.

Độ trễ thường là mối lo ngại với các ứng dụng AI tổng quát và trường hợp này cũng xảy ra ở đây. Điều đặc biệt đáng lo ngại đối với việc chuyển văn bản sang SQL, vốn yêu cầu lệnh gọi LLM tạo SQL ban đầu, sau đó là lệnh gọi LLM tạo phản hồi. Nếu chúng ta đang sử dụng LLM lớn, chẳng hạn như Claude V2 của Anthropic, điều này sẽ tăng gấp đôi độ trễ của chỉ một lần gọi LLM. Chúng tôi đã thử nghiệm một số cấu hình LLM lớn và nhỏ hơn để đánh giá thời gian chạy cũng như độ chính xác. Bảng sau đây trình bày ví dụ cho một câu hỏi thể hiện độ trễ cũng như các câu trả lời được tạo bằng Claude V2 và Claude Instant của Anthropic trên Amazon Bedrock.

Prototype

Trong ứng dụng của mình, chúng tôi đã sử dụng hàm Lambda để điều phối các lựa chọn và giao tiếp nhanh chóng giữa Amazon Athena, Amazon Kendra và Amazon Bedrock. Trợ lý ảo có giao diện đàm thoại, được xây dựng bằng React và Hệ thống thiết kế Cloudscape, sử dụng văn bản và video để tương tác với người dùng.

Trợ lý ảo của chúng tôi có thể đưa ra nhiều câu hỏi về các sự kiện, người chơi, số liệu thống kê, lịch sử của PGA TOUR, v.v. Ví dụ: khi được hỏi về những cú đánh bóng dài nhất của Tony Finau tại Shriners Children's Open (một trong những sự kiện đặc trưng của PGA TOUR), trợ lý có thể truy vấn dữ liệu có cấu trúc để lấy dữ liệu về cấp độ cú đánh của anh ấy. Nó có thể trích xuất khoảng cách chính xác tính bằng thước Anh, số vòng và lỗ mà anh ta đạt được kỷ lục này bằng cách sử dụng đường dẫn chuyển văn bản sang SQL. Sau đó, trợ lý sẽ diễn giải dữ liệu số này để tạo ra phản hồi cuối cùng. Bảng sau đây chứa một số câu trả lời mẫu.

| câu hỏi | Phản ứng |

| Cú đánh bóng dài nhất của Tony Finau ở giải Shriners Children's Open là bao nhiêu? | Cú đánh xa nhất mà Tony Finau thực hiện ở Shriners Children's Open là 382 yard, anh đã đánh được trong vòng đầu tiên ở lỗ số 4 năm 2018. |

| Cú đánh bóng dài nhất của Collin Morikawa ở giải Shriners Children's Open là bao nhiêu? | Cú đánh dài nhất của Collin Morikawa tại Shriners Childrens Open là 334 thước Anh. Điều này xảy ra vào năm 2019 trong vòng đầu tiên ở lỗ số 15. |

| Có ai đã giành được quân Át tại Shriners Children's Open 2022 không? | Đúng vậy, Adam Hadwin đã thực hiện cú Hole-in-One ở lỗ 14 trong vòng 3 của Shriners Children's Open 2022 |

Video giải thích sau đây nêu bật một số ví dụ về cách tương tác với trợ lý ảo.

Trong thử nghiệm ban đầu, trợ lý ảo PGA TOUR của chúng tôi đã cho thấy nhiều hứa hẹn trong việc cải thiện trải nghiệm của người hâm mộ. Bằng cách kết hợp các công nghệ AI như chuyển văn bản thành SQL, tìm kiếm ngữ nghĩa và tạo ngôn ngữ tự nhiên, trợ lý này sẽ đưa ra những phản hồi hấp dẫn, giàu thông tin. Người hâm mộ được trao quyền truy cập dễ dàng vào dữ liệu và câu chuyện mà trước đây khó tìm thấy.

Tương lai giữ gìn?

Khi chúng tôi tiếp tục phát triển, chúng tôi sẽ mở rộng phạm vi câu hỏi mà trợ lý ảo của chúng tôi có thể xử lý. Điều này sẽ yêu cầu thử nghiệm rộng rãi thông qua sự cộng tác giữa AWS và PGA TOUR. Theo thời gian, chúng tôi mong muốn phát triển trợ lý thành trải nghiệm đa kênh, được cá nhân hóa, có thể truy cập được trên các giao diện web, thiết bị di động và giọng nói.

Việc thiết lập trợ lý AI tổng hợp dựa trên đám mây cho phép PGA TOUR trình bày nguồn dữ liệu khổng lồ của mình cho nhiều bên liên quan bên trong và bên ngoài. Khi bối cảnh AI tổng quát về thể thao phát triển, nó cho phép tạo ra nội dung mới. Ví dụ: bạn có thể sử dụng AI và máy học (ML) để hiển thị nội dung mà người hâm mộ muốn xem khi họ đang xem một sự kiện hoặc khi đội sản xuất đang tìm kiếm các cảnh quay từ các giải đấu trước phù hợp với sự kiện hiện tại. Ví dụ: nếu Max Homa chuẩn bị thực hiện cú đánh cuối cùng của mình tại PGA TOUR Championship từ một vị trí cách chốt 20 feet, thì PGA TOUR có thể sử dụng AI và ML để xác định và trình bày các clip có bình luận do AI tạo về anh ấy đã thử thực hiện cú đánh tương tự năm lần trước đó. Loại quyền truy cập và dữ liệu này cho phép nhóm sản xuất ngay lập tức tăng thêm giá trị cho chương trình phát sóng hoặc cho phép người hâm mộ tùy chỉnh loại dữ liệu mà họ muốn xem.

“PGA TOUR là công ty dẫn đầu ngành trong việc sử dụng công nghệ tiên tiến để cải thiện trải nghiệm của người hâm mộ. AI đi đầu trong nhóm công nghệ của chúng tôi, nơi nó cho phép chúng tôi tạo ra một môi trường tương tác và hấp dẫn hơn cho người hâm mộ. Đây là sự khởi đầu cho hành trình AI sáng tạo của chúng tôi với sự cộng tác của Trung tâm đổi mới AI sáng tạo AWS để mang lại trải nghiệm mang tính chuyển đổi cho khách hàng từ đầu đến cuối. Chúng tôi đang nỗ lực tận dụng Amazon Bedrock và dữ liệu độc quyền của chúng tôi để tạo ra trải nghiệm tương tác cho người hâm mộ PGA TOUR để tìm thông tin quan tâm về một sự kiện, người chơi, số liệu thống kê hoặc nội dung khác theo kiểu tương tác.”

– Scott Gutterman, SVP phụ trách Thuộc tính Phát thanh và Kỹ thuật số tại PGA TOUR.

Kết luận

Dự án mà chúng tôi đã thảo luận trong bài đăng này minh họa cách hợp nhất các nguồn dữ liệu có cấu trúc và không cấu trúc bằng AI để tạo ra trợ lý ảo thế hệ tiếp theo. Đối với các tổ chức thể thao, công nghệ này cho phép người hâm mộ tương tác sâu sắc hơn và mở ra hiệu quả nội bộ. Thông tin dữ liệu thông minh mà chúng tôi thu được giúp các bên liên quan của PGA TOUR như người chơi, huấn luyện viên, quan chức, đối tác và giới truyền thông đưa ra quyết định sáng suốt nhanh hơn. Ngoài thể thao, phương pháp của chúng tôi có thể được nhân rộng trên bất kỳ ngành nào. Các nguyên tắc tương tự cũng áp dụng cho các trợ lý tòa nhà thu hút khách hàng, nhân viên, sinh viên, bệnh nhân và những người dùng cuối khác. Với thiết kế và thử nghiệm chu đáo, hầu như mọi tổ chức đều có thể hưởng lợi từ hệ thống AI giúp bối cảnh hóa cơ sở dữ liệu, tài liệu, hình ảnh, video và nội dung khác có cấu trúc của họ.

Nếu bạn quan tâm đến việc triển khai các chức năng tương tự, hãy cân nhắc sử dụng Đại lý cho Amazon Bedrock và Cơ sở kiến thức về Amazon Bedrock như một giải pháp thay thế, được quản lý hoàn toàn bởi AWS. Cách tiếp cận này có thể nghiên cứu sâu hơn về việc cung cấp khả năng tìm kiếm dữ liệu và tự động hóa thông minh thông qua các tác nhân có thể tùy chỉnh. Các tác nhân này có khả năng biến đổi các tương tác ứng dụng của người dùng trở nên tự nhiên, hiệu quả và hiệu quả hơn.

Giới thiệu về tác giả

Scott Gutterman là SVP phụ trách Hoạt động Kỹ thuật số của PGA TOUR. Anh ấy chịu trách nhiệm về các hoạt động kỹ thuật số tổng thể, phát triển sản phẩm của TOUR và đang thúc đẩy chiến lược GenAI của họ.

Scott Gutterman là SVP phụ trách Hoạt động Kỹ thuật số của PGA TOUR. Anh ấy chịu trách nhiệm về các hoạt động kỹ thuật số tổng thể, phát triển sản phẩm của TOUR và đang thúc đẩy chiến lược GenAI của họ.

Asan Ali là Nhà khoa học ứng dụng tại Trung tâm đổi mới AI sáng tạo của Amazon, nơi ông làm việc với khách hàng từ các lĩnh vực khác nhau để giải quyết các vấn đề cấp bách và tốn kém của họ bằng cách sử dụng AI sáng tạo.

Asan Ali là Nhà khoa học ứng dụng tại Trung tâm đổi mới AI sáng tạo của Amazon, nơi ông làm việc với khách hàng từ các lĩnh vực khác nhau để giải quyết các vấn đề cấp bách và tốn kém của họ bằng cách sử dụng AI sáng tạo.

Tahin Syed là Nhà khoa học ứng dụng tại Trung tâm đổi mới AI sáng tạo của Amazon, nơi ông làm việc với khách hàng để giúp hiện thực hóa kết quả kinh doanh bằng các giải pháp AI sáng tạo. Ngoài công việc, anh thích thử những món ăn mới, đi du lịch và dạy taekwondo.

Tahin Syed là Nhà khoa học ứng dụng tại Trung tâm đổi mới AI sáng tạo của Amazon, nơi ông làm việc với khách hàng để giúp hiện thực hóa kết quả kinh doanh bằng các giải pháp AI sáng tạo. Ngoài công việc, anh thích thử những món ăn mới, đi du lịch và dạy taekwondo.

Grace Lang là kỹ sư Liên kết dữ liệu & ML của AWS Professional Services. Được thúc đẩy bởi niềm đam mê vượt qua những thử thách khó khăn, Grace giúp khách hàng đạt được mục tiêu của mình bằng cách phát triển các giải pháp hỗ trợ máy học.

Grace Lang là kỹ sư Liên kết dữ liệu & ML của AWS Professional Services. Được thúc đẩy bởi niềm đam mê vượt qua những thử thách khó khăn, Grace giúp khách hàng đạt được mục tiêu của mình bằng cách phát triển các giải pháp hỗ trợ máy học.

Jae Lee là Giám đốc tương tác cấp cao trong ngành M&E của ProServe. Cô lãnh đạo và thực hiện các cam kết phức tạp, thể hiện bộ kỹ năng giải quyết vấn đề mạnh mẽ, quản lý kỳ vọng của các bên liên quan và quản lý các bài thuyết trình ở cấp điều hành. Cô thích làm việc trong các dự án tập trung vào thể thao, AI sáng tạo và trải nghiệm khách hàng.

Jae Lee là Giám đốc tương tác cấp cao trong ngành M&E của ProServe. Cô lãnh đạo và thực hiện các cam kết phức tạp, thể hiện bộ kỹ năng giải quyết vấn đề mạnh mẽ, quản lý kỳ vọng của các bên liên quan và quản lý các bài thuyết trình ở cấp điều hành. Cô thích làm việc trong các dự án tập trung vào thể thao, AI sáng tạo và trải nghiệm khách hàng.

Karn Chahar là Chuyên gia tư vấn bảo mật của nhóm phân phối chung tại AWS. Anh ấy là một người đam mê công nghệ và thích làm việc với khách hàng để giải quyết những thách thức về bảo mật của họ và cải thiện tình trạng bảo mật của họ trên đám mây.

Karn Chahar là Chuyên gia tư vấn bảo mật của nhóm phân phối chung tại AWS. Anh ấy là một người đam mê công nghệ và thích làm việc với khách hàng để giải quyết những thách thức về bảo mật của họ và cải thiện tình trạng bảo mật của họ trên đám mây.

Mike Amjadi là Kỹ sư Dữ liệu & ML của AWS ProServe tập trung vào việc hỗ trợ khách hàng tối đa hóa giá trị từ dữ liệu. Anh ấy chuyên thiết kế, xây dựng và tối ưu hóa đường dẫn dữ liệu theo các nguyên tắc được kiến trúc tốt. Mike đam mê sử dụng công nghệ để giải quyết vấn đề và cam kết mang lại kết quả tốt nhất cho khách hàng.

Mike Amjadi là Kỹ sư Dữ liệu & ML của AWS ProServe tập trung vào việc hỗ trợ khách hàng tối đa hóa giá trị từ dữ liệu. Anh ấy chuyên thiết kế, xây dựng và tối ưu hóa đường dẫn dữ liệu theo các nguyên tắc được kiến trúc tốt. Mike đam mê sử dụng công nghệ để giải quyết vấn đề và cam kết mang lại kết quả tốt nhất cho khách hàng.

Vrushali Sawant là Kỹ sư giao diện người dùng của Proserve. Cô ấy có tay nghề cao trong việc tạo ra các trang web đáp ứng. Cô ấy thích làm việc với khách hàng, hiểu rõ yêu cầu của họ và cung cấp cho họ các giải pháp UI/UX có thể mở rộng, dễ áp dụng.

Vrushali Sawant là Kỹ sư giao diện người dùng của Proserve. Cô ấy có tay nghề cao trong việc tạo ra các trang web đáp ứng. Cô ấy thích làm việc với khách hàng, hiểu rõ yêu cầu của họ và cung cấp cho họ các giải pháp UI/UX có thể mở rộng, dễ áp dụng.

Neelam Patel là Giám đốc giải pháp khách hàng tại AWS, dẫn đầu các sáng kiến quan trọng về AI sáng tạo và hiện đại hóa đám mây. Neelam làm việc với các giám đốc điều hành chủ chốt và chủ sở hữu công nghệ để giải quyết các thách thức trong chuyển đổi đám mây của họ và giúp khách hàng tối đa hóa lợi ích của việc áp dụng đám mây. Cô có bằng MBA của Trường Kinh doanh Warwick, Vương quốc Anh và bằng Cử nhân Kỹ thuật Máy tính, Ấn Độ.

Neelam Patel là Giám đốc giải pháp khách hàng tại AWS, dẫn đầu các sáng kiến quan trọng về AI sáng tạo và hiện đại hóa đám mây. Neelam làm việc với các giám đốc điều hành chủ chốt và chủ sở hữu công nghệ để giải quyết các thách thức trong chuyển đổi đám mây của họ và giúp khách hàng tối đa hóa lợi ích của việc áp dụng đám mây. Cô có bằng MBA của Trường Kinh doanh Warwick, Vương quốc Anh và bằng Cử nhân Kỹ thuật Máy tính, Ấn Độ.

Tiến sĩ Murali Baktha là Kiến trúc sư giải pháp chơi gôn toàn cầu tại AWS, dẫn đầu các sáng kiến quan trọng liên quan đến AI sáng tạo, phân tích dữ liệu và công nghệ đám mây tiên tiến. Murali làm việc với các giám đốc điều hành chủ chốt và chủ sở hữu công nghệ để hiểu những thách thức kinh doanh của khách hàng và thiết kế các giải pháp nhằm giải quyết những thách thức đó. Ông có bằng MBA về Tài chính của UConn và bằng tiến sĩ của Đại học Bang Iowa.

Tiến sĩ Murali Baktha là Kiến trúc sư giải pháp chơi gôn toàn cầu tại AWS, dẫn đầu các sáng kiến quan trọng liên quan đến AI sáng tạo, phân tích dữ liệu và công nghệ đám mây tiên tiến. Murali làm việc với các giám đốc điều hành chủ chốt và chủ sở hữu công nghệ để hiểu những thách thức kinh doanh của khách hàng và thiết kế các giải pháp nhằm giải quyết những thách thức đó. Ông có bằng MBA về Tài chính của UConn và bằng tiến sĩ của Đại học Bang Iowa.

Mehdi Noor là Giám đốc Khoa học Ứng dụng tại Trung tâm Đổi mới Generative Ai. Với niềm đam mê kết nối công nghệ và đổi mới, anh hỗ trợ khách hàng AWS khai thác tiềm năng của Generative AI, biến những thách thức tiềm tàng thành cơ hội để thử nghiệm và đổi mới nhanh chóng bằng cách tập trung vào việc sử dụng có hiệu quả, có thể đo lường và mở rộng được các công nghệ AI tiên tiến, đồng thời hợp lý hóa lộ trình đến sản xuất.

Mehdi Noor là Giám đốc Khoa học Ứng dụng tại Trung tâm Đổi mới Generative Ai. Với niềm đam mê kết nối công nghệ và đổi mới, anh hỗ trợ khách hàng AWS khai thác tiềm năng của Generative AI, biến những thách thức tiềm tàng thành cơ hội để thử nghiệm và đổi mới nhanh chóng bằng cách tập trung vào việc sử dụng có hiệu quả, có thể đo lường và mở rộng được các công nghệ AI tiên tiến, đồng thời hợp lý hóa lộ trình đến sản xuất.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/the-journey-of-pga-tours-generative-ai-virtual-assistant-from-concept-to-development-to-prototype/