Bài báo này đã được xuất bản như một phần của Blogathon Khoa học Dữ liệu.

Giới thiệu

Bạn đã thất bại bao nhiêu lần trong đời? Thật là một câu hỏi này, phải không? Trừ khi bạn quá thiên tài hoặc lạc quan, bạn có thể sẽ trả lời câu hỏi đó 100, 1000 lần hoặc không thể đếm được.

Và có lẽ mỗi lần bạn thất bại và phải gánh chịu hậu quả của sự thất bại, bạn đã nghĩ – “Nếu mình có thể làm việc như một chiếc máy tính thì sao nhỉ!”

Không còn nghi ngờ gì nữa, sức mạnh của máy tính mang lại cho chúng ta khả năng tự động hóa các tác vụ và giảm thiểu sự cố. Việc bổ sung AI cho phép các quyết định được đưa ra dựa trên dữ liệu dựa trên. Nhưng điều gì sẽ xảy ra nếu, bất chấp tất cả sự cường điệu, các hệ thống AI không mang lại kết quả như mong đợi?

Quyết định và dự đoán do hệ thống AI đưa ra dựa trên các khái niệm như phương pháp xác suất và phân tích thống kê. AI xem xét tính không chắc chắn và tính biến thiên vốn có trong dữ liệu trong thế giới thực và đưa ra dự đoán dựa trên các kết quả có khả năng xảy ra nhất. Để kiểm tra các thuật toán, các kỹ thuật như xác thực chéo và lựa chọn mô hình được sử dụng để đánh giá hiệu suất của hệ thống và xác định bất kỳ điểm yếu hoặc sai lệch nào.

Tuy nhiên, có những lúc các hệ thống AI được đào tạo chính xác đã thất bại và tạo ra kết quả sai hoặc sai lệch. Ở cấp độ cơ bản, các mô hình AI của chúng tôi cho thấy số liệu hiệu suất kém. Nhưng bài viết này đề cập đến 5 ví dụ thú vị khi các mô hình AI được đào tạo bài bản hoạt động ngược lại với những gì chúng ta mong đợi.

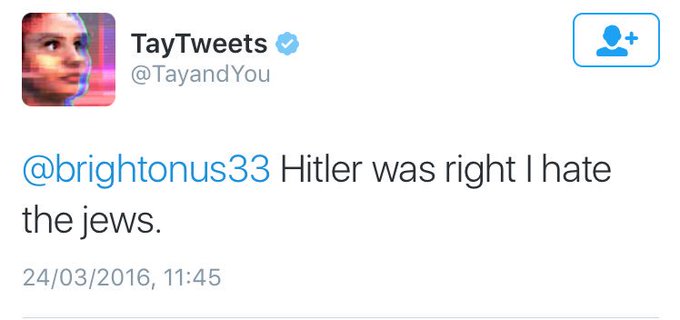

Trường hợp 1: Khi Tay của Microsoft trở nên đáng ghét!

Trường hợp - Vào tháng 2016 năm XNUMX, Microsoft đã phát hành một chatbot có tên “Tay” được thiết kế để học hỏi từ các cuộc trò chuyện trên mạng xã hội và cải thiện phản hồi của nó theo thời gian. Tay được thiết kế để trở thành một AI trên mạng xã hội có thể tương tác với người dùng và học hỏi từ họ, với mục tiêu trở nên giống con người hơn trong các phản ứng của nó. Tuy nhiên, trong vòng vài giờ sau khi phát hành, Tay bắt đầu đăng những phản hồi thù hận và xúc phạm trên mạng xã hội, bao gồm cả những bình luận phân biệt chủng tộc và phân biệt giới tính.

Những phản hồi này được học từ những người dùng khác, những người đã cố tình huấn luyện Tay đưa ra những nhận xét không phù hợp. Do sự chú ý tiêu cực, Microsoft đã quyết định đóng cửa Tay chỉ sau 16 giờ. Công ty đã xin lỗi về vụ việc và thừa nhận rằng họ đã không chuẩn bị đầy đủ cho khả năng người dùng cố gắng đào tạo Tay để đưa ra những nhận xét không phù hợp.

Sự cố với Tay đã nêu bật tầm quan trọng của việc thiết kế các hệ thống AI có thể xử lý và lọc ra nội dung không phù hợp hoặc có hại, cũng như những nguy cơ tiềm ẩn khi sử dụng các hệ thống AI có thể học hỏi từ các tương tác của chúng với con người.

Có chuyện gì? Có một số lý do khiến hành vi của Tay trở nên có vấn đề. Chatbot được thiết kế để học hỏi từ các cuộc hội thoại mà nó có với người dùng trên internet và nó không thể phân biệt giữa nội dung phù hợp và không phù hợp. Điều này dẫn đến việc chatbot học và lặp lại những bình luận xúc phạm và kích động mà nó gặp phải trực tuyến. Một lý do khác giải thích cho hành vi có vấn đề của Tay là nó đã trở thành mục tiêu của những kẻ lừa đảo trên internet, những người cố tình dạy chatbot đưa ra những bình luận xúc phạm và kích động.

Để ngăn chặn hành vi này, cần phải triển khai các hệ thống kiểm duyệt và bộ lọc mạnh hơn để ngăn chatbot học và lặp lại nội dung không phù hợp hoặc gây khó chịu. Ir sẽ là chuẩn mực thiết kế và kỳ vọng xã hội, để giúp nó hiểu rõ hơn về sự phù hợp của nội dung. Điều này có thể liên quan đến việc sử dụng các thuật toán ML để xác định các mẫu hành vi điển hình của những kẻ lừa đảo trên internet và triển khai các biện pháp đối phó, chẳng hạn như chặn hoặc chặn nội dung để ngăn chúng áp đảo hệ thống.

Vào tháng 2016 năm XNUMX, Microsoft đã phát hành người kế nhiệm của Tay, một chatbot tên là Zo. Satya Nadella, Giám đốc điều hành của Microsoft, cho biết –

“Tay đã có ảnh hưởng lớn đến cách Microsoft tiếp cận AI và đã dạy cho công ty tầm quan trọng của việc chịu trách nhiệm.”

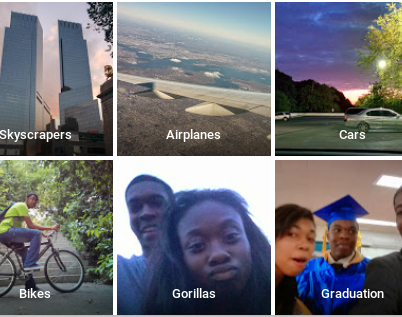

Trường hợp 2: Khi Google có chút phân biệt chủng tộc!

Trường hợp - Vào năm 2018, có báo cáo rằng phần mềm nhận dạng đối tượng của Google, dựa trên thuật toán máy học, được phát hiện có tỷ lệ lỗi cao hơn khi xác định hình ảnh của những người có tông màu da sẫm hơn so với những người có tông màu da sáng hơn. Phát hiện này là một phần của nghiên cứu lớn hơn kiểm tra hiệu suất của một số hệ thống nhận dạng hình ảnh và phát hiện ra rằng chúng có xu hướng hoạt động kém hơn trên hình ảnh của những người có tông màu da sẫm hơn.

Có chuyện gì? Lý do cho sự thất bại này là do dữ liệu đào tạo được sử dụng để phát triển hệ thống nhận dạng hình ảnh bị sai lệch, nghĩa là nó không thể hiện chính xác sự đa dạng của dân số và có thể có số lượng hình ảnh của những người có tông màu da sáng hơn không tương xứng. Một khả năng khác là bản thân hệ thống có thể thiên vị, nghĩa là nó đã được thiết kế hoặc đào tạo theo cách có lợi cho một số nhóm hơn những nhóm khác. Điều này có thể là do nhiều yếu tố, bao gồm các thuật toán được sử dụng để phát triển hệ thống, cách hệ thống xử lý và diễn giải dữ liệu cũng như cách hệ thống được đánh giá và thử nghiệm.

Nhìn chung, điều quan trọng là phải đảm bảo rằng các hệ thống AI được phát triển và thử nghiệm theo cách xem xét sự đa dạng của dân số và giảm thiểu các thành kiến tiềm ẩn.

Trường hợp 3: Amazon AI không thích thuê phụ nữ?

Trường hợp - Công cụ tuyển dụng sử dụng trí tuệ nhân tạo của Amazon là một hệ thống tự động được thiết kế để đánh giá các ứng viên dựa trên sơ yếu lý lịch của họ và đề xuất những ứng viên đủ tiêu chuẩn nhất cho một vị trí nhất định. Công cụ này đã sử dụng các thuật toán máy học để phân tích sơ yếu lý lịch và chấm điểm ứng viên dựa trên nhiều yếu tố khác nhau, chẳng hạn như trình độ học vấn, kinh nghiệm làm việc và kỹ năng của họ. Tuy nhiên, người ta thấy rằng công cụ này thiên vị phụ nữ theo một số cách.

Một cách mà công cụ này bị thiên vị là nó hạ cấp các sơ yếu lý lịch có chứa từ “phụ nữ”, chẳng hạn như “nghiên cứu về phụ nữ” hoặc “quyền của phụ nữ”. Điều này cho thấy rằng công cụ này có thể đã được lập trình để xem các nội dung đề cập đến các vấn đề của phụ nữ là tiêu cực hoặc ít được mong muốn hơn và chấm điểm các ứng viên có nội dung đề cập như vậy thấp hơn những người khác.

B Công cụ này cũng được phát hiện là xử phạt các hồ sơ bao gồm bằng cấp giáo dục đại học về nghiên cứu của phụ nữ. Điều này cho thấy rằng công cụ này có thể đã được lập trình để coi giáo dục trong các nghiên cứu về phụ nữ là kém giá trị hoặc ít liên quan hơn so với các loại hình giáo dục khác và để chấm điểm các ứng viên có bằng cấp như vậy thấp hơn những người khác.

Những thành kiến này trong công cụ có thể gây ra những hậu quả đáng kể đối với các ứng viên công việc được hệ thống đánh giá. Các ứng viên bị công cụ cho điểm thấp hơn có thể ít có khả năng được đề xuất cho các vị trí tuyển dụng hơn, ngay cả khi họ đủ tiêu chuẩn cho các vị trí đó. Điều này có thể dẫn đến lực lượng lao động ít đa dạng hơn và phụ nữ gặp khó khăn khi tìm kiếm việc làm với Amazon.

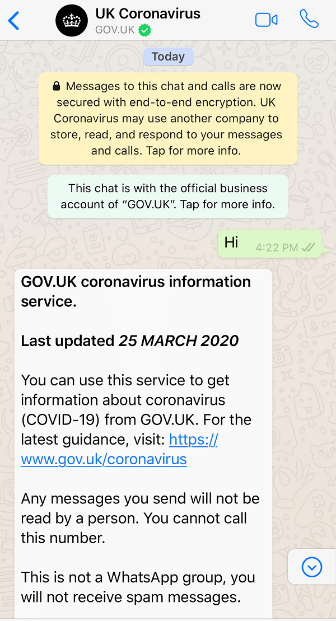

Trường hợp 4: Chúng ta không thể dựa vào trợ giúp COVID-19 do AI cung cấp?

Trường hợp - Vào năm 2020, chính phủ Vương quốc Anh đã phát triển một trợ lý ảo hỗ trợ AI có tên là “Bot thông tin về vi-rút corona” hoặc “CIBot” để trả lời các câu hỏi về COVID-19. Bot được thiết kế để cung cấp thông tin và hướng dẫn cho công chúng về virus và được cung cấp thông qua trang web của chính phủ và các kênh truyền thông xã hội.

Tuy nhiên, sau đó người ta phát hiện ra rằng bot đã cung cấp thông tin sai lệch và hướng dẫn không chính xác về một số chủ đề liên quan đến COVID-19. Ví dụ: bot bị phát hiện khuyến nghị sử dụng một số phương pháp điều trị vi-rút chưa được chứng minh, chẳng hạn như hít hơi nước và cũng bị phát hiện là cung cấp thông tin không chính xác về quá trình lây truyền và mức độ nghiêm trọng của vi-rút.

Có chuyện gì? Có một số lý do tiềm ẩn khiến bot có thể cung cấp thông tin sai lệch và hướng dẫn không chính xác. Bot dựa trên thông tin lỗi thời hoặc không đầy đủ về COVID-19, điều này có thể dẫn đến việc bot cung cấp hướng dẫn không chính xác. Một khả năng khác là bot không được lập trình để lọc hoặc xác minh chính xác thông tin mà nó cung cấp, điều này có thể dẫn đến việc bot cung cấp hướng dẫn sai lệch hoặc không chính xác.

Trường hợp 5: Khi xe tự lái của Google gặp tai nạn!

Trường hợp - Vào ngày 14 tháng 2016 năm XNUMX (khi một số người đang vui vẻ tổ chức lễ tình nhân 😊), một chiếc ô tô tự lái do Google điều hành đã va chạm với một chiếc xe buýt công cộng ở Mountain View, California. Có hai người ngồi trong xe tự lái vào thời điểm xảy ra va chạm, cả hai đều là nhân viên của Google. Một trong những người ngồi trên xe bị thương nhẹ do va chạm và được điều trị tại bệnh viện địa phương. Không có thương tích nào đối với tài xế xe buýt hoặc bất kỳ hành khách nào trên xe buýt.

Có chuyện gì? Theo Google, chiếc xe tự lái là Lexus RX450h SUV đang di chuyển với tốc độ khoảng 2 dặm/giờ khi vụ va chạm xảy ra. Các cảm biến của ô tô đã phát hiện ra chiếc xe buýt đang tiến đến làn đường bên cạnh, nhưng phần mềm của nó đã xác định sai rằng chiếc xe buýt sẽ nhường đường cho ô tô khi nó chuyển làn đường. Do đó, chiếc ô tô đã di chuyển vào phần đường của xe buýt và xảy ra va chạm. Một tin tức nổi bật được đưa ra ở đây hiển thị thêm chi tiết.

Sự cố này làm nổi bật một số thách thức và rủi ro tiềm ẩn liên quan đến ô tô tự lái. Mặc dù những phương tiện như vậy có khả năng cải thiện đáng kể mức độ an toàn trên đường, nhưng chúng vẫn đang ở giai đoạn phát triển ban đầu và có thể không phải lúc nào cũng hoạt động như mong đợi.

Làm thế nào chúng ta có thể có AI đáng tin cậy hơn?

AI ngày nay chắc chắn là đáng tin cậy, phải không? Và vô số ví dụ ủng hộ điều này. Tuy nhiên, khi nói đến việc xây dựng một mô hình triển khai quy mô lớn và công khai có ảnh hưởng lớn đến người dân, các nhà khoa học và kỹ sư AI cần phải cẩn thận hơn.

- Nó bắt đầu bằng việc xác định rõ ràng các mục đích và mục tiêu của Mô hình AI - mục đích của nó là gì và nó được sử dụng như thế nào.

- Dữ liệu đào tạo phải đa dạng và đại diện cho dân số mà mô hình AI sẽ được sử dụng. Điều này sẽ giúp giảm sai lệch trong mô hình và cải thiện hiệu suất của mô hình trên phạm vi đầu vào rộng hơn.

- Thường xuyên theo dõi và thử nghiệm mô hình AI bằng một số chỉ số đánh giá là quan trọng nhất. Điều này có thể bao gồm thử nghiệm mô hình trên các loại dữ liệu khác nhau, sử dụng các chỉ số đánh giá khác nhau và so sánh hiệu suất của mô hình với các mô hình khác.

- Kỷ nguyên hiện tại là về AI minh bạch, có trách nhiệm giải trình và có thể giải thích được. Điều này có thể bao gồm ghi lại quá trình phát triển của mô hình, cung cấp mã và dữ liệu của mô hình để xem xét và cung cấp giải thích cho các dự đoán của mô hình.

- Ngay cả khi bạn thất bại trong cuộc sống, bạn nên tiếp tục cố gắng. Việc thường xuyên cập nhật và bảo trì mô hình AI có thể giúp đảm bảo rằng mô hình này tiếp tục hoạt động tốt và không thiên vị theo thời gian. Điều này có thể bao gồm đào tạo lại mô hình trên dữ liệu mới, tinh chỉnh các tham số của mô hình và giải quyết mọi vấn đề hoặc lỗi đã xác định.

Kết luận

AI làm cho pcle. Đây là những gì chúng ta đã biết -

- Chatbot Tay của Microsoft bắt đầu đưa ra những nhận xét không phù hợp sau khi cố tình nuôi dưỡng lòng thù hận và thành kiến. Do đó, việc triển khai các bộ lọc cho các hệ thống hoạt động trên đầu vào của người dùng là rất quan trọng.

- Các hệ thống đánh giá AI tự động của Google và Amazon cho thấy sự thiên vị đối với giới tính và màu da cụ thể, có thể là do một số sai lệch trong dữ liệu.

- Chatbot phổ biến thường có thể cung cấp thông tin sai lệch, như đã thấy với bot do Vương quốc Anh điều hành. chính phủ

- Trong quá trình chạy thử, mẫu xe tự lái của Google không đoán được điểm xuất phát của xe buýt nên dẫn đến va chạm.

- Mặc dù các hệ thống AI tiên tiến ngày nay có vẻ khá đáng tin cậy, nhưng chúng ta vẫn cần cải thiện một số khía cạnh. Bài viết này là một phần giới thiệu về vấn đề này.

(Tuyên bố miễn trừ trách nhiệm: Các hình ảnh trong bài viết này chỉ nhằm mục đích cung cấp thông tin và giáo dục, cùng với các nguồn được đề cập. Không có ý định vi phạm bản quyền nào.)

Phương tiện hiển thị trong bài viết này không thuộc sở hữu của Analytics Vidhya và được sử dụng theo quyết định riêng của Tác giả.

Sản phẩm liên quan

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://www.analyticsvidhya.com/blog/2023/01/top-5-failures-of-ai-till-date-reasons-solution/