Kỹ thuật dữ liệu đóng một vai trò then chốt trong hệ sinh thái dữ liệu rộng lớn bằng cách thu thập, chuyển đổi và cung cấp dữ liệu cần thiết cho phân tích, báo cáo và học máy. Các kỹ sư dữ liệu đầy tham vọng thường tìm kiếm các dự án thực tế để tích lũy kinh nghiệm thực tế và thể hiện kiến thức chuyên môn của họ. Bài viết này trình bày 20 ý tưởng dự án kỹ thuật dữ liệu hàng đầu cùng với mã nguồn của chúng. Cho dù bạn là người mới bắt đầu, kỹ sư cấp trung cấp hay người hành nghề nâng cao, những dự án này mang đến cơ hội tuyệt vời để nâng cao kỹ năng kỹ thuật dữ liệu của bạn.

Mục lục

Dự án kỹ thuật dữ liệu cho người mới bắt đầu

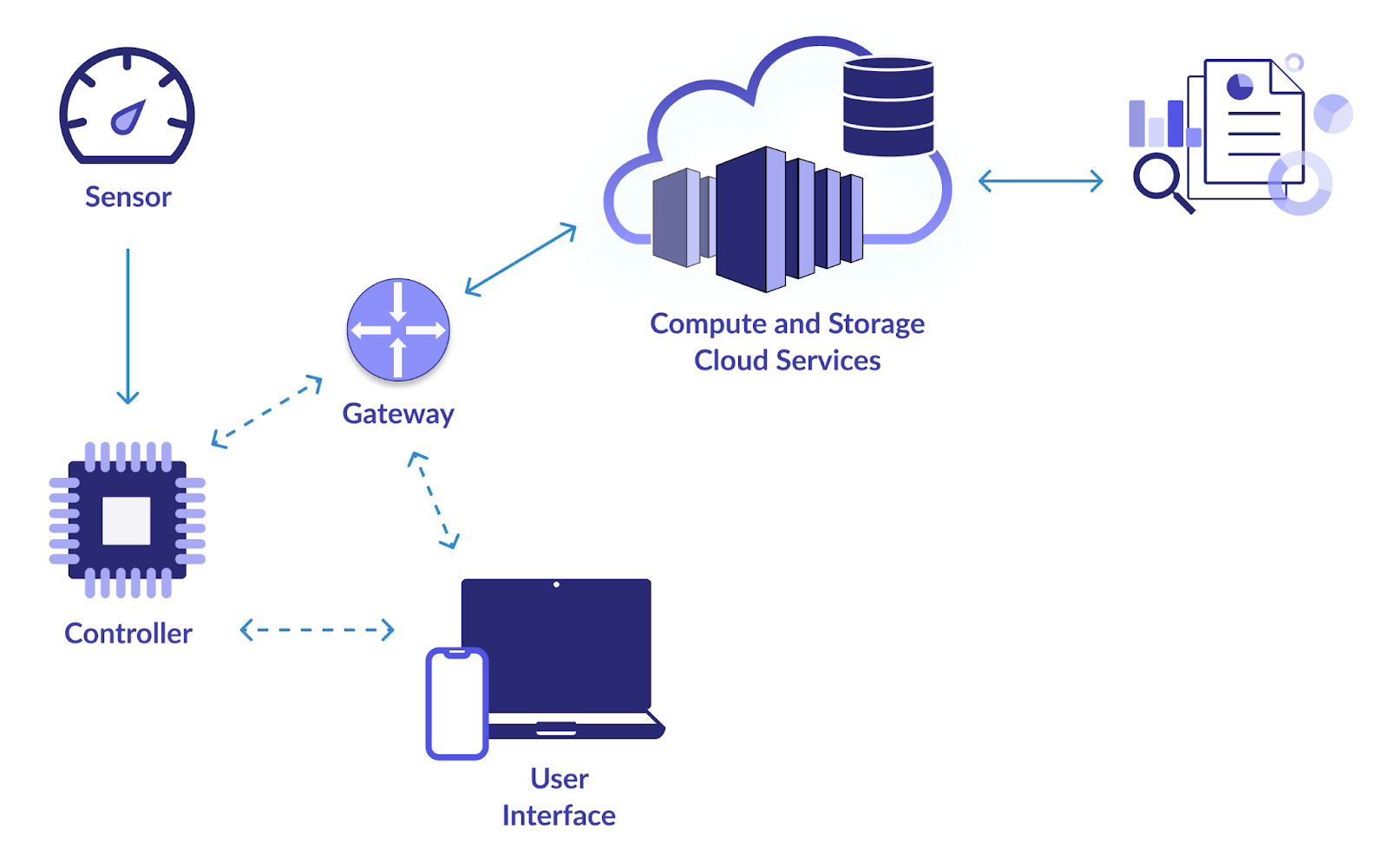

1. Cơ sở hạ tầng IoT thông minh

Mục tiêu

Mục tiêu chính của dự án này là thiết lập một đường dẫn dữ liệu đáng tin cậy để thu thập và phân tích dữ liệu từ các thiết bị IoT (Internet of Things). Webcam, cảm biến nhiệt độ, máy dò chuyển động và các thiết bị IoT khác đều tạo ra rất nhiều dữ liệu. Bạn muốn thiết kế một hệ thống để tiêu thụ, lưu trữ, xử lý và phân tích dữ liệu này một cách hiệu quả. Bằng cách này, việc giám sát và ra quyết định theo thời gian thực dựa trên những bài học từ dữ liệu IoT sẽ trở nên khả thi.

Giải quyết thế nào?

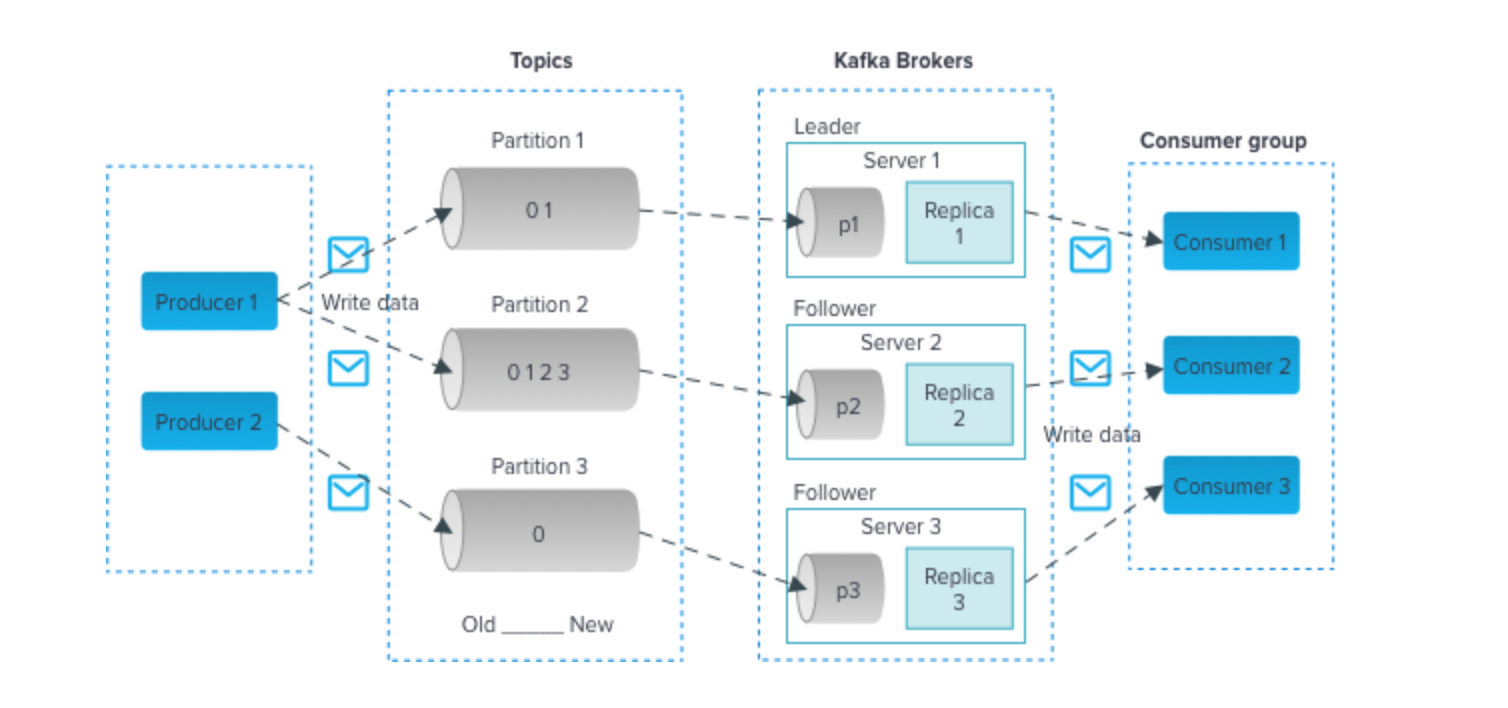

- Sử dụng các công nghệ như Apache Kafka hoặc MQTT để nhập dữ liệu hiệu quả từ các thiết bị IoT. Những công nghệ này hỗ trợ các luồng dữ liệu thông lượng cao.

- Sử dụng cơ sở dữ liệu có thể mở rộng như Apache Cassandra hoặc MongoDB để lưu trữ dữ liệu IoT đến. Các cơ sở dữ liệu NoSQL này có thể xử lý khối lượng và sự đa dạng của dữ liệu IoT.

- Triển khai xử lý dữ liệu theo thời gian thực bằng Apache Spark Streaming hoặc Apache Flink. Các khung này cho phép bạn phân tích và chuyển đổi dữ liệu khi có, làm cho dữ liệu phù hợp để theo dõi theo thời gian thực.

- Sử dụng các công cụ trực quan hóa như Grafana hoặc Kibana để tạo trang tổng quan cung cấp thông tin chuyên sâu về dữ liệu IoT. Trực quan hóa theo thời gian thực có thể giúp các bên liên quan đưa ra quyết định sáng suốt.

Bấm vào đây để kiểm tra mã nguồn

2. Phân tích dữ liệu hàng không

Mục tiêu

Để thu thập, xử lý và phân tích dữ liệu hàng không từ nhiều nguồn, bao gồm Cục Hàng không Liên bang (FAA), các hãng hàng không và sân bay, dự án này cố gắng phát triển một đường dẫn dữ liệu. Dữ liệu hàng không bao gồm các chuyến bay, sân bay, thời tiết và nhân khẩu học của hành khách. Mục tiêu của bạn là trích xuất những hiểu biết sâu sắc có ý nghĩa từ dữ liệu này để cải thiện lịch bay, tăng cường các biện pháp an toàn và tối ưu hóa các khía cạnh khác nhau của ngành hàng không.

Giải quyết thế nào?

- Apache Nifi hoặc AWS Kinesis có thể được sử dụng để nhập dữ liệu từ nhiều nguồn khác nhau.

- Lưu trữ dữ liệu đã xử lý trong kho dữ liệu như Amazon Redshift hoặc Google BigQuery để truy vấn và phân tích hiệu quả.

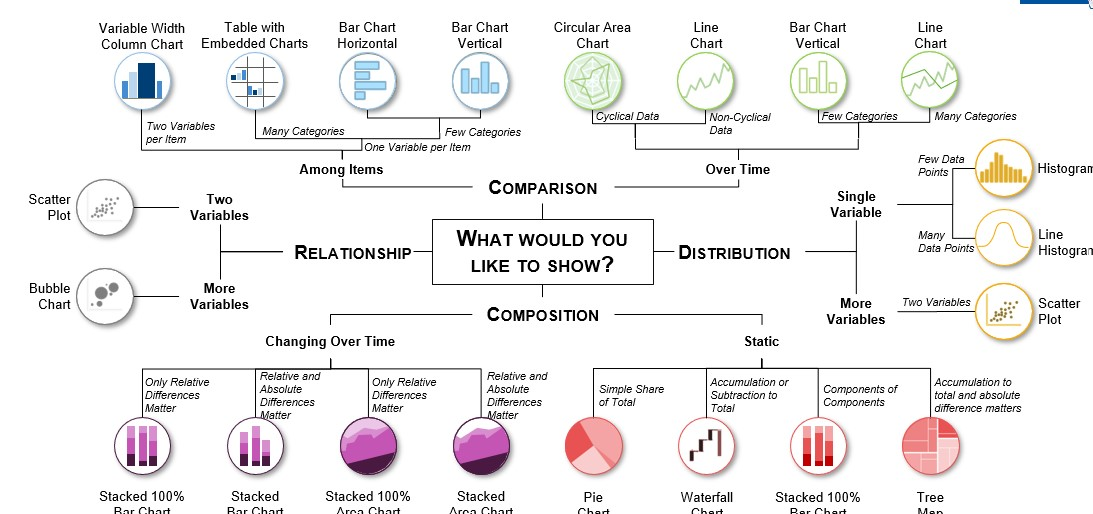

- Sử dụng Python với các thư viện như Pandas và Matplotlib để phân tích dữ liệu hàng không chuyên sâu. Điều này có thể liên quan đến việc xác định các nguyên nhân gây chậm trễ chuyến bay, tối ưu hóa các tuyến đường và đánh giá xu hướng hành khách.

- Các công cụ như Tableau hoặc Power BI có thể được sử dụng để tạo trực quan hóa thông tin giúp các bên liên quan đưa ra quyết định dựa trên dữ liệu trong lĩnh vực hàng không.

3. Dự báo nhu cầu vận chuyển và phân phối

Mục tiêu

Trong dự án này, mục tiêu của bạn là tạo ra một quy trình ETL (Trích xuất, Chuyển đổi, Tải) mạnh mẽ để xử lý dữ liệu vận chuyển và phân phối. Bằng cách sử dụng dữ liệu lịch sử, bạn sẽ xây dựng hệ thống dự báo nhu cầu dự đoán nhu cầu sản phẩm trong tương lai trong bối cảnh vận chuyển và phân phối. Điều này rất quan trọng để tối ưu hóa quản lý hàng tồn kho, giảm chi phí vận hành và đảm bảo giao hàng kịp thời.

Giải quyết thế nào?

- Apache NiFi hoặc Talend có thể được sử dụng để xây dựng đường dẫn ETL, đường dẫn này sẽ trích xuất dữ liệu từ nhiều nguồn khác nhau, chuyển đổi và tải nó vào một giải pháp lưu trữ dữ liệu phù hợp.

- Sử dụng các công cụ như Python hoặc Apache Spark cho các tác vụ chuyển đổi dữ liệu. Bạn có thể cần phải làm sạch, tổng hợp và xử lý trước dữ liệu để phù hợp với các mô hình dự báo.

- Triển khai các mô hình dự báo như ARIMA (Trung bình di chuyển tích hợp tự động hồi quy) hoặc Tiên tri để dự đoán chính xác nhu cầu.

- Lưu trữ dữ liệu đã được làm sạch và chuyển đổi trong cơ sở dữ liệu như PostgreSQL hoặc MySQL.

Bấm vào đây để xem mã nguồn của dự án kỹ thuật dữ liệu này,

4. Phân tích dữ liệu sự kiện

Mục tiêu

Tạo một đường dẫn dữ liệu thu thập thông tin từ nhiều sự kiện khác nhau, bao gồm hội nghị, sự kiện thể thao, buổi hòa nhạc và các cuộc tụ họp xã hội. Xử lý dữ liệu theo thời gian thực, phân tích cảm xúc của các bài đăng trên mạng xã hội về những sự kiện này và tạo ra các hình ảnh trực quan để hiển thị xu hướng và hiểu biết sâu sắc trong thời gian thực đều là một phần của dự án.

Giải quyết thế nào?

- Tùy thuộc vào nguồn dữ liệu sự kiện, bạn có thể sử dụng API Twitter để thu thập các dòng tweet, thu thập dữ liệu web cho các trang web liên quan đến sự kiện hoặc các phương pháp nhập dữ liệu khác.

- Sử dụng kỹ thuật Xử lý ngôn ngữ tự nhiên (NLP) trong Python để thực hiện phân tích tình cảm trên các bài đăng trên mạng xã hội. Các công cụ như NLTK hoặc spaCy có thể có giá trị.

- Sử dụng các công nghệ phát trực tuyến như Apache Kafka hoặc Apache Flink để xử lý và phân tích dữ liệu theo thời gian thực.

- Tạo bảng thông tin tương tác và trực quan hóa bằng cách sử dụng các khung như Dash hoặc Plotly để trình bày thông tin chi tiết liên quan đến sự kiện ở định dạng thân thiện với người dùng.

Nhấn vào đây để kiểm tra mã nguồn.

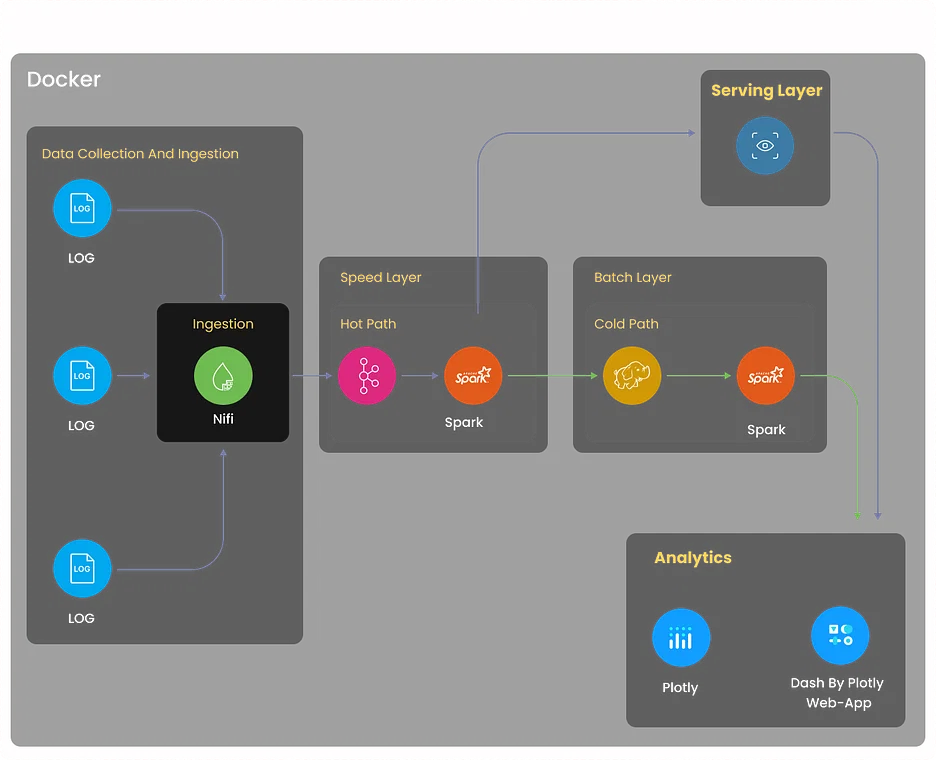

5. Dự án phân tích nhật ký

Mục tiêu

Xây dựng hệ thống phân tích nhật ký toàn diện để thu thập nhật ký từ nhiều nguồn khác nhau, bao gồm máy chủ, ứng dụng và thiết bị mạng. Hệ thống nên tập trung dữ liệu nhật ký, phát hiện các điểm bất thường, hỗ trợ khắc phục sự cố và tối ưu hóa hiệu suất hệ thống thông qua thông tin chi tiết dựa trên nhật ký.

Giải quyết thế nào?

- Triển khai việc thu thập nhật ký bằng các công cụ như Logstash hoặc Fluentd. Những công cụ này có thể tổng hợp nhật ký từ nhiều nguồn khác nhau và chuẩn hóa chúng để xử lý tiếp.

- Sử dụng Elaticsearch, một công cụ phân tích và tìm kiếm phân tán mạnh mẽ để lưu trữ và lập chỉ mục dữ liệu nhật ký một cách hiệu quả.

- Sử dụng Kibana để tạo bảng thông tin và hình ảnh trực quan cho phép người dùng giám sát dữ liệu nhật ký trong thời gian thực.

- Thiết lập cơ chế cảnh báo bằng cách sử dụng Elasticsearch Watcher hoặc Grafana Alerts để thông báo cho các bên liên quan khi phát hiện thấy các mẫu nhật ký cụ thể hoặc các điểm bất thường.

Nhấn vào đây để khám phá dự án kỹ thuật dữ liệu này

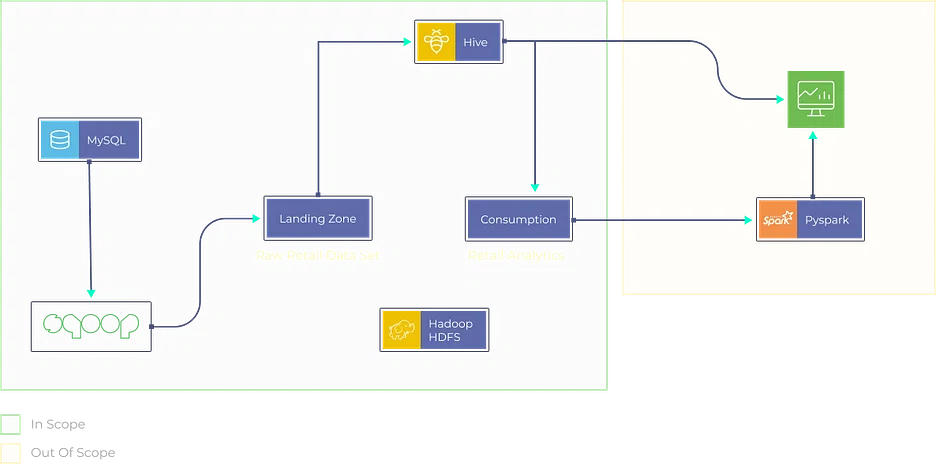

6. Phân tích dữ liệu của Movielens để đưa ra khuyến nghị

Mục tiêu

- Thiết kế và phát triển công cụ đề xuất bằng cách sử dụng bộ dữ liệu Movielens.

- Tạo quy trình ETL mạnh mẽ để xử lý trước và làm sạch dữ liệu.

- Triển khai các thuật toán lọc cộng tác để cung cấp đề xuất phim được cá nhân hóa cho người dùng.

Giải quyết thế nào?

- Tận dụng Apache Spark hoặc AWS Glue để xây dựng quy trình ETL trích xuất dữ liệu người dùng và phim, chuyển đổi dữ liệu đó thành định dạng phù hợp và tải dữ liệu đó vào giải pháp lưu trữ dữ liệu.

- Triển khai các kỹ thuật lọc cộng tác, chẳng hạn như lọc cộng tác dựa trên người dùng hoặc dựa trên mục, sử dụng các thư viện như Scikit-learn hoặc TensorFlow.

- Lưu trữ dữ liệu đã được làm sạch và chuyển đổi trong các giải pháp lưu trữ dữ liệu như Amazon S3 hoặc Hadoop HDFS.

- Phát triển ứng dụng dựa trên web (ví dụ: sử dụng Flask hoặc Django) nơi người dùng có thể nhập tùy chọn của họ và công cụ đề xuất cung cấp các đề xuất phim được cá nhân hóa.

Nhấn vào đây để khám phá dự án kỹ thuật dữ liệu này.

7. Dự án phân tích bán lẻ

Mục tiêu

Tạo nền tảng phân tích bán lẻ thu thập dữ liệu từ nhiều nguồn khác nhau, bao gồm hệ thống điểm bán hàng, cơ sở dữ liệu hàng tồn kho và tương tác của khách hàng. Phân tích xu hướng bán hàng, tối ưu hóa quản lý hàng tồn kho và tạo đề xuất sản phẩm được cá nhân hóa cho khách hàng.

Giải quyết thế nào?

- Triển khai các quy trình ETL bằng các công cụ như Apache Beam hoặc AWS Data Pipeline để trích xuất, chuyển đổi và tải dữ liệu từ các nguồn bán lẻ.

- Sử dụng các thuật toán học máy như XGBoost hoặc Random Forest để dự đoán doanh số bán hàng và tối ưu hóa hàng tồn kho.

- Lưu trữ và quản lý dữ liệu trong các giải pháp lưu trữ dữ liệu như Snowflake hoặc Azure Synapse Analytics để truy vấn hiệu quả.

- Tạo bảng thông tin tương tác bằng các công cụ như Tableau hoặc Looker để trình bày thông tin chi tiết về phân tích bán lẻ ở định dạng trực quan hấp dẫn và dễ hiểu.

Nhấn vào đây để khám phá mã nguồn.

Dự án kỹ thuật dữ liệu trên GitHub

8. Phân tích dữ liệu thời gian thực

Mục tiêu

Đóng góp cho một dự án nguồn mở tập trung vào phân tích dữ liệu thời gian thực. Dự án này mang đến cơ hội cải thiện tốc độ xử lý dữ liệu, khả năng mở rộng và khả năng hiển thị theo thời gian thực của dự án. Bạn có thể được giao nhiệm vụ nâng cao hiệu suất của các thành phần truyền dữ liệu, tối ưu hóa việc sử dụng tài nguyên hoặc thêm các tính năng mới để hỗ trợ các trường hợp sử dụng phân tích thời gian thực.

Giải quyết thế nào?

Phương pháp giải quyết sẽ tùy thuộc vào dự án mà bạn đóng góp nhưng thường liên quan đến các công nghệ như Apache Flink, Spark Streaming hoặc Apache Storm.

Nhấp vào đây để khám phá mã nguồn cho dự án kỹ thuật dữ liệu này.

9. Phân tích dữ liệu thời gian thực với Dịch vụ Azure Stream

Mục tiêu

Khám phá Azure Stream Analytics bằng cách đóng góp hoặc tạo dự án xử lý dữ liệu theo thời gian thực trên Azure. Điều này có thể liên quan đến việc tích hợp các dịch vụ Azure như Azure Functions và Power BI để hiểu rõ hơn và trực quan hóa dữ liệu theo thời gian thực. Bạn có thể tập trung vào việc nâng cao khả năng phân tích thời gian thực và làm cho dự án thân thiện hơn với người dùng.

Giải quyết thế nào?

- Phác thảo rõ ràng các mục tiêu và yêu cầu của dự án, bao gồm các nguồn dữ liệu và thông tin chi tiết mong muốn.

- Tạo môi trường Azure Stream Analytics, đặt cấu hình đầu vào/đầu ra và tích hợp Chức năng Azure và Power BI.

- Nhập dữ liệu thời gian thực, áp dụng các phép biến đổi cần thiết bằng các truy vấn giống SQL.

- Triển khai logic tùy chỉnh để xử lý dữ liệu theo thời gian thực bằng cách sử dụng Hàm Azure.

- Thiết lập Power BI để trực quan hóa dữ liệu theo thời gian thực và đảm bảo trải nghiệm thân thiện với người dùng.

Nhấp vào đây để khám phá mã nguồn cho dự án kỹ thuật dữ liệu này.

10. Đường dẫn dữ liệu thị trường tài chính theo thời gian thực với API Finnhub và Kafka

Mục tiêu

Xây dựng đường dẫn dữ liệu thu thập và xử lý dữ liệu thị trường tài chính theo thời gian thực bằng API Finnhub và Apache Kafka. Dự án này bao gồm việc phân tích giá cổ phiếu, thực hiện phân tích tâm lý trên dữ liệu tin tức và hình dung xu hướng thị trường theo thời gian thực. Đóng góp có thể bao gồm tối ưu hóa việc nhập dữ liệu, tăng cường phân tích dữ liệu hoặc cải thiện các thành phần trực quan hóa.

Giải quyết thế nào?

- Phác thảo rõ ràng các mục tiêu của dự án, bao gồm thu thập và xử lý dữ liệu thị trường tài chính theo thời gian thực cũng như thực hiện phân tích cổ phiếu và phân tích tâm lý.

- Tạo đường dẫn dữ liệu bằng Apache Kafka và API Finnhub để thu thập và xử lý dữ liệu thị trường theo thời gian thực.

- Phân tích giá cổ phiếu và thực hiện phân tích cảm tính về dữ liệu tin tức trong quy trình.

- Trực quan hóa xu hướng thị trường theo thời gian thực và xem xét tối ưu hóa việc nhập và phân tích dữ liệu.

- Khám phá các cơ hội để tối ưu hóa việc xử lý dữ liệu, cải thiện khả năng phân tích và nâng cao các thành phần trực quan hóa trong suốt dự án.

Bấm vào đây để khám phá mã nguồn của dự án này.

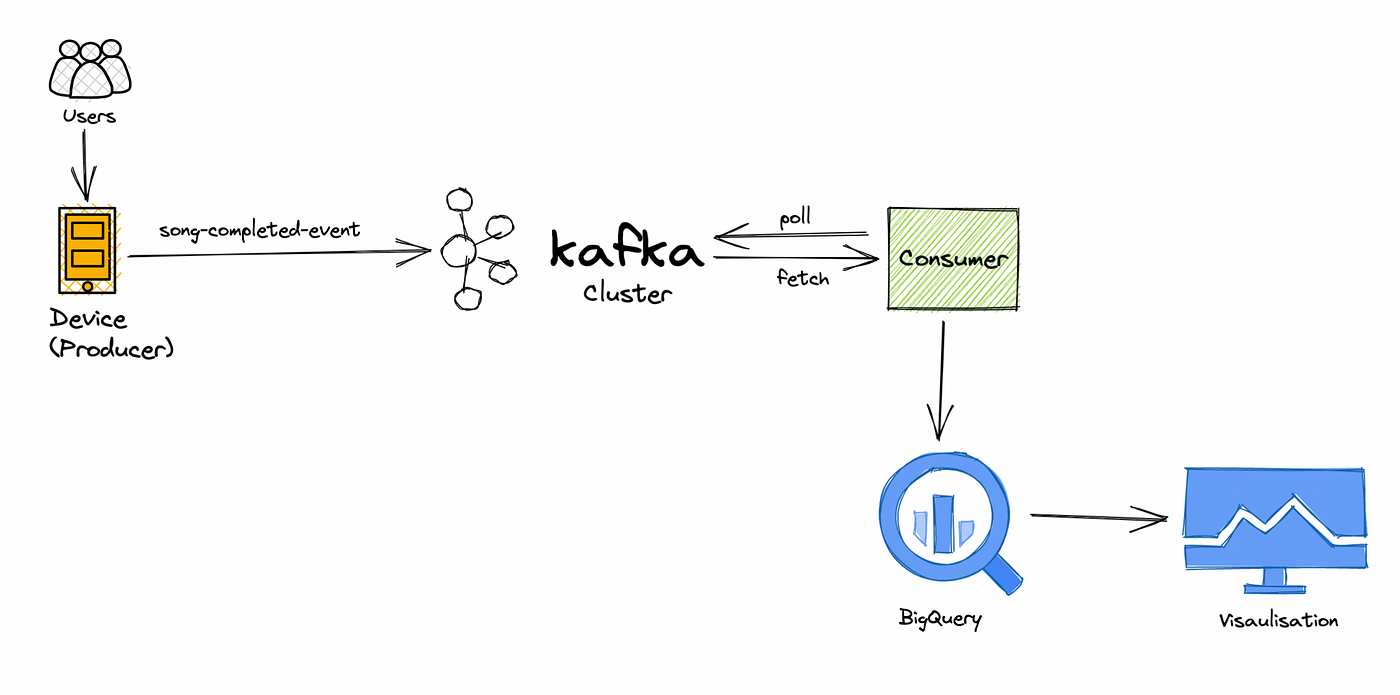

11. Đường ống xử lý dữ liệu ứng dụng âm nhạc theo thời gian thực

Mục tiêu

Cộng tác trong dự án dữ liệu phát nhạc trực tuyến theo thời gian thực tập trung vào việc xử lý và phân tích dữ liệu hành vi của người dùng trong thời gian thực. Bạn sẽ khám phá sở thích của người dùng, theo dõi mức độ phổ biến và nâng cao hệ thống đề xuất âm nhạc. Đóng góp có thể bao gồm cải thiện hiệu quả xử lý dữ liệu, triển khai các thuật toán đề xuất nâng cao hoặc phát triển bảng điều khiển thời gian thực.

Giải quyết thế nào?

- Xác định rõ ràng mục tiêu dự án, tập trung vào phân tích hành vi người dùng theo thời gian thực và nâng cao đề xuất âm nhạc.

- Cộng tác xử lý dữ liệu theo thời gian thực để khám phá sở thích của người dùng, theo dõi mức độ phổ biến và tinh chỉnh hệ thống đề xuất.

- Xác định và thực hiện các cải tiến hiệu quả trong quy trình xử lý dữ liệu.

- Phát triển và tích hợp các thuật toán đề xuất nâng cao để nâng cao hệ thống.

- Tạo bảng thông tin thời gian thực để theo dõi và trực quan hóa dữ liệu hành vi của người dùng, đồng thời xem xét các cải tiến liên tục.

Nhấn vào đây để khám phá mã nguồn.

Các dự án kỹ thuật dữ liệu nâng cao để tiếp tục

12. Giám sát trang web

Mục tiêu

Phát triển hệ thống giám sát trang web toàn diện để theo dõi hiệu suất, thời gian hoạt động và trải nghiệm người dùng. Dự án này liên quan đến việc sử dụng các công cụ như Selenium để quét web nhằm thu thập dữ liệu từ các trang web và tạo cơ chế cảnh báo cho thông báo theo thời gian thực khi phát hiện thấy vấn đề về hiệu suất.

Giải quyết thế nào?

- Xác định mục tiêu của dự án, bao gồm xây dựng hệ thống giám sát trang web để theo dõi hiệu suất và thời gian hoạt động, cũng như nâng cao trải nghiệm người dùng.

- Sử dụng Selenium để quét web nhằm thu thập dữ liệu từ các trang web mục tiêu.

- Triển khai các cơ chế cảnh báo theo thời gian thực để thông báo khi phát hiện vấn đề về hiệu suất hoặc thời gian ngừng hoạt động.

- Tạo một hệ thống toàn diện để theo dõi hiệu suất, thời gian hoạt động và trải nghiệm người dùng của trang web.

- Lập kế hoạch bảo trì liên tục và tối ưu hóa hệ thống giám sát để đảm bảo tính hiệu quả của nó theo thời gian.

Nhấp vào đây để khám phá mã nguồn của dự án kỹ thuật dữ liệu này.

13. Khai thác Bitcoin

Mục tiêu

Đi sâu vào thế giới tiền điện tử bằng cách tạo đường dẫn dữ liệu khai thác Bitcoin. Phân tích các mẫu giao dịch, khám phá mạng blockchain và hiểu rõ hơn về hệ sinh thái Bitcoin. Dự án này sẽ yêu cầu thu thập dữ liệu từ API blockchain, phân tích và trực quan hóa.

Giải quyết thế nào?

- Xác định mục tiêu của dự án, tập trung vào việc tạo đường dẫn dữ liệu khai thác Bitcoin để phân tích giao dịch và khám phá chuỗi khối.

- Triển khai cơ chế thu thập dữ liệu từ API blockchain cho dữ liệu liên quan đến khai thác.

- Đi sâu vào phân tích chuỗi khối để khám phá các mô hình giao dịch và hiểu rõ hơn về hệ sinh thái Bitcoin.

- Phát triển các thành phần trực quan hóa dữ liệu để thể hiện hiểu biết sâu sắc về mạng Bitcoin một cách hiệu quả.

- Tạo một đường truyền dữ liệu toàn diện bao gồm thu thập, phân tích và trực quan hóa dữ liệu để có cái nhìn toàn diện về các hoạt động khai thác Bitcoin.

Nhấp vào đây để khám phá mã nguồn cho dự án kỹ thuật dữ liệu này.

14. Dự án GCP khám phá các chức năng của đám mây

Mục tiêu

Khám phá Google Cloud Platform (GCP) bằng cách thiết kế và triển khai dự án kỹ thuật dữ liệu tận dụng các dịch vụ GCP như Cloud Functions, BigQuery và Dataflow. Dự án này có thể bao gồm các nhiệm vụ xử lý, chuyển đổi và trực quan hóa dữ liệu, tập trung vào việc tối ưu hóa việc sử dụng tài nguyên và cải thiện quy trình công việc kỹ thuật dữ liệu.

Giải quyết thế nào?

- Xác định rõ ràng phạm vi của dự án, nhấn mạnh việc sử dụng các dịch vụ GCP cho kỹ thuật dữ liệu, bao gồm Chức năng đám mây, BigQuery và Dataflow.

- Thiết kế và triển khai tích hợp các dịch vụ GCP, đảm bảo sử dụng hiệu quả Chức năng đám mây, BigQuery và Dataflow.

- Thực hiện các nhiệm vụ xử lý và chuyển đổi dữ liệu như một phần của dự án, phù hợp với các mục tiêu tổng thể.

- Tập trung vào việc tối ưu hóa việc sử dụng tài nguyên trong môi trường GCP để nâng cao hiệu quả.

- Tìm kiếm cơ hội cải thiện quy trình công việc kỹ thuật dữ liệu trong suốt vòng đời của dự án, hướng tới các quy trình hợp lý và hiệu quả.

Bấm vào đây để khám phá mã nguồn của dự án này.

15. Trực quan hóa dữ liệu Reddit

Mục tiêu

Thu thập và phân tích dữ liệu từ Reddit, một trong những nền tảng truyền thông xã hội phổ biến nhất. Tạo trực quan hóa tương tác và hiểu rõ hơn về hành vi của người dùng, chủ đề xu hướng và phân tích cảm tính trên nền tảng. Dự án này sẽ yêu cầu quét web, phân tích dữ liệu và kỹ thuật trực quan hóa dữ liệu sáng tạo.

Giải quyết thế nào?

- Xác định mục tiêu của dự án, nhấn mạnh việc thu thập và phân tích dữ liệu từ Reddit để hiểu rõ hơn về hành vi của người dùng, chủ đề xu hướng và phân tích cảm xúc.

- Triển khai các kỹ thuật quét web để thu thập dữ liệu từ nền tảng của Reddit.

- Đi sâu vào phân tích dữ liệu để khám phá hành vi của người dùng, xác định các chủ đề xu hướng và thực hiện phân tích cảm tính.

- Tạo trực quan hóa tương tác để truyền đạt hiệu quả những hiểu biết sâu sắc được rút ra từ dữ liệu Reddit.

- Sử dụng các kỹ thuật trực quan hóa dữ liệu sáng tạo để nâng cao việc trình bày các phát hiện trong suốt dự án.

Bấm vào đây để khám phá mã nguồn của dự án này.

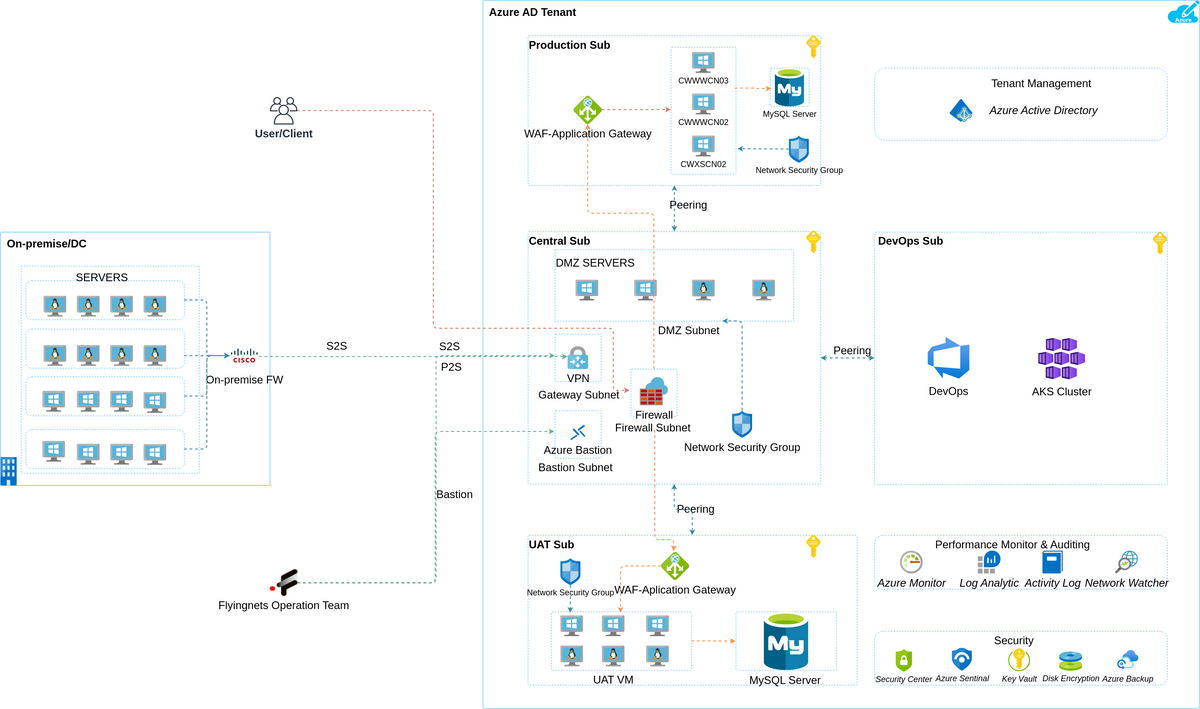

Dự án kỹ thuật dữ liệu Azure

16. Phân tích dữ liệu Yelp

Mục tiêu

Trong dự án này, mục tiêu của bạn là phân tích toàn diện dữ liệu Yelp. Bạn sẽ xây dựng một đường dẫn dữ liệu để trích xuất, chuyển đổi và tải dữ liệu Yelp vào một giải pháp lưu trữ phù hợp. Việc phân tích có thể bao gồm:

- Xác định các doanh nghiệp phổ biến.

- Phân tích cảm tính đánh giá của người dùng.

- Cung cấp thông tin chi tiết cho các doanh nghiệp địa phương để cải thiện dịch vụ của họ.

Giải quyết thế nào?

- Sử dụng kỹ thuật quét web hoặc API Yelp để trích xuất dữ liệu.

- Làm sạch và xử lý trước dữ liệu bằng Python hoặc Azure Data Factory.

- Lưu trữ dữ liệu trong Bộ lưu trữ Azure Blob hoặc Kho dữ liệu Azure SQL.

- Thực hiện phân tích dữ liệu bằng các thư viện Python như Pandas và Matplotlib.

Bấm vào đây để khám phá mã nguồn của dự án này.

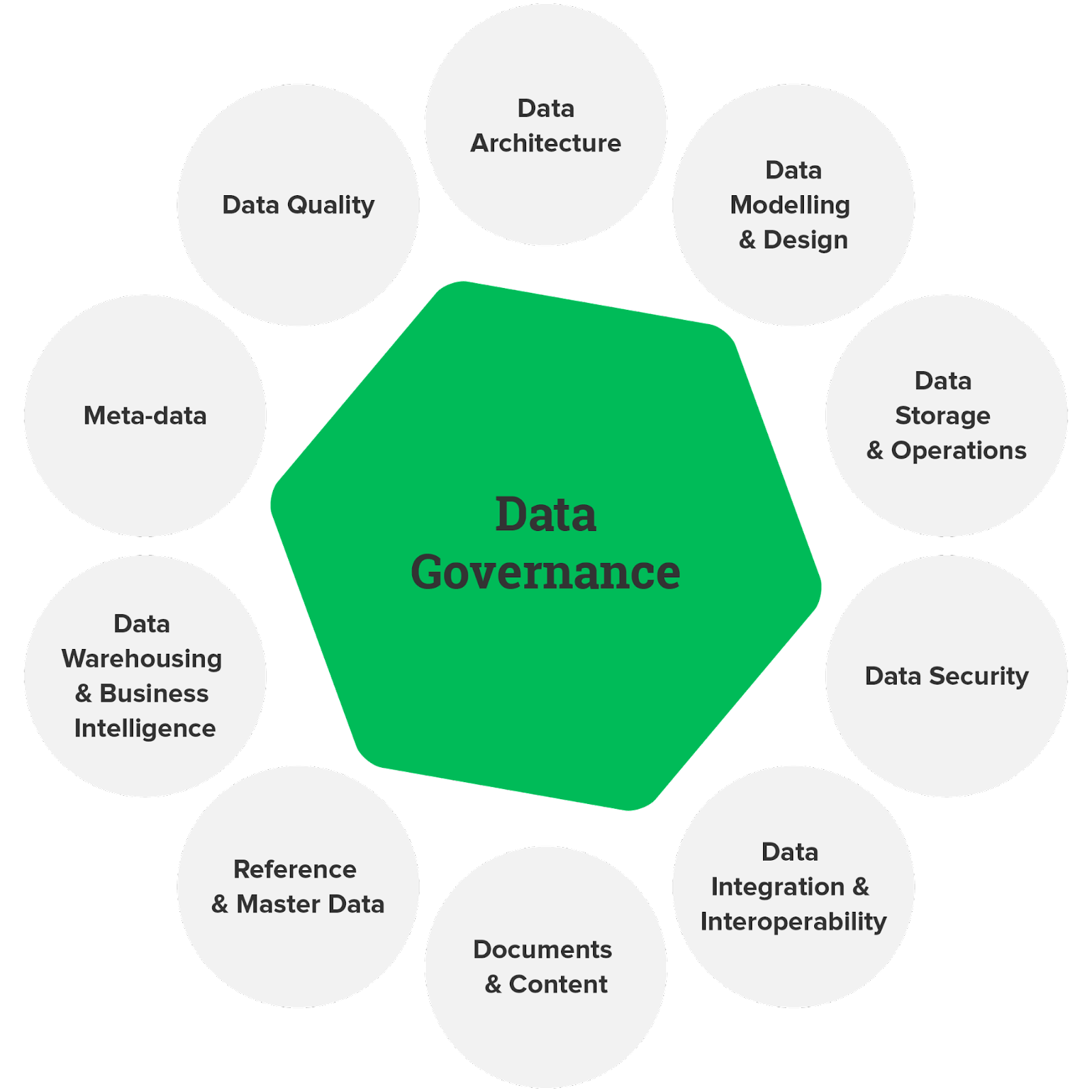

17. Quản trị dữ liệu

Mục tiêu

Quản trị dữ liệu rất quan trọng để đảm bảo chất lượng, tuân thủ và bảo mật dữ liệu. Trong dự án này, bạn sẽ thiết kế và triển khai khung quản trị dữ liệu bằng các dịch vụ Azure. Điều này có thể liên quan đến việc xác định chính sách dữ liệu, tạo danh mục dữ liệu và thiết lập các biện pháp kiểm soát truy cập dữ liệu để đảm bảo dữ liệu được sử dụng một cách có trách nhiệm và tuân thủ các quy định.

Giải quyết thế nào?

- Sử dụng Azure Purview để tạo danh mục ghi lại và phân loại nội dung dữ liệu.

- Triển khai các chính sách dữ liệu bằng Chính sách Azure và Azure Blueprints.

- Thiết lập kiểm soát truy cập dựa trên vai trò (RBAC) và tích hợp Azure Active Directory để quản lý quyền truy cập dữ liệu.

Nhấp vào đây để khám phá mã nguồn cho dự án kỹ thuật dữ liệu này.

18. Nhập dữ liệu theo thời gian thực

Mục tiêu

Thiết kế quy trình nhập dữ liệu theo thời gian thực trên Azure bằng cách sử dụng các dịch vụ như Azure Data Factory, Azure Stream Analytics và Azure Event Hubs. Mục tiêu là nhập dữ liệu từ nhiều nguồn khác nhau và xử lý dữ liệu theo thời gian thực, cung cấp thông tin chuyên sâu ngay lập tức cho việc ra quyết định.

Giải quyết thế nào?

- Sử dụng Trung tâm sự kiện Azure để nhập dữ liệu.

- Triển khai xử lý dữ liệu theo thời gian thực với Azure Stream Analytics.

- Lưu trữ dữ liệu đã xử lý trong Azure Data Lake Storage hoặc Azure SQL Database.

- Trực quan hóa thông tin chuyên sâu theo thời gian thực bằng cách sử dụng Bảng thông tin Power BI hoặc Azure.

hãy nhấp vào đây để khám phá mã nguồn của dự án này.

Ý tưởng dự án kỹ thuật dữ liệu AWS

19. Đường ống ETL

Mục tiêu

Xây dựng quy trình ETL (Trích xuất, Chuyển đổi, Tải) từ đầu đến cuối trên AWS. Đường dẫn sẽ trích xuất dữ liệu từ nhiều nguồn khác nhau, thực hiện các phép biến đổi và tải dữ liệu đã xử lý vào kho hoặc hồ dữ liệu. Dự án này lý tưởng để hiểu các nguyên tắc cốt lõi của kỹ thuật dữ liệu.

Giải quyết thế nào?

- Sử dụng AWS Glue hoặc AWS Data Pipeline để trích xuất dữ liệu.

- Triển khai các chuyển đổi bằng cách sử dụng Apache Spark trên Amazon EMR hoặc AWS Glue.

- Lưu trữ dữ liệu đã xử lý trên Amazon S3 hoặc Amazon Redshift.

- Thiết lập tự động hóa bằng AWS Step Functions hoặc AWS Lambda để điều phối.

Bấm vào đây để khám phá mã nguồn của dự án này.

20. Hoạt động ETL và ELT

Mục tiêu

Khám phá các phương pháp tích hợp dữ liệu ETL (Trích xuất, Chuyển đổi, Tải) và ELT (Trích xuất, Tải, Chuyển đổi) trên AWS. So sánh điểm mạnh và điểm yếu của họ trong các tình huống khác nhau. Dự án này sẽ cung cấp thông tin chi tiết về thời điểm sử dụng từng phương pháp dựa trên các yêu cầu kỹ thuật dữ liệu cụ thể.

Giải quyết thế nào?

- Triển khai các quy trình ETL bằng AWS Glue để chuyển đổi và tải dữ liệu. Sử dụng Đường ống dữ liệu AWS hoặc AWS DMS (Dịch vụ di chuyển cơ sở dữ liệu) cho các hoạt động ELT.

- Lưu trữ dữ liệu trên Amazon S3, Amazon Redshift hoặc Amazon Aurora, tùy theo phương pháp tiếp cận.

- Tự động hóa quy trình làm việc dữ liệu bằng cách sử dụng AWS Step Functions hoặc hàm AWS Lambda.

Bấm vào đây để khám phá mã nguồn của dự án này.

Kết luận

Các dự án kỹ thuật dữ liệu mang đến cơ hội tuyệt vời để đi sâu vào thế giới dữ liệu, khai thác sức mạnh của nó và thúc đẩy những hiểu biết có ý nghĩa. Cho dù bạn đang xây dựng quy trình cho dữ liệu phát trực tuyến theo thời gian thực hay tạo ra các giải pháp để xử lý các tập dữ liệu khổng lồ, những dự án này sẽ rèn luyện kỹ năng của bạn và mở ra cánh cửa cho những triển vọng nghề nghiệp thú vị.

Nhưng đừng dừng lại ở đây; nếu bạn mong muốn đưa hành trình kỹ thuật dữ liệu của mình lên một tầm cao mới, hãy cân nhắc đăng ký vào khóa học của chúng tôi Chương trình BlackBelt Plus. Với BB+, bạn sẽ có quyền truy cập vào hướng dẫn của chuyên gia, trải nghiệm thực tế và cộng đồng hỗ trợ, nâng kỹ năng kỹ thuật dữ liệu của bạn lên một tầm cao mới. Đăng ký ngay!

Những câu hỏi thường gặp

A. Kỹ thuật dữ liệu bao gồm việc thiết kế, xây dựng và duy trì đường dẫn dữ liệu. Ví dụ: Tạo quy trình thu thập, làm sạch và lưu trữ dữ liệu khách hàng để phân tích.

Đáp. Các biện pháp thực hành tốt nhất trong kỹ thuật dữ liệu bao gồm kiểm tra chất lượng dữ liệu hiệu quả, quy trình ETL hiệu quả, tài liệu và khả năng mở rộng để phát triển dữ liệu trong tương lai.

A. Kỹ sư dữ liệu làm việc với các nhiệm vụ như phát triển đường dẫn dữ liệu, đảm bảo độ chính xác của dữ liệu, cộng tác với các nhà khoa học dữ liệu và khắc phục các sự cố liên quan đến dữ liệu.

A. Để giới thiệu các dự án kỹ thuật dữ liệu trong sơ yếu lý lịch, hãy nêu bật các dự án chính, đề cập đến các công nghệ được sử dụng và định lượng tác động đến kết quả xử lý hoặc phân tích dữ liệu.

Sản phẩm liên quan

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.analyticsvidhya.com/blog/2023/09/data-engineering-project/