Đây là một bài đăng trên blog của khách được đồng viết với Ben Veasey, Jeremy Anderson, Jordan Knight và June Li từ Travelers.

Hình ảnh vệ tinh và trên không cung cấp cái nhìn sâu sắc về nhiều vấn đề, bao gồm nông nghiệp chính xác, đánh giá rủi ro bảo hiểm, phát triển đô thị và ứng phó với thảm họa. Tuy nhiên, việc đào tạo các mô hình học máy (ML) để giải thích dữ liệu này bị tắc nghẽn do các nỗ lực chú thích của con người tốn kém và tốn thời gian. Một cách để vượt qua thử thách này là thông qua học tập tự giám sát (SSL). Bằng cách đào tạo một lượng lớn dữ liệu hình ảnh chưa được gắn nhãn, các mô hình tự giám sát sẽ học các biểu diễn hình ảnh có thể được chuyển sang các tác vụ tiếp theo, chẳng hạn như phân loại hoặc phân đoạn hình ảnh. Cách tiếp cận này tạo ra các biểu diễn hình ảnh khái quát tốt cho dữ liệu không nhìn thấy và giảm lượng dữ liệu được gắn nhãn cần thiết để xây dựng các mô hình xuôi dòng hiệu quả.

Trong bài đăng này, chúng tôi trình bày cách đào tạo máy biến áp tầm nhìn tự giám sát trên hình ảnh trên cao bằng cách sử dụng Amazon SageMaker. Khách du lịch đã hợp tác với Phòng thí nghiệm giải pháp máy học của Amazon (hiện được gọi là Phòng thí nghiệm Trung tâm đổi mới AI sáng tạo) để phát triển khung này nhằm hỗ trợ và nâng cao các trường hợp sử dụng mô hình hình ảnh trên không. Giải pháp của chúng tôi dựa trên DINO thuật toán và sử dụng Thư viện dữ liệu song song phân tán SageMaker (SMDDP) để phân chia dữ liệu trên nhiều phiên bản GPU. Khi quá trình đào tạo trước hoàn tất, các biểu diễn hình ảnh DINO có thể được chuyển sang nhiều tác vụ tiếp theo. Sáng kiến này đã giúp cải thiện hiệu quả hoạt động của mô hình trong không gian Dữ liệu & Phân tích của khách du lịch.

Tổng quan về giải pháp

Quy trình hai bước để huấn luyện trước máy biến áp tầm nhìn và chuyển chúng sang các nhiệm vụ tiếp theo được giám sát được thể hiện trong sơ đồ sau.

Trong các phần tiếp theo, chúng tôi cung cấp hướng dẫn về giải pháp sử dụng hình ảnh vệ tinh từ Bộ dữ liệu BigEarthNet-S2. Chúng tôi xây dựng trên mã được cung cấp trong kho lưu trữ DINO.

Điều kiện tiên quyết

Trước khi bắt đầu, bạn cần truy cập vào một Phiên bản sổ ghi chép SageMaker và một Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3) xô.

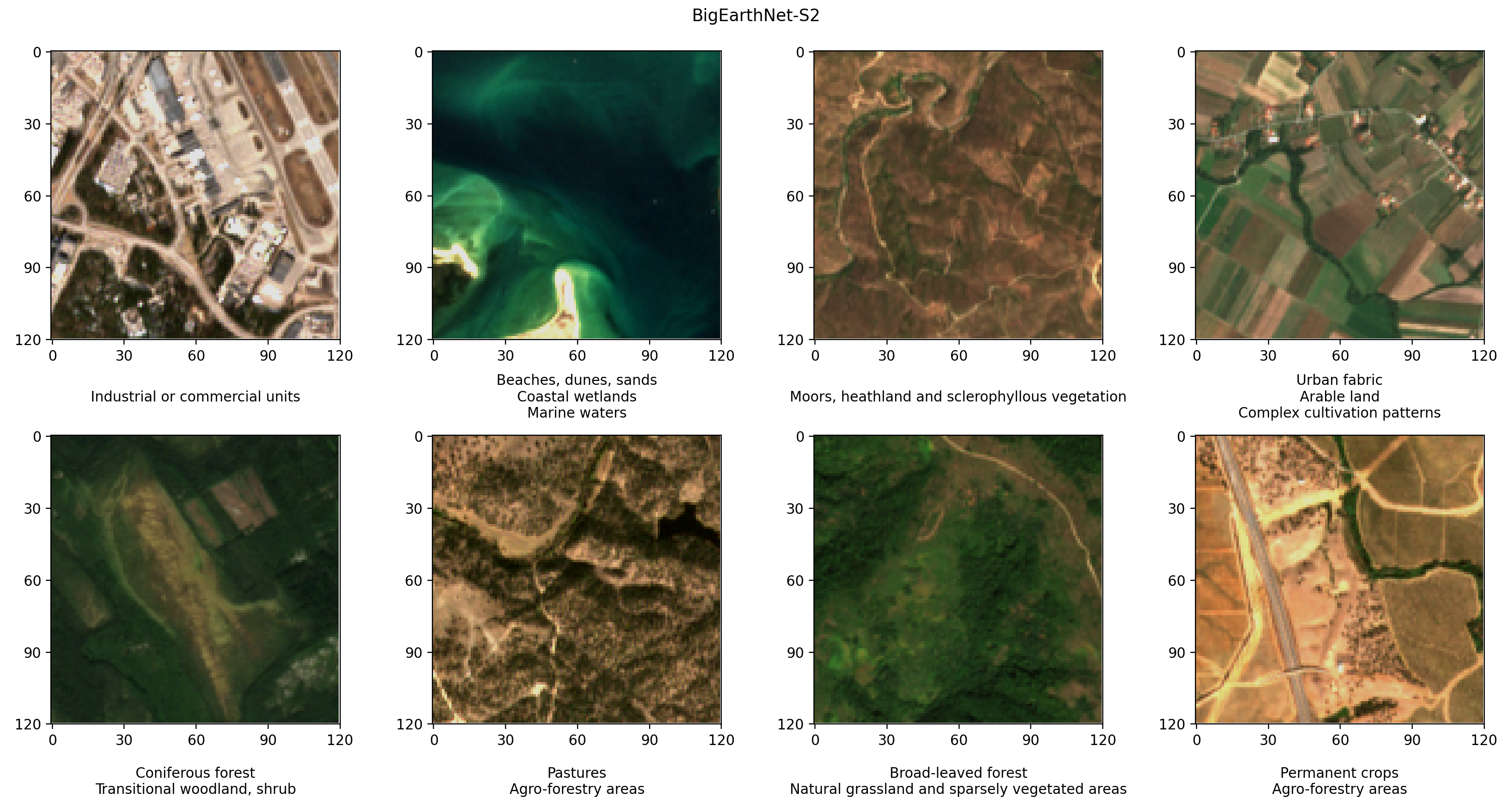

Chuẩn bị bộ dữ liệu BigEarthNet-S2

BigEarthNet-S2 là kho lưu trữ điểm chuẩn chứa 590,325 hình ảnh đa phổ do vệ tinh Sentinel-2 thu thập. Các hình ảnh ghi lại lớp phủ đất hoặc các đặc điểm bề mặt tự nhiên của mười quốc gia châu Âu trong khoảng thời gian từ tháng 2017 năm 2018 đến tháng 19 năm XNUMX. Các loại lớp phủ đất trong mỗi hình ảnh, chẳng hạn như đồng cỏ hoặc rừng, được chú thích theo XNUMX nhãn. Sau đây là một số ví dụ về hình ảnh RGB và nhãn của chúng.

Bước đầu tiên trong quy trình làm việc của chúng tôi là chuẩn bị bộ dữ liệu BigEarthNet-S2 để đào tạo và đánh giá DINO. Chúng tôi bắt đầu bằng cách tải xuống tập dữ liệu từ thiết bị đầu cuối của phiên bản sổ ghi chép SageMaker của chúng tôi:

Bộ dữ liệu có kích thước khoảng 109 GB. Mỗi hình ảnh được lưu trữ trong thư mục riêng của nó và chứa 12 kênh quang phổ. Ba dải có độ phân giải không gian 60m (chiều cao/chiều rộng pixel 60 mét) được thiết kế để xác định sol khí (B01), hơi nước (B09) và mây (B10). Sáu dải với độ phân giải không gian 20m được sử dụng để xác định thảm thực vật (B05, B06, B07, B8A) và phân biệt giữa tuyết, băng và mây (B11, B12). Ba dải tần với độ phân giải không gian 10m giúp thu được ánh sáng khả kiến và cận hồng ngoại (B02, B03, B04, B8/B8A). Ngoài ra, mỗi thư mục chứa một tệp JSON có siêu dữ liệu hình ảnh. Mô tả chi tiết về dữ liệu được cung cấp trong Hướng dẫn BigEarthNet.

Để thực hiện phân tích thống kê dữ liệu và tải hình ảnh trong quá trình đào tạo DINO, chúng tôi xử lý các tệp siêu dữ liệu riêng lẻ thành một tệp Parquet geopandas chung. Điều này có thể được thực hiện bằng BigEarthNet Common và BigEarthNet GDF Builder gói trợ giúp:

Tệp siêu dữ liệu kết quả chứa tập hợp hình ảnh được đề xuất, loại trừ 71,042 hình ảnh bị bao phủ hoàn toàn bởi tuyết, mây và bóng mây theo mùa. Nó cũng chứa thông tin về ngày mua, vị trí, lớp phủ đất và đào tạo, xác nhận và phân tách thử nghiệm cho mỗi hình ảnh.

Chúng tôi lưu trữ tệp siêu dữ liệu và hình ảnh BigEarthNet-S2 trong bộ chứa S3. Vì chúng tôi sử dụng hình ảnh màu thực trong quá trình đào tạo DINO nên chúng tôi chỉ tải lên các dải màu đỏ (B04), xanh lá cây (B03) và xanh dương (B02):

Tập dữ liệu có kích thước khoảng 48 GB và có cấu trúc như sau:

Huấn luyện các mô hình DINO với SageMaker

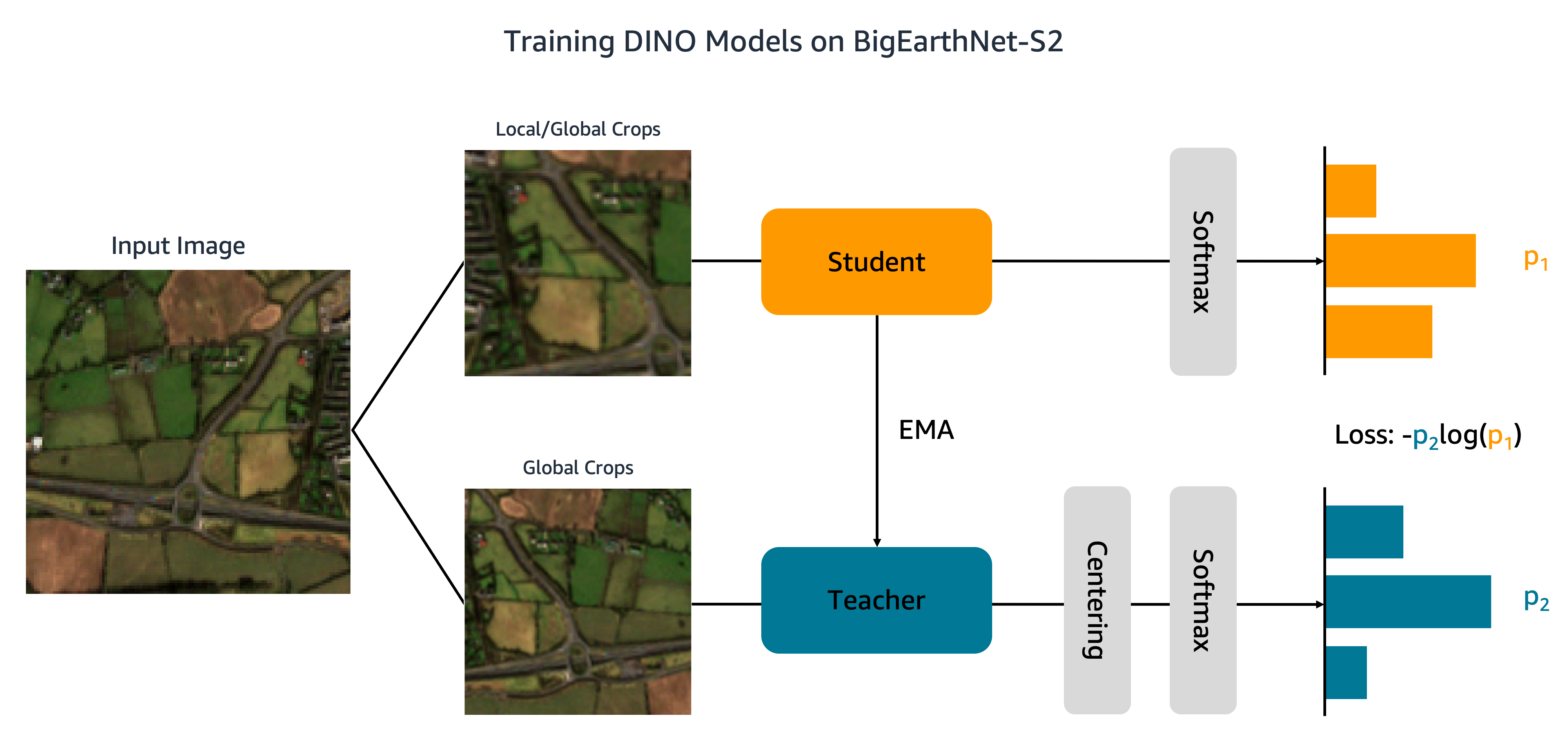

Bây giờ tập dữ liệu của chúng tôi đã được tải lên Amazon S3, chúng tôi chuyển sang huấn luyện các mô hình DINO trên BigEarthNet-S2. Như thể hiện trong hình dưới đây, thuật toán DINO chuyển các phần cắt toàn cục và cục bộ khác nhau của hình ảnh đầu vào tới mạng học sinh và giáo viên. Mạng sinh viên được dạy để phù hợp với đầu ra của mạng giáo viên bằng cách giảm thiểu tổn thất entropy chéo. Trọng số của học sinh và giáo viên được kết nối bằng một đường trung bình động hàm mũ (EMA).

Chúng tôi thực hiện hai sửa đổi đối với mã DINO ban đầu. Đầu tiên, chúng tôi tạo một lớp bộ dữ liệu PyTorch tùy chỉnh để tải các hình ảnh BigEarthNet-S2. Đoạn mã ban đầu được viết để xử lý dữ liệu ImageNet và hy vọng hình ảnh sẽ được lưu trữ theo lớp. Tuy nhiên, BigEarthNet-S2 là tập dữ liệu đa nhãn trong đó mỗi hình ảnh nằm trong thư mục con của chính nó. Lớp bộ dữ liệu của chúng tôi tải từng hình ảnh bằng đường dẫn tệp được lưu trữ trong siêu dữ liệu:

Lớp tập dữ liệu này được gọi trong main_dino.py Trong quá trình huấn luyện. Mặc dù mã bao gồm chức năng mã hóa một lần các nhãn che phủ đất, các nhãn này không được thuật toán DINO sử dụng.

Thay đổi thứ hai mà chúng tôi thực hiện đối với mã DINO là thêm hỗ trợ cho SMDDP. Chúng tôi thêm đoạn mã sau vào init_distributed_mode chức năng trong util.py tập tin:

Với những điều chỉnh này, chúng tôi đã sẵn sàng huấn luyện các mô hình DINO trên BigEarthNet-S2 bằng SageMaker. Để đào tạo trên nhiều GPU hoặc phiên bản, chúng tôi tạo một Công cụ ước tính PyTorch của SageMaker nhập tập lệnh đào tạo DINO, đường dẫn tệp hình ảnh và siêu dữ liệu cũng như siêu tham số đào tạo:

Mã này chỉ định rằng chúng tôi sẽ đào tạo một mô hình máy biến áp tầm nhìn nhỏ (21 triệu tham số) với kích thước bản vá là 16 cho 100 kỷ nguyên. Cách tốt nhất là tạo một tài khoản mới checkpoint_s3_uri cho từng công việc đào tạo để giảm thời gian tải dữ liệu ban đầu. Bởi vì chúng tôi đang sử dụng SMDDP, nên chúng tôi phải huấn luyện trên phiên bản ml.p3.16xlarge, ml.p3dn.24xlarge hoặc ml.p4d.24xlarge. Điều này là do SMDDP chỉ được bật cho các phiên bản đa GPU lớn nhất. Để huấn luyện các loại phiên bản nhỏ hơn mà không có SMDDP, bạn sẽ cần xóa distribution và debugger_hook_config đối số từ công cụ ước tính.

Sau khi chúng tôi đã tạo Công cụ ước tính SageMaker PyTorch, chúng tôi khởi chạy công việc đào tạo bằng cách gọi fit phương pháp. Chúng tôi chỉ định dữ liệu đào tạo đầu vào bằng cách sử dụng URI Amazon S3 cho hình ảnh và siêu dữ liệu BigEarthNet-S2:

SageMaker khởi động phiên bản, sao chép tập lệnh đào tạo và các thành phần phụ thuộc, rồi bắt đầu đào tạo DINO. Chúng tôi có thể theo dõi tiến trình của công việc đào tạo từ sổ ghi chép Jupyter của mình bằng các lệnh sau:

Chúng tôi cũng có thể theo dõi số liệu phiên bản và xem tệp nhật ký trên bảng điều khiển SageMaker bên dưới Công việc đào tạo. Trong các hình sau đây, chúng tôi vẽ sơ đồ hàm mất và sử dụng GPU cho mô hình DINO được đào tạo trên phiên bản ml.p3.16xlarge với kích thước lô là 128.

Trong quá trình đào tạo, mức sử dụng GPU là 83% dung lượng ml.p3.16xlarge (8 GPU NVIDIA Tesla V100) và mức sử dụng VRAM là 85%. Hàm mất mát giảm dần theo từng kỷ nguyên, cho thấy kết quả đầu ra của mạng lưới học sinh và giáo viên đang trở nên giống nhau hơn. Tổng cộng, đào tạo mất khoảng 11 giờ.

Chuyển việc học sang các nhiệm vụ xuôi dòng

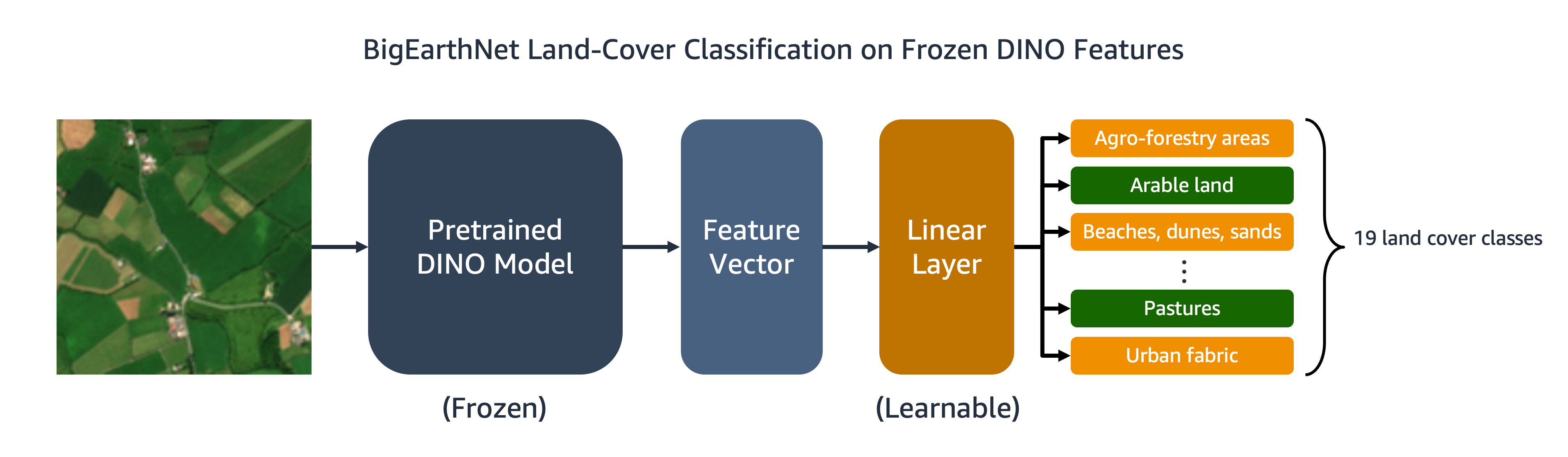

Mô hình DINO được đào tạo của chúng tôi có thể được chuyển sang các tác vụ hạ nguồn như phân loại hoặc phân đoạn hình ảnh. Trong phần này, chúng tôi sử dụng các tính năng DINO được đào tạo trước để dự đoán các lớp che phủ đất cho hình ảnh trong bộ dữ liệu BigEarthNet-S2. Như được mô tả trong sơ đồ sau, chúng tôi đào tạo một trình phân loại tuyến tính nhiều nhãn trên các tính năng DINO đã được đóng băng. Trong ví dụ này, hình ảnh đầu vào được liên kết với diện tích đất trồng trọt và đồng cỏ.

Hầu hết mã cho trình phân loại tuyến tính đã có sẵn trong kho lưu trữ DINO ban đầu. Chúng tôi thực hiện một số điều chỉnh cho nhiệm vụ cụ thể của mình. Như trước đây, chúng tôi sử dụng bộ dữ liệu BigEarthNet tùy chỉnh để tải hình ảnh trong quá trình đào tạo và đánh giá. Nhãn cho hình ảnh được mã hóa một lần dưới dạng vectơ nhị phân 19 chiều. chúng tôi sử dụng nhị phân chéo entropy cho hàm mất mát và tính toán độ chính xác trung bình để đánh giá hiệu quả của mô hình.

Để đào tạo trình phân loại, chúng tôi tạo Công cụ ước tính PyTorch SageMaker chạy tập lệnh đào tạo, eval_linear.py. Các siêu tham số đào tạo bao gồm các chi tiết về kiến trúc mô hình DINO và đường dẫn tệp cho điểm kiểm tra mô hình:

Chúng tôi bắt đầu công việc đào tạo bằng cách sử dụng fit phương thức, cung cấp các vị trí Amazon S3 của siêu dữ liệu BigEarthNet-S2 và hình ảnh đào tạo cũng như điểm kiểm tra mô hình DINO:

Khi quá trình đào tạo hoàn tất, chúng tôi có thể thực hiện suy luận trên bộ thử nghiệm BigEarthNet-S2 bằng cách sử dụng Chuyển đổi hàng loạt SageMaker or Xử lý SageMaker. Trong bảng sau, chúng tôi so sánh độ chính xác trung bình của mô hình tuyến tính trên các hình ảnh bộ thử nghiệm bằng cách sử dụng hai biểu diễn hình ảnh DINO khác nhau. Mô hình đầu tiên, ViT-S/16 (ImageNet), là điểm kiểm tra biến áp hình ảnh nhỏ có trong kho lưu trữ DINO đã được đào tạo trước bằng cách sử dụng hình ảnh mặt trước trong bộ dữ liệu ImageNet. Mô hình thứ hai, ViT-S/16 (BigEarthNet-S2), là mô hình chúng tôi tạo ra bằng cách đào tạo trước về hình ảnh trên cao.

| Mô hình | Độ chính xác trung bình |

|---|---|

| ViT-S/16 (ImageNet) | 0.685 |

| ViT-S/16 (BigEarthNet-S2) | 0.732 |

Chúng tôi thấy rằng mô hình DINO được đào tạo trước trên BigEarthNet-S2 chuyển sang nhiệm vụ phân loại lớp phủ đất tốt hơn so với mô hình DINO được đào tạo trước trên ImageNet, dẫn đến độ chính xác trung bình tăng 6.7%.

Làm sạch

Sau khi hoàn thành khóa đào tạo DINO và học chuyển tiếp, chúng tôi có thể dọn sạch tài nguyên của mình để tránh phát sinh phí. Chúng tôi dừng hoặc xóa phiên bản sổ ghi chép của chúng tôi và xóa mọi dữ liệu không mong muốn hoặc tạo tác mô hình từ Amazon S3.

Kết luận

Bài đăng này trình bày cách đào tạo các mô hình DINO trên hình ảnh trên cao bằng SageMaker. Chúng tôi đã sử dụng Công cụ ước tính SageMaker PyTorch và SMDDP để tạo các biểu diễn của hình ảnh BigEarthNet-S2 mà không cần nhãn rõ ràng. Sau đó, chúng tôi đã chuyển các tính năng DINO sang nhiệm vụ phân loại hình ảnh xuôi dòng, liên quan đến việc dự đoán lớp che phủ mặt đất của hình ảnh BigEarthNet-S2. Đối với nhiệm vụ này, đào tạo trước trên hình ảnh vệ tinh mang lại độ chính xác trung bình tăng 6.7% so với đào tạo trước trên ImageNet.

Bạn có thể sử dụng giải pháp này làm mẫu để đào tạo các mô hình DINO trên bộ dữ liệu hình ảnh vệ tinh và vệ tinh trên không, không được gắn nhãn. Để tìm hiểu thêm về DINO và xây dựng các mô hình trên SageMaker, hãy xem các tài nguyên sau:

Về các tác giả

Ben Vasey là Nhà khoa học dữ liệu liên kết cấp cao tại Travelers, làm việc trong nhóm AI & Máy gia tốc tự động hóa. Với sự hiểu biết sâu sắc về các công nghệ AI đổi mới, bao gồm thị giác máy tính, xử lý ngôn ngữ tự nhiên và AI tổng quát, Ben tận tâm đẩy nhanh việc áp dụng các công nghệ này để tối ưu hóa quy trình kinh doanh và nâng cao hiệu quả tại Travelers.

Jeremy Anderson là Giám đốc & Nhà khoa học dữ liệu tại Travelers trong nhóm AI & Máy gia tốc tự động hóa. Anh ấy quan tâm đến việc giải quyết các vấn đề kinh doanh bằng AI mới nhất và các kỹ thuật học sâu bao gồm các mô hình ngôn ngữ lớn, mô hình hình ảnh nền tảng và AI tổng quát. Trước khi làm Du khách, Jeremy đã lấy bằng Tiến sĩ về Vật lý sinh học phân tử tại Đại học Johns Hopkins và cũng nghiên cứu về hóa sinh tiến hóa. Ngoài giờ làm việc, bạn có thể thấy anh ấy chạy bộ, chế biến gỗ hoặc xây dựng lại sân vườn của mình.

Hiệp sĩ Jordan là Nhà khoa học dữ liệu cấp cao làm việc cho Khách du lịch trong Phòng nghiên cứu & phân tích bảo hiểm kinh doanh. Niềm đam mê của anh ấy là giải quyết các vấn đề về thị giác máy tính trong thế giới thực đầy thách thức và khám phá các phương pháp tiên tiến mới để giải quyết vấn đề đó. Anh ấy đặc biệt quan tâm đến tác động xã hội của các mô hình ML và cách chúng tôi có thể tiếp tục cải thiện các quy trình lập mô hình để phát triển các giải pháp ML công bằng cho tất cả mọi người. Jordan tốt nghiệp MIT với bằng Thạc sĩ về Phân tích Kinh doanh. Trong thời gian rảnh rỗi, bạn có thể thấy anh ấy leo núi, đi bộ đường dài hoặc tiếp tục phát triển kỹ năng nấu ăn hơi thô sơ của mình.

tháng XNUMX Lý là một nhà khoa học dữ liệu tại nhóm Trí tuệ nhân tạo của Bảo hiểm kinh doanh của Travelers, nơi cô lãnh đạo và điều phối công việc trong danh mục hình ảnh AI. Cô đam mê triển khai các giải pháp AI sáng tạo mang lại giá trị đáng kể cho các đối tác kinh doanh và các bên liên quan. Công việc của cô là không thể thiếu trong việc biến những thách thức kinh doanh phức tạp thành cơ hội bằng cách tận dụng các công nghệ AI tiên tiến.

Sourav Bhabesh là Nhà khoa học ứng dụng cấp cao tại AWS Titan Labs, nơi ông xây dựng các khả năng và tính năng của Mô hình nền tảng (FM). Chuyên môn của anh ấy là Xử lý ngôn ngữ tự nhiên (NLP) và đam mê học sâu. Ngoài công việc, anh ấy thích đọc sách và đi du lịch.

Laura Kulowski là Nhà khoa học ứng dụng tại Trung tâm đổi mới trí tuệ nhân tạo sáng tạo của Amazon, nơi cô làm việc chặt chẽ với khách hàng để xây dựng các giải pháp trí tuệ nhân tạo sáng tạo. Khi rảnh rỗi, Laura thích khám phá những địa điểm mới bằng xe đạp.

Andrew Ang là Kỹ sư máy học cấp cao tại AWS. Ngoài việc giúp khách hàng xây dựng các giải pháp AI/ML, anh ấy còn thích các môn thể thao dưới nước, bóng quần và xem các vlog về du lịch và ẩm thực.

Mehdi Noori là Giám đốc Khoa học Ứng dụng tại Trung tâm Sáng tạo AI Sáng tạo. Với niềm đam mê kết nối công nghệ và đổi mới, anh hỗ trợ khách hàng của AWS khai phá tiềm năng của AI tổng hợp, biến những thách thức tiềm tàng thành cơ hội để thử nghiệm và đổi mới nhanh chóng bằng cách tập trung vào việc sử dụng các công nghệ AI tiên tiến có thể mở rộng, đo lường được và có tác động, đồng thời hợp lý hóa lộ trình đến sản xuất.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Ô tô / Xe điện, Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- ChartPrime. Nâng cao trò chơi giao dịch của bạn với ChartPrime. Truy cập Tại đây.

- BlockOffsets. Hiện đại hóa quyền sở hữu bù đắp môi trường. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/train-self-supervised-vision-transformers-on-overhead-imagery-with-amazon-sagemaker/