Giới thiệu

Một nhóm các nhà khoa học máy tính đã tạo ra một loại nhanh nhẹn hơn, linh hoạt hơn của mô hình học máy. Bí quyết: Nó phải định kỳ quên đi những gì nó biết. Và mặc dù cách tiếp cận mới này sẽ không thay thế các mô hình khổng lồ làm nền tảng cho các ứng dụng lớn nhất, nhưng nó có thể tiết lộ nhiều hơn về cách các chương trình này hiểu ngôn ngữ.

Nghiên cứu mới đánh dấu “một bước tiến đáng kể trong lĩnh vực này”, cho biết Jea Kwon, một kỹ sư AI tại Viện Khoa học Cơ bản ở Hàn Quốc.

Các công cụ ngôn ngữ AI được sử dụng ngày nay chủ yếu được cung cấp bởi mạng lưới thần kinh nhân tạo. Mỗi “nơ-ron” trong mạng là một hàm toán học nhận tín hiệu từ các nơ-ron khác, thực hiện một số phép tính và gửi tín hiệu qua nhiều lớp nơ-ron. Ban đầu, luồng thông tin ít nhiều mang tính ngẫu nhiên, nhưng thông qua quá trình huấn luyện, luồng thông tin giữa các nơ-ron được cải thiện khi mạng thích ứng với dữ liệu huấn luyện. Ví dụ: nếu một nhà nghiên cứu AI muốn tạo ra một mô hình song ngữ, cô ấy sẽ huấn luyện mô hình đó với một lượng lớn văn bản từ cả hai ngôn ngữ, điều này sẽ điều chỉnh các kết nối giữa các nơ-ron theo cách liên kết văn bản trong một ngôn ngữ với các ngôn ngữ tương đương. các từ khác.

Nhưng quá trình đào tạo này tốn rất nhiều sức mạnh tính toán. Nếu mô hình hoạt động không tốt hoặc sau này nhu cầu của người dùng thay đổi thì rất khó để điều chỉnh nó. “Giả sử bạn có một mô hình có 100 ngôn ngữ, nhưng hãy tưởng tượng rằng một ngôn ngữ bạn muốn không được hỗ trợ,” nói Mikel Artetxe, đồng tác giả của nghiên cứu mới và là người sáng lập công ty khởi nghiệp AI Reka. “Bạn có thể bắt đầu lại từ đầu, nhưng điều đó không lý tưởng.”

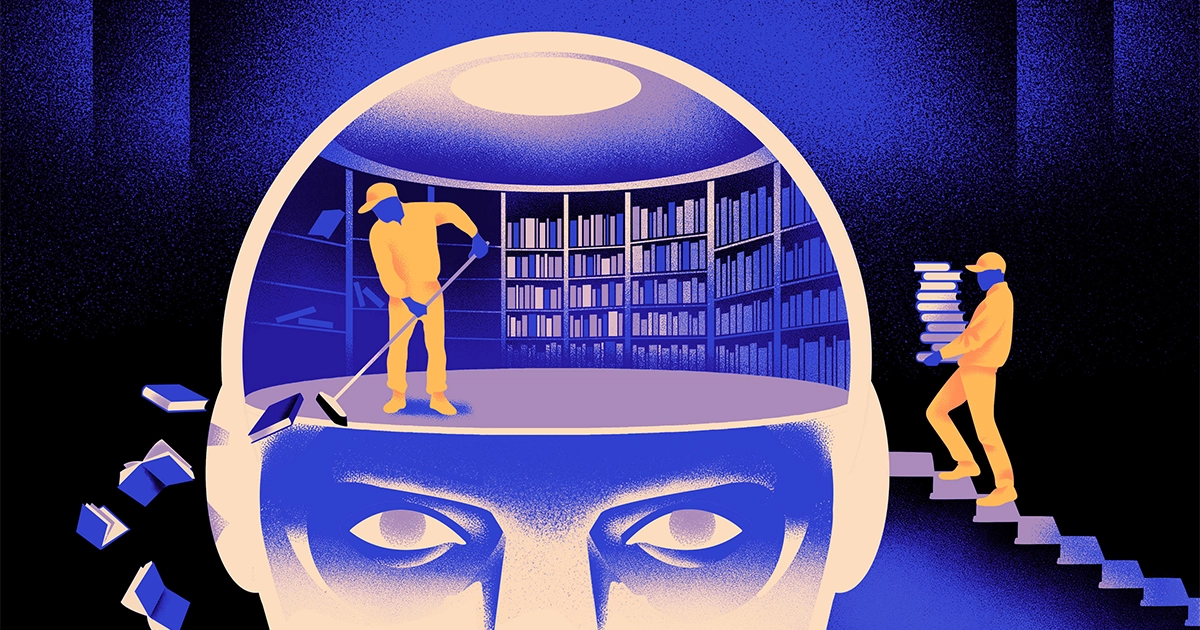

Artetxe và các đồng nghiệp của ông đã cố gắng khắc phục những hạn chế này. Vài năm trước, Artetxe và những người khác đã huấn luyện mạng lưới thần kinh bằng một ngôn ngữ, sau đó xóa những gì nó biết về các khối xây dựng của từ, được gọi là mã thông báo. Chúng được lưu trữ trong lớp đầu tiên của mạng lưới thần kinh, được gọi là lớp nhúng. Họ để lại tất cả các lớp khác của mô hình. Sau khi xóa các mã thông báo của ngôn ngữ đầu tiên, họ đã đào tạo lại mô hình trên ngôn ngữ thứ hai, lấp đầy lớp nhúng bằng các mã thông báo mới từ ngôn ngữ đó.

Mặc dù mô hình chứa thông tin không khớp nhưng quá trình đào tạo lại đã hoạt động: Mô hình có thể học và xử lý ngôn ngữ mới. Các nhà nghiên cứu phỏng đoán rằng trong khi lớp nhúng lưu trữ thông tin cụ thể cho các từ được sử dụng trong ngôn ngữ, thì các cấp độ sâu hơn của mạng sẽ lưu trữ nhiều thông tin trừu tượng hơn về các khái niệm đằng sau ngôn ngữ của con người, sau đó giúp mô hình học ngôn ngữ thứ hai.

“Chúng ta sống trong cùng một thế giới. Chúng tôi khái niệm hóa những điều giống nhau bằng những từ khác nhau” bằng các ngôn ngữ khác nhau, cho biết Yihong Chen, tác giả chính của bài báo gần đây. “Đó là lý do tại sao bạn có cùng lý luận cấp cao này trong mô hình. Một quả táo là một thứ gì đó ngọt ngào và mọng nước, thay vì chỉ một lời nói.”

Giới thiệu

Mặc dù phương pháp quên này là một cách hiệu quả để thêm ngôn ngữ mới vào một mô hình đã được đào tạo, nhưng việc đào tạo lại vẫn đòi hỏi khắt khe - nó đòi hỏi rất nhiều dữ liệu ngôn ngữ và khả năng xử lý. Chen đề xuất một điều chỉnh: Thay vì đào tạo, xóa lớp nhúng rồi đào tạo lại, họ nên định kỳ đặt lại lớp nhúng trong vòng đào tạo đầu tiên. Artetxe cho biết: “Bằng cách làm này, toàn bộ mô hình sẽ quen với việc đặt lại. “Điều đó có nghĩa là khi bạn muốn mở rộng mô hình sang một ngôn ngữ khác, điều đó sẽ dễ dàng hơn vì đó là những gì bạn đang làm.”

Các nhà nghiên cứu đã sử dụng một mô hình ngôn ngữ thường được sử dụng gọi là Roberta, huấn luyện nó bằng kỹ thuật quên định kỳ của họ và so sánh nó với hiệu suất của mô hình tương tự khi nó được huấn luyện bằng phương pháp tiêu chuẩn, không quên. Mô hình quên kém hơn một chút so với mô hình thông thường, nhận được số điểm 85.1 so với 86.1 trên một thước đo chung về độ chính xác của ngôn ngữ. Sau đó, họ đào tạo lại các mô hình trên các ngôn ngữ khác, sử dụng bộ dữ liệu nhỏ hơn nhiều, chỉ có 5 triệu mã thông báo, thay vì 70 tỷ mà họ đã sử dụng trong lần đào tạo đầu tiên. Độ chính xác của mô hình chuẩn giảm trung bình xuống còn 53.3, nhưng mô hình quên chỉ giảm xuống còn 62.7.

Mô hình quên cũng hoạt động tốt hơn nhiều nếu nhóm áp đặt các giới hạn tính toán trong quá trình đào tạo lại. Khi các nhà nghiên cứu cắt giảm thời lượng đào tạo từ 125,000 bước xuống chỉ còn 5,000, độ chính xác của mô hình quên giảm trung bình xuống còn 57.8, trong khi mô hình tiêu chuẩn giảm xuống còn 37.2, không tốt hơn so với các phỏng đoán ngẫu nhiên.

Giới thiệu

Nhóm nghiên cứu kết luận rằng việc quên định kỳ dường như làm cho mô hình học ngôn ngữ nói chung tốt hơn. “Bởi vì [họ] hay quên và học lại trong quá trình đào tạo nên việc dạy cho mạng những điều mới sau này trở nên dễ dàng hơn,” cho biết Evgenii Nikishin, nhà nghiên cứu tại Mila, một trung tâm nghiên cứu deep learning ở Quebec. Nó gợi ý rằng khi các mô hình ngôn ngữ hiểu một ngôn ngữ, chúng sẽ hiểu ở mức độ sâu hơn chứ không chỉ là nghĩa của từng từ riêng lẻ.

Cách tiếp cận này tương tự như cách bộ não của chúng ta hoạt động. “Bộ nhớ của con người nói chung không giỏi trong việc lưu trữ chính xác lượng lớn thông tin chi tiết. Thay vào đó, con người có xu hướng ghi nhớ ý chính của trải nghiệm, trừu tượng hóa và ngoại suy,” ông nói. Benjamin Levy, một nhà thần kinh học tại Đại học San Francisco. “Việc kích hoạt AI với các quy trình giống con người hơn, chẳng hạn như khả năng quên thích ứng, là một cách giúp chúng đạt được hiệu suất linh hoạt hơn.”

Ngoài những gì nó có thể nói về cách hoạt động của sự hiểu biết, Artetxe hy vọng các mô hình quên ngôn ngữ linh hoạt hơn cũng có thể giúp mang lại những đột phá AI mới nhất cho nhiều ngôn ngữ hơn. Mặc dù các mô hình AI xử lý tốt tiếng Tây Ban Nha và tiếng Anh, hai ngôn ngữ có tài liệu đào tạo phong phú, nhưng các mô hình này lại không giỏi bằng tiếng Basque, ngôn ngữ địa phương đặc trưng của vùng đông bắc Tây Ban Nha. Ông nói: “Hầu hết các mô hình của các công ty công nghệ lớn đều không làm tốt điều đó. “Việc điều chỉnh các mô hình hiện có cho phù hợp với tiếng Basque là một cách tốt.”

Chen cũng mong chờ một thế giới nơi có nhiều bông hoa AI nở rộ hơn. “Tôi đang nghĩ đến một tình huống mà thế giới không cần một mô hình ngôn ngữ lớn. Chúng tôi có rất nhiều”, cô nói. “Nếu có một nhà máy sản xuất mô hình ngôn ngữ, bạn cần loại công nghệ này. Nó có một mô hình cơ sở có thể nhanh chóng thích ứng với các miền mới.”

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/