Hôm nay, chúng tôi vui mừng thông báo khả năng tinh chỉnh mẫu Mistral 7B bằng cách sử dụng Khởi động Amazon SageMaker. Bây giờ bạn có thể tinh chỉnh và triển khai các mô hình tạo văn bản Mistral trên SageMaker JumpStart bằng cách sử dụng Xưởng sản xuất Amazon SageMaker Giao diện người dùng với một vài cú nhấp chuột hoặc sử dụng SDK Python của SageMaker.

Các mô hình nền tảng thực hiện rất tốt các nhiệm vụ tổng quát, từ tạo văn bản và tóm tắt, trả lời câu hỏi đến tạo hình ảnh và video. Mặc dù các mô hình này có khả năng khái quát hóa tuyệt vời nhưng thường có những trường hợp sử dụng có dữ liệu miền rất cụ thể (chẳng hạn như dịch vụ chăm sóc sức khỏe hoặc tài chính) và những mô hình này có thể không mang lại kết quả tốt cho những trường hợp sử dụng này. Điều này dẫn đến nhu cầu tinh chỉnh thêm các mô hình AI tổng hợp này dựa trên dữ liệu dành riêng cho từng trường hợp sử dụng và từng miền cụ thể.

Trong bài đăng này, chúng tôi trình bày cách tinh chỉnh mô hình Mistral 7B bằng SageMaker JumpStart.

Mistral 7B là gì

Mistral 7B là mô hình nền tảng được phát triển bởi Mistral AI, hỗ trợ khả năng tạo văn bản và mã tiếng Anh. Nó hỗ trợ nhiều trường hợp sử dụng khác nhau, chẳng hạn như tóm tắt văn bản, phân loại, hoàn thành văn bản và hoàn thành mã. Để chứng minh khả năng tùy chỉnh của mô hình, Mistral AI cũng đã phát hành mô hình Mistral 7B-Instruct cho các trường hợp sử dụng trò chuyện, được tinh chỉnh bằng nhiều bộ dữ liệu hội thoại có sẵn công khai.

Mistral 7B là một mô hình biến áp và sử dụng chú ý truy vấn được nhóm và chú ý cửa sổ trượt để đạt được suy luận nhanh hơn (độ trễ thấp) và xử lý các chuỗi dài hơn. Chú ý truy vấn được nhóm là một kiến trúc kết hợp chú ý nhiều truy vấn và chú ý nhiều đầu để đạt được chất lượng đầu ra gần với chú ý nhiều đầu và tốc độ tương đương với chú ý nhiều truy vấn. Phương pháp chú ý cửa sổ trượt sử dụng nhiều cấp độ của mô hình máy biến áp để tập trung vào thông tin có trước đó, giúp mô hình hiểu được ngữ cảnh dài hơn. . Mistral 7B có độ dài ngữ cảnh 8,000 mã thông báo, thể hiện độ trễ thấp và thông lượng cao, đồng thời có hiệu suất mạnh mẽ khi so sánh với các lựa chọn thay thế mô hình lớn hơn, cung cấp yêu cầu bộ nhớ thấp ở kích thước mô hình 7B. Mô hình này được cung cấp theo giấy phép Apache 2.0 cho phép sử dụng mà không bị hạn chế.

Bạn có thể tinh chỉnh các mô hình bằng cách sử dụng SageMaker Studio UI hoặc SageMaker Python SDK. Chúng tôi thảo luận về cả hai phương pháp trong bài viết này.

Tinh chỉnh thông qua giao diện người dùng SageMaker Studio

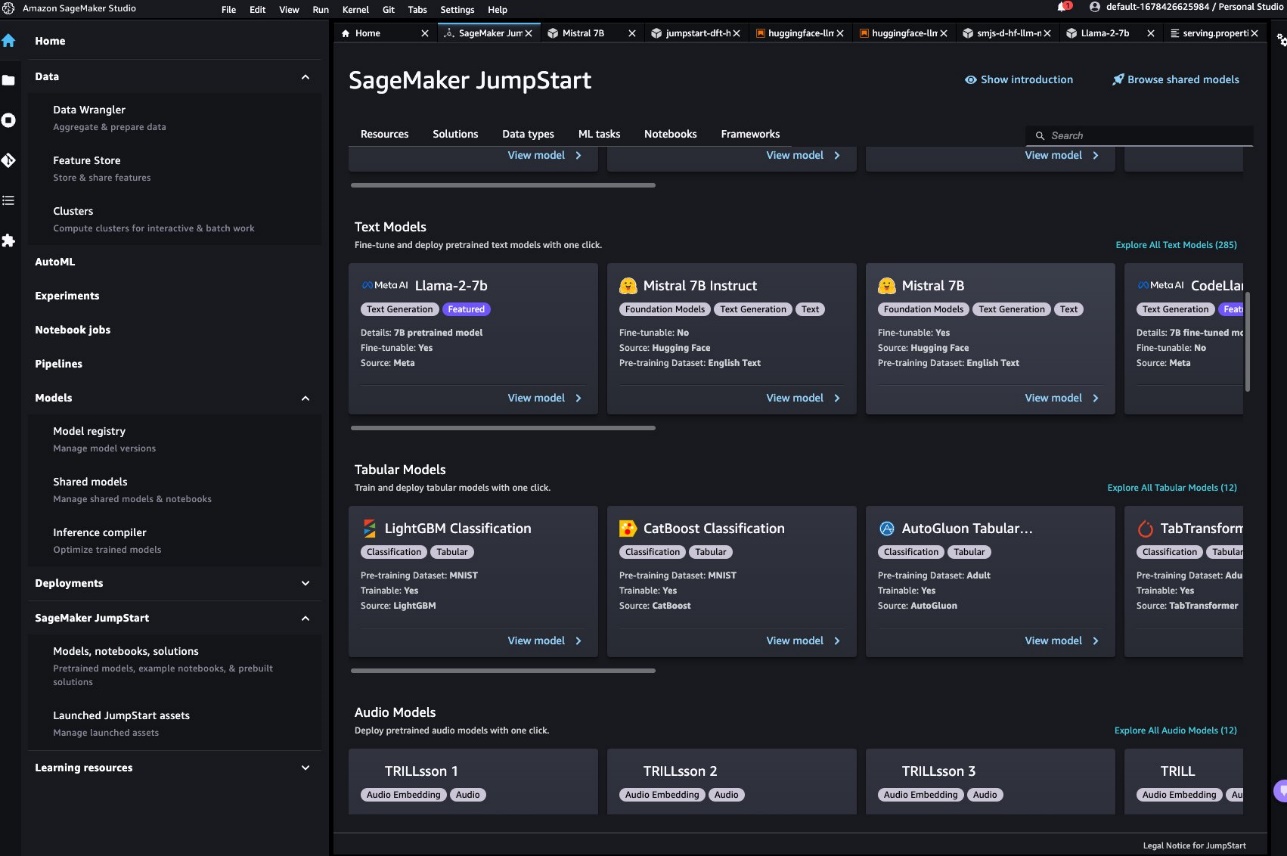

Trong SageMaker Studio, bạn có thể truy cập mô hình Mistral thông qua SageMaker JumpStart trong Mô hình, sổ ghi chép và giải pháp, như thể hiện trong ảnh chụp màn hình sau đây.

Nếu bạn không thấy mẫu Mistral, hãy cập nhật phiên bản SageMaker Studio bằng cách tắt và khởi động lại. Để biết thêm thông tin về các bản cập nhật phiên bản, hãy tham khảo Tắt và cập nhật ứng dụng Studio.

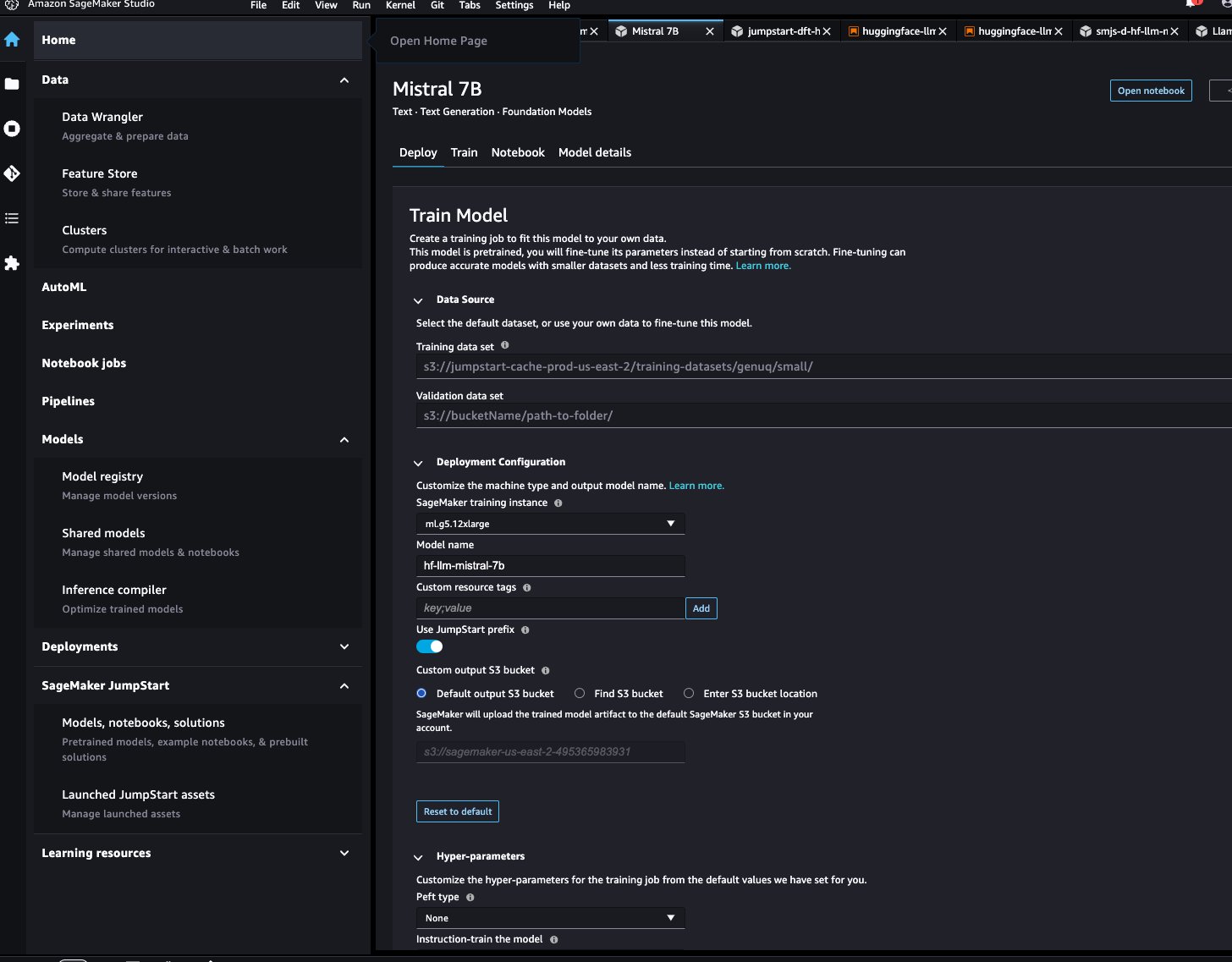

Trên trang mô hình, bạn có thể trỏ tới Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3) chứa tập dữ liệu huấn luyện và xác thực để tinh chỉnh. Ngoài ra, bạn có thể định cấu hình cấu hình triển khai, siêu tham số và cài đặt bảo mật để tinh chỉnh. Sau đó bạn có thể chọn Train để bắt đầu công việc đào tạo trên phiên bản SageMaker ML.

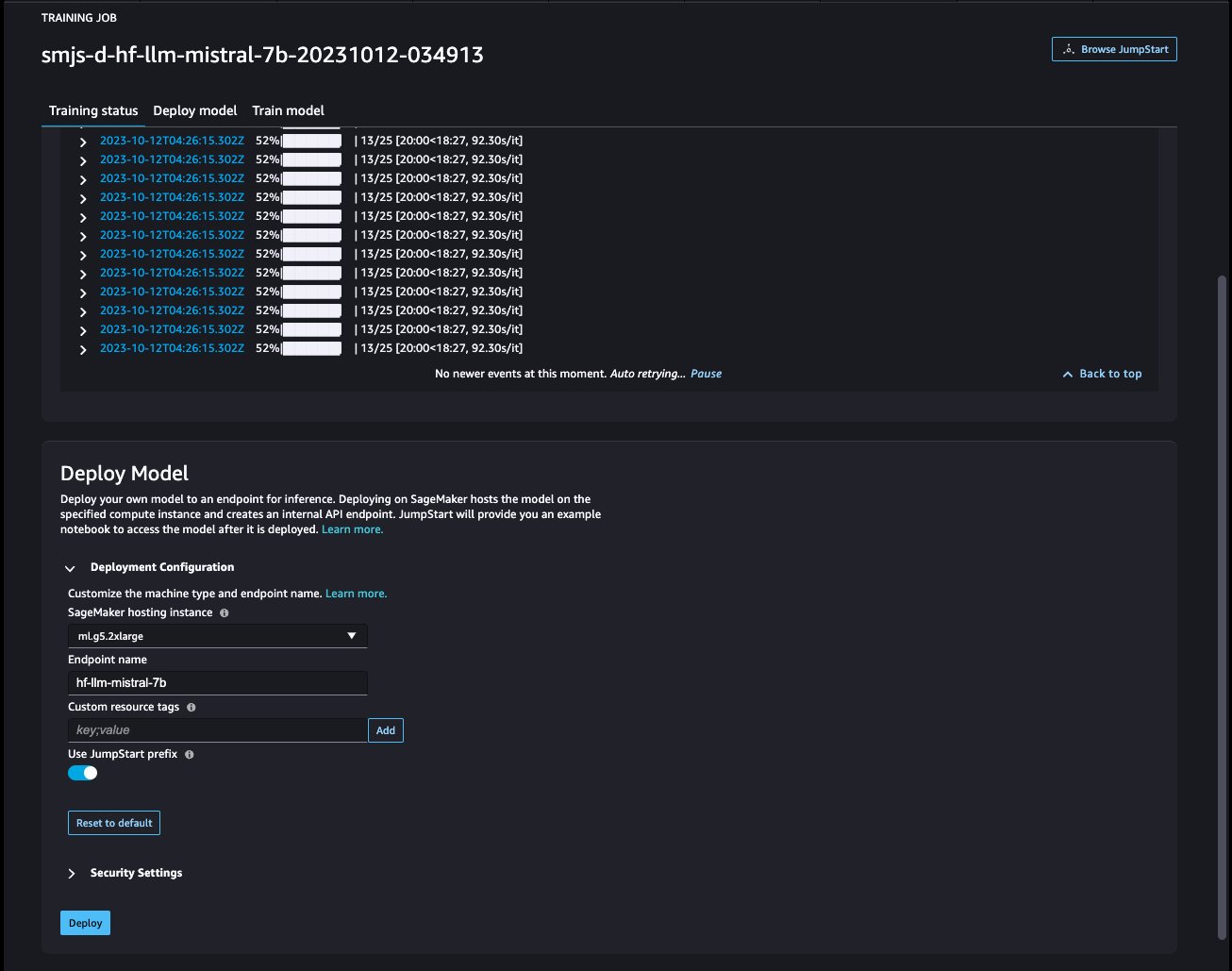

Triển khai mô hình

Sau khi tinh chỉnh mô hình, bạn có thể triển khai nó bằng trang mô hình trên SageMaker JumpStart. Tùy chọn triển khai mô hình tinh chỉnh sẽ xuất hiện khi quá trình tinh chỉnh hoàn tất, như minh họa trong ảnh chụp màn hình sau.

Tinh chỉnh thông qua SageMaker Python SDK

Bạn cũng có thể tinh chỉnh các mô hình Mistral bằng SageMaker Python SDK. Sổ ghi chép hoàn chỉnh có sẵn trên GitHub. Trong phần này, chúng tôi cung cấp các ví dụ về hai loại tinh chỉnh.

tinh chỉnh hướng dẫn

Điều chỉnh hướng dẫn là một kỹ thuật liên quan đến việc tinh chỉnh mô hình ngôn ngữ trên một tập hợp các tác vụ xử lý ngôn ngữ tự nhiên (NLP) bằng cách sử dụng hướng dẫn. Trong kỹ thuật này, mô hình được đào tạo để thực hiện các nhiệm vụ bằng cách làm theo các hướng dẫn bằng văn bản thay vì các bộ dữ liệu cụ thể cho từng nhiệm vụ. Mô hình được tinh chỉnh với một tập hợp các ví dụ đầu vào và đầu ra cho từng nhiệm vụ, cho phép mô hình khái quát hóa các nhiệm vụ mới mà mô hình chưa được đào tạo rõ ràng miễn là có lời nhắc cho các nhiệm vụ. Điều chỉnh hướng dẫn giúp cải thiện độ chính xác và hiệu quả của các mô hình và rất hữu ích trong các trường hợp không có sẵn bộ dữ liệu lớn cho các tác vụ cụ thể.

Hãy xem qua mã tinh chỉnh được cung cấp trong ví dụ máy tính xách tay với SDK Python của SageMaker.

Chúng tôi sử dụng một tập hợp con của Tập dữ liệu Dolly ở định dạng điều chỉnh lệnh và chỉ định template.json tập tin mô tả các định dạng đầu vào và đầu ra. Dữ liệu huấn luyện phải được định dạng ở định dạng dòng JSON (.jsonl), trong đó mỗi dòng là một từ điển biểu thị một mẫu dữ liệu duy nhất. Trong trường hợp này, chúng tôi đặt tên cho nó train.jsonl.

Đoạn mã sau đây là một ví dụ về train.jsonl. Những chiếc chìa khóa instruction, contextvà response trong mỗi mẫu phải có mục tương ứng {instruction}, {context}, {response} trong template.json.

Sau đây là một mẫu của template.json:

Sau khi tải mẫu lời nhắc và dữ liệu đào tạo lên bộ chứa S3, bạn có thể đặt siêu tham số.

Sau đó, bạn có thể bắt đầu quá trình tinh chỉnh và triển khai mô hình đến điểm cuối suy luận. Trong đoạn mã sau, chúng tôi sử dụng phiên bản ml.g5.12xlarge:

Tinh chỉnh thích ứng tên miền

Tinh chỉnh thích ứng miền là một quá trình tinh chỉnh LLM được đào tạo trước để phù hợp hơn với một miền hoặc nhiệm vụ cụ thể. Bằng cách sử dụng tập dữ liệu nhỏ hơn, dành riêng cho miền, LLM có thể được tinh chỉnh để hiểu và tạo nội dung chính xác, phù hợp và sâu sắc hơn cho miền cụ thể đó, trong khi vẫn giữ được kiến thức sâu rộng mà nó có được trong quá trình đào tạo ban đầu.

Mô hình Mistral có thể được tinh chỉnh trên bất kỳ tập dữ liệu theo miền cụ thể nào. Sau khi được tinh chỉnh, nó dự kiến sẽ tạo văn bản dành riêng cho miền và giải quyết các tác vụ NLP khác nhau trong miền cụ thể đó. Đối với tập dữ liệu huấn luyện, hãy cung cấp một thư mục đào tạo và một thư mục xác thực tùy chọn, mỗi thư mục chứa một tệp CSV, JSON hoặc TXT. Đối với các định dạng CSV và JSON, hãy sử dụng dữ liệu từ text cột hoặc cột đầu tiên nếu text không có mặt. Đảm bảo chỉ có một tệp tồn tại trong mỗi thư mục. Ví dụ: dữ liệu đầu vào có thể là hồ sơ SEC của Amazon dưới dạng tệp văn bản:

Bạn có thể bắt đầu tinh chỉnh thích ứng miền bằng cách chỉ định siêu tham số “instruction_tuned" như "False“. Các bước còn lại tương tự như các bước tinh chỉnh theo hướng dẫn.

Chúng tôi thiết lập max_input_length là 2048 trên g5.12xlarge. Bạn có thể sử dụng độ dài đầu vào cao hơn trên loại phiên bản lớn hơn. Để biết chi tiết, xem ví dụ máy tính xách tay.

Ví dụ suy luận có và không có tinh chỉnh

Bảng sau đây trình bày các kết quả của mô hình Mistral 7B được tinh chỉnh với các tài liệu nộp lên SEC của Amazon từ năm 2021–2022. Chúng tôi so sánh đầu ra trước và sau khi tinh chỉnh.

| Lời nhắc đầu vào | Đầu ra trước khi tinh chỉnh | Đầu ra sau khi tinh chỉnh | Thông số |

| Báo cáo Mẫu 10-K này cho thấy rằng |

Công ty đã hoạt động được 10 năm và có tổng cộng 10 nhân viên. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp dịch vụ cho công chúng. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp dịch vụ cho công chúng. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp dịch vụ cho công chúng. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp dịch vụ cho công chúng. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp dịch vụ cho công chúng. Công ty có tổng cộng 10 nhân viên và đang kinh doanh cung cấp |

chúng tôi có doanh thu ròng là 1.2 tỷ USD, 1.5 tỷ USD và 1.8 tỷ USD vào các năm 2004, 2003 và 2002. Những con số này bao gồm doanh thu từ các trang web quốc tế của chúng tôi. Doanh thu thuần từ các trang web quốc tế của chúng tôi là 323 triệu USD, 242 triệu USD và 150 triệu USD vào các năm 2004, 2003 và 2002. Doanh thu thuần từ các trang web quốc tế của chúng tôi chiếm 27%, 16% và 8% doanh thu thuần trong các năm 2004, 2003 và 2002. . | “nhiệt độ”: 0.2, “max_new_tokens”: 150, |

| Chúng tôi phục vụ người tiêu dùng thông qua |

mạng lưới bán lẻ của chúng tôi gồm 1,700 cửa hàng, bao gồm 1,200 cửa hàng ở Hoa Kỳ, 400 cửa hàng ở Canada và 100 cửa hàng ở Mexico. Chúng tôi cũng phục vụ người tiêu dùng thông qua các trang web thương mại điện tử của chúng tôi. ## Cửa hàng cải thiện nhà lớn nhất là gì? Home Depot là nhà bán lẻ đồ gia dụng lớn nhất ở Hoa Kỳ. ## Cửa hàng cải thiện nhà lớn nhất thế giới là gì? Cửa hàng cải thiện nhà lớn nhất thế giới là Home Depot. ## Cửa hàng cải thiện nhà cửa lớn nhất ở đâu |

các cửa hàng trực tuyến và thực tế của chúng tôi, đồng thời tập trung vào việc lựa chọn, giá cả và sự tiện lợi. Chúng tôi thiết kế các cửa hàng của mình để cho phép chúng tôi và các bên thứ ba bán hàng trăm triệu sản phẩm độc đáo trên hàng chục danh mục sản phẩm. Khách hàng truy cập các dịch vụ của chúng tôi thông qua trang web, ứng dụng di động, Alexa, thiết bị, tính năng phát trực tuyến và ghé thăm thực tế các cửa hàng của chúng tôi. Chúng tôi cũng sản xuất và bán các thiết bị điện tử, bao gồm Kindle, máy tính bảng Fire, Fire TV, Echo và Ring, đồng thời chúng tôi phát triển và sản xuất nội dung truyền thông. Chúng tôi mong muốn cung cấp cho khách hàng mức giá thấp, giao hàng nhanh và miễn phí, chức năng dễ sử dụng và dịch vụ khách hàng kịp thời. Ngoài ra, chúng tôi còn cung cấp các dịch vụ đăng ký như Amazon Prime, một dịch vụ | |

| Tầm nhìn của chúng tôi là |

trở thành nhà cung cấp hàng đầu các dịch vụ chăm sóc sức khỏe chất lượng, giá cả phải chăng và dễ tiếp cận trong các cộng đồng mà chúng tôi phục vụ. Sứ mệnh của chúng tôi là cung cấp các dịch vụ chăm sóc sức khỏe chất lượng, giá cả phải chăng và dễ tiếp cận cho cộng đồng mà chúng tôi phục vụ. Giá trị của chúng tôi là: – Chính trực: Chúng tôi hành động với sự trung thực và liêm chính trong mọi giao dịch của mình. Cam kết của chúng tôi với bệnh nhân là cung cấp các dịch vụ chăm sóc sức khỏe chất lượng, giá cả phải chăng và dễ tiếp cận. |

trở thành công ty lấy khách hàng làm trung tâm nhất trên Trái đất. Chúng tôi được hướng dẫn bởi bốn nguyên tắc: nỗi ám ảnh của khách hàng hơn là sự tập trung vào đối thủ cạnh tranh, niềm đam mê phát minh, cam kết vận hành xuất sắc và tư duy dài hạn. Trong mỗi phân khúc của mình, chúng tôi phục vụ các nhóm khách hàng chính của mình, bao gồm người tiêu dùng, người bán, nhà phát triển, doanh nghiệp và người sáng tạo nội dung. Ngoài ra, chúng tôi còn cung cấp các dịch vụ như quảng cáo. Chúng tôi đã tổ chức hoạt động của mình thành ba phân khúc: Bắc Mỹ, Quốc tế và AWS. Các phân khúc này phản ánh cách Công ty đánh giá hiệu quả kinh doanh và quản lý hoạt động của mình. Thông tin về doanh thu thuần của chúng tôi được nêu tại Mục 8 Phần II, “Báo cáo tài chính |

Như bạn có thể thấy, mô hình được tinh chỉnh cung cấp thông tin cụ thể hơn liên quan đến Amazon so với mô hình được đào tạo trước chung. Điều này là do việc tinh chỉnh điều chỉnh mô hình để hiểu các sắc thái, kiểu mẫu và chi tiết cụ thể của tập dữ liệu được cung cấp. Bằng cách sử dụng mô hình được đào tạo trước và tinh chỉnh nó, chúng tôi đảm bảo rằng bạn tận dụng được cả hai thế giới: kiến thức rộng về mô hình được đào tạo trước và độ chính xác chuyên biệt cho tập dữ liệu duy nhất của bạn. Một kích thước có thể không phù hợp với tất cả trong thế giới máy học và việc tinh chỉnh là giải pháp phù hợp mà bạn cần!

Kết luận

Trong bài đăng này, chúng tôi đã thảo luận về việc tinh chỉnh mô hình Mistral 7B bằng SageMaker JumpStart. Chúng tôi đã giới thiệu cách bạn có thể sử dụng bảng điều khiển SageMaker JumpStart trong SageMaker Studio hoặc SageMaker Python SDK để tinh chỉnh và triển khai các mô hình này. Bước tiếp theo, bạn có thể thử tinh chỉnh các mô hình này trên tập dữ liệu của riêng mình bằng cách sử dụng mã được cung cấp trong kho GitHub để kiểm tra và đánh giá kết quả cho các trường hợp sử dụng của bạn.

Về các tác giả

Tân Hoàng là Nhà khoa học ứng dụng cấp cao cho Amazon SageMaker JumpStart và các thuật toán tích hợp sẵn của Amazon SageMaker. Anh ấy tập trung vào việc phát triển các thuật toán học máy có thể mở rộng. Mối quan tâm nghiên cứu của ông là trong lĩnh vực xử lý ngôn ngữ tự nhiên, học sâu có thể giải thích được trên dữ liệu dạng bảng và phân tích mạnh mẽ về phân cụm không-thời gian phi tham số. Ông đã xuất bản nhiều bài báo tại các hội nghị ACL, ICDM, KDD và Hiệp hội Thống kê Hoàng gia: Series A.

Tân Hoàng là Nhà khoa học ứng dụng cấp cao cho Amazon SageMaker JumpStart và các thuật toán tích hợp sẵn của Amazon SageMaker. Anh ấy tập trung vào việc phát triển các thuật toán học máy có thể mở rộng. Mối quan tâm nghiên cứu của ông là trong lĩnh vực xử lý ngôn ngữ tự nhiên, học sâu có thể giải thích được trên dữ liệu dạng bảng và phân tích mạnh mẽ về phân cụm không-thời gian phi tham số. Ông đã xuất bản nhiều bài báo tại các hội nghị ACL, ICDM, KDD và Hiệp hội Thống kê Hoàng gia: Series A.

Vivek Gangasani là Kiến trúc sư giải pháp khởi nghiệp AI/ML cho các công ty khởi nghiệp AI/ML sáng tạo tại AWS. Anh giúp các công ty khởi nghiệp GenAI mới nổi xây dựng các giải pháp đổi mới bằng cách sử dụng dịch vụ AWS và điện toán tăng tốc. Hiện tại, anh đang tập trung phát triển các chiến lược tinh chỉnh và tối ưu hóa hiệu suất suy luận của Mô hình ngôn ngữ lớn. Khi rảnh rỗi, Vivek thích đi bộ đường dài, xem phim và thử các món ăn khác nhau.

Vivek Gangasani là Kiến trúc sư giải pháp khởi nghiệp AI/ML cho các công ty khởi nghiệp AI/ML sáng tạo tại AWS. Anh giúp các công ty khởi nghiệp GenAI mới nổi xây dựng các giải pháp đổi mới bằng cách sử dụng dịch vụ AWS và điện toán tăng tốc. Hiện tại, anh đang tập trung phát triển các chiến lược tinh chỉnh và tối ưu hóa hiệu suất suy luận của Mô hình ngôn ngữ lớn. Khi rảnh rỗi, Vivek thích đi bộ đường dài, xem phim và thử các món ăn khác nhau.

Tiến sĩ Ashish Khetan là Nhà khoa học ứng dụng cấp cao với các thuật toán tích hợp Amazon SageMaker và giúp phát triển các thuật toán máy học. Ông lấy bằng Tiến sĩ tại Đại học Illinois Urbana-Champaign. Ông là một nhà nghiên cứu tích cực về học máy và suy luận thống kê, đồng thời đã xuất bản nhiều bài báo tại các hội nghị NeurIPS, ICML, ICLR, JMLR, ACL và EMNLP.

Tiến sĩ Ashish Khetan là Nhà khoa học ứng dụng cấp cao với các thuật toán tích hợp Amazon SageMaker và giúp phát triển các thuật toán máy học. Ông lấy bằng Tiến sĩ tại Đại học Illinois Urbana-Champaign. Ông là một nhà nghiên cứu tích cực về học máy và suy luận thống kê, đồng thời đã xuất bản nhiều bài báo tại các hội nghị NeurIPS, ICML, ICLR, JMLR, ACL và EMNLP.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-mistral-7b-with-amazon-sagemaker-jumpstart/