高速 5G モバイル ネットワークの出現により、企業はこれまで以上に簡単に、通信ネットワークとクラウドの融合を活用する機会を得られるようになりました。 これまでで最も顕著なユース ケースの XNUMX つとして、エッジでの機械学習 (ML) により、企業は ML モデルをエンド カスタマーの近くにデプロイして、レイテンシを短縮し、アプリケーションの応答性を向上させることができました。 例として、 スマート会場ソリューション オンプレミスのハードウェア ネットワーク機器への投資を最小限に抑えながら、ほぼリアルタイムのコンピューター ビジョンを使用して 5G ネットワークを介した群衆分析を行うことができます。 小売業者は、自然言語処理 (NLP)、リアルタイム レコメンデーション システム、および不正検出を使用して、外出先でよりスムーズなエクスペリエンスを提供できます。 平 地上および空中ロボット工学 ML を使用して、より安全で自律的な運用を実現できます。

エッジでの ML への参入障壁を減らすために、事前にトレーニングされたモデルをデプロイする例を示したかったのです。 アマゾンセージメーカー 〜へ AWSの波長、すべて 100 行未満のコードで。 この投稿では、SageMaker モデルを AWS Wavelength にデプロイして、5G ネットワークベースのアプリケーションのモデル推論レイテンシーを削減する方法を示します。

ソリューションの概要

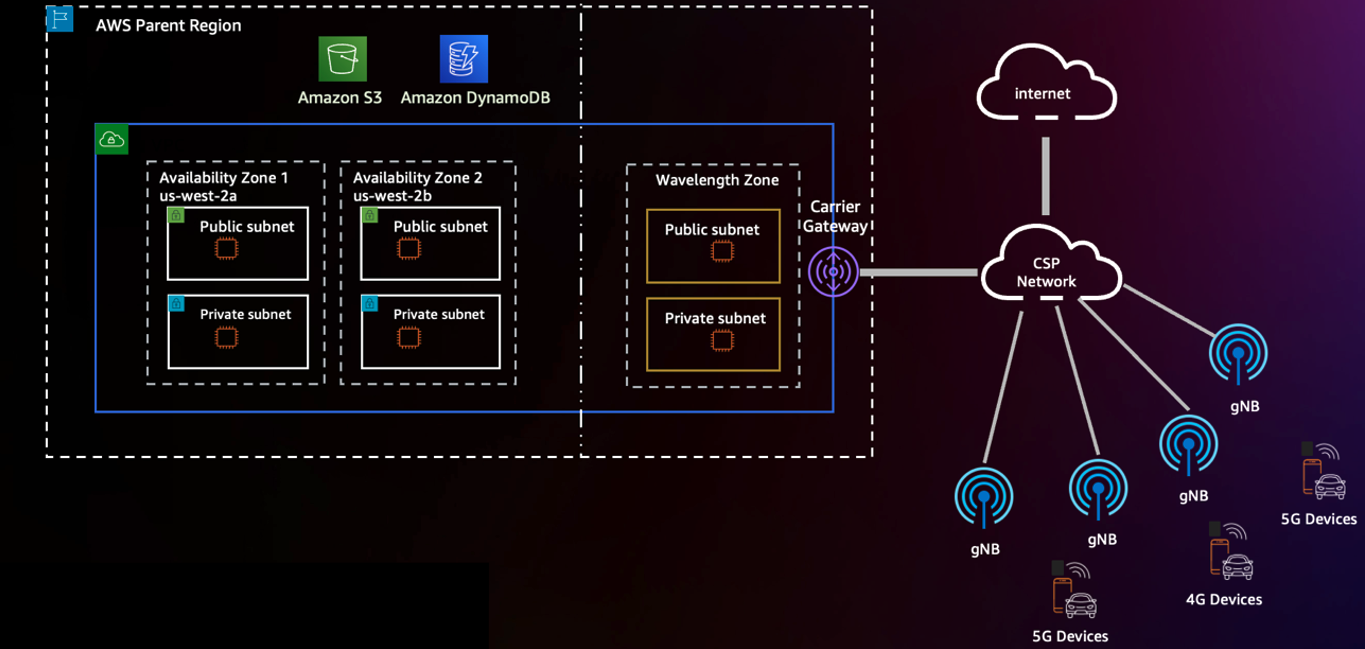

AWS の急速に拡大するグローバル インフラストラクチャ全体で、AWS Wavelength はクラウド コンピューティングとストレージのパワーを 5G ネットワークのエッジにもたらし、よりパフォーマンスの高いモバイル エクスペリエンスを解き放ちます。 AWS Wavelength を使用すると、仮想プライベート クラウド (VPC) を通信事業者のネットワーク エッジに対応する Wavelength Zone に拡張できます。 29の都市 世界中。 次の図は、このアーキテクチャの例を示しています。

を介して、特定のリージョン内の Wavelength Zone にオプトインできます。 AWSマネジメントコンソール または AWSコマンドラインインターフェイス (AWS CLI)。 AWS Wavelength で地理的に分散されたアプリケーションをデプロイする方法の詳細については、次を参照してください。 地理的に分散された Amazon EKS クラスターを AWS Wavelength にデプロイする.

この投稿で説明した基礎に基づいて、AWS Wavelength にデプロイするためのサンプル ワークロードとして、エッジでの ML に注目します。 サンプル ワークロードとして、事前トレーニング済みのモデルをデプロイします。 Amazon SageMaker ジャンプスタート.

SageMaker は、開発者が ML モデルを AWS 環境に簡単にデプロイできるようにするフルマネージド ML サービスです。 AWS はモデル トレーニングのオプションを多数提供していますが、 AWS Marketplace モデルと SageMaker 組み込みアルゴリズム — オープンソースの ML モデルをデプロイするための多くの手法があります。

JumpStart は、SageMaker エンドポイントにシームレスにデプロイできる事前トレーニング済みモデルを使用して、何百もの組み込みアルゴリズムへのアクセスを提供します。 予知保全やコンピュータ ビジョンから自動運転や不正検出まで、JumpStart は、コンソールでのワンクリック展開で、さまざまな一般的なユース ケースをサポートします。

SageMaker は Wavelength Zone でネイティブにサポートされていないため、モデルのアーティファクトをリージョンから抽出し、エッジに再デプロイする方法を示します。 これを行うには、次を使用します Amazon Elastic Kubernetesサービス Wavelength Zone 内の (Amazon EKS) クラスターとノード グループ。続いて、JumpStart によって生成されたコンテナー イメージを使用してデプロイ マニフェストを作成します。 次の図は、このアーキテクチャを示しています。

前提条件

これをできるだけ簡単にするために、AWS アカウントで Wavelength Zone が有効になっていることを確認してください。 この統合は、 us-east-1 & us-west-2を使用します。 us-east-1 デモの期間中。

AWS Wavelength にオプトインするには、次の手順を完了します。

- Amazon VPCコンソールで、 ゾーン 下 設定 選択して 米国東部 (Verizon) / us-east-1-wl1.

- 選択する 管理 .

- 選択 オプトイン.

- 選択する ゾーンを更新する.

AWS Wavelength インフラストラクチャを作成する

ローカル SageMaker モデル推論エンドポイントを Kubernetes デプロイメントに変換する前に、Wavelength Zone に EKS クラスターを作成できます。 これを行うには、AWS Wavelength ノード グループを使用して Amazon EKS クラスターをデプロイします。 詳細については、次の URL をご覧ください。 AWS Containers ブログのこのガイド or Verizon の 5GEdgeTutorials リポジトリ そのような例のXNUMXつです。

次に、 AWS クラウド9 環境またはインタラクティブな開発環境 (IDE) を選択し、必要な SageMaker パッケージをダウンロードして、 ドッカーの作成、JumpStart の重要な依存関係です。

JumpStart を使用してモデル アーティファクトを作成する

まず、あなたが持っていることを確認してください AWS IDおよびアクセス管理 (IAM) SageMaker の実行ロール。 詳細については、次の URL をご覧ください。 SageMakerの役割.

- 使い方 この例、SageMaker ソフトウェア開発キット (SDK) を使用してビルド済みモデルを取得する train_model.py というファイルを作成します ( SageMaker 実行ロールの Amazon リソースネーム (ARN) に置き換えます)。 このファイルでは、

instance_typeの属性model.deploy()関数は、定義したすべての必要なモデル アーティファクトを使用して、IDE 内で Docker コンテナーを開始します。

- 次に、設定します

infer_model_idを、使用したい SageMaker モデルの ID に置き換えます。

完全なリストについては、を参照してください。 事前トレーニング済みのモデル テーブルを使用した組み込みアルゴリズム. この例では、自然言語処理に一般的に使用される BERT (Bidirectional Encoder Representations from Transformers) モデルを使用します。

- 実行する

train_model.pyスクリプトを使用して JumpStart モデル アーティファクトを取得し、事前トレーニング済みのモデルをローカル マシンにデプロイします。

このステップが成功すると、出力は次のようになります。

出力には、次の XNUMX つのアーティファクトが順番に表示されます。TensorFlow 推論のベース イメージ、モデルを提供する推論スクリプト、トレーニング済みモデルを含むアーティファクトです。 これらのアーティファクトを使用してカスタム Docker イメージを作成することもできますが、別の方法として、SageMaker ローカル モードで Docker イメージを作成することもできます。 以降の手順では、ローカルで実行されているコンテナー イメージを抽出し、デプロイします。 Amazon エラスティック コンテナ レジストリ (Amazon ECR) だけでなく、モデル アーティファクトを個別にプッシュして Amazon シンプル ストレージ サービス (Amazon S3)。

ローカル モード アーティファクトをリモート Kubernetes デプロイメントに変換する

SageMaker がローカルで動作していることを確認したので、実行中のコンテナからデプロイ マニフェストを抽出しましょう。 次の手順を完了します。

SageMaker ローカル モードのデプロイ マニフェストの場所を特定します。これを行うには、ルート ディレクトリで次の名前のファイルを検索します。 docker-compose.yaml.

docker_manifest=$( find /tmp/tmp* -name "docker-compose.yaml" -printf '%T+ %pn' | sort | tail -n 1 | cut -d' ' -f2-)

echo $docker_manifestSageMaker ローカル モード モデル アーティファクトの場所を特定する: 次に、アーティファクトを Amazon s3 にアップロードした後、各 EKS ワーカー ノードで使用される、ローカルの SageMaker 推論コンテナーにマウントされた基礎となるボリュームを見つけます。

model_local_volume = $(grep -A1 -w "volumes:" $docker_manifest | tail -n 1 | tr -d ' ' | awk -F: '{print $1}' | cut -c 2-) # Returns something like: /tmp/tmpcr4bu_a7</p>実行中の SageMaker 推論コンテナーのローカル コピーを作成する: 次に、機械学習推論モデルを実行している現在実行中のコンテナー イメージを見つけて、コンテナーのコピーをローカルに作成します。 これにより、Amazon ECR からプルするコンテナ イメージの独自のコピーが確保されます。

# Find container ID of running SageMaker Local container

mkdir sagemaker-container

container_id=$(docker ps --format "{{.ID}} {{.Image}}" | grep "tensorflow" | awk '{print $1}')

# Retrieve the files of the container locally

docker cp $my_container_id:/ sagemaker-container/行動する前に model_local_volumeこれを Amazon S3 にプッシュし、実行中の Docker イメージのコピーをプッシュします。 sagemaker-container ディレクトリ、Amazon Elastic Container Registry へ。 必ず交換してください region, aws_account_id, docker_image_id & my-repository:tag またはに従ってください Amazon ECR ユーザーガイド. また、最終的な ECR イメージ URL (aws_account_id.dkr.ecr.region.amazonaws.com/my-repository:tag)、これを EKS デプロイで使用します。

推論エンドポイントに対応する ECR イメージができたので、新しい Amazon S3 バケットを作成し、SageMaker Local アーティファクトをコピーします (model_local_volume) をこのバケットに追加します。 並行して、バケット内のオブジェクトを読み取るための Amazon EC2 インスタンス アクセスを提供する Identity Access Management (IAM) を作成します。 必ず交換してください Amazon S3 バケットにグローバルに一意の名前を付けます。

次に、各 EC2 インスタンスが起動時にモデル アーティファクトのコピーを取得するように、EKS ワーカー ノードのユーザー データを編集します。 ユーザー データ スクリプトで、各ノードが起動時に S3 API を使用してモデル アーティファクトを取得するようにします。 必ず交換してください Amazon S3 バケットにグローバルに一意の名前を付けます。 ノードのユーザー データに EKS ブートストラップ スクリプトも含まれている場合、完全なユーザー データは次のようになります。

これで、既存の docker マニフェストを検査し、それを Kubernetes に適したマニフェスト ファイルに変換できます。 コンポゼ、有名な変換ツールです。 注: バージョンの互換性エラーが発生した場合は、 version docker-compose.yml の 27 行目の属性を “2”.

Kompose を実行すると、次の XNUMX つの新しいファイルが表示されます。 Deployment オブジェクト、 Service オブジェクト、 PersistentVolumeClaim オブジェクト、および NetworkPolicy 物体。 これで、エッジで Kubernetes への進出を開始するために必要なものがすべて揃いました!

SageMaker モデルアーティファクトをデプロイする

kubectl と aws-iam-authenticator が AWS Cloud9 IDE にダウンロードされていることを確認してください。 そうでない場合は、インストール ガイドに従ってください。

ここで、次の手順を完了します。

修正します service/algo-1-ow3nv サービス タイプを切り替えるオブジェクト ClusterIP 〜へ NodePort. この例では、ポート 30,007 を選択しました。 NodePort:

次に、ノードのセキュリティ グループで NodePort を許可する必要があります。 これを行うには、セキュリティ グループ ID を取得し、NodePort を許可リストに登録します。

次に、 algo-1-ow3nv-deployment.yaml マニフェストをマウントする /tmp/model hostPath ディレクトリをコンテナに。 交換 前に作成した ECR イメージを使用します。

Kompose から作成したマニフェスト ファイルを使用して、kubectl を使用して構成をクラスターに適用します。

5G エッジ モデルに接続する

モデルに接続するには、次の手順を実行します。

Amazon EC2 コンソールで、EKS ワーカー ノードのキャリア IP を取得するか、AWS CLI を使用してキャリア IP アドレスを直接クエリします。

これで、キャリア IP アドレスが抽出されたので、NodePort を使用してモデルに直接接続できます。 というファイルを作成します。 invoke.py センチメント アナライザーに対して実行されるテキストベースの入力を提供することで、BERT モデルを直接呼び出して、トーンがポジティブかネガティブかを判断します。

出力は次のようになります。

クリーンアップ

作成されたすべてのアプリケーション リソースを破棄するには、AWS Wavelength ワーカー ノード、EKS コントロール プレーン、および VPC 内で作成されたすべてのリソースを削除します。 さらに、コンテナ イメージをホストするために使用される ECR リポジトリ、SageMaker モデル アーティファクトをホストするために使用される S3 バケット、および sagemaker-demo-app-s3 IAM ポリシー。

まとめ

この投稿では、Amazon EKS と AWS Wavelength を使用して SageMaker モデルをネットワーク エッジにデプロイする新しいアプローチを示しました。 AWS Wavelength での Amazon EKS のベスト プラクティスについては、以下を参照してください。 地理的に分散された Amazon EKS クラスターを AWS Wavelength にデプロイする. また、ジャンプスタートの詳細については、次の Web サイトにアクセスしてください。 Amazon SageMaker JumpStart 開発者ガイド または JumpStart使用可能なモデルテーブル.

著者について

ロバート・ベルソン AWS ワールドワイド テレコム ビジネス ユニットのデベロッパー アドボケイトであり、AWS エッジ コンピューティングを専門としています。 彼は、自動化、ハイブリッド ネットワーキング、およびエッジ クラウドを使用してビジネス上の課題を解決するために、開発者コミュニティおよび大企業の顧客と協力することに重点を置いています。

ロバート・ベルソン AWS ワールドワイド テレコム ビジネス ユニットのデベロッパー アドボケイトであり、AWS エッジ コンピューティングを専門としています。 彼は、自動化、ハイブリッド ネットワーキング、およびエッジ クラウドを使用してビジネス上の課題を解決するために、開発者コミュニティおよび大企業の顧客と協力することに重点を置いています。

モハメド・アルメダール AWS のワールドワイド テレコム ビジネス ユニットのシニア ソリューション アーキテクトです。 彼の主な焦点は、顧客が AWS で Telco および Enterprise IT ワークロードを構築およびデプロイできるようにすることです。 AWS に入社する前は、Mohammed は通信業界で 13 年以上働いており、LTE パケット コア、5G、IMS、WebRTC の分野で豊富な経験を持っています。 Mohammed は、コンコーディア大学で電気通信工学の学士号を取得しています。

モハメド・アルメダール AWS のワールドワイド テレコム ビジネス ユニットのシニア ソリューション アーキテクトです。 彼の主な焦点は、顧客が AWS で Telco および Enterprise IT ワークロードを構築およびデプロイできるようにすることです。 AWS に入社する前は、Mohammed は通信業界で 13 年以上働いており、LTE パケット コア、5G、IMS、WebRTC の分野で豊富な経験を持っています。 Mohammed は、コンコーディア大学で電気通信工学の学士号を取得しています。

エヴァン・クラヴィッツ アマゾンウェブサービスのソフトウェアエンジニアであり、SageMakerJumpStartに取り組んでいます。 彼はニューヨーク市で料理やランニングを楽しんでいます。

エヴァン・クラヴィッツ アマゾンウェブサービスのソフトウェアエンジニアであり、SageMakerJumpStartに取り組んでいます。 彼はニューヨーク市で料理やランニングを楽しんでいます。

ジャスティン・セント・アーナウド IT 業界で 15 年以上の経験を持つ、ベライゾンの公共部門向けソリューション アーキテクトであるアソシエイト ディレクターです。 彼はエッジ コンピューティングと 5G ネットワークの力を熱心に支持しており、これらのテクノロジを活用する革新的なテクノロジ ソリューションの開発の専門家です。 ジャスティンは、クライアントに最先端のソリューションを提供するためにアマゾン ウェブ サービス (AWS) が提供する機能に特に熱心です。 余暇には、ジャスティンは最新のテクノロジー トレンドを把握し、知識と洞察を業界の他のユーザーと共有することを楽しんでいます。

ジャスティン・セント・アーナウド IT 業界で 15 年以上の経験を持つ、ベライゾンの公共部門向けソリューション アーキテクトであるアソシエイト ディレクターです。 彼はエッジ コンピューティングと 5G ネットワークの力を熱心に支持しており、これらのテクノロジを活用する革新的なテクノロジ ソリューションの開発の専門家です。 ジャスティンは、クライアントに最先端のソリューションを提供するためにアマゾン ウェブ サービス (AWS) が提供する機能に特に熱心です。 余暇には、ジャスティンは最新のテクノロジー トレンドを把握し、知識と洞察を業界の他のユーザーと共有することを楽しんでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- Platoblockchain。 Web3メタバースインテリジェンス。 知識の増幅。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/deploy-pre-trained-models-on-aws-wavelength-with-5g-edge-using-amazon-sagemaker-jumpstart/