Hình ảnh của Tác giả

Anthropic gần đây đã tung ra một loạt mô hình AI mới vượt trội hơn cả GPT-4 và Gemini trong các bài kiểm tra điểm chuẩn. Với ngành công nghiệp AI đang phát triển và phát triển nhanh chóng, các mô hình Claude 3 đang có những bước tiến đáng kể với tư cách là bước tiến lớn tiếp theo trong Mô hình ngôn ngữ lớn (LLM).

Trong bài đăng trên blog này, chúng ta sẽ khám phá các tiêu chuẩn hiệu suất của 3 mẫu máy của Claude. Chúng ta cũng sẽ tìm hiểu về API Python mới hỗ trợ tạo phản hồi luồng đơn giản, không đồng bộ và theo luồng, cùng với khả năng thị giác nâng cao của nó.

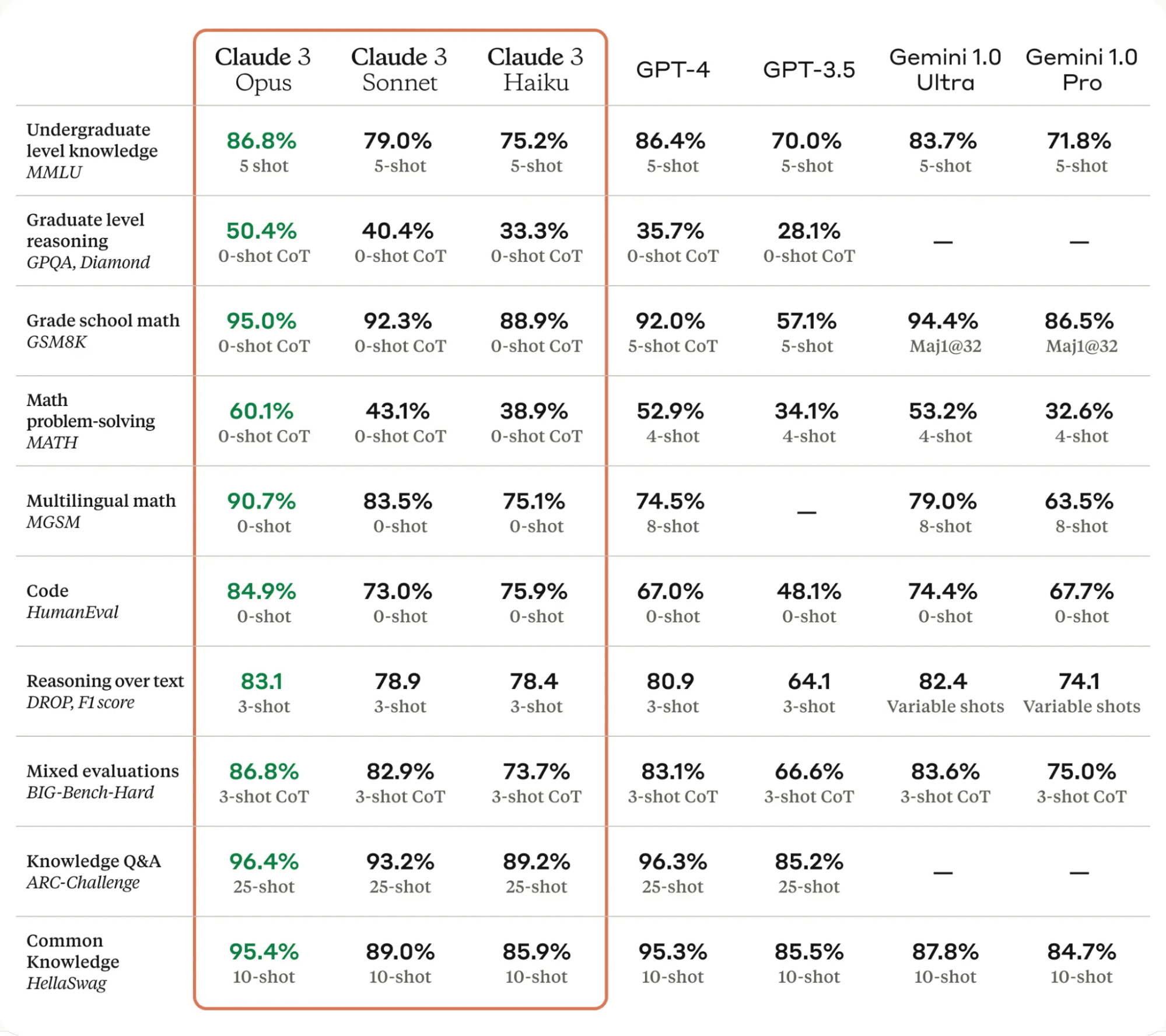

Claude 3, là một bước tiến vượt bậc trong lĩnh vực công nghệ AI. Nó vượt trội hơn các mô hình ngôn ngữ hiện đại trên nhiều tiêu chuẩn đánh giá khác nhau, bao gồm MMLU, GPQA và GSM8K, thể hiện mức độ hiểu và thông thạo gần như con người trong các nhiệm vụ phức tạp.

Mẫu Claude 3 có ba biến thể: Haiku, Sonnet và Opus, mỗi người có khả năng và thế mạnh riêng.

- Haiku là mô hình nhanh nhất và tiết kiệm chi phí nhất, có khả năng đọc và xử lý các tài liệu nghiên cứu dày đặc thông tin trong vòng chưa đầy ba giây.

- Bài thơ mười bốn câu nhanh hơn gấp 2 lần so với Claude 2 và 2.1, hoàn thành xuất sắc các nhiệm vụ đòi hỏi phản hồi nhanh, như truy xuất kiến thức hoặc tự động hóa bán hàng.

- Opus mang lại tốc độ tương tự như Claude 2 và 2.1 nhưng có mức độ thông minh cao hơn nhiều.

Theo bảng bên dưới, Claude 3 Opus vượt trội hơn GPT-4 và Gemini Ultra trên tất cả các điểm chuẩn LLM, khiến nó trở thành công ty dẫn đầu mới trong thế giới AI.

Bảng từ Claude 3

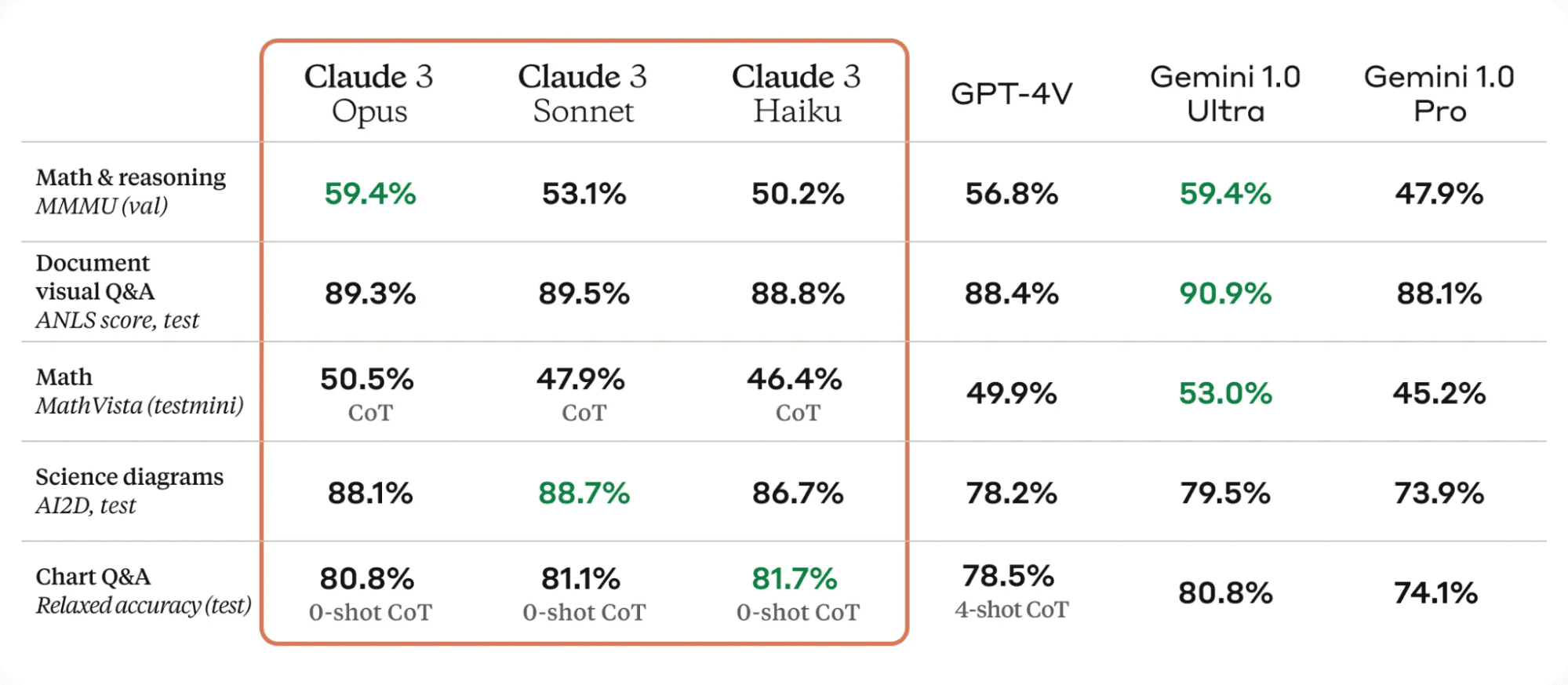

Một trong những cải tiến đáng kể ở mẫu Claude 3 là khả năng quan sát tốt. Họ có thể xử lý nhiều định dạng hình ảnh khác nhau, bao gồm ảnh, biểu đồ, đồ thị và sơ đồ kỹ thuật.

Bảng từ Claude 3

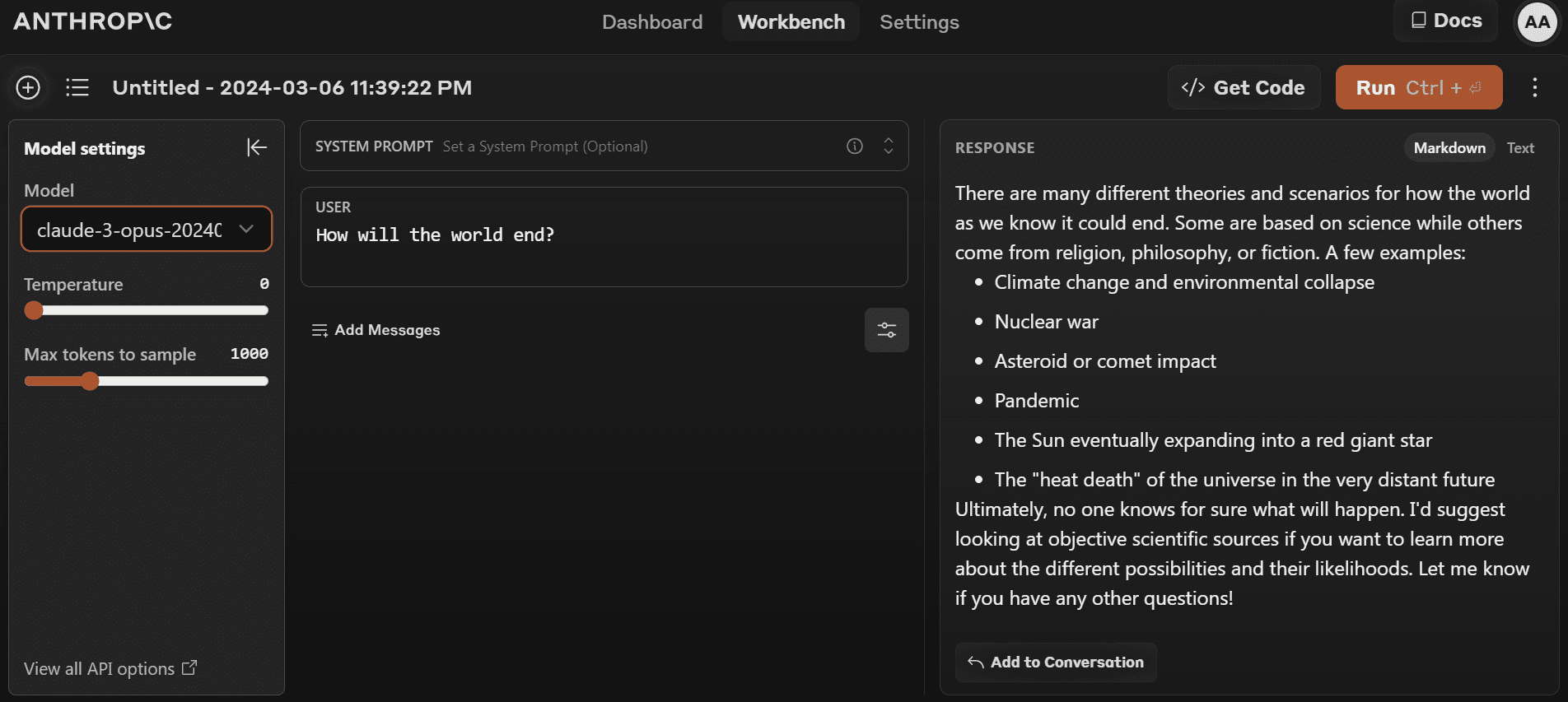

Bạn có thể bắt đầu sử dụng mẫu mới nhất bằng cách truy cập https://www.anthropic.com/claude và tạo một tài khoản mới. Nó khá đơn giản so với sân chơi OpenAI.

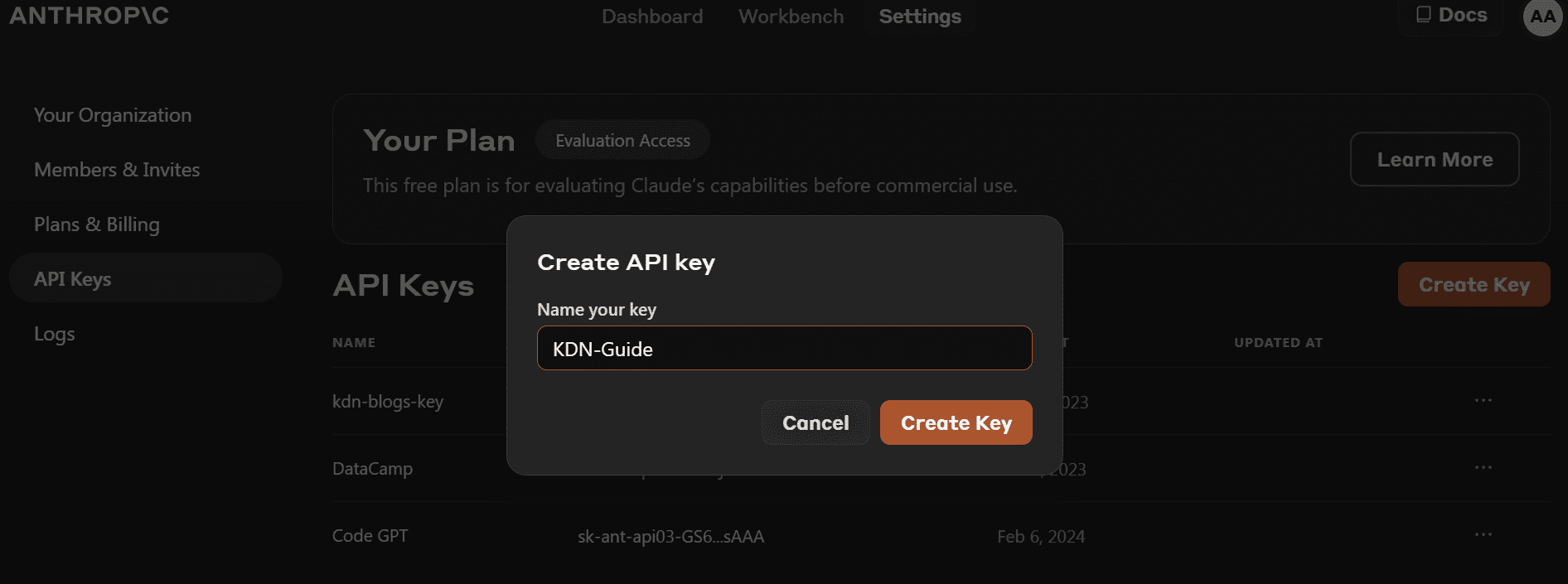

- Trước khi cài đặt Gói Python, chúng ta cần truy cập https://console.anthropic.com/dashboard và lấy khóa API.

- Thay vì cung cấp khóa API trực tiếp để tạo đối tượng máy khách, bạn có thể đặt biến môi trường `ANTHROPIC_API_KEY` và cung cấp biến đó làm khóa.

- Cài đặt gói Python `anthropic` bằng PIP.

pip install anthropic- Tạo đối tượng khách hàng bằng khóa API. Chúng tôi sẽ sử dụng ứng dụng khách để tạo văn bản, truy cập khả năng thị giác và phát trực tuyến.

import os

import anthropic

from IPython.display import Markdown, display

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

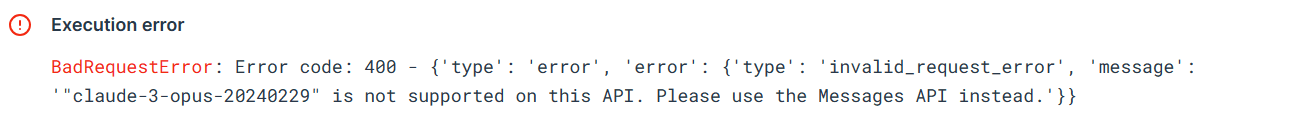

)Hãy thử API Python cũ để kiểm tra xem nó có còn hoạt động hay không. Chúng tôi sẽ cung cấp API hoàn thành với tên mô hình, độ dài mã thông báo tối đa và lời nhắc.

from anthropic import HUMAN_PROMPT, AI_PROMPT

completion = client.completions.create(

model="claude-3-opus-20240229",

max_tokens_to_sample=300,

prompt=f"{HUMAN_PROMPT} How do I cook a original pasta?{AI_PROMPT}",

)

Markdown(completion.completion)Lỗi cho thấy chúng tôi không thể sử dụng API cũ cho model `claude-3-opus-20240229`. Thay vào đó, chúng ta cần sử dụng API Tin nhắn.

Hãy sử dụng API Tin nhắn để tạo phản hồi. Thay vì nhắc nhở, chúng ta phải cung cấp cho đối số messages một danh sách các từ điển chứa vai trò và nội dung.

Prompt = "Write the Julia code for the simple data analysis."

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{"role": "user", "content": Prompt}

]

)

Markdown(message.content[0].text)Sử dụng IPython Markdown sẽ hiển thị phản hồi dưới dạng định dạng Markdown. Có nghĩa là nó sẽ hiển thị các dấu đầu dòng, khối mã, tiêu đề và liên kết một cách rõ ràng.

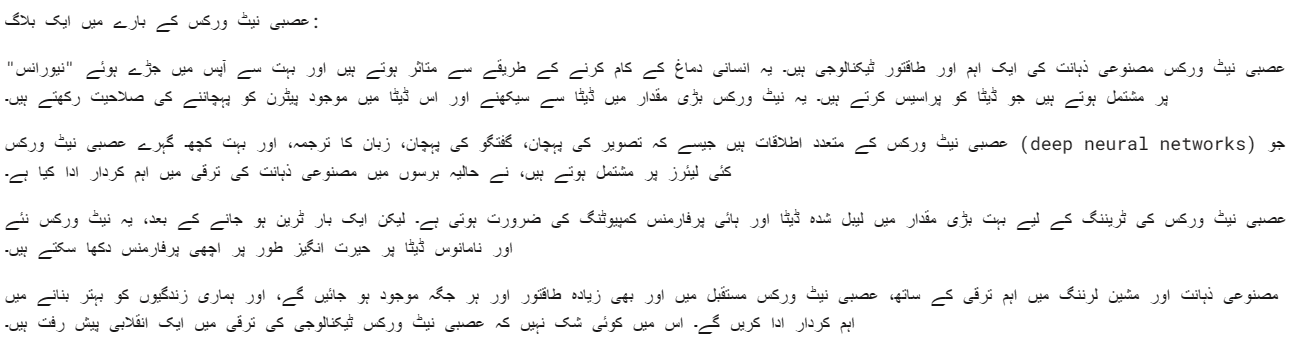

Chúng tôi cũng có thể cung cấp lời nhắc hệ thống để tùy chỉnh phản hồi của bạn. Trong trường hợp của chúng tôi, chúng tôi yêu cầu Claude 3 Opus trả lời bằng tiếng Urdu.

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

Prompt = "Write a blog about neural networks."

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

system="Respond only in Urdu.",

messages=[

{"role": "user", "content": Prompt}

]

)

Markdown(message.content[0].text)Mô hình Opus khá tốt. Ý tôi là tôi có thể hiểu nó khá rõ ràng.

API đồng bộ thực thi các yêu cầu API một cách tuần tự, chặn cho đến khi nhận được phản hồi trước khi thực hiện lệnh gọi tiếp theo. Mặt khác, API không đồng bộ cho phép nhiều yêu cầu đồng thời mà không bị chặn, giúp chúng hiệu quả hơn và có khả năng mở rộng hơn.

- Chúng tôi phải tạo một ứng dụng khách Async Anthropic.

- Tạo chức năng chính với async.

- Tạo phản hồi bằng cú pháp chờ đợi.

- Chạy hàm chính bằng cú pháp chờ đợi.

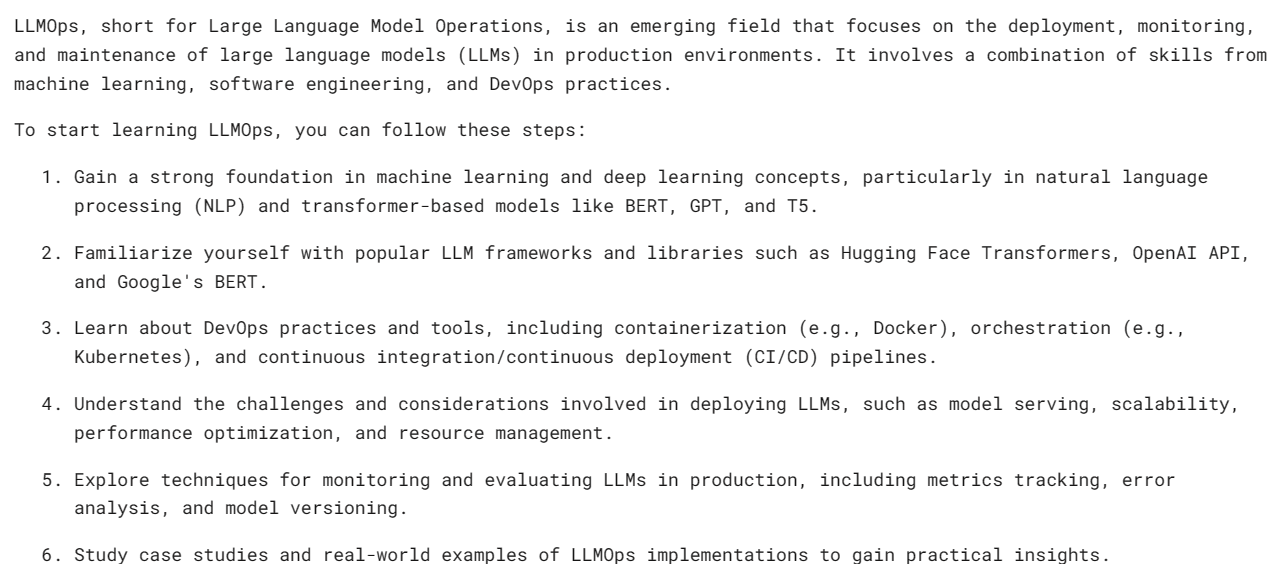

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

async def main() -> None:

Prompt = "What is LLMOps and how do I start learning it?"

message = await client.messages.create(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

display(Markdown(message.content[0].text))

await main()

Lưu ý: Nếu bạn đang sử dụng async trong Notebook Jupyter, hãy thử sử dụng chờ main(), thay vì asyncio.run(main())

Truyền trực tuyến là một cách tiếp cận cho phép xử lý đầu ra của Mô hình ngôn ngữ ngay khi có sẵn mà không cần chờ phản hồi đầy đủ. Phương pháp này giảm thiểu độ trễ nhận thấy bằng cách trả lại mã thông báo đầu ra theo mã thông báo, thay vì tất cả cùng một lúc.

Thay vì `messages.create`, chúng tôi sẽ sử dụng `messages.stream` để truyền phát phản hồi và sử dụng vòng lặp để hiển thị nhiều từ trong phản hồi ngay khi chúng có sẵn.

from anthropic import Anthropic

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

Prompt = "Write a mermaid code for typical MLOps workflow."

completion = client.messages.stream(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

with completion as stream:

for text in stream.text_stream:

print(text, end="", flush=True)Như chúng ta có thể thấy, chúng ta đang tạo ra phản hồi khá nhanh.

Chúng ta cũng có thể sử dụng chức năng không đồng bộ với tính năng phát trực tuyến. Bạn chỉ cần sáng tạo và kết hợp chúng.

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic()

async def main() -> None:

completion = client.messages.stream(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

async with completion as stream:

async for text in stream.text_stream:

print(text, end="", flush=True)

await main()

Claude 3 Vision đã trở nên tốt hơn theo thời gian và để nhận được phản hồi, bạn chỉ cần cung cấp loại hình ảnh base64 cho API tin nhắn.

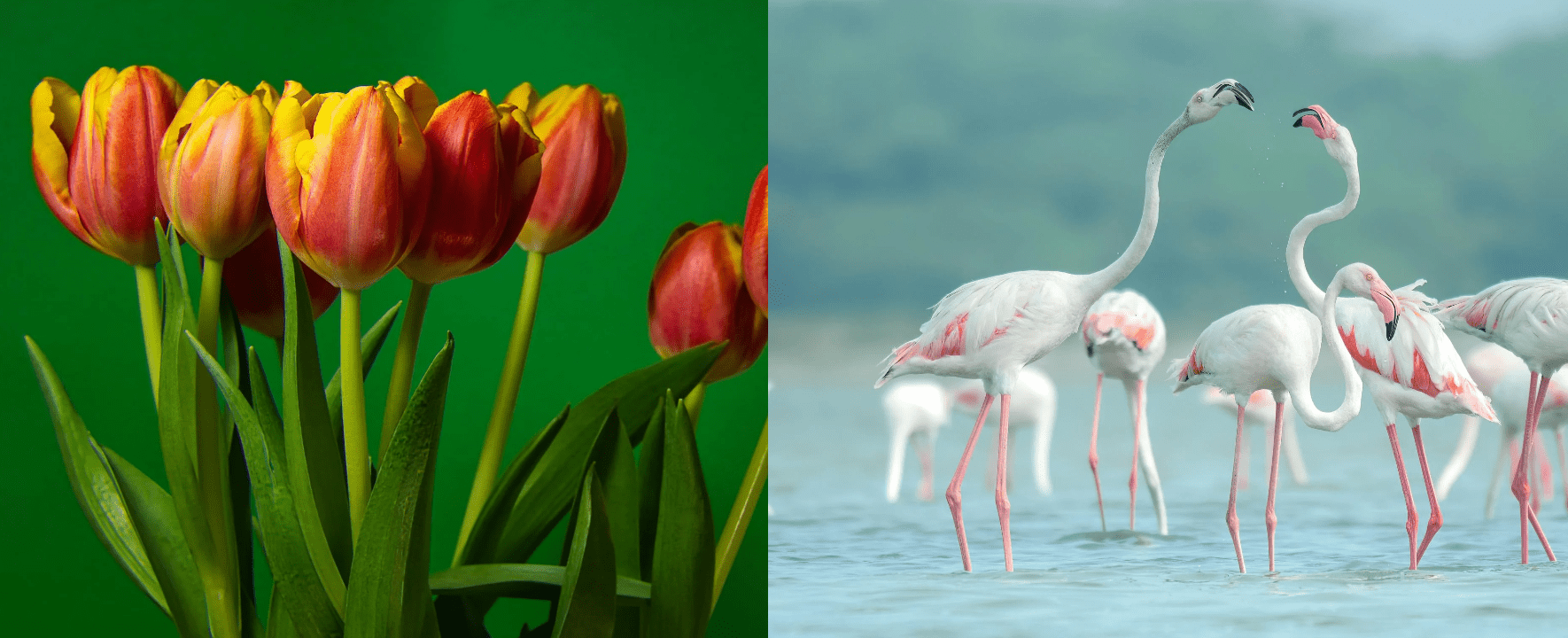

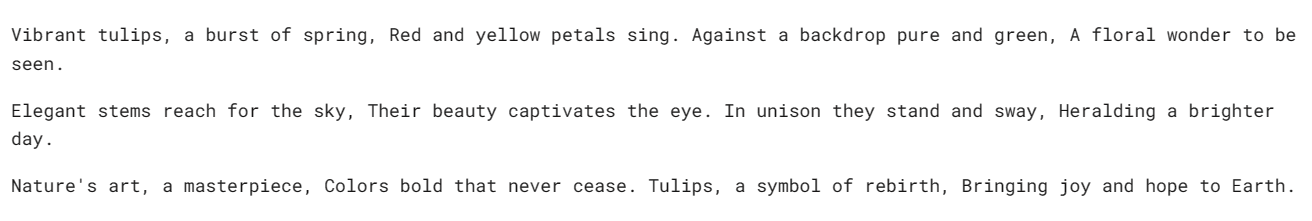

Trong ví dụ này, chúng tôi sẽ sử dụng Hoa tulip (Hình 1) và Chim hồng hạc (Hình 2) ảnh từ Pexel.com để tạo phản hồi bằng cách đặt câu hỏi về hình ảnh.

Chúng tôi sẽ sử dụng thư viện `httpx` để tìm nạp cả hai hình ảnh từ pexel.com và chuyển đổi chúng sang mã hóa base64.

import anthropic

import base64

import httpx

client = anthropic.Anthropic()

media_type = "image/jpeg"

img_url_1 = "https://images.pexels.com/photos/20230232/pexels-photo-20230232/free-photo-of-tulips-in-a-vase-against-a-green-background.jpeg"

image_data_1 = base64.b64encode(httpx.get(img_url_1).content).decode("utf-8")

img_url_2 = "https://images.pexels.com/photos/20255306/pexels-photo-20255306/free-photo-of-flamingos-in-the-water.jpeg"

image_data_2 = base64.b64encode(httpx.get(img_url_2).content).decode("utf-8")Chúng tôi cung cấp hình ảnh được mã hóa base64 cho API tin nhắn trong khối nội dung hình ảnh. Vui lòng làm theo mẫu mã hóa hiển thị bên dưới để tạo phản hồi thành công.

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{

"role": "user",

"content": [

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_1,

},

},

{

"type": "text",

"text": "Write a poem using this image."

}

],

}

],

)

Markdown(message.content[0].text)Chúng tôi có một bài thơ hay về hoa Tulip.

Hãy thử tải nhiều hình ảnh vào cùng một API tin nhắn Claude 3.

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Image 1:"

},

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_1,

},

},

{

"type": "text",

"text": "Image 2:"

},

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_2,

},

},

{

"type": "text",

"text": "Write a short story using these images."

}

],

}

],

)

Markdown(message.content[0].text)Chúng tôi có một câu chuyện ngắn về Vườn Hoa Tulip và Chim Hồng Hạc.

Nếu bạn gặp sự cố khi chạy mã, đây là Không gian làm việc ghi chú sâu nơi bạn có thể tự mình xem lại và chạy mã.

Tôi nghĩ Claude 3 Opus là một mẫu đầy hứa hẹn, mặc dù nó có thể không nhanh bằng GPT-4 và Gemini. Tôi tin rằng người dùng trả phí có thể có tốc độ tốt hơn.

Trong hướng dẫn này, chúng ta đã tìm hiểu về dòng mô hình mới của Anthropic có tên là Claude 3, xem xét điểm chuẩn và kiểm tra khả năng thị giác của nó. Chúng tôi cũng đã học cách tạo phản hồi đơn giản, không đồng bộ và truyền phát. Còn quá sớm để nói liệu đây có phải là LLM tốt nhất hiện nay hay không, nhưng nếu nhìn vào điểm chuẩn kiểm tra chính thức, chúng ta có một vị vua mới trên ngai vàng AI.

Abid Ali Awan (@ 1abidaliawan) là một nhà khoa học dữ liệu chuyên nghiệp được chứng nhận, người yêu thích việc xây dựng các mô hình học máy. Hiện tại, anh đang tập trung sáng tạo nội dung và viết blog kỹ thuật về công nghệ máy học và khoa học dữ liệu. Abid có bằng Thạc sĩ về Quản lý Công nghệ và bằng cử nhân về Kỹ thuật Viễn thông. Tầm nhìn của ông là xây dựng một sản phẩm AI bằng cách sử dụng mạng nơ-ron đồ thị cho những sinh viên đang chống chọi với bệnh tâm thần.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/getting-started-with-claude-3-opus-that-just-destroyed-gpt-4-and-gemini?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-claude-3-opus-that-just-destroyed-gpt-4-and-gemini