차례

- 상위 NLP 인터뷰 질문

- 신입생을 위한 NLP 면접 질문

- 경험자를 위한 NLP 면접 질문

- 13. 다음 중 키워드를 기본 형식으로 변환하는 프로세스인 NLP에서 키워드 정규화에 사용할 수 있는 기술은 무엇입니까?

- 14. 다음 중 NLP에서 두 단어 벡터 사이의 거리를 계산하는 데 사용할 수 있는 기술은 무엇입니까?

- 15. NLP에서 텍스트 코퍼스의 가능한 기능은 무엇입니까?

- 16. 기계 학습 모델에 대한 20K 문서의 입력 데이터에 대한 문서 용어 행렬을 만들었습니다. 다음 중 데이터의 차원을 줄이는 데 사용할 수 있는 것은 무엇입니까?

- 17. NLP에서 명사구 감지, 동사구 감지, 주제 감지 및 객체 감지에 사용할 수 있는 텍스트 구문 분석 기술은 무엇입니까?

- 18. 코사인 유사도를 사용하여 표현된 단어 간의 유사도는 0.5보다 훨씬 높은 값을 갖습니다.

- 19. 다음 중 NLP의 키워드 정규화 기법은 무엇입니까?

- 20. 다음 중 NLP 사용 사례는 무엇입니까?

- 21. N개의 문서 코퍼스에서 무작위로 선택된 하나의 문서에는 총 T개의 용어가 포함되어 있으며 "hello"라는 용어가 K번 나타납니다.

- 22. NLP에서 알고리즘은 일반적으로 사용되는 단어에 대한 가중치를 줄이고 문서 모음에서 많이 사용되지 않는 단어에 대한 가중치를 높입니다.

- 23. NLP에서 "and", "is", "a", "an", "the"와 같은 단어를 문장에서 제거하는 과정을 다음과 같이 부릅니다.

- 24. NLP에서 문장이나 단락을 토큰으로 변환하는 과정을 스테밍(Stemming)이라고 합니다.

- 25. NLP에서 토큰은 신경망에 제공하기 전에 숫자로 변환됩니다.

- 26. 이상한 것을 식별하십시오

- 27. TF-IDF는 당신이 설정하는 데 도움이됩니까?

- 28. NLP에서는 주어진 문장에서 사람, 조직을 식별하는 과정을 단락이라고 합니다.

- 29. 다음 중 NLP의 전처리 기법이 아닌 것은?

- 30. 텍스트 마이닝에서 텍스트를 토큰으로 변환한 다음 정수 또는 부동 소수점 벡터로 변환하는 것은 다음을 사용하여 수행할 수 있습니다.

- 31. NLP에서 벡터로 표현되는 단어를 신경 단어 임베딩(Neural Word Embedding)이라고 합니다.

- 32. NLP에서는 다음 단어 임베딩 중 하나를 사용하여 컨텍스트 모델링을 지원합니다.

- 33. NLP에서 양방향 컨텍스트는 다음 임베딩에 의해 지원됩니다.

- 34. 다음 중 NLP의 특정 주제에 대해 맞춤 학습할 수 있는 Word 임베딩

- 35. 단어 임베딩은 데이터의 여러 차원을 캡처하고 벡터로 표시됩니다.

- 36. NLP에서 Word 임베딩 벡터는 두 토큰 사이의 거리를 설정하는 데 도움이 됩니다.

- 37. 언어 편향은 단어 임베딩 훈련 중에 사용된 과거 데이터로 인해 발생합니다. 다음 중 하나는 편향의 예가 아닙니다.

- 38. 의미론적 유사성, 독해력, 상식 추론과 같은 NLP 사용 사례를 해결하기 위해 다음 중 어느 것이 더 나은 선택입니까?

- 39. 트랜스포머 아키텍처가 처음 소개된 것은?

- 40. 다음 중 더 빠르게 훈련할 수 있고 더 적은 양의 훈련 데이터를 필요로 하는 아키텍처는 무엇입니까?

- 41. ____________로 같은 단어에 여러 단어 임베딩이 가능합니까?

- 42. 주어진 토큰에 대한 입력 표현은 토큰, 세그먼트 및 위치에서 포함된 합계입니다.

- 43. 두 개의 독립적인 LSTM 언어 모델을 왼쪽에서 오른쪽으로, 오른쪽에서 왼쪽으로 훈련하고 얕게 연결합니다.

- 44. 단어 임베딩을 생성하기 위해 단방향 언어 모델을 사용합니다.

- 45. 이 아키텍처에서 문장의 모든 단어 사이의 관계는 위치에 관계없이 모델링됩니다. 이것은 어떤 아키텍처입니까?

- 46. NLP 기술을 사용하여 해결해야 할 10가지 사용 사례를 나열하십시오.

- 47. 트랜스포머 모델은 문장에서 가장 중요한 단어에 주목한다.

- 48. 다음 중 정확도가 가장 좋은 NLP 모델은?

- 49. 순열 언어 모델은

- 50. Transformer XL은 상대 위치 임베딩을 사용합니다.

- 자연어 처리 FAQ

- 1. NLP가 필요한 이유는 무엇입니까?

- 2. 자연어 프로그램은 무엇을 결정해야 합니까?

- 3. NLP는 어디에 유용합니까?

- 4. NLP 면접은 어떻게 준비하나요?

- 5. NLP의 주요 과제는 무엇입니까?

- 6. 어떤 NLP 모델이 최고의 정확도를 제공합니까?

- 7. NLP의 주요 업무는 무엇입니까?

자연어 처리는 기계가 자연어를 이해하고 분석하는 데 도움이 됩니다. NLP는 기계 학습 알고리즘을 적용하여 데이터에서 필요한 정보를 추출하는 데 도움이 되는 자동화된 프로세스입니다. NLP를 학습하면 데이터 사이언티스트 전문가, 머신러닝 엔지니어 등 다양한 전문가가 사용하는 고임금 직업을 얻을 수 있습니다.

다가오는 인터뷰를 준비하는 데 도움이 될 NLP 인터뷰 질문 및 답변의 포괄적인 목록을 작성했습니다. 무료로 확인할 수도 있습니다. NLP 과정 당신의 준비를 돕기 위해. 다음과 같은 자주 묻는 질문을 준비하면 원하는 직무를 맡을 수 있습니다.

상위 NLP 인터뷰 질문

- NLP에서 이 알고리즘을 사용할 수 있는 경우 Naive Bayes 알고리즘은 무엇입니까?

- NLP의 종속성 구문 분석을 설명하시겠습니까?

- 텍스트 요약이란 무엇입니까?

- NLTK는 무엇입니까? 스페이시와 어떻게 다른가요?

- 정보추출이란?

- 단어의 가방이란 무엇입니까?

- NLP의 실용적인 모호성이란 무엇입니까?

- 마스크 언어 모델이란 무엇입니까?

- NLP와 CI(대화형 인터페이스)의 차이점은 무엇입니까?

- 최고의 NLP 도구는 무엇입니까?

더 이상 고민하지 않고 NLP 학습 여정을 시작하겠습니다.

- 신입생을 위한 NLP 면접 질문

- 경험자를 위한 NLP 면접 질문

- 자연어 처리 FAQ

신입생을 위한 NLP 면접 질문

NLP 경력을 시작할 준비가 되셨습니까? 신입생을 위한 자연어 처리 인터뷰 질문으로 전문 경력을 시작하십시오. 우리는 기본부터 시작하여 더 고급 질문으로 넘어갈 것입니다. 숙련된 전문가라면 이 섹션을 통해 NLP 기술을 연마할 수 있습니다.

1. Naive Bayes 알고리즘이란 무엇입니까? NLP에서 이 알고리즘을 언제 사용할 수 있습니까?

나이브 베이즈 알고리즘 베이즈 정리의 원리에 따라 작동하는 분류기의 모음입니다. 이 일련의 NLP 모델은 감정 예측, 스팸 필터링, 문서 분류 등을 포함한 광범위한 분류 작업에 사용할 수 있는 알고리즘 제품군을 형성합니다.

Naive Bayes 알고리즘은 더 빠르게 수렴하고 더 적은 훈련 데이터가 필요합니다. 로지스틱 회귀와 같은 다른 판별 모델과 비교하여 Naive Bayes 모델은 학습하는 데 시간이 덜 걸립니다. 이 알고리즘은 데이터가 동적이고 자주 변경되는 여러 클래스 및 텍스트 분류 작업 시 사용하기에 적합합니다.

2. NLP의 종속성 구문 분석을 설명하시겠습니까?

NLP에서 구문 분석이라고도 하는 종속성 구문 분석은 구문 구조를 문장에 할당하고 종속성 구문 분석을 식별하는 프로세스입니다. 이 과정은 구문 구조에서 "머리" 단어 간의 상관 관계를 이해하는 데 중요합니다.

종속성 구문 분석 프로세스는 문장이 둘 이상의 종속성 구문을 가질 수 있는 방법을 고려하면 약간 복잡할 수 있습니다. 다중 구문 분석 트리는 모호성으로 알려져 있습니다. 종속성 구문 분석은 구문 구조를 문장에 효과적으로 할당하기 위해 이러한 모호성을 해결해야 합니다.

종속성 구문 분석은 구문 구조화와는 별도로 문장의 의미론적 분석에 사용할 수 있습니다.

3. 텍스트 요약이란 무엇입니까?

텍스트 요약 의미와 효과를 그대로 유지하면서 긴 텍스트를 줄이는 과정입니다. 텍스트 요약은 주어진 텍스트에 대한 요약을 만들고 문서의 주요 요점을 설명합니다. 이 기술은 최근에 개선되었으며 많은 양의 텍스트를 성공적으로 요약할 수 있습니다.

기계가 많은 양의 텍스트를 순식간에 요약할 수 있기 때문에 텍스트 요약은 축복이었음이 입증되었습니다. 텍스트 요약에는 두 가지 유형이 있습니다.

- 추출 기반 요약

- 추상화 기반 요약

4. NLTK는 무엇입니까? 스페이시와 어떻게 다른가요?

NLTK 또는 Natural Language Toolkit은 기호 및 통계적 자연어 처리에 사용되는 일련의 라이브러리 및 프로그램입니다. 이 툴킷에는 인간의 언어를 분해하고 이해하기 위해 다양한 ML 기술에서 작동할 수 있는 가장 강력한 라이브러리가 포함되어 있습니다. NLTK는 Lemmatization, Punctuation, Character Count, Tokenization 및 Stemming에 사용됩니다. NLTK와 Spacey의 차이점은 다음과 같습니다.

- NLTK에는 선택할 수 있는 프로그램 모음이 있지만 Spacey에는 해당 툴킷의 문제에 가장 적합한 알고리즘만 포함되어 있습니다.

- NLTK는 Spacey에 비해 더 넓은 범위의 언어를 지원합니다(Spacey는 7개 언어만 지원).

- Spacey에는 객체 지향 라이브러리가 있지만 NLTK에는 문자열 처리 라이브러리가 있습니다.

- Spacey는 단어 벡터를 지원할 수 있지만 NLTK는 지원할 수 없습니다.

자연어 처리의 맥락에서 정보 추출은 구조화되지 않은 소스에서 구조화된 정보를 자동으로 추출하여 의미를 부여하는 기술을 말합니다. 여기에는 엔터티의 속성, 다른 엔터티 간의 관계 등에 관한 정보 추출이 포함될 수 있습니다. 다양한 정보 추출 모델에는 다음이 포함됩니다.

- 태거 모듈

- 관계 추출 모듈

- 사실 추출 모듈

- 엔티티 추출 모듈

- 감정 분석 모듈

- 네트워크 그래프 모듈

- 문서 분류 및 언어 모델링 모듈

6. Bag of Words란 무엇입니까?

단어 가방 분류기를 훈련하기 위해 단어 빈도 또는 발생에 의존하는 일반적으로 사용되는 모델입니다. 이 모델은 문법적 구조나 단어 순서에 관계없이 문서나 문장에 대한 발생 행렬을 생성합니다.

7. NLP의 실용적인 모호성이란 무엇입니까?

화용적 모호성은 하나 이상의 의미를 갖는 단어를 말하며 어떤 문장에서든 그 단어의 사용은 전적으로 문맥에 따라 달라질 수 있습니다. 화용적 모호성은 동일한 문장에 대한 여러 해석을 초래할 수 있습니다. 종종 우리는 여러 의미를 가진 단어를 포함하는 문장을 접하게 되어 문장을 해석의 여지가 있게 만듭니다. 이러한 다중 해석은 모호성을 유발하며 NLP에서 Pragmatic ambiguity로 알려져 있습니다.

8. 마스크 언어 모델이란 무엇입니까?

마스크 언어 모델은 학습자가 손상된 입력에서 출력을 가져와 다운스트림 작업의 심층 표현을 이해하는 데 도움이 됩니다. 이 모델은 종종 문장에서 사용될 단어를 예측하는 데 사용됩니다.

9. NLP와 CI(대화형 인터페이스)의 차이점은 무엇입니까?

NLP와 CI의 차이점은 다음과 같습니다.

| 자연 언어 처리 (NLP) | 대화형 인터페이스(CI) |

|---|---|

| NLP는 기계가 언어 개념이 작동하는 방식을 이해하고 배우도록 돕습니다. | CI는 사용자에게 상호 작용할 인터페이스를 제공하는 데만 중점을 둡니다. |

| NLP는 AI 기술을 사용하여 언어를 통해 사용자의 요청을 식별, 이해 및 해석합니다. | CI는 음성, 채팅, 비디오, 이미지 및 기타 대화 보조 도구를 사용하여 사용자 인터페이스를 만듭니다. |

10. 최고의 NLP 도구는 무엇입니까?

오픈 소스에서 제공하는 최고의 NLP 도구는 다음과 같습니다.

- 스페이시

- 텍스트블롭

- 문자

- 자연어 도구 키트(NLTK)

- 다시 텍스트

- NLP.js

- 스탠포드 NLP

- CogcompNLP

11. POS 태깅이란?

로 더 잘 알려진 품사 태깅 POS 태깅 문서에서 특정 단어를 식별하고 컨텍스트를 기반으로 음성의 일부로 그룹화하는 프로세스를 나타냅니다. POS 태깅은 문법 구조를 이해하고 각 구성 요소를 식별하는 것을 포함하기 때문에 문법 태깅이라고도 합니다.

POS 태깅은 같은 단어가 문맥에 따라 품사가 다를 수 있기 때문에 복잡한 과정입니다. 단어 매핑에 사용되는 동일한 일반 프로세스는 같은 이유로 POS 태깅에 매우 비효율적입니다.

12. NES란 무엇입니까?

이름 엔터티 인식은 NER이 텍스트 문서에서 더 유익하고 고유한 컨텍스트를 가진 특정 엔터티를 식별하는 프로세스이므로 더 일반적으로 알려져 있습니다. 이들은 종종 장소, 사람, 조직 등을 나타냅니다. 이러한 개체가 고유명사인 것처럼 보이지만 NER 프로세스는 명사만을 식별하는 것과는 거리가 멉니다. 사실, NER은 엔티티 청킹 또는 추출을 포함하며 엔티티는 미리 정의된 다른 클래스로 분류하기 위해 분류됩니다. 이 단계는 정보를 추출하는 데 더 도움이 됩니다.

경험자를 위한 NLP 면접 질문

13. 다음 중 키워드를 기본 형식으로 변환하는 프로세스인 NLP에서 키워드 정규화에 사용할 수 있는 기술은 무엇입니까?

ㅏ. 표제어화

비. 사운덱스

씨. 코사인 유사도

디. N-그램

답변 : a)

표제어는 단어의 기본 형태를 파악하는 데 도움이 됩니다(예: are play -> play, eat -> eat 등). 다른 옵션은 다른 용도로 사용됩니다.

14. 다음 중 NLP에서 두 단어 벡터 사이의 거리를 계산하는 데 사용할 수 있는 기술은 무엇입니까?

ㅏ. 표제어화

비. 유클리드 거리

씨. 코사인 유사도

디. N-그램

답변 : b) 및 c)

두 단어 사이의 거리 벡터는 코사인 유사도와 유클리드 거리를 사용하여 계산할 수 있습니다. 코사인 유사도는 두 단어의 벡터 사이에 코사인 각도를 설정합니다. 두 단어 벡터 사이에 서로 가까운 코사인 각도는 단어가 유사하고 그 반대도 마찬가지임을 나타냅니다.

예를 들어 "Football"과 "Cricket"이라는 두 단어 사이의 코사인 각도는 "Football"과 "New Delhi"라는 단어 사이의 각도.

CosineSimlarity 함수를 구현하는 Python 코드는 다음과 같습니다.:

def cosine_similarity(x,y): return np.dot(x,y)/( np.sqrt(np.dot(x,x)) * np.sqrt(np.dot(y,y)) )

q1 = wikipedia.page(‘Strawberry’)

q2 = wikipedia.page(‘Pineapple’)

q3 = wikipedia.page(‘Google’)

q4 = wikipedia.page(‘Microsoft’)

cv = CountVectorizer()

X = np.array(cv.fit_transform([q1.content, q2.content, q3.content, q4.content]).todense())

print (“Strawberry Pineapple Cosine Distance”, cosine_similarity(X[0],X[1]))

print (“Strawberry Google Cosine Distance”, cosine_similarity(X[0],X[2]))

print (“Pineapple Google Cosine Distance”, cosine_similarity(X[1],X[2]))

print (“Google Microsoft Cosine Distance”, cosine_similarity(X[2],X[3]))

print (“Pineapple Microsoft Cosine Distance”, cosine_similarity(X[1],X[3]))

Strawberry Pineapple Cosine Distance 0.8899200413701714

Strawberry Google Cosine Distance 0.7730935582847817

Pineapple Google Cosine Distance 0.789610214147025

Google Microsoft Cosine Distance 0.8110888282851575일반적으로 문서 유사성은 문서의 내용(또는 단어)이 의미적으로 얼마나 가까운지에 의해 측정됩니다. 가까우면 유사성 지수가 1에 가깝고 그렇지 않으면 0에 가깝습니다.

XNUMXD덴탈의 유클리드 거리 두 점 사이의 길이는 두 점을 연결하는 최단 경로의 길이입니다. 일반적으로 삼각형에 대한 피타고라스 정리를 사용하여 계산됩니다.

15. NLP에서 텍스트 말뭉치의 가능한 기능은 무엇입니까?

ㅏ. 문서의 단어 수

비. 단어의 벡터 표기법

씨. 음성 태그의 일부

디. 기본 종속성 문법

이자형. 무엇보다도

답변 : e)

위의 모든 것은 텍스트 코퍼스의 기능으로 사용할 수 있습니다.

16. 기계 학습 모델에 대한 20K 문서의 입력 데이터에 대한 문서 용어 행렬을 만들었습니다. 다음 중 데이터의 차원을 줄이는 데 사용할 수 있는 것은 무엇입니까?

- 키워드 정규화

- 잠재 의미 론적 인덱싱

- 잠재 된 디 리클 렛 할당

ㅏ. 단 1

b. 2, 3

씨. 1, 3

디. 1, 2, 3

답변 : d)

17. NLP에서 명사구 감지, 동사구 감지, 주제 감지 및 객체 감지에 사용할 수 있는 텍스트 구문 분석 기술은 무엇입니까?

ㅏ. 품사 태깅

비. 그램 및 N-그램 추출 건너뛰기

씨. 연속 단어 가방

디. 종속성 구문 분석 및 구성 요소 구문 분석

답변 : d)

18. 코사인 유사도를 사용하여 표현된 단어 간의 유사도는 0.5보다 훨씬 높은 값을 갖습니다.

진실

b. 거짓

답변 : a)

19. 다음 중 NLP의 키워드 정규화 기법은 무엇입니까?

ㅏ. 형태소 분석

비. 품사

씨. 명명된 엔터티 인식

디. 표제어화

답: a) 및 d)

품사(POS) 및 명명된 개체 인식(NER)은 키워드 정규화 기술이 아닙니다. 명명된 엔터티가 도움이 됩니다. 주어진 문장에서 조직, 시간, 날짜, 도시 등의 엔터티 유형을 추출하는 반면 품사는 주어진 문장 토큰에서 명사, 동사, 대명사, 형용사 등을 추출하는 데 도움이 됩니다.

20. 다음 중 NLP 사용 사례는 무엇입니까?

ㅏ. 이미지에서 물체 감지

비. 얼굴 인식

씨. 음성 생체 인식

디. 텍스트 요약

답변: d)

a) 및 b)는 Computer Vision 사용 사례이고 c)는 음성 사용 사례.

d) 텍스트 요약만 NLP 사용 사례입니다.

21. N개의 문서 코퍼스에서 무작위로 선택된 하나의 문서에는 총 T개의 용어가 포함되어 있으며 "hello"라는 용어가 K번 나타납니다.

"hello"라는 용어가 전체 문서의 약 XNUMX/XNUMX에 나타날 경우 TF(용어 빈도)와 IDF(문서 빈도 역)의 곱에 대한 올바른 값은 무엇입니까?

ㅏ. KT * 로그(3)

비. T * 로그(3) / K

씨. K * 로그(3) / T

디. 로그(3) / KT

답변 : (C)

TF의 공식은 K/T입니다.

IDF에 대한 공식은 log(총 문서 / "데이터"를 포함하는 문서 수)입니다.

= 로그(1 / (⅓))

= 로그 (3)

따라서 올바른 선택은 Klog(3)/T입니다.

22. NLP에서 알고리즘은 일반적으로 사용되는 단어에 대한 가중치를 줄이고 문서 모음에서 많이 사용되지 않는 단어에 대한 가중치를 높입니다.

ㅏ. 기간 빈도(TF)

비. 역 문서 빈도(IDF)

씨. Word2Vec

디. 잠재 디리클레 할당(LDA)

답변 : b)

23. NLP에서 "and", "is", "a", "an", "the"와 같은 단어를 문장에서 제거하는 과정을 다음과 같이 부릅니다.

a. 줄기

비. 표제어화

씨. 중지 단어

디. 무엇보다도

Ans : c)

Lemmatization에서는,,, 등과 같은 모든 불용어가 제거됩니다. 제거를 위해 사용자 정의 중지 단어를 정의할 수도 있습니다.

24. NLP에서 문장이나 단락을 토큰으로 변환하는 과정을 스테밍(Stemming)이라고 합니다.

진실

b. 거짓

답변 : b)

이 진술은 형태소 분석이 아닌 토큰화 과정을 설명하므로 False입니다.

25. NLP에서 토큰은 신경망에 제공하기 전에 숫자로 변환됩니다.

a. 참된

b. 거짓

답변 : a)

NLP에서 모든 단어는 신경망에 공급되기 전에 숫자로 변환됩니다.

26. 이상한 것을 식별하십시오

ㅏ. NLTK

비. 사이킷 런

씨. 스페이시

디. 버트

답변 : d)

언급된 것은 모두 단어 임베딩인 BERT를 제외한 NLP 라이브러리입니다..

27. TF-IDF는 당신이 설정하는 데 도움이됩니까?

ㅏ. 문서에서 가장 자주 등장하는 단어

비. 그만큼 문서에서 가장 중요한 단어

답변 : b)

TF-IDF는 문서 코퍼스의 맥락에서 특정 단어가 얼마나 중요한지 설정하는 데 도움이 됩니다. TF-IDF는 단어가 문서에 나타나는 횟수를 고려하고 말뭉치에 나타나는 문서의 수로 상쇄됩니다.

- TF는 용어의 빈도를 문서의 총 용어 수로 나눈 값입니다.

- IDF는 전체 문서 수를 해당 용어를 포함하는 문서 수로 나눈 다음 해당 몫의 로그를 취하여 구합니다.

- Tf.idf는 두 값 TF와 IDF의 곱입니다.

여기에 나열된 것과 같이 단 두 개의 문서로 구성된 말뭉치의 용어 개수 테이블이 있다고 가정합니다.:

| 기간 | 문서 1 빈도 | 문서 2 빈도 |

| 이 | 1 | 1 |

| is | 1 | 1 |

| a | 2 | |

| 견본 | 1 | |

| 다른 | 2 | |

| 예 | 3 |

"this"라는 용어에 대한 tf–idf의 계산은 다음과 같이 수행됩니다.

for "this"

-----------

tf("this", d1) = 1/5 = 0.2

tf("this", d2) = 1/7 = 0.14

idf("this", D) = log (2/2) =0

hence tf-idf

tfidf("this", d1, D) = 0.2* 0 = 0

tfidf("this", d2, D) = 0.14* 0 = 0

for "example"

------------

tf("example", d1) = 0/5 = 0

tf("example", d2) = 3/7 = 0.43

idf("example", D) = log(2/1) = 0.301

tfidf("example", d1, D) = tf("example", d1) * idf("example", D) = 0 * 0.301 = 0

tfidf("example", d2, D) = tf("example", d2) * idf("example", D) = 0.43 * 0.301 = 0.129원시 주파수 형식에서 TF는 각 문서에 대한 "this"의 빈도입니다. 각 문서에서 "this"라는 단어가 한 번 나타납니다. 그러나 문서 2에는 단어가 많을수록 상대적 빈도가 더 적습니다.

IDF는 코퍼스당 일정하며 "this"라는 단어가 포함된 문서의 비율을 설명합니다. 이 경우 두 개의 문서로 구성된 코퍼스가 있으며 모두 "this"라는 단어가 포함되어 있습니다. 따라서 TF-IDF는 "this"라는 단어에 대해 XNUMX입니다. 이는 해당 단어가 모든 문서에 나타나는 것처럼 그다지 유익한 정보가 아님을 의미합니다.

"예시"라는 단어가 더 흥미롭습니다. 세 번 발생하지만 두 번째 문서에서만 나타납니다. NLP에 대해 자세히 알아보려면 다음을 확인하세요. NLP 프로젝트.

28. NLP에서는 주어진 문장에서 사람, 조직을 식별하는 과정을 단락이라고 합니다.

ㅏ. 형태소 분석

비. 표제어화

씨. 단어 제거 중지

디. 명명된 개체 인식

답변 : d)

29. 다음 중 NLP의 전처리 기법이 아닌 것은?

a. 형태소 분석 및 표제어 추출

비. 소문자로 변환

씨. 구두점 제거

디. 중지 단어 제거

이자형. 감정 분석

답변 : e)

감정 분석은 전처리 기술이 아닙니다. 전처리 후 수행되며 NLP 사용 사례입니다. 나열된 다른 모든 항목은 명령문 사전 처리의 일부로 사용됩니다.

30. 텍스트 마이닝에서 텍스트를 토큰으로 변환한 다음 정수 또는 부동 소수점 벡터로 변환하는 것은 다음을 사용하여 수행할 수 있습니다.

ㅏ. CountVectorizer

비. TF-IDF

씨. 단어 가방

디. NER

답변 : a)

CountVectorizer는 위의 작업을 수행하는 데 도움이 되지만 다른 것은 적용할 수 없습니다.

text =["Rahul is an avid writer, he enjoys studying understanding and presenting. He loves to play"]

vectorizer = CountVectorizer()

vectorizer.fit(text)

vector = vectorizer.transform(text)

print(vector.toarray())산출

[[1 1 1 1 2 1 1 1 1 1 1 1 1]]

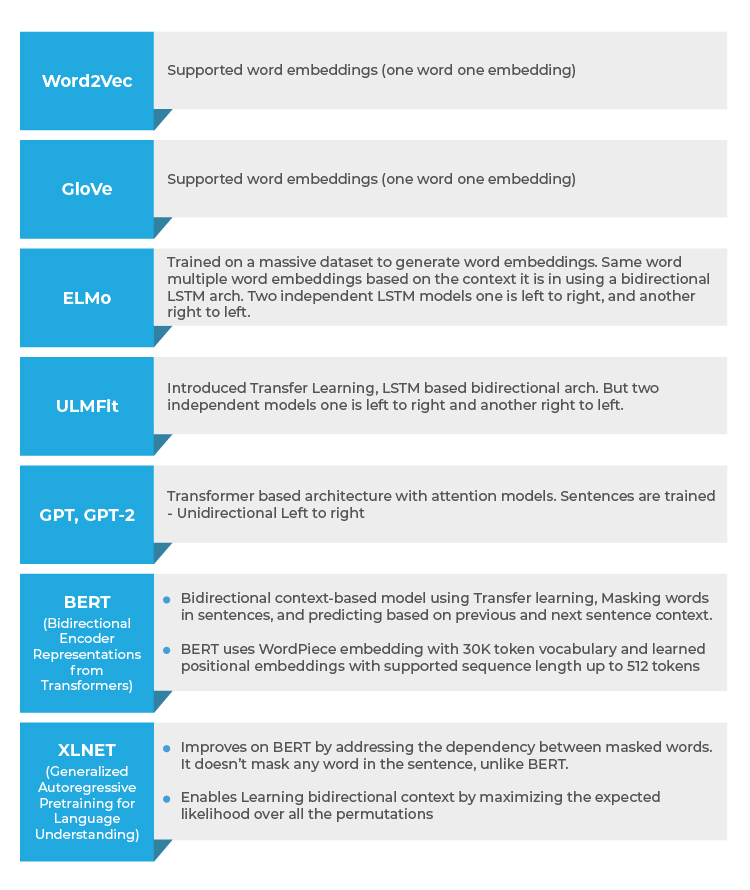

인터뷰 질문의 두 번째 섹션에서는 Word2Vec, GloVe 단어 임베딩과 같은 고급 NLP 기술과 GPT, Elmo, BERT, XLNET 기반과 같은 고급 모델을 다룹니다. 질문과 설명.

31. NLP에서 벡터로 표현되는 단어를 신경 단어 임베딩(Neural Word Embedding)이라고 합니다.

진실

b. 거짓

답변 : a)

Word2Vec, GloVe 기반 모델은 다차원인 단어 임베딩 벡터를 구축합니다.

32. NLP에서는 다음 단어 임베딩 중 하나를 사용하여 컨텍스트 모델링을 지원합니다.

- ㅏ. Word2Vec

- b) 장갑

- 다) 버트

- d) 위의 모든 것

답변 : c)

BERT(Bidirectional Encoder Representations from Transformer)만 이전 및 다음 문장 컨텍스트가 고려되는 컨텍스트 모델링을 지원합니다. Word2Vec에서 GloV는 단어 임베딩만 고려하고 이전 및 다음 문장 컨텍스트는 고려하지 않습니다.

33. NLP에서 양방향 컨텍스트는 다음 임베딩에 의해 지원됩니다.

ㅏ. Word2Vec

비. 버트

씨. 장갑

디. 모든것 위에

답변 : b)

BERT만이 양방향 컨텍스트를 제공합니다. BERT 모델은 컨텍스트에 도달하기 위해 이전 및 다음 문장을 사용합니다. Word2Vec 및 GloVe는 단어 임베딩이며 컨텍스트를 제공하지 않습니다.

34. 다음 중 NLP의 특정 주제에 대해 맞춤 학습할 수 있는 Word 임베딩

ㅏ. Word2Vec

비. 버트

씨. 장갑

디. 모든것 위에

답변 : b)

BERT는 기존의 사전 훈련된 모델에서 Transform Learning을 허용하므로 기존 단어 임베딩을 사용할 수 있는 Word2Vec 및 GloVe와 달리 텍스트에 대한 전이 학습이 가능하지 않고 주어진 특정 주제에 대해 맞춤형 훈련이 가능합니다.

35. 단어 임베딩은 데이터의 여러 차원을 캡처하고 벡터로 표시됩니다.

a. 참된

b. 거짓

답변 : a)

36. NLP에서 Word 임베딩 벡터는 두 토큰 사이의 거리를 설정하는 데 도움이 됩니다.

a. 참된

b. 거짓

답 : a)

코사인 유사도를 사용하여 Word Embeddings를 통해 표현되는 두 벡터 사이의 거리

37. 언어 편향은 단어 임베딩 훈련 중에 사용된 과거 데이터로 인해 발생합니다. 다음 중 하나는 편향의 예가 아닙니다.

ㅏ. 뉴델리는 인도, 베이징은 중국

비. 남자는 컴퓨터, 여자는 주부

답변 : a)

진술 b)는 여성을 주부로 묶기 때문에 편향된 반면 진술 a)는 편향된 진술이 아닙니다.

38. 의미론적 유사성, 독해력, 상식 추론과 같은 NLP 사용 사례를 해결하기 위해 다음 중 어느 것이 더 나은 선택입니까?

a. 엘모

비. AI의 GPT 열기

씨. 울핏

답변 : b)

Open AI의 GPT는 Transformer 모델의 Attention 메커니즘을 사용하여 데이터의 복잡한 패턴을 학습할 수 있으므로 의미론적 유사성, 독해력 및 상식 추론과 같은 복잡한 사용 사례에 더 적합합니다.

39. 트랜스포머 아키텍처가 처음 소개된 것은?

a. 글 로베

비. 버트

씨. AI의 GPT 열기

디. 울핏

답변 : c)

ULMFit에는 LSTM 기반 언어 모델링 아키텍처가 있습니다. 이것은 Open AI의 GPT와 함께 Transformer 아키텍처로 대체되었습니다.

40. 다음 중 더 빠르게 훈련할 수 있고 더 적은 양의 훈련 데이터를 필요로 하는 아키텍처는 무엇입니까?

ㅏ. LSTM 기반 언어 모델링

비. 변압기 아키텍처

답변 : b)

Transformer 아키텍처는 GPT부터 지원되었으며 훈련 속도가 더 빨랐고 훈련에 필요한 데이터 양이 적었습니다.

41. ____________로 같은 단어에 여러 단어 임베딩이 가능합니까?

ㅏ. 장갑

비. Word2Vec

씨. 엘모

디. NLTK

답변 : c)

EMLo 단어 임베딩은 여러 임베딩이 있는 동일한 단어를 지원하므로 다른 컨텍스트에서 동일한 단어를 사용하는 데 도움이 되므로 GloVe 및 Word2Vec과 달리 단어의 의미보다 컨텍스트를 캡처합니다. Nltk는 단어 임베딩이 아닙니다.

42. 주어진 토큰에 대한 입력 표현은 토큰, 세그먼트 및 위치에서 포함된 합계입니다.

임베딩

ㅏ. 엘모

비. GPT

씨. 버트

디. 울핏

답변 : c)

BERT는 토큰, 세그먼트 및 위치 임베딩을 사용합니다.

43. 두 개의 독립적인 LSTM 언어 모델을 왼쪽에서 오른쪽으로, 오른쪽에서 왼쪽으로 훈련하고 얕게 연결합니다..

ㅏ. GPT

비. 버트

씨. 울핏

디. 엘모

답변 : d)

ELMo는 두 개의 독립적인 LSTM 언어 모델(왼쪽에서 오른쪽 및 오른쪽에서 왼쪽)을 훈련하고 결과를 연결하여 단어 임베딩을 생성합니다.

44. 단어 임베딩을 생성하기 위해 단방향 언어 모델을 사용합니다.

ㅏ. 버트

비. GPT

씨. 엘모

디. Word2Vec

답변 : b)

GPT는 양방향 모델 및 워드 임베딩은 왼쪽에서 오른쪽으로 정보 흐름에 대한 교육을 통해 생성됩니다. ELMo는 양방향이지만 얕습니다. Word2Vec은 간단한 단어 임베딩을 제공합니다.

45. 이 아키텍처에서 문장의 모든 단어 사이의 관계는 위치에 관계없이 모델링됩니다. 이것은 어떤 아키텍처입니까?

ㅏ. 오픈AI GPT

비. 엘모

씨. 버트

디. 울핏

Ans : c)

BERT Transformer 아키텍처는 각 단어와 문장의 다른 모든 단어 간의 관계를 모델링하여 주의 점수를 생성합니다. 이러한 주의 점수는 나중에 새로운 표현을 생성하기 위해 완전히 연결된 네트워크에 제공되는 모든 단어 표현의 가중 평균에 대한 가중치로 사용됩니다.

46. NLP 기술을 사용하여 해결해야 할 10가지 사용 사례를 나열하십시오.

- 감정 분석

- 언어 번역(영어에서 독일어로, 중국어에서 영어로 등..)

- 문서 요약

- 질문 답변

- 문장 완성

- 속성 추출(문서에서 핵심 정보 추출)

- 챗봇 상호작용

- 주제 분류

- 의도 추출

- 문법 또는 문장 수정

- 이미지 캡션

- 문서 순위

- 자연어 추론

47. Transformer 모델은 문장에서 가장 중요한 단어에 주의를 기울입니다..

진실

b. 거짓

Ans : a) Transformer 모델의 주의 메커니즘은 모든 단어 간의 관계를 모델링하고 가장 중요한 단어에 가중치를 제공하는 데 사용됩니다.

48. 다음 중 정확도가 가장 좋은 NLP 모델은?

ㅏ. 버트

비. XLNET

씨. GPT-2

디. 엘모

Ans : 나) XLNET

XLNET은 모든 모델 중에서 최고의 정확도를 제공합니다. 20개 작업에서 BERT를 능가했으며 감정 분석, 질문 답변, 자연어 추론 등을 포함한 18개 작업에서 최첨단 결과를 달성했습니다.

49. 순열 언어 모델은

ㅏ. 버트

비. EMMO

씨. GPT

디. XLNET

Ans : d)

XLNET은 순열 기반 언어 모델링을 제공하며 BERT와의 주요 차이점입니다. 순열 언어 모델링에서 토큰은 순차적이 아닌 무작위 방식으로 예측됩니다. 예측 순서는 반드시 왼쪽에서 오른쪽일 필요는 없으며 오른쪽에서 왼쪽일 수도 있습니다. 단어의 원래 순서는 변경되지 않지만 예측은 무작위일 수 있습니다. BERT와 XLNET의 개념적 차이점은 다음 다이어그램에서 확인할 수 있습니다.

50. Transformer XL은 상대 위치 임베딩을 사용합니다.

진실

b. 거짓

Ans : a)

단어의 절대 위치를 나타내야 하는 임베딩 대신 Transformer XL은 임베딩을 사용하여 단어 사이의 상대 거리를 인코딩합니다. 이 임베딩은 전후에 n 단어로 분리될 수 있는 임의의 2개 단어 사이의 주의 점수를 계산하는 데 사용됩니다.

NLP 인터뷰에 대한 모든 가능한 질문이 있습니다. 이제 최선을 다하십시오.

자연어 처리 FAQ

1. NLP가 필요한 이유는 무엇입니까?

NLP가 필요한 주된 이유 중 하나는 컴퓨터가 자연어로 인간과 의사 소통하는 데 도움이 되기 때문입니다. 또한 다른 언어 관련 작업을 확장합니다. NLP 덕분에 컴퓨터는 음성을 듣고, 이 음성을 해석하고, 측정하고, 음성의 어느 부분이 중요한지 결정할 수 있습니다.

2. 자연어 프로그램은 무엇을 결정해야 합니까?

자연어 프로그램은 무엇을 말해야 할지, 언제 말해야 할지 결정해야 합니다.

3. NLP는 어디에 유용합니까?

NLP는 자신의 언어로 인간과 의사 소통하는 데 유용할 수 있습니다. 기계 번역의 효율성을 높이는 데 도움이 되며 감정 분석에도 유용합니다. 에 도움이 될 수 있습니다. 파이썬을 이용한 감정 분석 도. 또한 고도로 비정형 데이터를 구조화하는 데 도움이 됩니다. 챗봇, 텍스트 요약 및 가상 비서를 만드는 데 도움이 될 수 있습니다.

4. NLP 면접은 어떻게 준비하나요?

NLP 면접을 준비하는 가장 좋은 방법은 기본 개념을 명확히 하는 것입니다. 모든 주요 측면을 다루고 중요한 주제를 기억하는 데 도움이 되는 블로그를 살펴보십시오. 인터뷰를 위해 구체적으로 배우고 모든 질문에 대답하면서 자신감을 가지십시오.

5. NLP의 주요 과제는 무엇입니까?

문장을 토큰으로 나누기, 품사 태깅, 컨텍스트 이해, 생성된 어휘의 구성 요소 연결 및 의미론적 의미 추출은 현재 NLP의 주요 과제 중 일부입니다.

6. 어떤 NLP 모델이 최고의 정확도를 제공합니까?

나이브 베이즈 알고리즘은 최고의 정확도 NLP 모델의 경우. 최대 73%의 정확한 예측을 제공합니다.

7. NLP의 주요 업무는 무엇입니까?

번역, 명명된 엔터티 인식, 관계 추출, 감정 분석, 음성 인식 및 주제 세분화는 NLP의 주요 작업 중 일부입니다. 비정형 데이터에는 조직 성장에 도움이 될 수 있는 미개척 정보가 많이 있을 수 있습니다.

8. NLP에서 불용어는 무엇입니까?

문장에 무게를 더하는 문장에서 흔히 나오는 단어를 불용어라고 합니다. 이러한 불용어는 다리 역할을 하며 문장이 문법적으로 올바른지 확인합니다. 간단히 말해서 자연어 데이터를 처리하기 전에 걸러내는 단어를 불용어라고 하며 일반적인 전처리 방식입니다.

9. NLP에서 형태소 분석이란 무엇입니까?

주어진 단어에서 어근을 얻는 과정을 형태소 분석이라고 합니다. 모든 토큰은 효율적이고 잘 일반화된 규칙의 도움으로 어근이나 어간을 얻기 위해 잘라낼 수 있습니다. 이는 규칙 기반 프로세스이며 단순성으로 잘 알려져 있습니다.

10. NLP가 왜 그렇게 어려운가요?

자연어 처리 과정을 어렵게 만드는 몇 가지 요인이 있습니다. 전 세계적으로 수백 가지의 자연어가 있고, 단어의 의미가 모호할 수 있고, 각 자연어마다 스크립트와 구문이 다르며, 단어의 의미는 컨텍스트에 따라 달라질 수 있으므로 NLP 프로세스가 어려울 수 있습니다. 기술을 향상하고 계속 학습하기로 선택하면 시간이 지남에 따라 프로세스가 더 쉬워질 것입니다.

11. NLP 파이프라인은 *로 구성되어 있습니까?

의 전반적인 아키텍처 NLP 파이프라인 구성 여러 계층의: 사용자 인터페이스; 하나 또는 여러 NLP 사용 사례에 따라 모델; 설명하기 위한 자연어 이해 계층 의 의미 단어와 문장; 전처리층; 구성 요소를 함께 연결하기 위한 마이크로서비스는 물론입니다.

12. NLP의 단계는 몇 단계입니까?

NLP의 XNUMX단계는 어휘(구조) 분석, 구문 분석, 의미론적 분석, 담화 통합 및 화용론적 분석을 포함합니다.

추가 읽기

- 2022년 파이썬 인터뷰 질문과 답변

- 2022년 기계 학습 인터뷰 질문 및 답변

- 100가지 가장 일반적인 비즈니스 분석가 인터뷰 질문

- 2022년 인공 지능 인터뷰 질문 | AI 면접 질문

- 100년 데이터 과학 인터뷰 질문 2022개 이상

- 일반적인 면접 질문

- 코인스마트. 유럽 최고의 비트코인 및 암호화폐 거래소.Click Here

- 플라토 블록체인. Web3 메타버스 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 출처: https://www.mygreatlearning.com/blog/nlp-interview-questions/