개요

지도 학습의 목표는 새로운 데이터 세트에서 잘 작동하는 모델을 구축하는 것입니다. 문제는 새로운 데이터가 없을 수도 있지만 열차-테스트-검증 분할과 같은 절차를 통해 이를 경험할 수 있다는 것입니다.

모델이 데이터 세트에서 어떻게 작동하는지 보는 것이 흥미롭지 않나요? 그것은! 헌신적으로 일하는 것의 가장 좋은 측면 중 하나는 효율적인 기계 학습 모델을 만들고 효과적인 결과를 생성하기 위해 올바른 방식으로 노력이 활용되는 것을 보는 것입니다.

열차 테스트 검증 분할이란 무엇입니까?

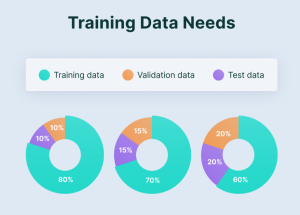

학습-테스트-검증 분할은 기본입니다. 기계 학습 특히 모델 개발 중에 데이터 분석이 가능합니다. 여기에는 데이터세트를 훈련, 테스트, 검증이라는 세 가지 하위 집합으로 나누는 작업이 포함됩니다. 훈련 테스트 분할은 모델이 새로운 데이터 세트로 어떻게 작동하는지 확인할 수 있는 모델 검증 프로세스입니다.

훈련-테스트-검증 분할은 기계 학습 모델이 새로운, 보이지 않는 데이터에 얼마나 잘 일반화되는지 평가하는 데 도움이 됩니다. 또한 모델이 훈련 데이터에서는 잘 작동하지만 새 인스턴스로 일반화하지 못하는 과적합을 방지합니다. 검증 세트를 사용하면 실무자는 모델의 매개변수를 반복적으로 조정하여 보이지 않는 데이터에 대해 더 나은 성능을 얻을 수 있습니다.

기계 학습에서 데이터 분할의 중요성

데이터 분할 데이터 세트를 교육, 검증 및 테스트 하위 집합으로 나누는 작업이 포함됩니다. 기계 학습에서 데이터 분할의 중요성은 다음과 같은 측면을 다룹니다.

교육, 검증 및 테스트

데이터 분할은 데이터 세트를 세 가지 주요 하위 집합, 즉 모델 훈련에 사용되는 훈련 세트로 나눕니다. 모델 매개변수를 추적하고 과적합을 방지하는 데 사용되는 검증 세트 새로운 데이터에 대한 모델 성능을 확인하는 데 사용되는 테스트 세트입니다. 각 하위 집합은 기계 학습 모델을 개발하는 반복 프로세스에서 고유한 목적을 수행합니다.

모델 개발 및 튜닝

모델 개발 단계에서는 알고리즘을 데이터 내의 다양한 패턴에 노출시키기 위해 훈련 세트가 필요합니다. 모델은 이 하위 집합에서 학습하여 매개변수를 조정하여 오류를 최소화합니다. 검증 세트는 하이퍼파라미터 추적 중에 중요하며 모델 구성을 최적화하는 데 도움이 됩니다.

과적합 방지

과적합은 모델이 훈련 데이터를 잘 학습하여 노이즈와 관련 없는 패턴을 포착할 때 발생합니다. 검증 세트는 체크포인트 역할을 하여 과적합을 감지할 수 있습니다. 다양한 데이터 세트에서 모델 성능을 평가함으로써 모델 복잡성, 기술 또는 기타 하이퍼파라미터를 조정하여 과적합을 방지하고 일반화를 강화할 수 있습니다.

성능 평가

테스트 세트는 기계 학습 모델의 성능에 필수적입니다. 훈련 및 검증 후 모델은 실제 시나리오를 확인하는 테스트 세트를 마주하게 됩니다. 테스트 세트에서 잘 수행되는 모델은 새로운, 보이지 않는 데이터에 성공적으로 적응했음을 나타냅니다. 이 단계는 실제 응용 프로그램에 대한 모델 배포에 대한 자신감을 얻는 데 중요합니다.

편향 및 분산 평가

Train Test Validation Split은 편향 균형을 이해하는 데 도움이 됩니다. 훈련 세트는 모델의 편향에 대한 정보를 제공하여 고유한 패턴을 포착하며, 검증 세트와 테스트 세트는 분산을 평가하여 데이터 세트의 변동에 대한 모델의 민감도를 나타내는 데 도움을 줍니다. 다양한 데이터 세트에서 일반화되는 모델을 달성하려면 편향과 분산 사이의 올바른 균형을 유지하는 것이 중요합니다.

견고성을 위한 교차 검증

단순한 학습-검증-테스트 분할 외에도 k-겹 교차 검증과 같은 기술은 모델의 견고성을 더욱 향상시킵니다. 교차 검증에는 데이터세트를 k개의 하위 집합으로 나누고, k-1개의 하위 집합에 대해 모델을 훈련하고, 나머지 하위 집합을 검증하는 작업이 포함됩니다. 이 과정을 k번 반복하고 그 결과를 평균냅니다. 교차 검증을 통해 데이터의 다양한 하위 집합에서 모델 성능을 보다 포괄적으로 이해할 수 있습니다.

모델 성능에서 데이터 분할의 중요성

모델 성능에서 데이터 분할의 중요성은 다음과 같은 목적으로 사용됩니다.

모델 일반화 평가

모델은 훈련 데이터를 기억할 뿐만 아니라 일반화도 잘해야 합니다. 데이터 분할을 사용하면 테스트 세트를 생성하여 모델이 새 데이터에서 얼마나 잘 작동하는지 확인하기 위한 실제 검사를 제공할 수 있습니다. 전용 테스트 세트가 없으면 모델이 훈련 데이터에 너무 가깝게 적응하면 과적합 위험이 증가합니다. 데이터 분할은 모델의 실제 일반화 기능을 평가하여 이러한 위험을 완화합니다.

과적합 방지

과적합은 모델이 더욱 복잡해지고 훈련 데이터에서 노이즈나 특정 패턴을 포착하여 일반화 능력이 저하될 때 발생합니다.

모델 하이퍼파라미터 최적화 모델 추적에는 성능 달성을 위해 하이퍼파라미터를 조정하는 작업이 포함됩니다. 이 프로세스에는 별도의 검증 세트를 통해 수행되는 모델 동작을 기반으로 하는 반복적인 조정이 필요합니다.

강도 평가

강력한 모델은 다양한 데이터 세트와 시나리오에서 일관되게 작동해야 합니다. 데이터 분할, 특히 k-겹 교차 검증은 모델의 견고성을 평가하는 데 도움이 됩니다. 다양한 하위 집합을 훈련하고 검증함으로써 모델이 다양한 데이터 분포에 얼마나 잘 일반화되는지에 대한 통찰력을 얻을 수 있습니다.

편향-분산 균형 관리

데이터에 과적합되지 않는 모델을 개발하려면 편향과 분산 사이의 균형을 맞추는 것이 중요합니다. 데이터 분할을 사용하면 훈련 세트에 대한 모델의 편향과 검증 또는 테스트 세트에 대한 분산을 평가할 수 있습니다. 이러한 이해는 모델 복잡성을 최적화하는 데 필수적입니다.

데이터 분할 이해: 훈련, 테스트, 검증

모델의 학습 및 테스트 목적을 위해 데이터는 세 가지 데이터 세트로 분류되어야 합니다.

트레이닝 세트

모델이 데이터의 숨겨진 기능을 학습하고 학습하도록 하는 데 사용되는 데이터 세트입니다. 훈련 세트에는 모델이 모든 조건에서 훈련되고 미래에 나타날 수 있는 모든 데이터 샘플을 예측할 수 있도록 다양한 입력이 있어야 합니다.

검증 세트

검증 세트는 훈련 중에 모델 성능을 검증하는 데 사용되는 데이터 세트입니다.

이 검증 프로세스는 모델 구성을 조정하는 데 도움이 되는 정보를 제공합니다. 매 에포크 후에 모델은 훈련 세트에서 훈련되고 모델 평가는 검증 세트에서 수행됩니다.

데이터 세트를 검증 세트로 분할하는 주요 아이디어는 모델이 훈련 세트의 샘플을 잘 분류하지만 이전에 본 적이 없는 데이터를 일반화하고 정확하게 분류하지 못하는 것을 방지하는 것입니다.

테스트 세트

테스트 세트는 학습이 완료된 후 모델을 테스트하는 데 사용되는 데이터 세트입니다. 정확성과 정밀도 측면에서 최종 모델 성능을 제공합니다.

데이터 전처리 및 정리

데이터 전처리에는 원시 데이터 세트를 이해할 수 있는 형식으로 변환하는 작업이 포함됩니다. 데이터 전처리는 데이터 효율성을 향상시키는 데 도움이 되는 데이터 마이닝의 필수 단계입니다.

데이터 분할의 무작위화

무작위화는 기계 학습에서 필수적이며 편견 없는 교육, 검증 및 테스트 하위 집합을 보장합니다. 분할하기 전에 데이터 세트를 무작위로 섞으면 데이터 순서와 관련된 패턴이 도입될 위험이 최소화됩니다. 이는 모델이 배열에 따라 시끄러운 데이터를 학습하는 것을 방지합니다. 무작위화는 모델의 일반화 능력을 향상시켜 다양한 데이터 분포에 걸쳐 견고하게 만듭니다. 또한 잠재적인 편향으로부터 보호하여 각 하위 집합이 전체 데이터 세트에 존재하는 다양성을 반영하도록 합니다.

학습-테스트 분할: 방법

학습-테스트 분할을 수행하려면 Python에서 scikit-learn과 같은 라이브러리를 사용하세요. `train_test_split` 함수를 가져오고, 데이터 세트를 지정하고, 테스트 크기(예: 20%)를 설정합니다. 이 기능은 데이터를 훈련 및 테스트 세트로 무작위로 나누어 클래스 또는 결과의 분포를 유지합니다.

학습 테스트 분할을 위한 Python 코드:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

#import csv검증 분할: 방법

훈련-테스트 분할 후 검증 분할을 위해 훈련 세트를 추가로 분할합니다. 이는 모델 튜닝에 매우 중요합니다. 이번에도 훈련 데이터에 'train_test_split'을 사용하여 일부(예: 15%)를 검증 세트로 할당합니다. 이는 손대지 않은 테스트 세트를 건드리지 않고도 모델의 매개변수를 개선하는 데 도움이 됩니다.

검증 분할을 위한 Python 코드

from sklearn.model_selection import train_test_split

X_train_temp, X_temp, y_train_temp, y_temp = train_test_split(X, y, test_size=0.3, random_state=42) X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

#import csv분류를 위한 훈련 테스트 분할

분류에서 데이터는 훈련 세트와 테스트 세트라는 두 부분으로 나뉩니다. 모델은 훈련 세트에서 훈련되고, 성능은 테스트 세트에서 검사됩니다. 훈련 세트에는 데이터의 80%가 포함되어 있고 테스트 세트에는 20%가 포함되어 있습니다.

실제 데이터 예:

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_trivia

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

iris = load_trivia()

X = trivia.data

y = trivia.target

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = LogisticRegression()

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy}")

#import csv산출

정확도 : 1.0

훈련 테스트 회귀

회귀 데이터 세트를 학습 데이터 세트와 테스트 데이터 세트로 나눕니다. 훈련 데이터를 기반으로 모델을 훈련시키고, 테스트 데이터를 기반으로 성능을 평가합니다. 주요 목표는 모델이 새 데이터 세트에 얼마나 잘 일반화되는지 확인하는 것입니다.

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_boston

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

boston = load_boston()

X = boston.data

y = boston.target

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = LinearRegression()

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

print(f"Mean Squared Error: {mse}")

#import csv평균 제곱 오류: 24.291119474973616

데이터 분할 모범 사례

- 무작위화: 순서 관련 편향을 피하기 위해 분할하기 전에 데이터를 무작위로 섞습니다.

- 계층화: 분류 작업에 필수적인 각 분할의 클래스 분포를 유지합니다.

- 교차 검증: 특히 소규모 데이터세트에서 강력한 모델 평가를 위해 k-겹 교차 검증을 사용합니다.

피해야 할 일반적인 실수

훈련-테스트-검증 분할을 수행하는 동안 피해야 할 일반적인 실수는 다음과 같습니다.

- 데이터 유출: 테스트 세트의 정보가 훈련이나 검증에 영향을 주지 않는지 확인하세요.

- 클래스 불균형 무시: 더 나은 모델 훈련을 위해 분할을 계층화하여 클래스 불균형을 해결합니다.

- 교차 검증 간과: 단일 학습-테스트 분할에만 의존하면 모델 평가가 편향될 수 있습니다.

결론

Train-Test-Validation Split은 기계 학습 모델의 효율성을 테스트하기 위한 필수 테스트입니다. 다양한 데이터 세트를 평가하여 기계 학습 모델의 정확성을 확인하므로 기술 분야에서 필수적인 도구로 사용됩니다.

주요 요점

- 전략 데이터 부문:

- 효과적인 모델 개발을 위해 데이터를 교육, 테스트, 검증 세트로 나누는 것의 중요성을 알아보세요.

- 과적합을 방지하고 모델 성능을 최적화하는 데 있어 각 하위 집합의 특정 역할을 이해합니다.

- 실제 구현:

- Python 라이브러리를 사용하여 학습-테스트-검증 분할을 구현하는 기술을 습득하세요.

- 편견이 없고 신뢰할 수 있는 모델 평가를 위한 무작위화 및 계층화의 중요성을 이해합니다.

- 일반적인 실수로부터 보호하기:

- 누출 및 클래스 불균형과 같은 데이터 분할 중 일반적인 함정에 대한 통찰력을 얻으세요.

- 다양한 데이터세트에 걸쳐 모델의 견고성과 일반화를 보장하는 교차 검증의 역할.

관련

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://www.analyticsvidhya.com/blog/2023/11/train-test-validation-split/