大規模言語モデル (LLM) を中心に構築された生成人工知能 (AI) アプリケーションは、ビジネスに経済的価値を生み出し、加速する可能性を実証しています。アプリケーションの例としては、以下が挙げられます。 会話型検索、 カスタマーサポートエージェントのサポート, カスタマーサポート分析, セルフサービス仮想アシスタント、 チャットボット, リッチメディア世代, コンテンツ管理, 安全で高性能なソフトウェア開発を加速するコーディングコンパニオン, マルチモーダルコンテンツソースからのより深い洞察, 組織のセキュリティ調査と緩和策の加速、 などなど。多くの顧客は、生成 AI アプリケーションを開発する際に、セキュリティ、プライバシー、コンプライアンスを管理する方法に関するガイダンスを求めています。設計およびアーキテクチャの段階で LLM の脆弱性、脅威、リスクを理解し、対処することで、チームは生成 AI がもたらす経済的および生産性の利点を最大化することに集中できます。リスクを認識することで、生成 AI アプリケーションの透明性と信頼が促進され、可観測性の向上が促進され、コンプライアンス要件を満たすのに役立ち、リーダーによる十分な情報に基づいた意思決定が促進されます。

この投稿の目的は、AI および機械学習 (ML) エンジニア、データ サイエンティスト、ソリューション アーキテクト、セキュリティ チーム、その他の関係者がセキュリティのベスト プラクティスを適用するための共通のメンタル モデルとフレームワークを持てるようにして、AI/ML チームが移行できるようにすることです。速度のためにセキュリティを犠牲にすることなく、高速に動作します。具体的には、この投稿は、これまでセキュリティ原則に触れたことのない AI/ML およびデータ サイエンティストが、LLM を使用した生成 AI アプリケーションの開発に関連する中核となるセキュリティとプライバシーのベスト プラクティスを理解できるように支援することを目的としています。また、AI の信頼を損なう可能性のある一般的なセキュリティ上の懸念事項についても説明します。 Open Worldwide Application Security Project (OWASP) LLM アプリケーションのトップ 10、生成 AI で革新しながら、AWS を使用してセキュリティ体制と自信を高める方法を示します。

この投稿では、LLM を使用して生成 AI アプリケーションを開発する際にリスク管理戦略を構築するための 3 つのガイド付きステップを説明します。まず、LLM ソリューションの実装、展開、使用から生じる脆弱性、脅威、リスクを詳しく調べ、セキュリティを念頭に置いてイノベーションを開始する方法についてのガイダンスを提供します。次に、安全な基盤の上に構築することが生成 AI にとっていかに重要であるかを説明します。最後に、これらを LLM ワークロードの例と結び付けて、信頼境界を越えた多層防御のセキュリティを構築するためのアプローチを説明します。

この投稿の終わりまでに, AI/ML エンジニア、データ サイエンティスト、セキュリティ志向の技術者は、生成 AI アプリケーションの多層防御を構築するための戦略を特定し、LLM のセキュリティ上の懸念事項に対する OWASP トップ 10 を対応する制御にマッピングする方法を理解し、それに向けた基礎知識を構築できるようになります。アプリケーションに関する次の AWS 顧客のよくある質問のテーマに答えます。

- アプリケーションで LLM に基づく生成 AI を使用する場合に発生する一般的なセキュリティとプライバシーのリスクのうち、このガイダンスが最も影響を与える可能性があるものは何ですか?

- AWS 上の生成 AI LLM アプリケーションの開発ライフサイクルでセキュリティとプライバシーの制御を実装するにはどのような方法がありますか?

- LLM を使用してリスクを管理し、生成 AI アプリケーションの信頼性を高めるために、組織が生成 AI LLM アプリケーションを構築する方法にどのような運用上および技術上のベスト プラクティスを組み込むことができますか?

生成 AI を開発しながらセキュリティの成果を向上させる

LLM を使用した生成 AI によるイノベーションでは、セキュリティを念頭に置き、組織の回復力を開発し、安全な基盤を構築し、セキュリティと多層防御のセキュリティ アプローチを統合する必要があります。セキュリティというのは、 責任の共有 AWS と AWS の顧客の間。 AWS 責任共有モデルのすべての原則は、生成 AI ソリューションに適用できます。 LLM ソリューションを構築するときにインフラストラクチャ、サービス、データに適用される AWS 責任共有モデルについての理解を改めて深めてください。

組織の回復力を高めるためにセキュリティを念頭に置くことから始めます

セキュリティを念頭に置き、セキュリティとコンプライアンスの目標を満たす生成 AI アプリケーションを開発するための組織の回復力を開発します。組織の回復力は、 AWS Well-Architected フレームワークにおける復元力の定義 組織が混乱から回復する能力を備え、それに備えます。 LLM を使用した生成 AI を開発するための全体的な準備状況と、潜在的な影響に対する組織の回復力を評価する際には、セキュリティ体制、ガバナンス、および運用の優秀性を考慮してください。組織が生成 AI や LLM などの新興テクノロジーの利用を進めるにつれて、資産や事業部門を意図しない結果から保護するための多層防御戦略の基礎として、組織全体の回復力を考慮する必要があります。

LLM アプリケーションにとって組織の回復力は非常に重要です

すべてのリスク管理プログラムは回復力から恩恵を受けることができますが、組織の回復力は生成 AI にとって非常に重要です。 OWASP が特定した LLM アプリケーションのトップ 10 リスクのうち XNUMX つは、リスクを管理するために、アーキテクチャおよび運用上の制御を定義し、組織規模でそれらを強制することに依存しています。これら XNUMX つのリスクとは、安全でない出力処理、サプライ チェーンの脆弱性、機密情報の漏洩、過剰な主体性、および過度の依存です。 AI、ML、生成型 AI のセキュリティが中核的なビジネス要件であり、アイデアの発案から研究、アプリケーションの開発、展開、および製品のライフサイクル全体を通じて最優先事項であるとチームを組織して、組織の回復力を高め始めます。使用。認識に加えて、チームはガバナンス、保証、コンプライアンス検証の実践において生成 AI を考慮するための行動を起こす必要があります。

生成 AI を中心に組織の回復力を構築する

組織は、組織内で AI/ML および生成 AI セキュリティの能力と能力を構築する方法の採用を開始できます。まず、既存のセキュリティ、保証、コンプライアンス、および開発プログラムを拡張して生成 AI に対応できるようにする必要があります。

以下は、組織 AI、ML、生成 AI のセキュリティにとって重要な 5 つの分野です。

- AI/ML セキュリティ環境を理解する

- セキュリティ戦略に多様な視点を組み込む

- 研究開発活動の安全確保に積極的に取り組む

- インセンティブを組織の成果と一致させる

- AI/ML および生成 AI における現実的なセキュリティ シナリオを準備する

生成 AI ライフサイクル全体を通じて脅威モデルを開発する

生成 AI を使用して構築する組織は、リスクの排除ではなくリスク管理に焦点を当て、次のことを含める必要があります。 脅威モデリング と 事業継続計画 生成的な AI ワークロードの計画、開発、運用。従来のセキュリティ リスクと生成 AI 固有のリスクを使用して、各アプリケーションの脅威モデルを開発することにより、生成 AI の本番使用から逆算して作業します。一部のリスクは企業にとって許容できる可能性があり、脅威モデリングの演習は、企業が許容できるリスク選好度を特定するのに役立ちます。たとえば、ビジネスでは生成 AI アプリケーションで 99.999% の稼働時間を必要としない場合があるため、 AWS バックアップ アマゾンS3氷河 許容できるリスクかもしれません。逆に、モデル内のデータは非常に機密性が高く、高度に規制されている可能性があるため、 AWSキー管理サービス (AWS KMS) カスタマー マネージド キー (CMK) ローテーションと使用 AWSネットワークファイアウォール データ漏洩を防ぐために、受信トラフィックと送信トラフィックに対してトランスポート層セキュリティ (TLS) を適用することは、許容できないリスクとなる可能性があります。

本番環境で生成 AI アプリケーションを使用する場合のリスク (固有のリスクと残留リスク) を評価し、適切な基本およびアプリケーション レベルの制御を特定します。プロンプトインジェクション、トレーニングデータポイズニング、モデルのサービス拒否、モデルの盗難などの実稼働セキュリティイベントやサービス中断からのロールバックとリカバリを早い段階で計画し、アプリケーション要件を定義する際に使用する緩和策を定義します。導入する必要があるリスクと制御について学ぶことは、生成 AI アプリケーションを構築するための最適な実装アプローチを定義するのに役立ち、リスクに関する情報に基づいたビジネス上の意思決定を行うための情報を利害関係者や意思決定者に提供します。 AI と ML のワークフロー全体に慣れていない場合は、まず復習してください。 機械学習ワークロードのセキュリティを向上させる 7 つの方法 従来の AI/ML システムに必要なセキュリティ制御への習熟度を高めるため。

他の ML アプリケーションの構築と同様に、生成 AI アプリケーションの構築には、一連の研究開発ライフサイクル段階を経る必要があります。を見直してみてはいかがでしょうか AWS Generative AI セキュリティスコーピングマトリックス 選択した生成 AI ソリューションに応じて考慮する必要がある主要なセキュリティ規律を理解するためのメンタル モデルを構築するのに役立ちます。

LLM を使用する生成 AI アプリケーションは通常、次の順序付けられた手順に従って開発および運用されます。

- 応募要件 – ユースケースのビジネス目標、要件、成功基準を特定する

- モデル選択 – ユースケースの要件に合わせた基盤モデルを選択する

- モデルの適応と微調整 – データを準備し、プロンプトを設計し、モデルを微調整する

- モデル評価 – ユースケース固有のメトリックを使用して基盤モデルを評価し、最もパフォーマンスの高いモデルを選択します

- 導入と統合 – 選択した基盤モデルを最適化されたインフラストラクチャにデプロイし、生成 AI アプリケーションと統合します

- アプリケーションの監視 – アプリケーションとモデルのパフォーマンスを監視して、根本原因の分析を可能にする

ソフトウェア開発ライフサイクルの初日から、設計およびアーキテクチャのフェーズの一部として、チームがセキュリティの重要な性質を理解していることを確認します。これは、スタックとライフサイクルの各層でセキュリティについて議論し、ビジネス目標を達成するためのイネーブラーとしてセキュリティとプライバシーを位置づけることを意味します。 LLM アプリケーションを起動する前に脅威の制御を設計し、モデルの適応と微調整に使用するデータと情報が研究、開発、トレーニング環境での実装を制御するかどうかを検討します。品質保証テストの一環として、合成セキュリティ脅威 (トレーニング データを汚染しようとする試みや、悪意のあるプロンプト エンジニアリングを通じて機密データを抽出しようとする試みなど) を導入して、防御とセキュリティ体制を定期的にテストします。

さらに、利害関係者は、実稼働 AI、ML、および生成 AI ワークロードの一貫したレビュー頻度を確立し、開始前に人間と機械の制御とエラーの間のトレードオフを理解することに組織の優先順位を設定する必要があります。導入された LLM アプリケーションでこれらのトレードオフが尊重されていることを検証し、保証することで、リスク軽減が成功する可能性が高まります。

安全なクラウド基盤上に生成型 AI アプリケーションを構築する

AWS では、セキュリティが最優先事項です。 AWS は、アプリケーションとワークロードを構築、移行、管理するための最も安全なグローバル クラウド インフラストラクチャとなるように設計されています。これは、300 を超えるクラウド セキュリティ ツールの豊富なセットと、政府、医療、金融サービスなどのセキュリティに最も敏感な組織を含む数百万の顧客の信頼によって裏付けられています。 AWS で LLM を使用して生成 AI アプリケーションを構築すると、セキュリティ上の利点が得られます。 安全で信頼性が高く、柔軟な AWS クラウド コンピューティング環境.

セキュリティ、プライバシー、コンプライアンスのために AWS グローバル インフラストラクチャを使用する

AWS でデータ集約型アプリケーションを開発する場合、中核となるセキュリティとコンプライアンスの要件を満たす機能を提供するように設計された AWS グローバル リージョン インフラストラクチャの恩恵を受けることができます。これは私たちの取り組みによってさらに強化されています AWS デジタル主権の誓約、クラウドで利用可能な最先端の主権制御と機能のセットを提供するという当社の取り組み。私たちは、お客様のニーズを満たすことができるよう、当社の機能を拡大することに全力で取り組んでいます。 デジタル主権 AWS クラウドのパフォーマンス、イノベーション、セキュリティ、スケールに妥協することなく、ニーズに応えます。セキュリティとプライバシーのベスト プラクティスの実装を簡素化するには、リファレンス デザインとインフラストラクチャをコード リソースとして使用することを検討してください。 AWS セキュリティリファレンスアーキテクチャ (AWS SRA) と AWS プライバシー参照アーキテクチャ (AWS PRA)。 もっと詳しく読む プライバシー ソリューションの設計, 設計上の主権, AWS でのコンプライアンス などのサービスを利用します AWSConfig, AWSアーティファクト, AWS監査マネージャー プライバシー、コンプライアンス、監査、可観測性のニーズをサポートします。

AWS Well-Architected とクラウド導入フレームワークを使用してセキュリティ体制を理解する

AWS は、お客様によるクラウド環境の構築をサポートしてきた長年の経験から開発されたベストプラクティス ガイダンスを提供します。 AWS の適切に設計されたフレームワーク そして、クラウドテクノロジーからビジネス価値を実現するために進化しています。 AWS クラウド導入フレームワーク (AWS CAF)。 Well-Architected フレームワークのレビューを実行して、AI、ML、生成 AI ワークロードのセキュリティ体制を理解します。レビューは、次のようなツールを使用して実行できます。 AWS Well-Architected ツール、または AWS チームの協力を得て、 AWSエンタープライズサポート。 AWS Well-Architected ツール 洞察を自動的に統合します から AWS の信頼できるアドバイザ どのようなベスト プラクティスが実施されているか、機能とコストの最適化を改善するためにどのような機会が存在するかを評価します。 AWS Well-Architected Tool は、次のような特定のベストプラクティスを備えたカスタマイズされたレンズも提供します。 機械学習レンズ これにより、アーキテクチャをベスト プラクティスと比較して定期的に測定し、改善の余地がある領域を特定できます。 AWS の顧客が組織能力を開発するための戦略をどのように採用しているかを理解することで、価値の実現とクラウドの成熟への道をチェックポイントします。 人工知能、機械学習、生成 AI のための AWS クラウド導入フレームワーク。また、クラウドへの全体的な準備状況を理解するには、 AWS クラウドの準備状況評価。 AWS は、エンゲージメントのための追加の機会を提供しています。AWS アカウントチームに、利用を開始する方法の詳細をお問い合わせください。 ジェネレーティブAIイノベーションセンター.

ベスト プラクティスのガイダンス、トレーニング、認定により、セキュリティと AI/ML の学習を加速します

AWS はまた、次のような推奨事項を厳選します。 セキュリティ、アイデンティティ、コンプライアンスのベストプラクティス & AWS セキュリティドキュメント トレーニング、開発、テスト、運用環境を保護する方法を特定するのに役立ちます。始めたばかりの場合は、セキュリティ トレーニングと認定資格について詳しく調べて、以下から始めることを検討してください。 AWSセキュリティの基礎 と AWS セキュリティ学習プラン。 あなたも使うことができます AWS セキュリティ成熟度モデル これは、AWS の成熟度のさまざまな段階で最適なアクティビティを見つけて優先順位を付けるのに役立ちます。簡単な成功から始まり、基礎的、効率的、最適化された段階まで続きます。あなたとあなたのチームが AWS のセキュリティの基本を理解したら、次の内容を確認することを強くお勧めします。 脅威モデリングへのアプローチ方法 次に、チームとともに脅威モデリング演習を主導します。 ビルダーのための脅威モデリング ワークショップ 研修プログラム。他にもたくさんあります AWS セキュリティのトレーニングと認定リソース にアクセスできるようにしています。

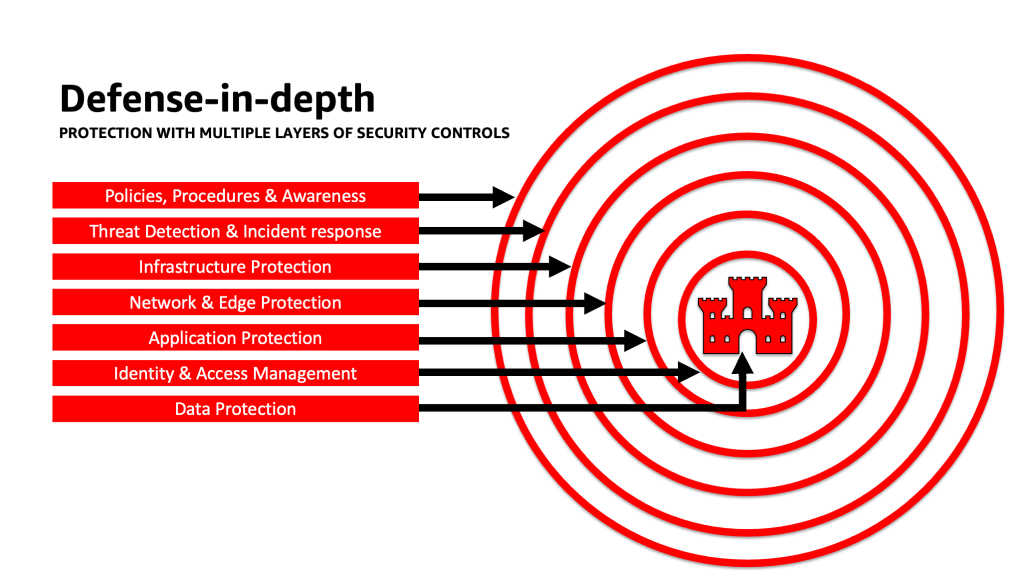

多層防御アプローチを適用して安全な LLM アプリケーションを実現する

多層防御のセキュリティ アプローチを生成 AI ワークロード、データ、情報に適用すると、ビジネス目標を達成するための最適な条件を作り出すことができます。多層防御のセキュリティのベスト プラクティスは、あらゆるワークロードが直面する一般的なリスクの多くを軽減し、あなたとあなたのチームが生成 AI イノベーションを加速するのに役立ちます。多層防御のセキュリティ戦略では、複数の冗長防御を使用して AWS アカウント、ワークロード、データ、資産を保護します。これは、いずれかのセキュリティ制御が侵害されたり失敗したりした場合に、脅威を隔離し、セキュリティ イベントを防止、検出、対応、回復するために追加のレイヤーが存在することを確認するのに役立ちます。各レイヤーで AWS のサービスやソリューションなどの戦略を組み合わせて使用することで、生成 AI ワークロードのセキュリティと復元力を向上させることができます。

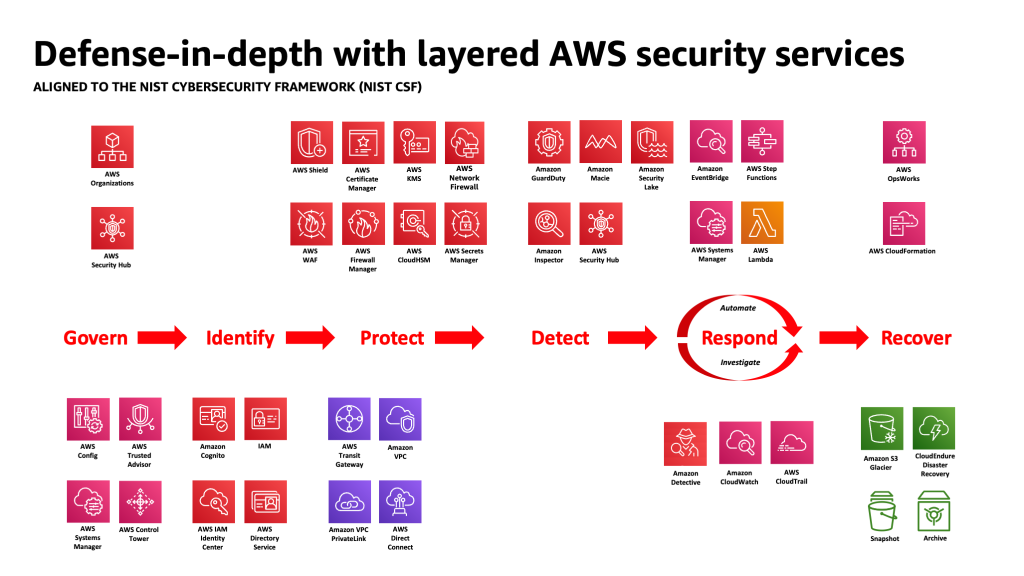

AWS の顧客の多くは、次のような業界標準のフレームワークに準拠しています。 NISTサイバーセキュリティフレームワーク。このフレームワークは、識別、保護、検出、対応、回復、そして最近追加された統治の柱全体でセキュリティ防御を確実に保護するのに役立ちます。このフレームワークは、AWS セキュリティ サービスや統合されたサードパーティのサービスに簡単にマッピングできるため、組織が遭遇するあらゆるセキュリティ イベントに対する適切な適用範囲とポリシーを検証するのに役立ちます。

多層防御: 環境を保護し、強化された AI/ML 固有のセキュリティおよびプライバシー機能を追加します。

多層防御戦略は、まずアカウントと組織を保護することから始め、次に、次のようなサービスの追加の組み込みセキュリティおよびプライバシー強化機能を重ねていく必要があります。 アマゾンの岩盤 & アマゾンセージメーカー. Amazon には、セキュリティ、アイデンティティ、コンプライアンスのポートフォリオに 30 を超えるサービスがあります これらは AWS AI/ML サービスと統合されており、ワークロード、アカウント、組織を保護するために一緒に使用できます。 OWASP Top 10 for LLM を適切に防御するには、これらを AWS AI/ML サービスと併用する必要があります。

まず、次のようなサービスを使用して、最小特権のポリシーを実装します。 IAM アクセス アナライザー 〜へ 短期的な認証情報を使用したアクセスを制限するために、過度に寛容なアカウント、ロール、リソースを探す。次に、CMK の使用を考慮して、保存されているすべてのデータが AWS KMS で暗号化されていること、およびすべてのデータとモデルがバージョン管理され、次の方法でバックアップされていることを確認します。 Amazon シンプル ストレージ サービス (Amazon S3) バージョニングとオブジェクトレベルの不変性の適用 Amazon S3 オブジェクト ロック。サービス間で転送されるすべてのデータを保護する AWS証明書マネージャー および AWS プライベート CAを使用して VPC 内に保持します。 AWS プライベートリンク。厳格なデータの受信および送信ルールを定義して、VPC を使用した操作や漏洩から保護します。 AWSネットワークファイアウォール ポリシー。挿入を検討してください AWS ウェブ アプリケーション ファイアウォール (AWS WAF) の前に Web アプリケーションと API を保護する から 悪意のあるボット, SQL インジェクション攻撃、クロスサイト スクリプティング (XSS)、 そしてアカウント乗っ取り 不正管理。ログ記録 AWS クラウドトレイル, アマゾン バーチャル プライベート クラウド (Amazon VPC) フローログ、および Amazon Elastic Kubernetesサービス (Amazon EKS) 監査ログは、次のようなサービスで利用可能な各トランザクションのフォレンジック レビューを提供するのに役立ちます。 アマゾン探偵。 あなたが使用することができます アマゾンインスペクター 脆弱性の発見と管理を自動化するため アマゾン エラスティック コンピューティング クラウド (Amazon EC2) インスタンス、コンテナ、 AWSラムダ 機能、および ワークロードのネットワーク到達可能性を特定する。を使用して、不審なアクティビティからデータとモデルを保護します。 アマゾンガードデューティの ML を利用した脅威モデルとインテリジェンス フィードを利用し、EKS 保護、ECS 保護、S3 保護、RDS 保護、マルウェア保護、Lambda 保護などの追加機能を有効にします。などのサービスが利用できます AWSセキュリティハブ セキュリティチェックを一元化して自動化し、セキュリティのベストプラクティスからの逸脱を検出し、調査を加速し、プレイブックを使用してセキュリティの発見事項の修復を自動化します。の実装を検討することもできます。 ゼロトラスト AWS 上のアーキテクチャを使用して、人間のユーザーまたはマシン間のプロセスがリクエストごとにアクセスできるものに対するきめ細かい認証および認可の制御をさらに強化します。の使用も検討してください アマゾン セキュリティ レイク AWS 環境、SaaS プロバイダー、オンプレミス、クラウド ソースからのセキュリティ データを、アカウントに保存されている専用のデータ レイクに自動的に一元化します。 Security Lake を使用すると、組織全体のセキュリティ データをより完全に理解できます。

生成 AI ワークロード環境が保護された後、次のような AI/ML 固有の機能をレイヤー化できます。 AmazonSageMakerデータラングラー データ準備中に潜在的なバイアスを特定し、 Amazon SageMaker の明確化 ML データとモデルのバイアスを検出します。も使用できます Amazon SageMakerモデルモニター 本番環境での SageMaker ML モデルの品質を評価し、データ品質、モデル品質、および機能の属性に変動がある場合に通知します。これらの AWS AI/ML サービス (Amazon Bedrock と連携する SageMaker を含む) と AWS セキュリティ サービスを連携させると、潜在的な自然バイアスの原因を特定し、悪意のあるデータ改ざんから保護することができます。 OWASP トップ 10 の LLM 脆弱性ごとにこのプロセスを繰り返し、AWS のサービスの価値を最大化して多層防御を実装し、データとワークロードを保護します。

AWS エンタープライズ ストラテジストの Clarke Rodgers がブログ投稿で次のように書いています。 「CISO の洞察: すべての AWS サービスはセキュリティ サービスである」, 「AWS クラウド内の事実上すべてのサービスは、セキュリティ、リスク、またはコンプライアンスの目標を達成するために、それ自体でセキュリティの成果を実現できるか、または顧客が (単独で、または 1 つ以上のサービスと組み合わせて) 使用できるかのどちらかだと私は主張します。」そして、「顧客の最高情報セキュリティ責任者 (CISO) (またはそれぞれのチーム) は、セキュリティ、リスク、またはコンプライアンスの目標を達成できる可能性があるため、時間をかけて AWS のすべてのサービスに精通していることを確認したい場合があります。サービスが「セキュリティ、アイデンティティ、コンプライアンス」のカテゴリに分類されない場合でも。」

LLM アプリケーションの信頼境界におけるレイヤー防御

生成 AI ベースのシステムおよびアプリケーションを開発するときは、「」で説明されているように、他の ML アプリケーションと同じ懸念事項を考慮する必要があります。 MITRE ATLAS 機械学習の脅威マトリクスこれには、ソフトウェアとデータ コンポーネントの起源に注意を払うこと (オープンソース ソフトウェア監査の実行、ソフトウェア部品表 (SBOM) のレビュー、データ ワークフローと API 統合の分析など)、LLM サプライ チェーンの脅威に対して必要な保護を実装することが含まれます。業界のフレームワークからの洞察を組み込み、脅威インテリジェンスとリスク情報の複数のソースを使用してセキュリティ防御を調整および拡張し、従来のフレームワークには含まれていない、AI、ML、および生成型 AI の新たなセキュリティ リスクに対応する方法を意識してください。 AI 固有のリスクに関する関連情報を業界、防衛、政府、国際、学術情報源から探してください。この領域では定期的に新しい脅威が出現および進化し、関連するフレームワークやガイドが頻繁に更新されるためです。たとえば、取得拡張生成 (RAG) モデルを使用する場合、モデルに必要なデータが含まれていない場合、推論や微調整中に使用するために外部データ ソースからデータを要求することがあります。クエリの対象となるソースは制御不能な場合があり、サプライ チェーンにおける潜在的な侵害源となる可能性があります。多層防御のアプローチを外部ソースにも拡張して、アクセスしているデータの信頼、認証、認可、アクセス、セキュリティ、プライバシー、および正確性を確立する必要があります。さらに詳しく知りたい場合は、「Amazon SageMaker JumpStart を使用して Generative AI と RAG を備えた安全なエンタープライズ アプリケーションを構築する

LLM アプリケーションのリスクを分析して軽減する

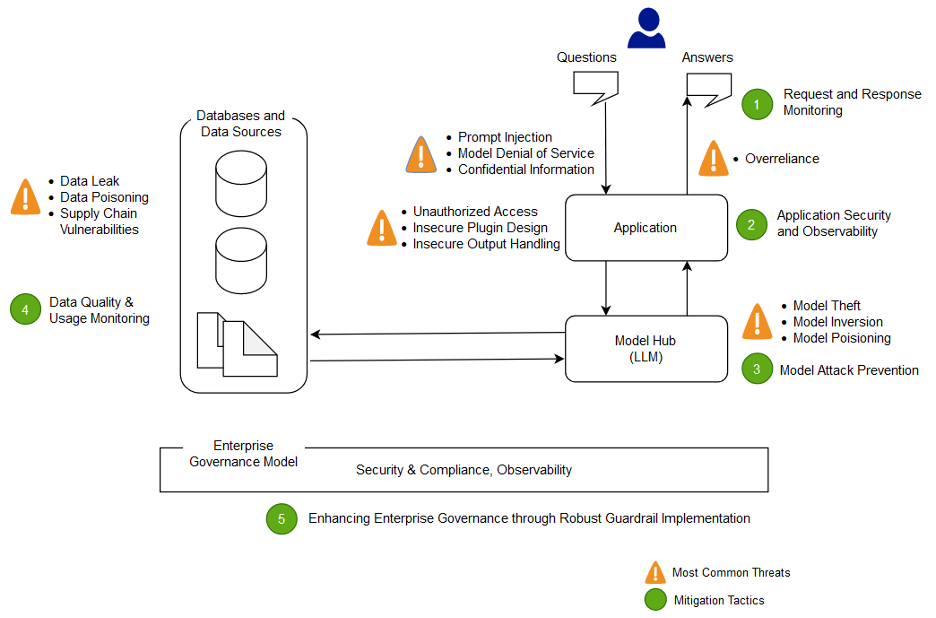

このセクションでは、信頼境界と相互作用、または同様の適切な制御範囲とリスク プロファイルを持つワークロードの個別の領域に基づいて、いくつかのリスク軽減手法を分析し、説明します。チャットボット アプリケーションのこのサンプル アーキテクチャには、AWS の顧客が一般的に LLM アプリケーションを構築する方法に基づいて、制御が実証される 5 つの信頼境界があります。 LLM アプリケーションには、定義可能な信頼境界が多かれ少なかれ存在する場合があります。次のサンプル アーキテクチャでは、これらの信頼境界は次のように定義されています。

- ユーザー インターフェイスの対話 (リクエストとレスポンス)

- アプリケーションの相互作用

- モデルの相互作用

- データの相互作用

- 組織的な相互作用と使用

ユーザー インターフェイスの対話: リクエストとレスポンスのモニタリングを開発する

生成 AI アプリケーションの入出力からのリスクに対処する戦略を評価することで、生成 AI に関連するサイバー インシデントをタイムリーに検出して対応します。たとえば、LLM アプリケーションで使用される場合、ドメインまたは組織外への機密情報の漏洩を検出するには、動作やデータ流出に対する追加の監視が必要になる場合があります。

生成 AI アプリケーションは、データの保護に関して、標準的なセキュリティのベスト プラクティスを維持する必要があります。を確立する 安全なデータ境界 & 安全な機密データ ストア。 LLM アプリケーションに使用されるデータと情報を保存中および転送中に暗号化します。どのユーザー、プロセス、ロールがデータ ストアへの貢献を許可されているか、アプリケーション内でデータがどのように流れるかを理解して制御し、バイアスの逸脱を監視し、バージョニングやバージョン管理を使用して、モデルのトレーニングに使用されるデータをトレーニング データ ポイズニングから保護しますAmazon S3 などのストレージ サービスの不変ストレージ。 AWS ネットワーク ファイアウォールや AWS VPC などのサービスを使用して、厳格なデータの出入り制御を確立し、不審な入力やデータ漏洩の可能性から保護します。

トレーニング、再トレーニング、または微調整のプロセス中は、使用される機密データに注意する必要があります。これらのプロセスのいずれかでデータが使用された後、モデルのユーザーがプロンプト インジェクション技術を利用して突然データや情報を抽出できるようになるシナリオを計画する必要があります。モデルや推論で機密データを使用することのリスクと利点を理解します。開示を防ぐために LLM アプリケーション ロジックに依存しない、きめ細かいアクセス許可を確立および管理するための堅牢な認証および認可メカニズムを実装します。生成 AI アプリケーションへのユーザー制御入力は、いくつかの条件下で、モデルまたは入力のユーザー制御以外の部分から情報を抽出するためのベクトルを提供できることが実証されています。これは、プロンプト インジェクションを介して発生する可能性があります。プロンプト インジェクションでは、モデルが最初にトレーニングされたデータセットへの手がかりを提供するなど、LLM アプリケーションの予想されるガードレールからモデルの出力を逸脱させる入力をユーザーが提供します。

ユーザーがモデルに入力を提供し、モデルから出力を受信するためのユーザーレベルのアクセス割り当てを実装します。モデルのトレーニング データと情報が機密である場合、または攻撃者がその入力と調整されたモデルの出力に基づいてモデルの複製をトレーニングするリスクがある状況では、匿名アクセスを許可しないアプローチを検討する必要があります。一般に、モデルへの入力の一部が任意のユーザー提供のテキストで構成されている場合、その出力はプロンプト インジェクションの影響を受けやすいと考え、そのため、出力の使用には、安全でない出力処理や過剰なエージェンシーを軽減するための技術的および組織的な対策を確実に組み込んでください。 、そして過依存。 AWS WAF を使用した悪意のある入力のフィルタリングに関連した前述の例では、このようなプロンプトの潜在的な誤用に備えてアプリケーションの前にフィルターを構築することを検討し、モデルとデータの成長に応じてそれらを処理および進化させる方法のポリシーを開発します。また、出力が品質、正確さ、またはコンテンツ管理基準を満たしていることを確認するために、ユーザーに返す前に出力をフィルター処理してレビューすることも検討してください。不審なトラフィック パターンを軽減するために、モデルの前に入力と出力の制御レイヤーを追加して、これを組織のニーズに合わせてさらにカスタマイズすることもできます。

アプリケーションの対話: アプリケーションのセキュリティと可観測性

ユーザーがモデルを利用して、アクセスまたは使用する権限を持たない下流のツールまたはツールチェーンへの標準権限をバイパスする方法に注意して、LLM アプリケーションを検討してください。この層におけるもう 1 つの懸念には、軽減されていない技術的または組織的な LLM リスクを使用する攻撃メカニズムとしてモデルを使用して、外部データ ストアにアクセスすることが含まれます。たとえば、モデルが機密データを含む可能性のある特定のデータ ストアにアクセスするようにトレーニングされている場合は、モデルとデータ ストアの間で適切な承認チェックが行われていることを確認する必要があります。認可チェックを実行するときは、モデルに由来しないユーザーに関する不変属性を使用します。安全でない出力処理、安全でないプラグイン設計、過剰なエージェンシーが緩和されていないと、脅威アクターがモデルを使用して承認システムをだまして有効な権限を昇格させ、ダウンストリーム コンポーネントがユーザーにデータの取得や特定の権限の取得が許可されていると認識される可能性があります。アクション。

生成 AI プラグインまたはツールを実装する場合、設定されているアクセス制御を精査するだけでなく、付与されているアクセスのレベルを調査して理解することが不可欠です。安全でない生成 AI プラグインをそのまま使用すると、システムがサプライ チェーンの脆弱性や脅威の影響を受けやすくなり、リモート コードの実行などの悪意のあるアクションにつながる可能性があります。

モデルの相互作用: モデル攻撃の防止

サプライ チェーンの脆弱性を評価して軽減するには、使用するモデル、プラグイン、ツール、またはデータの出所を認識する必要があります。たとえば、一部の一般的なモデル形式では、モデル自体に任意の実行可能コードを埋め込むことができます。組織のセキュリティ目標に応じて、パッケージのミラーリング、スキャン、追加の検査を使用します。

モデルのトレーニングと微調整に使用するデータセットもレビューする必要があります。ユーザーのフィードバック (またはその他のエンドユーザーが制御可能な情報) に基づいてモデルをさらに自動的に微調整する場合は、悪意のある攻撃者が応答の操作に基づいてモデルを恣意的に変更し、トレーニング データ ポイズニングを達成する可能性があるかどうかを考慮する必要があります。

データのやり取り: データの品質と使用状況を監視する

LLM などの生成 AI モデルは、大量のデータでトレーニングされているため、通常は適切に機能します。このデータは LLM が複雑なタスクを完了するのに役立ちますが、システムをトレーニング データ ポイズニングのリスクにさらす可能性もあります。トレーニング データ ポイズニングは、モデルの動作を変える可能性のあるトレーニング データセット内に不適切なデータが含まれたり省略されたりしたときに発生します。このリスクを軽減するには、モデル内で使用される前にサプライ チェーンを調べ、システムのデータ レビュー プロセスを理解する必要があります。トレーニング パイプラインはデータ ポイズニングの主な発生源ですが、RAG モデルやデータ レイクなどでモデルがデータを取得する方法や、そのデータのソースが信頼され保護されているかどうかも確認する必要があります。 AWS Security Hub、Amazon GuardDuty、Amazon Inspector などの AWS セキュリティ サービスを使用して、Amazon EC2、Amazon EKS、Amazon S3、 Amazon リレーショナル データベース サービス (Amazon RDS)、および新たな脅威の兆候である可能性のあるネットワーク アクセスを検出し、Detective を使用してセキュリティ調査を視覚化します。などのサービスの利用も検討しましょう。 アマゾン セキュリティ レイク AI/ML ワークロードに寄与する AWS 環境、SaaS プロバイダー、オンプレミス、クラウド ソースからのセキュリティ データを自動的に一元化する専用のデータレイクを作成することで、セキュリティ調査を加速します。

組織間の相互作用: 生成 AI のためのエンタープライズ ガバナンス ガードレールを実装する

ビジネスにおける生成 AI の使用に関連するリスクを特定します。生成型 AI ソリューションを導入する際には、組織のリスク分類を構築し、リスク評価を実施して情報に基づいた意思決定を行う必要があります。を開発する 事業継続計画(BCP) これには AI、ML、生成 AI ワークロードが含まれており、SLA を満たすために、影響を受ける LLM アプリケーションまたはオフラインの LLM アプリケーションの失われた機能を置き換えるために迅速に制定できます。

プロセスとリソースのギャップ、非効率、不一致を特定し、ビジネス全体の意識とオーナーシップを向上させます。 脅威モデル データへの不正アクセス、サービス妨害、リソースの誤用など、ビジネスに影響を及ぼす可能性のある潜在的なセキュリティ脅威を特定し、軽減するためのすべての生成 AI ワークロード。新しいものを活用する AWS Threat Composer モデリング ツール 脅威モデリングを実行する際の価値実現までの時間を短縮するのに役立ちます。開発サイクルの後半で、導入を含めることを検討してください。 セキュリティカオスエンジニアリング フォールト挿入実験を行って実際の状況を作成し、システムが未知のものにどのように反応するかを理解し、システムの回復力とセキュリティに対する信頼を築きます。

セキュリティ戦略とリスク管理メカニズムの開発に多様な視点を組み込むことで、すべての職務と機能にわたって AI/ML と生成型セキュリティの順守と適用範囲を確保します。生成 AI アプリケーションの開始と研究の段階からセキュリティの考え方を取り入れて、要件に合わせます。 AWS からの追加のサポートが必要な場合は、AWS セキュリティおよび AI/ML の AWS ソリューションアーキテクトに連携して支援を依頼することで、同等のサポートが確実に受けられるように AWS アカウントマネージャーに依頼してください。

セキュリティ組織が、プロダクト マネージャー、ソフトウェア開発者、データ サイエンティスト、経営幹部などの生成的 AI 関係者間のリスク認識とリスク管理の理解の両方に関するコミュニケーションを促進するための措置を定期的に講じて、脅威インテリジェンスと制御のガイダンスが脅威の可能性のあるチームに届くようにします。影響を受ける。セキュリティ組織は、ディスカッションに参加し、ビジネス目標に関連する生成 AI 関係者に新しいアイデアや情報を提供することで、責任ある開示と反復的な改善の文化をサポートできます。詳しくはこちら 責任ある AI への取り組み 追加 責任ある AI リソース お客様を助けるために。

組織の既存のセキュリティ プロセスにおける価値実現までの時間のブロックを解除することで、生成的 AI に対する組織の態勢を改善することで利点を得ることができます。生成的 AI のセキュリティ コンテキストを考慮すると、組織が過度に負担となるプロセスを必要とする可能性がある箇所を事前に評価し、これらを調整して、開発者や科学者に適切な制御を導入して開始するための明確な道筋を提供します。

インセンティブを調整し、リスクを回避し、望ましい結果について明確な見通しを提供する機会がどこにあるのかを評価します。アップデートは、AI/ML および生成 AI アプリケーション開発の進化するニーズに対応するためのガイダンスと防御を制御し、開発時間の損失、リスクの増大、影響の増大につながる混乱や不確実性を軽減します。

セキュリティの専門家ではない関係者が、組織のガバナンス、ポリシー、リスク管理の手順がワークロードにどのように適用されるかを理解し、リスク管理メカニズムを適用できるようにします。生成 AI アプリケーションで発生する可能性のある現実的なイベントやシナリオに組織が対応できるように準備し、生成 AI ビルダーの役割と対応チームが、不審なアクティビティが懸念される場合のエスカレーション パスとアクションを確実に認識できるようにします。

まとめ

新たなテクノロジーによるイノベーションの商業化を成功させるには、セキュリティ第一の考え方から始め、安全なインフラストラクチャ基盤を構築し、テクノロジー スタックの各レベルでセキュリティを早期に多層防御のセキュリティとさらに統合する方法を考える必要があります。アプローチ。これには、組織の回復力を確保するための、テクノロジー スタックの複数のレイヤーでのやり取りや、デジタル サプライ チェーン内の統合ポイントが含まれます。生成 AI によってセキュリティとプライバシーに新たな課題がいくつか生じますが、多層セキュリティ サービスによる多層防御の使用など、基本的なセキュリティのベスト プラクティスに従えば、多くの一般的な問題や進化する脅威から組織を保護することができます。生成 AI ワークロードと大規模な組織全体に階層化された AWS セキュリティ サービスを実装し、クラウド環境を保護するためにデジタル サプライ チェーンの統合ポイントに重点を置く必要があります。その後、Amazon SageMaker や Amazon Bedrock などの AWS AI/ML サービスの強化されたセキュリティおよびプライバシー機能を使用して、強化されたセキュリティおよびプライバシー制御のレイヤーを生成 AI アプリケーションに追加できます。最初からセキュリティを組み込むことで、コンプライアンスを簡素化しながら、生成 AI によるイノベーションをより迅速かつ簡単に、よりコスト効率よく行うことができます。これは、従業員、顧客、パートナー、規制当局、その他の関係者にとって、生成 AI アプリケーションの制御、信頼性、可観測性を高めるのに役立ちます。

追加の参考文献

- AI/ML 固有のリスク管理とセキュリティのための業界標準フレームワーク:

著者について

クリストファー・レイ プリンシパルワールドワイドセキュリティ GTM スペシャリストは、AWS セキュリティ サービスの導入を加速および拡大する戦略的イニシアチブの開発と実行に重点を置いています。彼はサイバーセキュリティと新興テクノロジーの交差点に情熱を持っており、メディア、エンターテイメント、通信の顧客にセキュリティ ソリューションを提供する世界的な戦略的リーダーの役割を 20 年以上経験しています。彼は、読書、旅行、食事とワイン、新しい音楽の発見、初期段階のスタートアップへのアドバイスを通じてエネルギーを充電しています。

クリストファー・レイ プリンシパルワールドワイドセキュリティ GTM スペシャリストは、AWS セキュリティ サービスの導入を加速および拡大する戦略的イニシアチブの開発と実行に重点を置いています。彼はサイバーセキュリティと新興テクノロジーの交差点に情熱を持っており、メディア、エンターテイメント、通信の顧客にセキュリティ ソリューションを提供する世界的な戦略的リーダーの役割を 20 年以上経験しています。彼は、読書、旅行、食事とワイン、新しい音楽の発見、初期段階のスタートアップへのアドバイスを通じてエネルギーを充電しています。

イライジャ・ウィンター Amazon セキュリティの上級セキュリティ エンジニアであり、サイバー セキュリティ エンジニアリングの理学士号を取得しており、ハリー ポッターへの愛が溢れています。イライジャは、技術的な専門知識と魔法のタッチを組み合わせて、AI システムの脆弱性を特定して対処することに優れています。 Elijah は AI エコシステム向けにカスタマイズされたセキュリティ プロトコルを設計し、デジタル防御に魔法のようなセンスをもたらします。誠実さを重視するイライジャは、公共部門と商業部門の両方の組織でセキュリティの経験があり、信頼の保護に重点を置いています。

イライジャ・ウィンター Amazon セキュリティの上級セキュリティ エンジニアであり、サイバー セキュリティ エンジニアリングの理学士号を取得しており、ハリー ポッターへの愛が溢れています。イライジャは、技術的な専門知識と魔法のタッチを組み合わせて、AI システムの脆弱性を特定して対処することに優れています。 Elijah は AI エコシステム向けにカスタマイズされたセキュリティ プロトコルを設計し、デジタル防御に魔法のようなセンスをもたらします。誠実さを重視するイライジャは、公共部門と商業部門の両方の組織でセキュリティの経験があり、信頼の保護に重点を置いています。

ラムヴィタル AWS のプリンシパル ML ソリューション アーキテクトです。 彼は、分散、ハイブリッド、クラウド アプリケーションの設計と構築に 3 年以上の経験があります。 彼は、安全でスケーラブルな AI/ML およびビッグ データ ソリューションを構築し、企業顧客のクラウド導入と最適化の取り組みを支援してビジネス成果を向上させることに情熱を注いでいます。 暇なときは、オートバイに乗ったり、3 歳のシーパドゥードルと散歩したりしています。

ラムヴィタル AWS のプリンシパル ML ソリューション アーキテクトです。 彼は、分散、ハイブリッド、クラウド アプリケーションの設計と構築に 3 年以上の経験があります。 彼は、安全でスケーラブルな AI/ML およびビッグ データ ソリューションを構築し、企業顧客のクラウド導入と最適化の取り組みを支援してビジネス成果を向上させることに情熱を注いでいます。 暇なときは、オートバイに乗ったり、3 歳のシーパドゥードルと散歩したりしています。

ナヴネ トゥテハ アマゾン ウェブ サービスのデータ スペシャリストです。 Navneet は、AWS に入社する前、データ アーキテクチャを最新化し、包括的な AI/ML ソリューションを実装しようとしている組織のファシリテーターとして働いていました。 彼女は、ターパー大学で工学の学位を取得し、テキサス A&M 大学で統計学の修士号を取得しています。

ナヴネ トゥテハ アマゾン ウェブ サービスのデータ スペシャリストです。 Navneet は、AWS に入社する前、データ アーキテクチャを最新化し、包括的な AI/ML ソリューションを実装しようとしている組織のファシリテーターとして働いていました。 彼女は、ターパー大学で工学の学位を取得し、テキサス A&M 大学で統計学の修士号を取得しています。

エミリー・スワード AWSProfessionalServicesのデータサイエンティストです。 彼女は、英国スコットランドのエジンバラ大学で、自然言語処理(NLP)に重点を置いて、人工知能の分野で卓越した科学の修士号を取得しています。 エミリーは、AI対応の製品研究開発、オペレーショナルエクセレンス、および公共部門と民間部門の組織で実行されているAIワークロードのガバナンスに焦点を当てた、応用科学およびエンジニアリングの役割を果たしてきました。 彼女はAWSシニアスピーカーとして、そして最近ではAWS Well-Architected in the MachineLearningLensの著者として顧客ガイダンスに貢献しています。

エミリー・スワード AWSProfessionalServicesのデータサイエンティストです。 彼女は、英国スコットランドのエジンバラ大学で、自然言語処理(NLP)に重点を置いて、人工知能の分野で卓越した科学の修士号を取得しています。 エミリーは、AI対応の製品研究開発、オペレーショナルエクセレンス、および公共部門と民間部門の組織で実行されているAIワークロードのガバナンスに焦点を当てた、応用科学およびエンジニアリングの役割を果たしてきました。 彼女はAWSシニアスピーカーとして、そして最近ではAWS Well-Architected in the MachineLearningLensの著者として顧客ガイダンスに貢献しています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/