数十億のパラメーターを持つ大規模言語モデル (LLM) は、現在、自然言語処理 (NLP) の最前線にあります。 これらのモデルは、テキストの生成、センチメントの分析、言語の翻訳など、驚くべき能力でこの分野を揺るがしています。 膨大な量のデータにアクセスできる LLM は、私たちが言語と対話する方法に革命をもたらす可能性を秘めています。 LLM はさまざまな NLP タスクを実行できますが、スペシャリストではなくジェネラリストと見なされます。 LLM を特定のドメインのエキスパートになるようにトレーニングするには、通常、微調整が必要です。

数十億のパラメーターを使用して LLM をトレーニングおよび展開する際の主な課題の XNUMX つは、そのサイズです。これにより、ディープ ラーニングに一般的に使用されるハードウェアである単一の GPU に LLM を適合させることが難しくなる可能性があります。 これらのモデルは非常に規模が大きいため、大量のメモリを備えた特殊な GPU などの高性能コンピューティング リソースが必要です。 さらに、これらのモデルのサイズによって計算コストが高くなり、トレーニングと推論の時間が大幅に増加する可能性があります。

この投稿では、使用方法を示します Amazon SageMaker ジャンプスタート モデルをトレーニングして展開するのと同じ方法で、ドメイン固有のデータセットで大規模な言語テキスト生成モデルを簡単に微調整する アマゾンセージメーカー. 特に、JumpStart SDK と Amazon SageMakerスタジオ 公開されている SEC ファイリングのデータセットの UI。

JumpStart は、機械学習 (ML) をすばやく簡単に開始するのに役立ち、いくつかの手順で簡単にトレーニングしてデプロイできる、最も一般的なユース ケース向けの一連のソリューションを提供します。 このデモのすべての手順は、付属のノートブックで利用できます ドメイン固有のデータセットでのテキスト生成 GPT-J 6B モデルの微調整.

ソリューションの概要

以下のセクションでは、JumpStart Studio UI と Python SDK の両方を使用して、テキスト生成タスク用に LLM を微調整するための段階的なデモンストレーションを提供します。 特に、次のトピックについて説明します。

- モデルが微調整されている金融ドメインの SEC ファイリング データの概要

- 微調整のために選択したLLM GPT-J 6Bモデルの概要

- JumpStart を使用して LLM を微調整する XNUMX つの異なる方法のデモンストレーション:

- SageMaker Python SDK でプログラムで JumpStart を使用する

- Studio UI を使用して JumpStart にアクセスする

- 微調整なしの事前トレーニング済みモデルと比較することによる微調整済みモデルの評価

微調整とは、事前にトレーニングされた言語モデルを取得し、特定のデータを使用して別の関連タスク用にトレーニングするプロセスを指します。 このアプローチは、 転移学習これには、あるタスクから学んだ知識を別のタスクに移すことが含まれます。 GPT-J 6B のような LLM は、大量のラベルのないデータでトレーニングされ、小規模なデータセットで微調整できるため、特定のドメインでモデルのパフォーマンスが向上します。

モデルを微調整するとパフォーマンスがどのように向上するかの例として、次の質問をすることを検討してください。

「Amazon の売上成長の原動力は何ですか?」

微調整しないと、応答は次のようになります。

「アマゾンは世界最大のオンライン小売業者です。 また、世界最大のオンライン市場でもあります。 それも世界だ」

微調整すると、応答は次のようになります。

「Amazon での売上高の伸びは、主に、品揃えの増加、価格の低下、利便性の向上、および当社のウェブサイトでの他の販売者による売上の増加など、顧客の利用の増加によってもたらされています。」

微調整による改善は明らかです。

SEC ファイリングの財務テキストを使用して、GPT-J 6B LLM を財務アプリケーション用に微調整します。 次のセクションでは、微調整するデータと LLM を紹介します。

SEC ファイリング データセット

SEC への提出書類は、金融における規制と情報開示にとって重要です。 ファイリングは、企業のビジネス状況と企業の将来の見通しについて投資家コミュニティに通知します。 SEC ファイリングのテキストは、企業の業務とビジネス状況の全範囲をカバーしています。 これらのファイリングは潜在的な予測価値があるため、投資家にとって優れた情報源です。 これらのSECファイリングは 公に利用可能 誰にとっても、解析されたファイリングをダウンロードし、機能が追加されたクリーンなデータセットを構築することは、時間のかかる作業です。 JumpStart のいくつかの API 呼び出しでこれを可能にします。 業界 SDK.

SageMaker API を使用して、年次レポートをダウンロードしました (10-Kファイリング; 湖 10-K の読み方 詳しくは) 多数の企業向け。 GPT-J 2021B モデルを微調整するためのトレーニング データとして、Amazon の 2022 ~ 6 年の SEC ファイリング レポートを選択します。 特に、会社の経営陣による将来の見通しに関する記述を含み、検証データとして使用される「経営陣の議論と分析」セクションを除いて、異なる年の会社の SEC ファイリング レポートを XNUMX つのテキスト ファイルに連結します。

金融 SEC ドキュメントで GPT-J 6B テキスト生成モデルを微調整した後、モデルは洞察に満ちた金融関連のテキスト出力を生成できるため、複数のドメイン固有の NLP タスクを解決するために使用できることが期待されます。

GPT-J 6B 大言語モデル

GPT-J6B は Eleuther AI が公開したオープンソースの 6 億パラメータ モデルです。 GPT-J 6B は、テキスト データの大規模なコーパスでトレーニングされており、テキスト生成、テキスト分類、テキスト要約などのさまざまな NLP タスクを実行できます。 このモデルは、微調整を必要としない多くの NLP タスクで優れていますが、多くの場合、解決しようとしている特定のデータセットと NLP タスクでモデルを微調整する必要があります。 ユース ケースには、カスタム チャットボット、アイデア生成、エンティティ抽出、分類、感情分析が含まれます。

SageMaker で LLM にアクセスする

微調整するデータセットとモデルを特定したので、JumpStart は、テキスト生成の微調整の使用を開始するための XNUMX つの手段を提供します: SageMaker SDK と Studio。

SageMakerSDKでJumpStartをプログラムで使用する

ここでは、SageMaker JumpStart SDK を使用して LLM (GPT-J 6B) にアクセスし、SEC ファイリング データセットで微調整する方法の例について説明します。 微調整が完了したら、微調整されたモデルをデプロイし、それに対して推論を行います。 この投稿のすべての手順は、付属のノートブックで利用できます。 ドメイン固有のデータセットでのテキスト生成 GPT-J 6B モデルの微調整.

この例では、JumpStart は SageMaker Hugging Face 深層学習コンテナ (DLC)と ディープスピード モデルを微調整するためのライブラリ。 DeepSpeed ライブラリは、コンピューティング能力とメモリ使用量を削減し、既存のコンピューター ハードウェア上で優れた並列処理を使用して大規模な分散モデルをトレーニングできるように設計されています。 単一ノードの分散トレーニングをサポートし、勾配チェックポイントとモデルの並列処理を利用して、複数の GPU を備えた単一の SageMaker トレーニング インスタンスで大規模なモデルをトレーニングします。 JumpStart では、DeepSpeed ライブラリを SageMaker Hugging Face DLC と統合し、内部のすべてを処理します。 手動で設定しなくても、ドメイン固有のデータセットでモデルを簡単に微調整できます。

ドメイン固有のデータで事前トレーニング済みのモデルを微調整する

選択したモデルを微調整するには、そのモデルの URI、トレーニング スクリプト、およびトレーニングに使用されるコンテナー イメージを取得する必要があります。 簡単にするために、これら XNUMX つの入力は、モデル名、バージョンのみに依存します (使用可能なモデルのリストについては、 事前トレーニング済みのモデル テーブルを使用した組み込みアルゴリズム)、およびトレーニングするインスタンスのタイプ。 これは、次のコードスニペットで示されています。

を取得します model_id 使用したい同じモデルに対応します。 この場合、微調整を行います huggingface-textgeneration1-gpt-j-6b.

ハイパーパラメータの定義には、ML モデルのトレーニング プロセス中に使用されるさまざまなパラメータの値の設定が含まれます。 これらのパラメーターは、モデルのパフォーマンスと精度に影響を与える可能性があります。 次のステップでは、デフォルト設定を利用し、次のようなパラメーターのカスタム値を指定して、ハイパーパラメーターを確立します。 epochs & learning_rate:

JumpStart は、調整可能なハイパーパラメータの広範なリストを提供します。 次のリストは、モデルの微調整に使用される主要なハイパーパラメーターの一部の概要を示しています。 ハイパーパラメータの完全なリストについては、ノートブックを参照してください ドメイン固有のデータセットでのテキスト生成 GPT-J 6B モデルの微調整.

- エポック – 元のデータセットの最大何エポックを反復するかを指定します。

- Learning_rate – トレーニング中の最適化アルゴリズムのステップ サイズまたは学習率を制御します。

- eval_steps – トレーニング中に検証セットでモデルを評価する前に実行するステップ数を指定します。 検証セットは、トレーニングには使用されないデータのサブセットですが、代わりに、目に見えないデータに対するモデルのパフォーマンスをチェックするために使用されます。

- 体重の減衰 – モデルのトレーニング中に正則化の強度を制御します。 正則化は、モデルがトレーニング データにオーバーフィットするのを防ぐのに役立つ手法です。これにより、目に見えないデータのパフォーマンスが向上する可能性があります。

- fp16 – 16 ビット トレーニングの代わりに fp16 32 ビット (混合) 精度トレーニングを使用するかどうかを制御します。

- 評価戦略 – トレーニング中に使用される評価戦略。

- gradient_accumulation_steps – 逆方向/更新パスを実行する前に、勾配を累積する更新ステップの数。

ハイパーパラメータの詳細については、公式を参照してください。 ハグフェイス トレーナーのドキュメント.

SageMaker SDK を使用して、独自のカスタム データセットでこの JumpStart モデルを微調整できるようになりました。 前述の SEC ファイリング データを使用します。 トレーニングと検証データは以下でホストされています train_dataset_s3_path & validation_dataset_s3_path. サポートされているデータ形式には、CSV、JSON、および TXT が含まれます。 CSV および JSON データの場合、テキスト データは、呼び出された列から使用されます。 text text という列が見つからない場合は最初の列。 これはテキスト生成の微調整のためであるため、グラウンド トゥルース ラベルは必要ありません。 次のコードは、モデルを微調整する方法の SDK の例です。

必要なハイパーパラメータで SageMaker Estimator をセットアップした後、SageMaker estimator をインスタンス化し、 .fit モデルの微調整を開始するメソッド Amazon シンプル ストレージ サービス (Amazon S3) トレーニング データの URI。 ご覧のとおり、 entry_point 提供されるスクリプトの名前は transfer_learning.py (他のタスクやモデルでも同じ)、およびに渡される入力データチャネル .fit train および validation という名前にする必要があります。

JumpStart は、ハイパーパラメータの最適化もサポートしています。 SageMaker自動モデル調整. 詳細については、例を参照してください ノート.

微調整されたモデルを展開する

トレーニングが完了すると、微調整されたモデルを展開できます。 そのために必要なのは、推論スクリプトURI(デプロイ後にモデルが推論にどのように使用されるかを決定するコード)と、選択したモデルをホストする適切なモデルサーバーを含む推論コンテナイメージURIだけです。 次のコードを参照してください。

数分後、モデルがデプロイされ、リアルタイムでモデルから予測を取得できます。

StudioUIからJumpStartにアクセスします

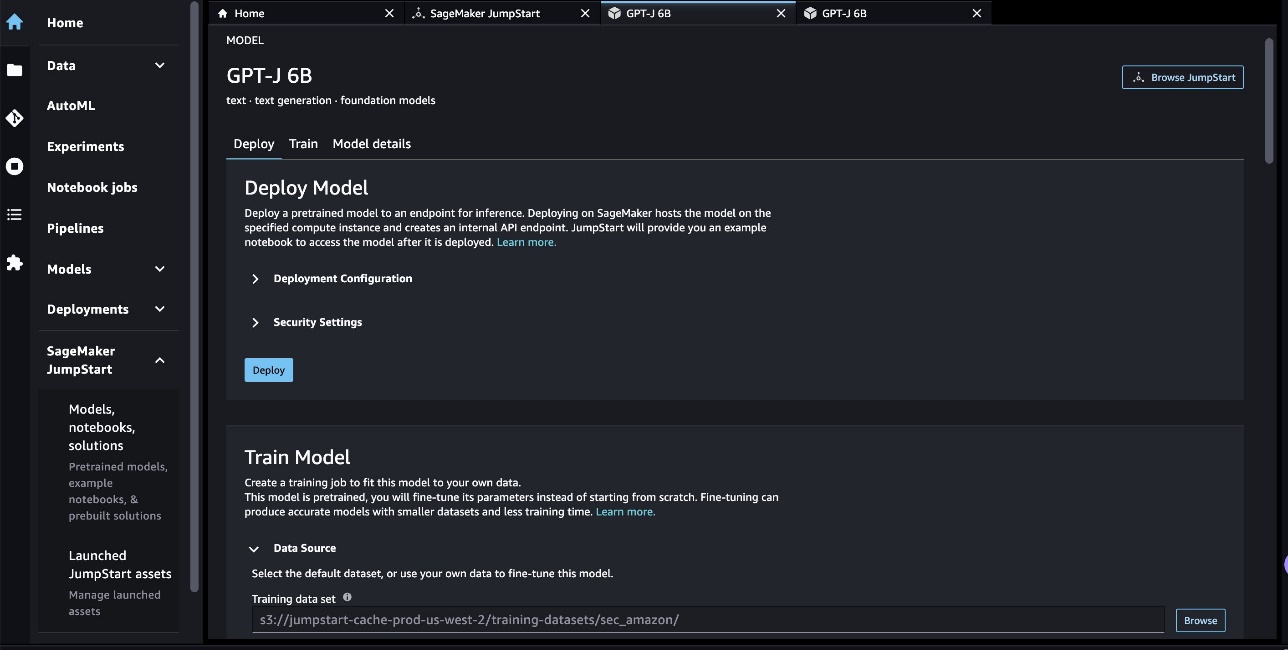

JumpStart モデルを微調整してデプロイするもう XNUMX つの方法は、Studio UI を使用することです。 この UI は、LLM を微調整するためのローコード/ノーコード ソリューションを提供します。

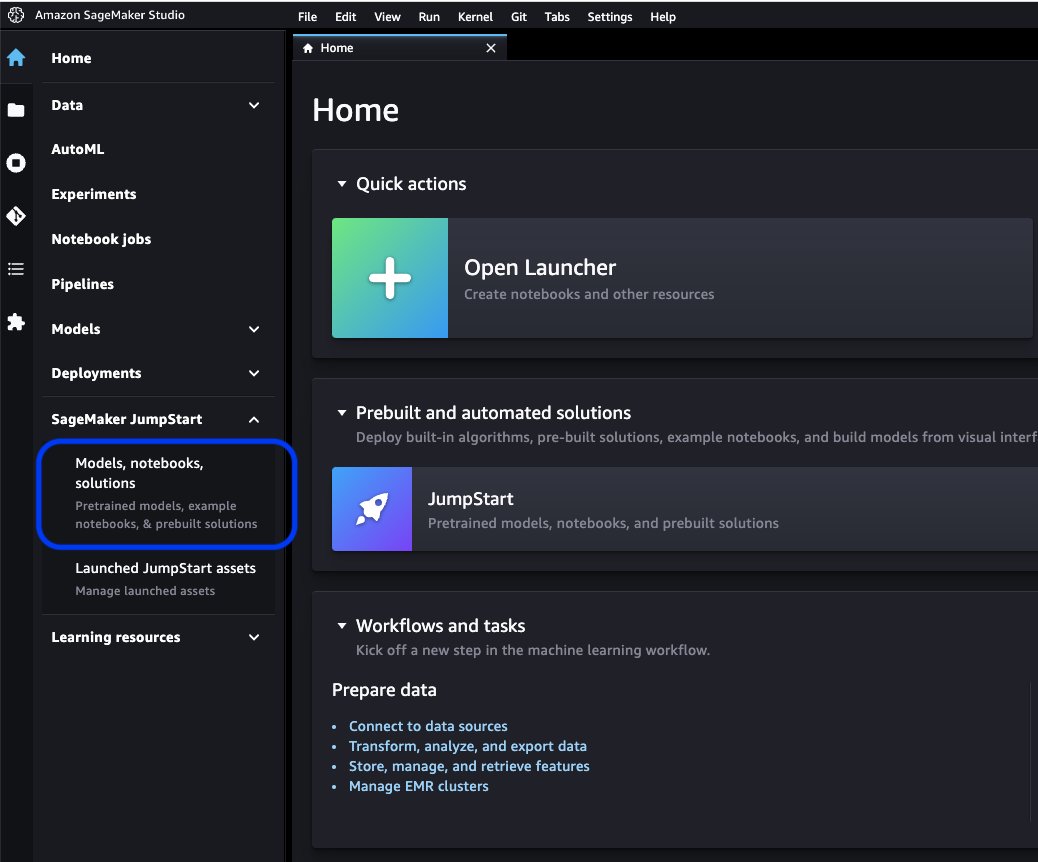

Studioコンソールで、 モデル、ノートブック、ソリューション 下 SageMaker ジャンプスタート ナビゲーションペインに表示されます。

検索バーで、微調整してデプロイするモデルを検索します。

私たちの場合、GPT-J 6B モデル カードを選択しました。 ここで、LLM を直接微調整またはデプロイできます。

モデル評価

LLM を評価するときは、perplexity (PPL) を使用できます。 PPL は、言語モデルがシーケンス内の次の単語をどれだけうまく予測できるかを示す一般的な尺度です。 簡単に言えば、モデルが人間のような言語をどれだけ理解し、生成できるかを測定する方法です。

perplexity スコアが低いということは、モデルが次の単語をより適切に予測できることを示していることを意味します。 実際には、perplexity を使用してさまざまな言語モデルを比較し、特定のタスクでどちらが優れているかを判断できます。 これを使用して、単一モデルのパフォーマンスを経時的に追跡することもできます。 詳細については、を参照してください。 固定長モデルの難しさ.

微調整前と微調整後のパフォーマンスを比較して、モデルのパフォーマンスを評価します。 PPL はトレーニング ジョブの アマゾンクラウドウォッチ ログ。 さらに、特定のテスト プロンプトに応答してモデルによって生成された出力を調べます。

| 検証データの評価指標 | 微調整前 | 微調整後 |

| 困惑 (PPL) | 8.147 | 1.437 |

モデルの強化されたパフォーマンスは、次の XNUMX つの実験で実証されています。

- テキスト生成 – 微調整された GPT-J の出力が、SEC データセットに類似したテキストを生成することを示します。これは、金融規制ドメインの言語パターンと慣習をエミュレートすることを学習したことを示しています。

- ゼロショット学習 – 微調整された GPT-J は、微調整されていない GPT-J よりも、ゼロ ショットの質問応答で大幅に優れたパフォーマンスを示すことが実証されました。

テキスト生成実験では、次の推論パラメーターを使用して結果を達成します。 max_length 400 個 (返されたトークンの数)、 num_return_sequences of 1 (応答テキストの例の数)、 top_k 250 の (上位 250 の可能な継続の XNUMX つから選択)、 top_p 0.8 (少なくとも 80% の可能性がある継続からのみ選択)、 do_sample is True (サンプリング)、および temperature 1 (温度が高いほど応答のランダム性が高くなります)。 パラメータの詳細については、次を参照してください。 世代構成. 次の表は、テキスト補完タスクで微調整された GPT-J と微調整されていない GPT-J を比較したものです。

| 推論例 | 微調整前のGPT-J 6B出力 | 微調整後のGPT-J 6Bからの出力 |

| この Form 10-K レポートは、 |

この Form 10-K レポートは、次のことを示しています。 31 年 2016 月 3,923,000 日に終了した年度の当社に帰属する当社の純利益は、0.21 年 3,818,000 月 0.21 日に終了した年度の 31 ドルまたは希薄化後 2015 株あたり XNUMX ドルと比較して、XNUMX ドルまたは希薄化後 XNUMX 株あたり XNUMX ドルでした。 31 年 2016 月 4,816,000 日に終了した年度の当社に帰属する当社の純利益は、0.28 年 4,726,000 月 0.27 日に終了した年度の 31 ドルまたは希薄化後 2015 株あたり XNUMX ドルと比較して、XNUMX ドルまたは希薄化後 XNUMX 株あたり XNUMX ドルでした。 31 年 2016 月 5,828,000 日に終了した年度の当社に帰属する当社の純利益は、0.34 年 5,716,000 月 0.33 日に終了した年度の 31 ドルまたは希薄化後 2015 株あたり XNUMX ドルと比較して、XNUMX ドルまたは希薄化後 XNUMX 株あたり XNUMX ドルでした。 21 年 2009 月 10 日、当社は 31 年 2008 月 XNUMX 日に終了した四半期のフォーム XNUMX-Q を提出しました。 21 年 2009 月 10 日、当社は 30 年 2008 月 XNUMX 日に終了した四半期のフォーム XNUMX-Q を提出しました。 21 年 2009 月 10 日、当社は 31 年 2009 月 XNUMX 日に終了した四半期のフォーム XNUMX-Q を提出しました。 |

このフォーム 10-K レポートは次のことを示しています。(1) 登録者の名前、住所、および電話番号は次のとおりです。Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington 2 年証券取引法第 1934 条の目的のため、登録者の名前および住所は次のとおりです。本レポートに含まれる財務諸表およびその他の財務情報が、すべての重要な点において、本レポートに示されている期間および現在の登録会社の財務状況、経営成績およびキャッシュフローを公正に表していること。 (3) 登録会社の経営陣の評価は、本報告書に含まれる財務諸表およびその他の財務情報が、本報告書に示されている期間現在および期間中の登録会社の財政状態、経営成績およびキャッシュフローをすべての重要な点で公正に示していることである./s/ Ernst & Young LLPSeattle, Washington1 年 2020 月 4 日EX-5 29 amzn-2020xex31.1.htm EX-5 DocumentExhibit 20201231CERTIFICATIONSI, Andrew R. Jassy, certify that:311. Amazon.com, Inc. のこの Form 31.1-K を確認しました;31.1. 私の知る限りでは、この報告書は重要な事実の虚偽の記述を含んでおらず、また、そのような記述がなされた状況に照らして、この報告書が対象とする期間に関して誤解を招くものではなく、なされた記述を行うために必要な重要な事実の記述を省略していません。報告; |

| 私たちは消費者にサービスを提供します |

私たちは以下を通じて消費者にサービスを提供します。 ブログ あなたはビジネスを成長させたいビジネスオーナーですか? より効果的で効率的なビジネスを作りたいですか? ビジネスを成長させる方法を学びたいですか? これらの質問のいずれかに「はい」と答えた場合は、この記事を読む必要があります。 ビジネスを成長させるための最初のステップは、ビジネスを理解することです。 ビジネスに関する次の質問に答えることができなければなりません。 あなたの顧客は誰ですか? あなたの製品またはサービスは何ですか? あなたのユニークな販売提案は何ですか? あなたのマーケティング戦略は何ですか? 売上予測は? 売上予測は? 売上予測は? 売上予測は? 売上予測は? |

Amazon.com は物理的およびデジタル製品の小売業者です。 事実上あらゆる種類のビジネスを可能にするテクノロジー インフラストラクチャ サービスを提供するアマゾン ウェブ サービス。 より良いビジネス プロセスを可能にし、効率と生産性を向上させるカスタム テクノロジとサービスを企業に提供する Amazon Enterprise Solutions。 そして、デジタル オーディオブックの出版社である Audible です。 AWS を通じて、あらゆる規模の開発者や企業にサービスを提供しています。AWS は、グローバルなコンピューティング、ストレージ、データベース、およびその他のサービスを幅広く提供しています。 また、電子機器の製造・販売も行っています。 当社の事業は、北米と国際という 8 つの主要なセグメントに編成されています。 第Ⅱ部第12項「財務諸表及び補足資料-注記7-セグメント情報」参照 第Ⅱ部第100項「財政状態及び経営成績に関する経営者の考察及び分析-経営成績-補足情報」参照消費者オンラインおよび実店舗を通じて消費者にサービスを提供し、選択、価格、利便性に重点を置いています。 私たちは、数十の製品カテゴリにわたって数億のユニークな製品を私たちおよびサードパーティによって販売できるようにストアを設計しています. 顧客は、当社の Web サイト、モバイル アプリ、Alexa を通じて、また実際に店舗を訪れて、当社のサービスにアクセスします。 また、Kindleデバイスの製造・販売も行っています。 私たちは、毎日の製品価格設定と配送のオファーを通じて可能な限り低価格を顧客に提供し、顧客のために価格を引き下げ続けることができるように業務効率を改善するよう努めています. また、使いやすい機能、迅速で信頼性の高いフルフィルメント、タイムリーなカスタマー サービスも提供します。さらに、XNUMX 億を超えるアイテムの無制限の送料無料、数万の映画の無制限のストリーミングへのアクセス、およびテレビのエピソード、およびその他の特典。 |

| 今年は特に力を入れている |

今年は特に次のことに重点を置いています。 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 肥満と糖尿病の予防における医療制度の役割 |

今年は、特に次のことに重点を置いています。 ・既存顧客への売上増や新規顧客の獲得など、顧客基盤の拡大。 - 新しいビジネスの機会を開発し、ライセンスやその他の取り決めを通じて、他の企業との間で、または他の企業の買収を通じて、商業協定を結ぶ; -強化された顧客サービスを提供し、当社の製品とサービスを効率的に提供する技術の開発。 - 新しい製品およびサービスの提供を開発し、これらを既存および新しい製品およびサービスの提供に組み込む。 -当社のビジネスをサポートするための効率的かつ効果的なシステムの開発;および -その他のビジネスおよび戦略的イニシアチブ。 お客様に低価格を提供することは、当社の将来の成功の基本であると考えています。 低価格を提供する方法の 8 つは、製品を配送するための正味費用が発生する送料無料のオファーと、何百万もの商品を送料無料で提供し、映画やその他のコンテンツへのアクセスを提供する Amazon プライムのメンバーシップを利用することです。 また、純売上原価の削減を可能にする他のプロモーションも提供しています。当社の事業は、北米と国際という 12 つの主要なセグメントに編成されています。 パート II の項目 7「財務諸表および補足データ - 注記 XNUMX - セグメント情報」を参照してください。純売上高に関する補足情報。 |

ゼロショットの質問応答タスクを使用した XNUMX 番目の実験では、次のように設定しました。 max_length 各質問から期待される出力に基づいて、異なる値 (それぞれ 40、200、および 40) になります。 のパラメータ top_k, top_p, do_sample, temperature 250、0.8、 False、および 0 です。 出力のランダム性を制御するために温度を 0 に近い値に設定しますが、テキスト生成タスクでは、モデルをより創造的にするために 1 に近い値に設定します。 次の表は、結果を比較したものです。 各質問について、微調整された GPT-J からの出力は、微調整されていないものよりも正確です。

| 入力 | 微調整前のGPT-J 6B出力 | 微調整後のGPT-J 6Bからの出力 |

| 7-K SEC ファイリングの項目 10 とは何ですか?: |

7-K SEC ファイリングの項目 10 とは何ですか?: 7-K SEC ファイリングの項目 10 は次のとおりです。 「当社は重大な不利益を受け取っていません |

Item 7. 財務状況および経営成績に関する経営陣の考察および分析 将来の見通しに関する記述 |

| COVID-19 のパンデミックは、Amazon のビジネスにどのような影響を与えましたか?: |

COVID-19 のパンデミックは、Amazon のビジネスにどのような影響を与えましたか?: Amazon のビジネスは、COVID-19 パンデミックの影響をさまざまな形で受けています。 同社は、ビジネスの大部分を占めるプライム会員数の減少を目の当たりにしています。 同社はまた、プライム会員数の減少も見ています。 アマゾンのウェブサイトでの注文数も減少している。 同社はまた、ウェブサイトで買い物をする人の数も減少していると見ています。 アマゾンのウェブサイトで買い物をする人の数も減少しています。 アマゾンのウェブサイトで買い物をする人の数も減少しています。 アマゾンのウェブサイトで買い物をする人の数も減少しています。 Amazonでも買い物をする人の数が減少している |

COVID-19 パンデミックは Amazon のビジネスにどのような影響を与えましたか?: COVID-19 パンデミックは、Amazon のビジネスにいくつかの方法で影響を与えました。 第 8 に、サプライ チェーンが混乱し、顧客の需要に影響を与え、その結果、当社の売上と業績に影響を与えました。 第二に、広告とマーケティングへの支出が増えましたが、長期的には効果がない可能性があります. 第三に、テクノロジー インフラストラクチャとコンピューティング キャパシティへの支出が増加しましたが、これは長期的には効果的ではない可能性があります。 第 1 に、フルフィルメントとカスタマー サービスへの支出が増加しましたが、これは長期的には効果的ではない可能性があります。 最後に、コンテンツへの支出が増加しましたが、これは長期的には効果がない可能性があります. パート II の項目 XNUMX「財務諸表および補足データ - 注 XNUMX - 事業および会計方針の説明」を参照してください。 |

| Amazon の売上成長の原動力は何ですか?: | アマゾンは世界最大のオンライン小売業者です。 また、世界最大のオンライン市場でもあります。 それは世界でもある」 | Amazon での売上高の伸びは、主に、品揃えの増加、価格の低下、利便性の向上などの顧客の利用の増加、および当社の Web サイトでの他の販売者による売上の増加によってもたらされています。 |

クリーンアップ

継続的な課金を回避するには、SageMaker 推論エンドポイントを削除してください。 次のコマンドを使用して、SageMaker コンソールまたはノートブックからエンドポイントを削除できます。

まとめ

JumpStart は、ML をすぐに使い始めることができる SageMaker の機能です。 JumpStart は、オープンソースの事前トレーニング済みモデルを使用して、画像分類、オブジェクト検出、テキスト分類、文ペア分類、質問応答などの一般的な ML 問題を解決します。

この投稿では、SEC 充填データセットに基づいてテキストを生成するために、事前トレーニング済みの LLM (GPT-J 6B) を微調整してデプロイする方法を紹介しました。 私たちは、会社のわずか XNUMX つの年次報告書の微調整プロセスを経て、モデルがどのように金融分野の専門家に変化したかを示しました。 この微調整により、モデルは金融トピックを理解し、より正確なコンテンツを生成できるようになりました。 自分で解決策を試してみて、コメントでそれがどうなるか教えてください.

重要: この投稿は説明のみを目的としています。 これは財務に関するアドバイスではなく、財務または投資に関するアドバイスとして依拠すべきではありません。 この投稿では、SEC EDGAR データベースから取得したデータで事前トレーニングされたモデルを使用しました。 SEC データを使用する場合は、EDGAR のアクセス条件を遵守する責任があります。

JumpStart の詳細については、次の投稿をご覧ください。

著者について

XinHuang博士 Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの上級応用科学者です。 スケーラブルな機械学習アルゴリズムの開発に注力しています。 彼の研究対象は、自然言語処理、表形式データの説明可能なディープ ラーニング、およびノンパラメトリック時空クラスタリングの堅牢な分析の分野です。 彼は、ACL、ICDM、KDD カンファレンス、Royal Statistical Society: Series A で多くの論文を発表しています。

XinHuang博士 Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの上級応用科学者です。 スケーラブルな機械学習アルゴリズムの開発に注力しています。 彼の研究対象は、自然言語処理、表形式データの説明可能なディープ ラーニング、およびノンパラメトリック時空クラスタリングの堅牢な分析の分野です。 彼は、ACL、ICDM、KDD カンファレンス、Royal Statistical Society: Series A で多くの論文を発表しています。

マーク・カープ Amazon SageMaker Service チームの ML アーキテクトです。 彼は、お客様が大規模な ML ワークロードを設計、デプロイ、管理できるよう支援することに重点を置いています。 余暇には、旅行や新しい場所の探索を楽しんでいます。

マーク・カープ Amazon SageMaker Service チームの ML アーキテクトです。 彼は、お客様が大規模な ML ワークロードを設計、デプロイ、管理できるよう支援することに重点を置いています。 余暇には、旅行や新しい場所の探索を楽しんでいます。

サンジブ・ダス博士 アマゾンの学者であり、サンタクララ大学の財務およびデータサイエンスのテリー教授です。 彼は、財務(ニューヨーク大学でM.PhilとPhD)とコンピューターサイエンス(カリフォルニア大学バークレー校で修士号)の大学院の学位を取得し、アーメダバードのインド経営研究所でMBAを取得しています。 学者になる前は、シティバンクの副社長としてアジア太平洋地域のデリバティブ事業に従事していました。 彼は金融アプリケーションの分野でマルチモーダル機械学習に取り組んでいます。

サンジブ・ダス博士 アマゾンの学者であり、サンタクララ大学の財務およびデータサイエンスのテリー教授です。 彼は、財務(ニューヨーク大学でM.PhilとPhD)とコンピューターサイエンス(カリフォルニア大学バークレー校で修士号)の大学院の学位を取得し、アーメダバードのインド経営研究所でMBAを取得しています。 学者になる前は、シティバンクの副社長としてアジア太平洋地域のデリバティブ事業に従事していました。 彼は金融アプリケーションの分野でマルチモーダル機械学習に取り組んでいます。

アルン・クマール・ロカナサ Amazon SageMaker サービスチームのシニア ML ソリューションアーキテクトです。 彼は、お客様が ML 本番ワークロードを大規模に構築、トレーニング、および SageMaker に移行するのを支援することに重点を置いています。 彼は深層学習、特に NLP と CV の分野を専門としています。 仕事以外では、ランニングとハイキングを楽しんでいます。

アルン・クマール・ロカナサ Amazon SageMaker サービスチームのシニア ML ソリューションアーキテクトです。 彼は、お客様が ML 本番ワークロードを大規模に構築、トレーニング、および SageMaker に移行するのを支援することに重点を置いています。 彼は深層学習、特に NLP と CV の分野を専門としています。 仕事以外では、ランニングとハイキングを楽しんでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- Platoblockchain。 Web3メタバースインテリジェンス。 知識の増幅。 こちらからアクセスしてください。

- 未来を鋳造する w エイドリエン・アシュリー。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/financial-text-generation-using-a-domain-adapted-fine-tuned-large-language-model-in-amazon-sagemaker-jumpstart/