この投稿は書かれました PwC オーストラリアのクラウド & デジタル ビジネスの Ankur Goyal 氏と Karthikeyan Chokappa 氏との共同研究です。

人工知能 (AI) と機械学習 (ML) はシステムとプロセスに不可欠な部分になりつつあり、リアルタイムでの意思決定を可能にし、それによって組織全体の売上高と収益の改善を促進します。ただし、ML モデルを大規模な運用環境に導入することは困難であり、一連のベスト プラクティスが必要です。多くの企業には、最先端のモデルを構築できるデータ サイエンティストや ML エンジニアがすでにいますが、モデルを本番環境に導入し、大規模にモデルを維持することは依然として課題です。手動ワークフローでは ML ライフサイクル操作が制限され、開発プロセスが遅くなり、コストが増加し、最終製品の品質が低下します。

機械学習オペレーション (MLOps) は、DevOps の原則を ML システムに適用します。 DevOps がソフトウェア エンジニアリングの開発と運用を結合するのと同じように、MLOps は ML エンジニアリングと IT 運用を結合します。 ML システムおよび ML エンジニアリングのコンテキストにおける急速な成長に伴い、MLOps は、ML システムの実際のアプリケーション特有の複雑さを処理するために必要な機能を提供します。全体として、ML のユースケースには、MLOps を使用して ML モデルを開発から本番展開まで大規模に行うプロセスを工業化および合理化するために、すぐに利用できる統合ソリューションが必要です。

これらの顧客の課題に対処するために、PwC オーストラリアは、ML ライフサイクル運用全体を通じてチーム間の部門間のコラボレーションを可能にする AI/ML モデルの運用性を向上させる、標準化されたプロセスとテクノロジー機能のセットとして Machine Learning Ops Accelerator を開発しました。 PwC Machine Learning Ops Accelerator は、AWS ネイティブ サービス上に構築されており、あらゆる業界の顧客に ML ユースケースに簡単に統合できる、目的に合ったソリューションを提供します。この投稿では、ML モデルのさまざまなライフサイクル コンポーネントを統合し、継続的インテグレーション (CI)、継続的デリバリー (CD)、継続的トレーニング (CT)、継続的モニタリング (CM) を可能にする ML ユースケースの構築とデプロイに焦点を当てます。

ソリューションの概要

MLOps では、データから ML モデル、そしてビジネス システムやプロセスにおける推奨事項や予測への移行を成功させるには、いくつかの重要な手順が必要です。これには、実験またはプロトタイプの結果を取得し、それを標準の制御、品質、およびフィードバック ループを備えた生産システムに変換することが含まれます。それは単なる自動化ではありません。それは、組織の実践を改善し、大規模かつ再現可能な成果をもたらすことです。

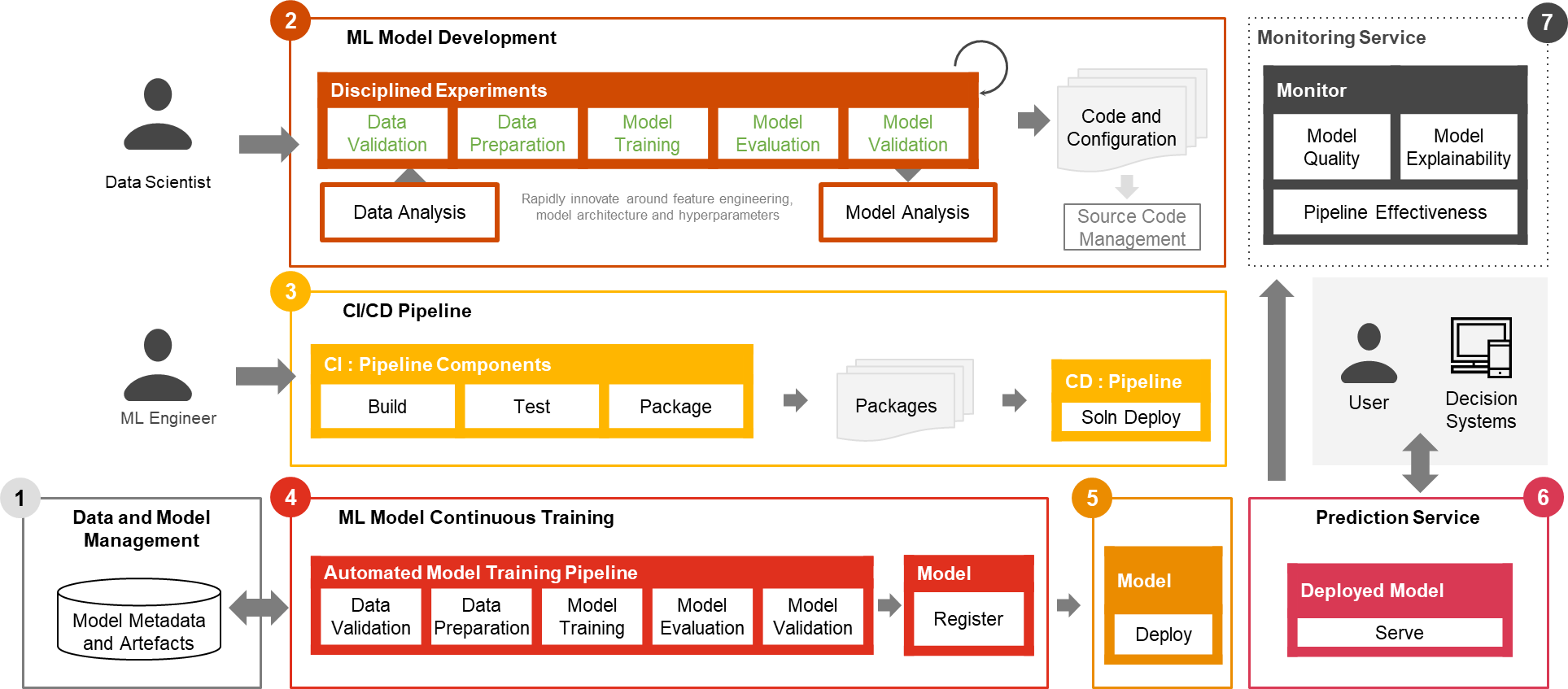

モデル自体を構成するのは、実際の ML ユースケースのほんの一部だけです。統合された高度な ML 機能を構築し、それを大規模に継続的に運用するために必要なさまざまなコンポーネントを図 1 に示します。次の図に示すように、PwC MLOps アクセラレータは XNUMX つの主要な統合機能と、CI、CD、CT、およびML ユースケースの CM。このソリューションは、AWS のネイティブ機能を利用します。 アマゾンセージメーカー、これを中心に柔軟で拡張可能なフレームワークを構築します。

図 1 – – PwC Machine Learning Ops Accelerator の機能

実際の企業シナリオでは、さまざまな環境にわたるモデルの厳密な検証と展開を確実にするために、テストの追加のステップと段階が存在する場合があります。

- データとモデルの管理 ライフサイクル全体を通じて ML アーティファクトを管理する中心的な機能を提供します。これにより、監査可能性、トレーサビリティ、およびコンプライアンスが可能になります。また、ML 資産の共有性、再利用性、発見性も向上します。

- ML モデルの開発 これにより、さまざまな担当者が、データの検証と変換からモデルのトレーニングと評価までの一連のステップで構成される、堅牢で再現可能なモデル トレーニング パイプラインを開発できます。

- 継続的インテグレーション/デリバリー モデル トレーニング パイプラインの自動構築、テスト、パッケージ化と、ターゲットの実行環境へのデプロイを容易にします。 CI/CD ワークフローとデータのバージョン管理との統合により、反復開発やデータのバージョン管理のためのガバナンスや監視などの MLOps のベスト プラクティスが促進されます。

- ML モデルの継続的なトレーニング 機能は、再トレーニング トリガーに基づいてトレーニング パイプラインを実行します。つまり、新しいデータが利用可能になったとき、またはモデルのパフォーマンスが事前に設定されたしきい値を下回ったときです。成功したモデル候補として適格な場合、トレーニング済みモデルを登録し、トレーニング アーティファクトと関連するメタデータを保存します。

- モデルの展開 登録されたトレーニング済みモデルにアクセスして実稼働リリースをレビューおよび承認できるようになり、モデルのパッケージ化、テスト、および実稼働サービス用の予測サービス環境へのデプロイが可能になります。

- 予測サービス この機能により、デプロイされたモデルが開始され、オンライン、バッチ、またはストリーミング パターンを通じて予測が提供されます。サービス提供ランタイムは、継続的な監視と改善のためにモデル提供ログもキャプチャします。

- 継続的な監視 モデルの減衰とサービスの有効性 (レイテンシ、パイプライン全体、および実行エラー) を検出するための予測有効性についてモデルを監視します。

PwC Machine Learning Ops Accelerator アーキテクチャ

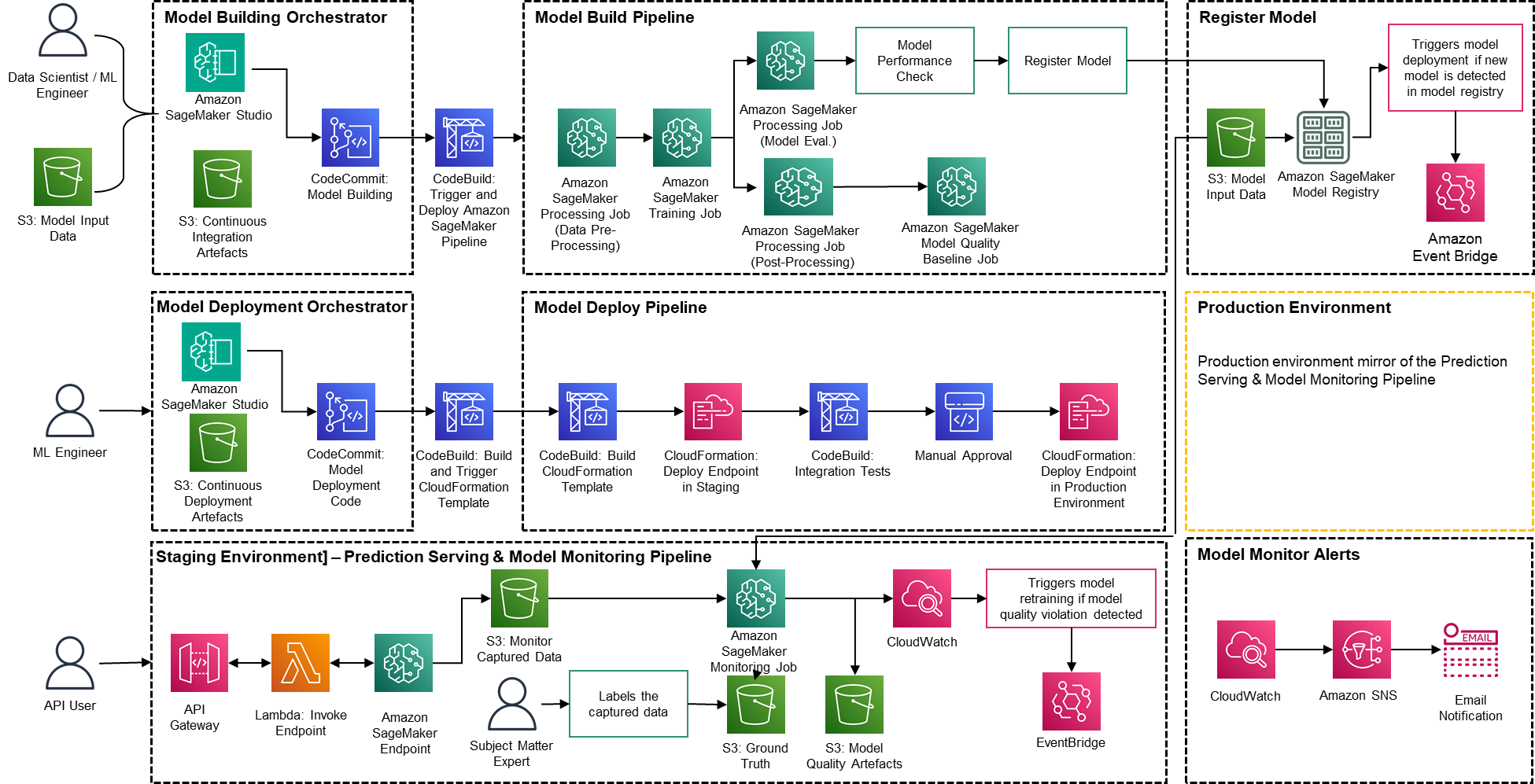

このソリューションは、Amazon SageMaker とサーバーレステクノロジーを使用した AWS ネイティブのサービス上に構築されており、パフォーマンスとスケーラビリティを高く保ち、ランニングコストを低く抑えています。

図 2 – PwC Machine Learning Ops Accelerator アーキテクチャ

- PwC Machine Learning Ops Accelerator は、構築、使用、運用のためのペルソナ主導のアクセス資格を提供し、ML エンジニアやデータ サイエンティストがパイプラインの展開 (トレーニングとサービス) を自動化し、モデルの品質の変化に迅速に対応できるようにします。 Amazon SageMaker ロールマネージャー ロールベースの ML アクティビティを実装するために使用されます。 アマゾンS3 入力データと成果物を保存するために使用されます。

- このソリューションでは、顧客からの既存のモデル作成アセットを使用し、AWS ネイティブ サービスを使用してこれを中心に柔軟で拡張可能なフレームワークを構築します。 Amazon S3、Git、AWS CodeCommit の間に統合が構築されており、将来の管理を最小限に抑えながらデータセットのバージョニングが可能になります。

- AWS CloudFormation テンプレートは次を使用して生成されます AWSクラウド開発キット(AWS CDK)。 AWS CDK は、ソリューション全体の変更を管理する機能を提供します。自動化されたパイプラインには、すぐに使用できるモデルの保存とメトリクスの追跡のためのステップが含まれています。

- PwC MLOps Accelerator はモジュール式に設計されており、自動展開を可能にするコードとしてのインフラストラクチャー (IaC) として提供されます。デプロイメントプロセスでは以下を使用します。 AWS コードコミット, AWS コードビルド, AWS コードパイプライン、および AWS CloudFormation テンプレート。 ML モデルを運用するための完全なエンドツーエンドのソリューションは、デプロイ可能なコードとして利用できます。

- 一連の IaC テンプレートを通じて、モデルの構築、モデルのデプロイメント、モデルの監視と予測の提供という XNUMX つの異なるコンポーネントがデプロイされます。 AmazonSageMakerパイプライン

- モデル構築パイプラインはモデルのトレーニングと評価プロセスを自動化し、トレーニングされたモデルの承認と登録を可能にします。

- モデル デプロイメント パイプラインは、バッチおよびリアルタイム推論用の ML モデルをデプロイするために必要なインフラストラクチャをプロビジョニングします。

- モデルの監視と予測の提供パイプラインは、予測の提供とモデルのパフォーマンスの監視に必要なインフラストラクチャをデプロイします。

- PwC MLOps Accelerator は、ML モデル、ML フレームワーク、ランタイム環境に依存しないように設計されています。このソリューションでは、構成ファイルを通じて、Python や R などのプログラミング言語、Jupyter Notebook などの開発ツール、ML フレームワークを使い慣れた方法で使用できるようになります。この柔軟性により、データ サイエンティストはモデルを継続的に改良し、好みの言語と環境を使用してデプロイすることが簡単になります。

- このソリューションには、事前に構築されたツールまたはカスタム ツールを使用してラベル付けタスクを割り当てるための統合機能が組み込まれています。 Amazon SageMakerグラウンドトゥルース 継続的なトレーニングとモニタリングを提供するトレーニング データセット用。

- エンドツーエンドの ML パイプラインは、SageMaker ネイティブ機能 (Amazon SageMakerスタジオ , AmazonSageMakerモデル構築パイプライン, AmazonSageMakerの実験, AmazonSageMakerエンドポイント).

- このソリューションは、モデルのバージョニング、モデル系統の追跡、モデル共有、サーバーレス推論に Amazon SageMaker の組み込み機能を使用します。 Amazon SageMaker モデルレジストリ.

- モデルが運用開始されると、ソリューションは ML モデルの品質をリアルタイムで継続的に監視します。 Amazon SageMakerモデルモニター 実稼働環境でモデルを継続的に監視するために使用されます。 Amazon CloudWatch Logs は、モデルのステータスを監視するログ ファイルを収集するために使用され、モデルの品質が特定のしきい値に達すると、Amazon SNS を使用して通知が送信されます。ネイティブ ロガー (ボト3) は、トラブルシューティングを促進するために実行ステータスをキャプチャするために使用されます。

ソリューションウォークスルー

次のチュートリアルでは、PwC MLOps アクセラレータを使用してモデルの MLOps プロセスを作成する標準的な手順について詳しく説明します。このウォークスルーでは、直感的なシンプルな定義/構成ファイルを使用して、最近開発された ML モデルのパイプラインをデプロイしたい MLOps エンジニアのユース ケースについて説明します。

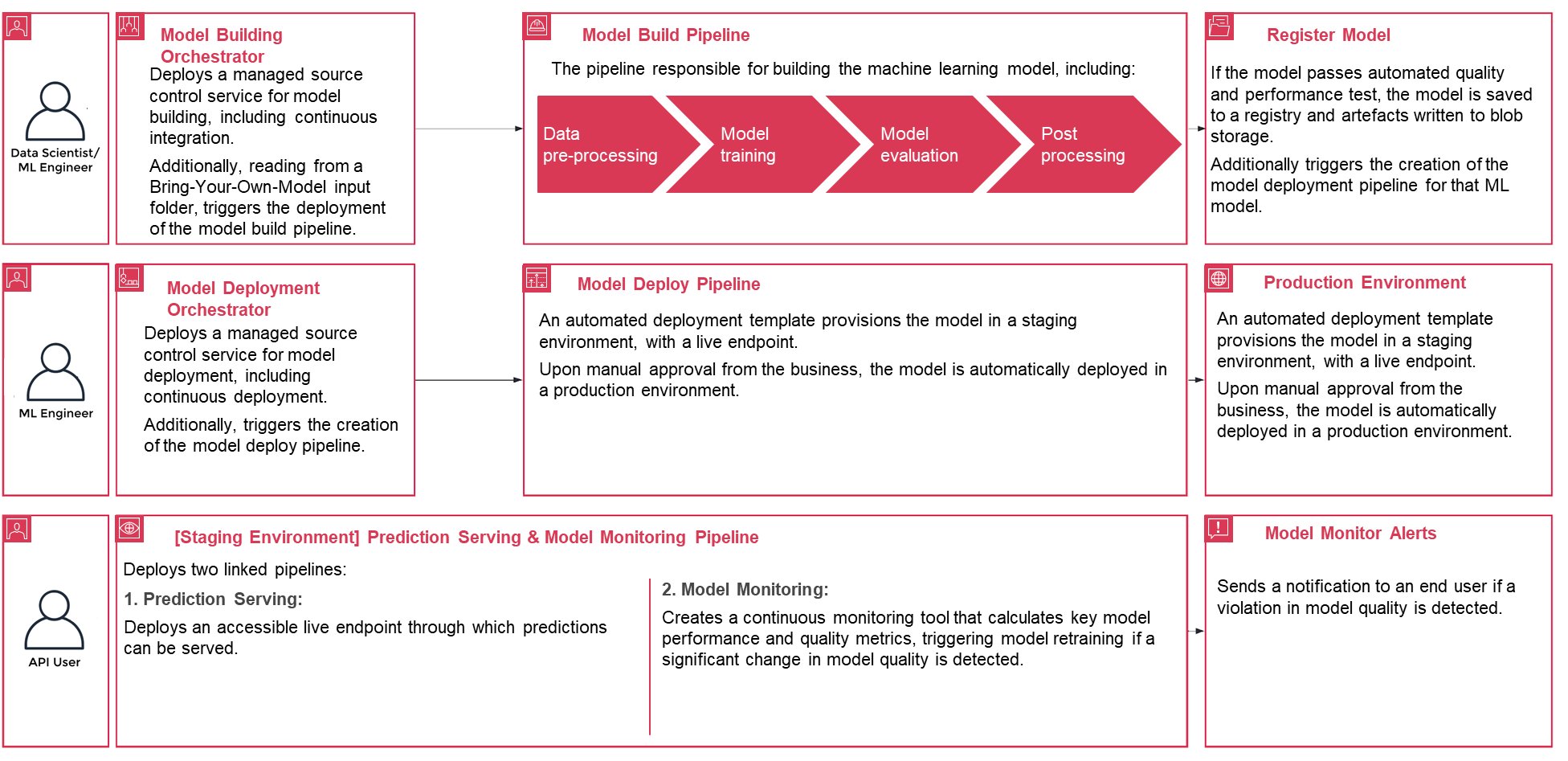

図 3 – PwC Machine Learning Ops Accelerator プロセスのライフサイクル

- 始めるには、登録してください PwC MLOps アクセラレータ ソリューションのアーティファクトにアクセスします。ソリューション全体は XNUMX つの構成 YAML ファイル (

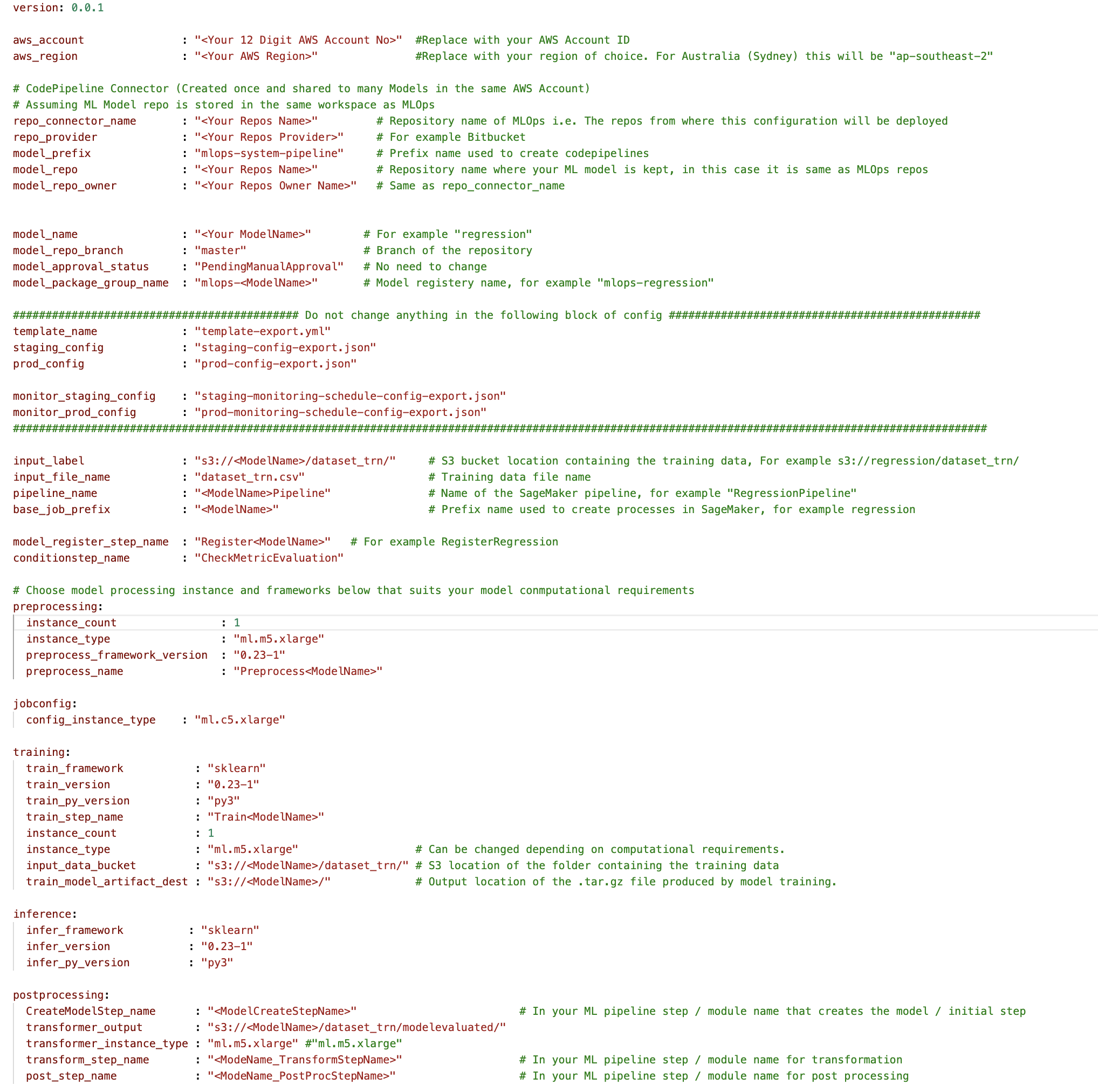

config.yaml) モデルごとに。ソリューションの実行に必要な詳細はすべてその構成ファイル内に含まれており、モデルとともに Git リポジトリに保存されます。構成ファイルは、重要なパラメーターと設定をコードの外部に外部化することで、ワークフロー ステップを自動化するための入力として機能します。 - ML エンジニアは入力する必要があります

config.yamlファイルを作成し、MLOps パイプラインをトリガーします。お客様は、AWS アカウント、リポジトリ、モデル、使用するデータ、パイプライン名、トレーニング フレームワーク、トレーニングに使用するインスタンスの数、推論フレームワーク、前処理ステップと後処理ステップ、およびその他のいくつかのステップを構成できます。モデルの品質、偏り、説明可能性をチェックするための構成。

図 4 – Machine Learning Ops Accelerator の構成 YAML

- 単純な YAML ファイルを使用して、各モデルのトレーニング、デプロイ、モニタリング、およびランタイム要件を構成します。一度

config.yamlが適切に構成され、モデルとともに独自の Git リポジトリに保存されると、モデル構築オーケストレーターが呼び出されます。また、YAML を通じて構成できる Bring-Your-Own-Model から読み取って、モデル ビルド パイプラインのデプロイメントをトリガーすることもできます。 - この時点以降の作業はすべてソリューションによって自動化され、ML エンジニアやデータ サイエンティストの関与は必要ありません。 ML モデルの構築を担当するパイプラインには、データの前処理、モデルのトレーニング、モデルの評価、および OST 処理が含まれます。モデルが自動化された品質およびパフォーマンスのテストに合格すると、モデルはレジストリに保存され、YAML ファイルの定義に従ってアーティファクトが Amazon S3 ストレージに書き込まれます。これにより、その ML モデルのモデル デプロイメント パイプラインの作成がトリガーされます。

図 5 – サンプル モデル展開ワークフロー

- 次に、自動化されたデプロイ テンプレートにより、ライブ エンドポイントを備えたステージング環境にモデルがプロビジョニングされます。承認されると、モデルは自動的に実稼働環境にデプロイされます。

- このソリューションは、リンクされた XNUMX つのパイプラインをデプロイします。予測の提供では、予測を提供できるアクセス可能なライブ エンドポイントをデプロイします。モデルのモニタリングは、主要なモデルのパフォーマンスと品質のメトリクスを計算する継続的なモニタリング ツールを作成し、モデルの品質に重大な変化が検出された場合にモデルの再トレーニングをトリガーします。

- 作成と初期デプロイメントが完了したので、MLOps エンジニアは、パイプラインが意図したジョブを実行できない場合など、問題について警告されるように失敗アラートを構成できます。

- MLOps は、従来の CI/CD デプロイメントと同様に、クラウド サービス コンポーネントをパッケージ化、テスト、デプロイするものではなくなりました。別のサービスを自動的にデプロイする必要があるシステムです。たとえば、モデル トレーニング パイプラインは、モデル デプロイメント パイプラインを自動的にデプロイして予測サービスを有効にし、それによってモデル監視サービスが有効になります。

まとめ

要約すると、ML モデルを実稼働システムに大規模に展開することを目指す組織にとって、MLOps は不可欠です。 PwC は、DevOps ツールをモデル開発プロセスに統合することで、ML モデルの構築、デプロイ、保守を自動化するアクセラレータを開発しました。

この投稿では、PwC ソリューションが AWS ネイティブ ML サービスをどのように活用し、企業が AI への取り組みを加速し、ML モデルからより多くの価値を得ることができるように、MLOps プラクティスの導入にどのように役立つかを検討しました。ユーザーが PwC Machine Learning Ops Accelerator にアクセスし、パイプラインを実行し、ML モデルのさまざまなライフサイクル コンポーネントを統合する ML ユース ケースをデプロイするために実行する手順を説明しました。

AWS クラウドで大規模な MLOps の取り組みを開始し、ML 本番ワークロードを実行するには、に登録してください。 PwC 機械学習オペレーション.

著者について

キラン・クマール・バラリ アマゾン ウェブ サービス (AWS) のプリンシパル ソリューション アーキテクトです。彼は、顧客が新しいテクノロジーを活用し、問題を解決するための再現可能な業界ソリューションを構築できるよう支援することに熱心なエバンジェリストです。彼は特にソフトウェア エンジニアリング、生成 AI、および企業の AI/ML 製品開発の支援に情熱を注いでいます。

キラン・クマール・バラリ アマゾン ウェブ サービス (AWS) のプリンシパル ソリューション アーキテクトです。彼は、顧客が新しいテクノロジーを活用し、問題を解決するための再現可能な業界ソリューションを構築できるよう支援することに熱心なエバンジェリストです。彼は特にソフトウェア エンジニアリング、生成 AI、および企業の AI/ML 製品開発の支援に情熱を注いでいます。

アンクル・ゴヤル PwC オーストラリアのクラウドおよびデジタル業務のディレクターであり、データ、分析、AI に重点を置いています。 Ankur は、データ資産とテクノロジーを活用してテクノロジー変革を推進し、革新的なソリューションを設計する公共部門と民間部門の組織をサポートする豊富な経験を持っています。

アンクル・ゴヤル PwC オーストラリアのクラウドおよびデジタル業務のディレクターであり、データ、分析、AI に重点を置いています。 Ankur は、データ資産とテクノロジーを活用してテクノロジー変革を推進し、革新的なソリューションを設計する公共部門と民間部門の組織をサポートする豊富な経験を持っています。

カーティケヤン・チョカッパ (KC) は、PwC オーストラリアのクラウドおよびデジタル業務のマネージャーであり、データ、分析、AI に重点を置いています。 KC は、データを貴重な意思決定資産に変換してパフォーマンスと使用率を向上させ、コネクテッドでインテリジェントなモノの総所有コストを削減する、エンドツーエンドの分析ソリューションの設計、開発、導入に熱心に取り組んでいます。

カーティケヤン・チョカッパ (KC) は、PwC オーストラリアのクラウドおよびデジタル業務のマネージャーであり、データ、分析、AI に重点を置いています。 KC は、データを貴重な意思決定資産に変換してパフォーマンスと使用率を向上させ、コネクテッドでインテリジェントなモノの総所有コストを削減する、エンドツーエンドの分析ソリューションの設計、開発、導入に熱心に取り組んでいます。

ラマ・ランカラパリ AWS のシニア パートナー ソリューション アーキテクトであり、PwC と協力してクライアントの AWS への移行とモダナイゼーションを加速しています。彼はさまざまな業界で AWS クラウドの導入を促進するために働いています。彼の専門知識は、効率的でスケーラブルなクラウド ソリューションの構築、AWS サービスの活用による顧客アプリケーションのイノベーションと最新化の推進、回復力のあるクラウド基盤の確立にあります。

ラマ・ランカラパリ AWS のシニア パートナー ソリューション アーキテクトであり、PwC と協力してクライアントの AWS への移行とモダナイゼーションを加速しています。彼はさまざまな業界で AWS クラウドの導入を促進するために働いています。彼の専門知識は、効率的でスケーラブルなクラウド ソリューションの構築、AWS サービスの活用による顧客アプリケーションのイノベーションと最新化の推進、回復力のあるクラウド基盤の確立にあります。

ジージー・ウンワラ は AWS のシニア ソリューション アーキテクトであり、顧客が課題を解決し、戦略的に考えるよう指導することに喜びを感じています。彼はテクノロジーとデータ、そしてイノベーションの実現に情熱を持っています。

ジージー・ウンワラ は AWS のシニア ソリューション アーキテクトであり、顧客が課題を解決し、戦略的に考えるよう指導することに喜びを感じています。彼はテクノロジーとデータ、そしてイノベーションの実現に情熱を持っています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/driving-advanced-analytics-outcomes-at-scale-using-amazon-sagemaker-powered-pwcs-machine-learning-ops-accelerator/