概要

リアルタイム AI システムは高速推論に大きく依存しています。 OpenAI、Google、Azure などの業界リーダーが提供する推論 API により、迅速な意思決定が可能になります。 Groq の言語処理ユニット (LPU) テクノロジーは、AI 処理効率を向上させる優れたソリューションです。この記事では、Groq の革新的なテクノロジ、AI 推論速度への影響、および Groq API を使用したテクノロジの活用方法について詳しく説明します。

学習目標

- Groq の言語処理ユニット (LPU) テクノロジーとその AI 推論速度への影響を理解する

- Groq の API エンドポイントをリアルタイムで低遅延の AI 処理タスクに利用する方法を学びます。

- 自然言語の理解と生成のための、Mixtral-8x7b-Instruct-v0.1 や Llama-70b などの Groq のサポートされているモデルの機能を探索します。

- Groq の LPU システムと他の推論 API を比較対照し、速度、効率、スケーラビリティなどの要素を調べます

この記事は、の一部として公開されました データサイエンスブログ。

目次

グロクとは何ですか?

2016年に設立され、 グロク はカリフォルニアを拠点とする AI ソリューションのスタートアップで、本社はマウンテン ビューにあります。超低遅延の AI 推論を専門とする Groq は、AI コンピューティングのパフォーマンスを大幅に向上させています。 Groq は、AI テクノロジー分野の著名な参加者であり、その名前を商標として登録し、AI へのアクセスの民主化に取り組むグローバル チームを結成しました。

言語処理ユニット

Groq の革新的なテクノロジーである言語処理ユニット (LPU) は、特に大規模言語モデル (LLM) の AI コンピューティング パフォーマンスを向上させることを目的としています。 Groq LPU システムは、優れた推論パフォーマンスを備えたリアルタイムの低遅延エクスペリエンスを提供するよう努めています。 Groq は、Meta AI の Llama-300 2B モデルでユーザーあたり 70 秒あたり XNUMX トークンを超えるトークンを達成し、新たな業界ベンチマークを設定しました。

Groq LPU システムは、AI サポート テクノロジーに不可欠な超低遅延機能を誇ります。特にシーケンシャルで計算量の多い GenAI 言語処理向けに設計されており、従来の GPU ソリューションを上回るパフォーマンスを発揮し、自然言語の作成や理解などのタスクの効率的な処理を保証します。

Groq の第 1 世代 GroqChip は、LPU システムの一部であり、速度、効率、精度、費用対効果が最適化されたテンソル ストリーミング アーキテクチャを備えています。このチップは既存のソリューションを上回り、ユーザーあたり XNUMX 秒あたりのトークンで測定される基本的な LLM 速度で新記録を樹立しました。 Groq は、XNUMX 年以内に XNUMX 万個の AI 推論チップを導入する計画を立てており、AI 高速化テクノロジーの進歩への取り組みを示しています。

要約すると、Groq の言語処理ユニット システムは、AI コンピューティング テクノロジの大幅な進歩を表しており、AI の革新を推進しながら、大規模言語モデルに優れたパフォーマンスと効率を提供します。

また読む: AWS SageMaker での ML モデルの構築

Groq の使用を開始する

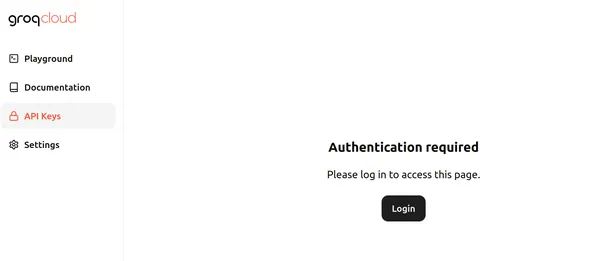

現在、Groq は、Groq LPU (言語処理ユニット) 上で実行される大規模言語モデルに無料で使用できる API エンドポイントを提供しています。始めるには、こちらにアクセスしてください ページ そして「ログイン」をクリックします。ページは以下のようになります。

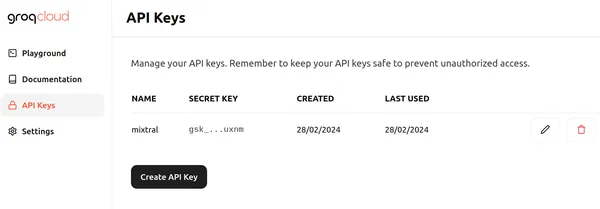

[ログイン] をクリックし、Groq にサインインするための適切な方法の 1 つを選択します。次に、「API キーの作成」ボタンをクリックして、以下のような新しい API を作成できます。

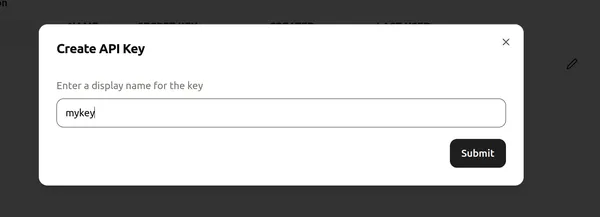

次に、API キーに名前を割り当て、「送信」をクリックして新しい API キーを作成します。ここで、任意のコード エディタ/Colab に進み、Groq の使用を開始するために必要なライブラリをインストールします。

!pip install groqこのコマンドは Groq ライブラリをインストールし、Groq LPU 上で実行されている大規模言語モデルを推論できるようにします。

それでは、コードを進めてみましょう。

コードの実装

# Importing Necessary Libraries

import os

from groq import Groq

# Instantiation of Groq Client

client = Groq(

api_key=os.environ.get("GROQ_API_KEY"),

)このコード スニペットは、Groq API と対話するための Groq クライアント オブジェクトを確立します。まず、GROQ_API_KEY という名前の環境変数から API キーを取得し、それを引数 api_key に渡します。その後、API キーによって Groq クライアント オブジェクトが初期化され、Groq サーバー内の大規模言語モデルへの API 呼び出しが可能になります。

LLM の定義

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What are Black Holes?",

}

],

model="mixtral-8x7b-32768",

)

print(llm.choices[0].message.content)- 最初の行は llm オブジェクトを初期化し、OpenAI Chat Completion API と同様に大規模言語モデルとの対話を可能にします。

- 後続のコードは、LLM に送信するメッセージのリストを作成し、メッセージ変数に格納します。

- 最初のメッセージは、役割を「システム」として割り当て、5 歳児に説明するようにトピックを説明する LLM の望ましい動作を定義します。

- 2 番目のメッセージは、役割を「ユーザー」に割り当て、ブラック ホールに関する質問が含まれています。

- 次の行は、応答の生成に使用する LLM を指定し、Groq API 経由でアクセスできる 8k コンテキスト Mixtral-7x32768b-Instruct-v32 ラージ言語モデルである「mixtral-8x7b-0.1」に設定します。

- このコードの出力は、5 歳児の理解に適した方法でブラック ホールを説明する LLM からの応答になります。

- 出力へのアクセスは、OpenAI エンドポイントの操作と同様のアプローチに従います。

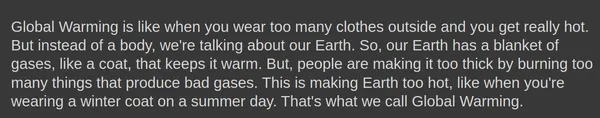

出力

以下は、Mixtral-8x7b-Instruct-v0.1 Large 言語モデルによって生成された出力を示しています。

完了.create() オブジェクトは次のような追加パラメータを取り込むこともできます 温度, トップ_p, max_tokens.

応答の生成

これらのパラメータを使用して応答を生成してみましょう。

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What is Global Warming?",

}

],

model="mixtral-8x7b-32768",

temperature = 1,

top_p = 1,

max_tokens = 256,

)- 温度: 応答のランダム性を制御します。温度が低いほど、より予測可能な出力が得られますが、温度が高いほど、より多様で、場合によってはより創造的な出力が得られます。

- max_tokens: モデルが 1 つの応答で処理できるトークンの最大数。この制限により、計算効率とリソース管理が確保されます。

- トップ_p: 最も可能性の高い上位 p 個のトークンの確率分布から次のトークンを選択するテキスト生成方法。これにより、生成中の探索と活用のバランスが取れます。

出力

Groq エンドポイントから生成された応答をストリーミングするオプションもあります。指定する必要があるのは、 ストリーム=真 内のオプション 完了.create() モデルが応答のストリーミングを開始するためのオブジェクト。

ラングチェーンのグロク

Groq は LangChain とも互換性があります。 LangChain で Groq の使用を開始するには、ライブラリをダウンロードします。

!pip install langchain-groq上記により、LangChain 互換性のための Groq ライブラリがインストールされます。では、コードで試してみましょう。

# Import the necessary libraries.

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

# Initialize a ChatGroq object with a temperature of 0 and the "mixtral-8x7b-32768" model.

llm = ChatGroq(temperature=0, model_name="mixtral-8x7b-32768")上記のコードは次のことを行います。

- llm という名前の新しい ChatGroq オブジェクトを作成します

- 設定します 温度 パラメータを 0 に設定すると、応答がより予測可能になることが示されます。

- 設定します モデル名 「へのパラメータmixtral-8x7b-32768"、使用する言語モデルを指定します

# AI アシスタントの機能を紹介するシステム メッセージを定義します。

# Define the system message introducing the AI assistant's capabilities.

system = "You are an expert Coding Assistant."

# Define a placeholder for the user's input.

human = "{text}"

# Create a chat prompt consisting of the system and human messages.

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# Invoke the chat chain with the user's input.

chain = prompt | llm

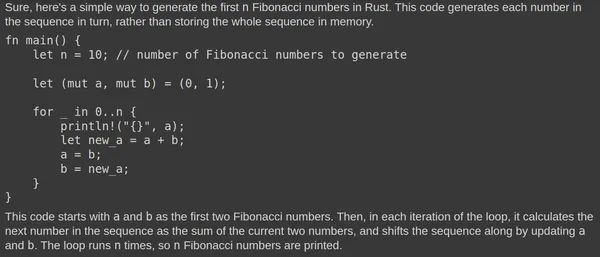

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# Print the Response.

print(response.content)- このコードは、ChatPromptTemplate クラスを使用してチャット プロンプトを生成します。

- プロンプトは 2 つのメッセージで構成されます。1 つは「システム」 (AI アシスタント) からのもので、もう 1 つは「人間」 (ユーザー) からのものです。

- システム メッセージは、AI アシスタントを専門家のコーディング アシスタントとして示します。

- 人間のメッセージは、ユーザー入力のプレースホルダーとして機能します。

- llm メソッドは、llm チェーンを呼び出して、指定されたプロンプトとユーザーの入力に基づいて応答を生成します。

出力

Mixtral 大規模言語モデルによって生成された出力は次のとおりです。

Mixtral LLM は一貫して関連する応答を生成します。 Rust Playground でコードをテストして、その機能を確認します。素早い応答は、基盤となる言語処理ユニット (LPU) によるものです。

Groq と他の推論 API

Groq の言語処理ユニット (LPU) システムは、OpenAI や Azure が提供する他の推論 API を上回る、大規模言語モデル (LLM) の超高速推論速度を実現することを目指しています。 LLM 用に最適化された Groq の LPU システムは、AI 支援テクノロジーに不可欠な超低遅延機能を提供します。計算密度やメモリ帯域幅など、LLM の主なボトルネックに対処し、テキスト シーケンスのより高速な生成を可能にします。

他の推論 API と比較して、Groq の LPU システムは高速であり、Anyscale の LLMPerf Leaderboard では、他のトップ クラウドベース プロバイダーと比較して最大 18 倍高速な推論パフォーマンスを生み出すことができます。また、Groq の LPU システムは、大規模な展開でもシングル コア アーキテクチャと同期ネットワーキングを維持することで効率が向上し、LLM の自動コンパイルと即時メモリ アクセスを可能にします。

上の画像は 70B モデルのベンチマークを示しています。出力トークンのスループットを計算するには、150 秒あたりに返される出力トークンの数を平均する必要があります。各 LLM 推論プロバイダーは XNUMX のリクエストを処理して結果を収集し、平均出力トークン スループットはこれらのリクエストを使用して計算されます。 LLM 推論プロバイダーのパフォーマンスの向上は、出力トークンのスループットの向上によって示されます。 Groq の XNUMX 秒あたりの出力トークンが、表示されている多くのクラウド プロバイダーよりも優れていることは明らかです。

まとめ

結論として、Groq の言語処理ユニット (LPU) システムは、AI コンピューティングの分野で革新的なテクノロジーとして際立っており、大規模言語モデル (LLM) の処理に前例のない速度と効率を提供し、AI 分野の革新を推進します。 Groq は、その超低レイテンシ機能と最適化されたアーキテクチャを活用することで、推論速度の新しいベンチマークを設定し、従来の GPU ソリューションやその他の業界をリードする推論 API を上回るパフォーマンスを発揮します。 Groq は、AI へのアクセスを民主化し、リアルタイムの低遅延エクスペリエンスに重点を置くことで、AI アクセラレーション テクノロジの状況を再構築する態勢を整えています。

主要な取り組み

- Groq の言語処理ユニット (LPU) システムは、AI 推論、特に大規模言語モデル (LLM) に対して比類のない速度と効率を提供し、リアルタイムで低遅延のエクスペリエンスを実現します。

- GroqChip を搭載した Groq の LPU システムは、AI サポート テクノロジに不可欠な超低レイテンシ機能を誇り、従来の GPU ソリューションを上回ります。

- Groq は 1 年以内に XNUMX 万個の AI 推論チップを導入する計画で、AI 高速化テクノロジーの進歩と AI へのアクセスの民主化に熱心に取り組んでいることを示しています

- Groq は、Groq LPU 上で実行される大規模言語モデル用に無料で使用できる API エンドポイントを提供し、開発者がアクセスしてプロジェクトに統合できるようにします。

- Groq と LangChain および LlamaIndex との互換性により、その使いやすさがさらに拡張され、言語処理タスクで Groq テクノロジーを活用しようとしている開発者にシームレスな統合が提供されます。

よくある質問

A. Groq は、AI コンピューティングのパフォーマンスに革命を起こすことを目的として、特に大規模言語モデル (LLM) 向けの超低レイテンシー AI 推論を専門としています。

A. GroqChip を搭載した Groq の LPU システムは、特に GenAI 言語処理の計算集約型の性質に合わせて調整されており、従来の GPU ソリューションと比較して優れた速度、効率、精度を提供します。

A. Groq は、Mixtral-8x7b-Instruct-v0.1 や Llama-70b など、AI 推論用のさまざまなモデルをサポートしています。

A. はい、Groq は LangChain および LlamaIndex と互換性があり、その使いやすさを拡張し、言語処理タスクで Groq テクノロジーを活用しようとしている開発者にシームレスな統合を提供します。

A. Groq の LPU システムは、Anyscale の LLMPerf Leaderboard のベンチマークで実証されているように、速度と効率の点で他の推論 API を上回り、最大 18 倍の高速な推論速度と優れたパフォーマンスを実現します。

この記事に示されているメディアは Analytics Vidhya が所有するものではなく、著者の裁量で使用されています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.analyticsvidhya.com/blog/2024/03/getting-started-with-groq-api/