Finanzdienstleistungskunden nutzen Daten aus verschiedenen Quellen, die mit unterschiedlichen Häufigkeiten stammen, darunter Echtzeit-, Batch- und archivierte Datensätze. Darüber hinaus benötigen sie Streaming-Architekturen, um wachsende Handelsvolumina, Marktvolatilität und regulatorische Anforderungen zu bewältigen. Im Folgenden sind einige der wichtigsten Geschäftsanwendungsfälle aufgeführt, die diesen Bedarf verdeutlichen:

- Handelsberichterstattung – Seit der globalen Finanzkrise 2007–2008 haben die Aufsichtsbehörden ihre Anforderungen und Kontrollen an die aufsichtsrechtliche Berichterstattung erhöht. Die Regulierungsbehörden haben einen verstärkten Fokus darauf gelegt, sowohl den Verbraucher durch Transaktionsmeldungen zu schützen (typischerweise T+1, d. h. 1 Werktag nach dem Handelsdatum) als auch die Markttransparenz durch nahezu in Echtzeit erfolgende Handelsmeldepflichten zu erhöhen.

- Risikomanagement – Da die Kapitalmärkte immer komplexer werden und die Regulierungsbehörden neue Risikorahmen einführen, wie z Grundlegende Überprüfung des Handelsbuchs (FRTB) und BaselIIIFinanzinstitute möchten die Häufigkeit der Berechnungen des Gesamtmarktrisikos, des Liquiditätsrisikos, des Kontrahentenrisikos und anderer Risikomessungen erhöhen und möglichst nah an Echtzeitberechnungen herankommen.

- Handelsqualität und -optimierung – Um die Handelsqualität zu überwachen und zu optimieren, müssen Sie Marktmerkmale wie Volumen, Richtung, Markttiefe, Ausführungsrate und andere Benchmarks im Zusammenhang mit dem Abschluss von Geschäften kontinuierlich bewerten. Die Handelsqualität hängt nicht nur von der Leistung des Brokers ab, sondern ist auch eine Anforderung seitens der Regulierungsbehörden MIFID II.

Die Herausforderung besteht darin, eine Lösung zu finden, die diese unterschiedlichen Quellen, unterschiedlichen Frequenzen und Verbrauchsanforderungen mit geringer Latenz bewältigen kann. Die Lösung sollte skalierbar, kosteneffizient sowie einfach einzuführen und zu betreiben sein. Amazon RedShift Funktionen wie Streaming-Aufnahme, Amazonas-Aurora Zero-ETL-Integrationund Datenaustausch mit AWS-Datenaustausch ermöglichen eine Verarbeitung nahezu in Echtzeit für Handelsberichte, Risikomanagement und Handelsoptimierung.

In diesem Beitrag stellen wir eine Lösungsarchitektur bereit, die beschreibt, wie Sie Daten aus drei verschiedenen Arten von Quellen – Streaming-, Transaktions- und Referenzdaten von Drittanbietern – verarbeiten und in Amazon Redshift für Business Intelligence (BI)-Berichte aggregieren können.

Lösungsüberblick

Bei der Erstellung dieser Lösungsarchitektur wird ein Low-Code/No-Code-Ansatz mit den folgenden Leitprinzipien priorisiert:

- Benutzerfreundlichkeit – Die Implementierung und Bedienung sollte mit intuitiven Benutzeroberflächen weniger komplex sein

- Skalierbar – Sie sollten in der Lage sein, die Kapazität bei Bedarf nahtlos zu erhöhen und zu verringern

- Native Integration – Komponenten sollten ohne zusätzliche Anschlüsse oder Software integriert werden

- Kosteneffizient – Es sollte ein ausgewogenes Preis-Leistungs-Verhältnis bieten

- Geringer Wartungsaufwand – Es sollte weniger Verwaltungs- und Betriebsaufwand erfordern

Das folgende Diagramm veranschaulicht die Lösungsarchitektur und wie diese Leitprinzipien auf die Aufnahme-, Aggregations- und Berichtskomponenten angewendet wurden.

Stellen Sie die Lösung bereit

Sie können Folgendes verwenden AWS CloudFormation Vorlage zum Bereitstellen der Lösung.

Dieser Stack erstellt die folgenden Ressourcen und erforderlichen Berechtigungen zur Integration der Dienste:

Verschlucken

Um Daten aufzunehmen, verwenden Sie Amazon Redshift-Streaming-Aufnahme um Streaming-Daten aus dem Kinesis-Datenstrom zu laden. Für Transaktionsdaten verwenden Sie die Redshift Zero-ETL-Integration mit Amazon Aurora MySQL. Für Referenzdaten Dritter nutzen Sie die Vorteile AWS Data Exchange-Datenfreigaben. Mit diesen Funktionen können Sie schnell skalierbare Datenpipelines erstellen, da Sie die Kapazität von Kinesis Data Streams-Shards erhöhen, für Zero-ETL-Quellen und -Ziele rechnen und Redshift-Rechen für Datenfreigaben durchführen können, wenn Ihre Daten wachsen. Redshift-Streaming-Ingestion und Zero-ETL-Integration sind Low-Code/No-Code-Lösungen, die Sie mit einfachen SQLs erstellen können, ohne viel Zeit und Geld in die Entwicklung komplexer benutzerdefinierter Codes zu investieren.

Für die Daten, die zur Erstellung dieser Lösung verwendet wurden, haben wir mit zusammengearbeitet FactSet, ein führender Anbieter von Finanzdaten, Analysen und offener Technologie. FactSet hat mehrere Datensätze verfügbar auf dem AWS Data Exchange-Marktplatz, den wir für Referenzdaten verwendet haben. Wir haben auch FactSets verwendet Marktdatenlösungen für historische und Streaming-Marktkurse und -geschäfte.

In Bearbeitung

Die Daten werden in Amazon Redshift nach einer ELT-Methode (Extrahieren, Laden und Transformieren) verarbeitet. Aufgrund seiner nahezu unbegrenzten Skalierbarkeit und Workload-Isolierung eignet sich ELT besser für Cloud-Data-Warehouse-Lösungen.

Sie verwenden die Redshift-Streaming-Aufnahme für die Echtzeitaufnahme von Streaming-Kursen (Bid/Ask) aus dem Kinesis-Datenstrom direkt in eine materialisierte Streaming-Ansicht und verarbeiten die Daten im nächsten Schritt mit PartiQL zum Parsen der Datenstrom-Eingaben. Beachten Sie, dass sich das Streamen materialisierter Ansichten von regulären materialisierten Ansichten hinsichtlich der Funktionsweise der automatischen Aktualisierung und der verwendeten SQL-Befehle für die Datenverwaltung unterscheidet. Beziehen auf Überlegungen zur Streaming-Aufnahme für weitere Einzelheiten.

Sie verwenden die Zero-ETL-Aurora-Integration für die Aufnahme von Transaktionsdaten (Trades) aus OLTP-Quellen. Beziehen auf Arbeiten mit Zero-ETL-Integrationen für derzeit unterstützte Quellen. Sie können Daten aus all diesen Quellen mithilfe von Ansichten kombinieren und gespeicherte Prozeduren verwenden, um Geschäftstransformationsregeln wie die Berechnung gewichteter Durchschnitte über Sektoren und Börsen hinweg zu implementieren.

Die historischen Handels- und Kursdatenmengen sind riesig und werden oft nicht häufig abgefragt. Sie können verwenden Amazon Redshift-Spektrum um direkt auf diese Daten zuzugreifen, ohne sie in Amazon Redshift zu laden. Sie erstellen externe Tabellen, die auf Daten in verweisen Amazon Simple Storage-Service (Amazon S3) und fragen Sie ähnlich ab, wie Sie jede andere lokale Tabelle in Amazon Redshift abfragen. Mehrere Redshift-Data-Warehouses können gleichzeitig dieselben Datensätze in Amazon S3 abfragen, ohne dass für jedes Data-Warehouse Kopien der Daten erstellt werden müssen. Diese Funktion vereinfacht den Zugriff auf externe Daten, ohne komplexe ETL-Prozesse schreiben zu müssen, und erhöht die Benutzerfreundlichkeit der Gesamtlösung.

Sehen wir uns einige Beispielabfragen an, die zur Analyse von Kursen und Geschäften verwendet werden. In den Beispielabfragen verwenden wir die folgenden Tabellen:

- dt_hist_quote – Historische Kursdaten mit Geldkurs und -volumen, Briefkurs und -volumen sowie Börsen und Sektoren. Sie sollten in Ihrer Organisation relevante Datensätze verwenden, die diese Datenattribute enthalten.

- dt_hist_trades – Historische Handelsdaten mit Details zu gehandeltem Preis, Volumen, Sektor und Börse. Sie sollten in Ihrer Organisation relevante Datensätze verwenden, die diese Datenattribute enthalten.

- factset_sector_map – Zuordnung zwischen Sektoren und Börsen. Dieses erhalten Sie bei der FactSet Fundamentals ADX-Datensatz.

Beispielabfrage zur Analyse historischer Kurse

Sie können die folgende Abfrage verwenden, um gewichtete durchschnittliche Spreads für Kurse zu finden:

Beispielabfrage zur Analyse historischer Trades

Sie können die folgende Abfrage zum Suchen verwenden $-volume zu Geschäften nach detaillierter Börse, nach Sektor und nach Hauptbörse (NYSE und Nasdaq):

Reporting

Sie können verwenden Amazon QuickSight und Von Amazon verwaltetes Grafana für BI bzw. Echtzeit-Reporting. Diese Dienste lassen sich nativ in Amazon Redshift integrieren, ohne dass zwischendurch zusätzliche Konnektoren oder Software verwendet werden müssen.

Sie können eine direkte Abfrage von QuickSight für BI-Berichte und -Dashboards ausführen. Mit QuickSight können Sie Daten auch lokal im SPICE-Cache mit automatischer Aktualisierung für geringe Latenz speichern. Beziehen auf Autorisieren von Verbindungen von Amazon QuickSight zu Amazon Redshift-Clustern Ausführliche Informationen zur Integration von QuickSight mit Amazon Redshift finden Sie hier.

Sie können Amazon Managed Grafana für Handels-Dashboards nahezu in Echtzeit verwenden, die alle paar Sekunden aktualisiert werden. Die Echtzeit-Dashboards zur Überwachung der Handelsaufnahmelatenzen werden mit Grafana erstellt und die Daten stammen aus Systemansichten in Amazon Redshift. Beziehen auf Verwendung der Amazon Redshift-Datenquelle Erfahren Sie, wie Sie Amazon Redshift als Datenquelle für Grafana konfigurieren.

Zu den Benutzern, die mit regulatorischen Meldesystemen interagieren, gehören Analysten, Risikomanager, Betreiber und andere Personen, die Geschäfts- und Technologieabläufe unterstützen. Neben der Erstellung regulatorischer Berichte benötigen diese Teams auch Einblick in den Zustand der Berichtssysteme.

Analyse historischer Zitate

In diesem Abschnitt untersuchen wir einige Beispiele für die Analyse historischer Zitate aus dem Amazon QuickSight Instrumententafel.

Gewichteter durchschnittlicher Spread nach Sektoren

Das folgende Diagramm zeigt die tägliche Aggregation nach Sektoren der gewichteten durchschnittlichen Geld-Brief-Spannen aller Einzelgeschäfte an der NASDAQ und der NYSE für drei Monate. Um den durchschnittlichen täglichen Spread zu berechnen, wird jeder Spread mit der Summe des Geld- und Briefvolumens in Dollar gewichtet. Die Abfrage zur Generierung dieses Diagramms verarbeitet insgesamt 3 Milliarden Datenpunkte, verknüpft jeden Handel mit der Sektorreferenztabelle und wird in weniger als 103 Sekunden ausgeführt.

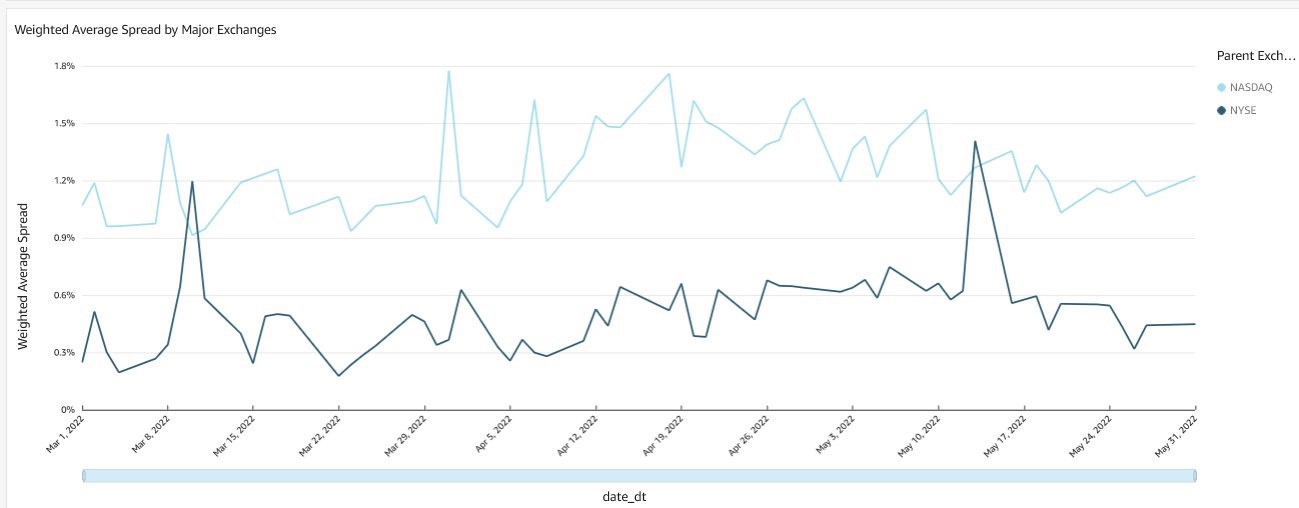

Gewichteter durchschnittlicher Spread nach Börsen

Das folgende Diagramm zeigt die tägliche Aggregation der gewichteten durchschnittlichen Geld-Brief-Spannen aller Einzelgeschäfte an der NASDAQ und der NYSE für drei Monate. Die Berechnungsmethode und die Abfrageleistungsmetriken ähneln denen im vorherigen Diagramm.

Historische Handelsanalyse

In diesem Abschnitt untersuchen wir einige Beispiele historischer Handelsanalysen aus dem Amazon QuickSight Instrumententafel.

Handelsvolumen nach Sektoren

Das folgende Diagramm zeigt die tägliche Aggregation nach Sektoren aller Einzelgeschäfte an der NASDAQ und der NYSE für drei Monate. Die Abfrage zur Generierung dieses Diagramms verarbeitet insgesamt 3 Milliarden Trades, verknüpft jeden Trade mit der Sektorreferenztabelle und wird in weniger als 3.6 Sekunden ausgeführt.

Handelsvolumen für große Börsen

Das folgende Diagramm zeigt die tägliche Aggregation nach Börsengruppen aller Einzelgeschäfte für 3 Monate. Die Abfrage zum Generieren dieses Diagramms verfügt über ähnliche Leistungsmetriken wie das vorherige Diagramm.

Echtzeit-Dashboards

Überwachung und Beobachtbarkeit sind eine wichtige Voraussetzung für jede kritische Geschäftsanwendung wie Handelsberichte, Risikomanagement und Handelsmanagementsysteme. Neben Metriken auf Systemebene ist es auch wichtig, wichtige Leistungsindikatoren in Echtzeit zu überwachen, damit Betreiber gewarnt werden und so schnell wie möglich auf geschäftsrelevante Ereignisse reagieren können. Für diese Demonstration haben wir in Grafana Dashboards erstellt, die die Verzögerung von Kurs- und Handelsdaten aus dem Kinesis-Datenstrom bzw. Aurora überwachen.

Das Dashboard „Verzögerung der Angebotsaufnahme“ zeigt die Zeit an, die es dauert, bis jeder Angebotsdatensatz aus dem Datenstrom aufgenommen wird und für die Abfrage in Amazon Redshift verfügbar ist.

Das Dashboard „Verzögerung der Handelsaufnahme“ zeigt die Zeit an, die es dauert, bis eine Transaktion in Aurora in Amazon Redshift zur Abfrage verfügbar wird.

Aufräumen

Um Ihre Ressourcen zu bereinigen, löschen Sie den Stack, den Sie mit AWS CloudFormation bereitgestellt haben. Anweisungen finden Sie unter Löschen eines Stacks in der AWS CloudFormation-Konsole.

Zusammenfassung

Zunehmende Handelsaktivitätsvolumina, komplexeres Risikomanagement und strengere regulatorische Anforderungen veranlassen Kapitalmarktunternehmen dazu, die Datenverarbeitung in Echtzeit und nahezu in Echtzeit zu nutzen, selbst auf Mid- und Back-Office-Plattformen, wo die Verarbeitung am Ende des Tages und über Nacht erfolgt war der Standard. In diesem Beitrag haben wir gezeigt, wie Sie die Funktionen von Amazon Redshift für Benutzerfreundlichkeit, geringen Wartungsaufwand und Kosteneffizienz nutzen können. Wir haben auch dienstübergreifende Integrationen besprochen, um Streaming-Marktdaten aufzunehmen, Aktualisierungen aus OLTP-Datenbanken zu verarbeiten und Referenzdaten von Drittanbietern zu verwenden, ohne eine komplexe und teure ETL- oder ELT-Verarbeitung durchführen zu müssen, bevor die Daten für Analyse und Berichterstellung verfügbar gemacht werden.

Bitte wenden Sie sich an uns, wenn Sie Hilfe bei der Implementierung dieser Lösung benötigen. Beziehen auf Echtzeitanalysen mit Amazon Redshift-Streamingaufnahme, Leitfaden für die ersten Schritte für Betriebsanalysen nahezu in Echtzeit mithilfe der Zero-ETL-Integration von Amazon Aurora mit Amazon Redshift und Als Produzent mit AWS Data Exchange-Datenfreigaben arbeiten um mehr zu erfahren.

Über die Autoren

Satesh Sonti ist ein Sr. Analytics Specialist Solutions Architect mit Sitz in Atlanta, der sich auf den Aufbau von Unternehmensdatenplattformen, Data Warehousing und Analyselösungen spezialisiert hat. Er verfügt über mehr als 18 Jahre Erfahrung im Aufbau von Datenbeständen und in der Leitung komplexer Datenplattformprogramme für Bank- und Versicherungskunden auf der ganzen Welt.

Satesh Sonti ist ein Sr. Analytics Specialist Solutions Architect mit Sitz in Atlanta, der sich auf den Aufbau von Unternehmensdatenplattformen, Data Warehousing und Analyselösungen spezialisiert hat. Er verfügt über mehr als 18 Jahre Erfahrung im Aufbau von Datenbeständen und in der Leitung komplexer Datenplattformprogramme für Bank- und Versicherungskunden auf der ganzen Welt.

Alket Memushaj arbeitet als Hauptarchitekt im Marktentwicklungsteam für Finanzdienstleistungen bei AWS. Alket ist für die technische Strategie für Kapitalmärkte verantwortlich und arbeitet mit Partnern und Kunden zusammen, um Anwendungen über den gesamten Handelslebenszyklus hinweg in der AWS Cloud bereitzustellen, einschließlich Marktkonnektivität, Handelssystemen sowie Analyse- und Forschungsplattformen vor und nach dem Handel.

Alket Memushaj arbeitet als Hauptarchitekt im Marktentwicklungsteam für Finanzdienstleistungen bei AWS. Alket ist für die technische Strategie für Kapitalmärkte verantwortlich und arbeitet mit Partnern und Kunden zusammen, um Anwendungen über den gesamten Handelslebenszyklus hinweg in der AWS Cloud bereitzustellen, einschließlich Marktkonnektivität, Handelssystemen sowie Analyse- und Forschungsplattformen vor und nach dem Handel.

Ruben Falk ist ein Kapitalmarktspezialist mit den Schwerpunkten KI sowie Daten und Analysen. Ruben berät Kapitalmarktteilnehmer zu modernen Datenarchitekturen und systematischen Anlageprozessen. Er kam von S&P Global Market Intelligence zu AWS, wo er Global Head of Investment Management Solutions war.

Ruben Falk ist ein Kapitalmarktspezialist mit den Schwerpunkten KI sowie Daten und Analysen. Ruben berät Kapitalmarktteilnehmer zu modernen Datenarchitekturen und systematischen Anlageprozessen. Er kam von S&P Global Market Intelligence zu AWS, wo er Global Head of Investment Management Solutions war.

Jeff Wilson ist ein weltweiter Go-to-Market-Spezialist mit 15 Jahren Erfahrung in der Arbeit mit Analyseplattformen. Sein aktueller Schwerpunkt liegt darin, die Vorteile der Verwendung von Amazon Redshift, dem nativen Cloud-Data-Warehouse von Amazon, zu teilen. Jeff hat seinen Sitz in Florida und ist seit 2019 bei AWS.

Jeff Wilson ist ein weltweiter Go-to-Market-Spezialist mit 15 Jahren Erfahrung in der Arbeit mit Analyseplattformen. Sein aktueller Schwerpunkt liegt darin, die Vorteile der Verwendung von Amazon Redshift, dem nativen Cloud-Data-Warehouse von Amazon, zu teilen. Jeff hat seinen Sitz in Florida und ist seit 2019 bei AWS.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/big-data/combine-transactional-streaming-and-third-party-data-on-amazon-redshift-for-financial-services/