Anwendungen der generativen künstlichen Intelligenz (KI), die auf großen Sprachmodellen (LLMs) basieren, haben gezeigt, dass sie das Potenzial haben, wirtschaftlichen Wert für Unternehmen zu schaffen und zu beschleunigen. Beispiele für Anwendungen sind: Konversationssuche, Unterstützung durch Kundendienstmitarbeiter, Kundensupportanalysen, virtuelle Selbstbedienungsassistenten, Chatbots, Rich-Media-Generierung, inhaltliche Moderation, Codierungsbegleiter zur Beschleunigung der sicheren, leistungsstarken Softwareentwicklung, tiefere Erkenntnisse aus multimodalen Inhaltsquellen, Beschleunigung der Sicherheitsuntersuchungen und Abhilfemaßnahmen Ihres Unternehmens, und vieles mehr. Viele Kunden suchen bei der Entwicklung generativer KI-Anwendungen nach Anleitung zum Management von Sicherheit, Datenschutz und Compliance. Das Verstehen und Behandeln von LLM-Schwachstellen, Bedrohungen und Risiken während der Entwurfs- und Architekturphase hilft Teams, sich auf die Maximierung der wirtschaftlichen und produktiven Vorteile zu konzentrieren, die generative KI mit sich bringen kann. Das Bewusstsein für Risiken fördert die Transparenz und das Vertrauen in generative KI-Anwendungen, fördert die bessere Beobachtbarkeit, hilft bei der Einhaltung von Compliance-Anforderungen und erleichtert Führungskräften die fundierte Entscheidungsfindung.

Ziel dieses Beitrags ist es, KI- und maschinelles Lernen (ML)-Ingenieure, Datenwissenschaftler, Lösungsarchitekten, Sicherheitsteams und andere Interessengruppen in die Lage zu versetzen, über ein gemeinsames mentales Modell und Framework für die Anwendung bewährter Sicherheitspraktiken zu verfügen, sodass KI/ML-Teams sich bewegen können schnell, ohne Sicherheit gegen Geschwindigkeit einzubüßen. Insbesondere soll dieser Beitrag KI/ML- und Datenwissenschaftlern helfen, die möglicherweise noch nie mit Sicherheitsprinzipien vertraut waren, ein Verständnis für die wichtigsten Best Practices für Sicherheit und Datenschutz im Kontext der Entwicklung generativer KI-Anwendungen mithilfe von LLMs zu erlangen. Wir diskutieren auch häufige Sicherheitsbedenken, die das Vertrauen in KI untergraben können, wie in der Studie festgestellt Open Worldwide Application Security Project (OWASP) Top 10 für LLM-Anwendungen, und zeigen Sie Möglichkeiten auf, wie Sie AWS nutzen können, um Ihren Sicherheitsstatus und Ihr Vertrauen zu verbessern und gleichzeitig Innovationen mit generativer KI voranzutreiben.

Dieser Beitrag bietet drei geführte Schritte zum Entwerfen von Risikomanagementstrategien bei der Entwicklung generativer KI-Anwendungen mithilfe von LLMs. Wir befassen uns zunächst mit den Schwachstellen, Bedrohungen und Risiken, die sich aus der Implementierung, Bereitstellung und Nutzung von LLM-Lösungen ergeben, und bieten Anleitungen für den Beginn von Innovationen unter Berücksichtigung der Sicherheit. Anschließend diskutieren wir, wie wichtig der Aufbau einer sicheren Grundlage für generative KI ist. Abschließend verbinden wir diese mit einem beispielhaften LLM-Workload, um einen Ansatz für die Architektur mit tiefgreifender Sicherheit über Vertrauensgrenzen hinweg zu beschreiben.

Am Ende dieses Beitrags, KI/ML-Ingenieure, Datenwissenschaftler und sicherheitsorientierte Technologen werden in der Lage sein, Strategien zum Aufbau mehrschichtiger Abwehrmaßnahmen für ihre generativen KI-Anwendungen zu identifizieren, zu verstehen, wie man die OWASP-Top-10-Sicherheitsbedenken für LLMs einigen entsprechenden Kontrollen zuordnet, und grundlegendes Wissen dazu aufzubauen Beantwortung der folgenden wichtigsten AWS-Kundenfragenthemen für ihre Anwendungen:

- Was sind einige der allgemeinen Sicherheits- und Datenschutzrisiken bei der Verwendung generativer KI auf Basis von LLMs in meinen Anwendungen, auf die ich mit dieser Anleitung am meisten Einfluss nehmen kann?

- Welche Möglichkeiten gibt es, Sicherheits- und Datenschutzkontrollen im Entwicklungslebenszyklus für generative KI-LLM-Anwendungen auf AWS zu implementieren?

- Welche betrieblichen und technischen Best Practices kann ich in die Art und Weise integrieren, wie mein Unternehmen generative KI-LLM-Anwendungen erstellt, um Risiken zu verwalten und das Vertrauen in generative KI-Anwendungen mithilfe von LLMs zu erhöhen?

Verbessern Sie die Sicherheitsergebnisse und entwickeln Sie gleichzeitig generative KI

Innovationen mit generativer KI unter Verwendung von LLMs erfordern, dass man mit Blick auf die Sicherheit beginnt, um die Widerstandsfähigkeit der Organisation zu entwickeln, auf einer sicheren Grundlage aufzubauen und Sicherheit mit einem umfassenden Sicherheitsansatz zu integrieren. Sicherheit ist ein geteilte Verantwortung zwischen AWS und AWS-Kunden. Alle Prinzipien des AWS Shared Responsibility Model gelten für generative KI-Lösungen. Frischen Sie Ihr Verständnis des AWS Shared Responsibility Model in Bezug auf Infrastruktur, Services und Daten auf, wenn Sie LLM-Lösungen erstellen.

Beginnen Sie mit der Sicherheit im Hinterkopf, um die Widerstandsfähigkeit Ihrer Organisation zu entwickeln

Beginnen Sie mit der Sicherheit im Hinterkopf, um die organisatorische Widerstandsfähigkeit für die Entwicklung generativer KI-Anwendungen zu entwickeln, die Ihre Sicherheits- und Compliance-Ziele erfüllen. Organisatorische Resilienz stützt sich auf das und erweitert es Definition von Resilienz im AWS Well-Architected Framework Einbeziehen und Vorbereiten der Fähigkeit einer Organisation, sich von Störungen zu erholen. Berücksichtigen Sie Ihre Sicherheitslage, Governance und betriebliche Exzellenz, wenn Sie die allgemeine Bereitschaft zur Entwicklung generativer KI mit LLMs und die Widerstandsfähigkeit Ihrer Organisation gegenüber möglichen Auswirkungen beurteilen. Während Ihr Unternehmen den Einsatz neuer Technologien wie generativer KI und LLMs vorantreibt, sollte die allgemeine Widerstandsfähigkeit der Organisation als Eckpfeiler einer mehrschichtigen Verteidigungsstrategie betrachtet werden, um Vermögenswerte und Geschäftsbereiche vor unbeabsichtigten Folgen zu schützen.

Die organisatorische Ausfallsicherheit ist für LLM-Anwendungen von wesentlicher Bedeutung

Obwohl alle Risikomanagementprogramme von Resilienz profitieren können, ist die organisatorische Resilienz für generative KI von wesentlicher Bedeutung. Fünf der von OWASP identifizierten Top-10-Risiken für LLM-Anwendungen beruhen auf der Definition architektonischer und betrieblicher Kontrollen und deren Durchsetzung auf organisatorischer Ebene, um Risiken zu verwalten. Diese fünf Risiken sind unsichere Ausgabeverarbeitung, Schwachstellen in der Lieferkette, Offenlegung vertraulicher Informationen, übermäßige Entscheidungsfreiheit und übermäßiges Vertrauen. Beginnen Sie mit der Erhöhung der organisatorischen Widerstandsfähigkeit, indem Sie Ihre Teams so sozialisieren, dass sie KI-, ML- und generative KI-Sicherheit als zentrale Geschäftsanforderung und höchste Priorität während des gesamten Lebenszyklus des Produkts betrachten, von der Idee über die Forschung bis hin zur Entwicklung und Bereitstellung der Anwendung verwenden. Zusätzlich zur Sensibilisierung sollten Ihre Teams Maßnahmen ergreifen, um generative KI in Governance-, Assurance- und Compliance-Validierungspraktiken zu berücksichtigen.

Bauen Sie organisatorische Widerstandsfähigkeit rund um generative KI auf

Unternehmen können damit beginnen, Wege einzuführen, um ihre Kapazitäten und Fähigkeiten für KI/ML und generative KI-Sicherheit in ihren Organisationen auszubauen. Sie sollten damit beginnen, Ihre bestehenden Sicherheits-, Gewährleistungs-, Compliance- und Entwicklungsprogramme zu erweitern, um generative KI zu berücksichtigen.

Im Folgenden sind die fünf Hauptinteressenbereiche für organisatorische KI, ML und generative KI-Sicherheit aufgeführt:

- Verstehen Sie die KI/ML-Sicherheitslandschaft

- Beziehen Sie unterschiedliche Perspektiven in Sicherheitsstrategien ein

- Ergreifen Sie proaktiv Maßnahmen zur Sicherung der Forschungs- und Entwicklungsaktivitäten

- Richten Sie Anreize an den Ergebnissen der Organisation aus

- Bereiten Sie sich auf realistische Sicherheitsszenarien in KI/ML und generativer KI vor

Entwickeln Sie während Ihres generativen KI-Lebenszyklus ein Bedrohungsmodell

Organisationen, die mit generativer KI aufbauen, sollten sich auf das Risikomanagement und nicht auf die Risikoeliminierung konzentrieren und Folgendes einbeziehen Bedrohungsmodellierung in und Geschäftskontinuitätsplanung die Planung, Entwicklung und den Betrieb generativer KI-Workloads. Arbeiten Sie vom Produktionseinsatz generativer KI rückwärts, indem Sie für jede Anwendung ein Bedrohungsmodell entwickeln, das sowohl herkömmliche Sicherheitsrisiken als auch generative KI-spezifische Risiken verwendet. Einige Risiken können für Ihr Unternehmen akzeptabel sein, und eine Bedrohungsmodellierung kann Ihrem Unternehmen dabei helfen, Ihre akzeptable Risikobereitschaft zu ermitteln. Beispielsweise benötigt Ihr Unternehmen möglicherweise keine 99.999-prozentige Verfügbarkeit einer generativen KI-Anwendung, sodass die mit der Wiederherstellung verbundene zusätzliche Wiederherstellungszeit erforderlich ist AWS-Sicherung mit Amazon S3 Gletscher kann ein akzeptables Risiko sein. Umgekehrt können die Daten in Ihrem Modell äußerst sensibel und stark reguliert sein, so dass eine Abweichung von der Norm erforderlich ist AWS-Schlüsselverwaltungsservice (AWS KMS) Kundenverwalteter Schlüssel (CMK) Rotation und Verwendung von AWS-Netzwerk-Firewall Die Durchsetzung von Transport Layer Security (TLS) für ein- und ausgehenden Datenverkehr zum Schutz vor Datenexfiltration kann ein inakzeptables Risiko darstellen.

Bewerten Sie die Risiken (inhärente vs. verbleibende) der Verwendung der generativen KI-Anwendung in einer Produktionsumgebung, um die richtigen grundlegenden und Anwendungsebenenkontrollen zu identifizieren. Planen Sie frühzeitig ein Rollback und eine Wiederherstellung nach Produktionssicherheitsereignissen und Dienstunterbrechungen wie Prompt-Injection, Trainingsdatenvergiftung, Modell-Denial-of-Service und Modelldiebstahl und definieren Sie die Abhilfemaßnahmen, die Sie bei der Definition der Anwendungsanforderungen verwenden werden. Wenn Sie sich über die Risiken und Kontrollen informieren, die eingerichtet werden müssen, können Sie den besten Implementierungsansatz für den Aufbau einer generativen KI-Anwendung definieren und Stakeholdern und Entscheidungsträgern Informationen zur Verfügung stellen, um fundierte Geschäftsentscheidungen über Risiken zu treffen. Wenn Sie mit dem gesamten KI- und ML-Workflow nicht vertraut sind, beginnen Sie mit der Überprüfung 7 Möglichkeiten, die Sicherheit Ihrer Machine-Learning-Workloads zu verbessern um die Vertrautheit mit den Sicherheitskontrollen zu erhöhen, die für herkömmliche KI/ML-Systeme erforderlich sind.

Genau wie bei der Erstellung jeder ML-Anwendung erfordert die Erstellung einer generativen KI-Anwendung das Durchlaufen einer Reihe von Phasen des Forschungs- und Entwicklungslebenszyklus. Vielleicht möchten Sie die überprüfen AWS Generative AI Security Scoping Matrix um dabei zu helfen, ein mentales Modell zu erstellen, um die wichtigsten Sicherheitsdisziplinen zu verstehen, die Sie je nach ausgewählter generativer KI-Lösung berücksichtigen sollten.

Generative KI-Anwendungen mit LLMs werden typischerweise in folgenden geordneten Schritten entwickelt und betrieben:

- Bewerbungsvoraussetzungen – Identifizieren Sie Geschäftsziele, Anforderungen und Erfolgskriterien für Anwendungsfälle

- Modellauswahl – Wählen Sie ein Basismodell aus, das den Anforderungen des Anwendungsfalls entspricht

- Modellanpassung und Feinabstimmung – Bereiten Sie Daten vor, erstellen Sie Eingabeaufforderungen und optimieren Sie das Modell

- Modellbewertung – Bewerten Sie Basismodelle mit anwendungsfallspezifischen Metriken und wählen Sie das Modell mit der besten Leistung aus

- Bereitstellung und Integration – Stellen Sie das ausgewählte Basismodell auf Ihrer optimierten Infrastruktur bereit und integrieren Sie es in Ihre generative KI-Anwendung

- Anwendungsüberwachung – Überwachen Sie die Anwendungs- und Modellleistung, um eine Ursachenanalyse zu ermöglichen

Stellen Sie sicher, dass die Teams am ersten Tag die entscheidende Natur der Sicherheit als Teil der Design- und Architekturphasen Ihres Softwareentwicklungslebenszyklus verstehen. Das bedeutet, die Sicherheit auf jeder Ebene Ihres Stacks und Lebenszyklus zu besprechen und Sicherheit und Datenschutz als Wegbereiter für das Erreichen von Geschäftszielen zu positionieren. Entwerfen Sie Bedrohungskontrollen, bevor Sie Ihre LLM-Anwendung starten, und überlegen Sie, ob die Daten und Informationen, die Sie für die Modellanpassung und Feinabstimmung verwenden, die Implementierung in den Forschungs-, Entwicklungs- und Schulungsumgebungen rechtfertigen. Führen Sie im Rahmen von Qualitätssicherungstests synthetische Sicherheitsbedrohungen ein (z. B. den Versuch, Trainingsdaten zu manipulieren oder durch böswillige Eingabeaufforderungen sensible Daten zu extrahieren), um Ihre Abwehrmaßnahmen und Sicherheitslage regelmäßig zu testen.

Darüber hinaus sollten Stakeholder einen konsistenten Überprüfungsrhythmus für Produktions-KI-, ML- und generative KI-Arbeitslasten festlegen und vor der Einführung organisatorische Priorität auf das Verständnis der Kompromisse zwischen menschlicher und maschineller Kontrolle und Fehlern legen. Die Validierung und Sicherstellung, dass diese Kompromisse in den bereitgestellten LLM-Anwendungen berücksichtigt werden, erhöht die Wahrscheinlichkeit einer erfolgreichen Risikominderung.

Erstellen Sie generative KI-Anwendungen auf sicheren Cloud-Grundlagen

Bei AWS hat Sicherheit für uns oberste Priorität. AWS ist als die sicherste globale Cloud-Infrastruktur konzipiert, auf der Anwendungen und Workloads erstellt, migriert und verwaltet werden können. Dies wird durch unser umfassendes Angebot an über 300 Cloud-Sicherheitstools und das Vertrauen unserer Millionen Kunden unterstützt, darunter die sicherheitssensibelsten Organisationen wie Regierung, Gesundheitswesen und Finanzdienstleistungen. Wenn Sie generative KI-Anwendungen mithilfe von LLMs auf AWS erstellen, profitieren Sie von Sicherheitsvorteilen sichere, zuverlässige und flexible AWS Cloud-Computing-Umgebung.

Nutzen Sie eine globale AWS-Infrastruktur für Sicherheit, Datenschutz und Compliance

Wenn Sie datenintensive Anwendungen auf AWS entwickeln, können Sie von einer globalen AWS-Regionsinfrastruktur profitieren, die so konzipiert ist, dass sie Funktionen bietet, die Ihre wichtigsten Sicherheits- und Compliance-Anforderungen erfüllen. Dies wird durch unsere verstärkt AWS-Versprechen zur digitalen Souveränität, unser Engagement, Ihnen die fortschrittlichsten Souveränitätskontrollen und Funktionen anzubieten, die in der Cloud verfügbar sind. Wir sind bestrebt, unsere Fähigkeiten zu erweitern, damit Sie Ihre Anforderungen erfüllen können digitale Souveränität Anforderungen, ohne Kompromisse bei der Leistung, Innovation, Sicherheit oder Skalierbarkeit der AWS Cloud einzugehen. Um die Implementierung von Best Practices für Sicherheit und Datenschutz zu vereinfachen, sollten Sie die Verwendung von Referenzdesigns und Infrastruktur als Coderessourcen in Betracht ziehen, z AWS-Sicherheitsreferenzarchitektur (AWS SRA) und dem AWS-Datenschutzreferenzarchitektur (AWS PRA). Lesen Sie mehr über Architektur von Datenschutzlösungen, Souveränität durch Design und Compliance auf AWS und nutzen Sie Dienste wie AWS-Konfiguration, AWS-Artefakt und AWS Audit Manager zur Unterstützung Ihrer Datenschutz-, Compliance-, Prüfungs- und Beobachtbarkeitsanforderungen.

Verstehen Sie Ihre Sicherheitslage mit AWS Well-Architected und Cloud Adoption Frameworks

AWS bietet Best-Practice-Anleitungen, die auf jahrelanger Erfahrung bei der Unterstützung von Kunden bei der Architektur ihrer Cloud-Umgebungen basieren AWS Well-Architated-Framework und bei der Weiterentwicklung, um mit den Cloud-Technologien einen geschäftlichen Nutzen zu erzielen AWS Cloud Adoption Framework (AWS CAF). Verstehen Sie den Sicherheitsstatus Ihrer KI-, ML- und generativen KI-Workloads, indem Sie eine Well-Architected Framework-Überprüfung durchführen. Bewertungen können mit Tools wie dem durchgeführt werden AWS Well-Architected-Tool, oder mit Hilfe Ihres AWS-Teams durch AWS Enterprise-Support. Das AWS Well-Architected Tool integriert Erkenntnisse automatisch für Vertrauenswürdiger AWS-Berater um zu bewerten, welche Best Practices vorhanden sind und welche Möglichkeiten zur Verbesserung der Funktionalität und Kostenoptimierung bestehen. Das AWS Well-Architected Tool bietet auch maßgeschneiderte Linsen mit spezifischen Best Practices wie z Linse für maschinelles Lernen Damit Sie Ihre Architekturen regelmäßig anhand von Best Practices messen und Verbesserungsmöglichkeiten identifizieren können. Kontrollieren Sie Ihre Reise auf dem Weg zur Wertschöpfung und Cloud-Reife, indem Sie verstehen, wie AWS-Kunden Strategien zur Entwicklung organisatorischer Fähigkeiten in der Cloud anwenden AWS Cloud Adoption Framework für künstliche Intelligenz, maschinelles Lernen und generative KI. Möglicherweise profitieren Sie auch davon, Ihre allgemeine Cloud-Bereitschaft zu verstehen, indem Sie an einem teilnehmen Bewertung der AWS-Cloud-Bereitschaft. AWS bietet zusätzliche Möglichkeiten zur Interaktion – fragen Sie Ihr AWS-Account-Team nach weiteren Informationen zum Einstieg Zentrum für generative KI-Innovation.

Beschleunigen Sie Ihr Sicherheits- und KI/ML-Lernen mit Best-Practice-Anleitungen, Schulungen und Zertifizierungen

AWS kuratiert auch Empfehlungen von Best Practices für Sicherheit, Identität und Compliance und AWS-Sicherheitsdokumentation um Ihnen dabei zu helfen, Wege zur Sicherung Ihrer Schulungs-, Entwicklungs-, Test- und Betriebsumgebungen zu finden. Wenn Sie gerade erst anfangen, vertiefen Sie sich in die Sicherheitsschulung und -zertifizierung und überlegen Sie, mit zu beginnen AWS-Sicherheitsgrundlagen und dem AWS-Sicherheitslernplan. Sie können auch die AWS-Sicherheitsreifemodell um Sie dabei zu unterstützen, die besten Aktivitäten in verschiedenen Reifephasen auf AWS zu finden und zu priorisieren, angefangen bei schnellen Erfolgen bis hin zu grundlegenden, effizienten und optimierten Phasen. Nachdem Sie und Ihre Teams ein grundlegendes Verständnis der Sicherheit in AWS erworben haben, empfehlen wir Ihnen dringend, dies noch einmal durchzugehen Vorgehensweise bei der Bedrohungsmodellierung Anschließend führen Sie mit Ihren Teams eine Bedrohungsmodellierungsübung durch, beginnend mit dem Workshop zur Bedrohungsmodellierung für Bauherren Trainingsprogramm. Es gibt viele andere Schulungs- und Zertifizierungsressourcen für AWS-Sicherheit erhältlich.

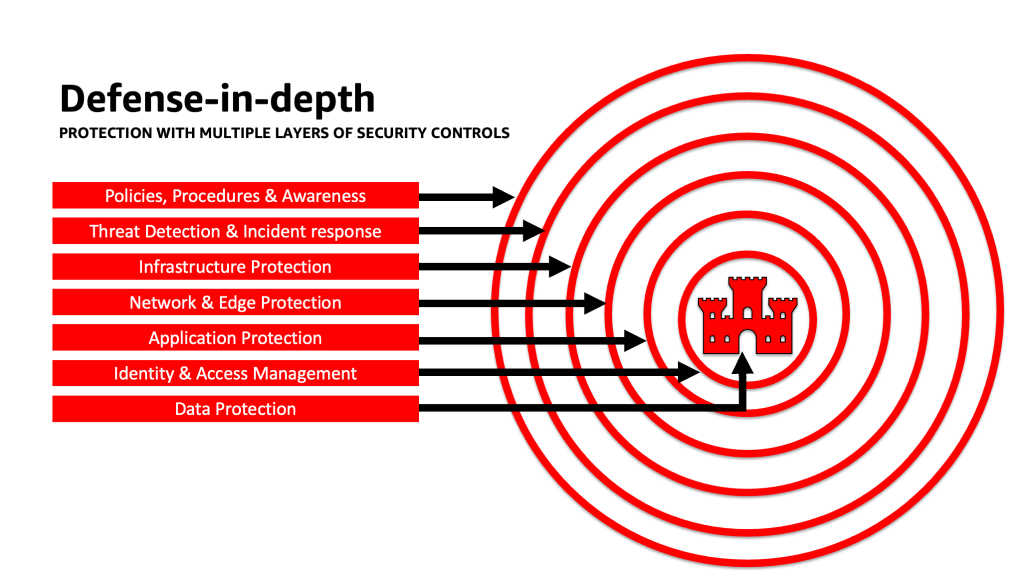

Wenden Sie einen Defense-in-Depth-Ansatz an, um LLM-Anwendungen zu sichern

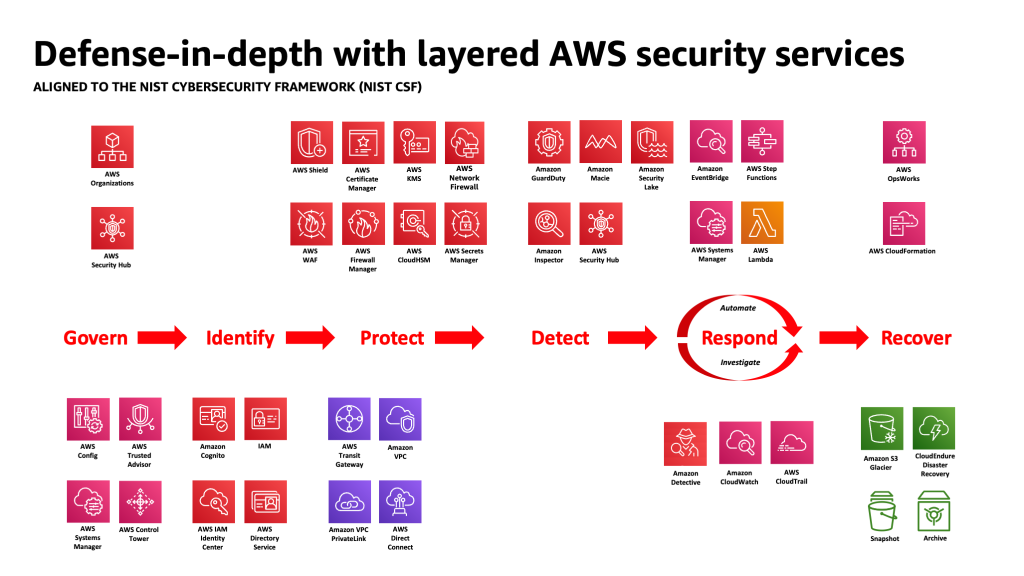

Die Anwendung eines tiefgreifenden Sicherheitsansatzes für Ihre generativen KI-Workloads, Daten und Informationen kann dazu beitragen, die besten Voraussetzungen zum Erreichen Ihrer Geschäftsziele zu schaffen. Best Practices für die Tiefenverteidigung mindern viele der allgemeinen Risiken, denen jede Arbeitslast ausgesetzt ist, und helfen Ihnen und Ihren Teams, Ihre generative KI-Innovation zu beschleunigen. Eine tiefgreifende Sicherheitsstrategie nutzt mehrere redundante Abwehrmaßnahmen, um Ihre AWS-Konten, Arbeitslasten, Daten und Vermögenswerte zu schützen. Dadurch wird sichergestellt, dass zusätzliche Ebenen vorhanden sind, um Bedrohungen zu isolieren und Sicherheitsereignisse zu verhindern, zu erkennen, darauf zu reagieren und die Wiederherstellung zu ermöglichen, wenn eine Sicherheitskontrolle beeinträchtigt wird oder ausfällt. Sie können auf jeder Ebene eine Kombination von Strategien, einschließlich AWS-Services und -Lösungen, verwenden, um die Sicherheit und Ausfallsicherheit Ihrer generativen KI-Workloads zu verbessern.

Viele AWS-Kunden orientieren sich an Branchenstandard-Frameworks wie dem NIST Cybersecurity Framework. Dieses Framework trägt dazu bei, sicherzustellen, dass Ihre Sicherheitsmaßnahmen über die Säulen „Identifizieren“, „Schützen“, „Erkennen“, „Reagieren“, „Wiederherstellen“ und zuletzt auch „Regieren“ geschützt sind. Dieses Framework lässt sich dann problemlos auf AWS-Sicherheitsdienste und Dienste integrierter Dritter abbilden, um Ihnen bei der Validierung einer angemessenen Abdeckung und Richtlinien für alle Sicherheitsereignisse zu helfen, denen Ihr Unternehmen begegnet.

Tiefgreifende Verteidigung: Sichern Sie Ihre Umgebung und fügen Sie dann erweiterte KI/ML-spezifische Sicherheits- und Datenschutzfunktionen hinzu

Eine tiefgreifende Verteidigungsstrategie sollte zunächst mit dem Schutz Ihrer Konten und Ihrer Organisation beginnen und dann die zusätzlichen integrierten Sicherheits- und Datenschutzfunktionen von Diensten wie z. B. ergänzen Amazonas Grundgestein und Amazon Sage Maker. Amazon verfügt über mehr als 30 Dienste im Portfolio für Sicherheit, Identität und Compliance die in AWS AI/ML-Services integriert sind und zusammen verwendet werden können, um Ihre Arbeitslasten, Konten und Ihr Unternehmen zu schützen. Um sich gegen die OWASP Top 10 für LLM richtig zu verteidigen, sollten diese zusammen mit den AWS AI/ML-Services genutzt werden.

Beginnen Sie mit der Implementierung einer Richtlinie der geringsten Rechte und nutzen Sie Dienste wie IAM-Zugriffsanalysator zu Suchen Sie nach übermäßig freizügigen Konten, Rollen und Ressourcen, um den Zugriff mithilfe kurzfristiger Anmeldeinformationen einzuschränken. Stellen Sie als Nächstes sicher, dass alle ruhenden Daten mit AWS KMS verschlüsselt sind, einschließlich der Verwendung von CMKs, und dass alle Daten und Modelle mithilfe von AWS KMS versioniert und gesichert werden Amazon Simple Storage-Service (Amazon S3) Versionierung und Anwendung der Unveränderlichkeit auf Objektebene mit Amazon S3-Objektsperre. Schützen Sie alle Daten bei der Übertragung zwischen Diensten AWS-Zertifikatsmanager und / oder AWS Private CA, und behalten Sie es innerhalb der VPCs, die es verwenden AWS PrivateLink. Definieren Sie strenge Regeln für den Dateneingang und -ausgang, um sich vor Manipulation und Exfiltration mithilfe von VPCs zu schützen AWS-Netzwerk-Firewall Richtlinien. Erwägen Sie das Einfügen AWS Web Application Firewall (AWS WAF) vor Schützen Sie Webanwendungen und APIs für bösartige Bots, SQL-Injection-Angriffe, Cross-Site-Scripting (XSS), und Kontoübernahmen mit Betrugsbekämpfung. Protokollierung mit AWS CloudTrail, Amazon Virtual Private Cloud (Amazon VPC) Flussprotokolle und Amazon Elastic Kubernetes-Service (Amazon EKS) Audit-Protokolle helfen bei der forensischen Überprüfung jeder Transaktion, die für Dienste wie z. B. verfügbar ist Amazon-Detektiv. Sie können Amazon-Inspektor zur Automatisierung der Schwachstellenerkennung und -verwaltung Amazon Elastic Compute-Cloud (Amazon EC2) Instanzen, Container, AWS Lambda Funktionen und Identifizieren Sie die Netzwerkerreichbarkeit Ihrer Workloads. Schützen Sie Ihre Daten und Modelle vor verdächtigen Aktivitäten Amazon-WachdienstDie ML-gestützten Bedrohungsmodelle und Intelligence-Feeds werden von Microsoft bereitgestellt und die zusätzlichen Funktionen für EKS-Schutz, ECS-Schutz, S3-Schutz, RDS-Schutz, Malware-Schutz, Lambda-Schutz und mehr aktiviert. Sie können Dienste wie nutzen AWS-Sicherheits-Hub um Ihre Sicherheitsüberprüfungen zu zentralisieren und zu automatisieren, um Abweichungen von bewährten Sicherheitspraktiken zu erkennen und die Untersuchung zu beschleunigen und die Behebung von Sicherheitsbefunden mit Playbooks zu automatisieren. Sie können auch die Implementierung von a in Betracht ziehen null vertrauen Architektur auf AWS, um die feinkörnige Authentifizierungs- und Autorisierungskontrolle für das, worauf menschliche Benutzer oder Maschine-zu-Maschine-Prozesse auf Anfragebasis zugreifen können, weiter zu verbessern. Erwägen Sie auch die Verwendung Amazon Security Lake um Sicherheitsdaten aus AWS-Umgebungen, SaaS-Anbietern, vor Ort und Cloud-Quellen automatisch in einem speziell entwickelten Datensee zu zentralisieren, der in Ihrem Konto gespeichert ist. Mit Security Lake erhalten Sie ein umfassenderes Verständnis Ihrer Sicherheitsdaten in Ihrem gesamten Unternehmen.

Nachdem Ihre generative KI-Workload-Umgebung gesichert wurde, können Sie KI-/ML-spezifische Funktionen einbinden, z Amazon SageMaker Data Wrangler um potenzielle Verzerrungen während der Datenvorbereitung zu identifizieren und Amazon SageMaker klären um Verzerrungen in ML-Daten und -Modellen zu erkennen. Sie können auch verwenden Amazon SageMaker-Modellmonitor um die Qualität von SageMaker ML-Modellen in der Produktion zu bewerten und Sie zu benachrichtigen, wenn es Abweichungen bei der Datenqualität, der Modellqualität und der Merkmalszuordnung gibt. Die Zusammenarbeit dieser AWS-KI/ML-Dienste (einschließlich SageMaker in Zusammenarbeit mit Amazon Bedrock) mit AWS-Sicherheitsdiensten kann Ihnen dabei helfen, potenzielle Quellen natürlicher Voreingenommenheit zu identifizieren und sich vor böswilliger Datenmanipulation zu schützen. Wiederholen Sie diesen Vorgang für jede der OWASP Top 10 für LLM-Schwachstellen, um sicherzustellen, dass Sie den Wert der AWS-Services maximieren, um eine umfassende Verteidigung zum Schutz Ihrer Daten und Arbeitslasten zu implementieren.

Wie AWS Enterprise Strategist Clarke Rodgers in seinem Blogbeitrag schrieb „CISO Insight: Jeder AWS-Service ist ein Sicherheitsservice“„Ich würde argumentieren, dass praktisch jeder Dienst innerhalb der AWS-Cloud entweder für sich genommen ein Sicherheitsergebnis ermöglicht oder von Kunden (allein oder in Verbindung mit einem oder mehreren Diensten) verwendet werden kann, um ein Sicherheits-, Risiko- oder Compliance-Ziel zu erreichen.“ Und „Kunden-Chief Information Security Officers (CISOs) (oder ihre jeweiligen Teams) möchten sich möglicherweise die Zeit nehmen, um sicherzustellen, dass sie mit allen AWS-Diensten gut vertraut sind, da möglicherweise ein Sicherheits-, Risiko- oder Compliance-Ziel erreicht werden kann.“ auch wenn ein Dienst nicht in die Kategorie „Sicherheit, Identität und Compliance“ fällt.“

Layer-Verteidigungen an Vertrauensgrenzen in LLM-Anwendungen

Bei der Entwicklung generativer KI-basierter Systeme und Anwendungen sollten Sie die gleichen Bedenken berücksichtigen wie bei jeder anderen ML-Anwendung, wie im erwähnt MITRE ATLAS Bedrohungsmatrix für maschinelles LernenB. die Berücksichtigung der Herkunft von Software und Datenkomponenten (z. B. die Durchführung eines Open-Source-Software-Audits, die Überprüfung von Software-Stücklisten (SBOMs) und die Analyse von Daten-Workflows und API-Integrationen) und die Implementierung notwendiger Schutzmaßnahmen gegen Bedrohungen der LLM-Lieferkette. Beziehen Sie Erkenntnisse aus Branchen-Frameworks ein und achten Sie auf Möglichkeiten, mehrere Quellen von Bedrohungsinformationen und Risikoinformationen zu nutzen, um Ihre Sicherheitsmaßnahmen anzupassen und zu erweitern, um KI-, ML- und generative KI-Sicherheitsrisiken zu berücksichtigen, die neu auftreten und nicht in herkömmlichen Frameworks enthalten sind. Informieren Sie sich über begleitende Informationen zu KI-spezifischen Risiken aus Branchen-, Verteidigungs-, Regierungs-, internationalen und akademischen Quellen, da in diesem Bereich regelmäßig neue Bedrohungen auftauchen und sich weiterentwickeln und begleitende Frameworks und Leitfäden häufig aktualisiert werden. Wenn Sie beispielsweise ein Retrieval Augmented Generation (RAG)-Modell verwenden und das Modell nicht die benötigten Daten enthält, kann es diese von einer externen Datenquelle anfordern, um sie während der Inferenzierung und Feinabstimmung zu verwenden. Die abgefragte Quelle liegt möglicherweise außerhalb Ihrer Kontrolle und kann eine potenzielle Quelle für Gefährdungen in Ihrer Lieferkette darstellen. Ein Defense-in-Depth-Ansatz sollte auf externe Quellen ausgeweitet werden, um Vertrauen, Authentifizierung, Autorisierung, Zugriff, Sicherheit, Datenschutz und Genauigkeit der Daten, auf die zugegriffen wird, herzustellen. Um tiefer einzutauchen, lesen Sie „Erstellen Sie mit Amazon SageMaker JumpStart eine sichere Unternehmensanwendung mit generativer KI und RAG"

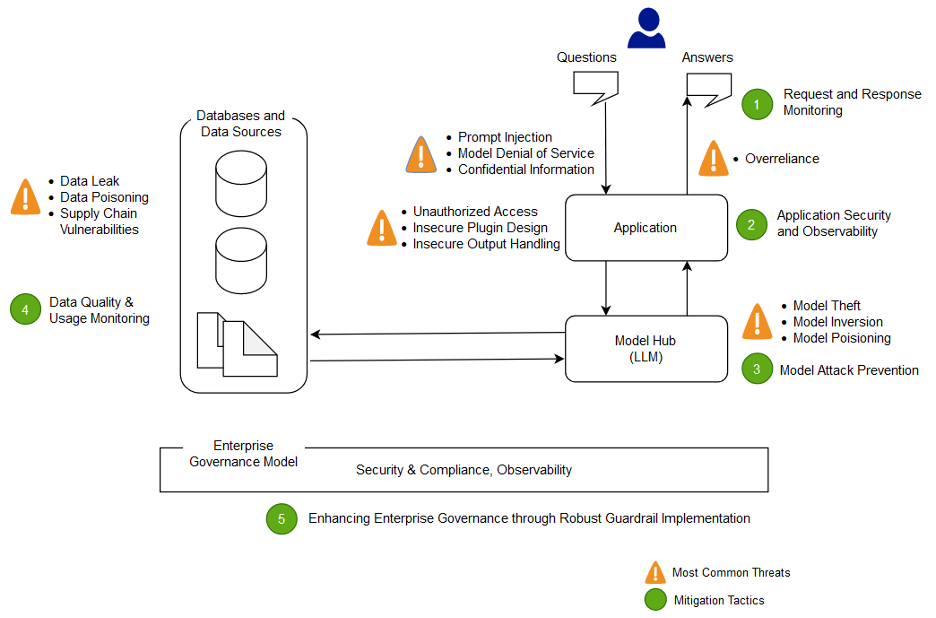

Analysieren und mindern Sie Risiken in Ihren LLM-Anwendungen

In diesem Abschnitt analysieren und diskutieren wir einige Techniken zur Risikominderung, die auf Vertrauensgrenzen und Interaktionen oder bestimmten Bereichen der Arbeitslast mit ähnlichem geeigneten Kontrollumfang und Risikoprofil basieren. In dieser Beispielarchitektur einer Chatbot-Anwendung gibt es fünf Vertrauensgrenzen, an denen Kontrollen demonstriert werden, basierend darauf, wie AWS-Kunden ihre LLM-Anwendungen üblicherweise erstellen. Ihre LLM-Anwendung verfügt möglicherweise über mehr oder weniger definierbare Vertrauensgrenzen. In der folgenden Beispielarchitektur sind diese Vertrauensgrenzen wie folgt definiert:

- Interaktionen der Benutzeroberfläche (Anfrage und Antwort)

- Anwendungsinteraktionen

- Modellinteraktionen

- Dateninteraktionen

- Organisatorische Interaktionen und Nutzung

Interaktionen mit der Benutzeroberfläche: Entwickeln Sie die Überwachung von Anfragen und Antworten

Erkennen Sie Cybervorfälle im Zusammenhang mit generativer KI und reagieren Sie rechtzeitig darauf, indem Sie eine Strategie zur Bewältigung der Risiken aus den Ein- und Ausgängen der generativen KI-Anwendung evaluieren. Beispielsweise muss möglicherweise eine zusätzliche Überwachung von Verhalten und Datenabfluss instrumentiert werden, um die Offenlegung vertraulicher Informationen außerhalb Ihrer Domäne oder Organisation zu erkennen, falls diese in der LLM-Anwendung verwendet werden.

Generative KI-Anwendungen sollten beim Schutz von Daten weiterhin die standardmäßigen Best Practices für die Sicherheit einhalten. Einrichtung einer Sicherer Datenperimeter und Sichern Sie sensible Datenspeicher. Verschlüsseln Sie Daten und Informationen, die für LLM-Anwendungen im Ruhezustand und während der Übertragung verwendet werden. Schützen Sie Daten, die zum Trainieren Ihres Modells verwendet werden, vor Trainingsdatenvergiftung, indem Sie verstehen und steuern, welche Benutzer, Prozesse und Rollen zu den Datenspeichern beitragen dürfen, wie Daten in der Anwendung fließen, auf Bias-Abweichungen überwachen und Versionierung und verwenden unveränderlicher Speicher in Speicherdiensten wie Amazon S3. Richten Sie mithilfe von Diensten wie AWS Network Firewall und AWS VPCs strenge Kontrollen für den Dateneingang und -ausgang ein, um sich vor verdächtigen Eingaben und der Möglichkeit einer Datenexfiltration zu schützen.

Während des Schulungs-, Umschulungs- oder Feinabstimmungsprozesses sollten Sie sich aller sensiblen Daten bewusst sein, die verwendet werden. Nachdem Daten während eines dieser Prozesse verwendet wurden, sollten Sie ein Szenario einplanen, in dem jeder Benutzer Ihres Modells plötzlich in der Lage ist, die Daten oder Informationen durch den Einsatz von Prompt-Injection-Techniken wieder zu extrahieren. Verstehen Sie die Risiken und Vorteile der Verwendung sensibler Daten in Ihren Modellen und Schlussfolgerungen. Implementieren Sie robuste Authentifizierungs- und Autorisierungsmechanismen zum Einrichten und Verwalten fein abgestufter Zugriffsberechtigungen, die nicht auf der LLM-Anwendungslogik basieren, um eine Offenlegung zu verhindern. Es hat sich gezeigt, dass benutzergesteuerte Eingaben in eine generative KI-Anwendung unter bestimmten Bedingungen einen Vektor bereitstellen können, um Informationen aus dem Modell oder anderen nicht benutzergesteuerten Teilen der Eingabe zu extrahieren. Dies kann über eine Prompt-Injection erfolgen, bei der der Benutzer Eingaben bereitstellt, die dazu führen, dass die Ausgabe des Modells von den erwarteten Leitplanken der LLM-Anwendung abweicht, einschließlich der Bereitstellung von Hinweisen auf die Datensätze, auf denen das Modell ursprünglich trainiert wurde.

Implementieren Sie Zugriffskontingente auf Benutzerebene für Benutzer, die Eingaben bereitstellen und Ausgaben von einem Modell empfangen. Sie sollten Ansätze in Betracht ziehen, die keinen anonymen Zugriff zulassen, wenn die Modelltrainingsdaten und -informationen vertraulich sind oder das Risiko besteht, dass ein Gegner ein Faksimile Ihres Modells auf der Grundlage seiner Eingaben und Ihrer abgestimmten Modellausgabe trainiert. Wenn ein Teil der Eingabe in ein Modell aus willkürlichem, vom Benutzer bereitgestelltem Text besteht, ist die Ausgabe im Allgemeinen als anfällig für eine sofortige Injektion zu betrachten und stellt dementsprechend sicher, dass die Verwendung der Ausgaben implementierte technische und organisatorische Gegenmaßnahmen umfasst, um unsichere Ausgabeverarbeitung und übermäßige Handlungsfähigkeit zu entschärfen und übermäßiges Vertrauen. Im obigen Beispiel, das sich auf die Filterung böswilliger Eingaben mithilfe von AWS WAF bezieht, sollten Sie erwägen, vor Ihrer Anwendung einen Filter für einen solchen potenziellen Missbrauch von Eingabeaufforderungen zu erstellen und eine Richtlinie zu entwickeln, wie diese gehandhabt und weiterentwickelt werden, wenn Ihr Modell und Ihre Daten wachsen. Erwägen Sie außerdem eine gefilterte Überprüfung der Ausgabe, bevor sie an den Benutzer zurückgegeben wird, um sicherzustellen, dass sie den Standards für Qualität, Genauigkeit oder Inhaltsmoderation entspricht. Möglicherweise möchten Sie dies noch weiter an die Anforderungen Ihres Unternehmens anpassen, indem Sie Ihren Modellen eine zusätzliche Kontrollebene für Ein- und Ausgänge hinzufügen, um verdächtige Datenverkehrsmuster abzuschwächen.

Anwendungsinteraktionen: Anwendungssicherheit und Beobachtbarkeit

Überprüfen Sie Ihre LLM-Anwendung und achten Sie darauf, wie ein Benutzer Ihr Modell nutzen könnte, um die Standardautorisierung für ein nachgelagertes Tool oder eine Toolchain zu umgehen, für die er keine Zugriffs- oder Nutzungsberechtigung hat. Ein weiteres Problem auf dieser Ebene besteht im Zugriff auf externe Datenspeicher mithilfe eines Modells als Angriffsmechanismus unter Verwendung uneingeschränkter technischer oder organisatorischer LLM-Risiken. Wenn Ihr Modell beispielsweise darauf trainiert ist, auf bestimmte Datenspeicher zuzugreifen, die vertrauliche Daten enthalten könnten, sollten Sie sicherstellen, dass zwischen Ihrem Modell und den Datenspeichern ordnungsgemäße Autorisierungsprüfungen durchgeführt werden. Verwenden Sie bei der Durchführung von Autorisierungsprüfungen unveränderliche Attribute für Benutzer, die nicht aus dem Modell stammen. Uneingeschränkte, unsichere Ausgabeverarbeitung, unsicheres Plugin-Design und übermäßige Handlungsspielräume können Bedingungen schaffen, in denen ein Bedrohungsakteur ein Modell verwenden kann, um das Autorisierungssystem dazu zu verleiten, wirksame Berechtigungen zu erhöhen, was dazu führt, dass eine nachgelagerte Komponente glaubt, der Benutzer sei berechtigt, Daten abzurufen oder bestimmte Daten zu übernehmen Aktion.

Bei der Implementierung eines generativen KI-Plugins oder -Tools ist es unbedingt erforderlich, die gewährte Zugriffsebene zu prüfen und zu verstehen sowie die konfigurierten Zugriffskontrollen zu hinterfragen. Die Verwendung vollständig unsicherer generativer KI-Plugins kann Ihr System anfällig für Schwachstellen und Bedrohungen in der Lieferkette machen, was möglicherweise zu böswilligen Aktionen, einschließlich der Ausführung von Remotecode, führt.

Modellinteraktionen: Verhinderung von Modellangriffen

Sie sollten sich der Herkunft aller von Ihnen verwendeten Modelle, Plugins, Tools oder Daten bewusst sein, um Schwachstellen in der Lieferkette bewerten und beheben zu können. Einige gängige Modellformate ermöglichen beispielsweise die Einbettung beliebigen ausführbaren Codes in die Modelle selbst. Nutzen Sie Paketspiegelungen, Scans und zusätzliche Inspektionen entsprechend den Sicherheitszielen Ihres Unternehmens.

Die Datensätze, auf denen Sie trainieren und Ihre Modelle optimieren, müssen ebenfalls überprüft werden. Wenn Sie ein Modell basierend auf Benutzerfeedback (oder anderen vom Endbenutzer kontrollierbaren Informationen) weiter automatisch verfeinern, müssen Sie berücksichtigen, ob ein böswilliger Bedrohungsakteur das Modell aufgrund der Manipulation seiner Antworten willkürlich ändern und eine Trainingsdatenvergiftung bewirken könnte.

Dateninteraktionen: Überwachen Sie die Datenqualität und -nutzung

Generative KI-Modelle wie LLMs funktionieren im Allgemeinen gut, da sie auf einer großen Datenmenge trainiert wurden. Obwohl diese Daten LLMs dabei helfen, komplexe Aufgaben zu erledigen, können sie Ihr System auch dem Risiko einer Trainingsdatenvergiftung aussetzen, die auftritt, wenn ungeeignete Daten in einen Trainingsdatensatz eingefügt oder weggelassen werden, die das Verhalten eines Modells verändern können. Um dieses Risiko zu mindern, sollten Sie sich Ihre Lieferkette ansehen und den Datenüberprüfungsprozess für Ihr System verstehen, bevor es in Ihrem Modell verwendet wird. Obwohl die Trainingspipeline eine Hauptquelle für Datenvergiftung ist, sollten Sie auch prüfen, wie Ihr Modell Daten erhält, beispielsweise in einem RAG-Modell oder Data Lake, und ob die Quelle dieser Daten vertrauenswürdig und geschützt ist. Nutzen Sie AWS-Sicherheitsdienste wie AWS Security Hub, Amazon GuardDuty und Amazon Inspector, um die kontinuierliche Überwachung auf verdächtige Aktivitäten in Amazon EC2, Amazon EKS, Amazon S3 zu unterstützen. Relationaler Amazon-Datenbankdienst (Amazon RDS) und Netzwerkzugriff, die Indikatoren für neu auftretende Bedrohungen sein können, und verwenden Sie Detective, um Sicherheitsuntersuchungen zu visualisieren. Erwägen Sie auch die Nutzung von Diensten wie z Amazon Security Lake um Sicherheitsuntersuchungen zu beschleunigen, indem Sie einen speziell entwickelten Datensee erstellen, um Sicherheitsdaten aus AWS-Umgebungen, SaaS-Anbietern, vor Ort und Cloud-Quellen, die zu Ihren KI/ML-Workloads beitragen, automatisch zu zentralisieren.

Organisatorische Interaktionen: Implementieren Sie Unternehmens-Governance-Leitlinien für generative KI

Identifizieren Sie Risiken, die mit dem Einsatz generativer KI für Ihr Unternehmen verbunden sind. Sie sollten die Risikotaxonomie Ihres Unternehmens aufbauen und Risikobewertungen durchführen, um fundierte Entscheidungen bei der Bereitstellung generativer KI-Lösungen zu treffen. Entwickeln Sie eine Business-Continuity-Plan (BCP) Dazu gehören KI-, ML- und generative KI-Workloads, die schnell umgesetzt werden können, um die verlorene Funktionalität einer betroffenen oder Offline-LLM-Anwendung zu ersetzen und Ihre SLAs einzuhalten.

Identifizieren Sie Prozess- und Ressourcenlücken, Ineffizienzen und Inkonsistenzen und verbessern Sie das Bewusstsein und die Eigenverantwortung in Ihrem gesamten Unternehmen. Bedrohungsmodell alle generativen KI-Workloads, um potenzielle Sicherheitsbedrohungen zu identifizieren und zu mindern, die zu geschäftsbeeinträchtigenden Ergebnissen führen können, einschließlich unbefugtem Zugriff auf Daten, Denial-of-Service und Ressourcenmissbrauch. Nutzen Sie das Neue AWS Threat Composer-Modellierungstool um die Time-to-Value bei der Bedrohungsmodellierung zu verkürzen. Erwägen Sie später in Ihren Entwicklungszyklen die Einführung Sicherheits-Chaos-Engineering Führen Sie Fehlerinjektionsexperimente durch, um reale Bedingungen zu schaffen, um zu verstehen, wie Ihr System auf Unbekannte reagiert, und um Vertrauen in die Ausfallsicherheit und Sicherheit des Systems aufzubauen.

Beziehen Sie unterschiedliche Perspektiven in die Entwicklung von Sicherheitsstrategien und Risikomanagementmechanismen ein, um die Einhaltung und Abdeckung von KI/ML und generativer Sicherheit in allen Jobrollen und Funktionen sicherzustellen. Bringen Sie von Anfang an und bei der Erforschung jeder generativen KI-Anwendung eine Sicherheitsmentalität mit ein, um sie an den Anforderungen auszurichten. Wenn Sie zusätzliche Unterstützung von AWS benötigen, bitten Sie Ihren AWS-Kundenbetreuer, sicherzustellen, dass gleichwertiger Support gewährleistet ist, indem Sie AWS Solutions Architects von AWS Security und AI/ML bitten, gemeinsam zu helfen.

Stellen Sie sicher, dass Ihre Sicherheitsorganisation regelmäßig Maßnahmen ergreift, um die Kommunikation rund um das Risikobewusstsein und das Verständnis des Risikomanagements zwischen generativen KI-Stakeholdern wie Produktmanagern, Softwareentwicklern, Datenwissenschaftlern und Führungskräften zu fördern, sodass Bedrohungsinformationen und Kontrollanleitungen die Teams erreichen können, die möglicherweise betroffen sind beeinflusst werden. Sicherheitsorganisationen können eine Kultur der verantwortungsvollen Offenlegung und iterativen Verbesserung unterstützen, indem sie sich an Diskussionen beteiligen und den Stakeholdern der generativen KI neue Ideen und Informationen bringen, die sich auf ihre Geschäftsziele beziehen. Lerne mehr über unser Engagement für verantwortungsvolle KI und zusätzlich verantwortungsvolle KI-Ressourcen um unseren Kunden zu helfen.

Verschaffen Sie sich Vorteile bei der Ermöglichung einer besseren Organisationslage für generative KI, indem Sie die Zeit bis zur Wertschöpfung in den bestehenden Sicherheitsprozessen Ihres Unternehmens freigeben. Bewerten Sie proaktiv, wo Ihr Unternehmen möglicherweise Prozesse benötigt, die angesichts des generativen KI-Sicherheitskontexts übermäßig aufwändig sind, und verfeinern Sie diese, um Entwicklern und Wissenschaftlern einen klaren Weg für den Start mit den richtigen Kontrollen zu bieten.

Bewerten Sie, wo es Möglichkeiten gibt, Anreize aufeinander abzustimmen, das Risiko zu reduzieren und einen klaren Überblick über die gewünschten Ergebnisse zu geben. Aktualisieren Sie die Kontrollrichtlinien und Abwehrmaßnahmen, um den sich entwickelnden Anforderungen der KI/ML- und generativen KI-Anwendungsentwicklung gerecht zu werden und Verwirrung und Unsicherheit zu reduzieren, die Entwicklungszeit kosten, das Risiko erhöhen und die Wirkung steigern können.

Stellen Sie sicher, dass Stakeholder, die keine Sicherheitsexperten sind, sowohl verstehen können, wie organisatorische Governance, Richtlinien und Risikomanagementschritte auf ihre Workloads angewendet werden, als auch Risikomanagementmechanismen anwenden können. Bereiten Sie Ihr Unternehmen darauf vor, auf realistische Ereignisse und Szenarien zu reagieren, die bei generativen KI-Anwendungen auftreten können, und stellen Sie sicher, dass die Rollen und Reaktionsteams der generativen KI-Entwickler über Eskalationspfade und Maßnahmen informiert sind, falls Bedenken hinsichtlich verdächtiger Aktivitäten bestehen.

Zusammenfassung

Um Innovationen mit jeder neuen und aufkommenden Technologie erfolgreich zu kommerzialisieren, müssen Sie mit einer sicherheitsorientierten Denkweise beginnen, auf einer sicheren Infrastrukturbasis aufbauen und darüber nachdenken, wie Sie die Sicherheit auf jeder Ebene des Technologie-Stacks frühzeitig mit einer tiefgreifenden Sicherheitsstrategie weiter integrieren können Ansatz. Dazu gehören Interaktionen auf mehreren Ebenen Ihres Technologie-Stacks und Integrationspunkte innerhalb Ihrer digitalen Lieferkette, um die Ausfallsicherheit Ihrer Organisation sicherzustellen. Auch wenn generative KI einige neue Sicherheits- und Datenschutzherausforderungen mit sich bringt, können Sie Ihr Unternehmen vor vielen häufigen Problemen und sich entwickelnden Bedrohungen schützen, wenn Sie grundlegende Best Practices für Sicherheit befolgen, wie z. B. die Verwendung von Tiefenverteidigung mit mehrschichtigen Sicherheitsdiensten. Sie sollten mehrschichtige AWS-Sicherheitsdienste für Ihre generativen KI-Workloads und Ihr größeres Unternehmen implementieren und sich auf Integrationspunkte in Ihren digitalen Lieferketten konzentrieren, um Ihre Cloud-Umgebungen zu sichern. Anschließend können Sie die erweiterten Sicherheits- und Datenschutzfunktionen in AWS AI/ML-Services wie Amazon SageMaker und Amazon Bedrock nutzen, um Ihren generativen KI-Anwendungen weitere Ebenen verbesserter Sicherheits- und Datenschutzkontrollen hinzuzufügen. Durch die Integration von Sicherheit von Anfang an wird es schneller, einfacher und kostengünstiger, Innovationen mit generativer KI voranzutreiben und gleichzeitig die Compliance zu vereinfachen. Dies wird Ihnen dabei helfen, die Kontrolle, das Vertrauen und die Beobachtbarkeit Ihrer generativen KI-Anwendungen für Ihre Mitarbeiter, Kunden, Partner, Aufsichtsbehörden und andere betroffene Interessengruppen zu erhöhen.

Zusätzliche Referenzen

- Branchenstandard-Frameworks für KI/ML-spezifisches Risikomanagement und Sicherheit:

Über die Autoren

Christoph Rae ist ein weltweit führender GTM-Sicherheitsspezialist, der sich auf die Entwicklung und Umsetzung strategischer Initiativen konzentriert, die die Einführung von AWS-Sicherheitsdiensten beschleunigen und skalieren. Er ist begeistert von der Schnittstelle zwischen Cybersicherheit und neuen Technologien und verfügt über mehr als 20 Jahre Erfahrung in globalen strategischen Führungspositionen bei der Bereitstellung von Sicherheitslösungen für Medien-, Unterhaltungs- und Telekommunikationskunden. Er tankt neue Energie durch Lesen, Reisen, Essen und Wein, das Entdecken neuer Musik und die Beratung von Startups in der Frühphase.

Christoph Rae ist ein weltweit führender GTM-Sicherheitsspezialist, der sich auf die Entwicklung und Umsetzung strategischer Initiativen konzentriert, die die Einführung von AWS-Sicherheitsdiensten beschleunigen und skalieren. Er ist begeistert von der Schnittstelle zwischen Cybersicherheit und neuen Technologien und verfügt über mehr als 20 Jahre Erfahrung in globalen strategischen Führungspositionen bei der Bereitstellung von Sicherheitslösungen für Medien-, Unterhaltungs- und Telekommunikationskunden. Er tankt neue Energie durch Lesen, Reisen, Essen und Wein, das Entdecken neuer Musik und die Beratung von Startups in der Frühphase.

Elijah Winter ist Senior Security Engineer bei Amazon Security, hat einen Bachelor-Abschluss in Cyber Security Engineering und ist von einer Vorliebe für Harry Potter durchdrungen. Elijah zeichnet sich dadurch aus, dass er Schwachstellen in KI-Systemen identifiziert und behebt, indem er technisches Fachwissen mit einem Hauch Zauberei verbindet. Elijah entwirft maßgeschneiderte Sicherheitsprotokolle für KI-Ökosysteme und verleiht digitalen Abwehrmaßnahmen ein magisches Flair. Elijah ist integritätsorientiert und verfügt über einen Sicherheitshintergrund sowohl im öffentlichen als auch im kommerziellen Sektor, der sich auf den Schutz von Vertrauen konzentriert.

Elijah Winter ist Senior Security Engineer bei Amazon Security, hat einen Bachelor-Abschluss in Cyber Security Engineering und ist von einer Vorliebe für Harry Potter durchdrungen. Elijah zeichnet sich dadurch aus, dass er Schwachstellen in KI-Systemen identifiziert und behebt, indem er technisches Fachwissen mit einem Hauch Zauberei verbindet. Elijah entwirft maßgeschneiderte Sicherheitsprotokolle für KI-Ökosysteme und verleiht digitalen Abwehrmaßnahmen ein magisches Flair. Elijah ist integritätsorientiert und verfügt über einen Sicherheitshintergrund sowohl im öffentlichen als auch im kommerziellen Sektor, der sich auf den Schutz von Vertrauen konzentriert.

Widder Vittal ist Principal ML Solutions Architect bei AWS. Er verfügt über mehr als drei Jahrzehnte Erfahrung in der Architektur und Entwicklung verteilter, Hybrid- und Cloud-Anwendungen. Seine Leidenschaft gilt der Entwicklung sicherer und skalierbarer KI/ML- und Big-Data-Lösungen, um Unternehmenskunden bei der Einführung und Optimierung der Cloud zu unterstützen und so ihre Geschäftsergebnisse zu verbessern. In seiner Freizeit fährt er Motorrad und geht mit seinem 3-jährigen Sheepadoodle spazieren!

Widder Vittal ist Principal ML Solutions Architect bei AWS. Er verfügt über mehr als drei Jahrzehnte Erfahrung in der Architektur und Entwicklung verteilter, Hybrid- und Cloud-Anwendungen. Seine Leidenschaft gilt der Entwicklung sicherer und skalierbarer KI/ML- und Big-Data-Lösungen, um Unternehmenskunden bei der Einführung und Optimierung der Cloud zu unterstützen und so ihre Geschäftsergebnisse zu verbessern. In seiner Freizeit fährt er Motorrad und geht mit seinem 3-jährigen Sheepadoodle spazieren!

Navnet Tuteja ist Datenspezialist bei Amazon Web Services. Bevor er zu AWS kam, arbeitete Navneet als Vermittler für Organisationen, die ihre Datenarchitekturen modernisieren und umfassende KI/ML-Lösungen implementieren wollten. Sie verfügt über einen Ingenieurabschluss der Thapar University sowie einen Master-Abschluss in Statistik der Texas A&M University.

Navnet Tuteja ist Datenspezialist bei Amazon Web Services. Bevor er zu AWS kam, arbeitete Navneet als Vermittler für Organisationen, die ihre Datenarchitekturen modernisieren und umfassende KI/ML-Lösungen implementieren wollten. Sie verfügt über einen Ingenieurabschluss der Thapar University sowie einen Master-Abschluss in Statistik der Texas A&M University.

Emily Soward ist Data Scientist bei AWS Professional Services. Sie hat einen Master of Science mit Auszeichnung in Künstlicher Intelligenz von der University of Edinburgh in Schottland, Vereinigtes Königreich mit Schwerpunkt auf Natural Language Processing (NLP). Emily war in angewandten wissenschaftlichen und technischen Funktionen tätig, die sich auf KI-gestützte Produktforschung und -entwicklung, operative Exzellenz und Governance für KI-Workloads konzentrierten, die in Organisationen im öffentlichen und privaten Sektor ausgeführt wurden. Sie trägt als AWS Senior Speaker und kürzlich als Autorin für AWS Well-Architected in the Machine Learning Lens zur Kundenberatung bei.

Emily Soward ist Data Scientist bei AWS Professional Services. Sie hat einen Master of Science mit Auszeichnung in Künstlicher Intelligenz von der University of Edinburgh in Schottland, Vereinigtes Königreich mit Schwerpunkt auf Natural Language Processing (NLP). Emily war in angewandten wissenschaftlichen und technischen Funktionen tätig, die sich auf KI-gestützte Produktforschung und -entwicklung, operative Exzellenz und Governance für KI-Workloads konzentrierten, die in Organisationen im öffentlichen und privaten Sektor ausgeführt wurden. Sie trägt als AWS Senior Speaker und kürzlich als Autorin für AWS Well-Architected in the Machine Learning Lens zur Kundenberatung bei.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/