Hình ảnh của Tác giả

Đối với nhiều người trong chúng ta, việc khám phá các khả năng của LLM có vẻ ngoài tầm với. Cho dù đó là tải xuống phần mềm phức tạp, tìm hiểu mã hóa hay cần máy móc mạnh mẽ – việc bắt đầu với LLM có vẻ khó khăn. Nhưng hãy tưởng tượng, nếu chúng ta có thể tương tác với các mô hình ngôn ngữ mạnh mẽ này dễ dàng như khởi động bất kỳ chương trình nào khác trên máy tính của mình. Không cần cài đặt, không mã hóa, chỉ cần nhấp chuột và nói chuyện. Khả năng truy cập này là chìa khóa cho cả nhà phát triển và người dùng cuối. llamaFile nổi lên như một giải pháp mới, hợp nhất cuộc gọi.cpp với Libc quốc tế vào một khuôn khổ duy nhất. Khung này làm giảm sự phức tạp của LLM bằng cách cung cấp một một tập tin thực thi được gọi là "tập tin llama", chạy trên máy cục bộ mà không cần cài đặt.

Vì vậy, làm thế nào nó hoạt động? ưu đãi llamaFile hai phương pháp thuận tiện để chạy LLM:

- Phương pháp đầu tiên liên quan đến việc tải xuống bản phát hành mới nhất của llamafile cùng với trọng lượng mô hình tương ứng từ Ôm mặt. Khi bạn có những tập tin đó, bạn đã sẵn sàng!

- Phương pháp thứ hai thậm chí còn đơn giản hơn – bạn có thể truy cập llamafiles ví dụ có sẵn có trọng lượng tích hợp.

Trong hướng dẫn này, bạn sẽ làm việc với llamafile của mô hình LLaVa sử dụng phương pháp thứ hai. Đó là mô hình 7 tỷ tham số được lượng tử hóa thành 4 bit mà bạn có thể tương tác qua trò chuyện, tải hình ảnh lên và đặt câu hỏi. Các tệp llamafile mẫu của các mô hình khác cũng có sẵn, nhưng chúng tôi sẽ làm việc với mô hình LLaVa vì kích thước tệp llamafile của nó là 3.97 GB, trong khi Windows có kích thước tệp thực thi tối đa là 4 GB. Quá trình này đủ đơn giản và bạn có thể chạy LLM bằng cách làm theo các bước được đề cập bên dưới.

Trước tiên, bạn cần tải xuống tệp thực thi llava-v1.5-7b-q4.llamafile (3.97 GB) từ nguồn được cung cấp tại đây.

Mở thiết bị đầu cuối của máy tính và điều hướng đến thư mục chứa tệp. Sau đó chạy lệnh sau để cấp quyền cho máy tính của bạn thực thi tệp này.

chmod +x llava-v1.5-7b-q4.llamafileNếu bạn đang dùng Windows, hãy thêm “.exe” vào tên của llamafile ở cuối. Bạn có thể chạy lệnh sau trên thiết bị đầu cuối cho mục đích này.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeThực thi tệp llama bằng lệnh sau.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ Vì MacOS sử dụng zsh làm shell mặc định và nếu bạn gặp phải zsh: exec format error: ./llava-v1.5-7b-q4.llamafile lỗi thì bạn cần thực hiện điều này:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Đối với Windows, lệnh của bạn có thể trông như thế này:

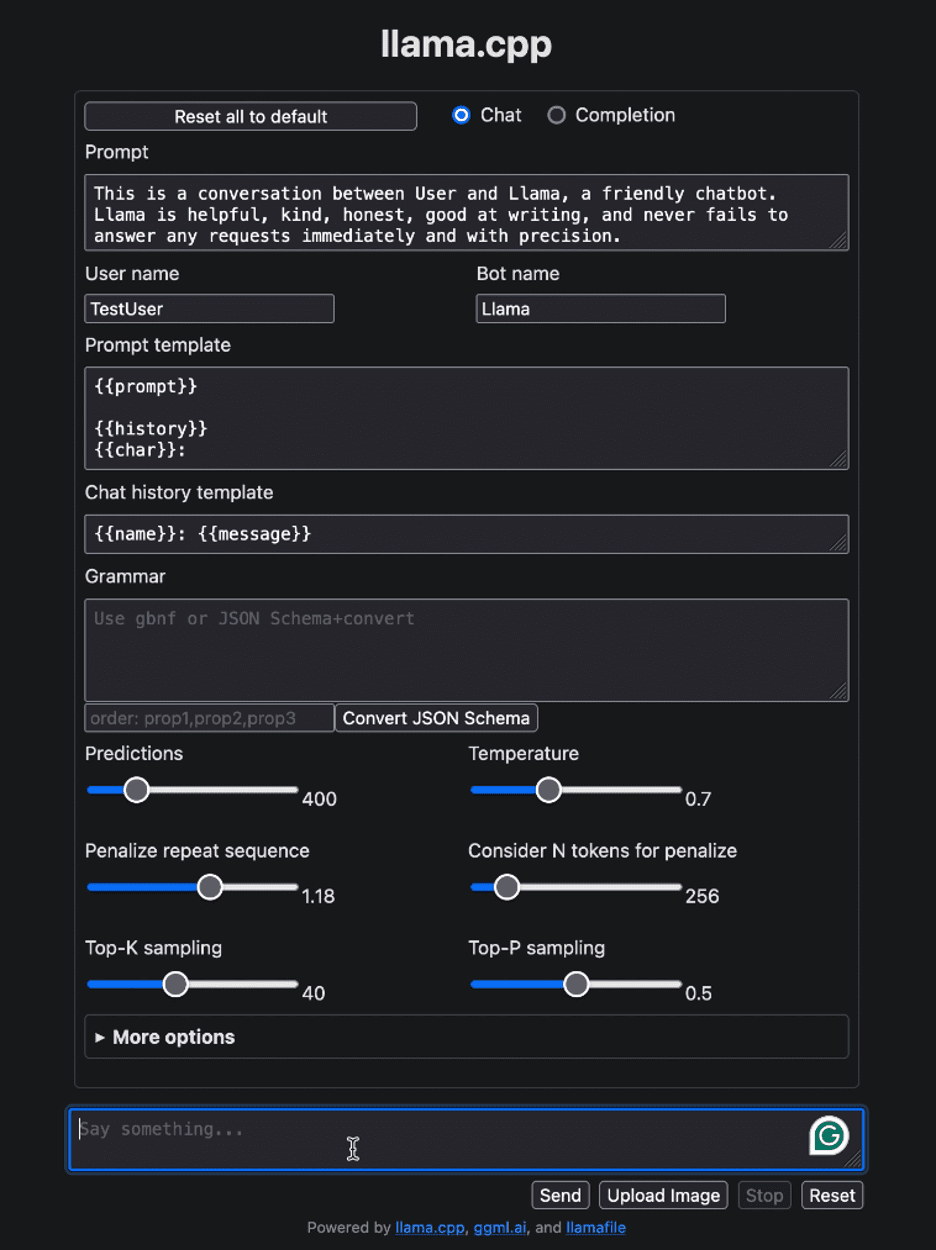

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Sau khi chạy llamafile, nó sẽ tự động mở trình duyệt mặc định của bạn và hiển thị giao diện người dùng như bên dưới. Nếu không, hãy mở trình duyệt và điều hướng đến http://localhost:8080 bằng tay.

Hình ảnh của Tác giả

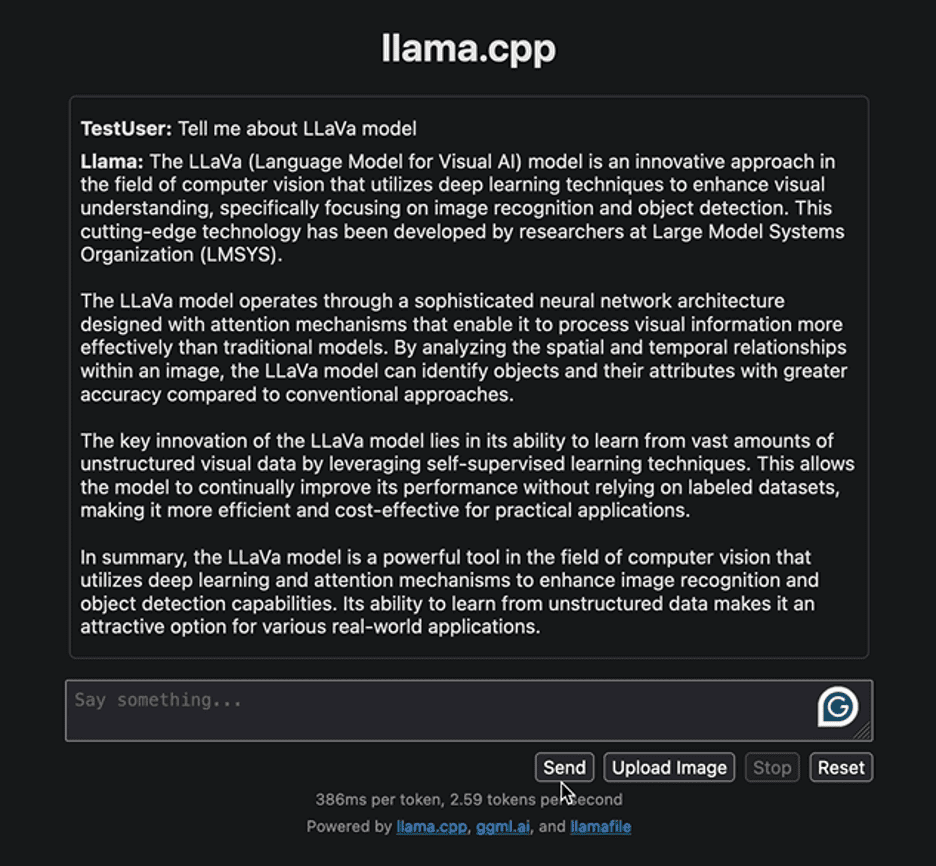

Hãy bắt đầu bằng việc tương tác với giao diện bằng một câu hỏi đơn giản nhằm cung cấp một số thông tin liên quan đến mô hình LLaVa. Dưới đây là phản hồi do mô hình tạo ra:

Hình ảnh của Tác giả

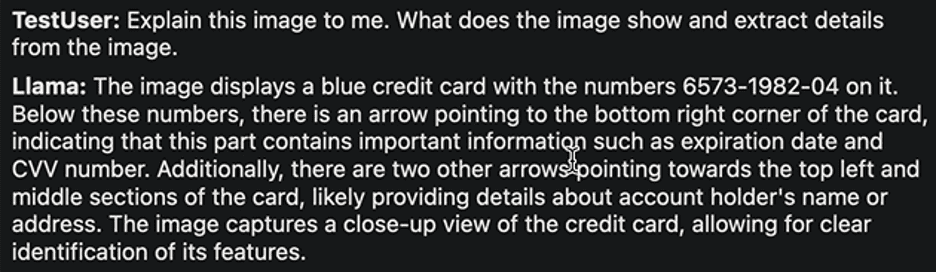

Phản hồi nêu bật cách tiếp cận để phát triển mô hình LLaVa và các ứng dụng của nó. Phản hồi được tạo ra khá nhanh. Hãy thử thực hiện một nhiệm vụ khác. Chúng tôi sẽ tải lên hình ảnh mẫu thẻ ngân hàng sau đây với các chi tiết trên đó và trích xuất thông tin cần thiết từ đó.

Hình ảnh của Ruby Thompson

Đây là phản hồi:

Hình ảnh của Tác giả

Một lần nữa, câu trả lời là khá hợp lý. Các tác giả của LLaVa tuyên bố rằng nó đạt được hiệu suất cao nhất trong nhiều nhiệm vụ khác nhau. Hãy thoải mái khám phá các nhiệm vụ đa dạng, quan sát những thành công và hạn chế của chúng, đồng thời tự mình trải nghiệm hiệu suất vượt trội của LLaVa.

Sau khi quá trình tương tác của bạn với LLM hoàn tất, bạn có thể tắt tệp llama bằng cách quay lại thiết bị đầu cuối và nhấn “Control - C”.

Việc phân phối và chạy LLM chưa bao giờ đơn giản hơn thế. Trong hướng dẫn này, chúng tôi đã giải thích cách bạn có thể chạy và thử nghiệm các mô hình khác nhau dễ dàng như thế nào chỉ bằng một tệp thực thi duy nhất. Điều này không chỉ tiết kiệm thời gian và nguồn lực mà còn mở rộng khả năng tiếp cận và tiện ích trong thế giới thực của LLM. Chúng tôi hy vọng bạn thấy hướng dẫn này hữu ích và muốn nghe suy nghĩ của bạn về nó. Ngoài ra, nếu bạn có bất kỳ câu hỏi hoặc phản hồi nào, vui lòng liên hệ với chúng tôi. Chúng tôi luôn sẵn lòng trợ giúp và đánh giá cao ý kiến đóng góp của bạn.

Cảm ơn bạn đã đọc!

Kanwal Mehreen Kanwal là một kỹ sư máy học và một nhà văn kỹ thuật có niềm đam mê sâu sắc với khoa học dữ liệu và sự kết hợp giữa AI với y học. Cô là đồng tác giả cuốn sách “Tối đa hóa năng suất với ChatGPT”. Với tư cách là Học giả Thế hệ Google năm 2022 cho khu vực Châu Á Thái Bình Dương, cô đề cao sự đa dạng và sự xuất sắc trong học tập. Cô cũng được công nhận là Học giả Công nghệ Đa dạng Teradata, Học giả Nghiên cứu Globalink của Mitacs và Học giả WeCode của Harvard. Kanwal là người ủng hộ nhiệt thành cho sự thay đổi, ông đã thành lập FEMCodes để trao quyền cho phụ nữ trong các lĩnh vực STEM.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps