Giới thiệu

Hệ thống AI thời gian thực phụ thuộc rất nhiều vào khả năng suy luận nhanh. API suy luận từ các công ty hàng đầu trong ngành như OpenAI, Google và Azure cho phép đưa ra quyết định nhanh chóng. Công nghệ Bộ xử lý ngôn ngữ (LPU) của Groq là giải pháp nổi bật, nâng cao hiệu quả xử lý AI. Bài viết này đi sâu vào công nghệ đổi mới của Groq, tác động của nó đến tốc độ suy luận AI và cách tận dụng nó bằng API Groq.

Mục tiêu học tập

- Hiểu công nghệ Đơn vị xử lý ngôn ngữ (LPU) của Groq và tác động của nó đến tốc độ suy luận AI

- Tìm hiểu cách sử dụng điểm cuối API của Groq cho các tác vụ xử lý AI theo thời gian thực, độ trễ thấp

- Khám phá khả năng của các mô hình được Groq hỗ trợ, chẳng hạn như Mixtral-8x7b-Instruct-v0.1 và Llama-70b, để hiểu và tạo ngôn ngữ tự nhiên

- So sánh và đối chiếu hệ thống LPU của Groq với các API suy luận khác, kiểm tra các yếu tố như tốc độ, hiệu quả và khả năng mở rộng

Bài báo này đã được xuất bản như một phần của Blogathon Khoa học Dữ liệu.

Mục lục

Groq là gì?

Được thành lập vào 2016, tiếng kêu là một công ty khởi nghiệp về giải pháp AI có trụ sở tại California với trụ sở chính đặt tại Mountain View. Groq, công ty chuyên về suy luận AI có độ trễ cực thấp, đã nâng cao hiệu suất tính toán AI một cách đáng kể. Groq là đơn vị tham gia nổi bật trong không gian công nghệ AI, đã đăng ký tên thương hiệu và tập hợp một nhóm toàn cầu cam kết dân chủ hóa quyền truy cập vào AI.

Đơn vị xử lý ngôn ngữ

Bộ xử lý ngôn ngữ (LPU) của Groq, một công nghệ tiên tiến, nhằm mục đích nâng cao hiệu suất tính toán AI, đặc biệt là cho các Mô hình ngôn ngữ lớn (LLM). Hệ thống Groq LPU nỗ lực mang lại trải nghiệm thời gian thực, độ trễ thấp với hiệu suất suy luận vượt trội. Groq đã đạt được hơn 300 token mỗi giây cho mỗi người dùng trên mô hình Llama-2 70B của Meta AI, thiết lập một chuẩn mực mới của ngành.

Hệ thống Groq LPU tự hào có khả năng có độ trễ cực thấp, rất quan trọng đối với các công nghệ hỗ trợ AI. Được thiết kế đặc biệt để xử lý ngôn ngữ GenAI chuyên sâu về tính toán và tuần tự, nó vượt trội hơn các giải pháp GPU thông thường, đảm bảo xử lý hiệu quả cho các tác vụ như tạo và hiểu ngôn ngữ tự nhiên.

GroqChip thế hệ đầu tiên của Groq, một phần của hệ thống LPU, có kiến trúc truyền phát tensor được tối ưu hóa về tốc độ, hiệu quả, độ chính xác và tiết kiệm chi phí. Con chip này vượt qua các giải pháp hiện có, lập kỷ lục mới về tốc độ LLM cơ bản được đo bằng mã thông báo mỗi giây cho mỗi người dùng. Với kế hoạch triển khai 1 triệu chip suy luận AI trong vòng hai năm, Groq thể hiện cam kết của mình trong việc thúc đẩy các công nghệ tăng tốc AI.

Tóm lại, hệ thống Đơn vị xử lý ngôn ngữ của Groq thể hiện sự tiến bộ đáng kể trong công nghệ điện toán AI, mang lại hiệu suất và hiệu quả vượt trội cho các Mô hình ngôn ngữ lớn đồng thời thúc đẩy sự đổi mới trong AI.

Cũng đọc: Xây dựng mô hình ML trong AWS SageMaker

Bắt đầu với Groq

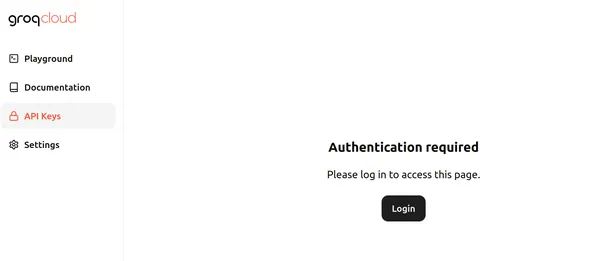

Hiện tại, Groq đang cung cấp các điểm cuối API sử dụng miễn phí cho các Mô hình ngôn ngữ lớn chạy trên Groq LPU – Đơn vị xử lý ngôn ngữ. Để bắt đầu, hãy truy cập vào đây trang và bấm vào đăng nhập. Trang này trông giống như bên dưới:

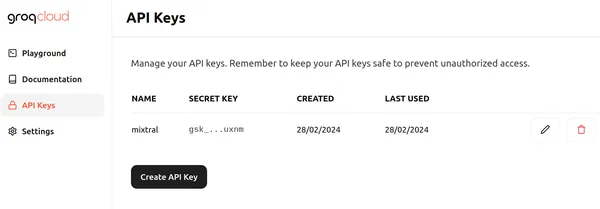

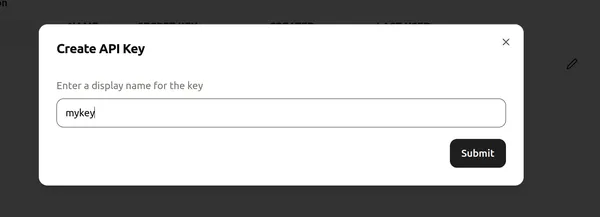

Nhấp vào Đăng nhập và chọn một trong các phương thức thích hợp để đăng nhập vào Groq. Sau đó, chúng ta có thể tạo API mới như API bên dưới bằng cách nhấp vào nút Tạo khóa API

Tiếp theo, gán tên cho khóa API và nhấp vào “gửi” để tạo Khóa API mới. Bây giờ, hãy chuyển đến bất kỳ trình soạn thảo mã/Colab nào và cài đặt các thư viện cần thiết để bắt đầu sử dụng Groq.

!pip install groqLệnh này cài đặt thư viện Groq, cho phép chúng ta suy ra các Mô hình ngôn ngữ lớn chạy trên Groq LPU.

Bây giờ, hãy tiếp tục với mã.

Triển khai mã

# Importing Necessary Libraries

import os

from groq import Groq

# Instantiation of Groq Client

client = Groq(

api_key=os.environ.get("GROQ_API_KEY"),

)Đoạn mã này thiết lập một đối tượng máy khách Groq để tương tác với API Groq. Quá trình này bắt đầu bằng cách truy xuất khóa API từ biến môi trường có tên GROQ_API_KEY và chuyển nó tới đối số api_key. Sau đó, khóa API khởi tạo đối tượng máy khách Groq, cho phép lệnh gọi API đến Mô hình ngôn ngữ lớn trong Máy chủ Groq.

Xác định LLM của chúng tôi

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What are Black Holes?",

}

],

model="mixtral-8x7b-32768",

)

print(llm.choices[0].message.content)- Dòng đầu tiên khởi tạo một đối tượng llm, cho phép tương tác với Mô hình ngôn ngữ lớn, tương tự như API hoàn thành trò chuyện OpenAI.

- Đoạn mã tiếp theo xây dựng một danh sách các tin nhắn sẽ được gửi đến LLM, được lưu trữ trong biến messages.

- Thông báo đầu tiên chỉ định vai trò là “hệ thống” và xác định hành vi mong muốn của LLM để giải thích các chủ đề giống như đối với một đứa trẻ 5 tuổi.

- Tin nhắn thứ hai chỉ định vai trò là “người dùng” và bao gồm câu hỏi về lỗ đen.

- Dòng sau chỉ định LLM sẽ được sử dụng để tạo phản hồi, được đặt thành “mixtral-8x7b-32768”, mô hình ngôn ngữ lớn Mixtral-32x8b-Instruct-v7 có ngữ cảnh 0.1k có thể truy cập được thông qua API Groq.

- Đầu ra của mã này sẽ là phản hồi từ LLM giải thích về các lỗ đen theo cách phù hợp với sự hiểu biết của trẻ 5 tuổi.

- Việc truy cập đầu ra tuân theo cách tiếp cận tương tự khi làm việc với điểm cuối OpenAI.

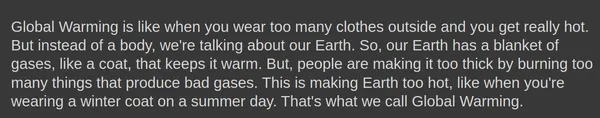

Đầu ra

Dưới đây hiển thị đầu ra được tạo bởi mô hình ngôn ngữ lớn Mixtral-8x7b-Instruct-v0.1:

Sản phẩm hoàn thành.create() đối tượng thậm chí có thể lấy các tham số bổ sung như nhiệt độ, đầu_pvà max_tokens.

Tạo phản hồi

Hãy thử tạo phản hồi với các tham số sau:

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What is Global Warming?",

}

],

model="mixtral-8x7b-32768",

temperature = 1,

top_p = 1,

max_tokens = 256,

)- nhiệt độ: Kiểm soát tính ngẫu nhiên của các phản hồi. Nhiệt độ thấp hơn dẫn đến kết quả đầu ra dễ dự đoán hơn, trong khi nhiệt độ cao hơn dẫn đến kết quả đầu ra đa dạng hơn và đôi khi sáng tạo hơn

- max_tokens: Số lượng mã thông báo tối đa mà mô hình có thể xử lý trong một phản hồi. Giới hạn này đảm bảo hiệu quả tính toán và quản lý tài nguyên

- đầu_p: Phương pháp tạo văn bản chọn mã thông báo tiếp theo từ phân phối xác suất của p mã thông báo có khả năng xảy ra cao nhất. Điều này cân bằng việc thăm dò và khai thác trong quá trình tạo

Đầu ra

Thậm chí còn có một tùy chọn để truyền phát các phản hồi được tạo từ Điểm cuối Groq. Chúng ta chỉ cần xác định luồng = Đúng tùy chọn trong hoàn thành.create() đối tượng để mô hình bắt đầu truyền phát phản hồi.

Groq ở Langchain

Groq thậm chí còn tương thích với LangChain. Để bắt đầu sử dụng Groq trong LangChain, hãy tải xuống thư viện:

!pip install langchain-groqỞ trên sẽ cài đặt thư viện Groq để tương thích với LangChain. Bây giờ hãy thử nó trong mã:

# Import the necessary libraries.

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

# Initialize a ChatGroq object with a temperature of 0 and the "mixtral-8x7b-32768" model.

llm = ChatGroq(temperature=0, model_name="mixtral-8x7b-32768")Đoạn mã trên thực hiện như sau:

- Tạo một đối tượng ChatGroq mới có tên llm

- Đặt nhiệt độ tham số thành 0, cho biết rằng các phản hồi sẽ dễ dự đoán hơn

- Đặt tên_người mẫu tham số thành “mixtral-8x7b-32768“, chỉ định mô hình ngôn ngữ sẽ sử dụng

# Xác định thông báo hệ thống giới thiệu khả năng của trợ lý AI.

# Define the system message introducing the AI assistant's capabilities.

system = "You are an expert Coding Assistant."

# Define a placeholder for the user's input.

human = "{text}"

# Create a chat prompt consisting of the system and human messages.

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# Invoke the chat chain with the user's input.

chain = prompt | llm

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# Print the Response.

print(response.content)- Mã tạo Lời nhắc trò chuyện bằng cách sử dụng lớp ChatPromptTemplate.

- Lời nhắc bao gồm hai thông báo: một từ “hệ thống” (trợ lý AI) và một từ “con người” (người dùng).

- Thông báo hệ thống giới thiệu trợ lý AI là Trợ lý mã hóa chuyên nghiệp.

- Thông điệp của con người đóng vai trò giữ chỗ cho thông tin đầu vào của người dùng.

- Phương thức llm gọi chuỗi llm để tạo ra phản hồi dựa trên Lời nhắc được cung cấp và thông tin đầu vào của người dùng.

Đầu ra

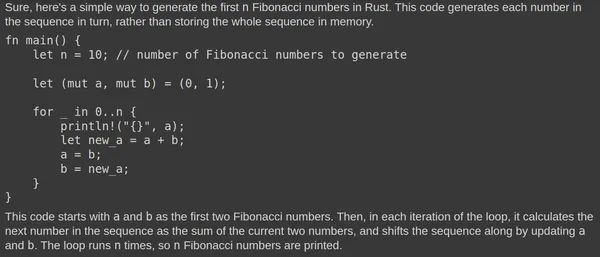

Đây là kết quả được tạo ra bởi Mô hình ngôn ngữ lớn Mixtral:

Mixtral LLM liên tục tạo ra các phản hồi có liên quan. Việc kiểm tra mã trong Rust Playground sẽ xác nhận chức năng của nó. Phản hồi nhanh được quy cho Đơn vị xử lý ngôn ngữ (LPU) cơ bản.

Groq so với các API suy luận khác

Hệ thống Đơn vị xử lý ngôn ngữ (LPU) của Groq nhằm mục đích mang lại tốc độ suy luận nhanh như chớp cho Mô hình ngôn ngữ lớn (LLM), vượt qua các API suy luận khác như API do OpenAI và Azure cung cấp. Được tối ưu hóa cho LLM, hệ thống LPU của Groq cung cấp khả năng có độ trễ cực thấp, rất quan trọng đối với các công nghệ hỗ trợ AI. Nó giải quyết các nút thắt chính của LLM, bao gồm mật độ tính toán và băng thông bộ nhớ, cho phép tạo chuỗi văn bản nhanh hơn.

So với các API suy luận khác, hệ thống LPU của Groq nhanh hơn với khả năng tạo ra hiệu suất suy luận nhanh hơn tới 18 lần trên Bảng xếp hạng LLMPerf của Anyscale so với các nhà cung cấp dựa trên đám mây hàng đầu khác. Hệ thống LPU của Groq cũng hiệu quả hơn, với kiến trúc lõi đơn và mạng đồng bộ được duy trì trong quá trình triển khai quy mô lớn, cho phép tự động biên dịch LLM và truy cập bộ nhớ tức thời.

Hình ảnh trên hiển thị điểm chuẩn cho các mẫu 70B. Tính toán thông lượng mã thông báo đầu ra liên quan đến việc tính trung bình số lượng mã thông báo đầu ra được trả về mỗi giây. Mỗi nhà cung cấp suy luận LLM xử lý 150 yêu cầu để thu thập kết quả và thông lượng mã thông báo đầu ra trung bình được tính toán bằng cách sử dụng các yêu cầu này. Hiệu suất của nhà cung cấp suy luận LLM được cải thiện được biểu thị bằng thông lượng mã thông báo đầu ra cao hơn. Rõ ràng là mã thông báo đầu ra mỗi giây của Groq vượt trội hơn nhiều nhà cung cấp đám mây được hiển thị.

Kết luận

Tóm lại, hệ thống Bộ xử lý ngôn ngữ (LPU) của Groq nổi bật như một công nghệ mang tính cách mạng trong lĩnh vực điện toán AI, mang lại tốc độ và hiệu quả chưa từng có để xử lý Mô hình ngôn ngữ lớn (LLM) và thúc đẩy đổi mới trong lĩnh vực AI. Bằng cách tận dụng khả năng có độ trễ cực thấp và kiến trúc được tối ưu hóa, Groq đang thiết lập các tiêu chuẩn mới về tốc độ suy luận, vượt trội so với các giải pháp GPU thông thường và các API suy luận hàng đầu trong ngành khác. Với cam kết dân chủ hóa khả năng tiếp cận AI và tập trung vào trải nghiệm thời gian thực, độ trễ thấp, Groq sẵn sàng định hình lại bối cảnh các công nghệ tăng tốc AI.

Chìa khóa chính

- Hệ thống Bộ xử lý ngôn ngữ (LPU) của Groq mang lại tốc độ và hiệu quả vượt trội cho hoạt động suy luận AI, đặc biệt là đối với Mô hình ngôn ngữ lớn (LLM), mang lại trải nghiệm theo thời gian thực, độ trễ thấp

- Hệ thống LPU của Groq, có GroqChip, tự hào có độ trễ cực thấp cần thiết cho các công nghệ hỗ trợ AI, vượt trội so với các giải pháp GPU thông thường

- Với kế hoạch triển khai 1 triệu chip suy luận AI trong vòng hai năm, Groq thể hiện sự cống hiến của mình trong việc thúc đẩy các công nghệ tăng tốc AI và dân chủ hóa quyền truy cập vào AI

- Groq cung cấp các điểm cuối API sử dụng miễn phí cho các Mô hình ngôn ngữ lớn chạy trên Groq LPU, giúp các nhà phát triển có thể truy cập để tích hợp vào các dự án của họ

- Khả năng tương thích của Groq với LangChain và LlamaIndex giúp mở rộng hơn nữa khả năng sử dụng của nó, mang đến sự tích hợp liền mạch cho các nhà phát triển đang tìm cách tận dụng công nghệ Groq trong các tác vụ xử lý ngôn ngữ của họ

Những câu hỏi thường gặp

A. Groq chuyên về suy luận AI có độ trễ cực thấp, đặc biệt dành cho Mô hình ngôn ngữ lớn (LLM), nhằm mục đích cách mạng hóa hiệu suất điện toán AI.

A. Hệ thống LPU của Groq, có GroqChip, được thiết kế riêng cho tính chất điện toán chuyên sâu của quá trình xử lý ngôn ngữ GenAI, mang lại tốc độ, hiệu quả và độ chính xác vượt trội so với các giải pháp GPU truyền thống.

A. Groq hỗ trợ nhiều mô hình suy luận AI, bao gồm Mixtral-8x7b-Instruct-v0.1 và Llama-70b.

Đáp: Có, Groq tương thích với LangChain và LlamaIndex, mở rộng khả năng sử dụng và cung cấp khả năng tích hợp liền mạch cho các nhà phát triển đang tìm cách tận dụng công nghệ Groq trong các tác vụ xử lý ngôn ngữ của họ.

A. Hệ thống LPU của Groq vượt qua các API suy luận khác về tốc độ và hiệu quả, mang lại tốc độ suy luận nhanh hơn tới 18 lần và hiệu suất vượt trội, được thể hiện qua các điểm chuẩn trên Bảng xếp hạng LLMPef của Anyscale.

Phương tiện hiển thị trong bài viết này không thuộc sở hữu của Analytics Vidhya và được sử dụng theo quyết định riêng của Tác giả.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.analyticsvidhya.com/blog/2024/03/getting-started-with-groq-api/