Müşteriler, dijital ayak izleri genişledikçe ve bu dijital varlıkların iş etkisi arttıkça altyapı ve uygulama kaynaklarında artan güvenlik tehditleri ve güvenlik açıklarıyla karşı karşıya kalıyor. Yaygın bir siber güvenlik sorunu iki yönlüdür:

- Farklı format ve şemalarda gelen dijital kaynaklardan günlüklerin alınması ve bu günlüklere dayalı olarak tehdit bulgularının analizinin otomatikleştirilmesi.

- Günlükler Amazon Web Services'ten (AWS), diğer bulut sağlayıcılardan, şirket içi veya uç cihazlardan geliyor olsun, müşterilerin güvenlik verilerini merkezileştirmesi ve standartlaştırması gerekir.

Ayrıca, güvenlik tehditlerini belirlemeye yönelik analizler, değişen tehdit aktörleri, güvenlik vektörleri ve dijital varlıklar ortamını karşılayacak şekilde ölçeklenebilmeli ve gelişebilmelidir.

Bu karmaşık güvenlik analitiği senaryosunu çözmeye yönelik yeni bir yaklaşım, güvenlik verilerinin alımını ve depolanmasını kullanarak birleştirir. Amazon Güvenlik Gölü ve güvenlik verilerinin makine öğrenimi (ML) ile analiz edilmesi Amazon Adaçayı Yapıcı. Amazon Security Lake, bir kuruluşun buluttan ve şirket içi kaynaklardan aldığı güvenlik verilerini, AWS hesabınızda depolanan amaca yönelik olarak oluşturulmuş bir veri gölünde otomatik olarak merkezileştiren, amaca yönelik oluşturulmuş bir hizmettir. Amazon Security Lake, güvenlik verilerinin merkezi yönetimini otomatikleştirir, entegre AWS hizmetlerinden ve üçüncü taraf hizmetlerden gelen günlükleri normalleştirir, özelleştirilebilir saklamayla verilerin yaşam döngüsünü yönetir ve ayrıca depolama katmanlamasını da otomatikleştirir. Amazon Security Lake, günlük dosyalarını alır Açık Siber Güvenlik Şema Çerçevesi (OCSF) biçiminde, Cisco Security, CrowdStrike, Palo Alto Networks gibi iş ortakları ve AWS ortamınız dışındaki kaynaklardan alınan OCSF günlükleri desteğiyle. Bu birleştirilmiş şema, verilerin standartlaştırılmış bir şemayı takip etmesi ve minimum veri hattı değişikliği ile yeni kaynakların eklenebilmesi nedeniyle aşağı akış tüketimini ve analitiği kolaylaştırır. Güvenlik günlüğü verileri Amazon Security Lake'te depolandıktan sonra, bunların nasıl analiz edileceği sorusu ortaya çıkıyor. Güvenlik günlüğü verilerini analiz etmenin etkili bir yaklaşımı ML'yi kullanmaktır; özellikle aktivite ve trafik verilerini inceleyen ve bunları bir temel çizgiyle karşılaştıran anormallik tespiti. Taban çizgisi, o ortam için hangi aktivitenin istatistiksel olarak normal olduğunu tanımlar. Anormallik tespiti, bireysel bir olay imzasının ötesine ölçeklenir ve periyodik yeniden eğitimle gelişebilir; Anormal veya anormal olarak sınıflandırılan trafiğe daha sonra önceliklendirilmiş bir odaklanma ve aciliyetle müdahale edilebilir. Amazon SageMaker, iş analistlerine yönelik kodsuz teklifler de dahil olmak üzere, tam olarak yönetilen altyapı, araçlar ve iş akışlarıyla müşterilerin veri hazırlamasına ve her türlü kullanım durumu için makine öğrenimi modelleri oluşturmasına, eğitmesine ve dağıtmasına olanak tanıyan tam olarak yönetilen bir hizmettir. SageMaker iki yerleşik anormallik algılama algoritmasını destekler: IP Analizleri ve Rastgele Kesim Ormanı. Ayrıca SageMaker'ı kullanarak kendi özel aykırı değer tespit modelinizi oluşturmak için de kullanabilirsiniz. algoritmalar birden fazla makine öğrenimi çerçevesinden alınmıştır.

Bu yazıda Amazon Security Lake'ten alınan verileri nasıl hazırlayacağınızı ve ardından SageMaker'da bir IP Insights algoritması kullanarak bir makine öğrenimi modelini nasıl eğitip dağıtacağınızı öğreneceksiniz. Bu model, anormal ağ trafiğini veya davranışını tanımlar ve daha sonra daha büyük bir uçtan uca güvenlik çözümünün parçası olarak oluşturulabilir. Böyle bir çözüm, bir kullanıcının alışılmadık bir sunucudan veya alışılmadık bir zamanda oturum açması durumunda çok faktörlü kimlik doğrulama (MFA) kontrolünü başlatabilir, yeni IP adreslerinden gelen şüpheli bir ağ taraması varsa personeli bilgilendirebilir, olağandışı bir ağ varsa yöneticileri uyarabilir. protokoller veya bağlantı noktaları kullanılır veya IP öngörüleri sınıflandırma sonucunu aşağıdakiler gibi diğer veri kaynaklarıyla zenginleştirir: Amazon Muhafız Görevi ve tehdit bulgularını sıralamak için IP itibar puanları.

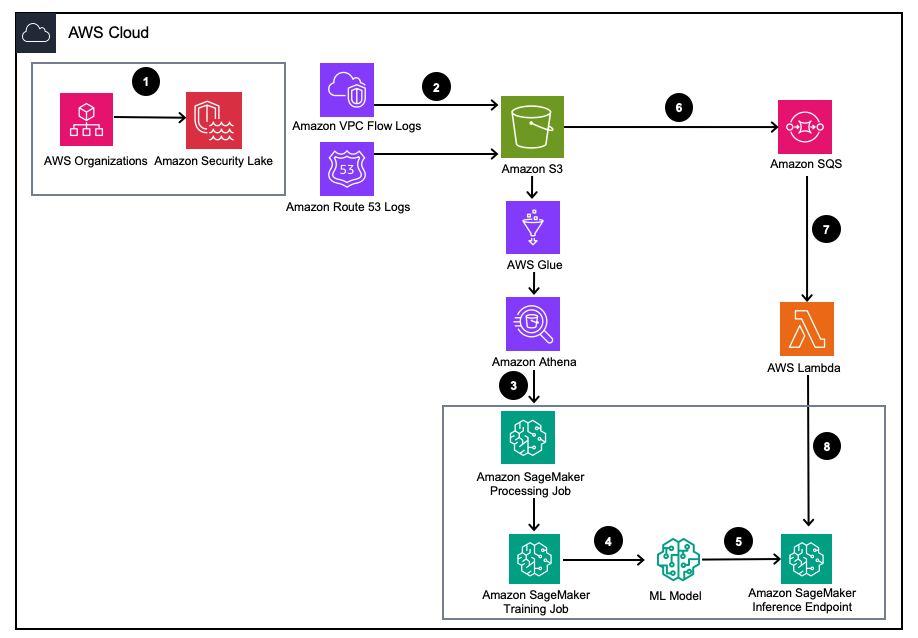

Çözüme genel bakış

Şekil 1 – Çözüm Mimarisi

- Amazon Security Lake'i şununla etkinleştirin: AWS Kuruluşları AWS hesapları, AWS Bölgeleri ve harici BT ortamları için.

- Security Lake kaynaklarını şuradan ayarlayın: Amazon Sanal Özel Bulut (Amazon VPC) Akış Günlükleri ve Amazon Rotası53 DNS, Amazon Security Lake S3 klasörüne günlük kaydeder.

- Özellikleri tasarlamak için SageMaker İşleme işini kullanarak Amazon Security Lake günlük verilerini işleyin. Kullanmak Amazon Atina yapılandırılmış OCSF günlük verilerini sorgulamak için Amazon Basit Depolama Hizmeti (Amazon S3) içinden AWS Tutkal AWS LakeFormation tarafından yönetilen tablolar.

- İşlenen Amazon Security Lake günlüklerini kullanan bir SageMaker Training işini kullanarak bir SageMaker ML modelini eğitin.

- Eğitilen ML modelini bir SageMaker çıkarım uç noktasına dağıtın.

- Yeni güvenlik günlüklerini bir S3 klasöründe saklayın ve olayları Amazon Basit Kuyruk Hizmeti (Amazon SQS).

- Abone ol AWS Lambda SQS kuyruğuna işlev.

- Güvenlik günlüklerini gerçek zamanlı olarak anormallikler olarak sınıflandırmak için Lambda işlevini kullanarak SageMaker çıkarım uç noktasını çağırın.

Önkoşullar

Çözümü dağıtmak için öncelikle aşağıdaki önkoşulları tamamlamanız gerekir:

- Amazon Security Lake'i etkinleştirin kuruluşunuz içinde veya hem VPC Akış Günlükleri hem de Route 53 çözümleyici günlüklerinin etkin olduğu tek bir hesapta.

- Emin olun AWS Kimlik ve Erişim Yönetimi (IAM) SageMaker'ın işleri ve not defterlerini işlemesi tarafından kullanılan role, aşağıdakileri içeren bir IAM politikası verilmiştir: Amazon Security Lake abone sorgusu erişim izni yönetilen Amazon Security lake veritabanı ve AWS Lake Formation tarafından yönetilen tablolar için. Bu işleme işinin, uyumluluğun devam etmesi için bir analiz veya güvenlik araçları hesabından çalıştırılması gerekir. AWS Güvenlik Referans Mimarisi (AWS SRA).

- Lambda işlevi tarafından kullanılan IAM rolüne aşağıdakileri içeren bir IAM politikası verildiğinden emin olun: Amazon Security Lake abone verilerine erişim izni.

Çözümü dağıtın

Ortamı kurmak için aşağıdaki adımları tamamlayın:

- Başlatmak Adaçayı Yapıcı Stüdyo veya SageMaker Jupyter dizüstü bilgisayar ile

ml.m5.largeörneği. Not: Örnek boyutu, kullandığınız veri kümelerine bağlıdır. - GitHub'ı klonlayın Depo.

- Not defterini aç

01_ipinsights/01-01.amazon-securitylake-sagemaker-ipinsights.ipy. - Uygulayın sağlanan IAM politikası ve karşılık gelen IAM güven politikası SageMaker Studio Notebook örneğinizin S3, Lake Formation ve Athena'daki tüm gerekli verilere erişmesi için.

Bu blog, ortamınıza dağıtıldıktan sonra not defterindeki kodun ilgili kısmını açıklamaktadır.

Bağımlılıkları yükleyin ve gerekli kitaplığı içe aktarın

Bağımlılıkları yüklemek, gerekli kitaplıkları içe aktarmak ve veri işleme ve model eğitimi için gereken SageMaker S3 klasörünü oluşturmak için aşağıdaki kodu kullanın. Gerekli kütüphanelerden biri, awswrangler, bir Pandaların veri çerçevesi için AWS SDK AWS Glue Data Catalog'daki ilgili tabloları sorgulamak ve sonuçları yerel olarak bir veri çerçevesinde depolamak için kullanılır.

Amazon Security Lake VPC akış günlüğü tablosunu sorgulama

Kodun bu bölümü, VPC Akış Günlükleriyle ilgili AWS Glue tablosunu sorgulamak için pandalara yönelik AWS SDK'yı kullanır. Önkoşullarda belirtildiği gibi Amazon Security Lake tabloları şu şekilde yönetilir: AWS Göl Oluşumu, dolayısıyla SageMaker not defteri tarafından kullanılan role tüm uygun izinlerin verilmesi gerekir. Bu sorgu birden fazla günlük VPC akış günlüğü trafiğini çekecek. Bu blogun geliştirilmesi sırasında kullanılan veri seti küçüktü. Kullanım senaryonuzun ölçeğine bağlı olarak AWS SDK'nın pandalara yönelik sınırlarının farkında olmalısınız. Terabayt ölçeğini değerlendirirken pandalar için AWS SDK desteğini göz önünde bulundurmalısınız. modin.

Veri çerçevesini görüntülediğinizde, ortak alanlarda bulunabilecek tek bir sütunun çıktısını göreceksiniz. Ağ Etkinliği (4001) OCSF'nin sınıfı.

Amazon Security Lake VPC akış günlüğü verilerini IP Insights için gerekli eğitim formatına göre normalleştirin.

IP Insights algoritması, eğitim verilerinin CSV formatında olmasını ve iki sütun içermesini gerektirir. İlk sütun, bir varlığın benzersiz tanımlayıcısına karşılık gelen opak bir dize olmalıdır. İkinci sütun, varlığın erişim olayının ondalık nokta gösterimindeki IPv4 adresi olmalıdır. Bu blogun örnek veri kümesindeki benzersiz tanımlayıcı, ilgili EC2 bulut sunucularının Örnek Kimlikleridir. instance_id içindeki değer dataframe. IPv4 adresi şu adresten türetilecektir: src_endpoint. Amazon Athena sorgusunun oluşturulma şekline bağlı olarak içe aktarılan veriler, bir IP Insights modelinin eğitimi için zaten doğru formatta olduğundan ek özellik mühendisliği gerekmez. Sorguyu başka bir şekilde değiştirirseniz ek özellik mühendisliğini dahil etmeniz gerekebilir.

Amazon Security Lake Route 53 çözümleyici günlük tablosunu sorgulama ve normalleştirme

Yukarıda yaptığınız gibi, not defterinin bir sonraki adımında Amazon Security Lake Route 53 çözümleyici tablosunda benzer bir sorgu çalıştırılır. Bu not defterindeki tüm OCSF uyumlu verileri kullanacağınız için, tüm özellik mühendisliği görevleri, VPC Akış Günlükleri için olduğu gibi Route 53 çözümleyici günlükleri için de aynı kalacaktır. Daha sonra iki veri çerçevesini eğitim için kullanılan tek bir veri çerçevesinde birleştirirsiniz. Amazon Athena sorgusu verileri yerel olarak doğru biçimde yüklediğinden başka özellik mühendisliğine gerek yoktur.

IP Insights eğitim görüntüsünü alın ve modeli OCSF verileriyle eğitin

Not defterinin bu sonraki bölümünde, IP Insights algoritmasını temel alan bir makine öğrenimi modeli eğitecek ve birleştirilmiş modeli kullanacaksınız. dataframe OCSF'nin farklı türdeki günlüklerden elde edilmesi. IP Insights hiperparmetrelerinin bir listesi bulunabilir okuyun. Aşağıdaki örnekte, en iyi performansı gösteren modeli ortaya çıkaran hiperparametreleri seçtik; örneğin, epoch için 5 ve vektör_dim için 128. Örneğimizin eğitim veri seti nispeten küçük olduğundan, ml.m5.large misal. Hiperparametreler ve örnek sayısı ile örnek türü gibi eğitim yapılandırmalarınız, hedef ölçümlerinize ve eğitim veri boyutunuza göre seçilmelidir. Modelinizin en iyi sürümünü bulmak için Amazon SageMaker'da kullanabileceğiniz yeteneklerden biri de Amazon SageMaker'dır. otomatik model ayarlama Bu, bir dizi hiperparametre değeri boyunca en iyi modeli arar.

Eğitilen modeli dağıtın ve geçerli ve anormal trafikle test edin

Model eğitildikten sonra modeli bir SageMaker uç noktasına dağıtırsınız ve modelinizi test etmek için bir dizi benzersiz tanımlayıcı ve IPv4 adresi birleşimi gönderirsiniz. Kodun bu kısmı, S3 klasörünüzde kayıtlı test verilerinin bulunduğunu varsayar. Test verileri, ilk sütunun örnek kimlikleri ve ikinci sütunun IP'ler olduğu bir .csv dosyasıdır. Modelin sonuçlarını görmek için geçerli ve geçersiz verilerin test edilmesi önerilir. Aşağıdaki kod uç noktanızı dağıtır.

Uç noktanız artık konuşlandırıldığına göre trafiğin potansiyel olarak anormal olup olmadığını belirlemek için çıkarım istekleri gönderebilirsiniz. Aşağıda biçimlendirilmiş verilerinizin nasıl görünmesi gerektiğine dair bir örnek verilmiştir. Bu durumda, ilk sütun tanımlayıcısı bir örnek kimliğidir ve ikinci sütun, aşağıda gösterildiği gibi ilişkili bir IP adresidir:

Verilerinizi CSV formatında aldıktan sonra, .csv dosyanızı bir S3 paketinden okuyarak kodu kullanarak verileri çıkarım için gönderebilirsiniz.:

IP Insights modelinin çıktısı, bir IP adresinin ve çevrimiçi kaynağın istatistiksel olarak ne kadar beklendiğine ilişkin bir ölçüm sağlar. Ancak bu adresin ve kaynağın aralığı sınırsız olduğundan, örnek kimliği ve IP adresi kombinasyonunun anormal olarak değerlendirilip değerlendirilmeyeceğine nasıl karar vereceğiniz konusunda dikkate alınması gereken noktalar vardır.

Önceki örnekte modele dört farklı tanımlayıcı ve IP kombinasyonu gönderilmiştir. İlk iki kombinasyon, eğitim setine göre beklenen geçerli örnek kimliği ve IP adresi kombinasyonlarıydı. Üçüncü kombinasyon, doğru benzersiz tanımlayıcıya sahiptir ancak aynı alt ağ içinde farklı bir IP adresine sahiptir. Yerleştirme, eğitim verilerinden biraz farklı olduğundan model, orta düzeyde bir anormallik olduğunu belirlemelidir. Dördüncü kombinasyon geçerli bir benzersiz tanımlayıcıya sahiptir ancak ortamdaki herhangi bir VPC'de var olmayan bir alt ağın IP adresine sahiptir.

Not: Normal ve anormal trafik verileri, özel kullanım durumunuza göre değişecektir; örneğin: harici ve dahili trafiği izlemek istiyorsanız, her IP adresine hizalanmış benzersiz bir tanımlayıcıya ve harici tanımlayıcıları oluşturmak için bir şemaya ihtiyacınız olacaktır.

Trafiğin anormal olup olmadığını belirlemek için eşiğinizin ne olması gerektiğini belirlemek, bilinen normal ve anormal trafik kullanılarak yapılabilir. Özetlenen adımlar bu örnek not defteri aşağıdaki gibidir:

- Normal trafiği temsil edecek bir test seti oluşturun.

- Veri kümesine anormal trafik ekleyin.

- Dağıtım grafiğini çizin

dot_productnormal trafik ve anormal trafikteki model için puanlar. - Normal alt kümeyi anormal alt kümeden ayıran bir eşik değeri seçin. Bu değer yanlış pozitif toleransınıza dayanmaktadır

Yeni VPC akış günlüğü trafiğinin sürekli izlenmesini ayarlayın.

Bu yeni makine öğrenimi modelinin Amazon Security Lake ile proaktif bir şekilde nasıl kullanılabileceğini göstermek için her birinde çağrılacak bir Lambda işlevi yapılandıracağız. PutObject Amazon Security Lake tarafından yönetilen paketteki olay, özellikle VPC akış günlüğü verileri. Amazon Security Lake'te, Amazon Security Lake'teki günlükleri ve olayları tüketen bir abone kavramı vardır. Yeni olaylara yanıt veren Lambda işlevine veri erişim aboneliği verilmelidir. Veri erişimi aboneleri, bir kaynak için yeni Amazon S3 nesneleri hakkında, nesneler Security Lake grubuna yazıldıkça bilgilendirilir. Aboneler, bir abonelik uç noktası aracılığıyla veya bir Amazon SQS kuyruğunu yoklayarak S3 nesnelerine doğrudan erişebilir ve yeni nesnelere ilişkin bildirimler alabilir.

- Açın Güvenlik Gölü konsolu.

- Gezinti bölmesinde şunu seçin: Aboneler.

- Aboneler sayfasında, Abone oluştur.

- Abone ayrıntıları için şunu girin:

inferencelambdaiçin Abone adı ve isteğe bağlı Açıklama. - The Bölge otomatik olarak seçili AWS Bölgeniz olarak ayarlanır ve değiştirilemez.

- İçin Günlük ve olay kaynakları, seçmek Belirli günlük ve olay kaynakları Ve seç VPC Akış Günlükleri ve Rota 53 günlükleri

- İçin Veri erişim yöntemi, seçmek S3.

- İçin Abone kimlik bilgileri, Lambda işlevinin bulunacağı hesabın AWS hesap kimliğini ve kullanıcı tarafından belirtilen bir kimlik bilgisini sağlayın harici kimlik.

Not: Bunu yerel olarak bir hesapta yapıyorsanız harici bir kimliğe sahip olmanıza gerek yoktur. - Klinik oluşturmak.

Lambda işlevini oluşturun

Lambda işlevini oluşturmak ve dağıtmak için aşağıdaki adımları tamamlayabilir veya önceden oluşturulmuş SAM şablonunu dağıtabilirsiniz. 01_ipinsights/01.02-ipcheck.yaml GitHub deposunda. SAM şablonu, SQS ARN'yi ve SageMaker uç noktası adını sağlamanızı gerektirir.

- Lambda konsolunda şunu seçin: İşlev oluştur.

- Klinik Sıfırdan yazar.

- İçin Fonksiyon adı, girmek

ipcheck. - İçin Süre, seçmek Python 3.10.

- İçin mimariseçin x86_64.

- İçin Yürütme rolüseçin Lambda izinleriyle yeni bir rol oluşturun.

- Fonksiyonu oluşturduktan sonra içeriğini girin. ipcheck.py GitHub deposundaki dosya.

- Gezinti bölmesinde şunu seçin: Ortam Değişkenleri.

- Klinik Düzenle.

- Klinik Ortam değişkeni ekle.

- Yeni ortam değişkeni için şunu girin:

ENDPOINT_NAMEve değer için SageMaker uç noktasının konuşlandırılması sırasında çıkarılan uç nokta ARN'sini girin. - seç İndirim.

- Klinik Sürüş.

- Gezinti bölmesinde şunu seçin: yapılandırma.

- seç tetikleyiciler.

- seç Tetikleyici ekle.

- Altında Bir kaynak seçin, seçmek SQS.

- Altında SQS kuyruğuSecurity Lake tarafından oluşturulan ana SQS kuyruğunun ARN'sini girin.

- için onay kutusunu seçin. Tetiği etkinleştir.

- seç Ekle.

Lambda bulgularını doğrulayın

- Açın Amazon CloudWatch konsolu.

- Sol taraftaki bölmede, Günlük grupları.

- Arama çubuğuna ipcheck yazın ve ardından adı taşıyan günlük grubunu seçin.

/aws/lambda/ipcheck. - Altında en yeni günlük akışını seçin Günlük akışları.

- Günlüklerde, her yeni Amazon Security Lake günlüğü için aşağıdaki gibi görünen sonuçları görmelisiniz:

{'predictions': [{'dot_product': 0.018832731992006302}, {'dot_product': 0.018832731992006302}]}

Bu Lambda işlevi, Amazon Security Lake tarafından alınan ağ trafiğini sürekli olarak analiz eder. Bu, ortamınızda anormal bir trafik olduğunu gösteren belirli bir eşik ihlal edildiğinde güvenlik ekiplerinize bildirimde bulunacak mekanizmalar oluşturmanıza olanak tanır.

Temizlemek

Bu çözümle denemelerinizi tamamladığınızda ve hesabınızın ücretlendirilmesini önlemek için, S3 klasörünü ve SageMaker uç noktasını silerek, SageMaker Jupyter dizüstü bilgisayara bağlı bilgi işlemi kapatarak, Lambda işlevini silerek ve Amazon Güvenliğini devre dışı bırakarak kaynaklarınızı temizleyin. Hesabınızdaki göl.

Sonuç

Bu gönderide Amazon Security Lake'ten alınan ağ trafiği verilerini makine öğrenimi için nasıl hazırlayacağınızı ve ardından Amazon SageMaker'da IP Insights algoritmasını kullanarak bir makine öğrenimi modeli eğitip dağıtmayı öğrendiniz. Jupyter not defterinde özetlenen adımların tümü, uçtan uca bir makine öğrenimi hattında çoğaltılabilir. Ayrıca yeni Amazon Security Lake günlüklerini tüketen ve eğitimli anormallik algılama modeline dayalı olarak çıkarımlar gönderen bir AWS Lambda işlevini de uyguladınız. AWS Lambda tarafından alınan ML modeli yanıtları, belirli eşiklere ulaşıldığında güvenlik ekiplerine anormal trafik konusunda proaktif olarak bildirimde bulunabilir. Anormal olarak tanımlanan trafiğin yanlış pozitif olup olmadığını etiketlemek için güvenlik ekibinizi döngü incelemelerine dahil ederek modelin sürekli iyileştirilmesi sağlanabilir. Bu daha sonra eğitim setinize eklenebilir ve ayrıca normal ampirik bir eşik belirlerken trafik veri kümesi. Bu model, potansiyel olarak anormal ağ trafiğini veya davranışını tanımlayabilir; bu sayede, bir kullanıcının alışılmadık bir sunucudan veya alışılmadık bir zamanda oturum açması durumunda bir MFA denetimi başlatmak ve şüpheli bir durum olması durumunda personeli uyarmak için daha büyük bir güvenlik çözümünün parçası olarak dahil edilebilir. Yeni IP adreslerinden gelen ağ taraması yapın veya tehdit bulgularını sıralamak için IP içgörü puanını Amazon Guard Duty gibi diğer kaynaklarla birleştirin. Bu model, Amazon Security Lake dağıtımınıza özel kaynaklar ekleyerek Azure Flow Logs gibi özel günlük kaynaklarını veya şirket içi günlükleri içerebilir.

Bu blog yazısı serisinin 2. bölümünde, bir anormallik tespit modelinin nasıl oluşturulacağını öğreneceksiniz. Rastgele Kesim Ormanı Ağ ve ana makine güvenlik günlüğü verilerini entegre eden ve otomatik, kapsamlı bir güvenlik izleme çözümünün parçası olarak güvenlik anormalliği sınıflandırmasını uygulayan ek Amazon Security Lake kaynaklarıyla eğitilmiş algoritma.

yazarlar hakkında

Joe Morotti Amazon Web Services'de (AWS) bir Çözüm Mimarıdır ve Ortabatı ABD'deki Kurumsal müşterilere yardımcı olur. Çok çeşitli teknik roller üstlendi ve müşterinin sanatını mümkün kılmaktan keyif aldı. Boş zamanlarında ailesiyle kaliteli zaman geçirmekten ve yeni yerler keşfetmekten ve spor takımının performansını gözden geçirmekten hoşlanıyor.

Joe Morotti Amazon Web Services'de (AWS) bir Çözüm Mimarıdır ve Ortabatı ABD'deki Kurumsal müşterilere yardımcı olur. Çok çeşitli teknik roller üstlendi ve müşterinin sanatını mümkün kılmaktan keyif aldı. Boş zamanlarında ailesiyle kaliteli zaman geçirmekten ve yeni yerler keşfetmekten ve spor takımının performansını gözden geçirmekten hoşlanıyor.

Bişr Tabbaa Amazon Web Services'ta bir çözüm mimarıdır. Bishr, makine öğrenimi, güvenlik ve gözlemlenebilirlik uygulamalarında müşterilere yardımcı olma konusunda uzmanlaşmıştır. İş dışında tenis oynamaktan, yemek yapmaktan ve ailesiyle vakit geçirmekten hoşlanır.

Bişr Tabbaa Amazon Web Services'ta bir çözüm mimarıdır. Bishr, makine öğrenimi, güvenlik ve gözlemlenebilirlik uygulamalarında müşterilere yardımcı olma konusunda uzmanlaşmıştır. İş dışında tenis oynamaktan, yemek yapmaktan ve ailesiyle vakit geçirmekten hoşlanır.

Sriharsh Adari Amazon Web Services'de (AWS) Kıdemli Çözüm Mimarıdır ve müşterilerin AWS'de yenilikçi çözümler geliştirmek için iş sonuçlarından geriye doğru çalışmasına yardımcı olur. Yıllar boyunca, endüstri sektörlerinde veri platformu dönüşümlerinde birden fazla müşteriye yardımcı oldu. Temel uzmanlık alanları arasında Teknoloji Stratejisi, Veri Analitiği ve Veri Bilimi bulunmaktadır. Boş zamanlarında Tenis oynamayı, TV şovlarını izlemeyi ve Tabla oynamayı seviyor.

Sriharsh Adari Amazon Web Services'de (AWS) Kıdemli Çözüm Mimarıdır ve müşterilerin AWS'de yenilikçi çözümler geliştirmek için iş sonuçlarından geriye doğru çalışmasına yardımcı olur. Yıllar boyunca, endüstri sektörlerinde veri platformu dönüşümlerinde birden fazla müşteriye yardımcı oldu. Temel uzmanlık alanları arasında Teknoloji Stratejisi, Veri Analitiği ve Veri Bilimi bulunmaktadır. Boş zamanlarında Tenis oynamayı, TV şovlarını izlemeyi ve Tabla oynamayı seviyor.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/identify-cybersecurity-anomalies-in-your-amazon-security-lake-data-using-amazon-sagemaker/