Bugün, ister finansal hizmetler, sağlık ve yaşam bilimleri, seyahat ve konaklama, medya ve eğlence, telekomünikasyon, hizmet olarak yazılım (SaaS) ve hatta özel model sağlayıcılar olsun, tüm sektörlerden müşteriler, büyük dil modellerini (LLM'ler) kullanıyor. Soru-cevap (QnA) sohbet robotları, arama motorları ve bilgi tabanları gibi uygulamalar oluşturun. Bunlar üretken yapay zeka uygulamalar yalnızca mevcut iş süreçlerini otomatikleştirmek için kullanılmıyor, aynı zamanda bu uygulamaları kullanan müşterilerin deneyimini dönüştürme özelliğine de sahip. LLM'lerde kaydedilen ilerlemelerle birlikte, Mixtral-8x7B Talimatıgibi mimarilerin türevi uzman karışımı (MEB)Müşteriler sürekli olarak üretken yapay zeka uygulamalarının performansını ve doğruluğunu iyileştirmenin ve aynı zamanda daha geniş bir kapalı ve açık kaynak model yelpazesini etkili bir şekilde kullanmalarına olanak sağlamanın yollarını arıyor.

Bir Yüksek Lisans çıktısının doğruluğunu ve performansını artırmak için tipik olarak bir takım teknikler kullanılır; örneğin, parametre verimli ince ayar (PEFT), insan geri bildiriminden (RLHF) pekiştirmeli öğrenme, ve performans bilgi damıtma. Ancak üretken yapay zeka uygulamaları oluştururken, harici bilginin dinamik olarak dahil edilmesine olanak tanıyan ve mevcut temel modelinizde ince ayar yapmanıza gerek kalmadan üretim için kullanılan bilgileri kontrol etmenize olanak tanıyan alternatif bir çözüm kullanabilirsiniz. Tartıştığımız daha pahalı ve sağlam ince ayar alternatiflerinin aksine, özellikle üretken yapay zeka uygulamaları için, Alma Artırılmış Üretimin (RAG) devreye girdiği yer burasıdır. Günlük görevlerinize karmaşık RAG uygulamaları uyguluyorsanız, RAG sistemlerinizde hatalı alma, belgelerin artan boyutu ve karmaşıklığı ve bağlam taşması gibi genel sorunlarla karşılaşabilirsiniz; bunlar, oluşturulan yanıtların kalitesini ve güvenilirliğini önemli ölçüde etkileyebilir. .

Bu gönderide, geliştiricilerin mevcut üretken yapay zeka uygulamalarını geliştirmelerine olanak sağlamak amacıyla bağlamsal sıkıştırma gibi tekniklerin yanı sıra LangChain ve ana belge alıcı gibi araçları kullanarak yanıt doğruluğunu artırmaya yönelik RAG modelleri tartışılmaktadır.

Çözüme genel bakış

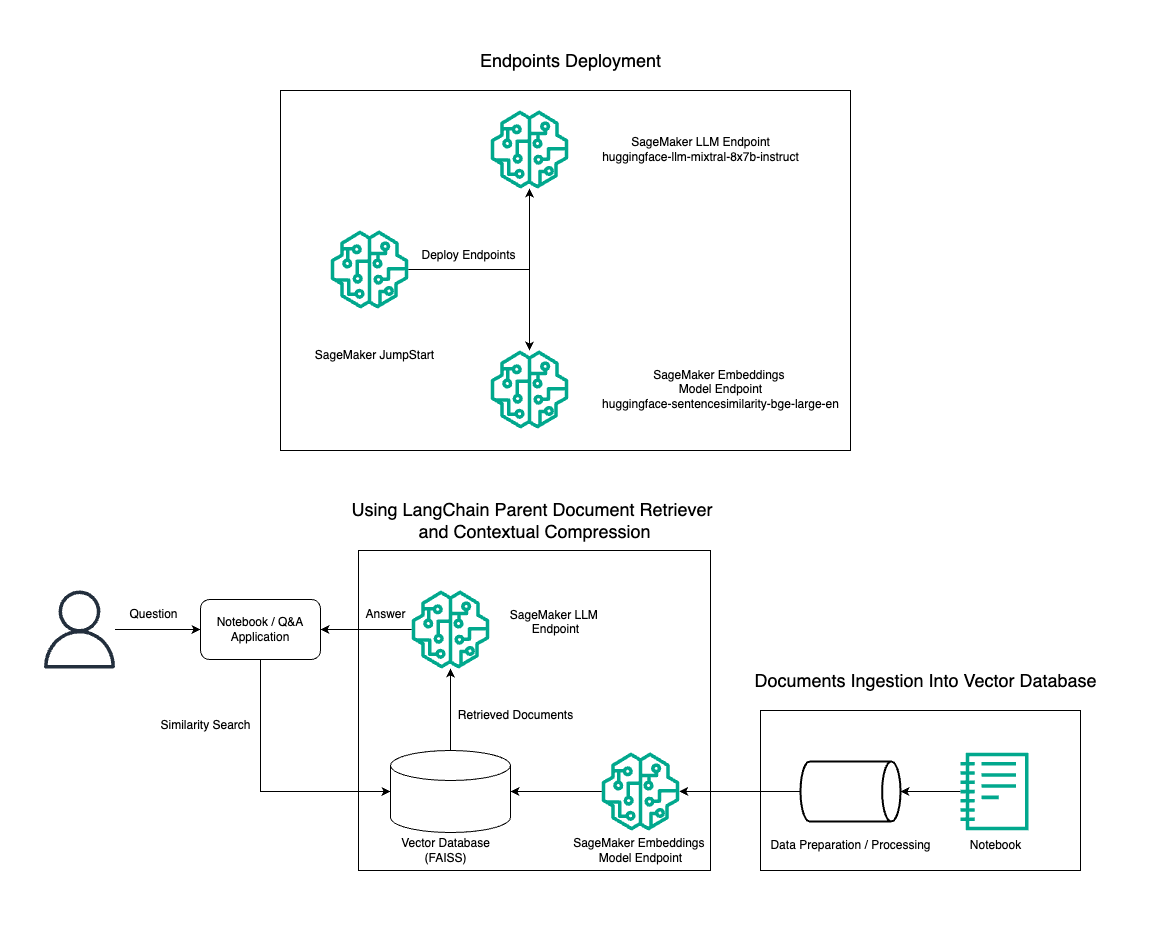

Bu yazıda, ana belge alma aracını ve bağlamsal sıkıştırma tekniğini kullanarak bir Amazon SageMaker dizüstü bilgisayarda verimli bir RAG QnA sistemi oluşturmak için Mixtral-8x7B Instruct metin oluşturmanın BGE Large En yerleştirme modeliyle birlikte kullanımını gösteriyoruz. Aşağıdaki diyagram bu çözümün mimarisini göstermektedir.

Bu çözümü kullanarak yalnızca birkaç tıklamayla dağıtabilirsiniz. Amazon SageMaker Hızlı Başlangıçiçerik yazma, kod oluşturma, soru yanıtlama, metin yazarlığı, özetleme, sınıflandırma ve bilgi alma gibi çeşitli kullanım durumları için en son teknolojiye sahip temel modeller sunan, tam olarak yönetilen bir platform. Hızlı ve kolay bir şekilde dağıtabileceğiniz önceden eğitilmiş modellerden oluşan bir koleksiyon sağlayarak makine öğrenimi (ML) uygulamalarının geliştirilmesini ve dağıtılmasını hızlandırır. SageMaker JumpStart'ın temel bileşenlerinden biri, çeşitli görevler için Mixtral-8x7B gibi önceden eğitilmiş modellerden oluşan geniş bir katalog sunan Model Hub'dır.

Mixtral-8x7B bir MoE mimarisi kullanır. Bu mimari, bir sinir ağının farklı bölümlerinin farklı görevlerde uzmanlaşmasına olanak tanıyarak iş yükünü birden fazla uzman arasında etkili bir şekilde bölüştürür. Bu yaklaşım, geleneksel mimarilere kıyasla daha büyük modellerin verimli bir şekilde eğitilmesine ve konuşlandırılmasına olanak tanır.

MoE mimarisinin temel avantajlarından biri ölçeklenebilirliğidir. İş yükünü birden fazla uzmana dağıtarak MoE modelleri daha büyük veri kümeleri üzerinde eğitilebilir ve aynı boyuttaki geleneksel modellere göre daha iyi performans elde edilebilir. Ek olarak, MoE modelleri çıkarım sırasında daha verimli olabilir çünkü belirli bir girdi için yalnızca bir uzman alt kümesinin etkinleştirilmesi gerekir.

AWS'de Mixtral-8x7B Talimatı hakkında daha fazla bilgi için bkz. Mixtral-8x7B artık Amazon SageMaker JumpStart'ta mevcut. Mixtral-8x7B modeli, izin verilen Apache 2.0 lisansı kapsamında kısıtlama olmaksızın kullanıma sunulmuştur.

Bu yazıda, nasıl kullanabileceğinizi tartışıyoruz. Dil Zinciri etkili ve daha verimli RAG uygulamaları oluşturmak. LangChain, Yüksek Lisans'larla uygulamalar oluşturmak için tasarlanmış açık kaynaklı bir Python kütüphanesidir. Güçlü ve özelleştirilebilir uygulamalar oluşturmak için LLM'leri bilgi tabanları, erişim sistemleri ve diğer yapay zeka araçları gibi diğer bileşenlerle birleştirmek için modüler ve esnek bir çerçeve sağlar.

Mixtral-8x7B ile SageMaker'da bir RAG boru hattı inşa etme adımlarını takip ediyoruz. Bir SageMaker dizüstü bilgisayarda RAG kullanarak verimli bir Soru-Cevap sistemi oluşturmak için Mixtral-8x7B Instruct metin oluşturma modelini BGE Large En yerleştirme modeliyle birlikte kullanıyoruz. LLM'lerin SageMaker tarafından oluşturulan bir API uç noktası aracılığıyla erişilebilen SageMaker JumpStart aracılığıyla dağıtılmasını göstermek için bir ml.t3.medium örneği kullanıyoruz. Bu kurulum, gelişmiş RAG tekniklerinin LangChain ile araştırılmasına, denenmesine ve optimizasyonuna olanak tanır. Ayrıca FAISS Gömme deposunun RAG iş akışına entegrasyonunu da gösteriyoruz ve sistemin performansını artırmak için yerleştirmelerin saklanması ve alınmasındaki rolünü vurguluyoruz.

SageMaker not defterinin kısa bir özetini gerçekleştiriyoruz. Daha ayrıntılı ve adım adım talimatlar için bkz. SageMaker Hızlı Başlangıç GitHub deposunda Mixtral ile Gelişmiş RAG Desenleri.

Gelişmiş RAG kalıplarına duyulan ihtiyaç

Gelişmiş RAG kalıpları, LLM'lerin insan benzeri metinleri işleme, anlama ve üretme konusundaki mevcut yeteneklerini geliştirmek için gereklidir. Belgelerin boyutu ve karmaşıklığı arttıkça, belgenin birden çok yönünün tek bir yerleştirmede temsil edilmesi, özgünlük kaybına neden olabilir. Bir belgenin genel özünü yakalamak önemli olsa da, içindeki çeşitli alt bağlamları tanımak ve temsil etmek de aynı derecede önemlidir. Bu, daha büyük belgelerle çalışırken sıklıkla karşılaştığınız bir zorluktur. RAG ile ilgili bir başka zorluk da, alma sırasında belge depolama sisteminizin alımın ardından ele alacağı belirli sorguların farkında olmamanızdır. Bu, bir sorguyla en alakalı bilgilerin metnin altına gömülmesine (bağlam taşması) yol açabilir. Arızayı azaltmak ve mevcut RAG mimarisini geliştirmek amacıyla, alma hatalarını azaltmak, yanıt kalitesini artırmak ve karmaşık soru yönetimini etkinleştirmek için gelişmiş RAG modellerini (ana belge alıcısı ve bağlamsal sıkıştırma) kullanabilirsiniz.

Bu yazıda tartışılan tekniklerle, dışarıdan bilgi alma ve entegrasyonla ilgili temel zorlukları çözebilir, uygulamanızın daha kesin ve bağlamsal olarak bilinçli yanıtlar sunmasını sağlayabilirsiniz.

Aşağıdaki bölümlerde bunun nasıl olduğunu araştırıyoruz ana belge alıcıları ve bağlamsal sıkıştırma tartıştığımız bazı sorunların üstesinden gelmenize yardımcı olabilir.

Ana belge alıcısı

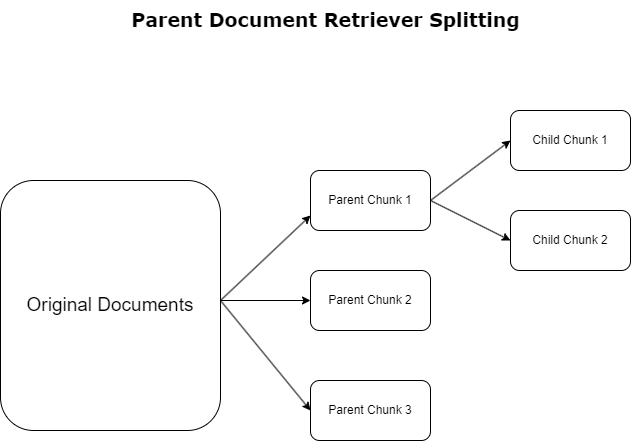

Önceki bölümde RAG uygulamalarının kapsamlı belgelerle uğraşırken karşılaştığı zorlukları vurguladık. Bu zorlukların üstesinden gelmek için, ana belge alıcıları Gelen belgeleri şu şekilde kategorilere ayırın ve belirtin: ana belgeler. Bu belgeler kapsamlı yapıları nedeniyle tanınmaktadır ancak yerleştirmeler için orijinal hallerinde doğrudan kullanılmamaktadır. Ana belge alıcıları, bir belgenin tamamını tek bir yerleştirmeye sıkıştırmak yerine bu ana belgeleri parçalara ayırır. alt belgeler. Her alt belge, daha geniş ana belgeden farklı yönleri veya konuları yakalar. Bu alt bölümlerin tanımlanmasının ardından, her birine özel tematik özlerini yakalayan ayrı yerleştirmeler atanır (aşağıdaki şemaya bakın). Alma sırasında ana belge çağrılır. Bu teknik, LLM'ye daha geniş bir bakış açısı kazandırarak hedefli ancak geniş kapsamlı arama yetenekleri sağlar. Ana belge alıcıları, LLM'lere iki yönlü bir avantaj sağlar: Kesin ve ilgili bilgi alımı için alt belge yerleştirmelerin özgüllüğü, yanıt oluşturmak için ana belgelerin çağrılması ile birleşerek LLM'nin çıktılarını katmanlı ve kapsamlı bir bağlamla zenginleştirir.

Bağlamsal sıkıştırma

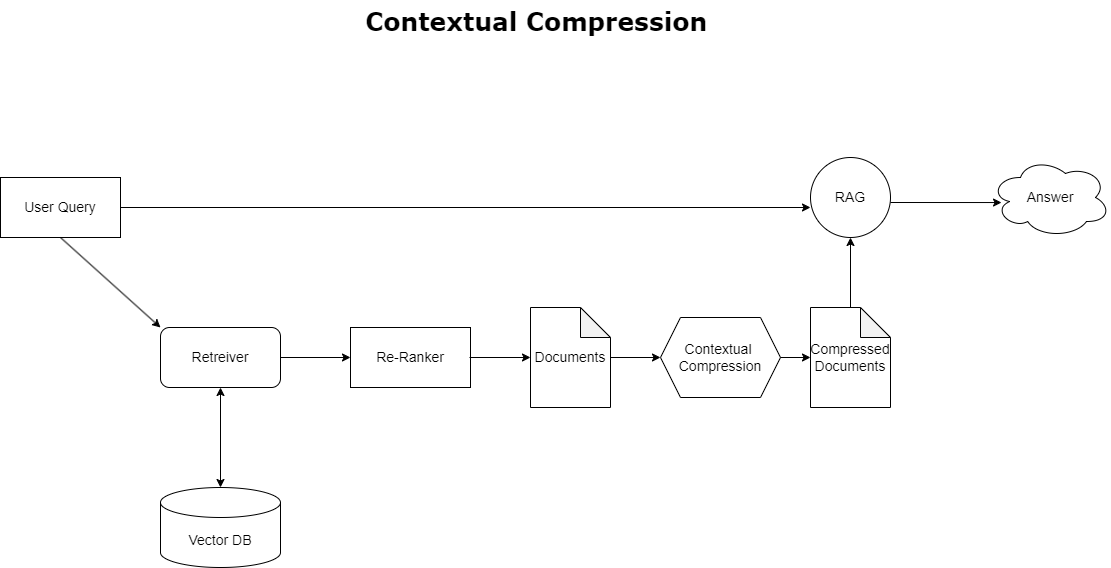

Daha önce tartışılan bağlam taşması sorununu çözmek için şunları kullanabilirsiniz: bağlamsal sıkıştırma Alınan belgeleri sorgu bağlamına uygun şekilde sıkıştırmak ve filtrelemek, böylece yalnızca ilgili bilgilerin saklanması ve işlenmesi. Bu, aşağıdaki şemada gösterildiği gibi, ilk belge alımı için bir temel alıcı ve bu belgelerin içeriklerini ayrıştırarak veya alaka düzeyine göre tamamen hariç tutarak iyileştirmek için bir belge sıkıştırıcının birleşimiyle gerçekleştirilir. Bağlamsal sıkıştırma alıcısı tarafından kolaylaştırılan bu kolaylaştırılmış yaklaşım, bir bilgi yığınından yalnızca gerekli olanı ayıklamak ve kullanmak için bir yöntem sağlayarak RAG uygulama verimliliğini büyük ölçüde artırır. Aşırı bilgi yüklemesi ve alakasız veri işleme sorununu doğrudan ele alarak yanıt kalitesinin iyileştirilmesine, daha uygun maliyetli LLM işlemlerine ve daha sorunsuz bir genel geri alma sürecine yol açar. Temel olarak, bilgileri eldeki sorguya göre uyarlayan bir filtredir ve bu da onu daha iyi performans ve kullanıcı memnuniyeti için RAG uygulamalarını optimize etmeyi amaçlayan geliştiriciler için çok ihtiyaç duyulan bir araç haline getirir.

Önkoşullar

SageMaker'da yeniyseniz, bkz. Amazon SageMaker Geliştirme Kılavuzu.

Çözüme başlamadan önce, bir AWS hesabı oluşturun. Bir AWS hesabı oluşturduğunuzda, hesaptaki tüm AWS hizmetlerine ve kaynaklarına tam erişime sahip olan bir tek oturum açma (SSO) kimliğine sahip olursunuz. Bu kimliğe AWS hesabı denir kök kullanıcı.

Oturum açma AWS Yönetim Konsolu hesabı oluşturmak için kullandığınız e-posta adresini ve şifreyi kullanmak, hesabınızdaki tüm AWS kaynaklarına tam erişim sağlar. Yönetici görevleri de dahil olmak üzere günlük görevler için root kullanıcısını kullanmamanızı önemle tavsiye ederiz.

Bunun yerine, aşağıdaki kurallara uyun güvenlik en iyi uygulamaları in AWS Kimlik ve Erişim Yönetimi (Ben ve yönetici kullanıcı ve grup oluştur. Ardından kök kullanıcı kimlik bilgilerini güvenli bir şekilde kilitleyin ve bunları yalnızca birkaç hesap ve hizmet yönetimi görevini gerçekleştirmek için kullanın.

Mixtral-8x7b modeli ml.g5.48xlarge örneğini gerektirir. SageMaker JumpStart, 100'den fazla farklı açık kaynak ve üçüncü taraf temel modeline erişmek ve bunları dağıtmak için basitleştirilmiş bir yol sağlar. İçin SageMaker JumpStart'tan Mixtral-8x7B'yi barındıracak bir uç nokta başlatınuç nokta kullanımı için bir ml.g5.48xlarge örneğine erişmek amacıyla hizmet kotası artışı talep etmeniz gerekebilir. Yapabilirsiniz hizmet kotası artışlarını talep etme konsol aracılığıyla, AWS Komut Satırı Arayüzü (AWS CLI) veya bu ek kaynaklara erişime izin vermek için API.

Bir SageMaker not defteri örneği kurun ve bağımlılıkları yükleyin

Başlamak için bir SageMaker not defteri örneği oluşturun ve gerekli bağımlılıkları yükleyin. Bakın GitHub repo Başarılı bir kurulum sağlamak için. Dizüstü bilgisayar örneğini kurduktan sonra modeli dağıtabilirsiniz.

Ayrıca dizüstü bilgisayarınızı tercih ettiğiniz tümleşik geliştirme ortamında (IDE) yerel olarak da çalıştırabilirsiniz. Jupyter dizüstü bilgisayar laboratuvarının kurulu olduğundan emin olun.

Modeli dağıtın

Mixtral-8X7B Instruct LLM modelini SageMaker JumpStart'ta dağıtın:

BGE Large En yerleştirme modelini SageMaker JumpStart'ta dağıtın:

LangChain'i kurun

Gerekli tüm kitaplıkları içe aktardıktan ve Mixtral-8x7B modelini ve BGE Large En yerleştirme modelini dağıttıktan sonra artık LangChain'i kurabilirsiniz. Adım adım talimatlar için bkz. GitHub repo.

Veri Hazırlama

Bu yazıda, Soru-Cevap gerçekleştirmek için Amazon'un Hissedarlara Mektuplarını birkaç yıllık bir metin külliyatı olarak kullanıyoruz. Verileri hazırlamaya yönelik daha ayrıntılı adımlar için bkz. GitHub repo.

Soru cevaplama

Veriler hazırlandıktan sonra, vektör deposunun etrafını saran ve LLM için girdi alan, LangChain tarafından sağlanan sarmalayıcıyı kullanabilirsiniz. Bu sarmalayıcı aşağıdaki adımları gerçekleştirir:

- Giriş sorusunu alın.

- Bir soru yerleştirme oluşturun.

- İlgili belgeleri getirin.

- Belgeleri ve soruyu bir bilgi istemine ekleyin.

- Modeli istemle çağırın ve yanıtı okunabilir bir şekilde oluşturun.

Artık vektör mağazası hazır olduğuna göre soru sormaya başlayabilirsiniz:

Düzenli av köpeği zinciri

Önceki senaryoda, sorunuza bağlama duyarlı bir yanıt almanın hızlı ve kolay yolunu araştırdık. Şimdi RetrievalQA'nın yardımıyla daha özelleştirilebilir bir seçeneğe bakalım; burada, Chain_type parametresini kullanarak getirilen belgelerin bilgi istemine nasıl eklenmesi gerektiğini özelleştirebilirsiniz. Ayrıca kaç tane ilgili belgenin alınması gerektiğini kontrol etmek için aşağıdaki koddaki k parametresini değiştirerek farklı çıktıları görebilirsiniz. Birçok senaryoda LLM'nin yanıtı oluşturmak için hangi kaynak belgeleri kullandığını bilmek isteyebilirsiniz. Bu belgeleri çıktıda kullanarak alabilirsiniz. return_source_documentsLLM isteminin bağlamına eklenen belgeleri döndürür. RetrievalQA ayrıca modele özel olabilecek özel bir bilgi istemi şablonu sağlamanıza da olanak tanır.

Bir soru soralım:

Ana belge alıcı zinciri

Aşağıdakilerin yardımıyla daha gelişmiş bir RAG seçeneğine bakalım: EbeveynDocumentRetriever. Belge alımıyla çalışırken, doğru yerleştirmeler için belgenin küçük parçalarını depolamak ile daha fazla bağlamı korumak için daha büyük belgeleri depolamak arasında bir dengeyle karşılaşabilirsiniz. Ana belge alıcısı, küçük veri parçalarını bölerek ve depolayarak bu dengeyi sağlar.

Kullanırız parent_splitter orijinal belgeleri ana belgeler adı verilen daha büyük parçalara bölmek ve child_splitter orijinal belgelerden daha küçük alt belgeler oluşturmak için:

Alt belgeler daha sonra yerleştirmeler kullanılarak bir vektör deposunda indekslenir. Bu, benzerliğe dayalı olarak ilgili alt belgelerin verimli bir şekilde alınmasını sağlar. İlgili bilgileri almak için ana belge alıcısı ilk olarak alt belgeleri vektör deposundan getirir. Daha sonra bu alt belgelerin ana kimliklerini arar ve karşılık gelen daha büyük ana belgeleri döndürür.

Bir soru soralım:

Bağlamsal sıkıştırma zinciri

Adı verilen başka bir gelişmiş RAG seçeneğine bakalım bağlamsal sıkıştırma. Almayla ilgili zorluklardan biri, verileri sisteme aldığınızda belge depolama sisteminizin karşılaşacağı spesifik sorguları genellikle bilmememizdir. Bu, bir sorguyla en alakalı bilgilerin, pek çok alakasız metin içeren bir belgenin içine gömülebileceği anlamına gelir. Bu belgenin tamamını başvurunuz aracılığıyla iletmek, daha pahalı LLM çağrılarına ve daha kötü yanıtlara yol açabilir.

Bağlamsal sıkıştırma alıcısı, ilgili verilerin çok fazla metin içeren belgelerin içine gömülebileceği bir belge depolama sisteminden ilgili bilgilerin alınması zorluğunu giderir. Alınan belgelerin verilen sorgu bağlamına göre sıkıştırılması ve filtrelenmesiyle yalnızca en alakalı bilgiler döndürülür.

Bağlamsal sıkıştırma alıcısını kullanmak için şunlara ihtiyacınız olacak:

- Bir baz alıcı – Bu, sorguya dayalı olarak depolama sisteminden belgeleri getiren ilk alıcıdır

- Bir belge sıkıştırıcı – Bu bileşen, başlangıçta alınan belgeleri alır ve alaka düzeyini belirlemek için sorgu bağlamını kullanarak, tek tek belgelerin içeriğini azaltarak veya ilgisiz belgeleri tamamen bırakarak bunları kısaltır.

LLM zincir çıkarıcıyla bağlamsal sıkıştırma ekleme

İlk önce, baz toplayıcınızı bir sarın ContextualCompressionRetriever. Bir ekleyeceksiniz LLMChainExtractor, başlangıçta döndürülen belgeler üzerinde yineleme yapacak ve her birinden yalnızca sorguyla ilgili içeriği çıkaracaktır.

kullanarak zinciri başlatın. ContextualCompressionRetriever bir ile LLMChainExtractor ve istemi aracılığıyla iletin chain_type_kwargs argüman.

Bir soru soralım:

Belgeleri LLM zincir filtresiyle filtreleyin

The LLMChainFiltre belge içeriğini değiştirmeden, başlangıçta alınan belgelerden hangisinin filtreleneceğine ve hangilerinin geri döndürüleceğine karar vermek için bir LLM zinciri kullanan, biraz daha basit ama daha sağlam bir sıkıştırıcıdır:

kullanarak zinciri başlatın. ContextualCompressionRetriever bir ile LLMChainFilter ve istemi aracılığıyla iletin chain_type_kwargs argüman.

Bir soru soralım:

Sonuçları karşılaştır

Aşağıdaki tablo, tekniğe dayalı olarak farklı sorgulardan elde edilen sonuçları karşılaştırır.

| Teknik | Sorgu 1 | Sorgu 2 | karşılaştırma |

| AWS nasıl gelişti? | Amazon neden başarılı? | ||

| Düzenli Retriever Zinciri Çıkışı | AWS (Amazon Web Services), başlangıçta kârsız bir yatırımdan, güçlü kârlılığa sahip, geniş bir hizmet ve özellik yelpazesi sunan ve Amazon'un portföyünün önemli bir parçası haline gelen, yıllık 85 milyar dolarlık gelir elde eden bir işletmeye dönüştü. AWS, şüphecilikle ve kısa vadeli olumsuzluklarla karşı karşıya olmasına rağmen yenilik yapmaya, yeni müşteriler çekmeye ve aktif müşterileri taşımaya devam ederek çeviklik, yenilikçilik, maliyet verimliliği ve güvenlik gibi avantajlar sunmaya devam etti. AWS ayrıca yeni yetenekler sağlamak ve müşterileri için mümkün olanı değiştirmek amacıyla çip geliştirme dahil uzun vadeli yatırımlarını da genişletti. | Amazon, teknolojik altyapı hizmetleri, dijital okuma cihazları, sesle çalışan kişisel asistanlar ve üçüncü taraf pazar yeri gibi yeni iş modelleri gibi sürekli yenilik ve yeni alanlara doğru genişlemesi nedeniyle başarılıdır. Sipariş karşılama ve ulaşım ağlarının hızla genişlemesinde görüldüğü gibi, operasyonları hızlı bir şekilde ölçeklendirme yeteneği de başarısına katkıda bulunuyor. Ayrıca Amazon'un süreçlerinde optimizasyon ve verimlilik kazanımlarına odaklanması, üretkenliğin artması ve maliyetlerin azalmasıyla sonuçlandı. Amazon Business örneği, şirketin farklı sektörlerdeki e-ticaret ve lojistik güçlerinden yararlanma yeteneğini vurguluyor. | Normal geri getirici zincirinden gelen yanıtlara dayanarak, uzun yanıtlar vermesine rağmen bağlam taşması sorunu yaşadığını ve sağlanan sorguya yanıt vermeyle ilgili olarak derlemdeki herhangi bir önemli ayrıntıdan bahsetmediğini fark ettik. Düzenli erişim zinciri, nüansları derinlemesine veya bağlamsal içgörüyle yakalayamıyor; bu da belgenin kritik yönlerinin kaçırılması ihtimalini doğuruyor. |

| Ana Belge Alıcı Çıktısı | AWS (Amazon Web Services), 2 yılında Elastic Compute Cloud (EC2006) hizmetinin düşük özellikli ilk lansmanıyla başladı ve yalnızca Linux işletim sistemi örnekleriyle dünyanın bir bölgesinde, tek bir veri merkezinde yalnızca tek bir bulut sunucusu boyutu sağladı. ve izleme, yük dengeleme, otomatik ölçeklendirme veya kalıcı depolama gibi pek çok temel özellik olmadan. Bununla birlikte, AWS'nin başarısı, eksik yetenekleri hızlı bir şekilde yinelemelerine ve eklemelerine olanak tanıdı ve sonunda bilgi işlem, depolama ve ağ iletişimi için çeşitli tatlar, boyutlar ve optimizasyonlar sunacak şekilde genişledi ve ayrıca fiyat ve performansı daha da artırmak için kendi çiplerini (Graviton) geliştirdi. . AWS'nin yinelenen inovasyon süreci, müşteri ihtiyaçlarını karşılamak ve uzun vadeli müşteri deneyimlerini, bağlılığını ve hissedarların getirilerini iyileştirmek için 20 yıl boyunca finansal kaynaklara ve insan kaynaklarına, çoğu zaman karşılığını alacağı zamandan çok önce önemli yatırımlar yapılmasını gerektirdi. | Amazon, sürekli yenilik yapma, değişen pazar koşullarına uyum sağlama ve çeşitli pazar segmentlerindeki müşteri ihtiyaçlarını karşılama yeteneği nedeniyle başarılıdır. Bu, ticari müşterilere seçim, değer ve kolaylık sunarak yıllık brüt satışlarda yaklaşık 35 milyar ABD doları elde eden Amazon Business'ın başarısında açıkça görülmektedir. Amazon'un e-ticaret ve lojistik yeteneklerine yaptığı yatırımlar, doğrudan tüketiciye yönelik web sitelerine sahip satıcıların görüntülemelerden satın almalara dönüşümü artırmasına yardımcı olan Buy with Prime gibi hizmetlerin oluşturulmasını da mümkün kıldı. | Ana belge alıcısı, bağlam açısından zengin bir yanıt sağlarken, müşteri geri bildirimlerine dayalı olarak yeni özelliklerin eklenmesine yönelik yinelemeli süreç ve özellik açısından zayıf bir ilk lansmandan hakim bir pazar konumuna kadar ayrıntılı yolculuk da dahil olmak üzere AWS'nin büyüme stratejisinin ayrıntılarını daha derinlemesine inceler. . Yanıtlar, teknik yenilikler ve pazar stratejisinden organizasyonel verimlilik ve müşteri odaklılığa kadar geniş bir yelpazeyi kapsamakta ve örneklerle birlikte başarıya katkıda bulunan faktörlere ilişkin bütünsel bir bakış sunmaktadır. Bu, ana belge alıcının hedefli ancak geniş kapsamlı arama yeteneklerine bağlanabilir. |

| Yüksek Lisans Zincir Çıkarıcı: Bağlamsal Sıkıştırma Çıktısı | AWS, Amazon içinde küçük bir proje olarak başlayarak, önemli miktarda sermaye yatırımı gerektirerek ve hem şirket içinden hem de dışarıdan şüphelerle karşı karşıya kalarak gelişti. Ancak AWS, potansiyel rakiplere göre bir adım öndeydi ve müşterilere ve Amazon'a getirebileceği değere inanıyordu. AWS, yatırımlarına devam etme konusunda uzun vadeli bir taahhütte bulundu ve bunun sonucunda 3,300'de 2022'den fazla yeni özellik ve hizmet piyasaya sürüldü. AWS, müşterilerin teknoloji altyapılarını yönetme biçimini dönüştürdü ve güçlü kârlılığa sahip, yıllık 85 milyar ABD doları gelir elde eden bir işletme haline geldi. AWS ayrıca EC2'yi ilk lansmanından sonra ek özellikler ve hizmetlerle geliştirmek gibi tekliflerini sürekli olarak geliştirdi. | Sunulan bağlama göre Amazon'un başarısı, kitap satış platformundan canlı bir üçüncü taraf satıcı ekosistemine sahip küresel bir pazara doğru stratejik genişlemesine, AWS'ye erken yatırım yapılmasına, Kindle ve Alexa'nın piyasaya sürülmesindeki yenilikçiliğe ve önemli büyümeye atfedilebilir. Bu büyüme, sipariş karşılama merkezinin kapladığı alanın genişletilmesine, son kilometre taşıma ağının oluşturulmasına ve üretkenlik ve maliyet azaltımı için optimize edilmiş yeni bir ayırma merkezi ağının inşa edilmesine yol açtı. | LLM zincir çıkarıcı, önemli noktaları kapsamlı bir şekilde ele almak ve gereksiz derinliklerden kaçınmak arasında bir denge sağlar. Sorgunun bağlamına dinamik olarak uyum sağlar, böylece çıktı doğrudan alakalı ve kapsamlı olur. |

| LLM Zincir Filtresi: Bağlamsal Sıkıştırma Çıktısı | AWS (Amazon Web Services), başlangıçta özellikleri zayıf olarak piyasaya sürülerek, ancak gerekli yetenekleri eklemek için müşteri geri bildirimlerine göre hızlı bir şekilde yinelenerek geliştirildi. Bu yaklaşım, AWS'nin 2 yılında sınırlı özelliklerle EC2006'yi piyasaya sürmesine ve ardından ek bulut sunucusu boyutları, veri merkezleri, bölgeler, işletim sistemi seçenekleri, izleme araçları, yük dengeleme, otomatik ölçeklendirme ve kalıcı depolama gibi sürekli olarak yeni işlevler eklemesine olanak tanıdı. AWS zamanla müşteri ihtiyaçlarına, çevikliğe, yenilikçiliğe, maliyet verimliliğine ve güvenliğe odaklanarak yetersiz özelliklere sahip bir hizmetten milyarlarca dolarlık bir işletmeye dönüştü. AWS şu anda yıllık 85 milyar dolarlık bir gelir elde ediyor ve her yıl 3,300'den fazla yeni özellik ve hizmet sunarak yeni kurulan şirketlerden çok uluslu şirketlere ve kamu sektörü kuruluşlarına kadar geniş bir müşteri yelpazesine hitap ediyor. | Amazon, yenilikçi iş modelleri, sürekli teknolojik gelişmeler ve stratejik organizasyonel değişiklikler nedeniyle başarılıdır. Şirket, çeşitli ürün ve hizmetler için bir e-ticaret platformu, üçüncü taraf bir pazar yeri, bulut altyapı hizmetleri (AWS), Kindle e-okuyucu ve Alexa sesli kişisel asistan gibi yeni fikirler sunarak geleneksel endüstrileri sürekli olarak altüst etti. . Ayrıca Amazon, verimliliğini artırmak için ABD sipariş karşılama ağını maliyetleri ve teslimat sürelerini azaltacak şekilde yeniden düzenlemek gibi yapısal değişiklikler yaparak başarısına daha da katkıda bulundu. | LLM zincir çıkarıcıya benzer şekilde LLM zincir filtresi, kilit noktaların kapsanmasına rağmen kısa ve bağlamsal yanıtlar arayan müşteriler için çıktının verimli olmasını sağlar. |

Bu farklı teknikleri karşılaştırdığımızda, AWS'nin basit bir hizmetten karmaşık, milyarlarca dolarlık bir varlığa geçişini detaylandırmak veya Amazon'un stratejik başarılarını açıklamak gibi bağlamlarda, normal geri alma zincirinin daha karmaşık tekniklerin sunduğu hassasiyetten yoksun olduğunu görebiliriz. daha az hedefe yönelik bilgiye yol açmaktadır. Tartışılan ileri teknikler arasında çok az fark görülse de, bunlar normal avlanma zincirlerinden çok daha bilgilendiricidir.

Sağlık hizmetleri, telekomünikasyon ve finansal hizmetler gibi endüstrilerde faaliyet gösteren ve uygulamalarında RAG'ı uygulamak isteyen müşteriler için, normal geri alma zincirinin hassasiyet sağlama, fazlalığı önleme ve bilgileri etkili bir şekilde sıkıştırma konusundaki sınırlamaları, bu zincirin bu ihtiyaçları karşılama konusunda daha az uygun olmasını sağlar. daha gelişmiş ana belge alıcısına ve bağlamsal sıkıştırma tekniklerine. Bu teknikler, büyük miktarda bilgiyi ihtiyacınız olan konsantre, etkili içgörülere dönüştürebilir ve aynı zamanda fiyat performansının iyileştirilmesine yardımcı olabilir.

Temizlemek

Not defterini çalıştırmayı tamamladığınızda, kullanılan kaynaklara ilişkin ücret tahakkuk etmesini önlemek için oluşturduğunuz kaynakları silin:

Sonuç

Bu yazıda, LLM'lerin bilgi işleme ve üretme yeteneğini geliştirmek için ana belge alıcısı ve bağlamsal sıkıştırma zinciri tekniklerini uygulamanıza olanak tanıyan bir çözüm sunduk. Bu gelişmiş RAG tekniklerini SageMaker JumpStart ile birlikte sunulan Mixtral-8x7B Instruct ve BGE Large En modelleriyle test ettik. Ayrıca yerleştirmeler ve belge parçaları için kalıcı depolamayı kullanmayı ve kurumsal veri depolarıyla entegrasyonu da araştırdık.

Uyguladığımız teknikler, yalnızca LLM modellerinin harici bilgiye erişme ve bunları dahil etme şeklini iyileştirmekle kalmıyor, aynı zamanda çıktılarının kalitesini, alaka düzeyini ve verimliliğini de önemli ölçüde artırıyor. Bu gelişmiş RAG teknikleri, büyük metin korporasından alma işlemini dil oluşturma yetenekleriyle birleştirerek, LLM'lerin daha gerçekçi, tutarlı ve bağlama uygun yanıtlar üretmesine olanak tanıyarak çeşitli doğal dil işleme görevlerindeki performanslarını artırır.

SageMaker JumpStart bu çözümün merkezinde yer alıyor. SageMaker JumpStart ile, ML'ye başlama sürecini kolaylaştıran ve hızlı deneme ve dağıtıma olanak tanıyan geniş bir açık ve kapalı kaynak model yelpazesine erişim kazanırsınız. Bu çözümü dağıtmaya başlamak için not defterine gidin. GitHub repo.

Yazarlar Hakkında

Niithiyn Vijeaswaran AWS'de Çözüm Mimarıdır. Odaklandığı alan üretken yapay zeka ve AWS Yapay Zeka Hızlandırıcılarıdır. Bilgisayar Bilimleri ve Biyoenformatik alanında lisans derecesine sahiptir. Niithiyn, AWS müşterilerine birden fazla alanda olanak sağlamak ve üretken yapay zekayı benimsemelerini hızlandırmak için Generative AI GTM ekibiyle yakın işbirliği içinde çalışıyor. Dallas Mavericks'in sıkı bir hayranı ve spor ayakkabı koleksiyonu yapmaktan hoşlanıyor.

Niithiyn Vijeaswaran AWS'de Çözüm Mimarıdır. Odaklandığı alan üretken yapay zeka ve AWS Yapay Zeka Hızlandırıcılarıdır. Bilgisayar Bilimleri ve Biyoenformatik alanında lisans derecesine sahiptir. Niithiyn, AWS müşterilerine birden fazla alanda olanak sağlamak ve üretken yapay zekayı benimsemelerini hızlandırmak için Generative AI GTM ekibiyle yakın işbirliği içinde çalışıyor. Dallas Mavericks'in sıkı bir hayranı ve spor ayakkabı koleksiyonu yapmaktan hoşlanıyor.

Sebastian Bustillo AWS'de Çözüm Mimarıdır. Üretken yapay zeka ve bilgi işlem hızlandırıcılara yönelik derin bir tutkuyla AI/ML teknolojilerine odaklanıyor. AWS'de müşterilerin üretken yapay zeka yoluyla iş değerinin ortaya çıkmasına yardımcı oluyor. İşte olmadığı zamanlarda mükemmel bir fincan özel kahve hazırlamaktan ve eşiyle birlikte dünyayı keşfetmekten hoşlanıyor.

Sebastian Bustillo AWS'de Çözüm Mimarıdır. Üretken yapay zeka ve bilgi işlem hızlandırıcılara yönelik derin bir tutkuyla AI/ML teknolojilerine odaklanıyor. AWS'de müşterilerin üretken yapay zeka yoluyla iş değerinin ortaya çıkmasına yardımcı oluyor. İşte olmadığı zamanlarda mükemmel bir fincan özel kahve hazırlamaktan ve eşiyle birlikte dünyayı keşfetmekten hoşlanıyor.

Armando diaz AWS'de Çözüm Mimarıdır. Üretken AI, AI/ML ve Veri Analitiği konularına odaklanıyor. Armando, AWS'de müşterilerin son teknoloji üretken yapay zeka yeteneklerini sistemlerine entegre etmelerine yardımcı olarak yenilikçiliği ve rekabet avantajını teşvik ediyor. İşte olmadığı zamanlarda eşi ve ailesiyle vakit geçirmekten, yürüyüş yapmaktan ve dünyayı gezmekten hoşlanıyor.

Armando diaz AWS'de Çözüm Mimarıdır. Üretken AI, AI/ML ve Veri Analitiği konularına odaklanıyor. Armando, AWS'de müşterilerin son teknoloji üretken yapay zeka yeteneklerini sistemlerine entegre etmelerine yardımcı olarak yenilikçiliği ve rekabet avantajını teşvik ediyor. İşte olmadığı zamanlarda eşi ve ailesiyle vakit geçirmekten, yürüyüş yapmaktan ve dünyayı gezmekten hoşlanıyor.

Dr. Farooq Sabir AWS'de Kıdemli Yapay Zeka ve Makine Öğrenimi Uzmanı Çözüm Mimarıdır. Austin'deki Texas Üniversitesi'nden Elektrik Mühendisliği alanında doktora ve yüksek lisans derecelerine ve Georgia Institute of Technology'den Bilgisayar Bilimleri alanında yüksek lisans derecesine sahiptir. 15 yılı aşkın iş tecrübesine sahiptir ve ayrıca üniversite öğrencilerine ders vermeyi ve rehberlik etmeyi sever. AWS'de müşterilerin veri bilimi, makine öğrenimi, bilgisayar görüşü, yapay zeka, sayısal optimizasyon ve ilgili alanlarda iş sorunlarını formüle etmelerine ve çözmelerine yardımcı olur. Dallas, Teksas'ta yaşayan o ve ailesi seyahat etmeyi ve uzun yolculuklara çıkmayı seviyor.

Dr. Farooq Sabir AWS'de Kıdemli Yapay Zeka ve Makine Öğrenimi Uzmanı Çözüm Mimarıdır. Austin'deki Texas Üniversitesi'nden Elektrik Mühendisliği alanında doktora ve yüksek lisans derecelerine ve Georgia Institute of Technology'den Bilgisayar Bilimleri alanında yüksek lisans derecesine sahiptir. 15 yılı aşkın iş tecrübesine sahiptir ve ayrıca üniversite öğrencilerine ders vermeyi ve rehberlik etmeyi sever. AWS'de müşterilerin veri bilimi, makine öğrenimi, bilgisayar görüşü, yapay zeka, sayısal optimizasyon ve ilgili alanlarda iş sorunlarını formüle etmelerine ve çözmelerine yardımcı olur. Dallas, Teksas'ta yaşayan o ve ailesi seyahat etmeyi ve uzun yolculuklara çıkmayı seviyor.

Marco Punio üretken yapay zeka stratejisine, uygulamalı yapay zeka çözümlerine ve müşterilerin AWS'de hiper ölçeklendirme yapmasına yardımcı olmak için araştırmalar yürütmeye odaklanan bir Çözüm Mimarıdır. Marco, FinTech, Sağlık ve Yaşam Bilimleri, Hizmet Olarak Yazılım ve son olarak Telekomünikasyon sektörlerinde deneyime sahip bir dijital yerel bulut danışmanıdır. Makine öğrenimi, yapay zeka, birleşme ve satın alma konularına tutkuyla bağlı, nitelikli bir teknoloji uzmanıdır. Marco Seattle, WA'da yaşıyor ve boş zamanlarında yazmaktan, okumaktan, egzersiz yapmaktan ve uygulamalar geliştirmekten hoşlanıyor.

Marco Punio üretken yapay zeka stratejisine, uygulamalı yapay zeka çözümlerine ve müşterilerin AWS'de hiper ölçeklendirme yapmasına yardımcı olmak için araştırmalar yürütmeye odaklanan bir Çözüm Mimarıdır. Marco, FinTech, Sağlık ve Yaşam Bilimleri, Hizmet Olarak Yazılım ve son olarak Telekomünikasyon sektörlerinde deneyime sahip bir dijital yerel bulut danışmanıdır. Makine öğrenimi, yapay zeka, birleşme ve satın alma konularına tutkuyla bağlı, nitelikli bir teknoloji uzmanıdır. Marco Seattle, WA'da yaşıyor ve boş zamanlarında yazmaktan, okumaktan, egzersiz yapmaktan ve uygulamalar geliştirmekten hoşlanıyor.

AJ Dhimine AWS'de Çözüm Mimarıdır. Üretken yapay zeka, sunucusuz bilgi işlem ve veri analitiği konularında uzmanlaşmıştır. Makine Öğrenimi Teknik Alan Topluluğunun aktif bir üyesi/akıl hocasıdır ve çeşitli AI/ML konularında çok sayıda bilimsel makale yayınlamıştır. AWSome üretken yapay zeka çözümleri geliştirmek için yeni kurulan şirketlerden kuruluşlara kadar geniş bir yelpazedeki müşterilerle birlikte çalışıyor. Kendisi özellikle gelişmiş veri analitiği için Büyük Dil Modellerinden yararlanma ve gerçek dünyadaki zorlukları ele alan pratik uygulamaları keşfetme konusunda tutkulu. AJ iş dışında seyahat etmekten hoşlanıyor ve şu anda dünyadaki her ülkeyi ziyaret etme hedefiyle 53 ülkede bulunuyor.

AJ Dhimine AWS'de Çözüm Mimarıdır. Üretken yapay zeka, sunucusuz bilgi işlem ve veri analitiği konularında uzmanlaşmıştır. Makine Öğrenimi Teknik Alan Topluluğunun aktif bir üyesi/akıl hocasıdır ve çeşitli AI/ML konularında çok sayıda bilimsel makale yayınlamıştır. AWSome üretken yapay zeka çözümleri geliştirmek için yeni kurulan şirketlerden kuruluşlara kadar geniş bir yelpazedeki müşterilerle birlikte çalışıyor. Kendisi özellikle gelişmiş veri analitiği için Büyük Dil Modellerinden yararlanma ve gerçek dünyadaki zorlukları ele alan pratik uygulamaları keşfetme konusunda tutkulu. AJ iş dışında seyahat etmekten hoşlanıyor ve şu anda dünyadaki her ülkeyi ziyaret etme hedefiyle 53 ülkede bulunuyor.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/advanced-rag-patterns-on-amazon-sagemaker/