この投稿は、Merck のシニア データ エンジニアリング スペシャリストである Jayadeep Pabbisetty と Tiger Analytics のシニア ML エンジニアである Prabakaran Mathaiyan の共同執筆です。

大規模な機械学習 (ML) モデルの開発ライフサイクルには、ソフトウェア開発と同様のスケーラブルなモデル リリース プロセスが必要です。モデル開発者は ML モデルの開発で共同作業することが多く、作業には堅牢な MLOps プラットフォームが必要です。スケーラブルな MLOps プラットフォームには、ML モデルのレジストリ、承認、次の環境レベル (開発、テスト) への昇格のワークフローを処理するプロセスが含まれている必要があります。 、UAT、または本番環境)。

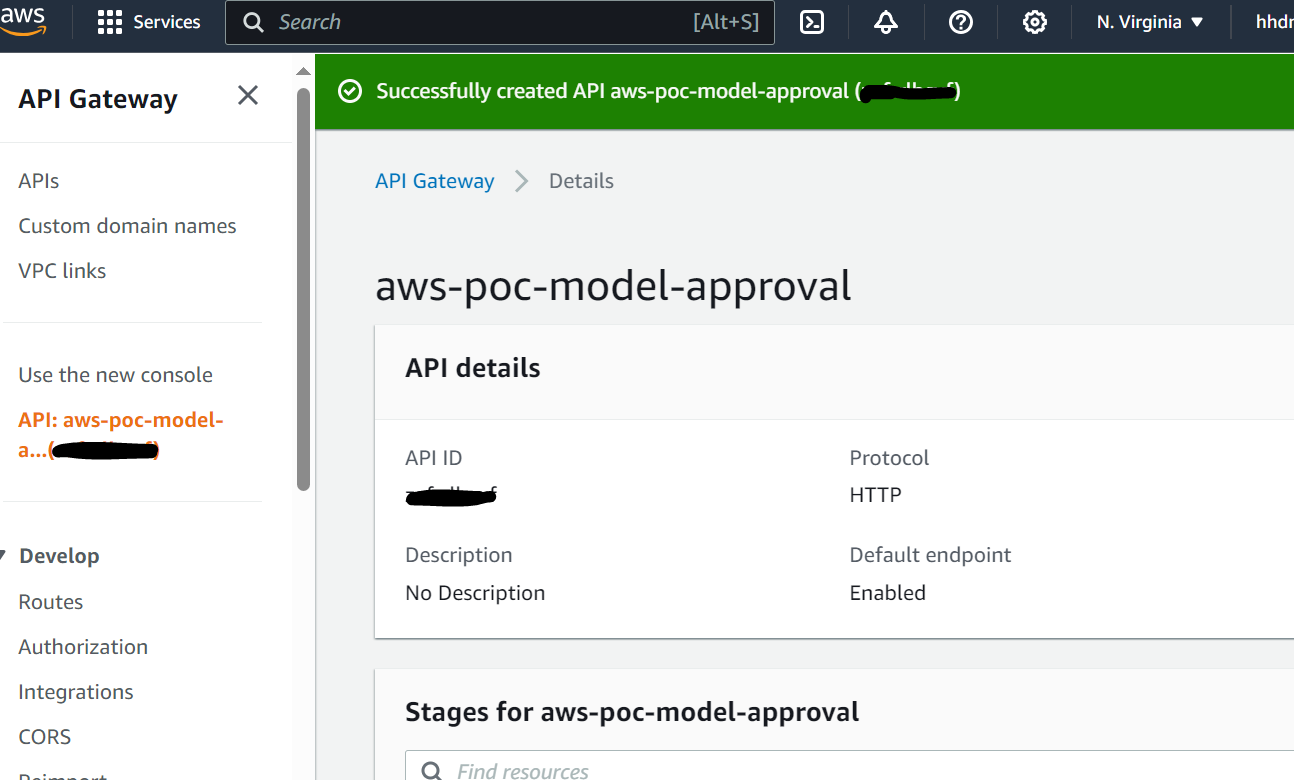

モデル開発者は通常、社内の個別の ML 開発環境で作業を開始します。 アマゾンセージメーカー。モデルがトレーニングされて使用できるようになったら、モデルを Amazon SageMaker モデルレジストリ。この投稿では、AWS AI/ML チームが Merck Human Health IT MLOps チームと協力して、中間に人間の介入を伴う ML モデルの承認とプロモーションのための自動ワークフローを使用するソリューションを構築した方法について説明します。

ソリューションの概要

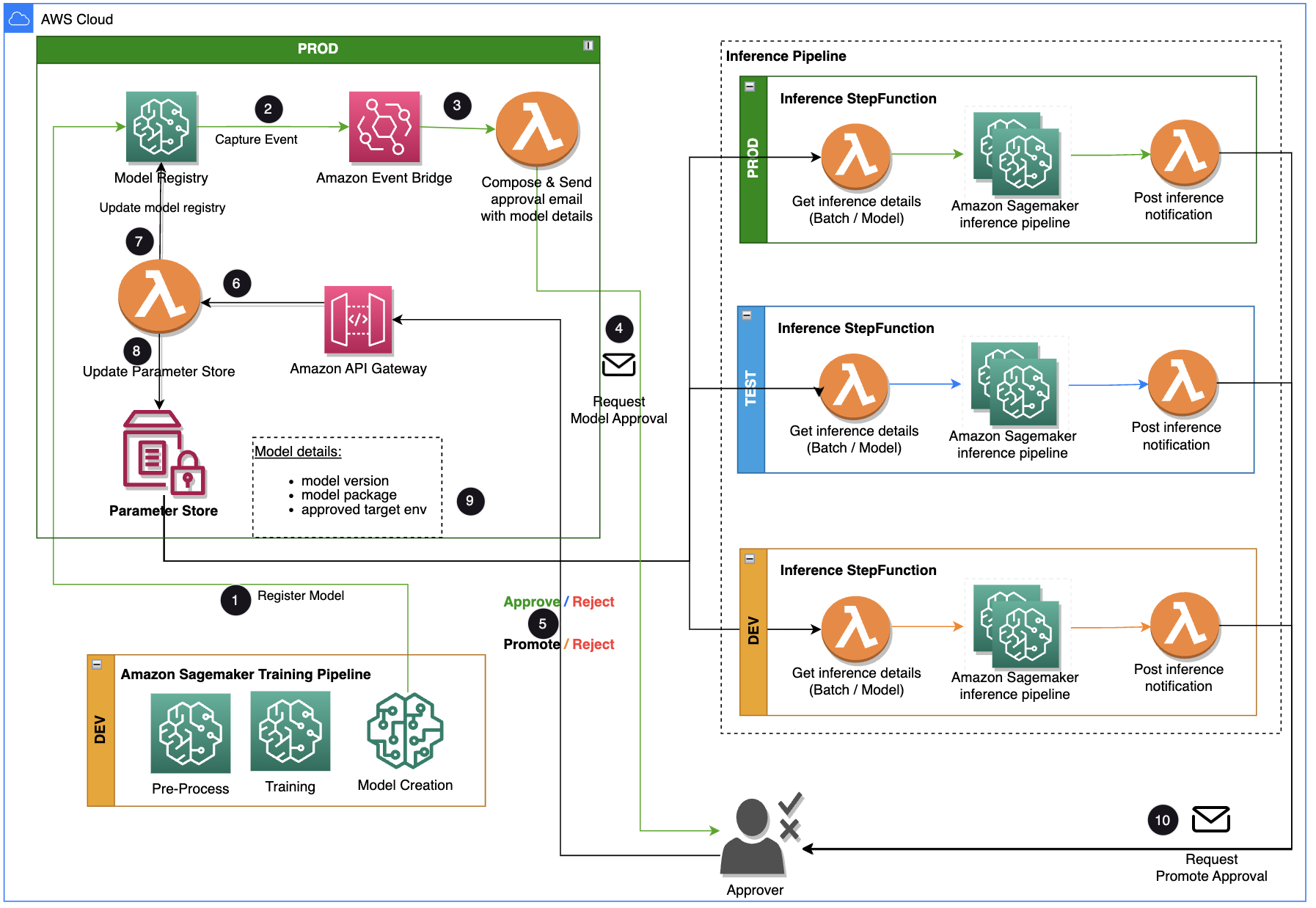

この投稿では、ML モデル開発ライフサイクルがトレーニング パイプラインと推論パイプラインの間で使用できるワークフロー ソリューションに焦点を当てます。このソリューションは、人間の介入による ML モデルの承認およびプロモーション プロセスをサポートする MLOps にスケーラブルなワークフローを提供します。データ サイエンティストによって登録された ML モデルは、推論パイプラインや次の環境レベル (テスト、UAT、または運用) で使用される前に、承認者によるレビューと承認が必要です。ソリューションでは、 AWSラムダ, アマゾンAPIゲートウェイ, アマゾンイベントブリッジ、SageMaker を使用して、途中で人間の承認が介入してワークフローを自動化します。次のアーキテクチャ図は、全体的なシステム設計、使用される AWS サービス、開発から本番まで人間の介入を伴う ML モデルの承認と推進のワークフローを示しています。

ワークフローには次の手順が含まれます。

- トレーニング パイプラインはモデルを開発し、SageMaker モデル レジストリに登録します。この時点でのモデルのステータスは、

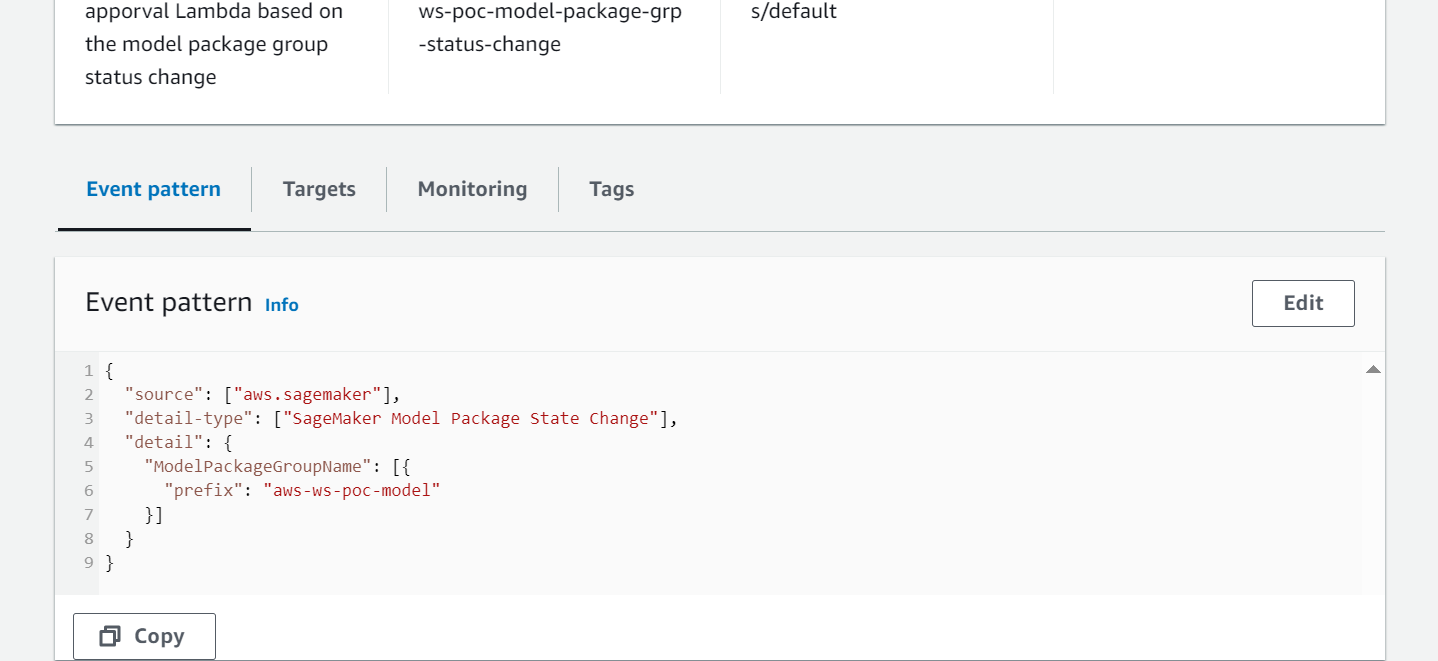

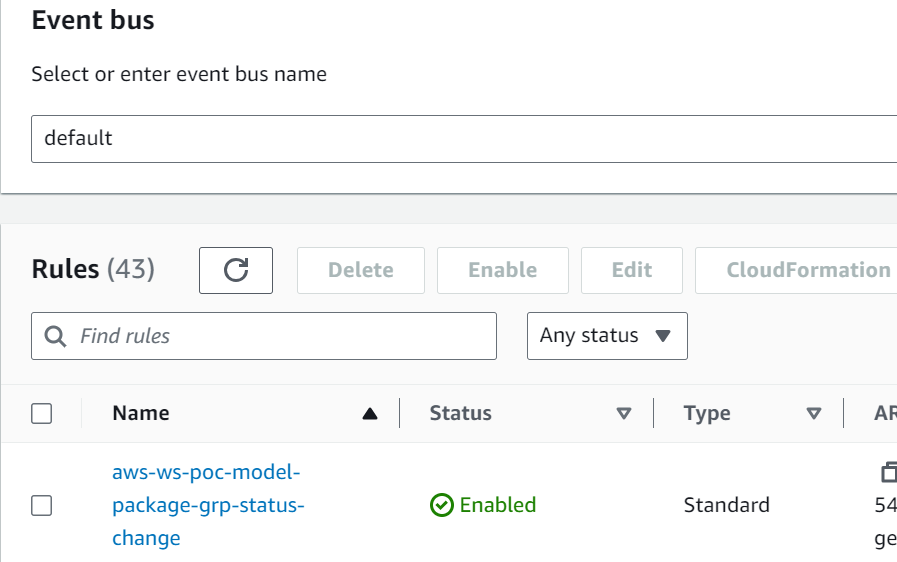

PendingManualApproval. - EventBridge はステータス変更イベントを監視し、簡単なルールに基づいて自動的にアクションを実行します。

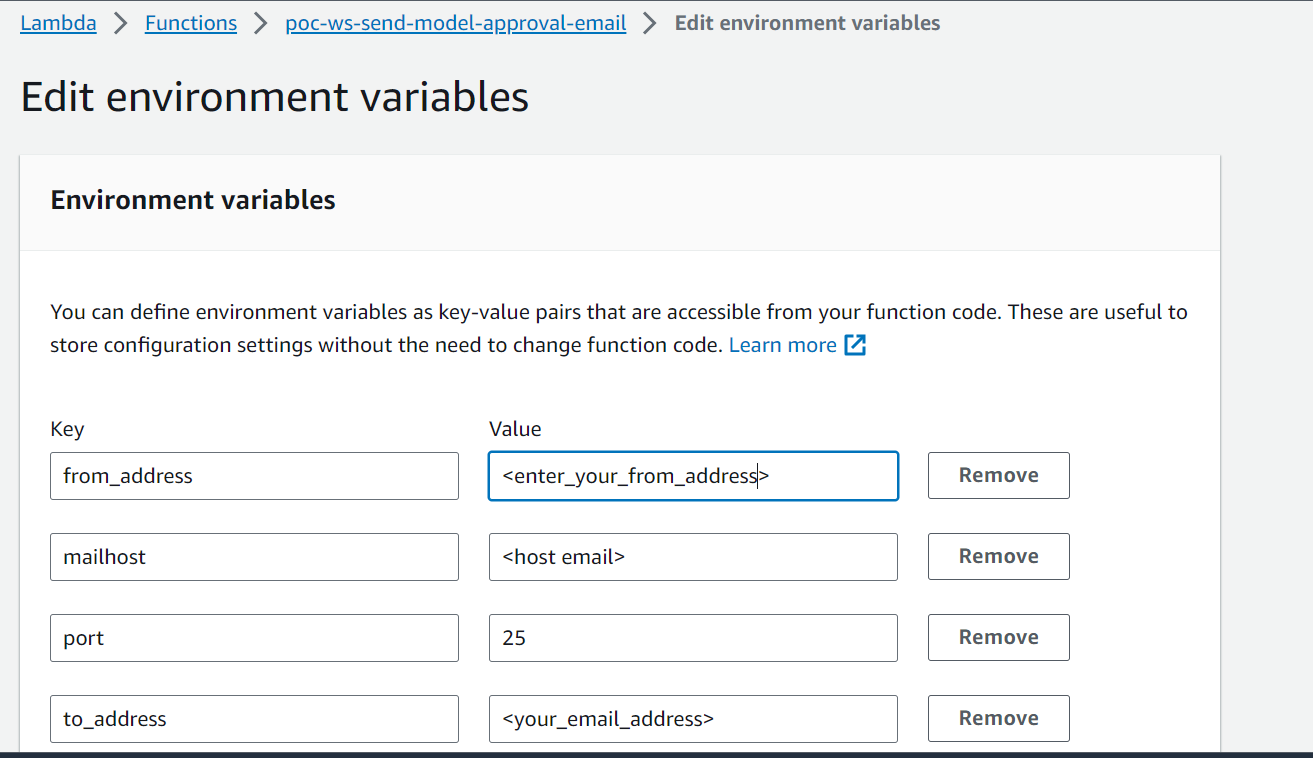

- EventBridge モデル登録イベント ルールは、登録されたモデルを承認または拒否するためのリンクを含む電子メールを作成する Lambda 関数を呼び出します。

- 承認者は、モデルを確認して承認または拒否するためのリンクが記載された電子メールを受け取ります。

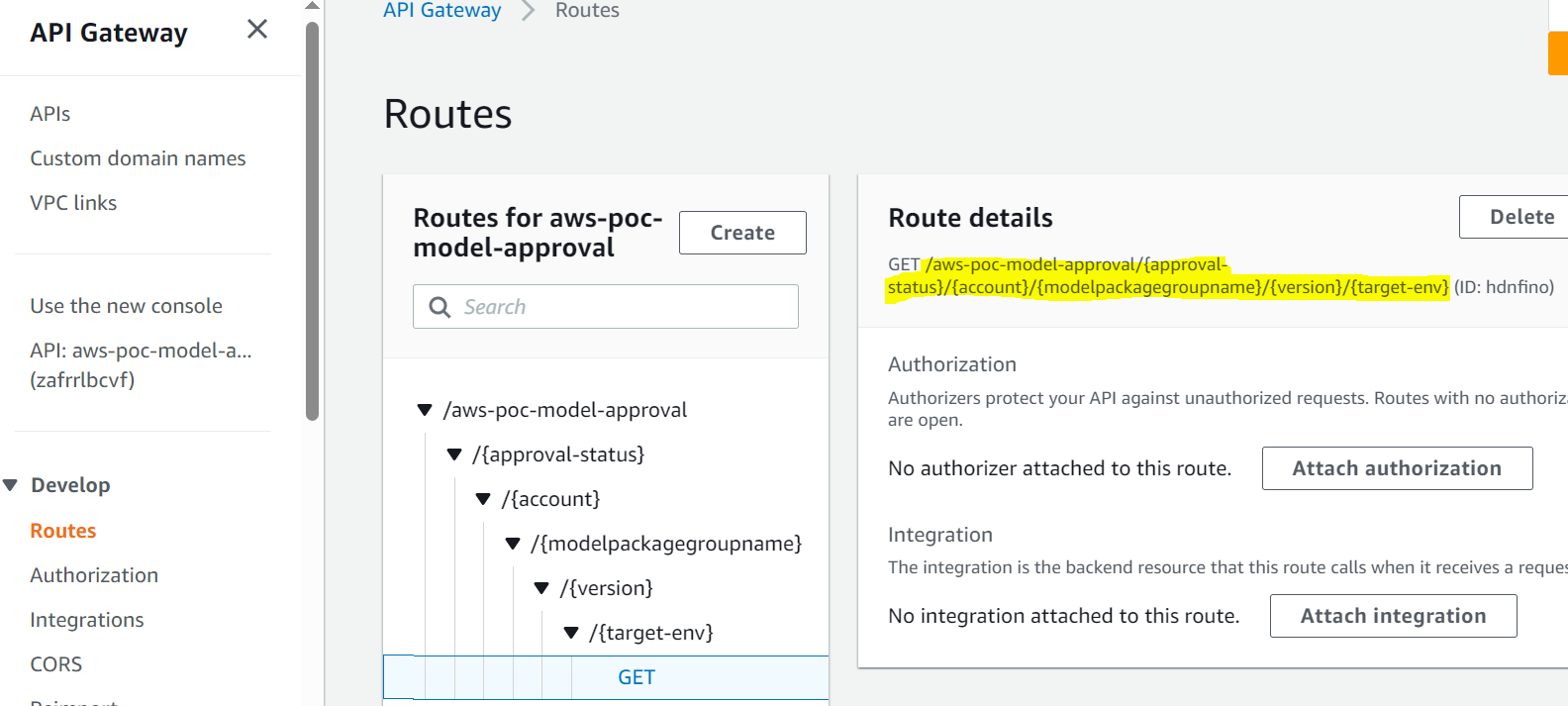

- 承認者は、電子メール内のリンクをたどって API Gateway エンドポイントにアクセスし、モデルを承認します。

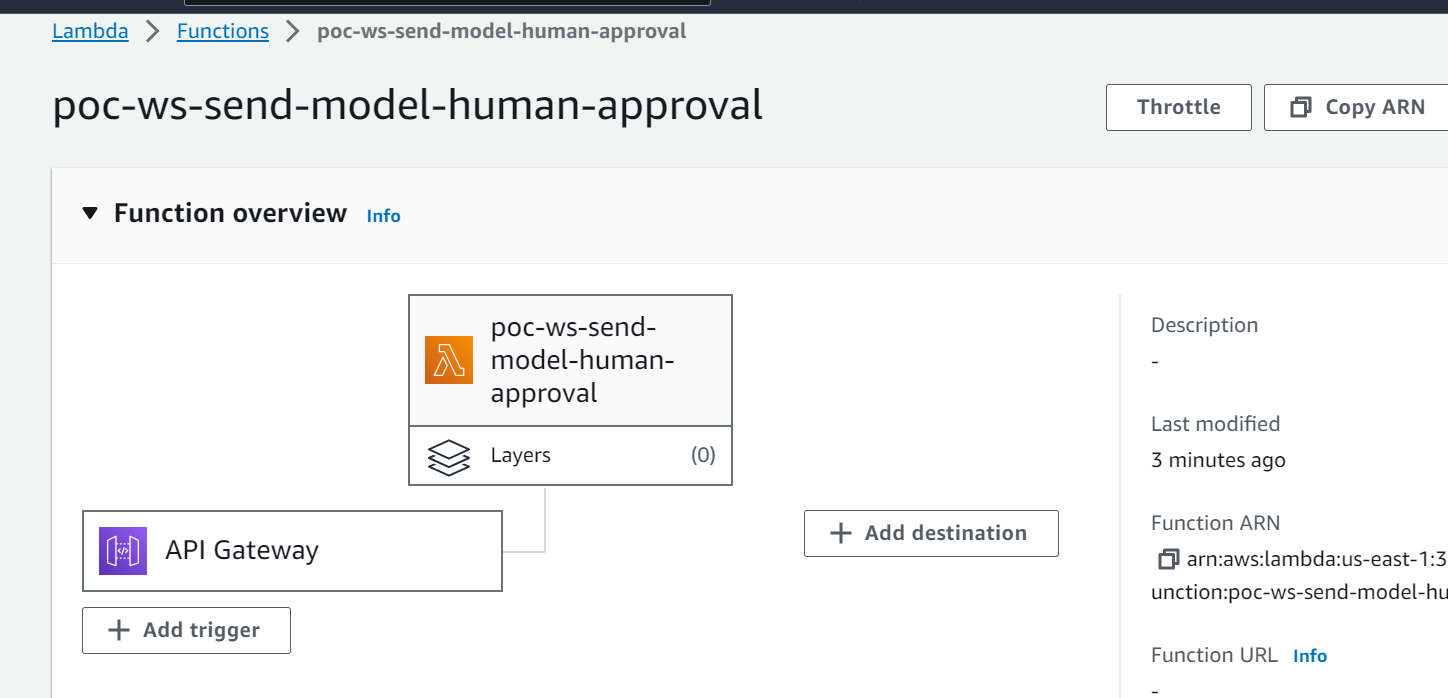

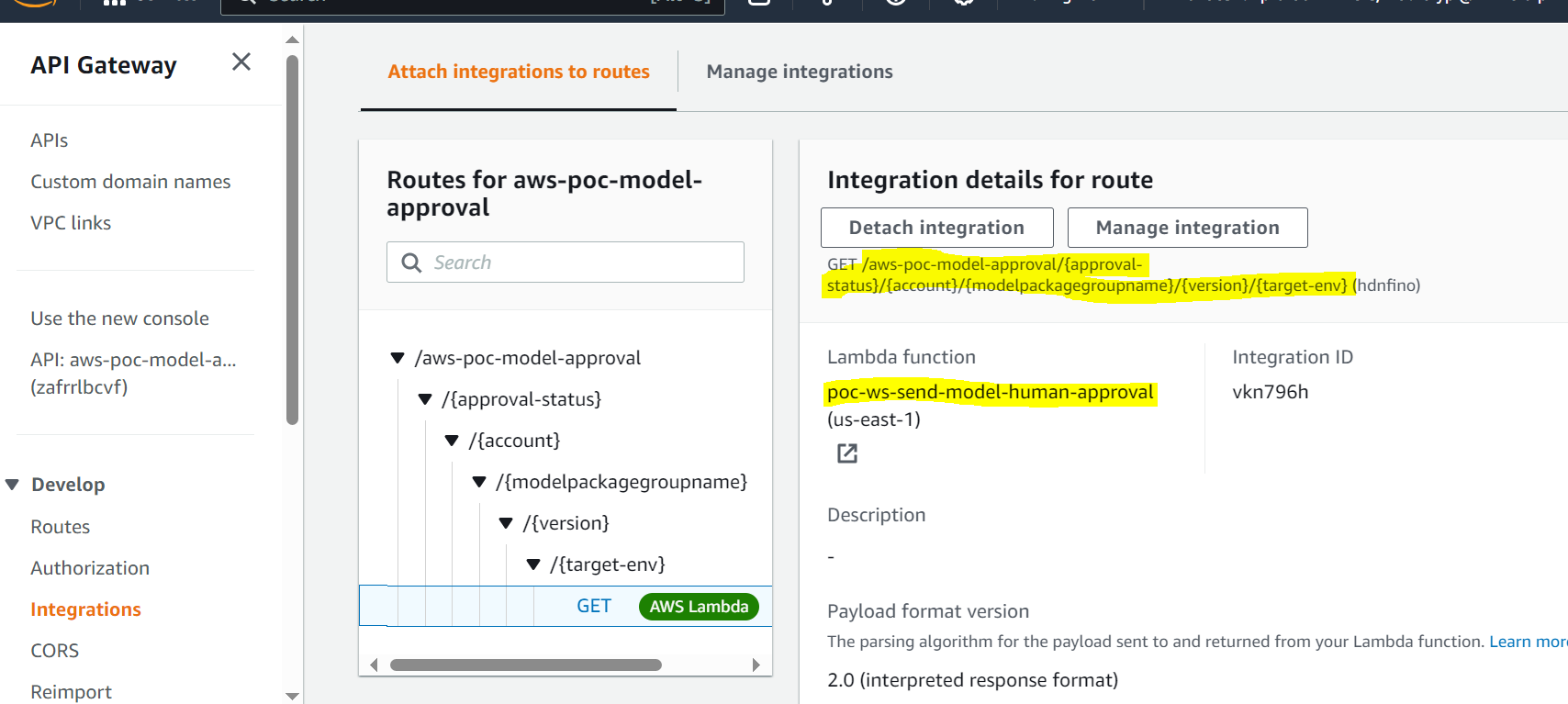

- API Gateway は Lambda 関数を呼び出してモデルの更新を開始します。

- モデル レジストリがモデル ステータスに更新されます (

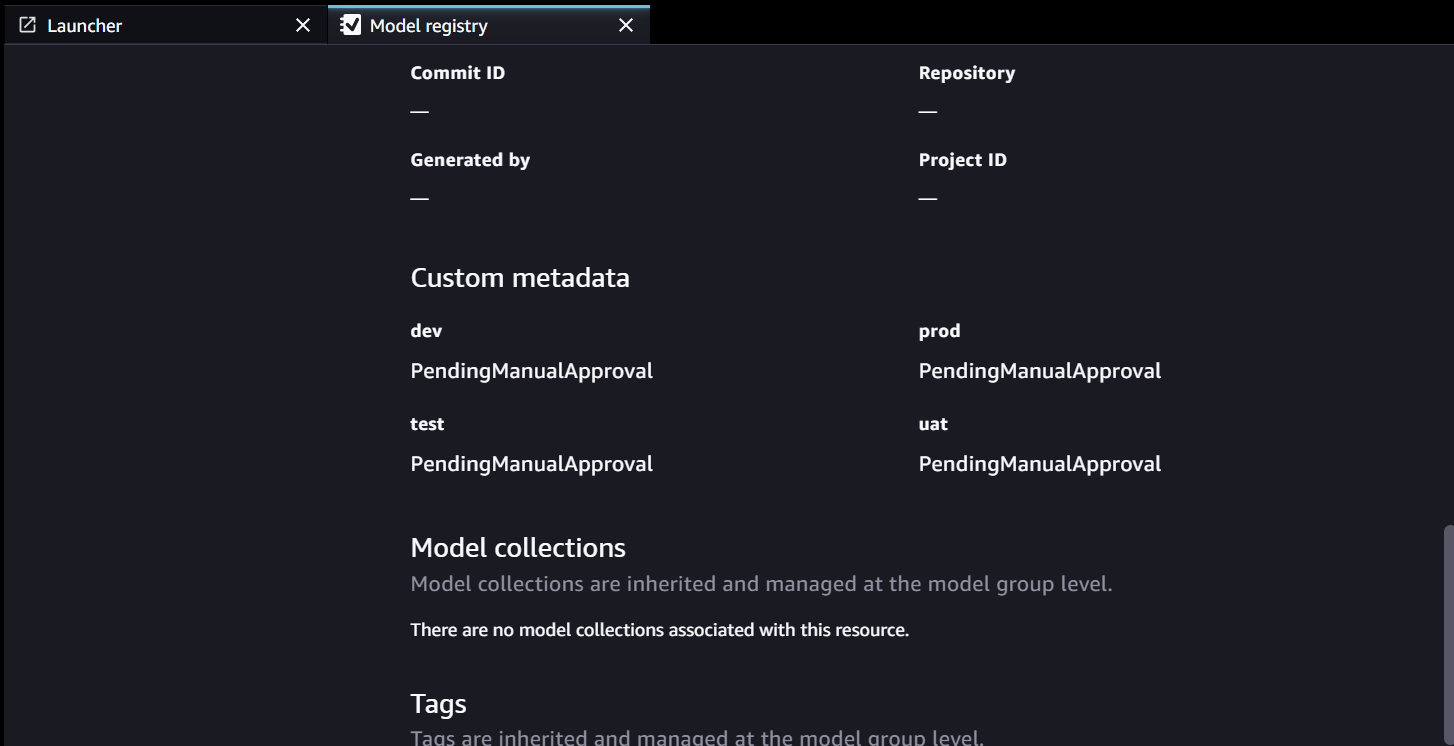

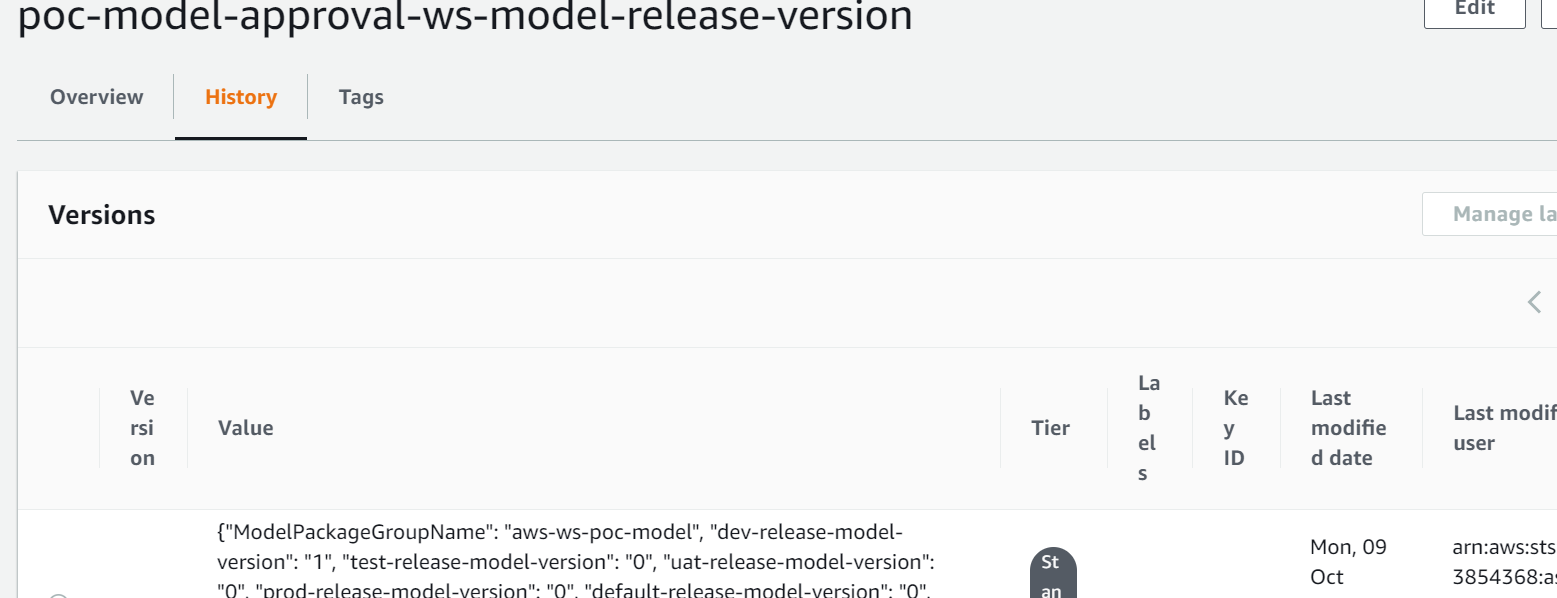

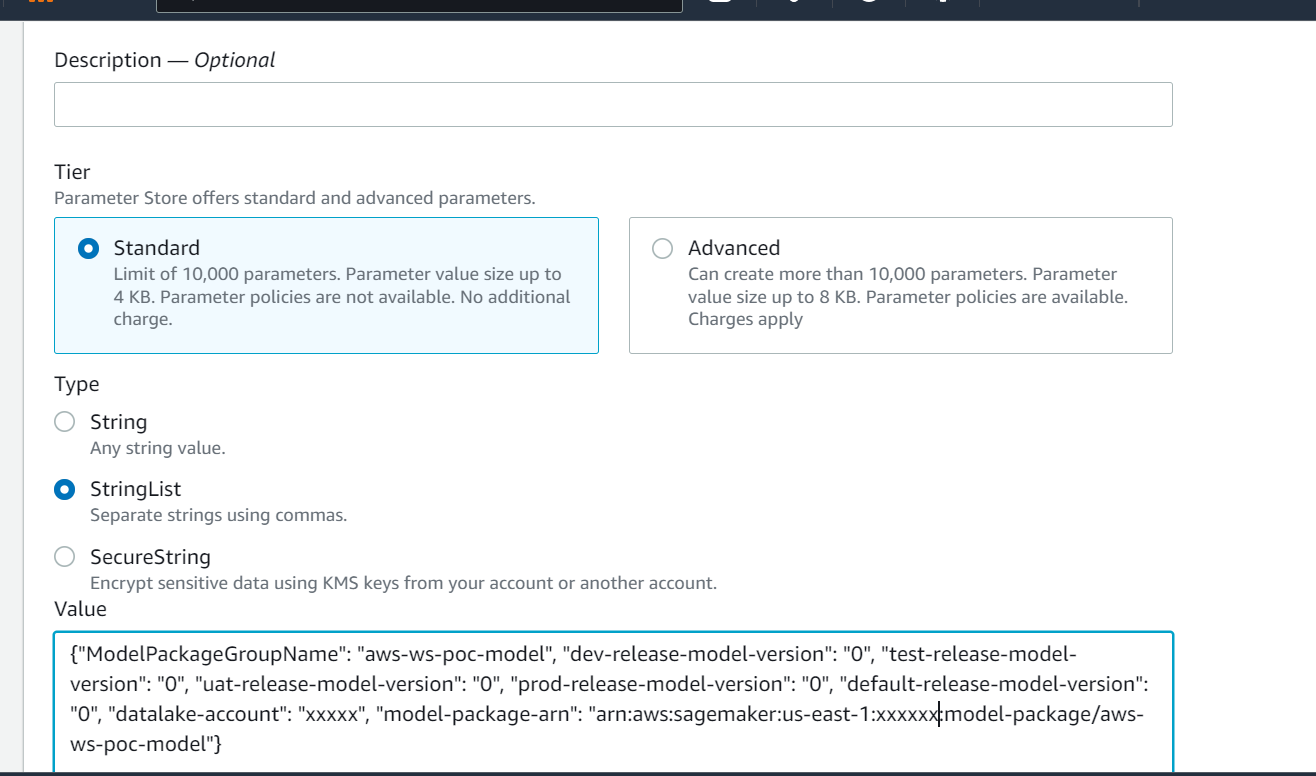

Approved開発環境の場合ですが、PendingManualApprovalテスト、UAT、実稼働用)。 - モデルの詳細は次の場所に保存されます。 AWSパラメータストア、の機能 AWS システム マネージャー、モデルのバージョン、承認されたターゲット環境、モデル パッケージを含みます。

- 推論パイプラインは、ターゲット環境用に承認されたモデルをパラメーター ストアから取得します。

- 推論後通知 Lambda 関数は、バッチ推論メトリクスを収集し、モデルを次の環境に昇格させるための電子メールを承認者に送信します。

前提条件

この投稿のワークフローは、トレーニング パイプラインの環境が他のリソースとともに SageMaker にセットアップされていることを前提としています。トレーニング パイプラインへの入力はフィーチャ データセットです。この投稿には特徴生成の詳細は含まれていませんが、トレーニング後の ML モデルのレジストリ、承認、プロモーションに焦点を当てています。モデルはモデル レジストリに登録され、監視フレームワークによって管理されます。 Amazon SageMakerモデルモニター ドリフトを検出し、モデルのドリフトが発生した場合には再トレーニングに進みます。

ワークフローの詳細

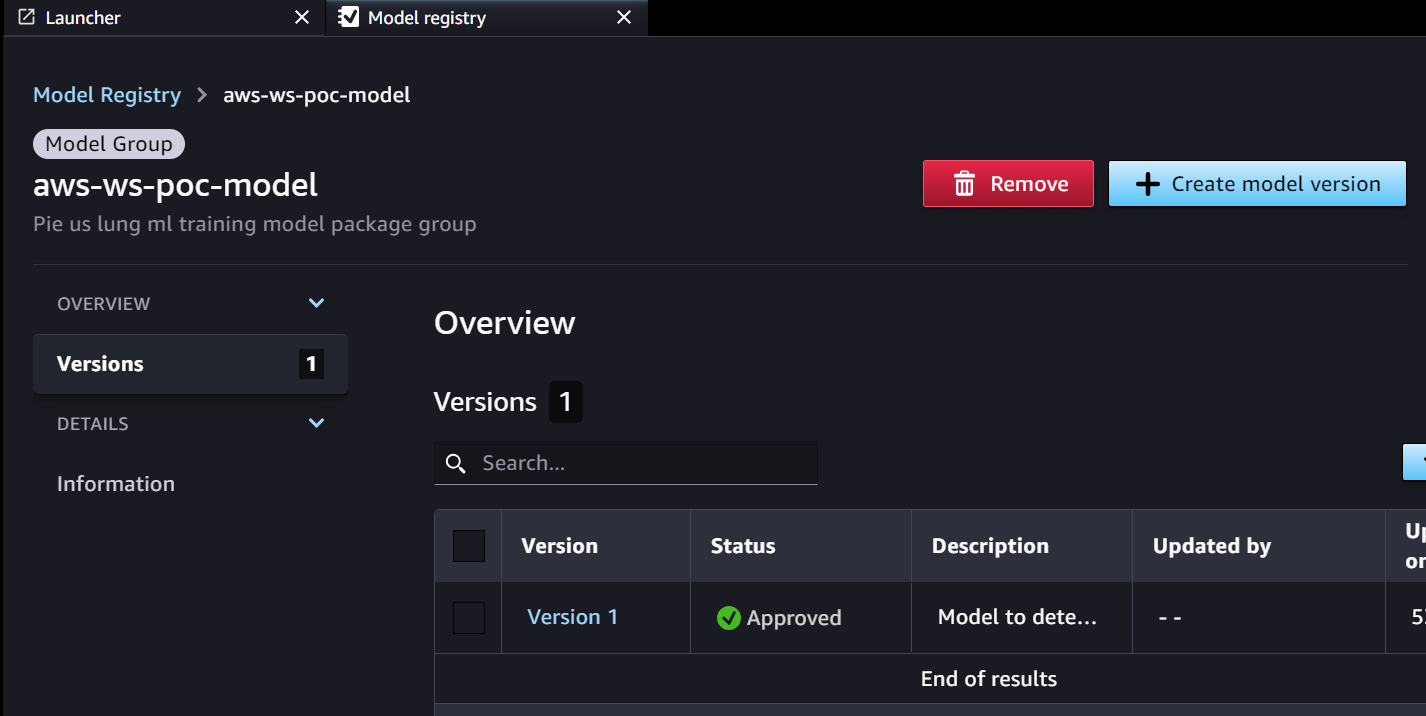

承認ワークフローは、トレーニング パイプラインから開発されたモデルから始まります。データ サイエンティストがモデルを開発するとき、モデル ステータスを SageMaker モデル レジストリに登録します。 PendingManualApproval。 EventBridge は SageMaker のモデル登録イベントを監視し、Lambda 関数を呼び出すイベント ルールをトリガーします。 Lambda 関数は、別の Lambda 関数への API Gateway エンドポイントへのリンクを含むモデルの承認用のメールを動的に作成します。承認者がリンクをたどってモデルを承認すると、API Gateway は承認アクションを Lambda 関数に転送し、SageMaker モデル レジストリとパラメータ ストアのモデル属性を更新します。承認者は認証されており、Active Directory によって管理される承認者グループの一員である必要があります。最初の承認では、モデルが次のようにマークされます。 Approved 開発者にとっては、しかし PendingManualApproval テスト、UAT、実稼働用。パラメーター ストアに保存されるモデル属性には、モデル バージョン、モデル パッケージ、承認されたターゲット環境が含まれます。

推論パイプラインがモデルをフェッチする必要がある場合、ターゲット環境で承認されている最新のモデル バージョンをパラメータ ストアで確認し、推論の詳細を取得します。推論パイプラインが完了すると、モデルを次の環境レベルに昇格させるための承認を求める推論後通知電子メールが関係者に送信されます。このメールには、モデルとメトリクスに関する詳細に加えて、モデル属性を更新する Lambda 関数の API Gateway エンドポイントへの承認リンクが含まれています。

以下は、モデルの作成から運用までの ML モデルの承認/プロモーション ワークフローの一連のイベントと実装手順です。モデルは、各ステップで人間による明示的な承認を得て、開発環境からテスト、UAT、実稼働環境にプロモートされます。

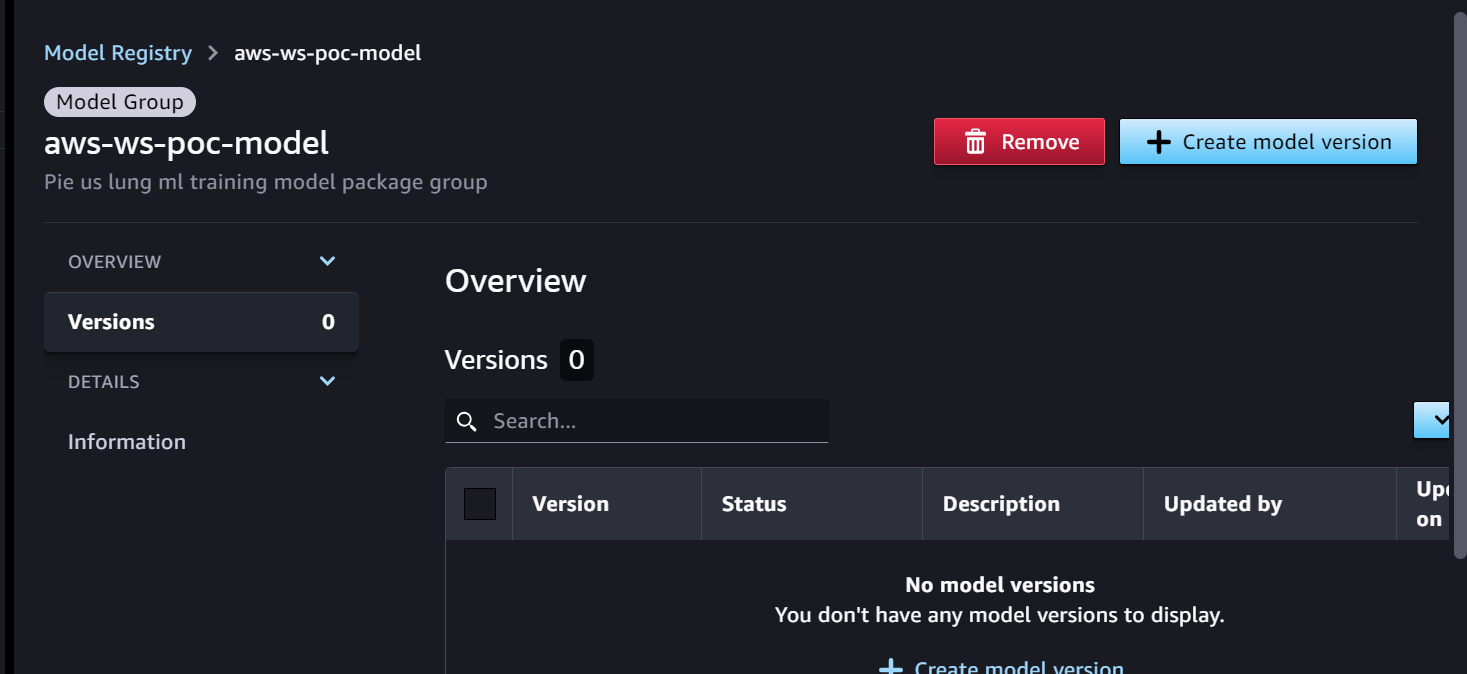

モデル開発の準備が整ったトレーニング パイプラインから始めます。モデルのバージョンは、SageMaker モデル レジストリでは 0 から始まります。

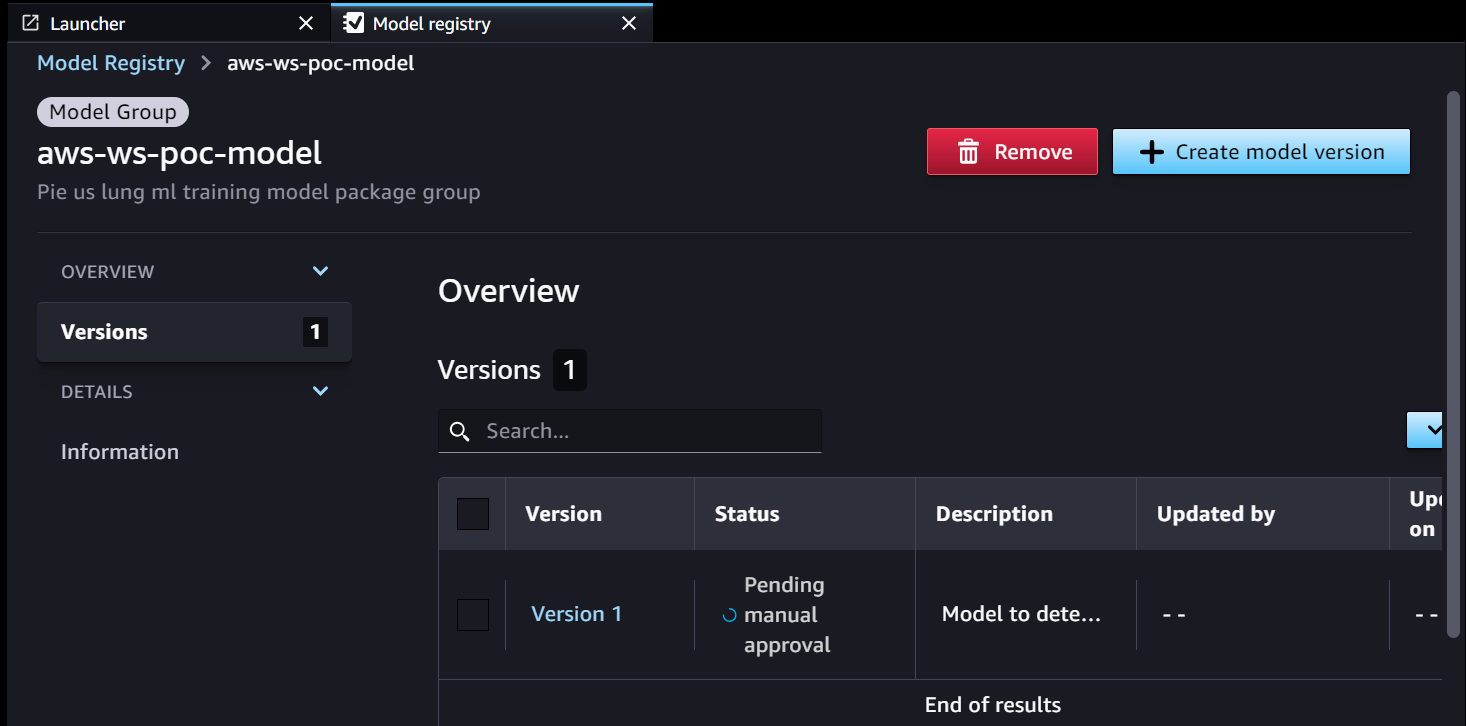

- SageMaker トレーニング パイプラインはモデルを開発し、SageMaker Model Registry に登録します。モデル バージョン 1 が登録されており、次で始まります。 手動承認待ち 状態。

モデル レジストリ メタデータには、環境用の 4 つのカスタム フィールドがあります。

モデル レジストリ メタデータには、環境用の 4 つのカスタム フィールドがあります。 dev, test, uat,prod.

- EventBridge は、SageMaker モデル レジストリのステータス変化を監視し、単純なルールで自動的にアクションを実行します。

- モデル登録イベントルールは、登録されたモデルを承認または拒否するためのリンクを含む電子メールを作成する Lambda 関数を呼び出します。

- 承認者は、モデルを確認して承認 (または拒否) するためのリンクが記載された電子メールを受け取ります。

- 承認者は、電子メール内の API Gateway エンドポイントへのリンクをクリックしてモデルを承認します。

- API Gateway は Lambda 関数を呼び出してモデルの更新を開始します。

- SageMaker モデル レジストリはモデルのステータスで更新されます。

- モデルのバージョン、承認されたターゲット環境、モデル パッケージなどのモデルの詳細情報はパラメーター ストアに保存されます。

- 推論パイプラインは、ターゲット環境用に承認されたモデルをパラメーター ストアから取得します。

- 推論後通知 Lambda 関数は、バッチ推論メトリクスを収集し、モデルを次の環境に昇格させるための電子メールを承認者に送信します。

- 承認者は、API Gateway エンドポイントへのリンクをたどることにより、次のレベルへのモデルの昇格を承認します。これにより、Lambda 関数がトリガーされ、SageMaker モデル レジストリとパラメータ ストアが更新されます。

モデルのバージョン管理と承認の完全な履歴は、レビューのためにパラメーター ストアに保存されます。

まとめ

大規模な ML モデルの開発ライフサイクルには、スケーラブルな ML モデルの承認プロセスが必要です。この投稿では、SageMaker Model Registry、EventBridge、API Gateway、Lambda を使用した人間の介入による ML モデル レジストリ、承認、プロモーションのワークフローの実装について共有しました。 MLOps プラットフォーム用のスケーラブルな ML モデル開発プロセスを検討している場合は、この投稿の手順に従って同様のワークフローを実装できます。

著者について

トム・キム 彼は AWS のシニア ソリューション アーキテクトであり、AWS でソリューションを開発することで顧客のビジネス目標の達成を支援しています。彼は、いくつかの業界、特にヘルスケアとライフ サイエンスのエンタープライズ システム アーキテクチャと運用に豊富な経験を持っています。トムは、顧客にとって望ましいビジネス成果につながる新しいテクノロジーを常に学んでいます。 AI/ML、GenAI、データ分析。彼はまた、時間を見つけては新しい場所に旅行したり、新しいゴルフコースでプレーしたりすることを楽しんでいます。

トム・キム 彼は AWS のシニア ソリューション アーキテクトであり、AWS でソリューションを開発することで顧客のビジネス目標の達成を支援しています。彼は、いくつかの業界、特にヘルスケアとライフ サイエンスのエンタープライズ システム アーキテクチャと運用に豊富な経験を持っています。トムは、顧客にとって望ましいビジネス成果につながる新しいテクノロジーを常に学んでいます。 AI/ML、GenAI、データ分析。彼はまた、時間を見つけては新しい場所に旅行したり、新しいゴルフコースでプレーしたりすることを楽しんでいます。

シャミカ・アリヤワンサアマゾン ウェブ サービス (AWS) のヘルスケアおよびライフ サイエンス部門でシニア AI/ML ソリューション アーキテクトを務めており、大規模言語モデル (LLM) トレーニング、推論の最適化、MLOps (機械学習) に重点を置いた生成 AI を専門としています。オペレーション)。彼は、顧客が高度な Generative AI をプロジェクトに組み込むようガイドし、効果的でスケーラブルな AI ソリューションのための堅牢なトレーニング プロセス、効率的な推論メカニズム、合理化された MLOps プラクティスを保証します。シャミカはプロとしての活動を超えて、スキーとオフロードの冒険を情熱的に追求しています。

シャミカ・アリヤワンサアマゾン ウェブ サービス (AWS) のヘルスケアおよびライフ サイエンス部門でシニア AI/ML ソリューション アーキテクトを務めており、大規模言語モデル (LLM) トレーニング、推論の最適化、MLOps (機械学習) に重点を置いた生成 AI を専門としています。オペレーション)。彼は、顧客が高度な Generative AI をプロジェクトに組み込むようガイドし、効果的でスケーラブルな AI ソリューションのための堅牢なトレーニング プロセス、効率的な推論メカニズム、合理化された MLOps プラクティスを保証します。シャミカはプロとしての活動を超えて、スキーとオフロードの冒険を情熱的に追求しています。

ジャヤディープ・パビセッティ Merck のシニア ML/データ エンジニアであり、ビジネス向けのデータ サイエンスと分析を可能にする ETL および MLOps ソリューションを設計および開発しています。彼は常に新しいテクノロジーを学び、新しい道を模索し、変化し続ける IT 業界に合わせて進化するために必要なスキルを習得することに熱心に取り組んでいます。余暇には、スポーツへの情熱を注ぐほか、旅行や新しい場所の探検が好きです。

ジャヤディープ・パビセッティ Merck のシニア ML/データ エンジニアであり、ビジネス向けのデータ サイエンスと分析を可能にする ETL および MLOps ソリューションを設計および開発しています。彼は常に新しいテクノロジーを学び、新しい道を模索し、変化し続ける IT 業界に合わせて進化するために必要なスキルを習得することに熱心に取り組んでいます。余暇には、スポーツへの情熱を注ぐほか、旅行や新しい場所の探検が好きです。

プラバカラン・マサイヤン Tiger Analytics LLC のシニア機械学習エンジニアであり、AWS でのモデル構築、トレーニング、検証、モニタリング、CICD、機械学習ソリューションの改善のためのソリューションを提供することで、顧客のビジネス目標の達成を支援しています。 Prabakaran は、顧客にとって望ましいビジネス成果につながる新しいテクノロジーを常に学習しています。 AI/ML、GenAI、GPT、LLM。彼はまた、時間があればクリケットをすることを楽しんでいます。

プラバカラン・マサイヤン Tiger Analytics LLC のシニア機械学習エンジニアであり、AWS でのモデル構築、トレーニング、検証、モニタリング、CICD、機械学習ソリューションの改善のためのソリューションを提供することで、顧客のビジネス目標の達成を支援しています。 Prabakaran は、顧客にとって望ましいビジネス成果につながる新しいテクノロジーを常に学習しています。 AI/ML、GenAI、GPT、LLM。彼はまた、時間があればクリケットをすることを楽しんでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/build-an-amazon-sagemaker-model-registry-approval-and-promotion-workflow-with-human-intervention/