Google は AI 研究の先駆者であり、次のような革新的なテクノロジーでオープンソース コミュニティに大きく貢献してきました。 TensorFlow, ベルト, T5、JAX、AlphaFold、および AlphaCode。この伝統を引き継ぎ、Google は、Gini モデルを強化したのと同じ研究とテクノロジーを活用して、責任ある AI 開発のために構築された LLM である Gemma を導入しました。

目次

ジェマ LLM とは何ですか?

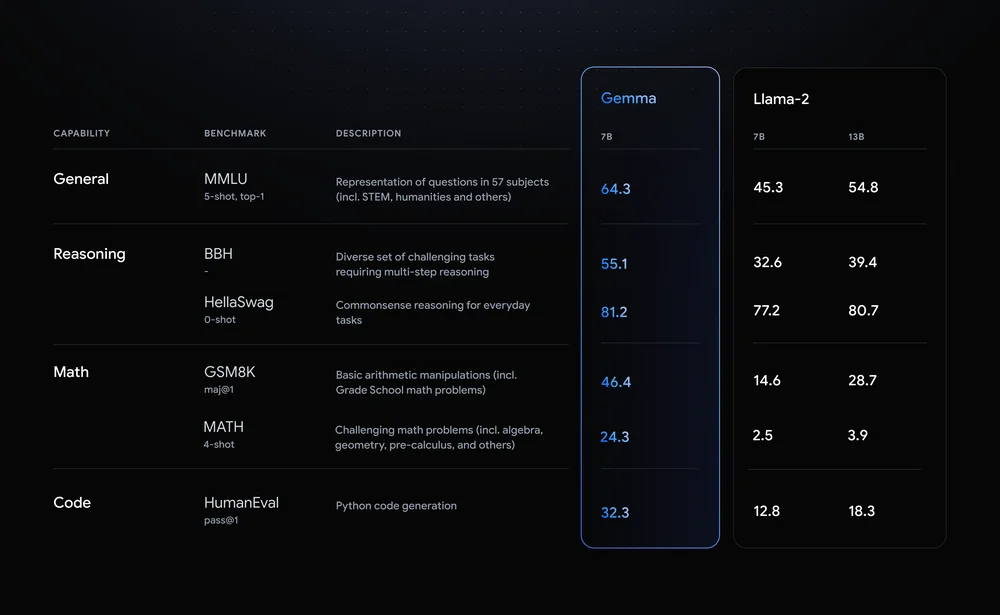

Gemma は、その優れたパフォーマンス指標で際立っています。これには 7 つのバリエーションがあり、2 つは 2 億のパラメータを持ち、もう 7 つは 64.3 億のパラメータを持ちます。 Meta の LLM、Llama 2 と比較すると、Gemma はさまざまなベンチマークにわたって優れた精度を示しています。たとえば、Gemma の XNUMX 億パラメータ モデルは XNUMX% の一般的な精度を誇り、推論、数学、その他のカテゴリでラマ XNUMX 世を上回っています。

Gemma LLM の機能のいくつかを見てみましょう。

- 軽量アーキテクチャ: Gemma には 2B と 7B の XNUMX つのサイズがあり、より大きなサイズのものよりも大幅に小さくなっています。これを翻訳すると、 推論速度が速くなり、計算量が少なくなります、パーソナルコンピュータやモバイルデバイスにも最適です。

- オープンソースの可用性: 多くの高性能 LLM とは異なり、Gemma のコードとパラメーターは自由に利用できるため、 開発者と研究者が実験、カスタマイズし、その進化に貢献する.

- 命令に合わせて調整されたバリアント: Gemma は、事前トレーニングされたモデルに加えて、質問応答や要約などの特定のタスクに最適化された「命令に調整された」バージョンを提供します。これ パフォーマンスと適応性を向上させます 現実世界のアプリケーション向け。

Gemma の影響は技術的な仕様を超えています。高度な LLM へのアクセスを民主化し、AI コミュニティ内でのイノベーションとコラボレーションを促進します。その潜在的な用途は、以下のようなさまざまな分野に及びます。 コード生成と科学研究のための個人生産性ツールとチャットボット。 Gemma 氏は、参入障壁を下げることで、自然言語処理の進歩を加速し、AI の未来を形作ることを約束しています。

Gemma のバリアントを詳しく調べる

Google のオープンソース LLM ファミリである Gemma は、多様なニーズに応える多彩なモデルを提供します。さまざまなサイズとバージョンを詳しく調べて、それぞれの強み、使用例、開発者向けの技術的な詳細を探ってみましょう。

サイズは重要です: ジェマの選択

- 2B: この軽量チャンピオンは、CPU やモバイル デバイスなどのリソースに制約のある環境で優れています。約 1.5GB のメモリ占有量と高速な推論速度により、テキスト分類や単純な質問応答などのタスクに最適です。

- 7B: 7B バリアントは、電力と効率のバランスを保ち、コンシューマー グレードの GPU と TPU に最適です。 5 GB のメモリ要件により、要約やコード生成などのより複雑なタスクが可能になります。

エンジンのチューニング: ベース vs. 命令チューニング

- ベース: トレーニング プロセスから出たばかりのこれらのモデルは、さまざまなアプリケーションに汎用の基盤を提供します。特定のタスクに合わせて微調整する必要がありますが、柔軟にカスタマイズできます。

- 命令に合わせて調整: 「要約」や「翻訳」などの特定の命令に基づいて事前トレーニングされたこれらのバリアントは、対象のタスクに対してすぐに使用できる使いやすさを提供します。指定されたドメインでのパフォーマンスを向上させるために、ある程度の汎用性を犠牲にします。

開発者向けの技術的な豆知識

- メモリ使用量: 2B モデルには約 1.5GB、7B モデルには約 5GB のメモリが必要です。微調整すると、このフットプリントがわずかに増加する可能性があります。

- 推論速度: 2B モデルは速度に優れ、リアルタイム アプリケーションに適しています。 7B モデルは、より大きな LLM と比較して高速な推論を提供しますが、より小さな兄弟モデルの速度には及ばない可能性があります。

- フレームワークの互換性: どちらのサイズも TensorFlow、PyTorch、JAX などの主要なフレームワークと互換性があるため、開発者は好みの環境を活用できます。

ニーズに合わせた適切な Gemma のマッチング

サイズとチューニングの選択は、特定の要件によって異なります。リソースに制約のあるシナリオや単純なタスクの場合、2B 基本モデルは優れた出発点となります。特定の領域でのパフォーマンスと複雑さを優先する場合は、7B 命令調整型が最適な選択肢となる可能性があります。どちらのサイズを微調整しても、独自の使用例に合わせてさらにカスタマイズできることに注意してください。

覚えておいてください: これは Gemma の亜種のほんの一部です。 Gemma は、その多様なオプションとオープンソースの性質により、開発者がさまざまなアプリケーションの可能性を探求し、解き放つことができるようにします。

Gemma を使い始める

Google の優れたオープンソース大規模言語モデル (LLM) ファミリーである Gemma は、開発者や研究者がすぐに AI の可能性を探求できる扉を開きます。どうすればできるか詳しく見てみましょう Gemma をインストールして実行する, 事前トレーニングされたモデルにアクセスする, 独自のアプリケーションを構築する その多彩な機能を活かして。

プラットフォームに依存しない: CPU、GPU、または TPU 上の Gemma

Gemma はプラットフォームの柔軟性を備えており、さまざまなハードウェア構成で実行できます。のために CPUベースのセットアップ、Hugging Face Transformers ライブラリと Google の Tensorflow Lite インタープリターは効率的なオプションを提供します。にアクセスできる場合は、 GPU または TPU、TensorFlow のフルパワーを活用してパフォーマンスを加速します。クラウドベースの導入の場合は、シームレスな統合とスケーラビリティを実現する Google Cloud Vertex AI を検討してください。

すぐに使えるモデルにアクセス

Gemma の事前トレーニング済みモデルにはさまざまなサイズと機能があり、多様なニーズに応えます。テキストの生成、翻訳、質問応答タスクでは、Gemma 2B および 7B バリアントは優れたパフォーマンスを提供します。さらに、Gemma 2B-FT や 7B-FT のような命令調整モデルは、独自のデータセットを微調整するために特別に設計されており、さらなるパーソナライゼーションを可能にします。

ジェマの能力を探る

Gemma を使用して構築できるいくつかのエキサイティングなアプリケーションを見てみましょう。

- 魅力的なストーリーテリング: テキスト生成機能を使用して、現実的で魅力的な物語を生成します。

- 言語翻訳が簡単に: Gemma の多言語能力を利用して、言語間でテキストをシームレスに翻訳します。

- 知識を明らかにする: 質問応答モデルを実装して、有益で洞察に満ちた応答を提供します。

- クリエイティブコンテンツの生成: 詩、スクリプト、コード生成を試して、クリエイティブ AI の限界を押し広げましょう。

微調整とカスタマイズ

Gemma の真の力は、その微調整機能にあります。独自のデータセットを活用してモデルを特定のニーズに合わせて調整し、比類のないパフォーマンスを実現します。提供されている参考記事には、微調整とカスタマイズに関する詳細な手順が記載されており、Gemma の可能性を最大限に引き出すことができます。

Gemma を使い始めるのはエキサイティングな旅です。 Gemma は、アクセスしやすい性質、多様な機能、活気のあるコミュニティ サポートにより、開発者と研究者の両方に可能性の世界を開きます。オープンソース LLM の世界に飛び込み、次の AI プロジェクトで Gemma の力を解き放ってください。

ジェマの未来

Gemma のオープンソースの性質と優れたパフォーマンスは、LLM コミュニティ内で大きな話題を引き起こしました。

しかし、この急成長するモデルファミリーの先には何が待っているのでしょうか?

- LLM ランドスケープの進歩: Gemma のオープンソースの性質により、コラボレーションとイノベーションが促進されます。世界中の研究者や開発者がその開発に貢献し、解釈可能性、公平性、効率性などの分野での進歩を加速できます。 Gemma が、テキストだけでなく画像、音声、ビデオも処理および生成できるマルチモーダル LLM の探求の先頭に立って進むかもしれません。

- 楽観的な見通し: Gemma は、その民主化アプローチと優れた機能により、AI を誰もが利用しやすく有益なものにするための重要な一歩を踏み出すことができます。開発が進むにつれて、さらに画期的なアプリケーションや進歩が期待できます。 Gemma のオープンソースの性質は、活気のあるコミュニティを促進し、その継続的な進化と LLM の将来への影響を確実にします。

まとめ

Gemma の LLM 業界への参入は、重要な転換点を示しています。大規模でリソースを大量に消費する他の製品とは異なり、Gemma はアクセシビリティと柔軟性を提供し、高度な AI 機能を幅広いユーザーが利用できるようにします。そのオープンソースの性質によりイノベーションとコラボレーションが促進され、自然言語処理の進歩が加速され、AI の未来が形成されます。

主要な取り組み

- 軽量かつオープンソース: Gemma はサイズが小さく、オープンな可用性であるため、さまざまなプラットフォームでアクセスできるため、個人や小規模な組織が AI の可能性を探求できるようになります。

- 多様なバリエーションと機能: Gemma は、複数のサイズと指示に合わせて調整されたオプションを備えており、基本的な質問応答から複雑なコンテンツの生成まで、さまざまなニーズに対応します。

- カスタマイズによる可能性の解放: 微調整機能により、ユーザーは Gemma を特定のニーズに合わせて調整し、さまざまな分野で新たな可能性を解き放つことができます。

- 活気に満ちたコミュニティと明るい未来: Gemma のオープンソースの性質は、協力的なコミュニティを促進し、解釈可能性、公平性、およびマルチモーダル機能の進歩を推進します。

重要なリンク

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/