Amazonas Grundgestein bietet eine breite Palette von Modellen von Amazon und Drittanbietern, darunter Anthropic, AI21, Meta, Cohere und Stability AI, und deckt ein breites Spektrum an Anwendungsfällen ab, darunter Text- und Bildgenerierung, Einbettung, Chat und hochrangige Agenten mit Argumentation und Orchestrierung und mehr. Wissensdatenbanken für Amazon Bedrock ermöglicht Ihnen die Erstellung leistungsstarker und maßgeschneiderter Retrieval Augmented Generation (RAG)-Anwendungen auf Basis von AWS und Vektorspeichern von Drittanbietern unter Verwendung von AWS- und Drittanbietermodellen. Knowledge Bases für Amazon Bedrock automatisiert die Synchronisierung Ihrer Daten mit Ihrem Vektorspeicher, einschließlich der Differenzierung der Daten bei Aktualisierungen, des Ladens und Chunkings von Dokumenten sowie der semantischen Einbettung. Damit können Sie Ihre RAG-Eingabeaufforderungen und Abrufstrategien nahtlos anpassen – wir stellen die Quellenangabe bereit und kümmern uns automatisch um die Speicherverwaltung. Knowledge Bases ist völlig serverlos, sodass Sie keine Infrastruktur verwalten müssen. Bei der Nutzung von Knowledge Bases werden Ihnen nur die Modelle, Vektordatenbanken und der Speicher berechnet, die Sie nutzen.

RAG ist eine beliebte Technik, die die Nutzung privater Daten mit großen Sprachmodellen (LLMs) kombiniert. RAG beginnt mit einem ersten Schritt zum Abrufen relevanter Dokumente aus einem Datenspeicher (meistens einem Vektorindex) basierend auf der Anfrage des Benutzers. Anschließend wird ein Sprachmodell verwendet, um eine Antwort zu generieren, indem sowohl die abgerufenen Dokumente als auch die ursprüngliche Abfrage berücksichtigt werden.

In diesem Beitrag zeigen wir, wie Sie mithilfe von Wissensdatenbanken für Amazon Bedrock einen RAG-Workflow für einen Anwendungsfall in der Arzneimittelforschung erstellen.

Übersicht über die Wissensdatenbanken für Amazon Bedrock

Knowledge Bases für Amazon Bedrock unterstützen eine breite Palette gängiger Dateitypen, darunter .txt, .docx, .pdf, .csv und mehr. Um einen effektiven Abruf privater Daten zu ermöglichen, besteht eine gängige Praxis darin, diese Dokumente zunächst in überschaubare Abschnitte aufzuteilen. Knowledge Bases hat eine standardmäßige Chunking-Strategie implementiert, die in den meisten Fällen gut funktioniert, damit Sie schneller loslegen können. Wenn Sie mehr Kontrolle wünschen, können Sie mit Knowledge Bases die Chunking-Strategie über eine Reihe vorkonfigurierter Optionen steuern. Sie können die maximale Tokengröße und das Ausmaß der Überlappung steuern, die zwischen den Blöcken erstellt werden soll, um einen kohärenten Kontext für die Einbettung bereitzustellen. Knowledge Bases für Amazon Bedrock verwaltet den Prozess der Synchronisierung von Daten aus Ihrem Amazon Simple Storage-Service (Amazon S3)-Bucket, teilt ihn in kleinere Teile auf, generiert Vektoreinbettungen und speichert die Einbettungen in einem Vektorindex. Dieser Prozess umfasst ein intelligentes Differenzierungs-, Durchsatz- und Fehlermanagement.

Zur Laufzeit wird ein Einbettungsmodell verwendet, um die Anfrage des Benutzers in einen Vektor umzuwandeln. Anschließend wird der Vektorindex abgefragt, um Dokumente zu finden, die der Anfrage des Benutzers ähneln, indem Dokumentvektoren mit dem Anfragevektor des Benutzers verglichen werden. Im letzten Schritt werden semantisch ähnliche Dokumente, die aus dem Vektorindex abgerufen wurden, als Kontext für die ursprüngliche Benutzeranfrage hinzugefügt. Beim Generieren einer Antwort für den Benutzer werden die semantisch ähnlichen Dokumente im Textmodell abgefragt, zusammen mit der Quellenangabe zur Nachvollziehbarkeit.

Knowledge Bases für Amazon Bedrock unterstützt mehrere Vektordatenbanken, darunter Amazon OpenSearch ohne Server, Amazonas-Aurora, Pinecone und Redis Enterprise Cloud. Mit den APIs „Retrieve“ und „RetrieveAndGenerate“ können Ihre Anwendungen den Index mithilfe einer einheitlichen Standardsyntax direkt abfragen, ohne dass für jede unterschiedliche Vektordatenbank separate APIs erlernt werden müssen. Dadurch verringert sich die Notwendigkeit, benutzerdefinierte Indexabfragen für Ihren Vektorspeicher zu schreiben. Die Retrieve-API nimmt die eingehende Abfrage entgegen, wandelt sie in einen Einbettungsvektor um und fragt den Backend-Speicher mithilfe der auf der Vektordatenbankebene konfigurierten Algorithmen ab. Die RetrieveAndGenerate-API verwendet ein vom Benutzer konfiguriertes LLM von Amazon Bedrock und generiert die endgültige Antwort in natürlicher Sprache. Die native Rückverfolgbarkeitsunterstützung informiert die anfragende Anwendung über die zur Beantwortung einer Frage verwendeten Quellen. Bei Unternehmensimplementierungen unterstützt Knowledge Bases AWS-Schlüsselverwaltungsservice (AWS KMS)-Verschlüsselung, AWS CloudTrail Integration und mehr.

In den folgenden Abschnitten zeigen wir, wie Sie mithilfe von Knowledge Bases für Amazon Bedrock und der OpenSearch Serverless-Vektor-Engine einen RAG-Workflow erstellen, um einen unstrukturierten Datensatz einer klinischen Studie für einen Anwendungsfall in der Arzneimittelforschung zu analysieren. Diese Daten sind reich an Informationen, können jedoch äußerst heterogen sein. Der richtige Umgang mit Fachterminologie und Konzepten in unterschiedlichen Formaten ist entscheidend, um Erkenntnisse zu gewinnen und die analytische Integrität sicherzustellen. Mit Knowledge Bases für Amazon Bedrock können Sie durch einfache, natürliche Abfragen auf detaillierte Informationen zugreifen.

Erstellen Sie eine Wissensdatenbank für Amazon Bedrock

In diesem Abschnitt demonstrieren wir den Prozess der Erstellung einer Wissensdatenbank für Amazon Bedrock über die Konsole. Führen Sie die folgenden Schritte aus:

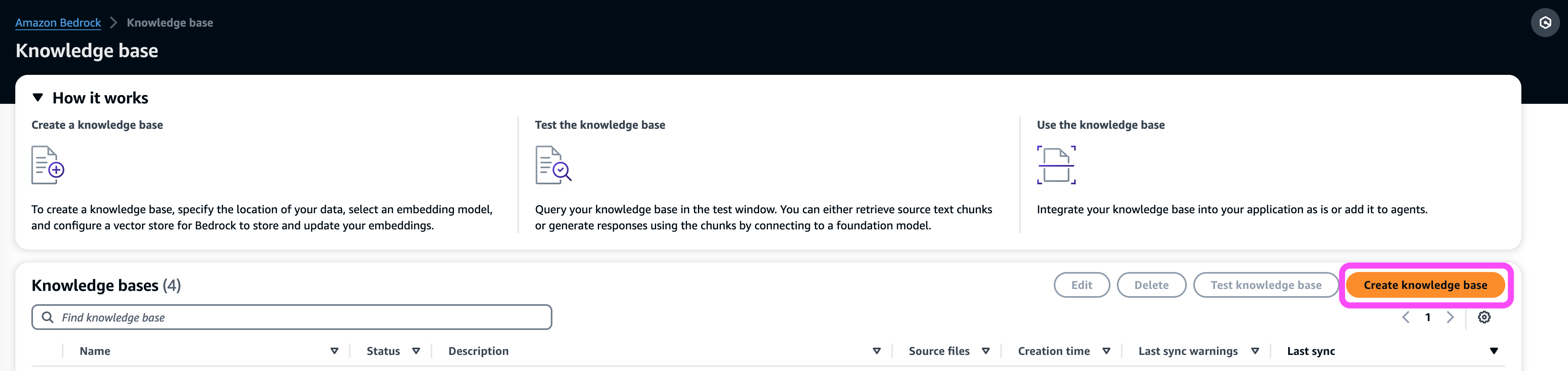

- Auf der Amazon Bedrock-Konsole unter Besetzung Wählen Sie im Navigationsbereich Wissensbasis.

- Auswählen Wissensbasis schaffen.

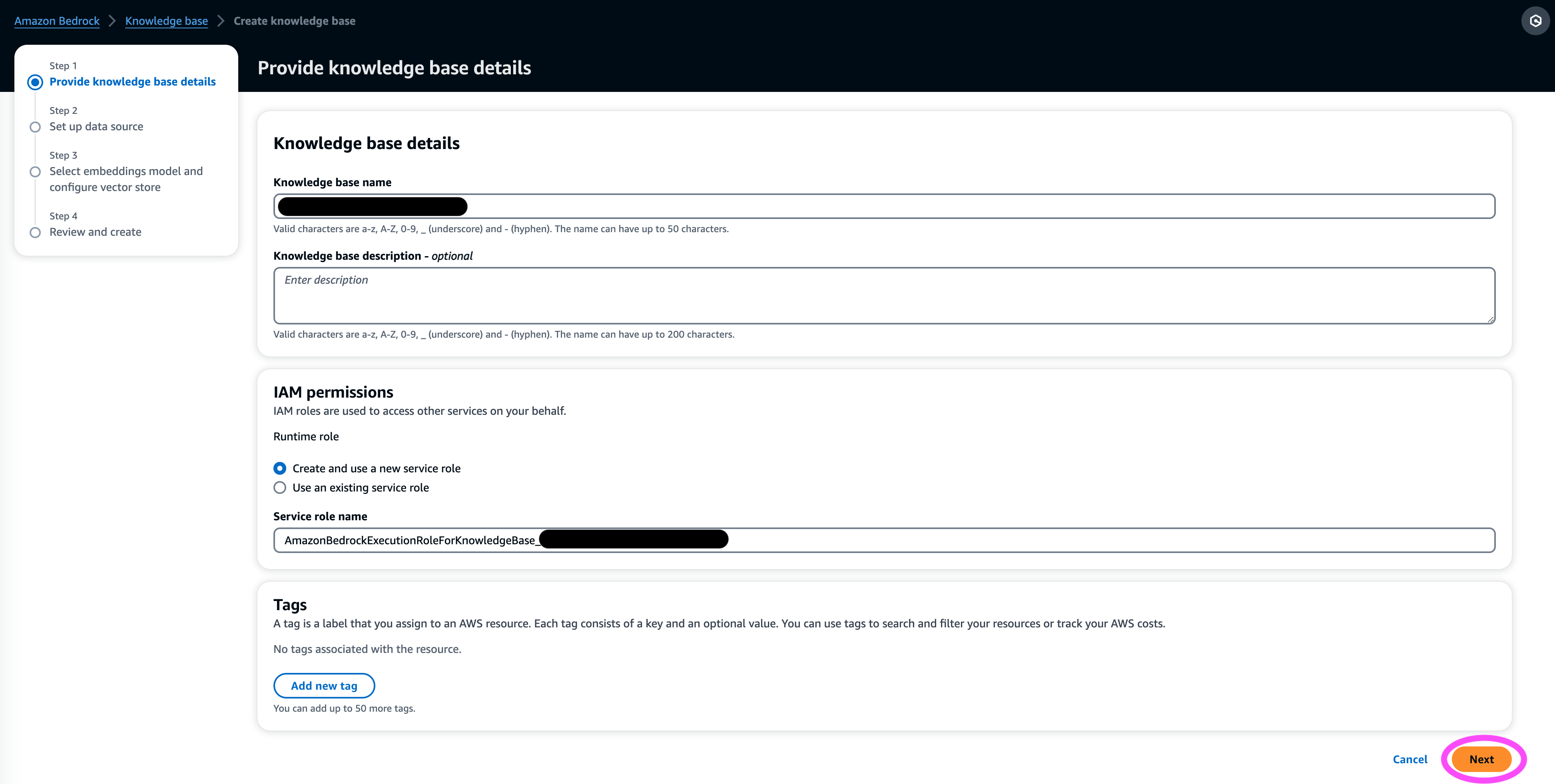

- Im Details zur Wissensdatenbank Geben Sie im Abschnitt einen Namen und optional eine Beschreibung ein.

- Im IAM-Berechtigungen Abschnitt auswählen Erstellen und verwenden Sie eine neue Servicerolle.

- Aussichten für Rolle des DienstnamensGeben Sie einen Namen für Ihre Rolle ein, der mit beginnen muss

AmazonBedrockExecutionRoleForKnowledgeBase_. - Auswählen Weiter.

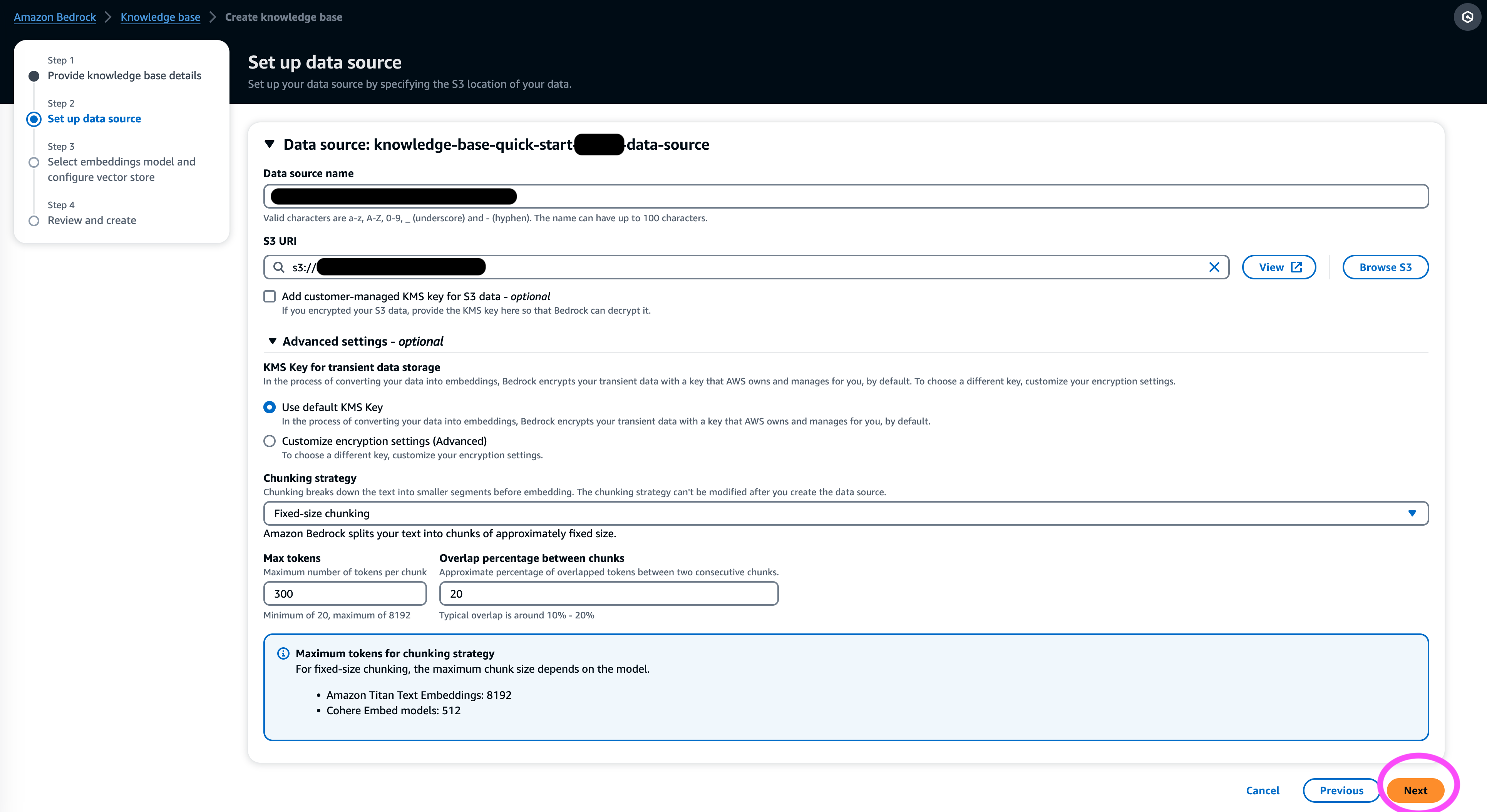

- Im Datenquelle Geben Sie im Abschnitt einen Namen für Ihre Datenquelle und den S3-URI ein, in dem sich der Datensatz befindet. Knowledge Bases unterstützt die folgenden Dateiformate:

- Nur-Text (.txt)

- Abschlag (.md)

- HyperText Markup Language (.html)

- Microsoft Word-Dokument (.doc/.docx)

- Durch Kommas getrennte Werte (.csv)

- Microsoft Excel-Tabelle (.xls/.xlsx)

- Portables Dokumentenformat (.pdf)

- Der Weitere Einstellungen¸ Wählen Sie Ihre bevorzugte Chunking-Strategie (für diesen Beitrag wählen wir Chunking mit fester Größe) und geben Sie die Blockgröße und die Überlagerung in Prozent an. Alternativ können Sie die Standardeinstellungen verwenden.

- Auswählen Weiter.

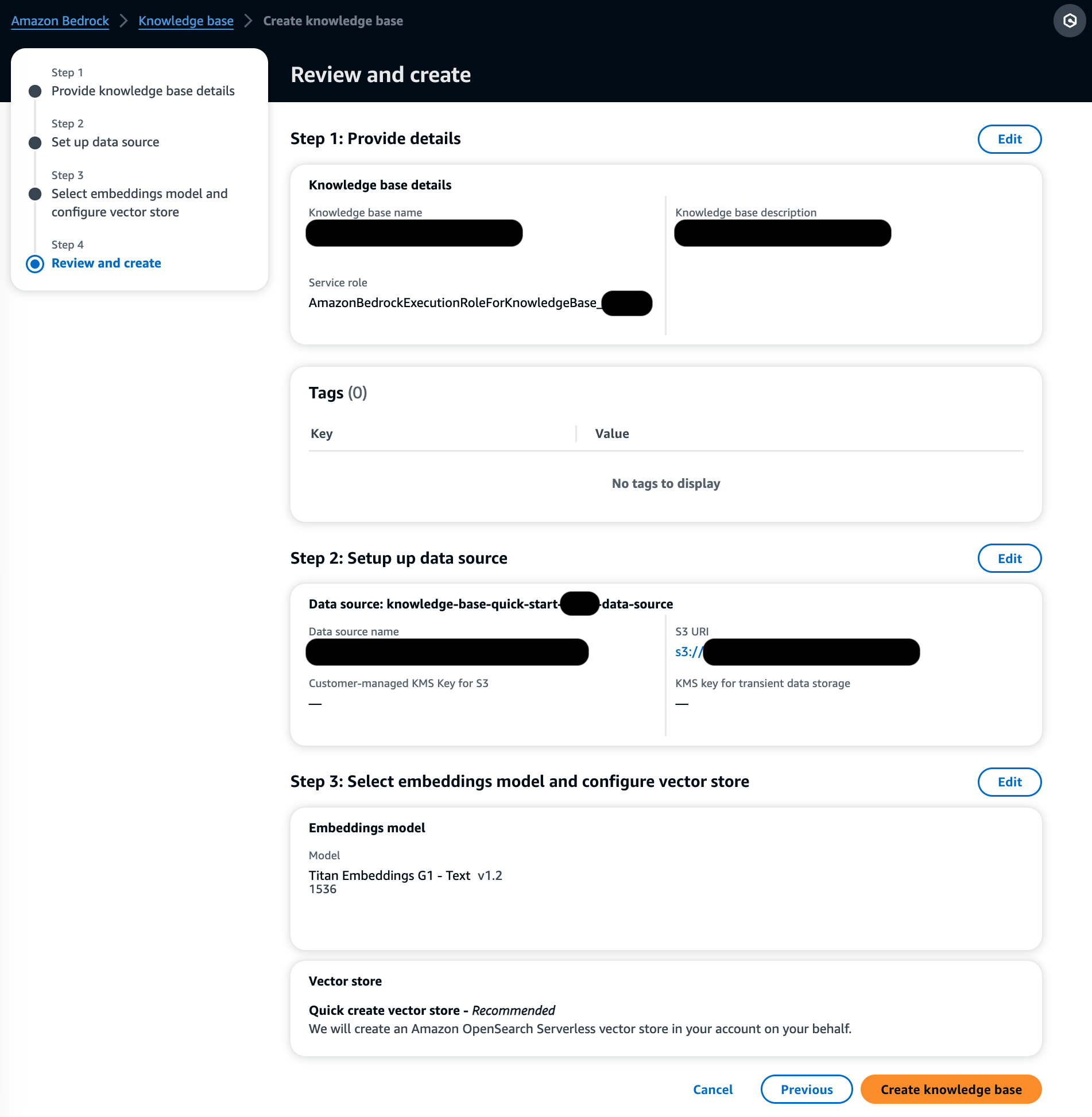

- Im Einbettungsmodell Wählen Sie im Abschnitt „Titan Embeddings“ das Modell „Titan Embeddings“ von Amazon Bedrock aus.

- Im Vektordatenbank Abschnitt auswählen Erstellen Sie schnell einen neuen Vektorspeicher, das den Prozess der Einrichtung eines Vektorspeichers verwaltet.

- Auswählen Weiter.

- Überprüfen Sie die Einstellungen und wählen Sie Wissensbasis schaffen.

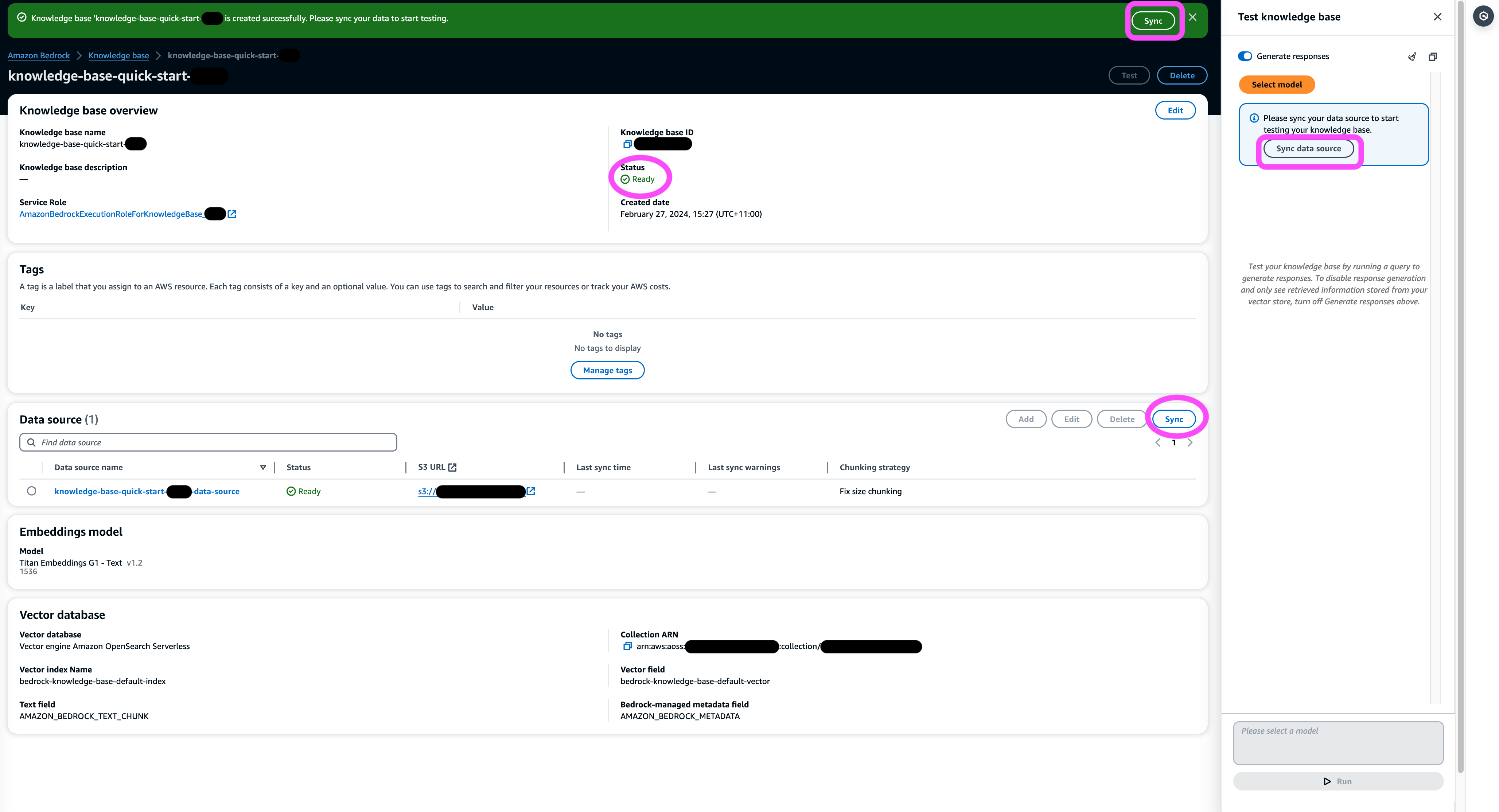

- Warten Sie, bis die Erstellung der Wissensdatenbank abgeschlossen ist, und bestätigen Sie, dass der Status lautet Bereit.

- Im Datenquelle Wählen Sie im Abschnitt „Testen“ oder im Banner oben auf der Seite oder im Popup im Testfenster die Option aus Synchronisierung um den Prozess des Ladens von Daten aus dem S3-Bucket, der Aufteilung in Blöcke der von Ihnen angegebenen Größe, der Generierung von Vektoreinbettungen mithilfe des ausgewählten Texteinbettungsmodells und der Speicherung dieser Daten im von Knowledge Bases für Amazon Bedrock verwalteten Vektorspeicher auszulösen.

Die Synchronisierungsfunktion unterstützt das Aufnehmen, Aktualisieren und Löschen der Dokumente aus dem Vektorindex basierend auf Änderungen an Dokumenten in Amazon S3. Sie können auch die verwenden StartIngestionJob API zum Auslösen der Synchronisierung über das AWS SDK.

Wenn die Synchronisierung abgeschlossen ist, wird im Synchronisierungsverlauf der Status angezeigt Abgeschlossen.

Fragen Sie die Wissensdatenbank ab

In diesem Abschnitt zeigen wir, wie Sie durch einfache und natürliche Abfragen auf detaillierte Informationen in der Wissensdatenbank zugreifen können. Wir verwenden einen unstrukturierten synthetischen Datensatz, der aus PDF-Dateien besteht, deren Seitenzahl jeweils zwischen 10 und 100 Seiten liegt, und einen klinischen Studienplan für ein vorgeschlagenes neues Medikament einschließlich statistischer Analysemethoden und Einverständniserklärungen der Teilnehmer simulieren. Wir nutzen die Wissensdatenbanken für Amazon Bedrock retrieve_and_generate und retrieve APIs mit Amazon Bedrock LangChain-Integration.

Bevor Sie Skripte schreiben können, die die Amazon Bedrock-API verwenden, müssen Sie die entsprechende Version des AWS SDK in Ihrer Umgebung installieren. Bei Python-Skripten ist dies das AWS SDK für Python (Boto3):

Aktivieren Sie außerdem den Zugriff auf das Amazon Titan Embeddings-Modell und Anthropic Claude v2 oder v1. Weitere Informationen finden Sie unter Modellzugriff.

Generieren Sie Fragen mit Amazon Bedrock

Wir können Anthropic Claude 2.1 für Amazon Bedrock verwenden, um eine Liste von Fragen vorzuschlagen, die im Datensatz der klinischen Studie gestellt werden sollen:

Verwenden Sie die Amazon Bedrock RetrieveAndGenerate-API

Für ein vollständig verwaltetes RAG-Erlebnis können Sie die nativen Wissensdatenbanken für Amazon Bedrock verwenden RetrieveAndGenerate API, um die Antworten direkt zu erhalten:

Die zitierte Informationsquelle kann über den folgenden Code abgerufen werden (wobei einige der Ausgaben der Kürze halber geschwärzt wurden):

Durch Übergabe der Sitzungs-ID des RetrieveAndGenerate Mit der API können Sie den Konversationskontext beibehalten und Folgefragen stellen. Wenn Sie beispielsweise ohne den Kontext nach weiteren Details aus der vorherigen Antwort fragen, kann diese möglicherweise nicht richtig antworten:

Durch die Übergabe der Sitzungs-ID ist die RAG-Pipeline jedoch in der Lage, den entsprechenden Kontext zu identifizieren und relevante Antworten zurückzugeben:

Die folgende Tabelle zeigt die abgerufenen Antworten auf alle entsprechenden Fragen.

| Fragen (FAQ) | Antworten |

| Was ist der Zweck der Studie? Stellen Sie sicher, dass Sie die Ziele der Forschung verstehen und wissen, was die Studienabläufe beinhalten. | Der Zweck der Studie besteht darin, zu testen, ob Lithium wiederholte selbstmörderische Gewalt bei Patienten mit Depressionen oder bipolarer Störung wirksam verhindert. |

| Was sind die Risiken und potenziellen Vorteile? Das Formular sollte alle vorhersehbaren Risiken, Nebenwirkungen oder Beschwerden erläutern, die bei der Teilnahme auftreten könnten. | Zu den möglichen Risiken oder Unannehmlichkeiten gehören: die Interviewfragen, die Unbehagen hervorrufen, Nebenwirkungen des Lithium-Medikaments wie Übelkeit, weicher Stuhlgang, Durst, Veränderungen beim Wasserlassen, Zittern, Kopfschmerzen, Schwitzen, Müdigkeit, verminderte Konzentration, Hautausschlag, Schilddrüsenveränderungen, sich verschlimmernde Akne /Psoriasis, Lithiumtoxizität und Risiken, wenn das Medikament plötzlich abgesetzt wird. Die potenziellen Vorteile bestehen darin, dass die Tests zu neuen Informationen führen können, die dem Teilnehmer helfen können, und dass Lithium dazu beitragen kann, wiederholte selbstmörderische Gewalt bei Menschen mit Depressionen oder bipolarer Störung zu verhindern. |

| Was beinhaltet die Teilnahme? Informieren Sie sich darüber, welche Tests, Medikamente, Änderungen Ihres Lebensstils oder Verfahren Sie durchführen werden, wie lange es dauern wird und wie lange die Studie dauern wird. | Zur Teilnahme gehört das Ausfüllen eines Interviews und von Fragebögen zu den Themen Denken, Verhalten, psychische Gesundheitsbehandlung, Medikamente, Alkohol- und Drogenkonsum, häusliche und soziale Unterstützung sowie das Verständnis der Forschungsstudie. Dies dauert etwa zwei Stunden und kann in mehreren Sitzungen persönlich und telefonisch durchgeführt werden. Wenn Sie sich für die vollständige Studie qualifizieren, finden im Laufe eines Jahres etwa 20 Studienbesuche statt. Dazu gehört die Einnahme von Studienmedikamenten, die Überprüfung der Vitalfunktionen, das Ausfüllen von Fragebögen, die Überprüfung von Nebenwirkungen und die Fortsetzung der normalen medizinischen und psychischen Gesundheitsfürsorge. |

| Fallen Kosten oder Zahlungen an? Fragen Sie, ob Sie für die Kosten im Zusammenhang mit der Studie aufkommen oder für die Teilnahme bezahlt werden. | Ja, in den Suchergebnissen werden Kosten und Zahlungen besprochen. Für Behandlungen oder Eingriffe, die Teil der Studie sind, werden Ihnen keine Kosten berechnet. Sie müssen jedoch weiterhin die üblichen VA-Zuzahlungen für Pflege und Medikamente zahlen, die nicht im Zusammenhang mit der Studie stehen. Für die Teilnahme erhalten Sie kein Geld, aber die Studie erstattet die mit der Teilnahme verbundenen Kosten wie Transport, Parken usw. Die Erstattungsbeträge und das Verfahren werden angegeben. |

| Wie wird meine Privatsphäre geschützt? Das Formular sollte erläutern, wie Ihre persönlichen Gesundheitsdaten vor, während und nach der Verhandlung vertraulich behandelt werden. | Ihre Privatsphäre wird geschützt, indem Sie Interviews privat führen, schriftliche Notizen in verschlossenen Akten und Büros aufbewahren, elektronische Informationen in verschlüsselten und passwortgeschützten Dateien speichern und eine Vertraulichkeitsbescheinigung vom Ministerium für Gesundheit und Soziale Dienste erhalten, um die Offenlegung von Informationen zu verhindern, die Sie identifizieren . Informationen, die Sie identifizieren, können an Ärzte weitergegeben werden, die für Ihre Behandlung verantwortlich sind, oder für Prüfungen und Bewertungen durch Regierungsbehörden. Durch Vorträge und Papiere über die Studie werden Sie jedoch nicht identifiziert. |

Abfrage mit der Amazon Bedrock Retrieve API

Um Ihren RAG-Workflow anzupassen, können Sie die Retrieve-API verwenden, um die relevanten Blöcke basierend auf Ihrer Abfrage abzurufen und an jedes von Amazon Bedrock bereitgestellte LLM weiterzuleiten. Um die Retrieve-API zu verwenden, definieren Sie sie wie folgt:

Rufen Sie den entsprechenden Kontext ab (wobei einige der Ausgaben der Kürze halber geschwärzt wurden):

Extrahieren Sie den Kontext für die Eingabeaufforderungsvorlage:

Importieren Sie die Python-Module, richten Sie die Vorlage für die Eingabeaufforderung für kontextbezogene Fragen und Antworten ein und generieren Sie dann die endgültige Antwort:

Abfrage mithilfe der Amazon Bedrock LangChain-Integration

Um eine durchgängige, individuelle Frage-und-Antwort-Anwendung zu erstellen, bietet Knowledge Bases für Amazon Bedrock eine Integration mit LangChain. Um den LangChain-Retriever einzurichten, geben Sie die Wissensdatenbank-ID an und geben Sie die Anzahl der Ergebnisse an, die von der Abfrage zurückgegeben werden sollen:

Richten Sie nun LangChain RetrievalQA ein und generieren Sie Antworten aus der Wissensdatenbank:

Dadurch werden entsprechende Antworten generiert, die denen in der vorherigen Tabelle ähneln.

Aufräumen

Stellen Sie sicher, dass Sie die folgenden Ressourcen löschen, um zusätzliche Kosten zu vermeiden:

Zusammenfassung

Amazon Bedrock bietet eine breite Palette tief integrierter Dienste zur Unterstützung von RAG-Anwendungen aller Größenordnungen, sodass Sie problemlos mit der Analyse Ihrer Unternehmensdaten beginnen können. Wissensdatenbanken für Amazon Bedrock lassen sich in Amazon Bedrock-Grundlagenmodelle integrieren, um skalierbare Dokumenteinbettungspipelines und Dokumentenabrufdienste zu erstellen, die eine breite Palette interner und kundenorientierter Anwendungen unterstützen. Wir sind gespannt auf die Zukunft und Ihr Feedback wird eine entscheidende Rolle bei der Weiterentwicklung dieses Produkts spielen. Weitere Informationen zu den Funktionen von Amazon Bedrock und den Wissensdatenbanken finden Sie unter Wissensdatenbank für Amazon Bedrock.

Über die Autoren

Markus Roy ist Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von KI/ML-Lösungen. Marks Arbeit deckt ein breites Spektrum von ML-Anwendungsfällen ab, wobei sein Hauptinteresse an Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen liegt. Er hat Unternehmen in vielen Branchen unterstützt, darunter Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification. Bevor er zu AWS kam, war Mark über 25 Jahre lang als Architekt, Entwickler und Technologieführer tätig, davon 19 Jahre im Finanzdienstleistungsbereich.

Markus Roy ist Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von KI/ML-Lösungen. Marks Arbeit deckt ein breites Spektrum von ML-Anwendungsfällen ab, wobei sein Hauptinteresse an Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen liegt. Er hat Unternehmen in vielen Branchen unterstützt, darunter Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification. Bevor er zu AWS kam, war Mark über 25 Jahre lang als Architekt, Entwickler und Technologieführer tätig, davon 19 Jahre im Finanzdienstleistungsbereich.

Mani Chanuja ist Tech Lead – Generative AI Specialists, Autorin des Buches „Applied Machine Learning and High Performance Computing on AWS“ und Mitglied des Vorstands der Women in Manufacturing Education Foundation. Sie leitet Projekte zum maschinellen Lernen (ML) in verschiedenen Bereichen wie Computer Vision, Verarbeitung natürlicher Sprache und generative KI. Sie hilft Kunden dabei, große Modelle für maschinelles Lernen in großem Maßstab zu erstellen, zu trainieren und bereitzustellen. Sie spricht auf internen und externen Konferenzen wie re:Invent, Women in Manufacturing West, YouTube-Webinaren und GHC 23. In ihrer Freizeit geht sie gerne lange Läufe am Strand entlang.

Mani Chanuja ist Tech Lead – Generative AI Specialists, Autorin des Buches „Applied Machine Learning and High Performance Computing on AWS“ und Mitglied des Vorstands der Women in Manufacturing Education Foundation. Sie leitet Projekte zum maschinellen Lernen (ML) in verschiedenen Bereichen wie Computer Vision, Verarbeitung natürlicher Sprache und generative KI. Sie hilft Kunden dabei, große Modelle für maschinelles Lernen in großem Maßstab zu erstellen, zu trainieren und bereitzustellen. Sie spricht auf internen und externen Konferenzen wie re:Invent, Women in Manufacturing West, YouTube-Webinaren und GHC 23. In ihrer Freizeit geht sie gerne lange Läufe am Strand entlang.

Dr. Baichuan Sonne, derzeit als Sr. AI/ML Solution Architect bei AWS tätig, konzentriert sich auf generative KI und wendet sein Wissen in Datenwissenschaft und maschinellem Lernen an, um praktische, cloudbasierte Geschäftslösungen bereitzustellen. Mit Erfahrung in der Unternehmensberatung und KI-Lösungsarchitektur befasst er sich mit einer Reihe komplexer Herausforderungen, darunter unter anderem Robotik-Computer-Vision, Zeitreihenprognosen und vorausschauende Wartung. Seine Arbeit basiert auf einem soliden Hintergrund in Projektmanagement, Software-Forschung und -Entwicklung sowie akademischen Aktivitäten. Außerhalb der Arbeit genießt Dr. Sun den Ausgleich zwischen Reisen und Zeit mit Familie und Freunden.

Dr. Baichuan Sonne, derzeit als Sr. AI/ML Solution Architect bei AWS tätig, konzentriert sich auf generative KI und wendet sein Wissen in Datenwissenschaft und maschinellem Lernen an, um praktische, cloudbasierte Geschäftslösungen bereitzustellen. Mit Erfahrung in der Unternehmensberatung und KI-Lösungsarchitektur befasst er sich mit einer Reihe komplexer Herausforderungen, darunter unter anderem Robotik-Computer-Vision, Zeitreihenprognosen und vorausschauende Wartung. Seine Arbeit basiert auf einem soliden Hintergrund in Projektmanagement, Software-Forschung und -Entwicklung sowie akademischen Aktivitäten. Außerhalb der Arbeit genießt Dr. Sun den Ausgleich zwischen Reisen und Zeit mit Familie und Freunden.

Derrick Choo ist Senior Solutions Architect bei AWS und konzentriert sich darauf, die Reise der Kunden in die Cloud zu beschleunigen und ihr Geschäft durch die Einführung cloudbasierter Lösungen zu transformieren. Seine Expertise liegt in der Entwicklung von Full-Stack-Anwendungen und maschinellem Lernen. Er unterstützt Kunden beim Entwerfen und Erstellen von End-to-End-Lösungen, die Frontend-Benutzeroberflächen, IoT-Anwendungen, API- und Datenintegrationen sowie Modelle für maschinelles Lernen umfassen. In seiner Freizeit verbringt er gerne Zeit mit seiner Familie und experimentiert mit Fotografie und Videografie.

Derrick Choo ist Senior Solutions Architect bei AWS und konzentriert sich darauf, die Reise der Kunden in die Cloud zu beschleunigen und ihr Geschäft durch die Einführung cloudbasierter Lösungen zu transformieren. Seine Expertise liegt in der Entwicklung von Full-Stack-Anwendungen und maschinellem Lernen. Er unterstützt Kunden beim Entwerfen und Erstellen von End-to-End-Lösungen, die Frontend-Benutzeroberflächen, IoT-Anwendungen, API- und Datenintegrationen sowie Modelle für maschinelles Lernen umfassen. In seiner Freizeit verbringt er gerne Zeit mit seiner Familie und experimentiert mit Fotografie und Videografie.

Frank Winkler ist Senior Solutions Architect und Spezialist für generative KI bei AWS mit Sitz in Singapur und konzentriert sich auf maschinelles Lernen und generative KI. Er arbeitet mit globalen Digital-Native-Unternehmen zusammen, um skalierbare, sichere und kostengünstige Produkte und Services auf AWS zu entwickeln. In seiner Freizeit verbringt er Zeit mit seinem Sohn und seiner Tochter und reist, um die Wellen durch die ASEAN-Staaten zu genießen.

Frank Winkler ist Senior Solutions Architect und Spezialist für generative KI bei AWS mit Sitz in Singapur und konzentriert sich auf maschinelles Lernen und generative KI. Er arbeitet mit globalen Digital-Native-Unternehmen zusammen, um skalierbare, sichere und kostengünstige Produkte und Services auf AWS zu entwickeln. In seiner Freizeit verbringt er Zeit mit seinem Sohn und seiner Tochter und reist, um die Wellen durch die ASEAN-Staaten zu genießen.

Nihir Chadderwala ist Senior AI/ML Solutions Architect im Global Healthcare and Life Sciences-Team. Seine Expertise liegt in der Entwicklung von Big Data- und KI-gestützten Lösungen für Kundenprobleme, insbesondere in den Bereichen Biomedizin, Biowissenschaften und Gesundheitswesen. Er ist auch begeistert von der Schnittstelle zwischen Quanteninformationswissenschaft und KI und genießt es, in diesem Bereich zu lernen und dazu beizutragen. In seiner Freizeit spielt er gerne Tennis, reist und lernt etwas über Kosmologie.

Nihir Chadderwala ist Senior AI/ML Solutions Architect im Global Healthcare and Life Sciences-Team. Seine Expertise liegt in der Entwicklung von Big Data- und KI-gestützten Lösungen für Kundenprobleme, insbesondere in den Bereichen Biomedizin, Biowissenschaften und Gesundheitswesen. Er ist auch begeistert von der Schnittstelle zwischen Quanteninformationswissenschaft und KI und genießt es, in diesem Bereich zu lernen und dazu beizutragen. In seiner Freizeit spielt er gerne Tennis, reist und lernt etwas über Kosmologie.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/use-rag-for-drug-discovery-with-knowledge-bases-for-amazon-bedrock/