Google là công ty đi đầu trong nghiên cứu AI, đóng góp đáng kể cho cộng đồng nguồn mở với các công nghệ mang tính biến đổi như TensorFlow, Chứng nhận, T5, JAX, AlphaFold và AlphaCode. Tiếp nối di sản này, Google đã giới thiệu Gemma, một LLM được xây dựng để phát triển AI có trách nhiệm, tận dụng nghiên cứu và công nghệ tương tự đã hỗ trợ các mô hình Gini.

Mục lục

Gemma LLM là gì?

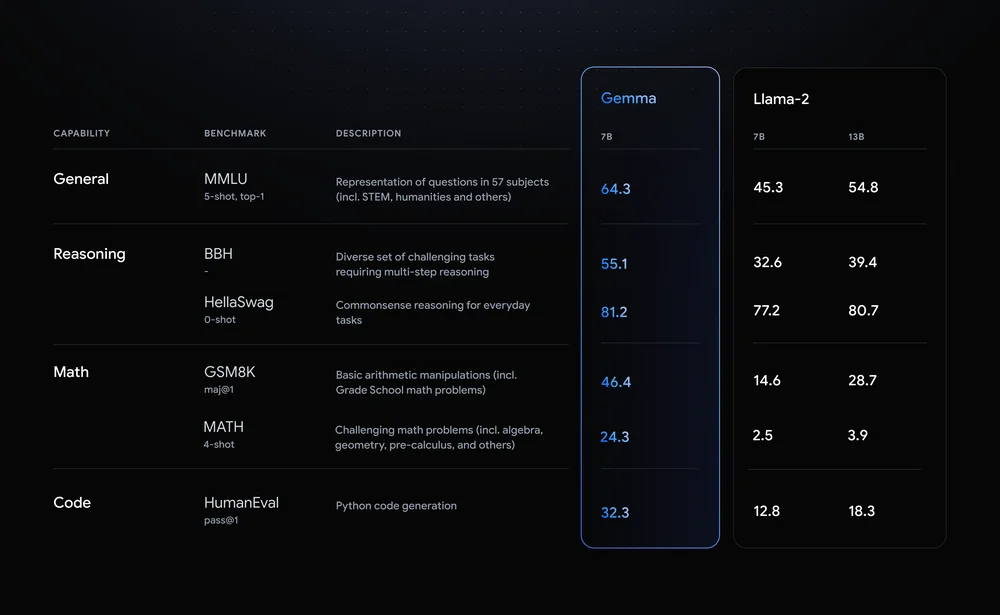

Gemma nổi bật với các chỉ số hiệu suất ấn tượng. Nó có hai biến thể: một biến thể có 7 tỷ tham số và biến thể khác có 2 tỷ tham số. Khi so sánh với LLM của Meta, Llama 2, Gemma cho thấy độ chính xác vượt trội trên nhiều điểm chuẩn khác nhau. Ví dụ: mô hình 7 tỷ tham số của Gemma tự hào có độ chính xác chung là 64.3%, vượt trội so với Lama 2 về lý luận, toán học và các hạng mục khác.

Hãy xem xét một số tính năng của Gemma LLM:

- Kiến trúc nhẹ: Gemma có hai kích cỡ, thông số 2B và 7B, nhỏ hơn đáng kể so với những người anh em họ lớn hơn của nó. Điều này dịch sang tốc độ suy luận nhanh hơn và nhu cầu tính toán thấp hơn, khiến nó trở nên lý tưởng cho máy tính cá nhân và thậm chí cả thiết bị di động.

- Tính khả dụng của nguồn mở: Không giống như nhiều LLM hiệu suất cao, mã và tham số của Gemma được cung cấp miễn phí, trao quyền cho các nhà phát triển và nhà nghiên cứu để thử nghiệm, tùy chỉnh và đóng góp cho sự phát triển của nó.

- Các biến thể được điều chỉnh theo hướng dẫn: Ngoài các mô hình được đào tạo trước, Gemma còn cung cấp các phiên bản “điều chỉnh theo hướng dẫn” được tối ưu hóa cho các tác vụ cụ thể như trả lời câu hỏi và tóm tắt. Cái này nâng cao hiệu suất và khả năng thích ứng cho các ứng dụng trong thế giới thực.

Tác động của Gemma vượt xa các thông số kỹ thuật. Nó dân chủ hóa quyền truy cập vào LLM tiên tiến, thúc đẩy sự đổi mới và hợp tác trong cộng đồng AI. Các ứng dụng tiềm năng của nó trải rộng trên nhiều lĩnh vực khác nhau, từ các công cụ năng suất cá nhân và chatbot để tạo mã và nghiên cứu khoa học. Bằng cách hạ thấp các rào cản gia nhập, Gemma hứa hẹn sẽ đẩy nhanh tiến bộ trong xử lý ngôn ngữ tự nhiên và định hình tương lai của AI.

Đi sâu vào các biến thể của Gemma

Gemma, dòng LLM nguồn mở của Google, cung cấp nhiều mô hình linh hoạt phục vụ các nhu cầu đa dạng. Hãy cùng đi sâu vào các kích thước và phiên bản khác nhau, khám phá điểm mạnh, trường hợp sử dụng và chi tiết kỹ thuật dành cho nhà phát triển:

Vấn đề về kích thước: Chọn Gemma của bạn

- 2B: Nhà vô địch hạng nhẹ này vượt trội trong các môi trường hạn chế về tài nguyên như CPU và thiết bị di động. Dung lượng bộ nhớ khoảng 1.5 GB và tốc độ suy luận nhanh khiến nó trở nên lý tưởng cho các tác vụ như phân loại văn bản và trả lời câu hỏi đơn giản.

- 7B: Tạo sự cân bằng giữa sức mạnh và hiệu quả, biến thể 7B tỏa sáng trên GPU và TPU cấp độ người tiêu dùng. Yêu cầu bộ nhớ 5GB của nó sẽ mở khóa các tác vụ phức tạp hơn như tóm tắt và tạo mã.

Điều chỉnh động cơ: Cơ sở so với điều chỉnh theo hướng dẫn

- Căn cứ: Vừa mới bắt đầu quá trình đào tạo, những mô hình này cung cấp nền tảng đa năng cho nhiều ứng dụng khác nhau. Chúng yêu cầu tinh chỉnh cho các tác vụ cụ thể nhưng mang lại sự linh hoạt cho việc tùy chỉnh.

- Điều chỉnh theo hướng dẫn: Được đào tạo trước về các hướng dẫn cụ thể như “tóm tắt” hoặc “dịch”, các biến thể này mang lại khả năng sử dụng ngay lập tức cho các tác vụ được nhắm mục tiêu. Họ hy sinh một số khả năng khái quát hóa để cải thiện hiệu suất trong lĩnh vực được chỉ định của họ.

Thông tin kỹ thuật dành cho nhà phát triển

- Mức chiếm dụng bộ nhớ: Model 2B yêu cầu khoảng 1.5 GB, trong khi model 7B yêu cầu khoảng 5GB bộ nhớ. Tinh chỉnh có thể tăng nhẹ dấu chân này.

- Tốc độ suy luận: Các mô hình 2B vượt trội về tốc độ, khiến chúng phù hợp với các ứng dụng thời gian thực. Các mô hình 7B cung cấp khả năng suy luận nhanh hơn so với các LLM lớn hơn nhưng có thể không phù hợp với tốc độ của các mô hình nhỏ hơn của chúng.

- Khả năng tương thích khung: Cả hai kích thước đều tương thích với các framework chính như TensorFlow, PyTorch và JAX, cho phép các nhà phát triển tận dụng môi trường ưa thích của họ.

Kết hợp đúng Gemma với nhu cầu của bạn

Sự lựa chọn giữa kích thước và điều chỉnh phụ thuộc vào yêu cầu cụ thể của bạn. Đối với các kịch bản hạn chế về tài nguyên và các tác vụ đơn giản, mô hình cơ sở 2B là điểm khởi đầu tuyệt vời. Nếu bạn ưu tiên hiệu suất và độ phức tạp trong các miền cụ thể thì biến thể được điều chỉnh theo hướng dẫn 7B có thể là nhà vô địch của bạn. Hãy nhớ rằng, việc tinh chỉnh một trong hai kích thước sẽ cho phép tùy chỉnh thêm cho trường hợp sử dụng riêng của bạn.

Ghi nhớ: Đây chỉ là một cái nhìn thoáng qua về các biến thể của Gemma. Với các tùy chọn đa dạng và tính chất nguồn mở, Gemma trao quyền cho các nhà phát triển khám phá và giải phóng tiềm năng của nó cho các ứng dụng khác nhau.

Bắt đầu với Gemma

Gemma, dòng mô hình ngôn ngữ lớn (LLM) nguồn mở ấn tượng của Google, mở ra cánh cửa cho các nhà phát triển và nhà nghiên cứu khám phá tiềm năng của AI trong tầm tay họ. Hãy đi sâu vào cách bạn có thể cài đặt và chạy Gemma, truy cập các mô hình được đào tạo trướcvà xây dựng ứng dụng của riêng bạn sử dụng khả năng đa dạng của nó.

Nền tảng bất khả tri: Gemma trên CPU, GPU hoặc TPU

Gemma tự hào về tính linh hoạt của nền tảng, cho phép bạn chạy nó trên nhiều cấu hình phần cứng khác nhau. Vì Thiết lập dựa trên CPU, thư viện Hugging Face Transformers và trình thông dịch Tensorflow Lite của Google cung cấp các tùy chọn hiệu quả. Nếu bạn có quyền truy cập vào GPU hoặc TPU, tận dụng toàn bộ sức mạnh của TensorFlow để tăng tốc hiệu suất. Đối với việc triển khai dựa trên đám mây, hãy xem xét Google Cloud Vertex AI để có khả năng mở rộng và tích hợp liền mạch.

Truy cập các mô hình sẵn sàng sử dụng

Các mô hình được đào tạo trước của Gemma có nhiều kích cỡ và khả năng khác nhau, đáp ứng các nhu cầu đa dạng. Đối với các tác vụ tạo văn bản, dịch thuật và trả lời câu hỏi, các biến thể Gemma 2B và 7B mang lại hiệu suất ấn tượng. Ngoài ra, các mô hình được điều chỉnh theo hướng dẫn như Gemma 2B-FT và 7B-FT được thiết kế đặc biệt để tinh chỉnh các tập dữ liệu của riêng bạn, mở khóa khả năng cá nhân hóa hơn nữa.

Khám phá khả năng của Gemma

Hãy cùng khám phá một số ứng dụng thú vị mà bạn có thể xây dựng với Gemma:

- Cách kể chuyện hấp dẫn: Tạo các câu chuyện thực tế và hấp dẫn bằng cách sử dụng khả năng tạo văn bản.

- Dịch ngôn ngữ dễ dàng: Dịch văn bản liền mạch giữa các ngôn ngữ với khả năng đa ngôn ngữ của Gemma.

- Khai phá kiến thức: Triển khai các mô hình trả lời câu hỏi để cung cấp những câu trả lời mang tính thông tin và sâu sắc.

- Tạo nội dung sáng tạo: Thử nghiệm thơ ca, chữ viết hoặc tạo mã, vượt qua ranh giới của AI sáng tạo.

Tinh chỉnh và tùy chỉnh

Sức mạnh thực sự của Gemma nằm ở khả năng tinh chỉnh của nó. Tận dụng bộ dữ liệu của riêng bạn để điều chỉnh mô hình theo nhu cầu cụ thể của bạn và đạt được hiệu suất tuyệt vời. Các bài viết tham khảo được cung cấp cung cấp hướng dẫn chi tiết về tinh chỉnh và tùy chỉnh, giúp bạn phát huy hết tiềm năng của Gemma.

Bắt đầu với Gemma là một hành trình thú vị. Với tính chất dễ tiếp cận, khả năng đa dạng và sự hỗ trợ cộng đồng sôi động, Gemma mở ra một thế giới đầy khả năng cho các nhà phát triển cũng như nhà nghiên cứu. Vì vậy, hãy đi sâu vào thế giới LLM nguồn mở và giải phóng sức mạnh của Gemma trong dự án AI tiếp theo của bạn!

Tương lai của Gemma

Bản chất nguồn mở và hiệu suất ấn tượng của Gemma đã gây được tiếng vang đáng kể trong cộng đồng LLM.

Nhưng điều gì đang chờ đợi phía trước đối với gia đình người mẫu đang phát triển này?

- Những tiến bộ trong bối cảnh LLM: Bản chất nguồn mở của Gemma thúc đẩy sự hợp tác và đổi mới. Các nhà nghiên cứu và nhà phát triển trên toàn thế giới có thể đóng góp vào sự phát triển của nó, thúc đẩy tiến bộ trong các lĩnh vực như khả năng diễn giải, tính công bằng và hiệu quả. Chúng ta có thể thấy Gemma dẫn đầu việc khám phá LLM đa phương thức, có khả năng xử lý và tạo ra không chỉ văn bản mà còn cả hình ảnh, âm thanh và video.

- Triển vọng lạc quan: Với cách tiếp cận dân chủ hóa và khả năng ấn tượng, Gemma thể hiện một bước quan trọng hướng tới việc giúp mọi người có thể tiếp cận và mang lại lợi ích cho AI. Khi quá trình phát triển tiến triển, chúng ta có thể mong đợi nhiều ứng dụng và tiến bộ đột phá hơn nữa. Bản chất nguồn mở của Gemma thúc đẩy một cộng đồng sôi động, đảm bảo sự phát triển liên tục và tác động đến tương lai của LLM.

Kết luận

Việc Gemma đến với bối cảnh LLM đánh dấu một bước ngoặt quan trọng. Không giống như những người anh em họ lớn hơn, sử dụng nhiều tài nguyên hơn, Gemma cung cấp khả năng tiếp cận và tính linh hoạt, cung cấp các khả năng AI tiên tiến cho nhiều đối tượng hơn. Bản chất nguồn mở của nó thúc đẩy sự đổi mới và hợp tác, thúc đẩy tiến bộ trong xử lý ngôn ngữ tự nhiên và định hình tương lai của AI.

Chìa khóa chính

- Nhẹ và nguồn mở: Quy mô nhỏ hơn và tính khả dụng mở của Gemma giúp nó có thể truy cập được trên nhiều nền tảng khác nhau, trao quyền cho các cá nhân và tổ chức nhỏ hơn để khám phá tiềm năng của AI.

- Các biến thể và khả năng đa dạng: Với nhiều kích cỡ và tùy chọn điều chỉnh theo hướng dẫn, Gemma đáp ứng nhiều nhu cầu khác nhau, từ trả lời câu hỏi cơ bản đến tạo nội dung phức tạp.

- Khai phá tiềm năng thông qua tùy chỉnh: Khả năng tinh chỉnh cho phép người dùng điều chỉnh Gemma theo nhu cầu cụ thể của họ, mở ra những khả năng mới trong các lĩnh vực đa dạng.

- Một cộng đồng sôi động và tương lai tươi sáng: Bản chất nguồn mở của Gemma thúc đẩy một cộng đồng hợp tác, thúc đẩy những tiến bộ về khả năng diễn giải, tính công bằng và khả năng đa phương thức.

Các liên kết quan trọng

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/