Làm quen với Mixtral 8x7B của Mistral AI. Nó cực kỳ thông minh trong việc xử lý dữ liệu lớn và có thể trợ giúp thực hiện các tác vụ như dịch ngôn ngữ và tạo mã. Các nhà phát triển trên khắp thế giới rất vui mừng về tiềm năng của nó trong việc hợp lý hóa các dự án của họ và nâng cao hiệu quả. Với thiết kế thân thiện với người dùng và khả năng ấn tượng, Mixtral 8x7B đang nhanh chóng trở thành công cụ phù hợp để phát triển AI.

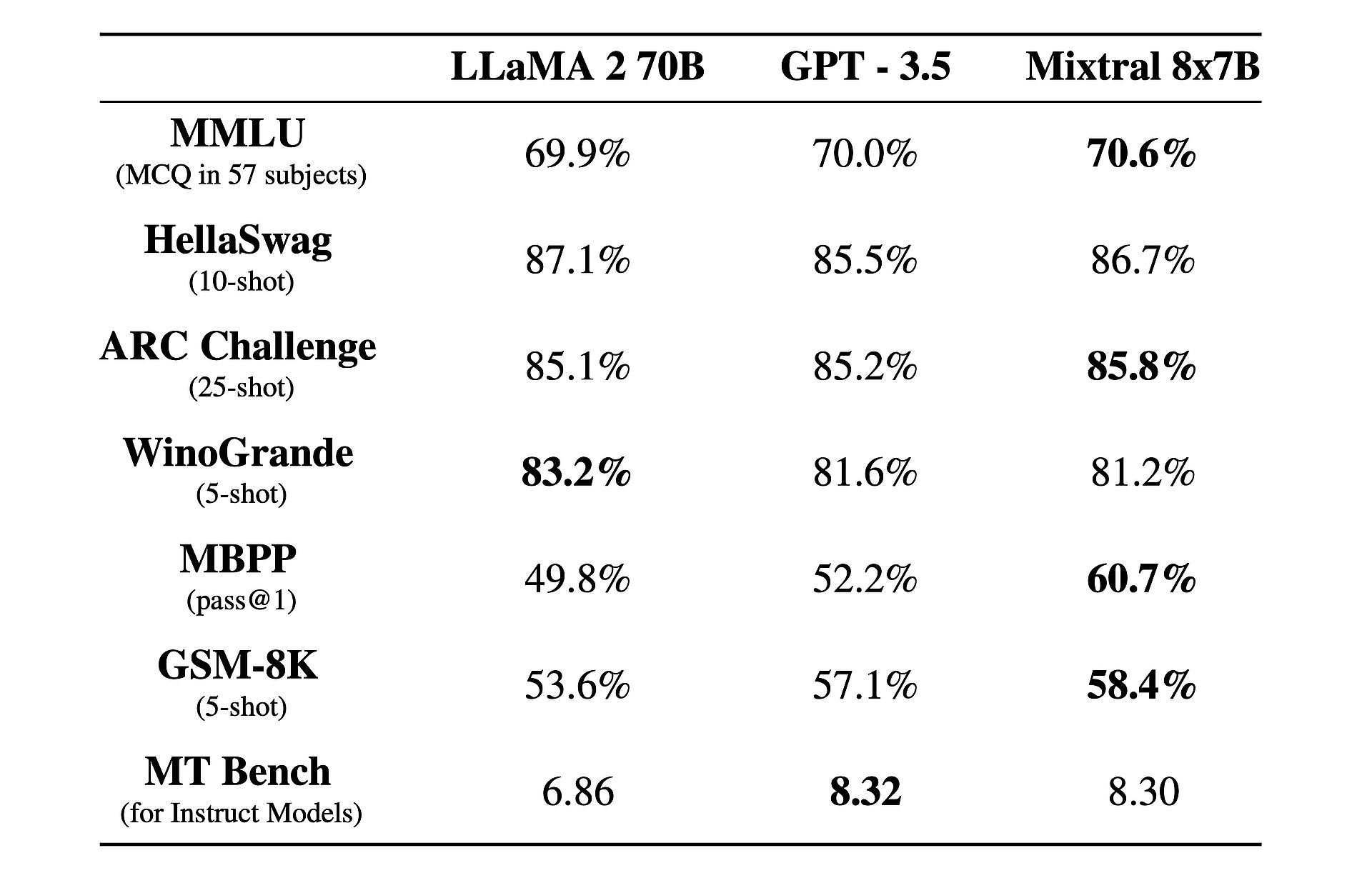

Ngoài ra, có một sự thật thú vị về nó: Nó hoạt động tốt hơn GPT-3.5 và lạc đà không bướu 2!

Mixtral 8x7B là gì?

Mixtral 8x7B là mô hình trí tuệ nhân tạo tiên tiến được phát triển bởi Mistral AI. Nó sử dụng một kiến trúc độc đáo được gọi là hỗn hợp chuyên gia thưa thớt (SMoE) để xử lý lượng lớn dữ liệu một cách hiệu quả. Mặc dù phức tạp nhưng Mixtral được thiết kế để dễ sử dụng và thích ứng với nhiều tác vụ khác nhau như dịch ngôn ngữ và tạo mã. Nó vượt trội hơn các mô hình khác về tốc độ và độ chính xác, khiến nó trở thành một công cụ có giá trị cho các nhà phát triển. Ngoài ra, nó còn có sẵn theo giấy phép Apache 2.0, cho phép mọi người sử dụng và sửa đổi nó một cách tự do.

Muốn tìm hiểu thêm? Về bản chất, Mixtral 8x7B hoạt động như một mô hình chỉ dành cho bộ giải mã, tận dụng một cách tiếp cận độc đáo trong đó khối tiếp liệu tiếp theo chọn từ tám nhóm tham số riêng biệt, được gọi là “chuyên gia”. Các chuyên gia này được mạng bộ định tuyến lựa chọn linh hoạt để xử lý từng mã thông báo, nâng cao hiệu quả và hiệu suất đồng thời giảm thiểu chi phí tính toán.

Một trong những điểm mạnh chính của Mixtral nằm ở khả năng thích ứng và khả năng mở rộng. Có khả năng xử lý các ngữ cảnh lên tới 32,000 mã thông báo và hỗ trợ nhiều ngôn ngữ, bao gồm tiếng Anh, tiếng Pháp, tiếng Ý, tiếng Đức và tiếng Tây Ban Nha. Mixtral trao quyền cho các nhà phát triển để giải quyết nhiều nhiệm vụ một cách dễ dàng và chính xác.

Điều thực sự khiến Mixtral trở nên khác biệt là tỷ lệ hiệu suất trên chi phí. Với tổng số đáng kinh ngạc là 46.7 tỷ tham số, Mixtral đạt được hiệu quả vượt trội bằng cách chỉ sử dụng một phần nhỏ các tham số này trên mỗi mã thông báo, dẫn đến thời gian suy luận nhanh hơn và giảm chi phí tính toán.

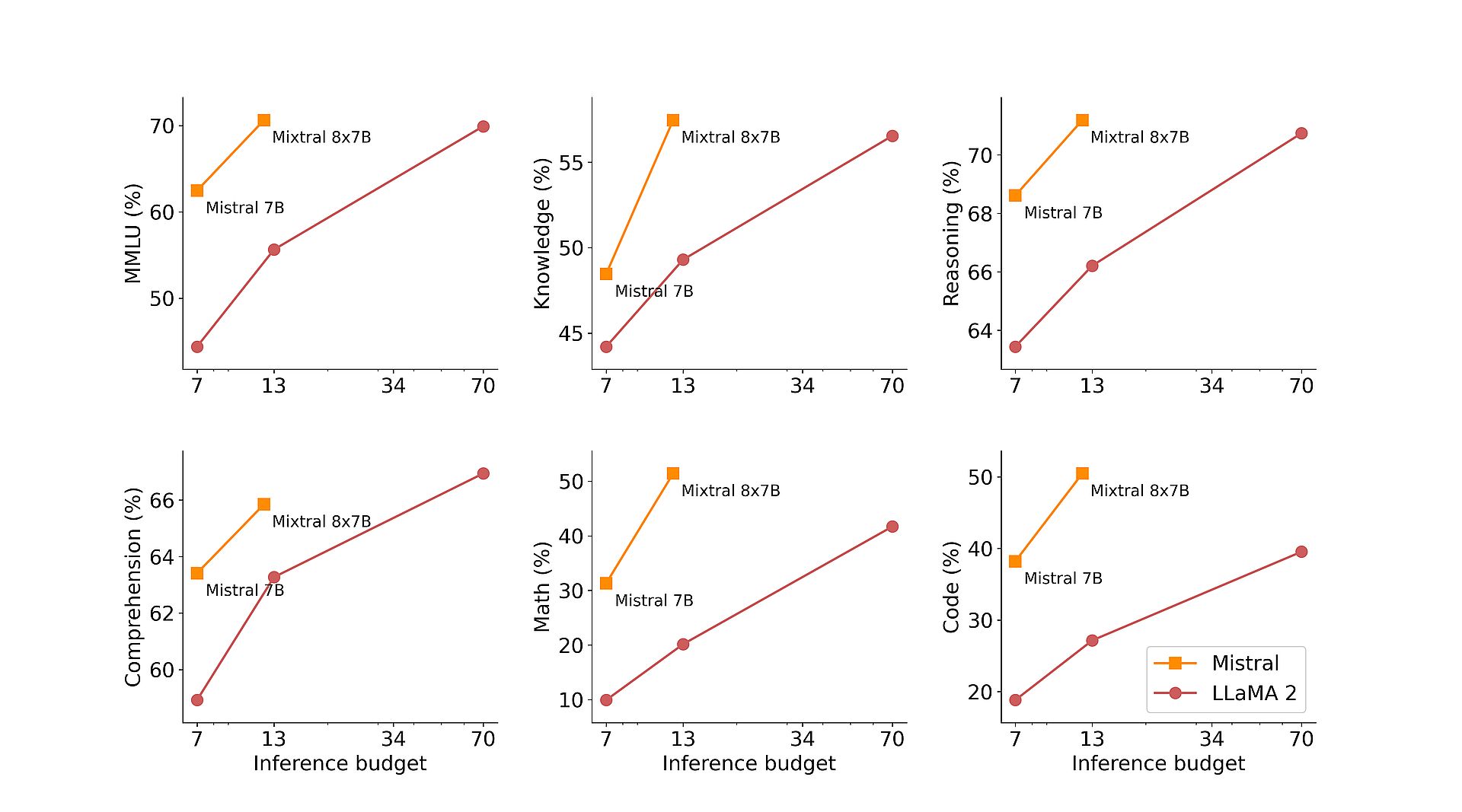

Hơn nữa, việc đào tạo trước của Mixtral về các bộ dữ liệu mở rộng được trích xuất từ web mở đảm bảo tính mạnh mẽ và linh hoạt trong các ứng dụng trong thế giới thực. Cho dù đó là tạo mã, dịch ngôn ngữ hay phân tích cảm xúc, Mixtral đều mang lại kết quả vượt trội trên nhiều tiêu chuẩn khác nhau, vượt qua các mô hình truyền thống như Llama 2 và thậm chí còn vượt trội hơn GPT3.5 trong nhiều trường hợp.

Để nâng cao hơn nữa khả năng của mình, Mistral AI đã giới thiệu Mixtral 8x7B Instruct, một biến thể chuyên dụng được tối ưu hóa cho các tác vụ làm theo hướng dẫn. Đạt được số điểm ấn tượng 8.30 trên MT-Bench, Mixtral 8x7B Instruct củng cố vị trí của mình như một mô hình nguồn mở hàng đầu về tinh chỉnh có giám sát và tối ưu hóa tùy chọn.

Ngoài năng lực kỹ thuật của mình, Mistral AI cam kết dân chủ hóa quyền truy cập vào Mixtral bằng cách đóng góp cho dự án vLLM, cho phép tích hợp và triển khai liền mạch với các công cụ nguồn mở. Điều này trao quyền cho các nhà phát triển khai thác sức mạnh của Mixtral trên nhiều ứng dụng và nền tảng, thúc đẩy sự đổi mới và tiến bộ trong lĩnh vực trí tuệ nhân tạo.

Groq AI, không phải Grok, chế nhạo Elon Musk bằng “LLM nhanh nhất”

Cách sử dụng Mixtral 8x7B

Mixtral 8x7B có thể truy cập được thông qua điểm cuối mistral-small của Mistral, nằm trong giai đoạn thử nghiệm betađ. Nếu bạn quan tâm đến việc có được quyền truy cập sớm vào tất cả các điểm cuối tổng hợp và nhúng của Mistral, bạn có thể ghi danh Hiện nay. Bằng cách đăng ký, bạn sẽ là một trong những người đầu tiên trải nghiệm toàn bộ khả năng của Mixtral 8x7B và khám phá các giải pháp sáng tạo của nó.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/