Bu, ortak yazar tarafından yazılan ortak gönderidir. Leidos ve AWS. Leidos, savunma, istihbarat, iç güvenlik, sivil ve sağlık pazarlarında dünyanın en zorlu zorluklarından bazılarını ele almak için çalışan bir FORTUNE 500 bilim ve teknoloji çözümleri lideridir.

Leidos, bulut özellikli, şifrelenmiş işlem hatları oluşturduğunuz, gizliliği koruyan, gizli makine öğrenimi (ML) modellemesine yönelik bir yaklaşım geliştirmek için AWS ile ortaklık kurdu.

Homomorfik şifreleme, verilerin şifresinin asla çözülmemesi gerektiğini belirten bir politikanız olduğu durumlarda gizliliği korumak için, önce şifresini çözmek zorunda kalmadan şifrelenmiş veriler üzerinde hesaplamaların ve analitik işlevlerin çalıştırılmasına izin veren yeni bir şifreleme yaklaşımıdır. Tamamen homomorfik şifreleme (FHE), bu tür bir yaklaşımın en güçlü kavramıdır ve sıfır güvenin anahtar olduğu durumlarda verilerinizin değerini ortaya çıkarmanıza olanak tanır. Temel gereksinim, verilerin sayısal, metinsel ve görüntü tabanlı veri kümelerine uygulanabilen bir kodlama tekniği aracılığıyla sayılarla temsil edilebilmesidir. FHE kullanan verilerin boyutu daha büyüktür, bu nedenle, çıkarımın neredeyse gerçek zamanlı olarak veya boyut sınırlamalarıyla gerçekleştirilmesine ihtiyaç duyan uygulamalar için test yapılmalıdır. Tüm hesaplamaları doğrusal denklemler olarak ifade etmek de önemlidir.

Bu gönderide, en üst düzey düzenlemelere tabi ortamlar için gizliliği koruyan makine öğrenimi tahminlerinin nasıl etkinleştirileceğini gösteriyoruz. Tahminler (çıkarım) şifrelenmiş verileri kullanır ve sonuçların şifresi yalnızca son tüketici (müşteri tarafı) tarafından çözülür.

Bunu göstermek için, bir özelleştirme örneğini gösteriyoruz. Amazon Adaçayı Yapıcı Scikit-learn, açık kaynaklı, derin öğrenme kabı konuşlandırılmış bir uç noktanın istemci tarafında şifrelenmiş çıkarım isteklerini kabul etmesini sağlamak için. Bu örnek çıkarım işlemleri için bunun nasıl gerçekleştirileceğini gösterse de, çözümü eğitim ve diğer makine öğrenimi adımlarına genişletebilirsiniz.

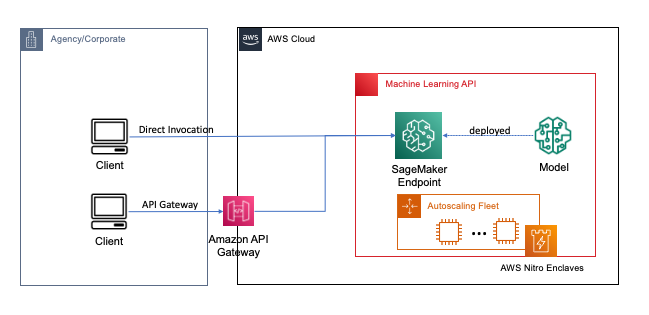

Uç noktalar, geliştiricilerin ve makine öğrenimi uzmanlarının bulutta makine öğrenimi ve derin öğrenme modelleri oluşturma ve eğitme sürecini basitleştiren SageMaker kullanılarak birkaç tıklamayla veya kod satırıyla dağıtılır. SageMaker kullanılarak oluşturulan modeller daha sonra şu şekilde dağıtılabilir: gerçek zamanlı uç noktalar, gerçek zamanlı, sabit durum, düşük gecikme gereksinimlerine sahip olduğunuz çıkarım iş yükleri için kritik öneme sahiptir. Uygulamalar ve hizmetler, dağıtılan uç noktayı doğrudan veya dağıtılan sunucusuz bir ağ üzerinden arayabilir Amazon API Ağ Geçidi mimari. Gerçek zamanlı uç nokta mimarisi en iyi uygulamaları hakkında daha fazla bilgi edinmek için bkz. Amazon API Gateway eşleme şablonları ve Amazon SageMaker ile makine öğrenimi destekli bir REST API oluşturma. Aşağıdaki şekil, bu kalıpların her iki versiyonunu da göstermektedir.

Bu modellerin her ikisinde de aktarım sırasında şifreleme, veriler çıkarım işlemini gerçekleştirmek için hizmetlerden geçerken gizlilik sağlar. SageMaker uç noktası tarafından alındığında, çalışma zamanında çıkarım işlemini gerçekleştirmek için verilerin şifresi genellikle çözülür ve herhangi bir harici kod ve işlem tarafından erişilemez. Ek koruma seviyeleri elde etmek için FHE, çıkarım işleminin güvenilir bir uygulama veya istemci tarafından sonuçların şifresinin çözülebileceği şifreli sonuçlar oluşturmasını sağlar.

Tamamen homomorfik şifreleme hakkında daha fazlası

FHE, sistemlerin şifrelenmiş veriler üzerinde hesaplamalar gerçekleştirmesini sağlar. Ortaya çıkan hesaplamalar, şifresi çözüldüğünde, şifreleme işlemi olmadan üretilenlere kontrol edilebilir bir şekilde yakındır. FHE, hesaplamaya eklenen gürültü nedeniyle kayan nokta hatasına benzer şekilde küçük bir matematiksel belirsizliğe neden olabilir. Soruna özgü, ayarlanmış bir parametre olan uygun FHE şifreleme parametreleri seçilerek kontrol edilir. Daha fazla bilgi için videoyu izleyin Homomorfik şifrelemeyi nasıl açıklarsınız?

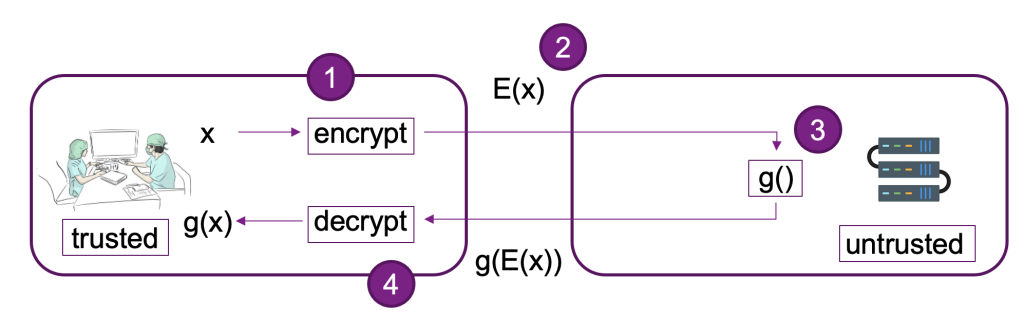

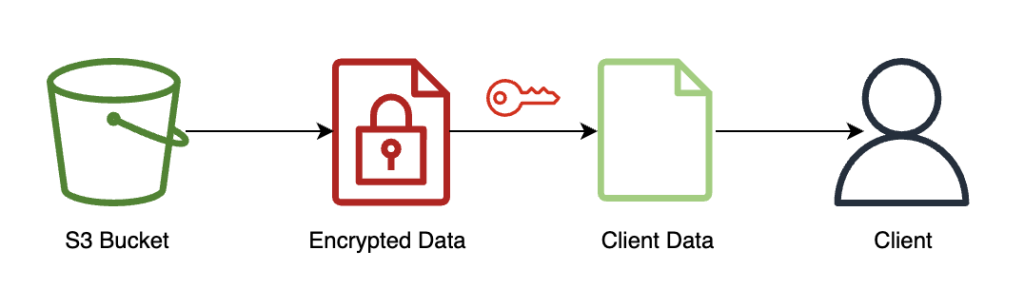

Aşağıdaki diyagram, bir FHE sisteminin örnek bir uygulamasını sağlar.

Bu sistemde siz veya güvenilir müşteriniz aşağıdakileri yapabilirsiniz:

- Bir genel anahtar FHE şeması kullanarak verileri şifreleyin. Birkaç farklı kabul edilebilir şema vardır; bu örnekte CKKS şemasını kullanıyoruz. Seçtiğimiz FHE ortak anahtar şifreleme süreci hakkında daha fazla bilgi edinmek için bkz. CKKS açıkladı.

- İstemci tarafı şifrelenmiş verileri işlenmek üzere bir sağlayıcıya veya sunucuya gönderin.

- Şifrelenmiş veriler üzerinde model çıkarımı gerçekleştirin; FHE ile şifre çözme gerekmez.

- Şifrelenmiş sonuçlar arayana döndürülür ve daha sonra, yalnızca sizin veya istemcideki güvenilir kullanıcılarınız tarafından kullanılabilen özel bir anahtar kullanılarak sonucunuzun şifresi çözülür.

SageMaker uç noktalarını kullanan bir örnek oluşturmak için önceki mimariyi kullandık, Pyfhel ML uygulamalarıyla entegrasyonu basitleştiren bir FHE API paketleyici olarak ve SEAL temel FHE şifreleme araç setimiz olarak.

Çözüme genel bakış

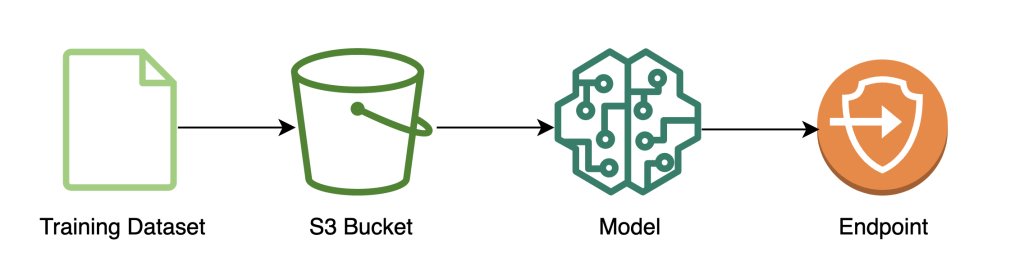

AWS'de bir ölçeklenebilir FHE işlem hattı örneği oluşturduk. SKLearn lojistik regresyon ile derin öğrenme kapsayıcısı Iris veri kümesi. Bir SageMaker not defteri kullanarak veri keşfi ve özellik mühendisliği gerçekleştiriyoruz ve ardından bir SageMaker kullanarak model eğitimi gerçekleştiriyoruz. SageMaker eğitim işi. Ortaya çıkan model konuşlandırılmış aşağıdaki şemada gösterildiği gibi istemci hizmetleri tarafından kullanılmak üzere bir SageMaker gerçek zamanlı uç noktasına.

Bu mimaride, yalnızca istemci uygulaması şifrelenmemiş verileri görür. Çıkarım için model aracılığıyla işlenen veriler, izole edilmiş sistemdeki işlemci içindeki çalışma zamanında bile yaşam döngüsü boyunca şifreli kalır. AWS Nitro Bölgesi. Aşağıdaki bölümlerde, bu işlem hattını oluşturmak için kodu gözden geçireceğiz.

Önkoşullar

Takip etmek için, bir kampanya başlattığınızı varsayıyoruz. SageMaker not defteri bir ile AWS Kimlik ve Erişim Yönetimi (IAM) rolü ile AmazonSageMakerTam Erişim yönetilen politika

Modeli eğitin

Aşağıdaki diyagram, model eğitimi iş akışını göstermektedir.

Aşağıdaki kod, SageMaker not defterlerini kullanarak eğitim veri kümemizi çekerek, gerekli temizleme işlemlerini gerçekleştirerek ve ardından verileri bir Amazon Basit Depolama Hizmeti (Amazon S3) paketi. Bu aşamada, veri setinizin ek özellik mühendisliğini de yapmanız veya farklı çevrimdışı özellik depolarıyla entegre etmeniz gerekebilir.

Bu örnekte, kullandığımız komut dosyası modu SageMaker içinde yerel olarak desteklenen bir çerçevede (scikit-öğrenme), burada çıkarım sırasında şifrelenmiş verileri işlemek için varsayılan SageMaker SKLearn tahmin aracımızı özel bir eğitim betiğiyle başlatıyoruz. Yerel olarak desteklenen çerçeveler ve betik modu hakkında daha fazla bilgi görmek için bkz. Amazon SageMaker ile Makine Öğrenimi Çerçevelerini, Python ve R'yi kullanın.

Son olarak, modelimizi veri kümesi üzerinde eğitiyoruz ve eğitilmiş modelimizi tercih ettiğimiz örnek türüne dağıtıyoruz.

Bu noktada, özel bir SKLearn FHE modeli eğittik ve onu, şifrelenmiş verileri kabul etmeye hazır bir SageMaker gerçek zamanlı çıkarım uç noktasına yerleştirdik.

İstemci verilerini şifreleyin ve gönderin

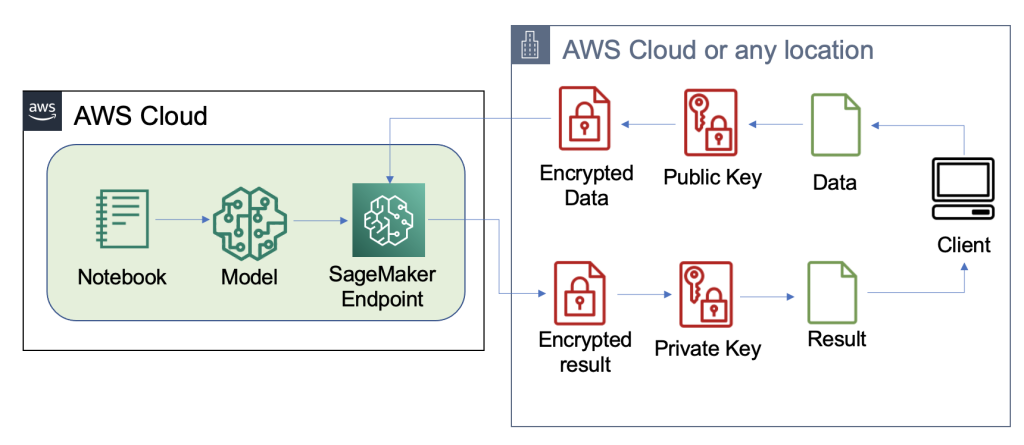

Aşağıdaki diyagram, müşteri verilerini şifreleme ve modele gönderme iş akışını göstermektedir.

Çoğu durumda, çıkarım uç noktasına yapılan çağrının yükü, önce Amazon S3'te depolamak yerine şifrelenmiş verileri içerir. Bunu bu örnekte, çıkarım çağrısı için çok sayıda kaydı bir araya topladığımız için yapıyoruz. Uygulamada, bu parti boyutu daha küçük olacak veya bunun yerine parti dönüşümü kullanılacaktır. Amazon S3'ün aracı olarak kullanılması FHE için gerekli değildir.

Artık çıkarım uç noktası ayarlandığına göre, verileri göndermeye başlayabiliriz. Normalde farklı test ve eğitim veri kümeleri kullanırız, ancak bu örnek için aynı eğitim veri kümelerini kullanırız.

İlk olarak client tarafına Iris veri setini yüklüyoruz. Ardından, Pyfhel kullanarak FHE bağlamını kurduk. Bu işlem için Pyfhel'i seçtik çünkü kurulumu ve çalışması basit, popüler FHE şemaları içeriyor ve altta yatan güvenilir açık kaynaklı şifreleme uygulamasına dayanıyor. SEAL. Bu örnekte, şifrelenmiş verileri, bu FHE şeması için ortak anahtar bilgileriyle birlikte sunucuya gönderiyoruz; gelen verilerin şifresini çözme yeteneği. Özel anahtar, yalnızca sonuçların şifresini çözme yeteneğine sahip olan istemcide kalır.

Verilerimizi şifreledikten sonra, Amazon S3'te depolanmak üzere (ilgili anahtarlar ve şifrelenmiş veriler dahil) eksiksiz bir veri sözlüğü oluştururuz. Daha sonra model, tahminlerini istemciden gelen şifrelenmiş veriler üzerinden aşağıdaki kodda gösterildiği gibi yapar. Özel anahtarı iletmediğimize dikkat edin, bu nedenle model ana bilgisayar verilerin şifresini çözemez. Bu örnekte, verileri bir S3 nesnesi olarak geçiriyoruz; alternatif olarak, bu veriler doğrudan Sagemaker uç noktasına gönderilebilir. Gerçek zamanlı bir uç nokta olarak yük, istek gövdesinde belirtilen veri parametresini içerir. SageMaker belgeleri.

Aşağıdaki ekran görüntüsü, içindeki merkezi tahmini gösterir. fhe_train.py (ek, tüm eğitim senaryosunu gösterir).

Şifreli lojistik regresyonumuzun sonuçlarını hesaplıyoruz. Bu kod, olası her sınıf için şifrelenmiş bir skaler ürünü hesaplar ve sonuçları istemciye döndürür. Sonuçlar, tüm örneklerde her sınıf için tahmin edilen logitlerdir.

İstemci şifresi çözülmüş sonuçlar döndürür

Aşağıdaki diyagram, çıkarım sonucunu ortaya çıkarmak için istemcinin şifrelenmiş sonucunu alma ve şifresini çözme (yalnızca onların erişebildiği özel anahtarla) iş akışını göstermektedir.

Bu örnekte, sonuçlar Amazon S3'te depolanır, ancak bu genellikle gerçek zamanlı uç noktanın yükü aracılığıyla döndürülür. Amazon S3'ün aracı olarak kullanılması FHE için gerekli değildir.

Çıkarım sonucu, FHE kullanmadan kendileri hesaplamış gibi sonuçlara kontrollü bir şekilde yakın olacaktır.

Temizlemek

Bu işlemden sonra kullanılmayan bir işlem kalmadığından emin olmak için oluşturduğumuz uç noktayı silerek bu işlemi sonlandırıyoruz.

Sonuçlar ve düşünceler

FHE'yi modellerin üzerinde kullanmanın yaygın dezavantajlarından biri, pratikte ortaya çıkan modeli etkileşimli kullanım durumları için çok yavaş hale getiren hesaplama yükü eklemesidir. Ancak, verilerin çok hassas olduğu durumlarda, bu gecikme değiş tokuşunu kabul etmek faydalı olabilir. Ancak, basit lojistik regresyonumuz için, 140 girdi verisi örneğini 60 saniye içinde işleyebilir ve doğrusal performansı görebiliriz. Aşağıdaki grafik, müşteri tarafından girişi şifrelemek ve sonuçların şifresini çözmek için gerçekleştirilen süre dahil olmak üzere toplam uçtan uca süreyi içerir. Ayrıca gecikme ekleyen ve bu durumlar için gerekli olmayan Amazon S3'ü kullanır.

Örnek sayısını 1'den 150'ye çıkardıkça doğrusal ölçekleme görüyoruz. Bu bekleniyor çünkü her örnek birbirinden bağımsız olarak şifreleniyor, bu nedenle hesaplamada sabit bir kurulum maliyeti ile doğrusal bir artış bekliyoruz.

Bu aynı zamanda, SageMaker uç noktanızın arkasında daha fazla istek verimi için çıkarım filonuzu yatay olarak ölçeklendirebileceğiniz anlamına gelir. Kullanabilirsiniz Amazon SageMaker Çıkarım Öneri Aracı iş ihtiyaçlarınıza göre filonuzu optimize etmek için.

Sonuç

Ve işte karşınızda: birkaç satır kodla kurabileceğiniz bir SKLearn lojistik regresyon modeli için tamamen homomorfik şifreleme ML'si. Bazı özelleştirmelerle, aynı şifreleme işlemini eğitim verilerinden bağımsız olarak farklı model türleri ve çerçeveler için uygulayabilirsiniz.

Homomorfik şifreleme kullanan bir makine öğrenimi çözümü oluşturma hakkında daha fazla bilgi edinmek istiyorsanız daha fazla bilgi edinmek için AWS hesap ekibiniz veya iş ortağınız Leidos ile iletişime geçin. Daha fazla örnek için aşağıdaki kaynaklara da başvurabilirsiniz:

Bu gönderideki içerik ve görüşler, üçüncü taraf yazarların görüşlerini içerir ve AWS, bu gönderinin içeriğinden veya doğruluğundan sorumlu değildir.

Ek

Tam eğitim senaryosu aşağıdaki gibidir:

Yazarlar Hakkında

Liv d'Aliberti Teknoloji Ofisi'ne bağlı Leidos AI/ML Accelerator bünyesinde bir araştırmacıdır. Araştırmaları gizliliği koruyan makine öğrenimine odaklanıyor.

Menbir Gulati Teknoloji Ofisi'ne bağlı Leidos AI/ML Accelerator bünyesinde bir araştırmacıdır. Araştırması, siber güvenlik ve ortaya çıkan AI tehditlerinin kesişimine odaklanmaktadır.

Joe Kovba Teknoloji Ofisi'ne bağlı Leidos Dijital Modernizasyon Hızlandırıcı bünyesinde bir Bulut Mükemmeliyet Merkezi Uygulama Lideridir. Boş zamanlarında futbol maçlarında hakemlik yapmaktan ve softbol oynamaktan hoşlanır.

Ben Snily Kamu Sektörü Uzmanı Çözüm Mimarıdır. Devlet kurumları, kar amacı gütmeyen kuruluşlar ve eğitim müşterileri ile büyük veri ve analitik projeler üzerinde çalışarak AWS kullanarak çözüm oluşturmalarına yardımcı olur. Boş zamanlarında evinin her yerine IoT sensörleri ekliyor ve bunlar üzerinde analizler yapıyor.

Sami Hoca Dünya Çapında Kamu Sektörünü kapsayan Partners Consulting bölümünde Kıdemli Çözüm Mimarıdır. Sami, eşit parçaların tasarım düşüncesi, yenilikçilik ve duygusal zekanın, ihtiyaç sahibi insanlar için sorunları çözmek ve onları etkilemek için kullanılabileceği projeler konusunda tutkulu.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/enable-fully-homomorphic-encryption-with-amazon-sagemaker-endpoints-for-secure-real-time-inferencing/