Üretken yapay zekanın ortaya çıkışıyla birlikte, büyük dil modelleri (LLM) Claude 2 ve Llama 2 gibi günümüzün temel modelleri (FM'ler), metin verileri üzerinde soru yanıtlama, özetleme ve içerik oluşturma gibi bir dizi üretken görevi gerçekleştirebilir. Ancak gerçek dünya verileri metin, resim, video ve ses gibi birden fazla biçimde mevcuttur. Örneğin bir PowerPoint slayt gösterisini ele alalım. Metin biçiminde veya grafiklere, tablolara ve resimlere gömülü bilgiler içerebilir.

Bu yazıda multimodal FM'leri kullanan bir çözüm sunuyoruz. Amazon Titan Multimodal Gömmeler model ve LLaVA 1.5 ve AWS hizmetleri dahil Amazon Ana Kayası ve Amazon Adaçayı Yapıcı çok modlu veriler üzerinde benzer üretken görevleri gerçekleştirmek.

Çözüme genel bakış

Çözüm, slayt destesinin metin ve görsel öğelerinde yer alan bilgileri kullanarak soruları yanıtlamaya yönelik bir uygulama sağlar. Tasarım, Alma Artırılmış Üretim (RAG) konseptine dayanmaktadır. Geleneksel olarak RAG, LLM'ler tarafından işlenebilen metinsel verilerle ilişkilendirilmiştir. Bu yazıda RAG'ı görüntüleri de içerecek şekilde genişletiyoruz. Bu, metinle birlikte tablolar ve grafikler gibi görsel öğelerden bağlamsal olarak alakalı içeriği çıkarmak için güçlü bir arama yeteneği sağlar.

Görüntüleri içeren bir RAG çözümü tasarlamanın farklı yolları vardır. Burada bir yaklaşım sunduk ve bu üç bölümlük serinin ikinci yazısında alternatif bir yaklaşımla devam edeceğiz.

Bu çözüm aşağıdaki bileşenleri içerir:

- Amazon Titan Multimodal Gömme modeli – Bu FM, bu yazıda kullanılan slayt kümesindeki içerik için yerleştirmeler oluşturmak için kullanılır. Çok modlu bir model olarak bu Titan modeli, metni, görüntüleri veya bir kombinasyonu girdi olarak işleyebilir ve yerleştirmeler oluşturabilir. Titan Multimodal Gömme modeli, 1,024 boyutlu vektörler (gömmeler) oluşturur ve bunlara Amazon Bedrock aracılığıyla erişilir.

- Büyük Dil ve Görme Asistanı (LLaVA) – LLaVA, görsel ve dilsel anlayışa yönelik açık kaynaklı çok modlu bir modeldir ve grafikler ve tablolar gibi görsel öğeler de dahil olmak üzere slaytlardaki verileri yorumlamak için kullanılır. 7 milyar parametreli versiyonunu kullanıyoruz LLaVA 1.5-7b bu çözümde.

- Amazon Adaçayı Yapıcı – LLaVA modeli, SageMaker barındırma hizmetleri kullanılarak bir SageMaker uç noktasına dağıtılır ve ortaya çıkan uç noktayı, LLaVA modeline karşı çıkarımlar yürütmek için kullanırız. Bu çözümü uçtan uca düzenlemek ve göstermek için SageMaker dizüstü bilgisayarlarını da kullanıyoruz.

- Amazon OpenSearch Sunucusuz – OpenSearch Serverless, isteğe bağlı sunucusuz bir yapılandırmadır. Amazon Açık Arama Hizmeti. Titan Multimodal Embeddings modeli tarafından oluşturulan yerleştirmeleri depolamak için OpenSearch Serverless'ı bir vektör veritabanı olarak kullanıyoruz. OpenSearch Sunucusuz koleksiyonunda oluşturulan bir dizin, RAG çözümümüz için vektör deposu görevi görür.

- Amazon OpenSearch Kullanımı (OSI) – OSI, OpenSearch Hizmeti etki alanlarına ve OpenSearch Sunucusuz koleksiyonlara veri sağlayan, tam olarak yönetilen, sunucusuz bir veri toplayıcıdır. Bu yazıda verileri OpenSearch Sunucusuz vektör deposuna iletmek için bir OSI kanalı kullanıyoruz.

Çözüm mimarisi

Çözüm tasarımı iki bölümden oluşur: alım ve kullanıcı etkileşimi. Alma sırasında, her slaydı bir görüntüye dönüştürerek giriş slayt kümesini işleriz, bu görüntüler için yerleştirmeler oluştururuz ve ardından vektör veri deposunu doldururuz. Bu adımlar, kullanıcı etkileşimi adımlarından önce tamamlanır.

Kullanıcı etkileşimi aşamasında, kullanıcıdan gelen bir soru yerleştirmelere dönüştürülür ve potansiyel olarak kullanıcı sorusuna yanıtlar içerebilecek bir slayt bulmak için vektör veritabanında bir benzerlik araması yapılır. Daha sonra bu slaydı (bir görüntü dosyası biçiminde) LLaVA modeline ve kullanıcı sorusunu, sorguya bir yanıt oluşturma istemi olarak sağlıyoruz. Bu gönderinin tüm kodu şurada mevcuttur: GitHub Repo.

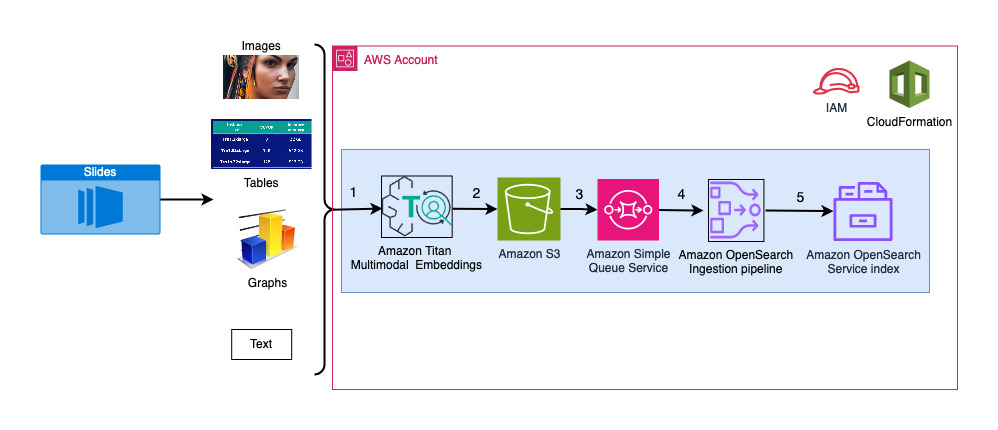

Aşağıdaki diyagram alım mimarisini göstermektedir.

İş akışı adımları aşağıdaki gibidir:

- Slaytlar, JPG formatında görüntü dosyalarına (slayt başına bir tane) dönüştürülür ve yerleştirmeler oluşturmak için Titan Multimodal Gömme modeline aktarılır. Bu yazıda başlıklı slayt destesini kullanıyoruz. AWS Trainium ve AWS Inferentia'yı kullanarak Stabil Difüzyonu eğitin ve dağıtın Çözümü göstermek için Haziran 2023'te Toronto'da düzenlenen AWS Zirvesi'nden. Örnek destesinde 31 slayt var, dolayısıyla her biri 31 boyuta sahip 1,024 set vektör yerleştirme oluşturuyoruz. Oluşturulan bu vektör yerleştirmelere ek meta veri alanları ekleyip bir JSON dosyası oluşturuyoruz. Bu ek meta veri alanları, OpenSearch'ün güçlü arama yeteneklerini kullanarak zengin arama sorguları gerçekleştirmek için kullanılabilir.

- Oluşturulan yerleştirmeler, şuraya yüklenen tek bir JSON dosyasında bir araya getirilir: Amazon Basit Depolama Hizmeti (Amazon S3).

- Üzerinden Amazon S3 Olay Bildirimleri, bir olay bir yere konur Amazon Basit Kuyruk Hizmeti (Amazon SQS) kuyruğu.

- SQS kuyruğundaki bu olay, OSI ardışık düzenini çalıştırmak için bir tetikleyici görevi görür ve bu işlem, verileri (JSON dosyası) belgeler olarak OpenSearch Sunucusuz dizinine alır. OpenSearch Sunucusuz dizininin bu işlem hattı için havuz olarak yapılandırıldığını ve OpenSearch Sunucusuz koleksiyonunun parçası olarak oluşturulduğunu unutmayın.

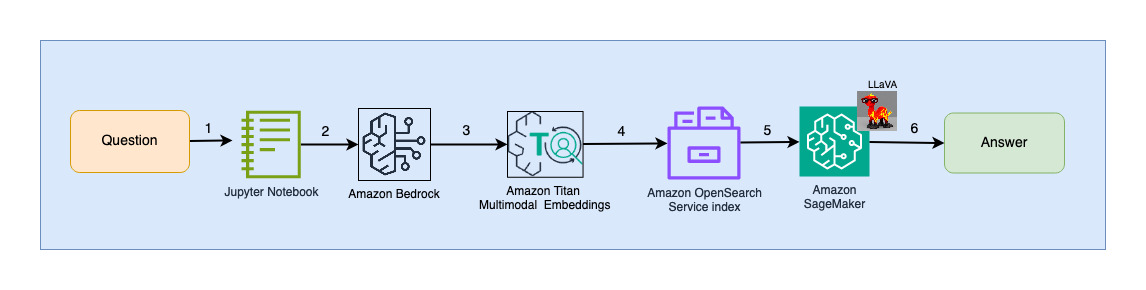

Aşağıdaki şema kullanıcı etkileşimi mimarisini göstermektedir.

İş akışı adımları aşağıdaki gibidir:

- Kullanıcı, alınan slayt kümesiyle ilgili bir soru gönderir.

- Kullanıcı girişi, Amazon Bedrock aracılığıyla erişilen Titan Multimodal Embeddings modeli kullanılarak yerleştirmelere dönüştürülür. Bu yerleştirmeler kullanılarak bir OpenSearch vektör araması gerçekleştirilir. Kullanıcı sorgusuyla eşleşen en alakalı yerleştirmeyi almak için k-en yakın komşu (k=1) araması gerçekleştiririz. k=1 ayarı, kullanıcı sorusuyla en alakalı slaydı getirir.

- OpenSearch Serverless'tan gelen yanıtın meta verileri, en alakalı slayda karşılık gelen görüntünün yolunu içerir.

- Kullanıcı sorusu ve görüntü yolu birleştirilerek bir bilgi istemi oluşturulur ve SageMaker'da barındırılan LLaVA'ya sağlanır. LLaVA modeli, görseldeki verileri inceleyerek kullanıcı sorusunu anlayıp cevaplayabilmektedir.

- Bu çıkarımın sonucu kullanıcıya döndürülür.

Bu adımlar aşağıdaki bölümlerde ayrıntılı olarak ele alınmaktadır. Bkz. Sonuçlar Çıktıya ilişkin ekran görüntüleri ve ayrıntılar için bölüm.

Önkoşullar

Bu gönderide sağlanan çözümü uygulamak için bir AWS hesabı ve FM'ler, Amazon Bedrock, SageMaker ve OpenSearch Service'e aşinalık.

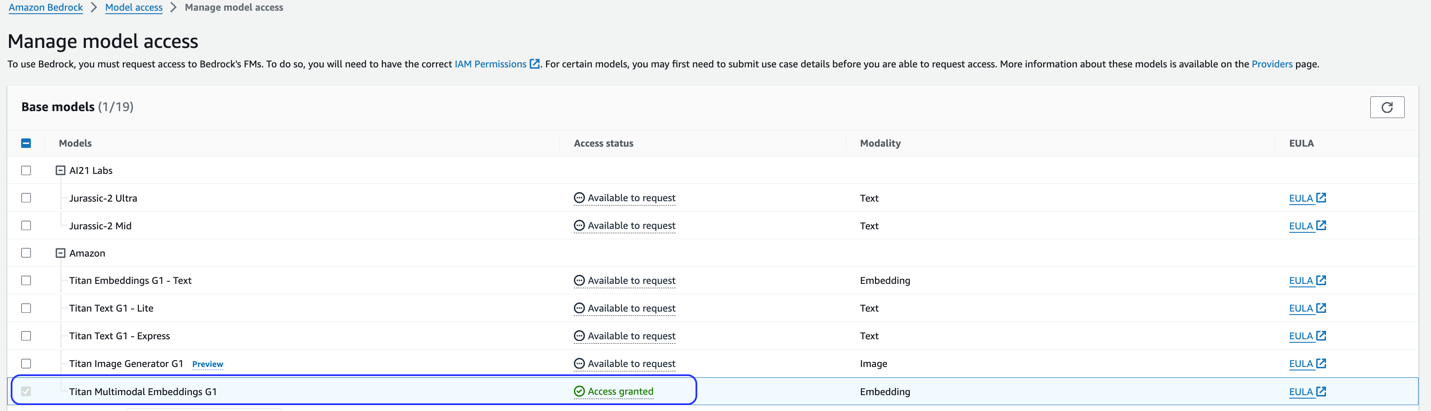

Bu çözüm Titan Multimodal Gömme modelini kullanır. Bu modelin Amazon Bedrock'ta kullanım için etkinleştirildiğinden emin olun. Amazon Bedrock konsolunda şunu seçin: Model erişimi Gezinti bölmesinde. Titan Multimodal Embeddings etkinleştirilirse erişim durumu şunu belirtir: Erişim izni.

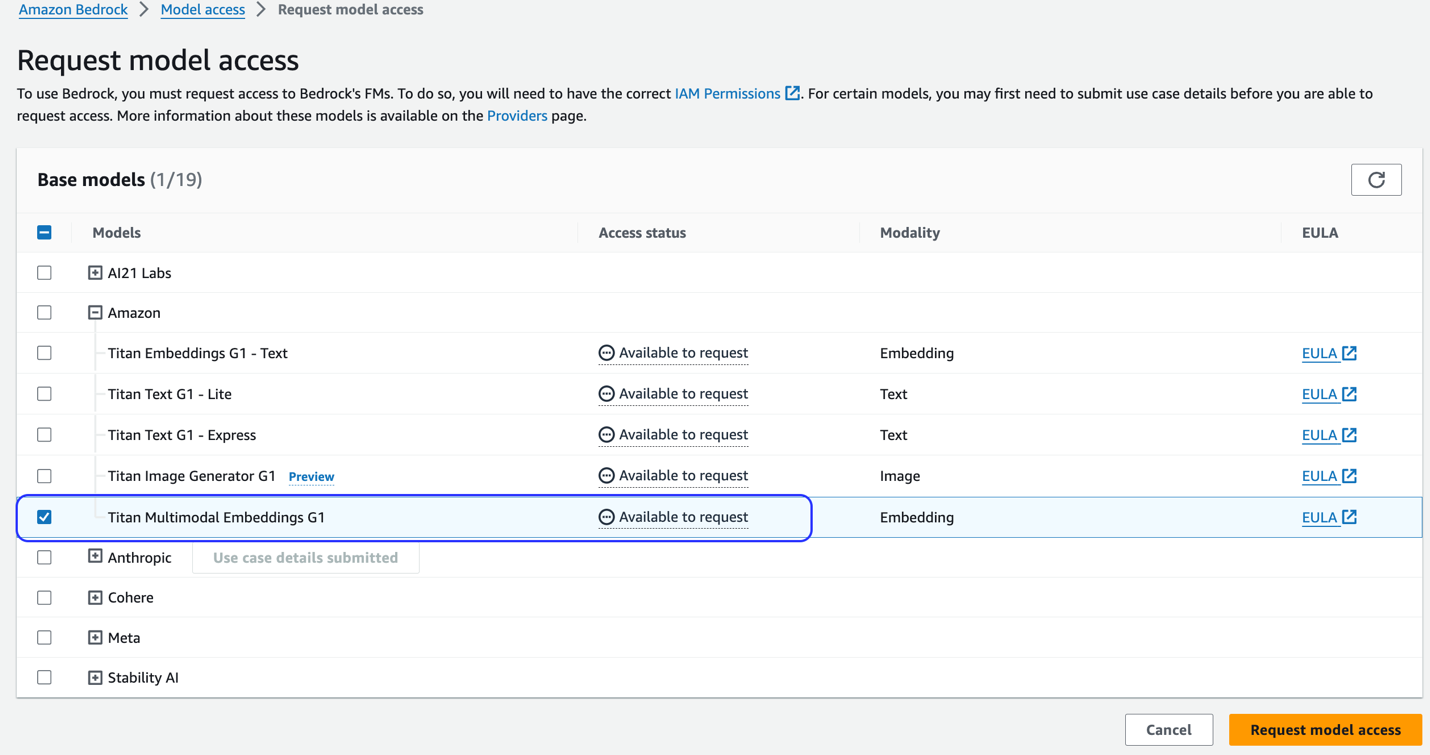

Model mevcut değilse, seçimini yaparak modele erişimi etkinleştirin. Model Erişimini Yönetin, seçerek Titan Multimodal Gömmeler G1ve seçerek Model erişimi iste. Model hemen kullanıma etkinleştirilir.

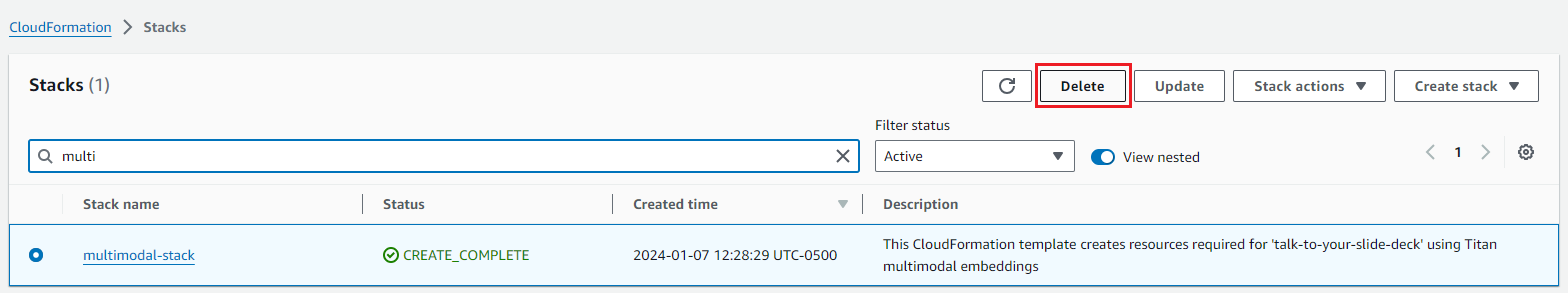

Çözüm yığınını oluşturmak için bir AWS CloudFormation şablonu kullanın

Aşağıdakilerden birini kullanın AWS CloudFormation çözüm kaynaklarını başlatmak için şablonlar (Bölgenize bağlı olarak).

| AWS Bölgesi | Link |

|---|---|

us-east-1 |

|

us-west-2 |

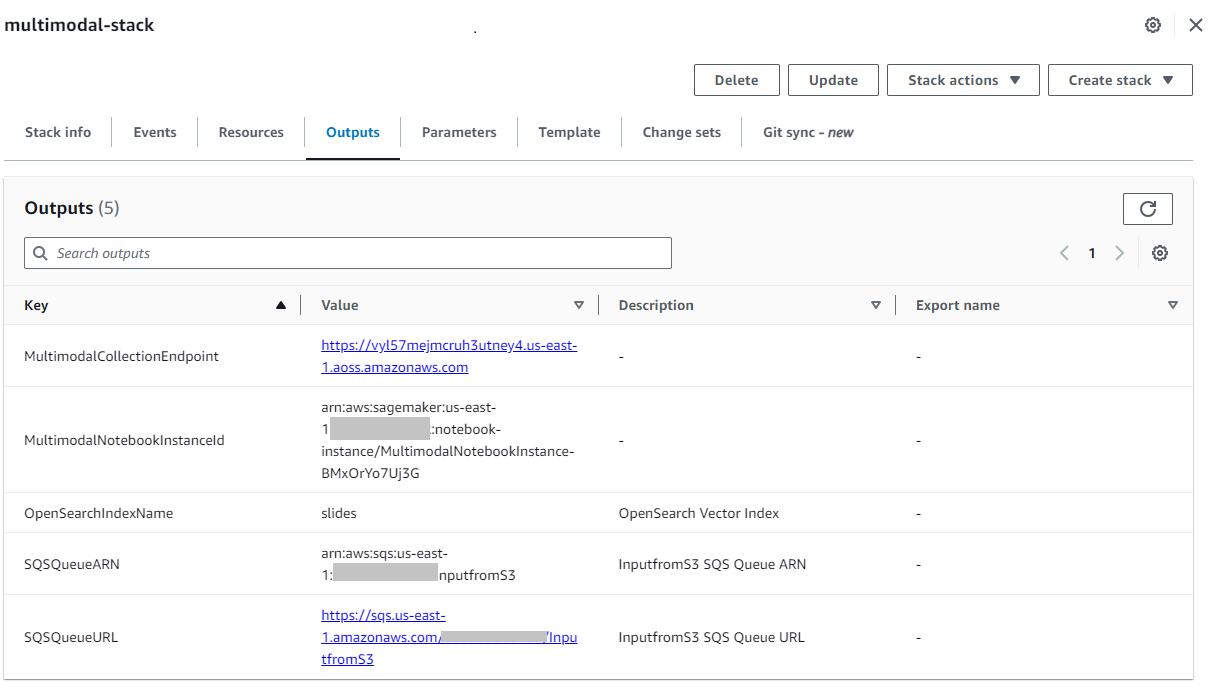

Yığın başarıyla oluşturulduktan sonra yığının bulunduğu konuma gidin. Çıkışlar AWS CloudFormation konsolunda sekmeyi açın ve değerini not edin. MultimodalCollectionEndpointsonraki adımlarda kullanacağımız.

CloudFormation şablonu aşağıdaki kaynakları oluşturur:

- IAM rolleri - Aşağıdaki AWS Kimlik ve Erişim Yönetimi (IAM) rolleri oluşturulur. Uygulamak için bu rolleri güncelleyin en az ayrıcalıklı izinler.

SMExecutionRoleAmazon S3, SageMaker, OpenSearch Service ve Bedrock tam erişimiyle.OSPipelineExecutionRolebelirli Amazon SQS ve OSI eylemlerine erişimle.

- SageMaker not defteri – Bu gönderinin tüm kodu bu not defteri aracılığıyla çalıştırılıyor.

- OpenSearch Sunucusuz koleksiyonu – Bu, yerleştirmeleri depolamak ve almak için kullanılan vektör veritabanıdır.

- OSI boru hattı – Bu, OpenSearch Sunucusuz'a veri almak için kullanılan boru hattıdır.

- S3 kepçe – Bu gönderiye ait tüm veriler bu pakette saklanır.

- SQS kuyruğu – OSI işlem hattı çalıştırmasını tetiklemeye yönelik olaylar bu kuyruğa konur.

CloudFormation şablonu, OSI işlem hattını kaynak olarak Amazon S3 ve Amazon SQS işleme ve havuz olarak OpenSearch Sunucusuz dizin ile yapılandırır. Belirtilen S3 klasöründe ve önekinde oluşturulan tüm nesneler (multimodal/osi-embeddings-json), verileri OpenSearch Serverless'a almak için OSI hattı tarafından kullanılan SQS bildirimlerini tetikleyecektir.

CloudFormation şablonu ayrıca şunları oluşturur: ağ, şifreleme, ve veri erişim OpenSearch Sunucusuz koleksiyonu için gereken politikalar. En az ayrıcalıklı izinleri uygulamak için bu politikaları güncelleyin.

SageMaker not defterlerinde CloudFormation şablon adına başvurulduğunu unutmayın. Varsayılan şablon adı değiştirilirse aynısını şu adreste güncellediğinizden emin olun: globals.py

Çözümü test edin

Önkoşul adımları tamamlandıktan ve CloudFormation yığını başarıyla oluşturulduktan sonra artık çözümü test etmeye hazırsınız:

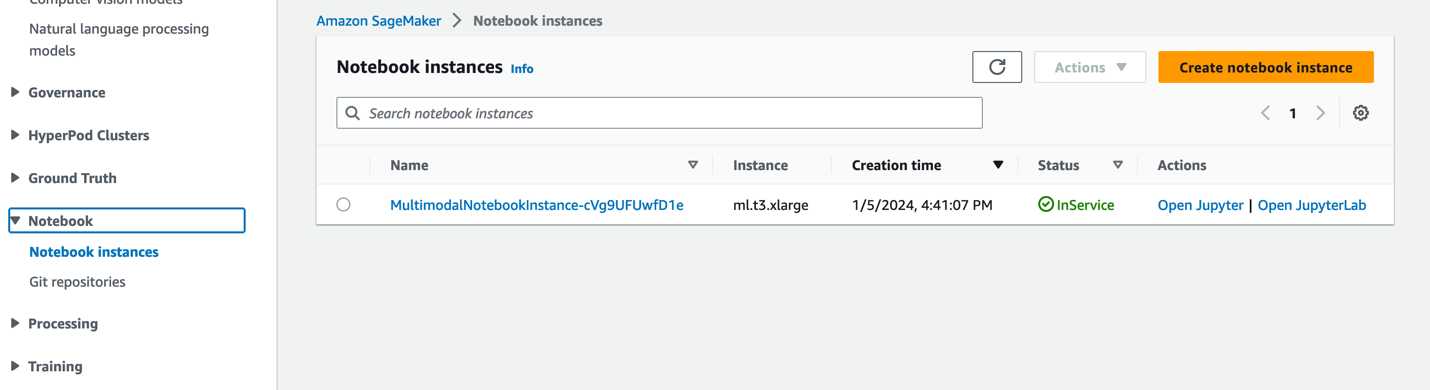

- SageMaker konsolunda, Defterler Gezinti bölmesinde.

- seçmek

MultimodalNotebookInstancenot defteri örneğini seçin ve seçin JupyterLab'ı aç.

- In Dosya Tarayıcı, not defterlerini ve destekleyici dosyaları görmek için not defterleri klasörüne gidin.

Not defterleri çalıştırıldıkları sıraya göre numaralandırılır. Her not defterindeki talimatlar ve yorumlar, o not defterinin gerçekleştirdiği eylemleri açıklar. Bu defterleri tek tek çalıştırıyoruz.

- Klinik 0_deploy_llava.ipynb JupyterLab'da açmak için.

- Üzerinde koşmak menü seç Tüm Hücreleri Çalıştır kodu bu not defterinde çalıştırmak için.

Bu dizüstü bilgisayar, LLaVA-v1.5-7B modelini bir SageMaker uç noktasına dağıtır. Bu not defterinde LLaVA-v1.5-7B modelini HuggingFace Hub'dan indiriyoruz, inference.py betiğini değiştiriyoruz llava_inference.pyve bu model için bir model.tar.gz dosyası oluşturun. model.tar.gz dosyası Amazon S3'e yüklenir ve modeli SageMaker uç noktasında dağıtmak için kullanılır. llava_inference.py betiğinde Amazon S3'ten bir görüntü dosyasının okunmasına ve bu dosya üzerinde çıkarım yapılmasına izin veren ek kod bulunur.

- Klinik 1_data_prep.ipynb JupyterLab'da açmak için.

- Üzerinde koşmak menü seç Tüm Hücreleri Çalıştır kodu bu not defterinde çalıştırmak için.

Bu not defteri şunları indirir: kaygan güverte, her slaydı JPG dosya formatına dönüştürür ve bunları bu gönderi için kullanılan S3 klasörüne yükler.

- Klinik 2_data_ingestion.ipynb JupyterLab'da açmak için.

- Üzerinde koşmak menü seç Tüm Hücreleri Çalıştır kodu bu not defterinde çalıştırmak için.

Bu not defterinde şunları yapıyoruz:

- OpenSearch Serverless koleksiyonunda bir indeks oluşturuyoruz. Bu dizin, slayt kümesine ilişkin yerleştirme verilerini saklar. Aşağıdaki koda bakın:

- Önceki not defterinde oluşturulan JPG görüntülerini vektör gömmelerine dönüştürmek için Titan Multimodal Gömme modelini kullanıyoruz. Bu yerleştirmeler ve ek meta veriler (görüntü dosyasının S3 yolu gibi) bir JSON dosyasında depolanır ve Amazon S3'e yüklenir. Yerleştirmelere dönüştürülen tüm slaytlara (resimlere) ilişkin belgeleri içeren tek bir JSON dosyasının oluşturulduğunu unutmayın. Aşağıdaki kod parçacığı, bir görüntünün (Base64 kodlu dize biçiminde) yerleştirmelere nasıl dönüştürüldüğünü gösterir:

- Bu eylem, dosyayı işleyen ve OpenSearch Sunucusuz dizinine aktaran OpenSearch Ingestion ardışık düzenini tetikler. Aşağıda oluşturulan JSON dosyasının bir örneği bulunmaktadır. (Örnek kodda dört boyutlu bir vektör gösterilmektedir. Titan Multimodal Gömmeler modeli 1,024 boyut üretir.)

- Klinik 3_rag_inference.ipynb JupyterLab'da açmak için.

- Üzerinde koşmak menü seç Tüm Hücreleri Çalıştır kodu bu not defterinde çalıştırmak için.

Bu not defteri RAG çözümünü uyguluyor: kullanıcı sorusunu yerleştirmelere dönüştürüyoruz, vektör veritabanından benzer bir görüntü (slayt) buluyoruz ve alınan görüntüyü kullanıcı sorusuna bir yanıt oluşturmak için LLaVA'ya sağlıyoruz. Aşağıdaki bilgi istemi şablonunu kullanıyoruz:

Aşağıdaki kod parçacığı RAG iş akışını sağlar:

Sonuçlar

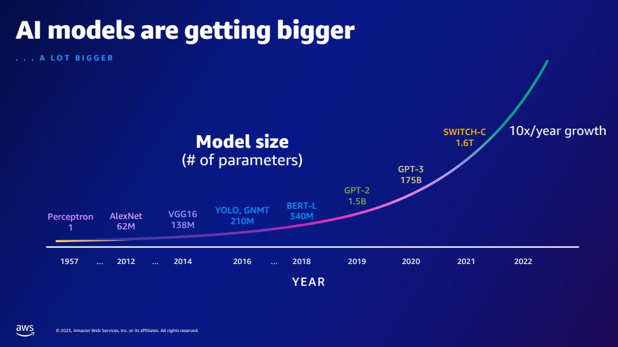

Aşağıda, uygulamamız tarafından oluşturulan bazı kullanıcı sorularının ve yanıtlarının bir derlemesi bulunmaktadır. Soru sütunu kullanıcı sorusunu yakalar ve Cevap sütunu, LLaVA tarafından oluşturulan metinsel yanıttır. Resim OpenSearch Sunucusuz vektör aramasının döndürdüğü k-en yakın (k=1) slayt eşleşmesidir. Bu slayt, cevabı sağlamak için LLaVA tarafından yorumlanmıştır.

Çok modlu RAG sonuçları

| Soru | Cevap | Resim |

|---|---|---|

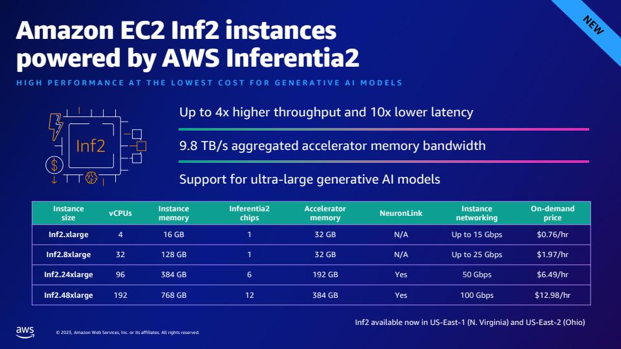

| Inf2'nin performansı karşılaştırılabilir EC2 bulut sunucularıyla nasıl karşılaştırılır? Numaralara ihtiyacım var. | Slayt sunumuna göre AWS Inferentia2'nin Inf2 bulut sunucuları, benzer EC4 bulut sunucularına kıyasla 10 kata kadar daha yüksek aktarım hızı ve 2 kat daha düşük gecikme süresi sunuyor. |  |

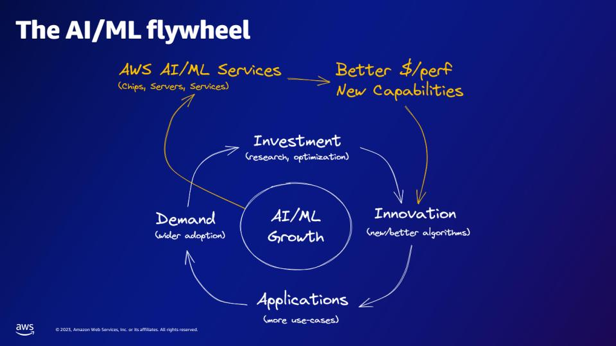

| AI/ML çarkına göre AWS AI/ML hizmetleri neler sağlar? | AWS AI/ML hizmetleri daha iyi $/perfer özellikleri, yeni özellikler ve inovasyona yatırım sağlar. |  |

| GPT-2 ile karşılaştırıldığında GPT-3'ün kaç parametresi daha var? GPT-2 ile GPT-3'ün parametre boyutu arasındaki sayısal fark nedir? | Slayta göre GPT-3'te 175 milyar parametre bulunurken, GPT-2'de 1.5 milyar parametre bulunuyor. GPT-2 ile GPT-3'ün parametre büyüklüğü arasındaki sayısal fark 173.5 milyardır. |  |

| Parçacık fiziğinde kuarklar nelerdir? | Bu sorunun cevabını slaytta bulamadım. |  |

Bu çözümü slayt sunumlarınıza genişletmekten çekinmeyin. Globals.py'deki SLIDE_DECK değişkenini slayt destenizin bir URL'siyle güncelleyin ve önceki bölümde ayrıntılı olarak açıklanan besleme adımlarını çalıştırın.

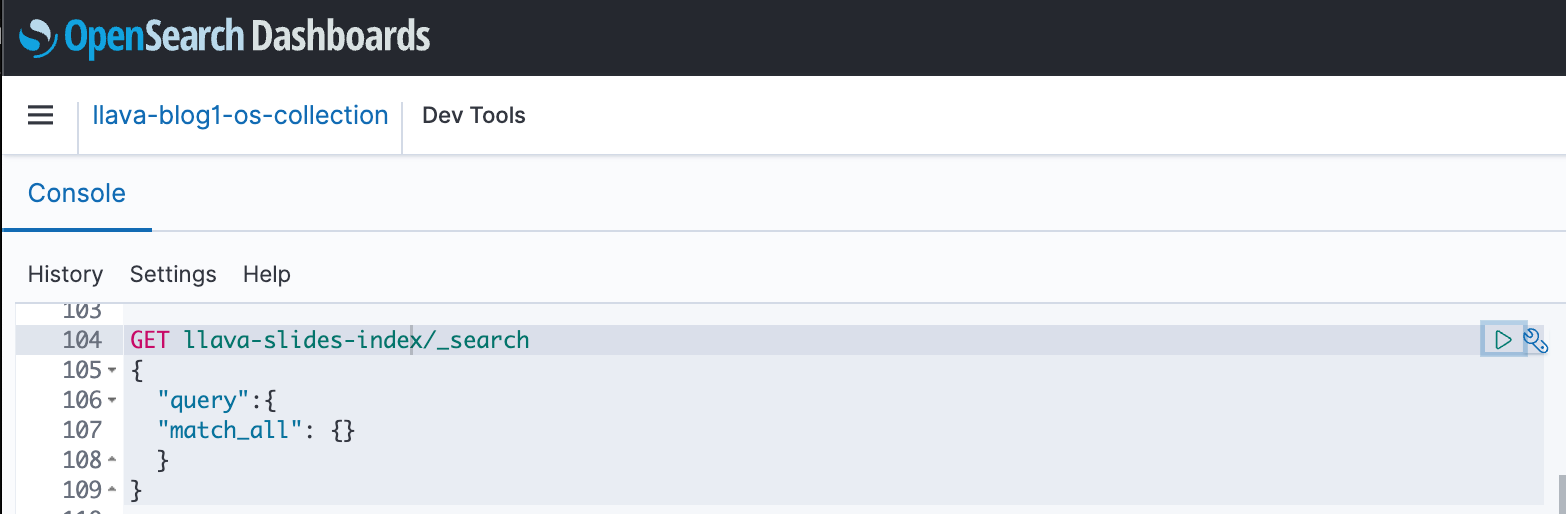

Bahşiş

Dizininiz ve alınan verileriniz üzerinde hızlı testler gerçekleştirmek üzere OpenSearch API ile etkileşimde bulunmak için OpenSearch Kontrol Panellerini kullanabilirsiniz. Aşağıdaki ekran görüntüsünde bir OpenSearch kontrol paneli GET örneği gösterilmektedir.

Temizlemek

Gelecekte masraf oluşmasını önlemek için oluşturduğunuz kaynakları silin. Bunu CloudFormation konsolu aracılığıyla yığını silerek yapabilirsiniz.

Ayrıca, LLaVA çıkarımı için oluşturulan SageMaker çıkarım uç noktasını silin. Bunu, temizleme adımının açıklamasını kaldırarak yapabilirsiniz. 3_rag_inference.ipynb ve hücreyi çalıştırarak veya SageMaker konsolu aracılığıyla uç noktayı silerek: sonuç ve Uç noktalar Gezinti bölmesinde uç noktayı seçin ve silin.

Sonuç

İşletmeler her zaman yeni içerik üretir ve slayt sunumları, bilgiyi kurum içinde kurumla, kurum dışında ise müşterilerle veya konferanslarda paylaşmak ve yaymak için kullanılan yaygın bir mekanizmadır. Zamanla zengin bilgiler, bu slayt destelerindeki grafikler ve tablolar gibi metin dışı yöntemlerde gömülü ve gizli kalabilir. Yeni bilgiler keşfetmek veya slayt destelerindeki içerikle ilgili yeni bakış açılarını ortaya çıkarmak için bu çözümü ve Titan Multimodal Embeddings modeli ve LLaVA gibi multimodal FM'lerin gücünü kullanabilirsiniz.

Keşfederek daha fazlasını öğrenmenizi öneririz. Amazon SageMaker Hızlı Başlangıç, Amazon Titan modelleri, Amazon Bedrock ve OpenSearch Service ile bu yazıda sağlanan örnek uygulamayı kullanarak bir çözüm oluşturma.

Bu serinin bir parçası olarak iki ek gönderiye dikkat edin. Bölüm 2, slayt destenizle konuşmak için kullanabileceğiniz başka bir yaklaşımı kapsamaktadır. Bu yaklaşım, LLaVA çıkarımlarını oluşturur ve saklar ve bu saklanan çıkarımları kullanıcı sorgularına yanıt vermek için kullanır. Bölüm 3 iki yaklaşımı karşılaştırmaktadır.

yazarlar hakkında

Amit Arora Amazon Web Services'ta Yapay Zeka ve Makine Öğrenimi Uzmanı Mimardır ve kurumsal müşterilerin yeniliklerini hızla ölçeklendirmek için bulut tabanlı makine öğrenimi hizmetlerini kullanmalarına yardımcı olur. Ayrıca Washington DC'deki Georgetown Üniversitesi'nde MS veri bilimi ve analitik programında yardımcı öğretim görevlisidir.

Amit Arora Amazon Web Services'ta Yapay Zeka ve Makine Öğrenimi Uzmanı Mimardır ve kurumsal müşterilerin yeniliklerini hızla ölçeklendirmek için bulut tabanlı makine öğrenimi hizmetlerini kullanmalarına yardımcı olur. Ayrıca Washington DC'deki Georgetown Üniversitesi'nde MS veri bilimi ve analitik programında yardımcı öğretim görevlisidir.

Manju Prasad Amazon Web Services'te Stratejik Hesaplar bünyesinde Kıdemli Çözüm Mimarıdır. Önemli bir izleme ve değerlendirme müşterisine AI/ML dahil olmak üzere çeşitli alanlarda teknik rehberlik sağlamaya odaklanmaktadır. AWS'ye katılmadan önce finansal hizmetler sektöründeki şirketlerin yanı sıra yeni kurulan şirketler için çözümler tasarladı ve üretti.

Manju Prasad Amazon Web Services'te Stratejik Hesaplar bünyesinde Kıdemli Çözüm Mimarıdır. Önemli bir izleme ve değerlendirme müşterisine AI/ML dahil olmak üzere çeşitli alanlarda teknik rehberlik sağlamaya odaklanmaktadır. AWS'ye katılmadan önce finansal hizmetler sektöründeki şirketlerin yanı sıra yeni kurulan şirketler için çözümler tasarladı ve üretti.

Archana Inapudi AWS'de stratejik müşterileri destekleyen Kıdemli Çözüm Mimarıdır. Müşterilerin veri analitiği ve veritabanı çözümleri tasarlamasına ve oluşturmasına yardımcı olma konusunda on yıldan fazla deneyime sahiptir. Müşterilere değer sağlamak ve iş sonuçlarına ulaşmak için teknolojiyi kullanma konusunda tutkulu.

Archana Inapudi AWS'de stratejik müşterileri destekleyen Kıdemli Çözüm Mimarıdır. Müşterilerin veri analitiği ve veritabanı çözümleri tasarlamasına ve oluşturmasına yardımcı olma konusunda on yıldan fazla deneyime sahiptir. Müşterilere değer sağlamak ve iş sonuçlarına ulaşmak için teknolojiyi kullanma konusunda tutkulu.

Antara Raisa Amazon Web Services'te Dallas, Teksas merkezli stratejik müşterilere destek veren bir Yapay Zeka ve Makine Öğrenimi Çözüm Mimarıdır. Ayrıca AWS'de büyük kurumsal iş ortaklarıyla çalışma deneyimine sahip olup burada dijital yerel müşteriler için İş Ortağı Başarı Çözümleri Mimarı olarak çalışmıştır.

Antara Raisa Amazon Web Services'te Dallas, Teksas merkezli stratejik müşterilere destek veren bir Yapay Zeka ve Makine Öğrenimi Çözüm Mimarıdır. Ayrıca AWS'de büyük kurumsal iş ortaklarıyla çalışma deneyimine sahip olup burada dijital yerel müşteriler için İş Ortağı Başarı Çözümleri Mimarı olarak çalışmıştır.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/talk-to-your-slide-deck-using-multimodal-foundation-models-hosted-on-amazon-bedrock-and-amazon-sagemaker-part-1/