Introductie

De afgelopen jaren is het vakgebied van de kunstmatige intelligentie (AI) getuige geweest van een opmerkelijke stijging in de ontwikkeling van generatieve AI-modellen. Deze modellen kunnen mensachtige tekst genereren, beelden en zelfs audio, waarbij de grenzen worden verlegd van wat ooit voor onmogelijk werd gehouden. Van deze modellen valt de Generative Pre-trained Transformer (GPT) op als een baanbrekende doorbraak in natuurlijke taalverwerking (NLP). Laten we de ingewikkelde architectuur van GPT's verkennen en ontdekken hoe ze generatieve AI- en NLP-taken gemakkelijk verwerken.

Inhoudsopgave

De opkomst van generatieve AI-modellen

Generatieve AI-modellen zijn daar een klasse van machine learning modellen die nieuwe gegevens, zoals tekst, afbeeldingen of audio, helemaal opnieuw kunnen creëren. Deze modellen zijn getraind op grote hoeveelheden bestaande gegevens, waardoor ze de onderliggende patronen en structuren kunnen leren kennen. Eenmaal getraind kunnen ze nieuwe, originele inhoud genereren die de kenmerken van de trainingsgegevens nabootst.

De opkomst van generatieve AI-modellen wordt aangewakkerd door de vooruitgang in deep learning-technieken, met name in neurale netwerken. Diepe leer algoritmen zijn opmerkelijk effectief gebleken in het vastleggen van complexe patronen in gegevens, waardoor ze zeer geschikt zijn voor generatieve taken. Naarmate de rekenkracht en de toegang tot grote datasets zijn toegenomen, hebben onderzoekers steeds geavanceerdere generatieve modellen kunnen trainen.

De mysteries van GPT

GPT-modellen zijn een soort groot taalmodel (LLM) dat gebruik maakt van de kracht van neurale netwerken om mensachtige tekst te begrijpen en te genereren. Deze modellen zijn ‘generatief’ omdat ze nieuwe, samenhangende tekst kunnen produceren op basis van de patronen die zijn geleerd uit enorme datasets. Ze zijn ‘voorgetraind’ omdat ze een initiële trainingsfase ondergaan over grote hoeveelheden tekstgegevens. Hierdoor kunnen ze een brede kennisbasis verwerven voordat ze worden afgestemd op specifieke taken.

De ‘transformator’-architectuur is de kerninnovatie die GPT-modellen naar ongekende prestatieniveaus heeft gestuwd. transformers zijn een type neuraal netwerk dat is ontworpen om sequentiële gegevens, zoals tekst, effectiever te verwerken dan traditionele modellen. Ze maken gebruik van een nieuw aandachtsmechanisme waarmee het model het belang van verschillende delen van de input kan afwegen bij het genereren van output. Hierdoor kan het lange-afstandsafhankelijkheden vastleggen en meer samenhangende en contextueel relevante tekst produceren.

Het ontleden van de GPT-architectuur

De GPT-architectuur is een krachtige combinatie van drie belangrijke componenten: de generatieve mogelijkheden, de pre-trainingsaanpak en het transformerende neurale netwerk. Elk van deze pijlers speelt een cruciale rol bij het mogelijk maken dat GPT-modellen hun opmerkelijke prestaties in NLP-taken kunnen bereiken.

De drie pijlers: generatief, voorgetraind en transformerend

Het ‘generatieve’ aspect van GPT-modellen verwijst naar hun vermogen om nieuwe, samenhangende tekst te genereren op basis van de patronen die ze hebben geleerd uit enorme hoeveelheden trainingsgegevens. Traditionele taalmodellen richten zich vooral op het begrijpen en analyseren van tekst. In tegenstelling tot deze zijn GPT-modellen ontworpen om mensachtige tekstuitvoer te produceren, waardoor ze zeer veelzijdig zijn voor een verscheidenheid aan toepassingen.

Het “voorgetrainde” onderdeel van GPT-modellen omvat een initiële trainingsfase waarin het model wordt blootgesteld aan een enorm corpus aan tekstgegevens. Tijdens deze pre-trainingsfase leert het model de onderliggende patronen, structuren en relaties binnen de gegevens vast te leggen. Dit helpt het effectief een brede kennisbasis op te bouwen. De pre-trainingsfase is van cruciaal belang, omdat hierdoor het model een algemeen begrip van taal kan verwerven voordat het wordt verfijnd.

De ‘transformator’-architectuur is de neurale netwerkruggengraat van GPT-modellen. Transformers zijn deep learning-modellen die speciaal zijn ontworpen om sequentiële gegevens, zoals tekst, effectiever te verwerken dan traditionele modellen. Ze maken gebruik van een nieuw aandachtsmechanisme waarmee het model het belang van verschillende delen van de input kan afwegen bij het genereren van output. Hierdoor kan het lange-afstandsafhankelijkheden vastleggen en meer samenhangende en contextueel relevante tekst produceren.

Hoe GPT's coherente zinnen produceren

GPT-modellen genereren tekst door het volgende woord of token in een reeks te voorspellen op basis van de context die door de voorgaande woorden of tokens wordt geboden. Dit proces wordt bereikt door een reeks berekeningen binnen de transformatorarchitectuur. Het begint met het tokeniseren van de invoertekst en het transformeren ervan in numerieke representaties (inbedding). Deze inbedding gaat vervolgens door meerdere lagen van de transformator. Hier zorgt het aandachtsmechanisme ervoor dat het model de relaties tussen verschillende delen van de input kan vastleggen en contextueel relevante output kan genereren.

De uitvoer van het model is a kansverdeling over de hele woordenschat, wat aangeeft hoe waarschijnlijk het is dat elk woord of token het volgende in de reeks is. Tijdens de inferentie bemonstert het model deze distributie om het volgende token te genereren, dat aan de invoerreeks wordt toegevoegd. Dit proces herhaalt zich totdat de gewenste uitvoerlengte is bereikt of aan een stopvoorwaarde is voldaan.

Gebruikmaken van enorme datasets voor betere prestaties

Een van de belangrijkste voordelen van GPT-modellen is hun vermogen om enorme datasets te benutten tijdens de pre-trainingsfase. Deze datasets kunnen bestaan uit miljarden woorden uit verschillende bronnen, zoals boeken, artikelen, websites en sociale media. Dit geeft het model een gevarieerde en uitgebreide blootstelling aan natuurlijke taal.

Tijdens de pre-training moet het model het volgende woord of token in de reeks voorspellen, vergelijkbaar met het proces voor het genereren van tekst. In plaats van nieuwe tekst te genereren, leert het model echter de onderliggende patronen en relaties binnen de trainingsgegevens vast te leggen. Deze pre-trainingsfase is rekenintensief maar cruciaal. Hierdoor kan het model een breed begrip van taal ontwikkelen, dat vervolgens kan worden verfijnd voor specifieke taken.

Door tijdens de pre-training gebruik te maken van enorme datasets kunnen GPT-modellen een enorme kennisbasis verwerven. Ze kunnen ook een diep begrip ontwikkelen van taalstructuren, idiomatische uitdrukkingen en contextuele nuances. Deze uitgebreide voortraining zorgt voor een sterke basis voor het model. Hierdoor kan het model goed presteren op een breed scala aan downstream-taken met relatief weinig taakspecifieke verfijning.

Het neurale netwerk achter de magie

De transformatorarchitectuur is de kerninnovatie die de GPT-modellen aandrijft en een revolutie teweeg heeft gebracht op het gebied van NLP. In tegenstelling tot traditioneel terugkerende neurale netwerken (RNN's), die sequentiële gegevens verwerken, gebruiken transformatoren een nieuw aandachtsmechanisme waarmee ze langeafstandsafhankelijkheden kunnen vastleggen en invoerreeksen efficiënt parallel kunnen verwerken.

De transformatorarchitectuur bestaat uit meerdere lagen, elk bestaande uit twee hoofdcomponenten: het multi-head aandachtsmechanisme en het feed-forward neurale netwerk. Het aandachtsmechanisme is verantwoordelijk voor het afwegen van het belang van verschillende delen van de invoerreeks bij het genereren van uitvoer, waardoor het model de context en relaties tussen op afstand gelegen elementen in de reeks kan vastleggen.

De feed-forward neurale netwerklagen zijn verantwoordelijk voor de verdere verwerking en verfijning van de output van het aandachtsmechanisme, waardoor het model complexere representaties van de invoergegevens kan leren.

Het geparallelliseerde verwerkings- en aandachtsmechanisme van de transformatorarchitectuur is zeer effectief gebleken bij het verwerken van lange reeksen en het vastleggen van afhankelijkheden op lange afstand, die cruciaal zijn voor NLP-taken. Deze architectuur heeft ervoor gezorgd dat GPT-modellen state-of-the-art prestaties kunnen leveren. Het heeft ook de ontwikkeling van andere op transformatoren gebaseerde modellen in verschillende domeinen beïnvloed, zoals computervisie en spraakherkenning.

Binnenin de Transformator

De transformatorarchitectuur is de kerncomponent die GPT-modellen in staat stelt hun opmerkelijke prestaties in NLP-taken te bereiken. Laten we de belangrijkste stappen die betrokken zijn bij de verwerking van tekstgegevens door de transformator eens nader bekijken.

Tokenisatie: tekst opsplitsen in verteerbare brokken

Voordat de transformator tekst kan verwerken, moeten de invoergegevens worden opgesplitst in kleinere eenheden die tokens worden genoemd. tokenization is het proces waarbij de tekst in deze tokens wordt gesplitst, wat woorden, subwoorden of zelfs individuele tekens kunnen zijn. Deze stap is cruciaal omdat de transformator hierdoor reeksen van verschillende lengtes kan verwerken en zeldzame of buiten de woordenschat voorkomende woorden effectief kan weergeven. Het tokenisatieproces omvat doorgaans technieken zoals woordsegmentatie, het omgaan met interpunctie en het omgaan met speciale tekens.

Woordinsluitingen: woorden toewijzen aan numerieke vectoren

Zodra de tekst is tokenized, wordt elk token toegewezen aan een numerieke vectorrepresentatie die woordinbedding wordt genoemd. Deze woordinsluitingen zijn compacte vectoren die semantische en syntactische informatie vastleggen over de woorden die ze vertegenwoordigen. De transformator gebruikt deze inbedding als invoer, waardoor deze tekstgegevens kan verwerken in een numeriek formaat dat efficiënt kan worden gemanipuleerd door de neurale netwerkarchitectuur. Woordinbedding wordt geleerd tijdens het trainingsproces, waarbij woorden met vergelijkbare betekenissen vaak vergelijkbare vectorrepresentaties hebben, waardoor het model semantische relaties en context kan vastleggen.

Het aandachtsmechanisme: het hart van de transformator

Het aandachtsmechanisme is de belangrijkste innovatie die transformatoren onderscheidt van traditionele neurale netwerkarchitecturen. Hierdoor kan het model zich selectief concentreren op relevante delen van de invoerreeks bij het genereren van uitvoer, waardoor afhankelijkheden en context op lange afstand effectief worden vastgelegd. De aandachtsmechanisme werkt door aandachtsscores te berekenen die het belang van elk invoerelement voor een bepaald uitvoerelement vertegenwoordigen, en deze scores vervolgens te gebruiken om de overeenkomstige invoerrepresentaties te wegen. Dit mechanisme stelt de transformator in staat om reeksen van verschillende lengtes effectief te verwerken en relaties tussen op afstand gelegen elementen in de invoer vast te leggen, wat cruciaal is voor taken als automatische vertaling en taalgeneratie.

Meerlaagse perceptrons: vectorrepresentaties verbeteren

Naast het aandachtsmechanisme bevatten transformatoren ook meerlaagse perceptrons (MLP's), dit zijn feed-forward neurale netwerken. Deze MLP's worden gebruikt om de vectorrepresentaties die door het aandachtsmechanisme worden geproduceerd verder te verwerken en te verfijnen, waardoor het model complexere patronen en relaties in de gegevens kan vastleggen. De MLP's nemen de output van het aandachtsmechanisme als input en passen een reeks lineaire transformaties en niet-lineaire activeringsfuncties toe om de vectorrepresentaties te verbeteren. Deze stap is cruciaal voor het model om functies en representaties op een hoger niveau te leren die nuttig zijn voor de daaropvolgende taak.

Een GPT-model trainen

Het trainen van een GPT-model is een complex en rekenintensief proces dat verschillende belangrijke componenten en technieken omvat.

Backpropagation: het algoritme dat GPT's slimmer maakt

De kern van het trainen van GPT-modellen is het backpropagation-algoritme, een veelgebruikte techniek bij deep learning voor het bijwerken van de gewichten en parameters van het model op basis van de fouten die het maakt tijdens de training. Tijdens terugvermeerdering, worden de voorspellingen van het model vergeleken met de ground-truth-labels, en worden de fouten achterwaarts door het netwerk gepropageerd om de gewichten aan te passen en de algehele fout te minimaliseren. Dit proces omvat het berekenen van de gradiënten van de verliesfunctie met betrekking tot de parameters van het model en het bijwerken van de parameters in de richting die het verlies minimaliseert. Backpropagation is een essentieel onderdeel van het trainingsproces, omdat het het model in staat stelt van zijn fouten te leren en zijn prestaties geleidelijk te verbeteren.

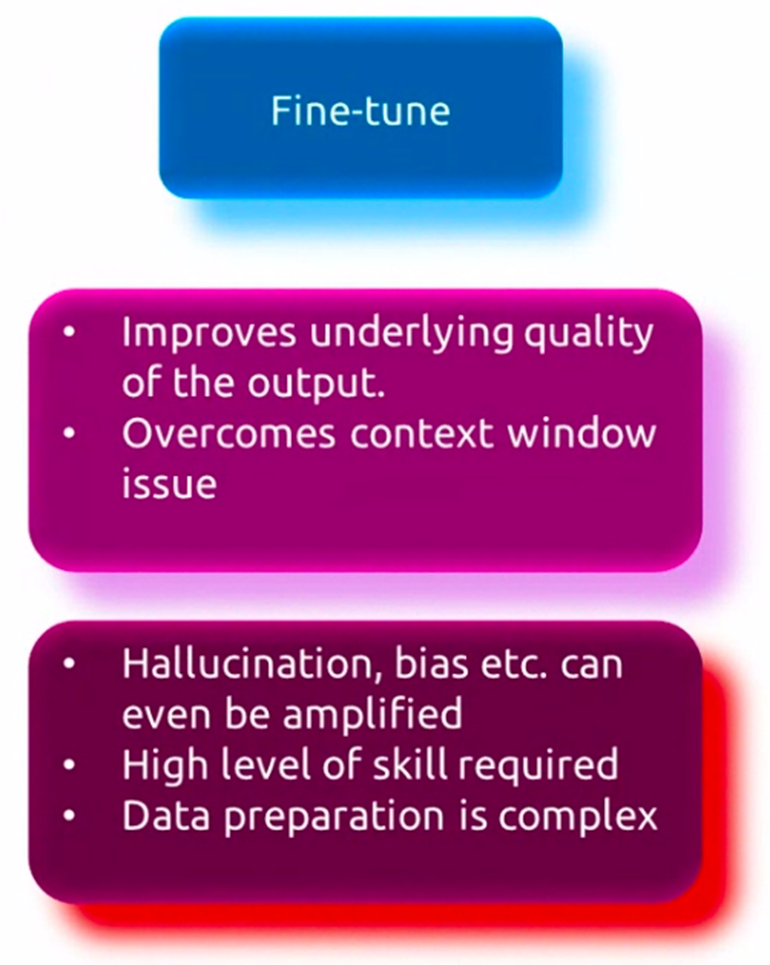

Begeleide fijnafstemming

Hoewel GPT-modellen vooraf zijn getraind op enorme datasets om een breed begrip van taal te verwerven, moeten ze vaak worden verfijnd op taakspecifieke gegevens om goed te kunnen presteren in specifieke toepassingen. Dit proces, ook wel gesuperviseerde afstemming genoemd, omvat het verder trainen van het vooraf getrainde model op een kleinere dataset die relevant is voor de doeltaak, zoals het beantwoorden van vragen, het samenvatten van teksten of automatische vertaling. Tijdens scherpstellenworden de gewichten van het model aangepast om de patronen en nuances die specifiek zijn voor de uit te voeren taak beter weer te geven, terwijl de algemene taalkennis die tijdens de vooropleiding is verworven nog steeds behouden blijft. Door dit verfijningsproces kan het model zich specialiseren en aanpassen aan de specifieke vereisten van de doeltaak, wat resulteert in verbeterde prestaties.

Vooropleiding zonder toezicht

Voordat GPT-modellen worden verfijnd, ondergaan ze een eerste, onbewaakte pre-trainingsfase, waarin ze worden blootgesteld aan enorme hoeveelheden tekstgegevens uit verschillende bronnen, zoals boeken, artikelen en websites. Tijdens deze fase leert het model de onderliggende patronen en relaties in de gegevens vast te leggen door het volgende woord of token in een reeks te voorspellen, een proces dat bekend staat als taalmodellering. Dankzij deze pre-training zonder toezicht kan het model een breed begrip van taal ontwikkelen, inclusief syntaxis, semantiek en context. Het model is getraind op een enorm corpus aan tekstgegevens, waardoor het kan leren van een breed scala aan onderwerpen, stijlen en domeinen. Deze pre-trainingsfase zonder toezicht is rekenintensief maar cruciaal, omdat het het model een sterke basis biedt voor daaropvolgende verfijning van specifieke taken.

GPT-toepassingen en gebruiksscenario's

GPT-modellen hebben een opmerkelijke veelzijdigheid getoond en zijn toegepast op een breed scala aan NLP-taken en -toepassingen. Laten we enkele van de belangrijkste gebruiksscenario's van deze krachtige taalmodellen onderzoeken.

Taalbarrières doorbreken

Een van de eerste en meest prominente toepassingen van GPT-modellen is op het gebied van automatische vertaling. Door gebruik te maken van hun vermogen om mensachtige tekst te begrijpen en te genereren, kunnen GPT-modellen worden getraind om met hoge nauwkeurigheid en vloeiendheid tussen verschillende talen te vertalen. Deze modellen kunnen de nuances en complexiteiten van taal vastleggen, waardoor ze vertalingen kunnen produceren die niet alleen accuraat zijn, maar ook de beoogde betekenis en context van de originele tekst behouden.

Tekstsamenvatting

Met de steeds groter wordende hoeveelheid tekstuele gegevens die beschikbaar zijn, is de mogelijkheid om samenvatten lange documenten of artikelen in beknopte en betekenisvolle samenvattingen zijn steeds belangrijker geworden. GPT-modellen hebben bewezen effectief te zijn in deze taak, omdat ze de context en de belangrijkste punten van een bepaalde tekst kunnen analyseren en begrijpen, en vervolgens een verkorte samenvatting kunnen genereren die de essentie van de originele inhoud weergeeft. Deze applicatie kent talloze gebruiksscenario's, variërend van het samenvatten van nieuwsartikelen en onderzoekspapers tot het genereren van beknopte rapporten en samenvattingen.

Chatbots en Conversationele AI

Een van de meest zichtbare en algemeen aanvaarde toepassingen van GPT-modellen is de ontwikkeling van chatbots en conversatie AI systemen. Deze modellen kunnen een mensachtige dialoog aangaan, waarbij ze vragen en input van gebruikers op een natuurlijke en contextueel passende manier begrijpen en erop reageren. Door GPT aangedreven chatbots worden in verschillende sectoren, zoals klantenservice, e-commerce en gezondheidszorg, gebruikt om gebruikers gepersonaliseerde en efficiënte hulp te bieden.

Het fantasierijke potentieel van GPT's

Hoewel GPT-modellen aanvankelijk waren ontworpen voor taalbegrip en taalgeneratietaken, heeft hun vermogen om samenhangende en fantasierijke tekst te produceren nieuwe mogelijkheden geopend op het gebied van creatief schrijven. Deze modellen kunnen worden verfijnd om verhalen, gedichten, scripts en zelfs songteksten te genereren, wat schrijvers en artiesten een krachtig hulpmiddel biedt om nieuwe creatieve wegen te verkennen. Bovendien kunnen GPT-modellen helpen bij het schrijfproces door plotontwikkelingen en karakterbeschrijvingen voor te stellen, en zelfs hele passages te genereren op basis van aanwijzingen of schetsen.

De toekomst van GPT's en generatieve AI

Hoe veelbelovend GPT-modellen ook zijn geweest, er zijn nog steeds beperkingen en uitdagingen die moeten worden overwonnen, evenals ethische overwegingen die moeten worden aangepakt. Bovendien evolueert het veld van generatieve AI snel, waarbij nieuwe trends en baanbrekend onderzoek de toekomst van deze modellen vormgeven.

Beperkingen en uitdagingen van de huidige GPT-modellen

Ondanks hun indrukwekkende mogelijkheden hebben de huidige GPT-modellen bepaalde beperkingen. Een van de grootste uitdagingen is hun onvermogen om de onderliggende betekenis en context van de tekst die ze genereren echt te begrijpen. Hoewel ze samenhangende en vloeiende teksten kunnen produceren, kunnen ze soms onzinnige of feitelijk onjuiste informatie genereren, vooral als het gaat om complexe of gespecialiseerde onderwerpen. Bovendien kunnen deze modellen vooroordelen vertonen in hun trainingsgegevens, wat aanleiding geeft tot bezorgdheid over eerlijkheid en mogelijk schadelijke resultaten.

Ethische overwegingen en verantwoorde AI-ontwikkeling

Naarmate GPT-modellen krachtiger en wijdverspreider worden, is het van cruciaal belang om ethische overwegingen aan te pakken en een verantwoorde ontwikkeling en inzet van deze technologieën te garanderen. Kwesties als privacy, beveiliging en de kans op misbruik of kwaadaardige applicaties moeten zorgvuldig worden onderzocht. Onderzoekers en ontwikkelaars moeten werken aan de ontwikkeling van ethische richtlijnen, bestuurskaders en robuuste waarborgen om potentiële risico's te beperken en het veilige en nuttige gebruik van GPT-modellen te garanderen.

Opkomende trends en baanbrekend onderzoek

Het veld van generatieve AI evolueert snel, waarbij onderzoekers nieuwe architecturen, trainingsmethoden en toepassingen verkennen. Eén van de opkomende trends is multimodale modellen die gegevens kunnen verwerken en genereren via verschillende modaliteiten (tekst, afbeeldingen, audio, enz.). Een andere aanpak is het versterken van leerbenaderingen voor het genereren van talen. De integratie van GPT-modellen met andere AI-technologieën, zoals computer visie en robotica is nog een trend. Daarnaast wordt onderzoek gedaan naar het verbeteren van de interpreteerbaarheid, controleerbaarheid en robuustheid van deze modellen. Onderzoekers onderzoeken ook hun potentieel op gebieden als wetenschappelijke ontdekkingen, onderwijs en gezondheidszorg.

Conclusie

GPT-modellen hebben een revolutie teweeggebracht op het gebied van NLP. Ze hebben opmerkelijke capaciteiten getoond in taken zoals het vertalen van talen, het samenvatten van teksten, conversationele AI en creatief schrijven. De kern van deze modellen is de transformatorarchitectuur. Hierbij wordt gebruik gemaakt van een nieuw aandachtsmechanisme om afhankelijkheden en context op lange afstand in tekstgegevens vast te leggen. Het trainen van GPT-modellen omvat een complex proces van pre-training zonder toezicht op enorme datasets, gevolgd door verfijnde afstemming onder toezicht voor specifieke taken.

Hoewel GPT-modellen indrukwekkende resultaten hebben geboekt, zijn er nog steeds beperkingen en uitdagingen die moeten worden overwonnen. Dit omvat het gebrek aan echt begrip, mogelijke vooroordelen en ethische zorgen. Bovendien evolueert het veld van generatieve AI snel, waarbij onderzoekers nieuwe architecturen, toepassingen en technieken onderzoeken om de grenzen van deze modellen te verleggen.

Naarmate GPT-modellen zich blijven ontwikkelen, is het van cruciaal belang om ethische overwegingen aan te pakken en verantwoorde AI-praktijken te ontwikkelen. Het is ook belangrijk om opkomende trends en baanbrekend onderzoek te onderzoeken om het volledige potentieel van deze krachtige modellen te benutten. Intussen moeten we het veilige en nuttige gebruik ervan garanderen door potentiële risico's te beperken.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/