In essentie, LangChain is een innovatief raamwerk dat op maat is gemaakt voor het maken van applicaties die gebruik maken van de mogelijkheden van taalmodellen. Het is een toolkit die is ontworpen voor ontwikkelaars om applicaties te maken die contextbewust zijn en in staat zijn tot geavanceerde redeneringen.

Dit betekent dat LangChain-applicaties de context kunnen begrijpen, zoals promptinstructies of inhoudelijke reacties, en taalmodellen kunnen gebruiken voor complexe redeneringstaken, zoals beslissen hoe te reageren of welke acties moeten worden ondernomen. LangChain vertegenwoordigt een uniforme aanpak voor het ontwikkelen van intelligente applicaties, waardoor de reis van concept naar uitvoering wordt vereenvoudigd met zijn diverse componenten.

LangChain begrijpen

LangChain is veel meer dan alleen een raamwerk; het is een volwaardig ecosysteem dat uit verschillende integrale onderdelen bestaat.

- Ten eerste zijn er de LangChain-bibliotheken, beschikbaar in zowel Python als JavaScript. Deze bibliotheken vormen de ruggengraat van LangChain en bieden interfaces en integraties voor verschillende componenten. Ze bieden een basisruntime voor het combineren van deze componenten tot samenhangende ketens en agenten, samen met kant-en-klare implementaties voor onmiddellijk gebruik.

- Vervolgens hebben we LangChain-sjablonen. Dit is een verzameling inzetbare referentiearchitecturen die op maat zijn gemaakt voor een breed scala aan taken. Of je nu een chatbot of een complexe analytische tool bouwt, deze sjablonen bieden een solide startpunt.

- LangServe treedt op als een veelzijdige bibliotheek voor het inzetten van LangChain-ketens als REST API's. Deze tool is essentieel om uw LangChain-projecten om te zetten in toegankelijke en schaalbare webservices.

- Ten slotte fungeert LangSmith als ontwikkelaarsplatform. Het is ontworpen voor het debuggen, testen, evalueren en monitoren van ketens die op elk LLM-framework zijn gebouwd. De naadloze integratie met LangChain maakt het een onmisbaar hulpmiddel voor ontwikkelaars die hun applicaties willen verfijnen en perfectioneren.

Samen zorgen deze componenten ervoor dat u met gemak applicaties kunt ontwikkelen, produceren en implementeren. Met LangChain begint u met het schrijven van uw applicaties met behulp van de bibliotheken, waarbij u ter begeleiding naar sjablonen verwijst. LangSmith helpt u vervolgens bij het inspecteren, testen en monitoren van uw ketens, zodat uw applicaties voortdurend worden verbeterd en gereed zijn voor implementatie. Ten slotte kunt u met LangServe eenvoudig elke keten in een API transformeren, waardoor de implementatie een fluitje van een cent wordt.

In de volgende secties gaan we dieper in op het opzetten van LangChain en beginnen we aan uw reis bij het creëren van intelligente, door taalmodellen aangedreven applicaties.

Automatiseer handmatige taken en workflows met onze AI-gestuurde workflowbuilder, ontworpen door Nanonets voor jou en je teams.

Installatie en configuratie

Ben je klaar om in de wereld van LangChain te duiken? Het instellen is eenvoudig en deze handleiding leidt u stap voor stap door het proces.

De eerste stap in uw LangChain-reis is het installeren ervan. Je kunt dit eenvoudig doen met pip of conda. Voer de volgende opdracht uit in uw terminal:

pip install langchain

Voor degenen die de voorkeur geven aan de nieuwste functies en vertrouwd zijn met wat meer avontuur, kunt u LangChain rechtstreeks vanaf de bron installeren. Kloon de repository en navigeer naar het langchain/libs/langchain map. Voer vervolgens uit:

pip install -e .

Voor experimentele functies kunt u overwegen om te installeren langchain-experimental. Het is een pakket dat de allernieuwste code bevat en bedoeld is voor onderzoeks- en experimentele doeleinden. Installeer het met behulp van:

pip install langchain-experimental

LangChain CLI is een handig hulpmiddel voor het werken met LangChain-sjablonen en LangServe-projecten. Om de LangChain CLI te installeren, gebruikt u:

pip install langchain-cli

LangServe is essentieel voor het inzetten van uw LangChain-ketens als REST API. Het wordt naast de LangChain CLI geïnstalleerd.

LangChain vereist vaak integraties met modelproviders, datastores, API's, enz. Voor dit voorbeeld gebruiken we de model-API's van OpenAI. Installeer het OpenAI Python-pakket met behulp van:

pip install openai

Om toegang te krijgen tot de API, stelt u uw OpenAI API-sleutel in als een omgevingsvariabele:

export OPENAI_API_KEY="your_api_key"

U kunt de sleutel ook rechtstreeks in uw Python-omgeving doorgeven:

import os

os.environ['OPENAI_API_KEY'] = 'your_api_key'

LangChain maakt het mogelijk om via modules taalmodeltoepassingen te creëren. Deze modules kunnen op zichzelf staan of worden samengesteld voor complexe gebruiksscenario's. Deze modules zijn –

- Model-I/O: Vergemakkelijkt de interactie met verschillende taalmodellen, waarbij de input en output efficiënt worden verwerkt.

- Ophalen: Maakt toegang tot en interactie met applicatiespecifieke gegevens mogelijk, cruciaal voor dynamisch gegevensgebruik.

- Ontmoet het team: Geef applicaties de mogelijkheid om geschikte tools te selecteren op basis van richtlijnen op hoog niveau, waardoor de besluitvormingsmogelijkheden worden verbeterd.

- Ketens: Biedt vooraf gedefinieerde, herbruikbare composities die dienen als bouwstenen voor applicatieontwikkeling.

- Geheugen: Behoudt de applicatiestatus over meerdere ketenuitvoeringen, essentieel voor contextbewuste interacties.

Elke module richt zich op specifieke ontwikkelingsbehoeften, waardoor LangChain een uitgebreide toolkit is voor het creëren van geavanceerde taalmodeltoepassingen.

Samen met de bovenstaande componenten hebben we ook LangChain-expressietaal (LCEL), wat een declaratieve manier is om eenvoudig modules samen te stellen, en dit maakt het aan elkaar koppelen van componenten mogelijk met behulp van een universele Runnable-interface.

LCEL ziet er ongeveer zo uit:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema import BaseOutputParser # Example chain

chain = ChatPromptTemplate() | ChatOpenAI() | CustomOutputParser()

Nu we de basis hebben behandeld, gaan we verder met:

- Graaf dieper in elke Langchain-module in detail.

- Leer hoe u de LangChain-expressietaal gebruikt.

- Ontdek veelvoorkomende gebruiksscenario's en implementeer deze.

- Implementeer een end-to-end-applicatie met LangServe.

- Bekijk LangSmith voor foutopsporing, testen en monitoring.

Laten we beginnen!

Module I: Model-I/O

In LangChain draait het kernelement van elke applicatie om het taalmodel. Deze module biedt de essentiële bouwstenen voor een effectieve interface met elk taalmodel, waardoor een naadloze integratie en communicatie wordt gegarandeerd.

Belangrijkste componenten van Model I/O

- LLM's en chatmodellen (door elkaar gebruikt):

- LLM's:

- Definitie: Modellen voor pure tekstaanvulling.

- Input / Output: Neem een tekststring als invoer en retourneer een tekststring als uitvoer.

- Chatmodellen

- LLM's:

- Definitie: Modellen die een taalmodel als basis gebruiken, maar verschillen in invoer- en uitvoerformaten.

- Input / Output: Accepteer een lijst met chatberichten als invoer en stuur een chatbericht terug.

- aanwijzingen: Modelinvoer sjabloneren, dynamisch selecteren en beheren. Maakt het mogelijk om flexibele en contextspecifieke aanwijzingen te creëren die de antwoorden van het taalmodel begeleiden.

- Uitvoerparsers: informatie uit modeluitvoer extraheren en formatteren. Handig voor het omzetten van de onbewerkte uitvoer van taalmodellen naar gestructureerde gegevens of specifieke formaten die nodig zijn voor de toepassing.

LLM's

De integratie van LangChain met Large Language Models (LLM's) zoals OpenAI, Cohere en Hugging Face is een fundamenteel aspect van de functionaliteit ervan. LangChain host zelf geen LLM's, maar biedt een uniforme interface voor interactie met verschillende LLM's.

Deze sectie biedt een overzicht van het gebruik van de OpenAI LLM-wrapper in LangChain, ook van toepassing op andere LLM-typen. We hebben dit al geïnstalleerd in het gedeelte 'Aan de slag'. Laten we de LLM initialiseren.

from langchain.llms import OpenAI

llm = OpenAI()

- LLM's implementeren de Uitvoerbare interface, de basisbouwsteen van de LangChain-expressietaal (LCEL). Dit betekent dat ze ondersteunen

invoke,ainvoke,stream,astream,batch,abatch,astream_lognoemt. - LLM's accepteren strings als invoer, of objecten die kunnen worden gedwongen om aanwijzingen te geven, inclusief

List[BaseMessage]enPromptValue. (hierover later meer)

Laten we eens kijken naar enkele voorbeelden.

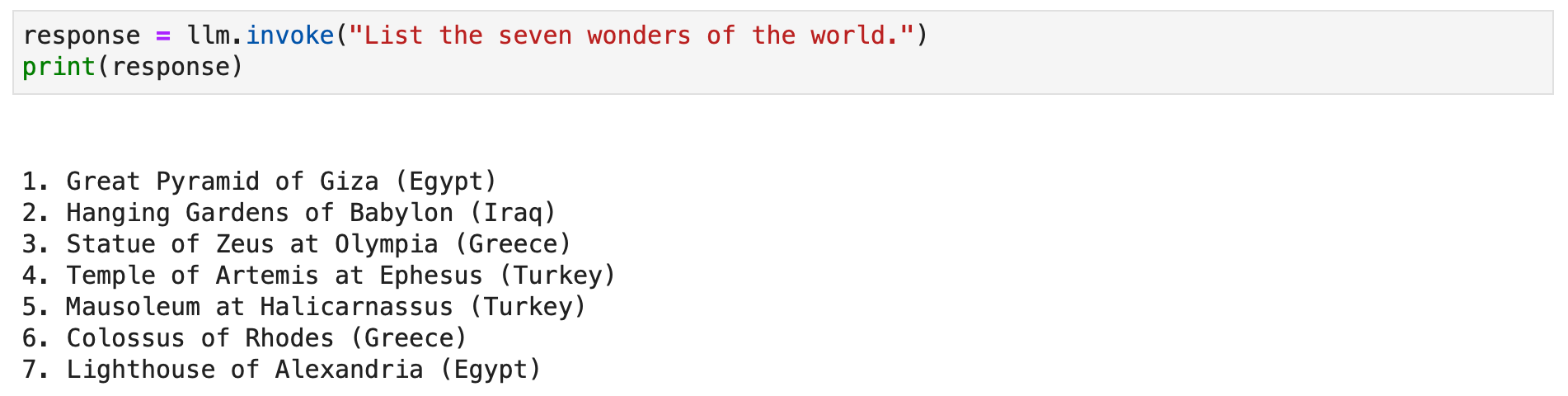

response = llm.invoke("List the seven wonders of the world.")

print(response)

U kunt ook de streammethode aanroepen om het tekstantwoord te streamen.

for chunk in llm.stream("Where were the 2012 Olympics held?"): print(chunk, end="", flush=True)

Chatmodellen

De integratie van LangChain met chatmodellen, een gespecialiseerde variant van taalmodellen, is essentieel voor het creëren van interactieve chattoepassingen. Hoewel ze intern taalmodellen gebruiken, bieden chatmodellen een aparte interface waarin chatberichten als input en output centraal staan. Deze sectie biedt een gedetailleerd overzicht van het gebruik van het chatmodel van OpenAI in LangChain.

from langchain.chat_models import ChatOpenAI

chat = ChatOpenAI()

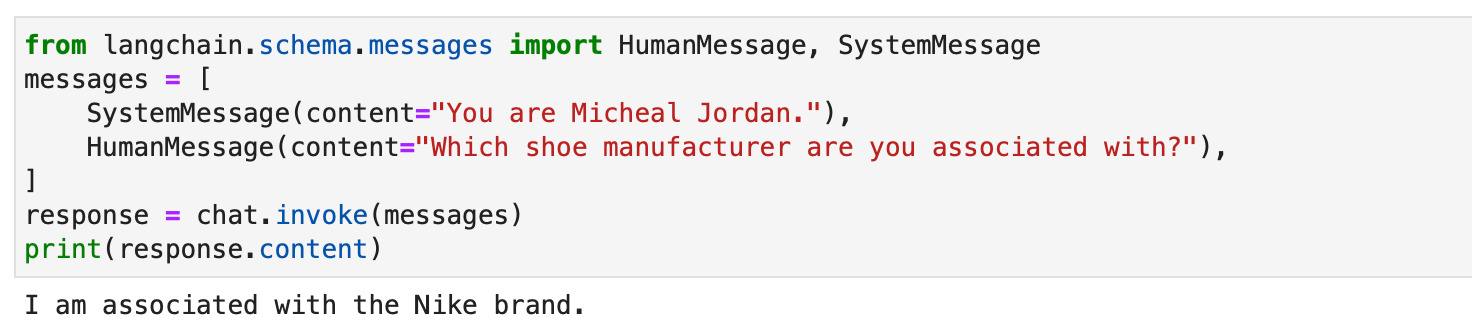

Chatmodellen in LangChain werken met verschillende berichttypen, zoals AIMessage, HumanMessage, SystemMessage, FunctionMessage en ChatMessage (met een willekeurige rolparameter). Over het algemeen, HumanMessage, AIMessage en SystemMessage zijn de meest gebruikte.

Chatmodellen accepteren voornamelijk List[BaseMessage] als ingangen. Tekenreeksen kunnen worden geconverteerd naar HumanMessage en PromptValue wordt ook ondersteund.

from langchain.schema.messages import HumanMessage, SystemMessage

messages = [ SystemMessage(content="You are Micheal Jordan."), HumanMessage(content="Which shoe manufacturer are you associated with?"),

]

response = chat.invoke(messages)

print(response.content)

aanwijzingen

Aanwijzingen zijn essentieel bij het begeleiden van taalmodellen om relevante en coherente resultaten te genereren. Ze kunnen variëren van eenvoudige instructies tot complexe, enkele voorbeelden. In LangChain kan het afhandelen van aanwijzingen een zeer gestroomlijnd proces zijn, dankzij verschillende speciale klassen en functies.

LangChains PromptTemplate class is een veelzijdig hulpmiddel voor het maken van stringprompts. Het maakt gebruik van Python str.format syntaxis, waardoor dynamische promptgeneratie mogelijk is. U kunt een sjabloon met tijdelijke aanduidingen definiëren en deze indien nodig met specifieke waarden vullen.

from langchain.prompts import PromptTemplate # Simple prompt with placeholders

prompt_template = PromptTemplate.from_template( "Tell me a {adjective} joke about {content}."

) # Filling placeholders to create a prompt

filled_prompt = prompt_template.format(adjective="funny", content="robots")

print(filled_prompt)Voor chatmodellen zijn aanwijzingen meer gestructureerd, waarbij berichten met specifieke rollen betrokken zijn. LangChain-aanbiedingen ChatPromptTemplate Voor dit doeleinde.

from langchain.prompts import ChatPromptTemplate # Defining a chat prompt with various roles

chat_template = ChatPromptTemplate.from_messages( [ ("system", "You are a helpful AI bot. Your name is {name}."), ("human", "Hello, how are you doing?"), ("ai", "I'm doing well, thanks!"), ("human", "{user_input}"), ]

) # Formatting the chat prompt

formatted_messages = chat_template.format_messages(name="Bob", user_input="What is your name?")

for message in formatted_messages: print(message)

Deze aanpak maakt het mogelijk interactieve, boeiende chatbots met dynamische reacties te creëren.

Te gebruiken zowel PromptTemplate en ChatPromptTemplate naadloos te integreren met de LangChain Expression Language (LCEL), waardoor ze deel kunnen uitmaken van grotere, complexe workflows. We zullen hier later meer over bespreken.

Aangepaste promptsjablonen zijn soms essentieel voor taken die unieke opmaak of specifieke instructies vereisen. Het maken van een aangepaste aanwijzingssjabloon omvat het definiëren van invoervariabelen en een aangepaste opmaakmethode. Dankzij deze flexibiliteit kan LangChain tegemoetkomen aan een breed scala aan toepassingsspecifieke vereisten. Lees hier meer.

LangChain ondersteunt ook enkele vragen, waardoor het model van voorbeelden kan leren. Deze functie is essentieel voor taken die contextueel begrip of specifieke patronen vereisen. Few-shot-promptsjablonen kunnen worden opgebouwd op basis van een reeks voorbeelden of door gebruik te maken van een voorbeeldkiezerobject. Lees hier meer.

Uitvoerparsers

Uitvoerparsers spelen een cruciale rol in Langchain, waardoor gebruikers de door taalmodellen gegenereerde antwoorden kunnen structureren. In deze sectie zullen we het concept van uitvoerparsers verkennen en codevoorbeelden geven met behulp van Langchain's PydanticOutputParser, SimpleJsonOutputParser, CommaSeparatedListOutputParser, DatetimeOutputParser en XMLOutputParser.

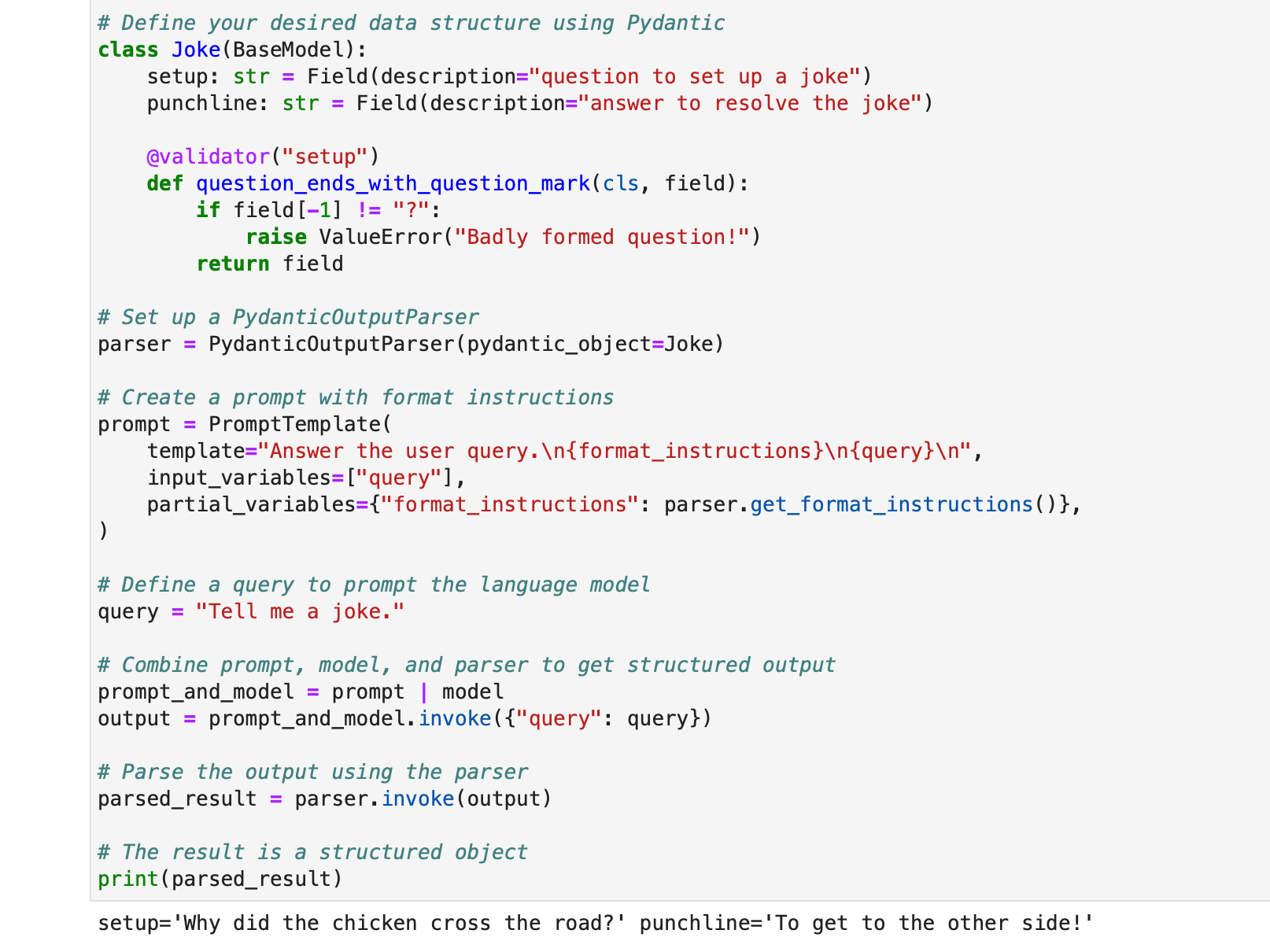

PydanticOutputParser

Langchain biedt de PydanticOutputParser voor het parseren van antwoorden in Pydantic-datastructuren. Hieronder vindt u een stapsgewijs voorbeeld van hoe u het kunt gebruiken:

from typing import List

from langchain.llms import OpenAI

from langchain.output_parsers import PydanticOutputParser

from langchain.prompts import PromptTemplate

from langchain.pydantic_v1 import BaseModel, Field, validator # Initialize the language model

model = OpenAI(model_name="text-davinci-003", temperature=0.0) # Define your desired data structure using Pydantic

class Joke(BaseModel): setup: str = Field(description="question to set up a joke") punchline: str = Field(description="answer to resolve the joke") @validator("setup") def question_ends_with_question_mark(cls, field): if field[-1] != "?": raise ValueError("Badly formed question!") return field # Set up a PydanticOutputParser

parser = PydanticOutputParser(pydantic_object=Joke) # Create a prompt with format instructions

prompt = PromptTemplate( template="Answer the user query.n{format_instructions}n{query}n", input_variables=["query"], partial_variables={"format_instructions": parser.get_format_instructions()},

) # Define a query to prompt the language model

query = "Tell me a joke." # Combine prompt, model, and parser to get structured output

prompt_and_model = prompt | model

output = prompt_and_model.invoke({"query": query}) # Parse the output using the parser

parsed_result = parser.invoke(output) # The result is a structured object

print(parsed_result)

De output zal worden:

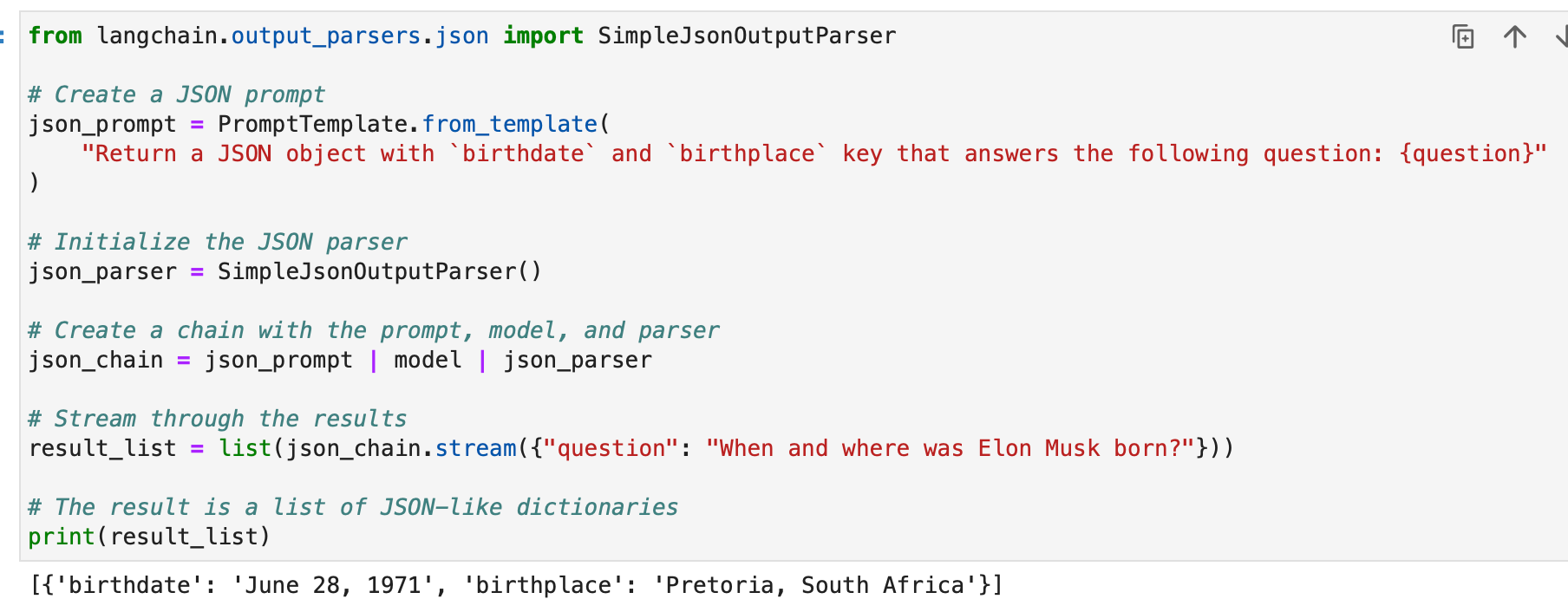

SimpleJsonOutputParser

De SimpleJsonOutputParser van Langchain wordt gebruikt wanneer u JSON-achtige uitvoer wilt parseren. Hier is een voorbeeld:

from langchain.output_parsers.json import SimpleJsonOutputParser # Create a JSON prompt

json_prompt = PromptTemplate.from_template( "Return a JSON object with `birthdate` and `birthplace` key that answers the following question: {question}"

) # Initialize the JSON parser

json_parser = SimpleJsonOutputParser() # Create a chain with the prompt, model, and parser

json_chain = json_prompt | model | json_parser # Stream through the results

result_list = list(json_chain.stream({"question": "When and where was Elon Musk born?"})) # The result is a list of JSON-like dictionaries

print(result_list)

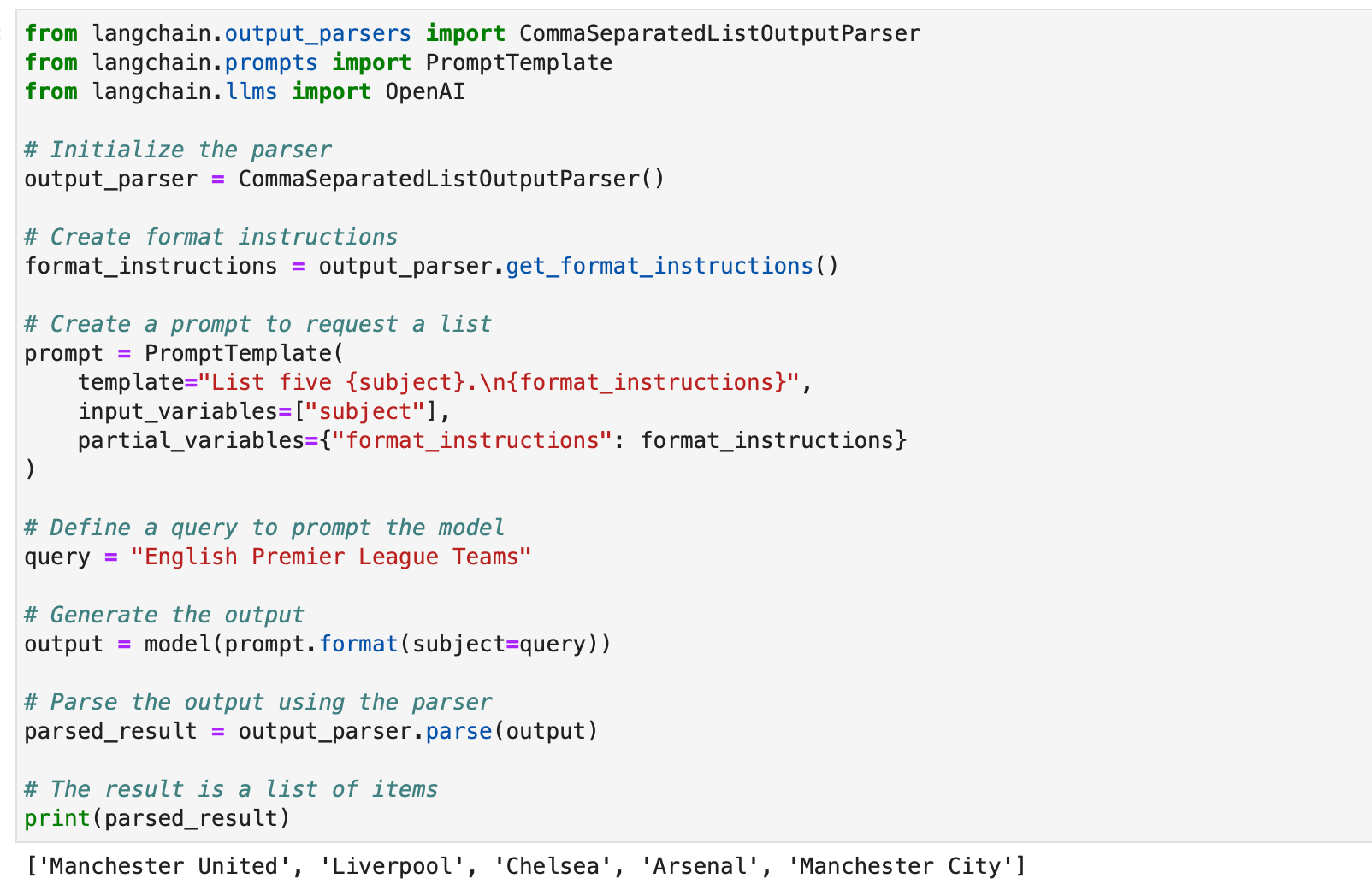

CommaSeparatedListOutputParser

De CommaSeparatedListOutputParser is handig als u door komma's gescheiden lijsten uit modelreacties wilt extraheren. Hier is een voorbeeld:

from langchain.output_parsers import CommaSeparatedListOutputParser

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI # Initialize the parser

output_parser = CommaSeparatedListOutputParser() # Create format instructions

format_instructions = output_parser.get_format_instructions() # Create a prompt to request a list

prompt = PromptTemplate( template="List five {subject}.n{format_instructions}", input_variables=["subject"], partial_variables={"format_instructions": format_instructions}

) # Define a query to prompt the model

query = "English Premier League Teams" # Generate the output

output = model(prompt.format(subject=query)) # Parse the output using the parser

parsed_result = output_parser.parse(output) # The result is a list of items

print(parsed_result)

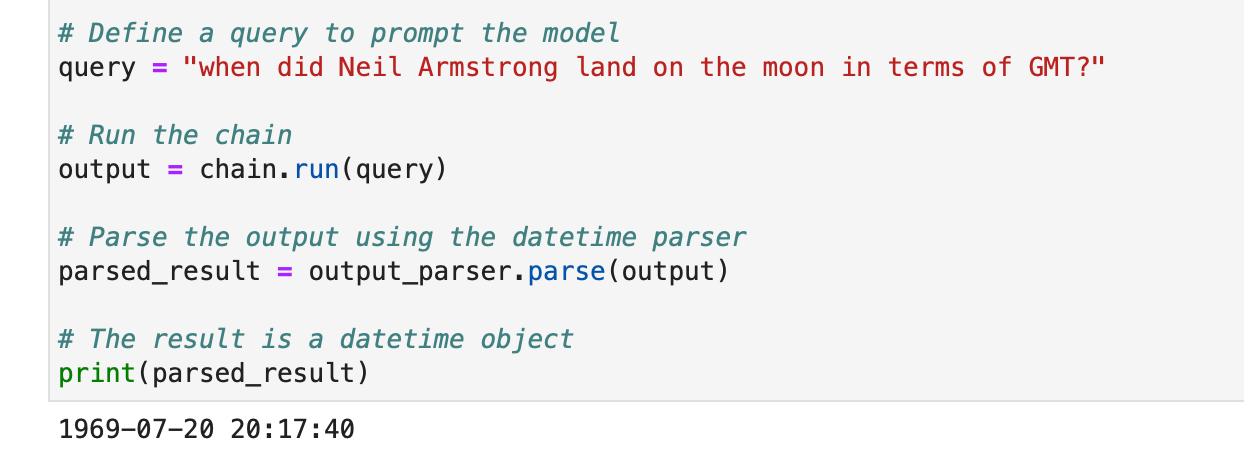

DatetimeOutputParser

De DatetimeOutputParser van Langchain is ontworpen om datetime-informatie te parseren. Hier ziet u hoe u het kunt gebruiken:

from langchain.prompts import PromptTemplate

from langchain.output_parsers import DatetimeOutputParser

from langchain.chains import LLMChain

from langchain.llms import OpenAI # Initialize the DatetimeOutputParser

output_parser = DatetimeOutputParser() # Create a prompt with format instructions

template = """

Answer the user's question:

{question}

{format_instructions} """ prompt = PromptTemplate.from_template( template, partial_variables={"format_instructions": output_parser.get_format_instructions()},

) # Create a chain with the prompt and language model

chain = LLMChain(prompt=prompt, llm=OpenAI()) # Define a query to prompt the model

query = "when did Neil Armstrong land on the moon in terms of GMT?" # Run the chain

output = chain.run(query) # Parse the output using the datetime parser

parsed_result = output_parser.parse(output) # The result is a datetime object

print(parsed_result)

Deze voorbeelden laten zien hoe de uitvoerparsers van Langchain kunnen worden gebruikt om verschillende soorten modelreacties te structureren, waardoor ze geschikt worden voor verschillende toepassingen en formaten. Uitvoerparsers zijn een waardevol hulpmiddel voor het verbeteren van de bruikbaarheid en interpreteerbaarheid van taalmodeluitvoer in Langchain.

Automatiseer handmatige taken en workflows met onze AI-gestuurde workflowbuilder, ontworpen door Nanonets voor jou en je teams.

Module II: Ophalen

Ophalen in LangChain speelt een cruciale rol in applicaties die gebruikersspecifieke gegevens vereisen, die niet zijn opgenomen in de trainingsset van het model. Dit proces, bekend als Retrieval Augmented Generation (RAG), omvat het ophalen van externe gegevens en het integreren ervan in het generatieproces van het taalmodel. LangChain biedt een uitgebreide reeks tools en functionaliteiten om dit proces te vergemakkelijken, geschikt voor zowel eenvoudige als complexe toepassingen.

LangChain bereikt het ophalen via een reeks componenten die we één voor één zullen bespreken.

Documentladers

Documentladers in LangChain maken het extraheren van gegevens uit verschillende bronnen mogelijk. Met meer dan 100 beschikbare laders ondersteunen ze een reeks documenttypen, apps en bronnen (privé s3-buckets, openbare websites, databases).

U kunt een documentlader kiezen op basis van uw vereisten hier.

Al deze laders nemen gegevens op in Document klassen. We zullen later leren hoe u gegevens kunt gebruiken die zijn opgenomen in documentklassen.

Tekstbestandslader: Laad een eenvoudig .txt opslaan in een document.

from langchain.document_loaders import TextLoader loader = TextLoader("./sample.txt")

document = loader.load()

CSV-lader: Laad een CSV-bestand in een document.

from langchain.document_loaders.csv_loader import CSVLoader loader = CSVLoader(file_path='./example_data/sample.csv')

documents = loader.load()

We kunnen ervoor kiezen om de parsering aan te passen door veldnamen op te geven:

loader = CSVLoader(file_path='./example_data/mlb_teams_2012.csv', csv_args={ 'delimiter': ',', 'quotechar': '"', 'fieldnames': ['MLB Team', 'Payroll in millions', 'Wins']

})

documents = loader.load()

PDF-laders: PDF-laders in LangChain bieden verschillende methoden voor het parseren en extraheren van inhoud uit PDF-bestanden. Elke lader voldoet aan verschillende vereisten en gebruikt verschillende onderliggende bibliotheken. Hieronder vindt u gedetailleerde voorbeelden voor elke lader.

PyPDFLoader wordt gebruikt voor eenvoudige PDF-parsering.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("example_data/layout-parser-paper.pdf")

pages = loader.load_and_split()

MathPixLoader is ideaal voor het extraheren van wiskundige inhoud en diagrammen.

from langchain.document_loaders import MathpixPDFLoader loader = MathpixPDFLoader("example_data/math-content.pdf")

data = loader.load()

PyMuPDFLoader is snel en bevat gedetailleerde extractie van metagegevens.

from langchain.document_loaders import PyMuPDFLoader loader = PyMuPDFLoader("example_data/layout-parser-paper.pdf")

data = loader.load() # Optionally pass additional arguments for PyMuPDF's get_text() call

data = loader.load(option="text")

PDFMiner Loader wordt gebruikt voor meer gedetailleerde controle over tekstextractie.

from langchain.document_loaders import PDFMinerLoader loader = PDFMinerLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

AmazonTextractPDFParser maakt gebruik van AWS Textract voor OCR en andere geavanceerde PDF-parseerfuncties.

from langchain.document_loaders import AmazonTextractPDFLoader # Requires AWS account and configuration

loader = AmazonTextractPDFLoader("example_data/complex-layout.pdf")

documents = loader.load()

PDFMinerPDFasHTMLLoader genereert HTML uit PDF voor semantische parsering.

from langchain.document_loaders import PDFMinerPDFasHTMLLoader loader = PDFMinerPDFasHTMLLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

PDFPlumberLoader biedt gedetailleerde metadata en ondersteunt één document per pagina.

from langchain.document_loaders import PDFPlumberLoader loader = PDFPlumberLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

Geïntegreerde laders: LangChain biedt een breed scala aan aangepaste laders om gegevens rechtstreeks uit uw apps (zoals Slack, Sigma, Notion, Confluence, Google Drive en nog veel meer) en databases te laden en deze in LLM-applicaties te gebruiken.

De volledige lijst is hier.

Hieronder staan een paar voorbeelden om dit te illustreren –

Voorbeeld I – Slack

Slack, een veelgebruikt instant messaging-platform, kan worden geïntegreerd in LLM-workflows en -applicaties.

- Ga naar uw Slack Workspace Management-pagina.

- Navigeer naar

{your_slack_domain}.slack.com/services/export. - Selecteer het gewenste datumbereik en start de export.

- Slack informeert via e-mail en DM zodra de export klaar is.

- De export resulteert in een

.zipbestand in uw map Downloads of het door u aangegeven downloadpad. - Wijs het pad van het gedownloade bestand toe

.zipbestand naarLOCAL_ZIPFILE. - Gebruik de

SlackDirectoryLoadervan hetlangchain.document_loaderspakket.

from langchain.document_loaders import SlackDirectoryLoader SLACK_WORKSPACE_URL = "https://xxx.slack.com" # Replace with your Slack URL

LOCAL_ZIPFILE = "" # Path to the Slack zip file loader = SlackDirectoryLoader(LOCAL_ZIPFILE, SLACK_WORKSPACE_URL)

docs = loader.load()

print(docs)

Voorbeeld II – Figma

Figma, een populaire tool voor interfaceontwerp, biedt een REST API voor data-integratie.

- Verkrijg de Figma-bestandssleutel uit het URL-formaat:

https://www.figma.com/file/{filekey}/sampleFilename. - Knooppunt-ID's zijn te vinden in de URL-parameter

?node-id={node_id}. - Genereer een toegangstoken volgens de instructies op de Figma-helpcentrum.

- De

FigmaFileLoaderklas vanlangchain.document_loaders.figmawordt gebruikt om Figma-gegevens te laden. - Verschillende LangChain-modules zoals

CharacterTextSplitter,ChatOpenAIenz., worden gebruikt voor de verwerking.

import os

from langchain.document_loaders.figma import FigmaFileLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain.chat_models import ChatOpenAI

from langchain.indexes import VectorstoreIndexCreator

from langchain.chains import ConversationChain, LLMChain

from langchain.memory import ConversationBufferWindowMemory

from langchain.prompts.chat import ChatPromptTemplate, SystemMessagePromptTemplate, AIMessagePromptTemplate, HumanMessagePromptTemplate figma_loader = FigmaFileLoader( os.environ.get("ACCESS_TOKEN"), os.environ.get("NODE_IDS"), os.environ.get("FILE_KEY"),

) index = VectorstoreIndexCreator().from_loaders([figma_loader])

figma_doc_retriever = index.vectorstore.as_retriever()

- De

generate_codefunctie gebruikt de Figma-gegevens om HTML/CSS-code te maken. - Het maakt gebruik van een sjabloongesprek met een op GPT gebaseerd model.

def generate_code(human_input): # Template for system and human prompts system_prompt_template = "Your coding instructions..." human_prompt_template = "Code the {text}. Ensure it's mobile responsive" # Creating prompt templates system_message_prompt = SystemMessagePromptTemplate.from_template(system_prompt_template) human_message_prompt = HumanMessagePromptTemplate.from_template(human_prompt_template) # Setting up the AI model gpt_4 = ChatOpenAI(temperature=0.02, model_name="gpt-4") # Retrieving relevant documents relevant_nodes = figma_doc_retriever.get_relevant_documents(human_input) # Generating and formatting the prompt conversation = [system_message_prompt, human_message_prompt] chat_prompt = ChatPromptTemplate.from_messages(conversation) response = gpt_4(chat_prompt.format_prompt(context=relevant_nodes, text=human_input).to_messages()) return response # Example usage

response = generate_code("page top header")

print(response.content)

- De

generate_codefunctie retourneert, indien uitgevoerd, HTML/CSS-code op basis van de Figma-ontwerpinvoer.

Laten we nu onze kennis gebruiken om een paar documentensets te maken.

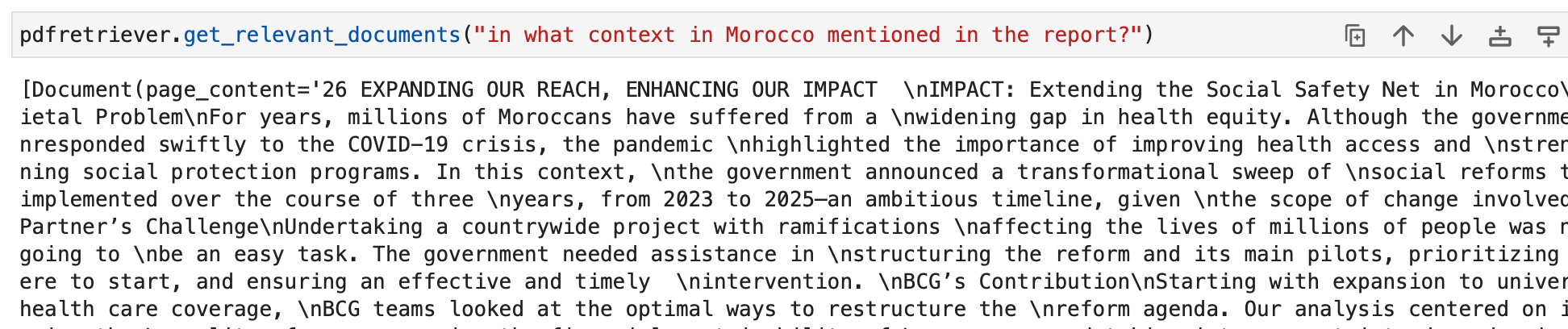

We laden eerst een pdf, het jaarlijkse duurzaamheidsrapport van BCG.

Wij gebruiken hiervoor de PyPDFLoader.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("bcg-2022-annual-sustainability-report-apr-2023.pdf")

pdfpages = loader.load_and_split()

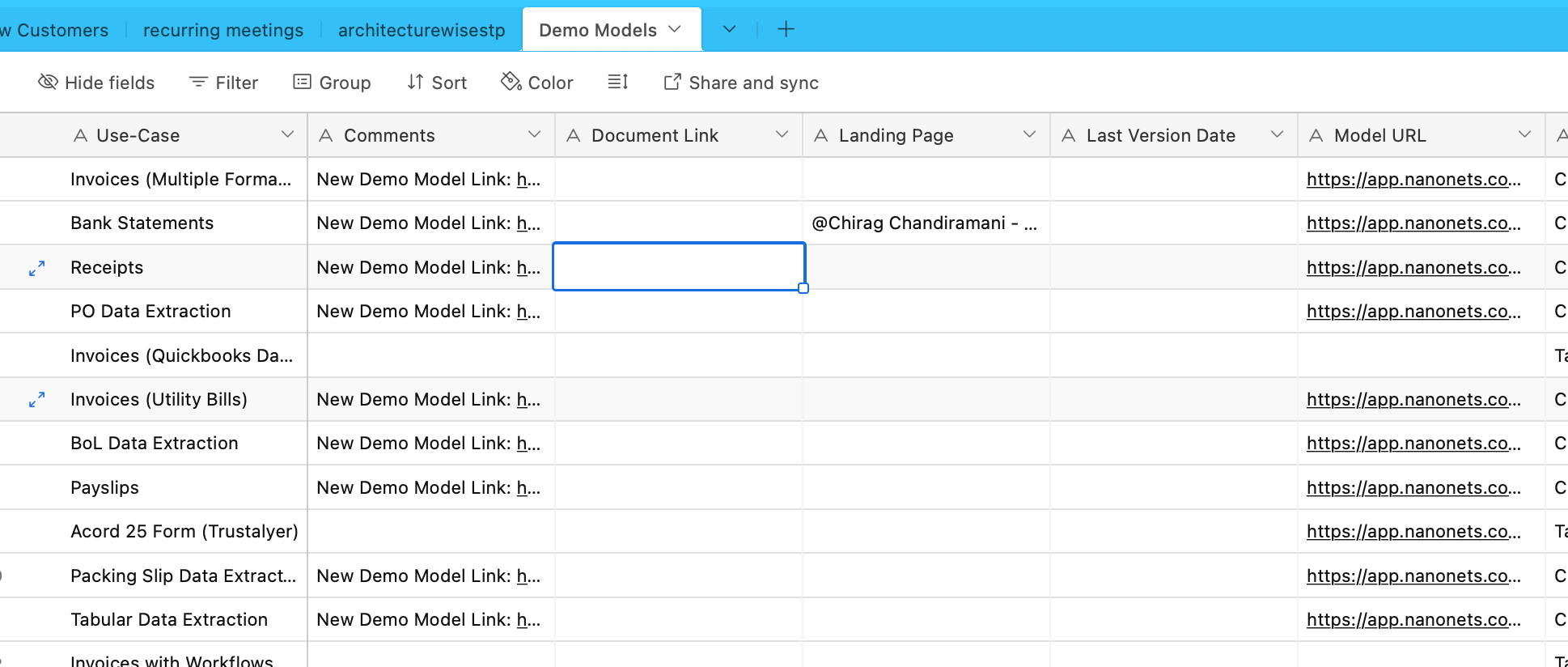

We zullen nu gegevens van Airtable opnemen. We hebben een Airtable met informatie over verschillende OCR- en data-extractiemodellen –

Laten we hiervoor de AirtableLoader gebruiken, te vinden in de lijst met geïntegreerde laders.

from langchain.document_loaders import AirtableLoader api_key = "XXXXX"

base_id = "XXXXX"

table_id = "XXXXX" loader = AirtableLoader(api_key, table_id, base_id)

airtabledocs = loader.load()

Laten we nu verder gaan en leren hoe u deze documentklassen kunt gebruiken.

Documenttransformatoren

Documenttransformatoren in LangChain zijn essentiële hulpmiddelen die zijn ontworpen om documenten te manipuleren, die we in onze vorige subsectie hebben gemaakt.

Ze worden gebruikt voor taken zoals het opsplitsen van lange documenten in kleinere stukken, het combineren en filteren, wat cruciaal is voor het aanpassen van documenten aan het contextvenster van een model of voor het voldoen aan specifieke applicatiebehoeften.

Eén zo'n tool is de RecursiveCharacterTextSplitter, een veelzijdige tekstsplitter die een tekenlijst gebruikt voor het splitsen. Het staat parameters toe zoals chunkgrootte, overlap en startindex. Hier is een voorbeeld van hoe het in Python wordt gebruikt:

from langchain.text_splitter import RecursiveCharacterTextSplitter state_of_the_union = "Your long text here..." text_splitter = RecursiveCharacterTextSplitter( chunk_size=100, chunk_overlap=20, length_function=len, add_start_index=True,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

print(texts[1])

Een ander hulpmiddel is de CharacterTextSplitter, die tekst splitst op basis van een opgegeven teken en besturingselementen bevat voor de blokgrootte en overlap:

from langchain.text_splitter import CharacterTextSplitter text_splitter = CharacterTextSplitter( separator="nn", chunk_size=1000, chunk_overlap=200, length_function=len, is_separator_regex=False,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

De HTMLHeaderTextSplitter is ontworpen om HTML-inhoud te splitsen op basis van header-tags, waarbij de semantische structuur behouden blijft:

from langchain.text_splitter import HTMLHeaderTextSplitter html_string = "Your HTML content here..."

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")] html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text(html_string)

print(html_header_splits[0])

Een complexere manipulatie kan worden bereikt door HTMLHeaderTextSplitter te combineren met een andere splitter, zoals de Pipelined Splitter:

from langchain.text_splitter import HTMLHeaderTextSplitter, RecursiveCharacterTextSplitter url = "https://example.com"

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")]

html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text_from_url(url) chunk_size = 500

text_splitter = RecursiveCharacterTextSplitter(chunk_size=chunk_size)

splits = text_splitter.split_documents(html_header_splits)

print(splits[0])

LangChain biedt ook specifieke splitters voor verschillende programmeertalen, zoals de Python Code Splitter en de JavaScript Code Splitter:

from langchain.text_splitter import RecursiveCharacterTextSplitter, Language python_code = """

def hello_world(): print("Hello, World!")

hello_world() """ python_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.PYTHON, chunk_size=50

)

python_docs = python_splitter.create_documents([python_code])

print(python_docs[0]) js_code = """

function helloWorld() { console.log("Hello, World!");

}

helloWorld(); """ js_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.JS, chunk_size=60

)

js_docs = js_splitter.create_documents([js_code])

print(js_docs[0])

Voor het splitsen van tekst op basis van het aantal tokens, wat handig is voor taalmodellen met tokenlimieten, wordt de TokenTextSplitter gebruikt:

from langchain.text_splitter import TokenTextSplitter text_splitter = TokenTextSplitter(chunk_size=10)

texts = text_splitter.split_text(state_of_the_union)

print(texts[0])

Ten slotte herschikt de LongContextReorder documenten opnieuw om prestatieverlies in modellen als gevolg van lange contexten te voorkomen:

from langchain.document_transformers import LongContextReorder reordering = LongContextReorder()

reordered_docs = reordering.transform_documents(docs)

print(reordered_docs[0])

Deze tools demonstreren verschillende manieren om documenten in LangChain te transformeren, van eenvoudige tekstsplitsing tot complexe herschikking en taalspecifieke splitsing. Voor meer diepgaande en specifieke gebruiksscenario's moet de sectie LangChain-documentatie en Integraties worden geraadpleegd.

In onze voorbeelden hebben de laders al gefragmenteerde documenten voor ons gemaakt, en dit deel is al afgehandeld.

Modellen voor het insluiten van tekst

Tekstinsluitingsmodellen in LangChain bieden een gestandaardiseerde interface voor verschillende aanbieders van insluitingsmodellen, zoals OpenAI, Cohere en Hugging Face. Deze modellen transformeren tekst in vectorrepresentaties, waardoor bewerkingen zoals semantisch zoeken door tekstovereenkomsten in de vectorruimte mogelijk worden.

Om aan de slag te gaan met modellen voor het insluiten van tekst, moet u doorgaans specifieke pakketten installeren en API-sleutels instellen. Voor OpenAI hebben we dit al gedaan

In LangChain, de embed_documents methode wordt gebruikt om meerdere teksten in te sluiten, waardoor een lijst met vectorrepresentaties ontstaat. Bijvoorbeeld:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a list of texts

embeddings = embeddings_model.embed_documents( ["Hi there!", "Oh, hello!", "What's your name?", "My friends call me World", "Hello World!"]

)

print("Number of documents embedded:", len(embeddings))

print("Dimension of each embedding:", len(embeddings[0]))

Voor het insluiten van een enkele tekst, zoals een zoekopdracht, wordt de embed_query methode wordt gebruikt. Dit is handig als u een query wilt vergelijken met een reeks documentinsluitingen. Bijvoorbeeld:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a single query

embedded_query = embeddings_model.embed_query("What was the name mentioned in the conversation?")

print("First five dimensions of the embedded query:", embedded_query[:5])

Het begrijpen van deze inbedding is cruciaal. Elk stukje tekst wordt omgezet in een vector, waarvan de afmeting afhangt van het gebruikte model. OpenAI-modellen produceren bijvoorbeeld doorgaans 1536-dimensionale vectoren. Deze inbedding wordt vervolgens gebruikt om relevante informatie op te halen.

De inbeddingsfunctionaliteit van LangChain is niet beperkt tot OpenAI, maar is ontworpen om met verschillende providers te werken. De opzet en het gebruik kunnen enigszins verschillen afhankelijk van de provider, maar het kernconcept van het inbedden van teksten in vectorruimte blijft hetzelfde. Voor gedetailleerd gebruik, inclusief geavanceerde configuraties en integraties met verschillende aanbieders van inbeddingsmodellen, is de LangChain-documentatie in de sectie Integraties een waardevolle hulpbron.

Vectorwinkels

Vectorwinkels in LangChain ondersteunen het efficiënt opslaan en zoeken van tekstinsluitingen. LangChain kan worden geïntegreerd met meer dan 50 vectorwinkels en biedt een gestandaardiseerde interface voor gebruiksgemak.

Voorbeeld: Insluitingen opslaan en zoeken

Na het insluiten van teksten kunnen we ze opslaan in een vectorwinkel zoals Chroma en zoek naar gelijkenissen:

from langchain.vectorstores import Chroma db = Chroma.from_texts(embedded_texts)

similar_texts = db.similarity_search("search query")

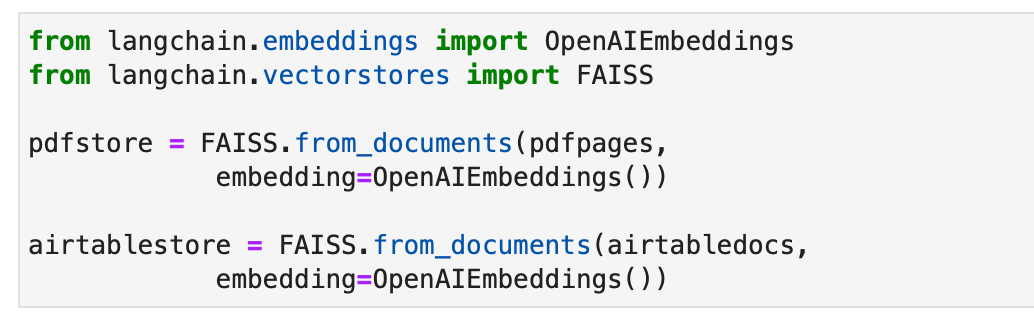

Laten we als alternatief de FAISS-vectoropslag gebruiken om indexen voor onze documenten te maken.

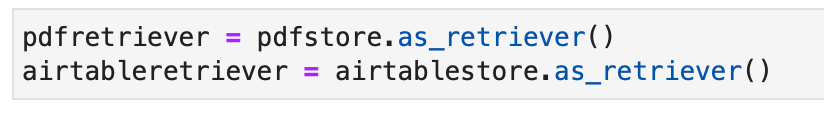

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS pdfstore = FAISS.from_documents(pdfpages, embedding=OpenAIEmbeddings()) airtablestore = FAISS.from_documents(airtabledocs, embedding=OpenAIEmbeddings())

retriever

Retrievers in LangChain zijn interfaces die documenten retourneren als reactie op een ongestructureerde vraag. Ze zijn algemener dan vectorwinkels en richten zich eerder op ophalen dan op opslag. Hoewel vectoropslag kan worden gebruikt als de ruggengraat van een retriever, zijn er ook andere soorten retrievers.

Om een Chroma retriever in te stellen, installeert u deze eerst met behulp van pip install chromadb. Vervolgens laadt, splitst, sluit u documenten in en haalt u ze op met behulp van een reeks Python-opdrachten. Hier is een codevoorbeeld voor het instellen van een Chroma-retriever:

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import CharacterTextSplitter

from langchain.vectorstores import Chroma full_text = open("state_of_the_union.txt", "r").read()

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=100)

texts = text_splitter.split_text(full_text) embeddings = OpenAIEmbeddings()

db = Chroma.from_texts(texts, embeddings)

retriever = db.as_retriever() retrieved_docs = retriever.invoke("What did the president say about Ketanji Brown Jackson?")

print(retrieved_docs[0].page_content)

De MultiQueryRetriever automatiseert het afstemmen van prompts door meerdere query's te genereren voor een gebruikersinvoerquery en de resultaten te combineren. Hier is een voorbeeld van het eenvoudige gebruik ervan:

from langchain.chat_models import ChatOpenAI

from langchain.retrievers.multi_query import MultiQueryRetriever question = "What are the approaches to Task Decomposition?"

llm = ChatOpenAI(temperature=0)

retriever_from_llm = MultiQueryRetriever.from_llm( retriever=db.as_retriever(), llm=llm

) unique_docs = retriever_from_llm.get_relevant_documents(query=question)

print("Number of unique documents:", len(unique_docs))

Contextuele compressie in LangChain comprimeert opgehaalde documenten met behulp van de context van de zoekopdracht, zodat alleen relevante informatie wordt geretourneerd. Hierbij gaat het om inhoudsreductie en het wegfilteren van minder relevante documenten. In het volgende codevoorbeeld ziet u hoe u Contextual Compression Retriever gebruikt:

from langchain.llms import OpenAI

from langchain.retrievers import ContextualCompressionRetriever

from langchain.retrievers.document_compressors import LLMChainExtractor llm = OpenAI(temperature=0)

compressor = LLMChainExtractor.from_llm(llm)

compression_retriever = ContextualCompressionRetriever(base_compressor=compressor, base_retriever=retriever) compressed_docs = compression_retriever.get_relevant_documents("What did the president say about Ketanji Jackson Brown")

print(compressed_docs[0].page_content)

De EnsembleRetriever combineert verschillende ophaalalgoritmen om betere prestaties te bereiken. Een voorbeeld van het combineren van BM25 en FAISS Retrievers wordt weergegeven in de volgende code:

from langchain.retrievers import BM25Retriever, EnsembleRetriever

from langchain.vectorstores import FAISS bm25_retriever = BM25Retriever.from_texts(doc_list).set_k(2)

faiss_vectorstore = FAISS.from_texts(doc_list, OpenAIEmbeddings())

faiss_retriever = faiss_vectorstore.as_retriever(search_kwargs={"k": 2}) ensemble_retriever = EnsembleRetriever( retrievers=[bm25_retriever, faiss_retriever], weights=[0.5, 0.5]

) docs = ensemble_retriever.get_relevant_documents("apples")

print(docs[0].page_content)

MultiVector Retriever in LangChain maakt het bevragen van documenten met meerdere vectoren per document mogelijk, wat handig is voor het vastleggen van verschillende semantische aspecten binnen een document. Methoden voor het maken van meerdere vectoren zijn onder meer het opsplitsen in kleinere stukken, het samenvatten of het genereren van hypothetische vragen. Voor het opsplitsen van documenten in kleinere stukken kan de volgende Python-code worden gebruikt:

python

from langchain.retrievers.multi_vector import MultiVectorRetriever

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.storage import InMemoryStore

from langchain.document_loaders from TextLoader

import uuid loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()]

text_splitter = RecursiveCharacterTextSplitter(chunk_size=10000)

docs = text_splitter.split_documents(docs) vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

id_key = "doc_id"

retriever = MultiVectorRetriever(vectorstore=vectorstore, docstore=store, id_key=id_key) doc_ids = [str(uuid.uuid4()) for _ in docs]

child_text_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

sub_docs = [sub_doc for doc in docs for sub_doc in child_text_splitter.split_documents([doc])]

for sub_doc in sub_docs: sub_doc.metadata[id_key] = doc_ids[sub_docs.index(sub_doc)] retriever.vectorstore.add_documents(sub_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Een andere methode is het genereren van samenvattingen voor een betere vindbaarheid dankzij een meer gerichte weergave van de inhoud. Hier is een voorbeeld van het genereren van samenvattingen:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema.output_parser import StrOutputParser

from langchain.schema.document import Document chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Summarize the following document:nn{doc}") | ChatOpenAI(max_retries=0) | StrOutputParser()

summaries = chain.batch(docs, {"max_concurrency": 5}) summary_docs = [Document(page_content=s, metadata={id_key: doc_ids[i]}) for i, s in enumerate(summaries)]

retriever.vectorstore.add_documents(summary_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Het genereren van hypothetische vragen die relevant zijn voor elk document met behulp van LLM is een andere benadering. Dit kan gedaan worden met de volgende code:

functions = [{"name": "hypothetical_questions", "parameters": {"questions": {"type": "array", "items": {"type": "string"}}}}]

from langchain.output_parsers.openai_functions import JsonKeyOutputFunctionsParser chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Generate 3 hypothetical questions:nn{doc}") | ChatOpenAI(max_retries=0).bind(functions=functions, function_call={"name": "hypothetical_questions"}) | JsonKeyOutputFunctionsParser(key_name="questions")

hypothetical_questions = chain.batch(docs, {"max_concurrency": 5}) question_docs = [Document(page_content=q, metadata={id_key: doc_ids[i]}) for i, questions in enumerate(hypothetical_questions) for q in questions]

retriever.vectorstore.add_documents(question_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

De Parent Document Retriever is een andere retriever die een balans vindt tussen inbeddingsnauwkeurigheid en contextbehoud door kleine stukjes op te slaan en de grotere ouderdocumenten op te halen. De uitvoering ervan is als volgt:

from langchain.retrievers import ParentDocumentRetriever loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()] child_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

retriever = ParentDocumentRetriever(vectorstore=vectorstore, docstore=store, child_splitter=child_splitter) retriever.add_documents(docs, ids=None) retrieved_docs = retriever.get_relevant_documents("query")

Een zelfvragende retriever construeert gestructureerde zoekopdrachten op basis van natuurlijke taalinvoer en past deze toe op de onderliggende VectorStore. De implementatie ervan wordt weergegeven in de volgende code:

from langchain.chat_models from ChatOpenAI

from langchain.chains.query_constructor.base from AttributeInfo

from langchain.retrievers.self_query.base from SelfQueryRetriever metadata_field_info = [AttributeInfo(name="genre", description="...", type="string"), ...]

document_content_description = "Brief summary of a movie"

llm = ChatOpenAI(temperature=0) retriever = SelfQueryRetriever.from_llm(llm, vectorstore, document_content_description, metadata_field_info) retrieved_docs = retriever.invoke("query")

De WebResearchRetriever voert webonderzoek uit op basis van een bepaalde zoekopdracht –

from langchain.retrievers.web_research import WebResearchRetriever # Initialize components

llm = ChatOpenAI(temperature=0)

search = GoogleSearchAPIWrapper()

vectorstore = Chroma(embedding_function=OpenAIEmbeddings()) # Instantiate WebResearchRetriever

web_research_retriever = WebResearchRetriever.from_llm(vectorstore=vectorstore, llm=llm, search=search) # Retrieve documents

docs = web_research_retriever.get_relevant_documents("query")

Voor onze voorbeelden kunnen we ook de standaard retriever gebruiken die al als volgt is geïmplementeerd als onderdeel van ons vectoropslagobject:

We kunnen nu de retrievers bevragen. De uitvoer van onze query bestaat uit documentobjecten die relevant zijn voor de query. Deze zullen uiteindelijk worden gebruikt om in verdere secties relevante reacties te creëren.

Automatiseer handmatige taken en workflows met onze AI-gestuurde workflowbuilder, ontworpen door Nanonets voor jou en je teams.

Module III: Agenten

LangChain introduceert een krachtig concept genaamd “Agents” dat het idee van ketens naar een geheel nieuw niveau tilt. Agenten maken gebruik van taalmodellen om op dynamische wijze de reeks acties te bepalen die moeten worden uitgevoerd, waardoor ze ongelooflijk veelzijdig en adaptief zijn. In tegenstelling tot traditionele ketens, waar acties hardgecodeerd zijn in code, gebruiken agenten taalmodellen als redeneermachines om te beslissen welke acties ze moeten ondernemen en in welke volgorde.

De agent is de kerncomponent die verantwoordelijk is voor de besluitvorming. Het maakt gebruik van de kracht van een taalmodel en een prompt om de volgende stappen te bepalen om een specifiek doel te bereiken. De invoer voor een agent omvat doorgaans:

- Tools: Beschrijvingen van beschikbare tools (hierover later meer).

- Gebruikers invoer: Het doel of de vraag op hoog niveau van de gebruiker.

- Tussenstappen: Een geschiedenis van (actie, gereedschapsuitvoer) paren die zijn uitgevoerd om de huidige gebruikersinvoer te bereiken.

De output van een agent kan de volgende zijn actie actie ondernemen (Agentacties) of de finale antwoord om naar de gebruiker te sturen (AgentFinish). Een actie specificeert a tools en invoer voor dat gereedschap.

Tools

Tools zijn interfaces die een agent kan gebruiken om met de wereld te communiceren. Ze stellen agenten in staat verschillende taken uit te voeren, zoals zoeken op internet, shell-opdrachten uitvoeren of toegang krijgen tot externe API's. In LangChain zijn tools essentieel om de mogelijkheden van agenten uit te breiden en hen in staat te stellen diverse taken uit te voeren.

Om tools in LangChain te gebruiken, kunt u ze laden met behulp van het volgende fragment:

from langchain.agents import load_tools tool_names = [...]

tools = load_tools(tool_names)

Voor sommige tools is mogelijk een basistaalmodel (LLM) nodig om te initialiseren. In dergelijke gevallen kunt u ook een LLM behalen:

from langchain.agents import load_tools tool_names = [...]

llm = ...

tools = load_tools(tool_names, llm=llm)

Met deze configuratie hebt u toegang tot een verscheidenheid aan tools en kunt u deze integreren in de workflows van uw agent. De volledige lijst met tools met gebruiksdocumentatie is hier.

Laten we eens kijken naar enkele voorbeelden van Tools.

DuckDuckGo

Met de DuckDuckGo-tool kunt u zoekopdrachten op internet uitvoeren met behulp van de zoekmachine. Hier ziet u hoe u het kunt gebruiken:

from langchain.tools import DuckDuckGoSearchRun

search = DuckDuckGoSearchRun()

search.run("manchester united vs luton town match summary")

GegevensForSeo

Met de DataForSeo toolkit kunt u zoekresultaten van zoekmachines verkrijgen met behulp van de DataForSeo API. Om deze toolkit te gebruiken, moet u uw API-gegevens instellen. Zo configureert u de inloggegevens:

import os os.environ["DATAFORSEO_LOGIN"] = "<your_api_access_username>"

os.environ["DATAFORSEO_PASSWORD"] = "<your_api_access_password>"

Zodra uw inloggegevens zijn ingesteld, kunt u een DataForSeoAPIWrapper hulpmiddel om toegang te krijgen tot de API:

from langchain.utilities.dataforseo_api_search import DataForSeoAPIWrapper wrapper = DataForSeoAPIWrapper() result = wrapper.run("Weather in Los Angeles")

De DataForSeoAPIWrapper tool haalt zoekresultaten van zoekmachines op uit verschillende bronnen.

U kunt het type resultaten en velden aanpassen dat in het JSON-antwoord wordt geretourneerd. U kunt bijvoorbeeld de resultaattypen en velden opgeven en een maximumaantal instellen voor het aantal topresultaten dat moet worden geretourneerd:

json_wrapper = DataForSeoAPIWrapper( json_result_types=["organic", "knowledge_graph", "answer_box"], json_result_fields=["type", "title", "description", "text"], top_count=3,

) json_result = json_wrapper.results("Bill Gates")

In dit voorbeeld wordt het JSON-antwoord aangepast door resultaattypen en velden op te geven en het aantal resultaten te beperken.

U kunt ook de locatie en taal voor uw zoekresultaten opgeven door aanvullende parameters door te geven aan de API-wrapper:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en"},

) customized_result = customized_wrapper.results("coffee near me")

Door locatie- en taalparameters op te geven, kunt u uw zoekresultaten afstemmen op specifieke regio's en talen.

U heeft de flexibiliteit om de zoekmachine te kiezen die u wilt gebruiken. Geef eenvoudig de gewenste zoekmachine op:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en", "se_name": "bing"},

) customized_result = customized_wrapper.results("coffee near me")

In dit voorbeeld is de zoekopdracht aangepast om Bing als zoekmachine te gebruiken.

Met de API-wrapper kunt u ook het type zoekopdracht opgeven dat u wilt uitvoeren. U kunt bijvoorbeeld een kaartzoekopdracht uitvoeren:

maps_search = DataForSeoAPIWrapper( top_count=10, json_result_fields=["title", "value", "address", "rating", "type"], params={ "location_coordinate": "52.512,13.36,12z", "language_code": "en", "se_type": "maps", },

) maps_search_result = maps_search.results("coffee near me")

Hiermee wordt de zoekopdracht aangepast om kaartgerelateerde informatie op te halen.

Shell (bash)

De Shell-toolkit biedt agenten toegang tot de shell-omgeving, waardoor ze shell-opdrachten kunnen uitvoeren. Deze functie is krachtig, maar moet met voorzichtigheid worden gebruikt, vooral in sandbox-omgevingen. Zo kunt u de Shell-tool gebruiken:

from langchain.tools import ShellTool shell_tool = ShellTool() result = shell_tool.run({"commands": ["echo 'Hello World!'", "time"]})

In dit voorbeeld voert de Shell-tool twee shell-opdrachten uit: in echo 'Hallo wereld!' en weergave van de huidige tijd.

U kunt de Shell-tool aan een agent ter beschikking stellen om complexere taken uit te voeren. Hier is een voorbeeld van een agent die links van een webpagina ophaalt met behulp van de Shell-tool:

from langchain.agents import AgentType, initialize_agent

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(temperature=0.1) shell_tool.description = shell_tool.description + f"args {shell_tool.args}".replace( "{", "{{"

).replace("}", "}}")

self_ask_with_search = initialize_agent( [shell_tool], llm, agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

self_ask_with_search.run( "Download the langchain.com webpage and grep for all urls. Return only a sorted list of them. Be sure to use double quotes."

)

In dit scenario gebruikt de agent de Shell-tool om een reeks opdrachten uit te voeren om URL's van een webpagina op te halen, te filteren en te sorteren.

De gegeven voorbeelden demonstreren enkele van de tools die beschikbaar zijn in LangChain. Deze tools breiden uiteindelijk de mogelijkheden van agenten uit (verkend in de volgende subsectie) en stellen hen in staat verschillende taken efficiënt uit te voeren. Afhankelijk van uw vereisten kunt u de tools en toolkits kiezen die het beste aansluiten bij de behoeften van uw project en deze integreren in de workflows van uw agent.

Terug naar Agenten

Laten we nu verder gaan met agenten.

De AgentExecutor is de runtimeomgeving voor een agent. Het is verantwoordelijk voor het oproepen van de agent, het uitvoeren van de acties die het selecteert, het doorgeven van de actie-uitvoer aan de agent en het herhalen van het proces totdat de agent klaar is. In pseudocode zou de AgentExecutor er ongeveer zo uit kunnen zien:

next_action = agent.get_action(...)

while next_action != AgentFinish: observation = run(next_action) next_action = agent.get_action(..., next_action, observation)

return next_action

De AgentExecutor kan verschillende complexiteiten aan, zoals het omgaan met gevallen waarin de agent een niet-bestaand hulpmiddel selecteert, het afhandelen van gereedschapsfouten, het beheren van door de agent geproduceerde uitvoer en het bieden van logboekregistratie en observatie op alle niveaus.

Hoewel de klasse AgentExecutor de primaire agentruntime in LangChain is, worden er andere, meer experimentele runtimes ondersteund, waaronder:

- Plan-en-uitvoeragent

- Baby-AGI

- Automatische GPT

Laten we, om een beter inzicht te krijgen in het agentframework, een basisagent helemaal opnieuw bouwen en vervolgens verdergaan met het verkennen van vooraf gebouwde agenten.

Voordat we ingaan op het bouwen van de agent, is het essentieel om enkele belangrijke terminologie en schema's opnieuw te bekijken:

- Agentactie: Dit is een gegevensklasse die de actie vertegenwoordigt die een agent moet ondernemen. Het bestaat uit een

tooleigenschap (de naam van het hulpmiddel dat moet worden aangeroepen) en atool_inputeigenschap (de invoer voor dat hulpmiddel). - AgentFinish: Deze gegevensklasse geeft aan dat de agent zijn taak heeft voltooid en een antwoord naar de gebruiker moet retourneren. Het bevat doorgaans een woordenboek met geretourneerde waarden, vaak met een sleutel 'uitvoer' die de antwoordtekst bevat.

- Tussenstappen: Dit zijn de records van eerdere agentacties en bijbehorende outputs. Ze zijn cruciaal voor het doorgeven van context aan toekomstige iteraties van de agent.

In ons voorbeeld gebruiken we OpenAI Function Calling om onze agent te maken. Deze aanpak is betrouwbaar voor het maken van agenten. We beginnen met het maken van een eenvoudig hulpmiddel dat de lengte van een woord berekent. Deze tool is handig omdat taalmodellen soms fouten kunnen maken als gevolg van tokenisatie bij het tellen van woordlengtes.

Laten we eerst het taalmodel laden dat we gaan gebruiken om de agent te besturen:

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

Laten we het model testen met een woordlengteberekening:

llm.invoke("how many letters in the word educa?")

Het antwoord moet het aantal letters van het woord ‘educa’ aangeven.

Vervolgens definiëren we een eenvoudige Python-functie om de lengte van een woord te berekenen:

from langchain.agents import tool @tool

def get_word_length(word: str) -> int: """Returns the length of a word.""" return len(word)

We hebben een tool gemaakt met de naam get_word_length dat een woord als invoer neemt en de lengte ervan retourneert.

Laten we nu de prompt voor de agent maken. De prompt instrueert de agent over het redeneren en formatteren van de uitvoer. In ons geval gebruiken we OpenAI Function Calling, waarvoor minimale instructies nodig zijn. We definiëren de prompt met tijdelijke aanduidingen voor gebruikersinvoer en het kladblok van de agent:

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Hoe weet de agent nu welke tools hij kan gebruiken? We vertrouwen op OpenAI-functieaanroepende taalmodellen, waarvoor functies afzonderlijk moeten worden doorgegeven. Om onze tools aan de agent te leveren, formatteren we ze als OpenAI-functieaanroepen:

from langchain.tools.render import format_tool_to_openai_function llm_with_tools = llm.bind(functions=[format_tool_to_openai_function(t) for t in tools])

Nu kunnen we de agent maken door invoertoewijzingen te definiëren en de componenten te verbinden:

Dit is LCEL-taal. We zullen dit later in detail bespreken.

from langchain.agents.format_scratchpad import format_to_openai_function_messages

from langchain.agents.output_parsers import OpenAIFunctionsAgentOutputParser agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai _function_messages( x["intermediate_steps"] ), } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

We hebben onze agent gemaakt, die gebruikersinvoer begrijpt, beschikbare tools gebruikt en de uitvoer formatteert. Laten we er nu mee omgaan:

agent.invoke({"input": "how many letters in the word educa?", "intermediate_steps": []})

De agent moet reageren met een AgentAction, waarmee de volgende actie wordt aangegeven.

We hebben de agent gemaakt, maar nu moeten we er een runtime voor schrijven. De eenvoudigste runtime is een runtime waarbij de agent continu wordt opgeroepen, acties wordt uitgevoerd en wordt herhaald totdat de agent klaar is. Hier is een voorbeeld:

from langchain.schema.agent import AgentFinish user_input = "how many letters in the word educa?"

intermediate_steps = [] while True: output = agent.invoke( { "input": user_input, "intermediate_steps": intermediate_steps, } ) if isinstance(output, AgentFinish): final_result = output.return_values["output"] break else: print(f"TOOL NAME: {output.tool}") print(f"TOOL INPUT: {output.tool_input}") tool = {"get_word_length": get_word_length}[output.tool] observation = tool.run(output.tool_input) intermediate_steps.append((output, observation)) print(final_result)

In deze lus bellen we herhaaldelijk de agent, voeren we acties uit en werken we de tussenstappen bij totdat de agent klaar is. We verzorgen ook gereedschapsinteracties binnen de lus.

Om dit proces te vereenvoudigen, biedt LangChain de klasse AgentExecutor, die de uitvoering van agenten omvat en foutafhandeling, vroegtijdig stoppen, traceren en andere verbeteringen biedt. Laten we AgentExecutor gebruiken om met de agent te communiceren:

from langchain.agents import AgentExecutor agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True) agent_executor.invoke({"input": "how many letters in the word educa?"})

AgentExecutor vereenvoudigt het uitvoeringsproces en biedt een handige manier om met de agent te communiceren.

Het geheugen wordt later ook in detail besproken.

De agent die we tot nu toe hebben gemaakt, is staatloos, wat betekent dat hij eerdere interacties niet onthoudt. Om vervolgvragen en gesprekken mogelijk te maken, moeten we geheugen aan de agent toevoegen. Dit omvat twee stappen:

- Voeg een geheugenvariabele toe aan de prompt om de chatgeschiedenis op te slaan.

- Houd de chatgeschiedenis bij tijdens interacties.

Laten we beginnen met het toevoegen van een tijdelijke aanduiding voor geheugen in de prompt:

from langchain.prompts import MessagesPlaceholder MEMORY_KEY = "chat_history"

prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), MessagesPlaceholder(variable_name=MEMORY_KEY), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Maak nu een lijst om de chatgeschiedenis bij te houden:

from langchain.schema.messages import HumanMessage, AIMessage chat_history = []

Bij het maken van de agent nemen we ook het geheugen op:

agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai_function_messages( x["intermediate_steps"] ), "chat_history": lambda x: x["chat_history"], } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Zorg er nu voor dat u bij het uitvoeren van de agent de chatgeschiedenis bijwerkt:

input1 = "how many letters in the word educa?"

result = agent_executor.invoke({"input": input1, "chat_history": chat_history})

chat_history.extend([ HumanMessage(content=input1), AIMessage(content=result["output"]),

])

agent_executor.invoke({"input": "is that a real word?", "chat_history": chat_history})

Hierdoor kan de agent een gespreksgeschiedenis bijhouden en vervolgvragen beantwoorden op basis van eerdere interacties.

Gefeliciteerd! U heeft met succes uw eerste end-to-end-agent in LangChain gemaakt en uitgevoerd. Om dieper in te gaan op de mogelijkheden van LangChain, kunt u het volgende verkennen:

- Verschillende agenttypen worden ondersteund.

- Vooraf gebouwde agenten

- Hoe te werken met tools en toolintegraties.

Agenttypen

LangChain biedt verschillende soorten agenten, elk geschikt voor specifieke gebruiksscenario's. Hier zijn enkele van de beschikbare agenten:

- Zero-shot ReAct: Deze agent gebruikt het ReAct-framework om tools uitsluitend op basis van hun beschrijvingen te kiezen. Het vereist beschrijvingen voor elk hulpmiddel en is zeer veelzijdig.

- Gestructureerde input ReAct: Deze agent verwerkt tools met meerdere invoer en is geschikt voor complexe taken zoals het navigeren door een webbrowser. Het gebruikt een argumentschema van tools voor gestructureerde invoer.

- OpenAI-functies: Deze agent is speciaal ontworpen voor modellen die zijn afgestemd op het aanroepen van functies en is compatibel met modellen als gpt-3.5-turbo-0613 en gpt-4-0613. We hebben dit gebruikt om onze eerste agent hierboven te maken.

- Gesprek: Deze agent is ontworpen voor gesprekssituaties en gebruikt ReAct voor toolselectie en gebruikt geheugen om eerdere interacties te onthouden.

- Zelf vragen met zoeken: Deze agent vertrouwt op één enkele tool, ‘Intermediate Answer’, die feitelijke antwoorden op vragen opzoekt. Het is gelijk aan de originele zelfvraag met zoekpapier.

- ReAct-documentopslag: Deze agent communiceert met een documentopslag met behulp van het ReAct-framework. Het vereist de tools "Zoeken" en "Opzoeken" en is vergelijkbaar met het Wikipedia-voorbeeld van het originele ReAct-artikel.

Ontdek deze agenttypen om degene te vinden die het beste bij uw behoeften past in LangChain. Met deze agenten kunt u een reeks tools aan hen koppelen om acties af te handelen en reacties te genereren. Meer informatie op hoe u hier uw eigen agent met tools kunt bouwen.

Vooraf gebouwde agenten

Laten we onze verkenning van agenten voortzetten, waarbij we ons concentreren op vooraf gebouwde agenten die beschikbaar zijn in LangChain.

Gmail

LangChain biedt een Gmail-toolkit waarmee u uw LangChain-e-mail kunt verbinden met de Gmail API. Om aan de slag te gaan, moet u uw inloggegevens instellen. Deze worden uitgelegd in de Gmail API-documentatie. Zodra u de credentials.json bestand, kunt u doorgaan met het gebruik van de Gmail API. Bovendien moet u enkele vereiste bibliotheken installeren met behulp van de volgende opdrachten:

pip install --upgrade google-api-python-client > /dev/null

pip install --upgrade google-auth-oauthlib > /dev/null

pip install --upgrade google-auth-httplib2 > /dev/null

pip install beautifulsoup4 > /dev/null # Optional for parsing HTML messages

U kunt de Gmail-toolkit als volgt maken:

from langchain.agents.agent_toolkits import GmailToolkit toolkit = GmailToolkit()

U kunt de authenticatie ook aanpassen aan uw behoeften. Achter de schermen wordt een googleapi-bron gemaakt met behulp van de volgende methoden:

from langchain.tools.gmail.utils import build_resource_service, get_gmail_credentials credentials = get_gmail_credentials( token_file="token.json", scopes=["https://mail.google.com/"], client_secrets_file="credentials.json",

)

api_resource = build_resource_service(credentials=credentials)

toolkit = GmailToolkit(api_resource=api_resource)

De toolkit biedt verschillende tools die binnen een agent kunnen worden gebruikt, waaronder:

GmailCreateDraft: maak een concept-e-mail met gespecificeerde berichtvelden.GmailSendMessage: e-mailberichten verzenden.GmailSearch: zoeken naar e-mailberichten of discussielijnen.GmailGetMessage: een e-mail ophalen op bericht-ID.GmailGetThread: zoeken naar e-mailberichten.

Om deze tools binnen een agent te gebruiken, kunt u de agent als volgt initialiseren:

from langchain.llms import OpenAI

from langchain.agents import initialize_agent, AgentType llm = OpenAI(temperature=0)

agent = initialize_agent( tools=toolkit.get_tools(), llm=llm, agent=AgentType.STRUCTURED_CHAT_ZERO_SHOT_REACT_DESCRIPTION,

)

Hier zijn een paar voorbeelden van hoe deze tools kunnen worden gebruikt:

- Maak een Gmail-concept om te bewerken:

agent.run( "Create a gmail draft for me to edit of a letter from the perspective of a sentient parrot " "who is looking to collaborate on some research with her estranged friend, a cat. " "Under no circumstances may you send the message, however."

)

- Zoek naar de nieuwste e-mail in uw concepten:

agent.run("Could you search in my drafts for the latest email?")

Deze voorbeelden demonstreren de mogelijkheden van de Gmail-toolkit van LangChain binnen een agent, waardoor u programmatisch met Gmail kunt communiceren.

SQL Database-agent

Deze sectie biedt een overzicht van een agent die is ontworpen voor interactie met SQL-databases, met name de Chinook-database. Deze agent kan algemene vragen over een database beantwoorden en fouten herstellen. Houd er rekening mee dat het nog steeds in actieve ontwikkeling is en dat niet alle antwoorden correct kunnen zijn. Wees voorzichtig als u het op gevoelige gegevens uitvoert, omdat het DML-instructies op uw database kan uitvoeren.

Om deze agent te gebruiken, kunt u deze als volgt initialiseren:

from langchain.agents import create_sql_agent

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.agents import AgentExecutor

from langchain.agents.agent_types import AgentType

from langchain.chat_models import ChatOpenAI db = SQLDatabase.from_uri("sqlite:///../../../../../notebooks/Chinook.db")

toolkit = SQLDatabaseToolkit(db=db, llm=OpenAI(temperature=0)) agent_executor = create_sql_agent( llm=OpenAI(temperature=0), toolkit=toolkit, verbose=True, agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

)

Deze agent kan worden geïnitialiseerd met behulp van de ZERO_SHOT_REACT_DESCRIPTION soort agent. Het is ontworpen om vragen te beantwoorden en beschrijvingen te geven. Als alternatief kunt u de agent initialiseren met behulp van de OPENAI_FUNCTIONS agenttype met het GPT-3.5-turbomodel van OpenAI, dat we in onze eerdere client gebruikten.

Disclaimer

- De queryketen kan query's voor invoegen/bijwerken/verwijderen genereren. Wees voorzichtig en gebruik indien nodig een aangepaste prompt of maak een SQL-gebruiker aan zonder schrijfrechten.

- Houd er rekening mee dat het uitvoeren van bepaalde query's, zoals 'voer de grootst mogelijke query uit', uw SQL-database kan overbelasten, vooral als deze miljoenen rijen bevat.

- Datawarehouse-georiënteerde databases ondersteunen vaak quota's op gebruikersniveau om het gebruik van bronnen te beperken.

U kunt de agent vragen een tabel te beschrijven, zoals de tabel “playlisttrack”. Hier is een voorbeeld van hoe u dit moet doen:

agent_executor.run("Describe the playlisttrack table")

De agent geeft informatie over het schema van de tabel en voorbeeldrijen.

Als u per ongeluk vraagt naar een tabel die niet bestaat, kan de agent de tabel herstellen en informatie verstrekken over de tabel die het dichtst bij de tabel past. Bijvoorbeeld:

agent_executor.run("Describe the playlistsong table")

De agent zal de dichtstbijzijnde bijpassende tafel vinden en hierover informatie verstrekken.

U kunt de agent ook vragen om query's uit te voeren op de database. Bijvoorbeeld:

agent_executor.run("List the total sales per country. Which country's customers spent the most?")

De agent voert de zoekopdracht uit en geeft het resultaat, bijvoorbeeld het land met de hoogste totale omzet.

Om het totale aantal nummers in elke afspeellijst te krijgen, kunt u de volgende query gebruiken:

agent_executor.run("Show the total number of tracks in each playlist. The Playlist name should be included in the result.")

De agent retourneert de namen van de afspeellijsten samen met het bijbehorende totale aantal nummers.

In gevallen waarin de agent fouten tegenkomt, kan deze herstellen en nauwkeurige antwoorden geven. Bijvoorbeeld:

agent_executor.run("Who are the top 3 best selling artists?")

Zelfs nadat er een eerste fout is opgetreden, zal de agent het aanpassen en het juiste antwoord geven, wat in dit geval de top 3 van best verkochte artiesten is.

Panda's DataFrame-agent

In deze sectie wordt een agent geïntroduceerd die is ontworpen om te communiceren met Pandas DataFrames voor het beantwoorden van vragen. Houd er rekening mee dat deze agent de Python-agent onder de motorkap gebruikt om Python-code uit te voeren die is gegenereerd door een taalmodel (LLM). Wees voorzichtig bij het gebruik van deze agent om mogelijke schade door kwaadaardige Python-code die door de LLM wordt gegenereerd, te voorkomen.

U kunt de Pandas DataFrame-agent als volgt initialiseren:

from langchain_experimental.agents.agent_toolkits import create_pandas_dataframe_agent

from langchain.chat_models import ChatOpenAI

from langchain.agents.agent_types import AgentType from langchain.llms import OpenAI

import pandas as pd df = pd.read_csv("titanic.csv") # Using ZERO_SHOT_REACT_DESCRIPTION agent type

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), df, verbose=True) # Alternatively, using OPENAI_FUNCTIONS agent type

# agent = create_pandas_dataframe_agent(

# ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613"),

# df,

# verbose=True,

# agent_type=AgentType.OPENAI_FUNCTIONS,

# )

U kunt de agent vragen het aantal rijen in het DataFrame te tellen:

agent.run("how many rows are there?")

De agent voert de code uit df.shape[0] en geef het antwoord, zoals "Er zijn 891 rijen in het dataframe."

U kunt de agent ook vragen rijen te filteren op basis van specifieke criteria, zoals het vinden van het aantal mensen met meer dan drie broers en zussen:

agent.run("how many people have more than 3 siblings")

De agent voert de code uit df[df['SibSp'] > 3].shape[0] en geef het antwoord, zoals '30 mensen hebben meer dan drie broers en zussen.'

Als u de wortel van de gemiddelde leeftijd wilt berekenen, kunt u de agent vragen:

agent.run("whats the square root of the average age?")

De agent berekent de gemiddelde leeftijd met behulp van df['Age'].mean() en bereken vervolgens de vierkantswortel met behulp van math.sqrt(). Het zal het antwoord opleveren, zoals: “De vierkantswortel van de gemiddelde leeftijd is 5.449689683556195.”

Laten we een kopie van het DataFrame maken en de ontbrekende leeftijdswaarden worden gevuld met de gemiddelde leeftijd:

df1 = df.copy()

df1["Age"] = df1["Age"].fillna(df1["Age"].mean())

Vervolgens kunt u de agent initialiseren met beide DataFrames en deze een vraag stellen:

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), [df, df1], verbose=True)

agent.run("how many rows in the age column are different?")

De agent vergelijkt de leeftijdskolommen in beide DataFrames en geeft het antwoord, bijvoorbeeld "177 rijen in de leeftijdskolom zijn verschillend."

Jira-toolkit

In deze sectie wordt uitgelegd hoe u de Jira-toolkit gebruikt, waarmee agenten kunnen communiceren met een Jira-instantie. Met deze toolkit kunt u verschillende acties uitvoeren, zoals het zoeken naar problemen en het aanmaken van problemen. Het maakt gebruik van de Atlassian-Python-API-bibliotheek. Als u deze toolkit wilt gebruiken, moet u omgevingsvariabelen instellen voor uw Jira-instantie, waaronder JIRA_API_TOKEN, JIRA_USERNAME en JIRA_INSTANCE_URL. Bovendien moet u mogelijk uw OpenAI API-sleutel instellen als omgevingsvariabele.

Installeer om te beginnen de atlassian-python-api-bibliotheek en stel de vereiste omgevingsvariabelen in:

%pip install atlassian-python-api import os

from langchain.agents import AgentType

from langchain.agents import initialize_agent

from langchain.agents.agent_toolkits.jira.toolkit import JiraToolkit

from langchain.llms import OpenAI

from langchain.utilities.jira import JiraAPIWrapper os.environ["JIRA_API_TOKEN"] = "abc"

os.environ["JIRA_USERNAME"] = "123"

os.environ["JIRA_INSTANCE_URL"] = "https://jira.atlassian.com"

os.environ["OPENAI_API_KEY"] = "xyz" llm = OpenAI(temperature=0)

jira = JiraAPIWrapper()

toolkit = JiraToolkit.from_jira_api_wrapper(jira)

agent = initialize_agent( toolkit.get_tools(), llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

U kunt de agent opdracht geven om in een specifiek project een nieuw probleem aan te maken met een samenvatting en beschrijving:

agent.run("make a new issue in project PW to remind me to make more fried rice")

De agent zal de nodige acties uitvoeren om het probleem aan te maken en een reactie te geven, zoals “Er is een nieuw probleem aangemaakt in project PW met de samenvatting ‘Maak meer gebakken rijst’ en de beschrijving ‘Herinnering om meer gebakken rijst te maken’.”

Hierdoor kunt u met uw Jira-instantie communiceren met behulp van instructies in natuurlijke taal en de Jira-toolkit.

Automatiseer handmatige taken en workflows met onze AI-gestuurde workflowbuilder, ontworpen door Nanonets voor jou en je teams.

Module IV: Kettingen

LangChain is een tool die is ontworpen voor het gebruik van grote taalmodellen (LLM's) in complexe toepassingen. Het biedt raamwerken voor het creëren van ketens van componenten, inclusief LLM's en andere soorten componenten. Twee primaire raamwerken

- De LangChain-expressietaal (LCEL)

- Legacy Chain-interface

De LangChain Expression Language (LCEL) is een syntaxis die een intuïtieve samenstelling van ketens mogelijk maakt. Het ondersteunt geavanceerde functies zoals streaming, asynchrone oproepen, batching, parallellisatie, nieuwe pogingen, fallbacks en tracering. U kunt bijvoorbeeld een prompt-, model- en uitvoerparser samenstellen in LCEL, zoals weergegeven in de volgende code:

from langchain.prompts import ChatPromptTemplate

from langchain.schema import StrOutputParser model = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

prompt = ChatPromptTemplate.from_messages([ ("system", "You're a very knowledgeable historian who provides accurate and eloquent answers to historical questions."), ("human", "{question}")

])

runnable = prompt | model | StrOutputParser() for chunk in runnable.stream({"question": "What are the seven wonders of the world"}): print(chunk, end="", flush=True)

Als alternatief is de LLMChain een optie vergelijkbaar met LCEL voor het samenstellen van componenten. Het LLMChain-voorbeeld is als volgt:

from langchain.chains import LLMChain chain = LLMChain(llm=model, prompt=prompt, output_parser=StrOutputParser())

chain.run(question="What are the seven wonders of the world")

Ketens in LangChain kunnen ook stateful zijn door een Memory-object op te nemen. Dit zorgt voor gegevenspersistentie tussen gesprekken, zoals weergegeven in dit voorbeeld:

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory conversation = ConversationChain(llm=chat, memory=ConversationBufferMemory())

conversation.run("Answer briefly. What are the first 3 colors of a rainbow?")

conversation.run("And the next 4?")

LangChain ondersteunt ook integratie met de API's voor het aanroepen van functies van OpenAI, wat handig is voor het verkrijgen van gestructureerde uitvoer en het uitvoeren van functies binnen een keten. Om gestructureerde uitvoer te verkrijgen, kunt u deze specificeren met behulp van Pydantic-klassen of JsonSchema, zoals hieronder geïllustreerd:

from langchain.pydantic_v1 import BaseModel, Field

from langchain.chains.openai_functions import create_structured_output_runnable

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") fav_food: Optional[str] = Field(None, description="The person's favorite food") llm = ChatOpenAI(model="gpt-4", temperature=0)

prompt = ChatPromptTemplate.from_messages([ # Prompt messages here

]) runnable = create_structured_output_runnable(Person, llm, prompt)

runnable.invoke({"input": "Sally is 13"})

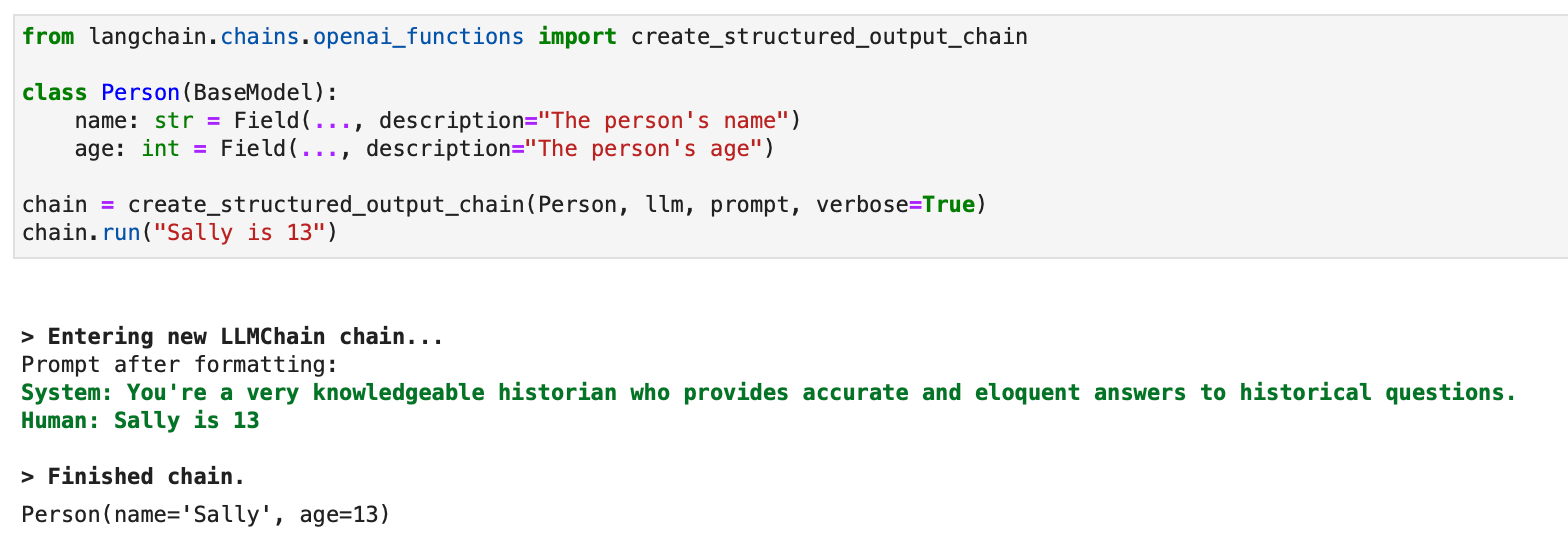

Voor gestructureerde uitvoer is er ook een verouderde aanpak met LLMChain beschikbaar:

from langchain.chains.openai_functions import create_structured_output_chain class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") chain = create_structured_output_chain(Person, llm, prompt, verbose=True)

chain.run("Sally is 13")

LangChain maakt gebruik van OpenAI-functies om verschillende specifieke ketens voor verschillende doeleinden te creëren. Deze omvatten ketens voor extractie, tagging, OpenAPI en QA met citaten.

In de context van extractie is het proces vergelijkbaar met de gestructureerde outputketen, maar richt het zich op de extractie van informatie of entiteiten. Bij het taggen is het de bedoeling om een document te labelen met klassen zoals sentiment, taal, stijl, behandelde onderwerpen of politieke strekking.

Een voorbeeld van hoe tagging werkt in LangChain kan worden gedemonstreerd met een Python-code. Het proces begint met het installeren van de benodigde pakketten en het opzetten van de omgeving: