Generatieve kunstmatige intelligentie (AI)-toepassingen gebouwd rond grote taalmodellen (LLM's) hebben het potentieel aangetoond om economische waarde voor bedrijven te creëren en te versnellen. Voorbeelden van toepassingen zijn onder meer conversatie zoeken, hulp van een klantenservicemedewerker, analyses van klantenondersteuning, virtuele zelfbedieningsassistenten, chatbots, rijke mediageneratie, inhoud modereren, codeerpartners om de veilige, krachtige softwareontwikkeling te versnellen, diepere inzichten uit multimodale inhoudsbronnen, versnelling van de beveiligingsonderzoeken en -maatregelen van uw organisatie, en nog veel meer. Veel klanten zijn op zoek naar begeleiding bij het beheren van beveiliging, privacy en compliance bij het ontwikkelen van generatieve AI-toepassingen. Het begrijpen en aanpakken van LLM-kwetsbaarheden, bedreigingen en risico’s tijdens de ontwerp- en architectuurfasen helpt teams zich te concentreren op het maximaliseren van de economische en productiviteitsvoordelen die generatieve AI kan opleveren. Het zich bewust zijn van risico's bevordert de transparantie en het vertrouwen in generatieve AI-toepassingen, stimuleert een grotere waarneembaarheid, helpt bij het voldoen aan compliance-eisen en vergemakkelijkt geïnformeerde besluitvorming door leiders.

Het doel van dit bericht is om AI- en machine learning (ML)-ingenieurs, datawetenschappers, oplossingsarchitecten, beveiligingsteams en andere belanghebbenden in staat te stellen een gemeenschappelijk mentaal model en raamwerk te hebben om best practices op het gebied van beveiliging toe te passen, waardoor AI/ML-teams kunnen bewegen snel zonder beveiliging in te ruilen voor snelheid. Dit artikel is specifiek bedoeld om AI/ML- en datawetenschappers die mogelijk nog niet eerder in aanraking zijn gekomen met beveiligingsprincipes, inzicht te geven in de belangrijkste best practices op het gebied van beveiliging en privacy in de context van de ontwikkeling van generatieve AI-toepassingen met behulp van LLM's. We bespreken ook gemeenschappelijke veiligheidsproblemen die het vertrouwen in AI kunnen ondermijnen, zoals geïdentificeerd door de Open Worldwide Application Security Project (OWASP) Top 10 voor LLM-applicatiesen laat zien hoe u AWS kunt gebruiken om uw beveiligingspositie en vertrouwen te vergroten terwijl u met generatieve AI innoveert.

Dit bericht biedt drie begeleide stappen voor het ontwerpen van risicobeheerstrategieën en het ontwikkelen van generatieve AI-toepassingen met behulp van LLM's. We verdiepen ons eerst in de kwetsbaarheden, bedreigingen en risico's die voortkomen uit de implementatie, inzet en gebruik van LLM-oplossingen, en geven advies over hoe u kunt beginnen met innoveren met het oog op beveiliging. Vervolgens bespreken we hoe het bouwen op een veilige basis essentieel is voor generatieve AI. Ten slotte verbinden we deze met een voorbeeld van een LLM-werklast om een benadering van architectuur te beschrijven met diepgaande beveiliging over vertrouwensgrenzen heen.

Aan het einde van dit bericht, AI/ML-ingenieurs, datawetenschappers en veiligheidsbewuste technologen zullen in staat zijn strategieën te identificeren om gelaagde verdedigingen voor hun generatieve AI-toepassingen te ontwerpen, te begrijpen hoe ze de OWASP Top 10 voor LLM-beveiligingsproblemen kunnen toewijzen aan een aantal overeenkomstige controles, en fundamentele kennis kunnen opbouwen om het beantwoorden van de volgende belangrijkste AWS-klantvraagthema's voor hun toepassingen:

- Wat zijn enkele veelvoorkomende beveiligings- en privacyrisico's bij het gebruik van generatieve AI op basis van LLM's in mijn toepassingen waarop ik met deze richtlijnen de meeste invloed kan uitoefenen?

- Wat zijn enkele manieren om beveiligings- en privacycontroles te implementeren in de ontwikkelingslevenscyclus van generatieve AI LLM-applicaties op AWS?

- Welke operationele en technische best practices kan ik integreren in de manier waarop mijn organisatie generatieve AI LLM-applicaties bouwt om risico's te beheren en het vertrouwen in generatieve AI-applicaties met behulp van LLM's te vergroten?

Verbeter de beveiligingsresultaten en ontwikkel tegelijkertijd generatieve AI

Innovatie met generatieve AI met behulp van LLM's vereist dat u begint met beveiliging in gedachten om de veerkracht van de organisatie te ontwikkelen, voort te bouwen op een veilige basis en beveiliging te integreren met een diepgaande beveiligingsaanpak. Beveiliging is een gedeelde verantwoordelijkheid tussen AWS en AWS-klanten. Alle principes van het AWS Shared Responsibility Model zijn van toepassing op generatieve AI-oplossingen. Vernieuw uw begrip van het AWS Shared Responsibility Model zoals dit van toepassing is op infrastructuur, services en gegevens wanneer u LLM-oplossingen bouwt.

Begin met beveiliging in gedachten om de veerkracht van de organisatie te ontwikkelen

Begin met beveiliging in gedachten om de veerkracht van de organisatie te ontwikkelen voor het ontwikkelen van generatieve AI-applicaties die voldoen aan uw beveiligings- en compliancedoelstellingen. De veerkracht van de organisatie maakt gebruik van en breidt deze uit definitie van veerkracht in het AWS Well-Architected Framework het opnemen van en voorbereiden op het vermogen van een organisatie om te herstellen van verstoringen. Houd rekening met uw beveiligingspositie, bestuur en operationele uitmuntendheid bij het beoordelen van de algehele bereidheid om generatieve AI met LLM's te ontwikkelen en de veerkracht van uw organisatie tegen mogelijke gevolgen. Naarmate uw organisatie het gebruik van opkomende technologieën zoals generatieve AI en LLM’s bevordert, moet de algehele veerkracht van de organisatie worden beschouwd als een hoeksteen van een gelaagde defensieve strategie om activa en bedrijfsonderdelen te beschermen tegen onbedoelde gevolgen.

De veerkracht van de organisatie is van groot belang voor LLM-toepassingen

Hoewel alle risicobeheerprogramma’s kunnen profiteren van veerkracht, is de veerkracht van de organisatie van groot belang voor generatieve AI. Vijf van de door OWASP geïdentificeerde top 10 risico's voor LLM-applicaties zijn afhankelijk van het definiëren van architecturale en operationele controles en het afdwingen ervan op organisatorische schaal om risico's te beheersen. Deze vijf risico's zijn een onveilige verwerking van de output, kwetsbaarheden in de toeleveringsketen, openbaarmaking van gevoelige informatie, buitensporige keuzevrijheid en overmatig vertrouwen. Begin met het vergroten van de veerkracht van uw organisatie door uw teams te socialiseren om AI, ML en generatieve AI-beveiliging te beschouwen als een kernvereiste en topprioriteit gedurende de hele levenscyclus van het product, vanaf het begin van het idee, tot onderzoek, tot de ontwikkeling, implementatie en implementatie van de applicatie. gebruik. Naast bewustwording moeten uw teams actie ondernemen om rekening te houden met generatieve AI in governance-, assurance- en compliance-validatiepraktijken.

Bouw de veerkracht van de organisatie rond generatieve AI

Organisaties kunnen manieren gaan gebruiken om hun capaciteit en mogelijkheden voor AI/ML en generatieve AI-beveiliging binnen hun organisaties op te bouwen. U moet beginnen met het uitbreiden van uw bestaande beveiligings-, zekerheids-, compliance- en ontwikkelingsprogramma's om rekening te houden met generatieve AI.

Hieronder volgen de vijf belangrijkste interessegebieden voor organisatorische AI, ML en generatieve AI-beveiliging:

- Begrijp het AI/ML-beveiligingslandschap

- Neem verschillende perspectieven op in beveiligingsstrategieën

- Proactief actie ondernemen om onderzoeks- en ontwikkelingsactiviteiten veilig te stellen

- Breng prikkels in lijn met de resultaten van de organisatie

- Bereid u voor op realistische beveiligingsscenario's in AI/ML en generatieve AI

Ontwikkel een dreigingsmodel gedurende uw generatieve AI-levenscyclus

Organisaties die bouwen met generatieve AI moeten zich richten op risicobeheer en niet op het elimineren van risico's modellering van bedreigingen en in planning van bedrijfscontinuïteit de planning, ontwikkeling en werking van generatieve AI-workloads. Werk terug van het productiegebruik van generatieve AI door voor elke toepassing een dreigingsmodel te ontwikkelen, waarbij gebruik wordt gemaakt van zowel traditionele beveiligingsrisico's als generatieve AI-specifieke risico's. Sommige risico's kunnen aanvaardbaar zijn voor uw bedrijf, en een oefening in het modelleren van bedreigingen kan uw bedrijf helpen bepalen wat uw aanvaardbare risicobereidheid is. Uw bedrijf heeft bijvoorbeeld mogelijk geen uptime van 99.999% nodig voor een generatieve AI-applicatie, dus de extra hersteltijd die gepaard gaat met herstel met behulp van AWS-back-up Met Amazon S3-gletsjer kan een aanvaardbaar risico zijn. Omgekeerd kunnen de gegevens in uw model extreem gevoelig en sterk gereguleerd zijn, dus wijk daar vanaf AWS Sleutelbeheerservice (AWS KMS) door de klant beheerde sleutel (CMK) rotatie en gebruik van AWS-netwerkfirewall Het helpen afdwingen van Transport Layer Security (TLS) voor inkomend en uitgaand verkeer ter bescherming tegen data-exfiltratie kan een onaanvaardbaar risico zijn.

Evalueer de risico's (inherent versus residuaal) van het gebruik van de generatieve AI-toepassing in een productieomgeving om de juiste fundamentele controles en controles op applicatieniveau te identificeren. Plan in een vroeg stadium het terugdraaien en herstellen van productiebeveiligingsgebeurtenissen en serviceonderbrekingen, zoals snelle injectie, vergiftiging van trainingsgegevens, denial-of-service van modellen en modeldiefstal, en definieer de oplossingen die u gaat gebruiken bij het definiëren van applicatievereisten. Leren over de risico's en controles die moeten worden ingevoerd, zal helpen bij het definiëren van de beste implementatieaanpak voor het bouwen van een generatieve AI-toepassing, en belanghebbenden en besluitvormers voorzien van informatie om weloverwogen zakelijke beslissingen over risico's te nemen. Als u niet bekend bent met de algehele AI- en ML-workflow, begin dan met het beoordelen ervan 7 manieren om de beveiliging van uw machine learning-workloads te verbeteren om de bekendheid met de beveiligingscontroles te vergroten die nodig zijn voor traditionele AI/ML-systemen.

Net als bij het bouwen van elke ML-applicatie, omvat het bouwen van een generatieve AI-applicatie het doorlopen van een reeks onderzoeks- en ontwikkelingsfasen in de levenscyclus. Misschien wilt u de AWS Generatieve AI Beveiligingscopingmatrix om te helpen een mentaal model op te bouwen om de belangrijkste beveiligingsdisciplines te begrijpen waarmee u rekening moet houden, afhankelijk van de generatieve AI-oplossing die u selecteert.

Generatieve AI-toepassingen die gebruik maken van LLM's worden doorgaans ontwikkeld en geëxploiteerd volgens de volgende geordende stappen:

- Toepassingsvereisten – Identificeer bedrijfsdoelstellingen, vereisten en succescriteria voor use cases

- Model selectie – Selecteer een basismodel dat aansluit bij de vereisten van de use case

- Modelaanpassing en finetuning – Bereid gegevens voor, engineer prompts en verfijn het model

- Modelevaluatie – Evalueer basismodellen met gebruiksspecifieke statistieken en selecteer het best presterende model

- Implementatie en integratie – Implementeer het geselecteerde basismodel op uw geoptimaliseerde infrastructuur en integreer met uw generatieve AI-toepassing

- Applicatiebewaking – Bewaak de applicatie- en modelprestaties om analyse van de hoofdoorzaak mogelijk te maken

Zorg ervoor dat teams de cruciale aard van beveiliging begrijpen als onderdeel van de ontwerp- en architectuurfasen van de levenscyclus van uw softwareontwikkeling op dag 1. Dit betekent dat u de beveiliging op elke laag van uw stack en levenscyclus moet bespreken, en beveiliging en privacy moet positioneren als middelen om bedrijfsdoelstellingen te bereiken. Ontwerp controles op bedreigingen voordat u uw LLM-applicatie start, en overweeg of de gegevens en informatie die u gaat gebruiken voor modelaanpassing en verfijning de implementatie in de onderzoeks-, ontwikkelings- en trainingsomgevingen rechtvaardigen. Als onderdeel van kwaliteitsborgingstests kunt u synthetische beveiligingsbedreigingen introduceren (zoals pogingen om trainingsgegevens te vergiftigen of gevoelige gegevens te extraheren via kwaadwillige prompt-engineering) om uw verdediging en beveiligingspositie regelmatig te testen.

Bovendien moeten belanghebbenden een consistente beoordelingsfrequentie vaststellen voor productie-AI-, ML- en generatieve AI-workloads en organisatorische prioriteit stellen aan het begrijpen van de afwegingen tussen menselijke en machinebesturing en fouten vóór de lancering. Het valideren en garanderen dat deze afwegingen worden gerespecteerd in de geïmplementeerde LLM-applicaties zal de kans op succes bij het beperken van risico's vergroten.

Bouw generatieve AI-applicaties op veilige cloudbasissen

Bij AWS is beveiliging onze topprioriteit. AWS is ontworpen om de veiligste wereldwijde cloudinfrastructuur te zijn waarop applicaties en workloads kunnen worden gebouwd, gemigreerd en beheerd. Dit wordt ondersteund door onze uitgebreide set van meer dan 300 cloudbeveiligingstools en het vertrouwen van onze miljoenen klanten, waaronder de meest beveiligingsgevoelige organisaties zoals de overheid, de gezondheidszorg en de financiële dienstverlening. Wanneer u generatieve AI-applicaties bouwt met behulp van LLM's op AWS, profiteert u van beveiligingsvoordelen veilige, betrouwbare en flexibele AWS Cloud-computeromgeving.

Gebruik een wereldwijde AWS-infrastructuur voor beveiliging, privacy en compliance

Wanneer u data-intensieve applicaties op AWS ontwikkelt, kunt u profiteren van een wereldwijde AWS-infrastructuur, ontworpen om mogelijkheden te bieden om aan uw kernvereisten op het gebied van beveiliging en compliance te voldoen. Dit wordt versterkt door onze AWS digitale soevereiniteitsbelofte, onze toewijding om u de meest geavanceerde reeks soevereiniteitscontroles en -functies aan te bieden die beschikbaar zijn in de cloud. Wij streven ernaar onze mogelijkheden uit te breiden, zodat u aan uw wensen kunt voldoen digitale soevereiniteit behoeften, zonder concessies te doen aan de prestaties, innovatie, beveiliging of schaal van de AWS Cloud. Om de implementatie van best practices op het gebied van beveiliging en privacy te vereenvoudigen, kunt u overwegen referentieontwerpen en infrastructuur te gebruiken als codebronnen zoals de AWS-beveiligingsreferentiearchitectuur (AWS SRA) en AWS Privacy Referentie Architectuur (AWS PRA). Lees meer over het ontwerpen van privacyoplossingen, soevereiniteit door ontwerp en naleving van AWS en gebruik diensten zoals AWS-configuratie, AWS-artefact en AWS-auditmanager om uw behoeften op het gebied van privacy, compliance, audit en observatie te ondersteunen.

Krijg inzicht in uw beveiligingshouding met behulp van AWS Well-Architected en Cloud Adoption Frameworks

AWS biedt best practice-richtlijnen die zijn ontwikkeld op basis van jarenlange ervaring met het ondersteunen van klanten bij het ontwerpen van hun cloudomgevingen met de AWS goed ontworpen raamwerk en in het evolueren naar het realiseren van zakelijke waarde uit cloudtechnologieën met de AWS Cloud Adoptie Framework (AWS CAF). Krijg inzicht in de beveiligingspositie van uw AI-, ML- en generatieve AI-workloads door een Well-Architected Framework-review uit te voeren. Beoordelingen kunnen worden uitgevoerd met behulp van tools zoals de AWS goed ontworpen tool, of met de hulp van uw AWS-team via AWS Enterprise-ondersteuning. De goed ontworpen tool van AWS integreert automatisch inzichten oppompen van AWS-betrouwbare adviseur om te evalueren welke best practices er zijn en welke mogelijkheden er zijn om de functionaliteit en kostenoptimalisatie te verbeteren. De AWS Well-Architected Tool biedt ook op maat gemaakte lenzen met specifieke best practices zoals de Machine learning-lens zodat u uw architecturen regelmatig kunt vergelijken met best practices en verbeterpunten kunt identificeren. Bepaal uw reis op weg naar waarderealisatie en volwassenheid van de cloud door te begrijpen hoe AWS-klanten strategieën toepassen om organisatorische capaciteiten in de wereld te ontwikkelen AWS Cloud Adoption Framework voor kunstmatige intelligentie, machinaal leren en generatieve AI. U kunt er ook baat bij hebben om inzicht te krijgen in uw algehele cloudgereedheid door deel te nemen aan een Beoordeling van AWS Cloud-gereedheid. AWS biedt extra mogelijkheden voor betrokkenheid. Vraag uw AWS-accountteam om meer informatie over hoe u aan de slag kunt gaan met de Generatief AI-innovatiecentrum.

Versnel uw beveiliging en AI/ML-leren met begeleiding, training en certificering op het gebied van best practices

AWS beheert ook aanbevelingen van Best practices voor beveiliging, identiteit en naleving en AWS-beveiligingsdocumentatie om u te helpen manieren te vinden om uw trainings-, ontwikkelings-, test- en operationele omgevingen te beveiligen. Als u net begint, duik dan dieper in beveiligingstraining en certificering, overweeg om te beginnen AWS-beveiligingsbeginselen en AWS-beveiligingsleerplan. U kunt ook de AWS-beveiligingsvolwassenheidsmodel om u te helpen bij het vinden en prioriteren van de beste activiteiten in verschillende volwassenheidsfasen van AWS, te beginnen met snelle overwinningen, via fundamentele, efficiënte en geoptimaliseerde fasen. Nadat u en uw teams een basiskennis hebben van de beveiliging van AWS, raden we u ten zeerste aan dit te beoordelen Hoe bedreigingsmodellering te benaderen en vervolgens met uw teams een oefening in het modelleren van dreigingen leiden, te beginnen met de Dreigingsmodellering voor bouwersworkshop oefenprogramma. Er zijn er nog veel meer AWS Security-training en certificeringsbronnen beschikbaar.

Pas een diepgaande verdedigingsaanpak toe om LLM-applicaties te beveiligen

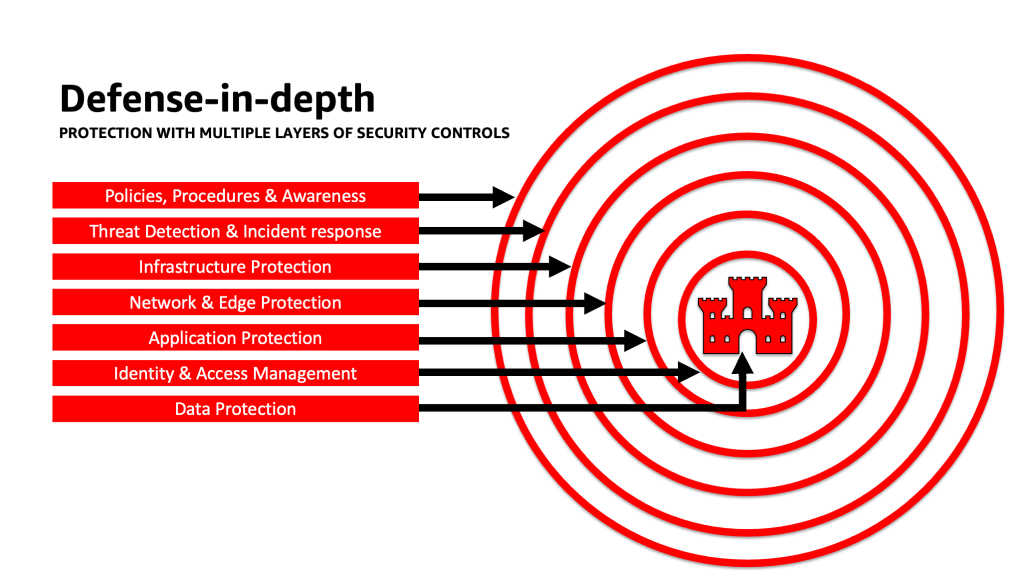

Het toepassen van een diepgaande beveiligingsaanpak op uw generatieve AI-workloads, gegevens en informatie kan u helpen de beste omstandigheden te creëren om uw bedrijfsdoelstellingen te bereiken. Diepgaande best practices op het gebied van beveiliging beperken veel van de veelvoorkomende risico's waarmee elke werklast wordt geconfronteerd, waardoor u en uw teams uw generatieve AI-innovatie kunnen versnellen. Een diepgaande beveiligingsstrategie maakt gebruik van meerdere redundante verdedigingen om uw AWS-accounts, workloads, gegevens en assets te beschermen. Het helpt ervoor te zorgen dat als een beveiligingscontrole wordt aangetast of faalt, er extra lagen bestaan om bedreigingen te helpen isoleren en beveiligingsgebeurtenissen te voorkomen, detecteren, erop te reageren en te herstellen. U kunt op elke laag een combinatie van strategieën gebruiken, waaronder AWS-services en -oplossingen, om de beveiliging en veerkracht van uw generatieve AI-workloads te verbeteren.

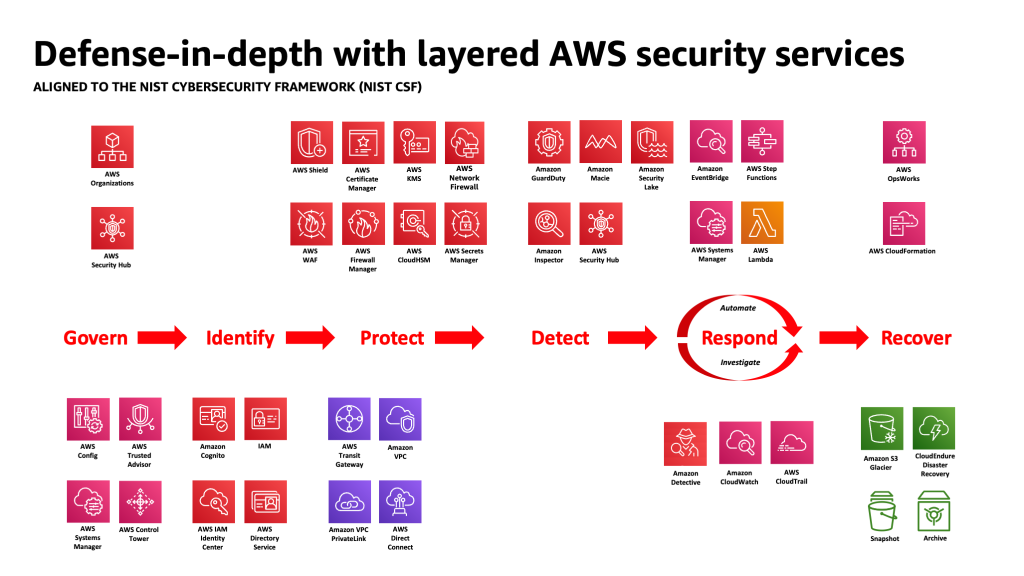

Veel AWS-klanten sluiten zich aan bij industriestandaardframeworks, zoals de NIST-kader voor cyberbeveiliging. Dit raamwerk helpt ervoor te zorgen dat uw beveiligingsverdediging bescherming biedt op de pijlers Identificeren, Beschermen, Detecteren, Reageren, Herstellen en, meest recentelijk toegevoegd, Beheren. Dit raamwerk kan vervolgens eenvoudig worden gekoppeld aan AWS Security-services en die van geïntegreerde derde partijen om u te helpen adequate dekking en beleid te valideren voor elke beveiligingsgebeurtenis waarmee uw organisatie wordt geconfronteerd.

Diepgaande verdediging: Beveilig uw omgeving en voeg vervolgens verbeterde AI/ML-specifieke beveiligings- en privacymogelijkheden toe

Een diepgaande verdedigingsstrategie moet beginnen met het eerst beschermen van uw accounts en organisatie, en vervolgens een laag bouwen op de extra ingebouwde beveiligings- en privacyverbeterde functies van services zoals Amazonebodem en Amazon Sage Maker. Amazon heeft meer dan 30 diensten in de portefeuille Beveiliging, Identiteit en Compliance die zijn geïntegreerd met AWS AI/ML-services en samen kunnen worden gebruikt om uw workloads, accounts en organisatie te beveiligen. Om zich goed te kunnen verdedigen tegen de OWASP Top 10 voor LLM, moeten deze samen met de AWS AI/ML-diensten worden gebruikt.

Begin met het implementeren van een beleid met de minste privileges, met behulp van services zoals IAM-toegangsanalysator naar zoek naar overdreven tolerante accounts, rollen en bronnen om de toegang te beperken met behulp van kortetermijnreferenties. Zorg er vervolgens voor dat alle gegevens in rust zijn gecodeerd met AWS KMS, inclusief het gebruik van CMK's, en dat van alle gegevens en modellen een versie wordt gemaakt en een back-up wordt gemaakt met behulp van Amazon eenvoudige opslagservice (Amazon S3) versiebeheer en onveranderbaarheid op objectniveau toepassen met Amazon S3 Objectvergrendeling. Bescherm alle gegevens tijdens de overdracht tussen services met behulp van AWS-certificaatbeheerder en / of AWS privé-CA, en bewaar het binnen VPC's die gebruiken AWS PrivéLink. Definieer strikte regels voor het binnenkomen en uitgaan van gegevens om te helpen beschermen tegen manipulatie en exfiltratie met behulp van VPC's AWS-netwerkfirewall beleid. Overweeg om in te voegen AWS-webapplicatie-firewall (AWS WAF) vooraan bij bescherm webapplicaties en API's oppompen van kwaadaardige bots, SQL-injectieaanvallen, cross-site scripting (XSS), en accountovernames met Fraudebestrijding. Inloggen met AWS CloudTrail, Amazon virtuele privécloud (Amazon VPC) stroomlogboeken, en Amazon Elastic Kubernetes-service (Amazon EKS) auditlogboeken helpen bij het bieden van forensische beoordeling van elke transactie die beschikbaar is voor services zoals Amazon detective. U kunt gebruik maken van Amazon-inspecteur om het ontdekken en beheren van kwetsbaarheden te automatiseren Amazon Elastic Compute-cloud (Amazon EC2) instanties, containers, AWS Lambda functies, en identificeer de netwerkbereikbaarheid van uw workloads. Bescherm uw gegevens en modellen tegen verdachte activiteiten met behulp van Amazone-wachtdienst's ML-aangedreven bedreigingsmodellen en inlichtingenfeeds, en het inschakelen van de extra functies voor EKS Protection, ECS Protection, S3 Protection, RDS Protection, Malware Protection, Lambda Protection en meer. U kunt gebruik maken van diensten zoals AWS-beveiligingshub om uw beveiligingscontroles te centraliseren en te automatiseren om afwijkingen van best practices op het gebied van beveiliging te detecteren en het onderzoek te versnellen en het herstel van beveiligingsbevindingen te automatiseren met draaiboeken. U kunt ook overwegen om een nul vertrouwen architectuur op AWS om de fijnmazige authenticatie- en autorisatiecontroles verder te vergroten voor waartoe menselijke gebruikers of machine-to-machine-processen per verzoek toegang hebben. Overweeg ook om te gebruiken Amazon Beveiligingsmeer om beveiligingsgegevens van AWS-omgevingen, SaaS-providers, on-premises en cloudbronnen automatisch te centraliseren in een speciaal gebouwd datameer dat in uw account is opgeslagen. Met Security Lake krijgt u een vollediger inzicht in uw beveiligingsgegevens in uw hele organisatie.

Nadat uw generatieve AI-werklastomgeving is beveiligd, kunt u AI/ML-specifieke functies toevoegen, zoals Amazon SageMaker-gegevens Wrangler om potentiële bias tijdens de datavoorbereiding te identificeren en Amazon SageMaker verduidelijken om bias in ML-gegevens en -modellen te detecteren. Je kan ook gebruiken Amazon SageMaker-modelmonitor om de kwaliteit van SageMaker ML-modellen in productie te evalueren en u op de hoogte te stellen wanneer er sprake is van afwijkingen in de gegevenskwaliteit, modelkwaliteit en kenmerkattributie. Deze AWS AI/ML-services die samenwerken (waaronder SageMaker die samenwerkt met Amazon Bedrock) met AWS Security-services kunnen u helpen potentiële bronnen van natuurlijke vooringenomenheid te identificeren en u te beschermen tegen kwaadwillige gegevensmanipulatie. Herhaal dit proces voor elk van de OWASP Top 10 voor LLM-kwetsbaarheden om ervoor te zorgen dat u de waarde van AWS-services maximaliseert en diepgaande verdediging implementeert om uw gegevens en werklasten te beschermen.

Zoals AWS Enterprise Strategist Clarke Rodgers in zijn blogpost schreef “CISO Insight: elke AWS-service is een beveiligingsservice”, “Ik zou willen stellen dat vrijwel elke dienst binnen de AWS-cloud op zichzelf een beveiligingsresultaat mogelijk maakt, of door klanten kan worden gebruikt (alleen of in combinatie met een of meer diensten) om een veiligheids-, risico- of compliancedoelstelling te bereiken.” En “Customer Chief Information Security Officers (CISO’s) (of hun respectievelijke teams) willen misschien de tijd nemen om ervoor te zorgen dat ze goed op de hoogte zijn van alle AWS-services, omdat er mogelijk een beveiligings-, risico- of compliancedoelstelling is waaraan kan worden voldaan. zelfs als een dienst niet in de categorie ‘Beveiliging, Identiteit en Compliance’ valt.”

Laagverdediging bij vertrouwensgrenzen in LLM-applicaties

Bij het ontwikkelen van generatieve op AI gebaseerde systemen en applicaties moet u rekening houden met dezelfde aandachtspunten als bij elke andere ML-applicatie, zoals vermeld in de MITRE ATLAS Bedreigingsmatrix voor machinaal leren, zoals het rekening houden met de oorsprong van software en datacomponenten (zoals het uitvoeren van een open source software-audit, het beoordelen van software bill of materials (SBOM's) en het analyseren van dataworkflows en API-integraties) en het implementeren van de nodige bescherming tegen LLM-bedreigingen in de toeleveringsketen. Neem inzichten uit branchekaders op en wees u bewust van manieren om meerdere bronnen van dreigingsinformatie en risico-informatie te gebruiken om uw beveiligingsverdediging aan te passen en uit te breiden om rekening te houden met AI-, ML- en generatieve AI-beveiligingsrisico's die zich voordoen en niet zijn opgenomen in traditionele raamwerken. Zoek aanvullende informatie over AI-specifieke risico's uit industriële, defensie-, overheids-, internationale en academische bronnen, omdat er regelmatig nieuwe bedreigingen opduiken en evolueren in deze ruimte en begeleidende raamwerken en handleidingen regelmatig worden bijgewerkt. Als u bijvoorbeeld een Retrieval Augmented Generation (RAG)-model gebruikt en het model niet de gegevens bevat die het nodig heeft, kan het deze opvragen bij een externe gegevensbron voor gebruik tijdens het infereren en afstemmen. De bron die wordt opgevraagd, ligt mogelijk buiten uw controle en kan een potentiële bron van compromissen in uw toeleveringsketen zijn. Een diepgaande verdedigingsaanpak moet worden uitgebreid naar externe bronnen om vertrouwen, authenticatie, autorisatie, toegang, beveiliging, privacy en nauwkeurigheid van de gegevens waartoe zij toegang heeft, tot stand te brengen. Om dieper te duiken, lees “Bouw een veilige bedrijfsapplicatie met generatieve AI en RAG met behulp van Amazon SageMaker JumpStart"

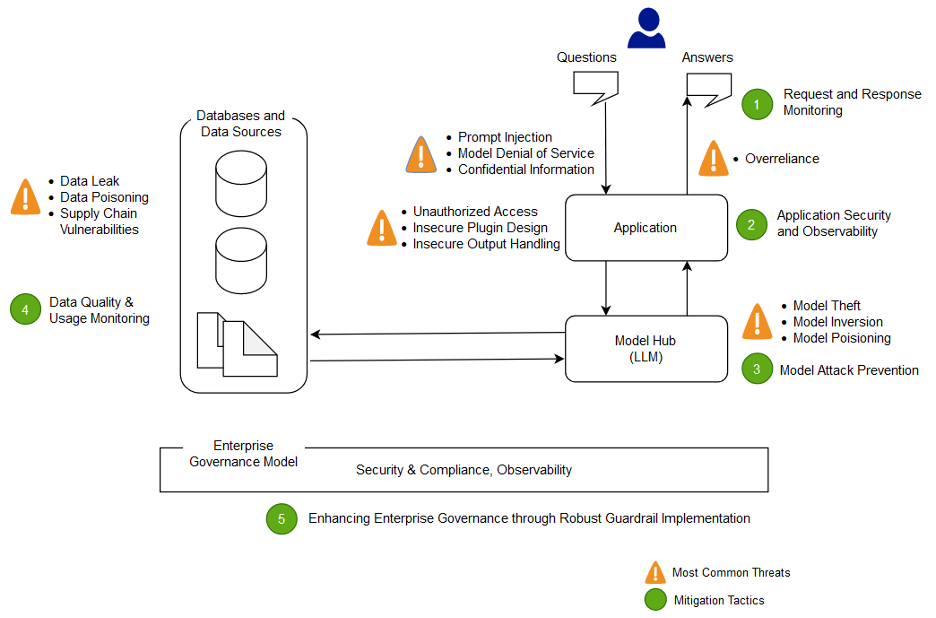

Analyseer en beperk de risico's in uw LLM-toepassingen

In deze sectie analyseren en bespreken we een aantal risicobeperkende technieken die gebaseerd zijn op vertrouwensgrenzen en interacties, of op afzonderlijke gebieden van de werklast met een vergelijkbare passende reikwijdte van de controles en een vergelijkbaar risicoprofiel. In deze voorbeeldarchitectuur van een chatbot-applicatie zijn er vijf vertrouwensgrenzen waar controles worden gedemonstreerd, gebaseerd op hoe AWS-klanten gewoonlijk hun LLM-applicaties bouwen. Uw LLM-toepassing kan meer of minder definieerbare vertrouwensgrenzen hebben. In de volgende voorbeeldarchitectuur worden deze vertrouwensgrenzen als volgt gedefinieerd:

- Interacties met gebruikersinterface (verzoek en antwoord)

- Applicatie-interacties

- Modelinteracties

- Gegevensinteracties

- Organisatorische interacties en gebruik

Interacties met gebruikersinterface: Ontwikkel het monitoren van verzoeken en antwoorden

Detecteer en reageer tijdig op cyberincidenten die verband houden met generatieve AI door een strategie te evalueren om de risico’s van de input en output van de generatieve AI-toepassing aan te pakken. Het kan bijvoorbeeld nodig zijn om aanvullende monitoring op gedrag en gegevensuitstroom uit te voeren om de openbaarmaking van gevoelige informatie buiten uw domein of organisatie te detecteren, in het geval dat deze wordt gebruikt in de LLM-applicatie.

Generatieve AI-toepassingen moeten nog steeds voldoen aan de standaard best practices op het gebied van beveiliging als het gaat om het beschermen van gegevens. Opzetten van een beveiligde dataperimeter en beveiligde gevoelige gegevensopslag. Versleutel gegevens en informatie die worden gebruikt voor LLM-applicaties in rust en onderweg. Bescherm gegevens die worden gebruikt om uw model te trainen tegen trainingsgegevensvergiftiging door inzicht te krijgen in en te controleren welke gebruikers, processen en rollen mogen bijdragen aan de gegevensopslag, en door te controleren hoe gegevens in de toepassing stromen, te controleren op bias-afwijkingen en door gebruik te maken van versiebeheer en onveranderlijke opslag in opslagdiensten zoals Amazon S3. Zorg voor strikte controles op het binnenkomen en uitgaan van gegevens met behulp van services zoals AWS Network Firewall en AWS VPC's om te beschermen tegen verdachte invoer en de mogelijkheid van gegevensexfiltratie.

Tijdens het training-, omscholings- of verfijningsproces moet u zich bewust zijn van eventuele gevoelige gegevens die worden gebruikt. Nadat gegevens tijdens een van deze processen zijn gebruikt, moet u een scenario plannen waarin elke gebruiker van uw model plotseling de gegevens of informatie er weer uit kan halen door gebruik te maken van snelle injectietechnieken. Begrijp de risico's en voordelen van het gebruik van gevoelige gegevens in uw modellen en gevolgtrekkingen. Implementeer robuuste authenticatie- en autorisatiemechanismen voor het instellen en beheren van fijnmazige toegangsrechten, die niet afhankelijk zijn van LLM-applicatielogica om openbaarmaking te voorkomen. Er is aangetoond dat door de gebruiker gecontroleerde invoer voor een generatieve AI-toepassing onder bepaalde omstandigheden een vector kan bieden om informatie uit het model of uit niet-door de gebruiker bestuurde delen van de invoer te extraheren. Dit kan gebeuren via snelle injectie, waarbij de gebruiker input levert die ervoor zorgt dat de output van het model afwijkt van de verwachte vangrails van de LLM-applicatie, inclusief het geven van aanwijzingen voor de datasets waarop het model oorspronkelijk is getraind.

Implementeer toegangsquota op gebruikersniveau voor gebruikers die invoer leveren en uitvoer ontvangen van een model. U moet benaderingen overwegen die geen anonieme toegang toestaan onder omstandigheden waarin de modeltrainingsgegevens en -informatie gevoelig zijn, of waar het risico bestaat dat een tegenstander een facsimile van uw model traint op basis van hun invoer en uw afgestemde modeluitvoer. Als een deel van de input voor een model bestaat uit willekeurige, door de gebruiker aangeleverde tekst, moet u er in het algemeen rekening mee houden dat de output vatbaar is voor directe injectie, en er dienovereenkomstig voor zorgen dat het gebruik van de output ook geïmplementeerde technische en organisatorische tegenmaatregelen omvat om onveilige verwerking van output en buitensporige keuzevrijheid tegen te gaan. en overmatig vertrouwen. In het eerder gegeven voorbeeld met betrekking tot het filteren op kwaadaardige invoer met behulp van AWS WAF kunt u overwegen een filter vóór uw toepassing te bouwen voor dergelijk potentieel misbruik van aanwijzingen, en een beleid te ontwikkelen voor de manier waarop u deze kunt afhandelen en ontwikkelen naarmate uw model en gegevens groeien. Overweeg ook een gefilterde beoordeling van de uitvoer voordat deze wordt teruggestuurd naar de gebruiker, om er zeker van te zijn dat deze voldoet aan de normen voor kwaliteit, nauwkeurigheid of inhoudsmoderatie. Mogelijk wilt u dit verder aanpassen aan de behoeften van uw organisatie met een extra controlelaag op invoer en uitvoer vóór uw modellen om verdachte verkeerspatronen te beperken.

Applicatie-interacties: applicatiebeveiliging en waarneembaarheid

Controleer uw LLM-toepassing en let erop hoe een gebruiker uw model kan gebruiken om de standaardautorisatie voor een downstream-tool of toolchain te omzeilen waarvoor hij of zij geen autorisatie heeft om toegang te krijgen of te gebruiken. Een andere zorg op deze laag betreft het verkrijgen van toegang tot externe gegevensopslag door het gebruik van een model als aanvalsmechanisme met gebruikmaking van onbeperkte technische of organisatorische LLM-risico's. Als uw model bijvoorbeeld is getraind om toegang te krijgen tot bepaalde gegevensarchieven die gevoelige gegevens kunnen bevatten, moet u ervoor zorgen dat er goede autorisatiecontroles plaatsvinden tussen uw model en de gegevensarchieven. Gebruik onveranderlijke kenmerken over gebruikers die niet uit het model komen bij het uitvoeren van autorisatiecontroles. Onbeperkte onveilige uitvoerafhandeling, onveilig plug-inontwerp en buitensporige keuzevrijheid kunnen omstandigheden creëren waarin een bedreigingsacteur een model kan gebruiken om het autorisatiesysteem te misleiden om effectieve privileges te escaleren, wat ertoe leidt dat een downstream-component gelooft dat de gebruiker geautoriseerd is om gegevens op te halen of een specifiek bestand te nemen. actie.

Bij het implementeren van een generatieve AI-plug-in of -tool is het absoluut noodzakelijk om het toegangsniveau dat wordt verleend te onderzoeken en te begrijpen, en om de geconfigureerde toegangscontroles nauwkeurig te onderzoeken. Het gebruik van volledig onveilige generatieve AI-plug-ins kan uw systeem vatbaar maken voor kwetsbaarheden en bedreigingen in de toeleveringsketen, wat mogelijk kan leiden tot kwaadwillige acties, waaronder het uitvoeren van externe code.

Modelinteracties: preventie van modelaanvallen

U moet op de hoogte zijn van de oorsprong van alle modellen, plug-ins, tools of gegevens die u gebruikt, om kwetsbaarheden in de toeleveringsketen te evalueren en te beperken. Sommige gangbare modelformaten maken bijvoorbeeld het inbedden van willekeurige uitvoerbare code in de modellen zelf mogelijk. Gebruik pakketspiegelservers, scans en aanvullende inspecties die relevant zijn voor de beveiligingsdoelstellingen van uw organisatie.

De datasets waarop u traint en waarop u uw modellen verfijnt, moeten ook worden beoordeeld. Als u een model automatisch verder verfijnt op basis van gebruikersfeedback (of andere door de eindgebruiker beheerbare informatie), moet u overwegen of een kwaadwillende bedreigingsacteur het model willekeurig zou kunnen veranderen op basis van het manipuleren van hun reacties en het vergiftigen van trainingsgegevens zou kunnen bewerkstelligen.

Gegevensinteracties: Bewaak de gegevenskwaliteit en het gebruik

Generatieve AI-modellen zoals LLM’s werken over het algemeen goed omdat ze zijn getraind op een grote hoeveelheid data. Hoewel deze gegevens LLM's helpen bij het voltooien van complexe taken, kunnen ze uw systeem ook blootstellen aan het risico van vergiftiging van trainingsgegevens, wat optreedt wanneer ongepaste gegevens worden opgenomen of weggelaten in een trainingsgegevensset die het gedrag van een model kunnen veranderen. Om dit risico te beperken, moet u naar uw toeleveringsketen kijken en het gegevensbeoordelingsproces voor uw systeem begrijpen voordat het in uw model wordt gebruikt. Hoewel de trainingspijplijn een belangrijke bron van gegevensvergiftiging is, moet u ook kijken hoe uw model gegevens krijgt, zoals in een RAG-model of een datameer, en of de bron van die gegevens vertrouwd en beschermd is. Gebruik AWS-beveiligingsservices zoals AWS Security Hub, Amazon GuardDuty en Amazon Inspector om voortdurend te controleren op verdachte activiteiten in Amazon EC2, Amazon EKS, Amazon S3, Amazon relationele databaseservice (Amazon RDS) en netwerktoegang die indicatoren kunnen zijn voor opkomende bedreigingen, en gebruik Detective om beveiligingsonderzoeken te visualiseren. Overweeg ook om diensten zoals Amazon Beveiligingsmeer om beveiligingsonderzoeken te versnellen door een speciaal gebouwd datameer te creëren om automatisch beveiligingsgegevens van AWS-omgevingen, SaaS-providers, on-premises en cloudbronnen te centraliseren die bijdragen aan uw AI/ML-workloads.

Organisatorische interacties: Implementeer vangrails voor ondernemingsbestuur voor generatieve AI

Identificeer de risico’s die verbonden zijn aan het gebruik van generatieve AI voor uw bedrijf. U moet de risicotaxonomie van uw organisatie opbouwen en risicobeoordelingen uitvoeren om weloverwogen beslissingen te nemen bij de inzet van generatieve AI-oplossingen. Ontwikkel een bedrijfscontinuïteitsplan (BCP) dat AI-, ML- en generatieve AI-workloads omvat en die snel kan worden geïmplementeerd om de verloren functionaliteit van een getroffen of offline LLM-applicatie te vervangen om aan uw SLA's te voldoen.

Identificeer lacunes in processen en middelen, inefficiënties en inconsistenties, en verbeter het bewustzijn en eigenaarschap binnen uw bedrijf. Bedreigingsmodel alle generatieve AI-workloads om potentiële veiligheidsbedreigingen te identificeren en te beperken die kunnen leiden tot bedrijfseffecten, waaronder ongeautoriseerde toegang tot gegevens, denial-of-service en misbruik van hulpbronnen. Profiteer van het nieuwe AWS Threat Composer-modelleringstool om de time-to-value te helpen verminderen bij het uitvoeren van bedreigingsmodellering. Overweeg later in uw ontwikkelingscyclus om introductie op te nemen beveiliging chaos engineering experimenten met foutinjectie om reële omstandigheden te creëren om te begrijpen hoe uw systeem zal reageren op onbekende factoren en om vertrouwen op te bouwen in de veerkracht en veiligheid van het systeem.

Neem verschillende perspectieven op bij het ontwikkelen van beveiligingsstrategieën en risicobeheermechanismen om de naleving en dekking van AI/ML en generatieve beveiliging in alle functies en functies te garanderen. Breng vanaf het begin en het onderzoek van elke generatieve AI-toepassing een beveiligingsmentaliteit mee om aan de vereisten te voldoen. Als u extra hulp van AWS nodig heeft, vraag dan uw AWS-accountmanager om ervoor te zorgen dat er gelijke ondersteuning is door AWS Solutions Architects van AWS Security en AI/ML te vragen om samen te helpen.

Zorg ervoor dat uw beveiligingsorganisatie routinematig actie onderneemt om de communicatie rond risicobewustzijn en inzicht in risicobeheer te bevorderen onder generatieve AI-stakeholders, zoals productmanagers, softwareontwikkelaars, datawetenschappers en leidinggevenden, waardoor informatie over bedreigingen en controles de teams kunnen bereiken die mogelijk beïnvloed worden. Beveiligingsorganisaties kunnen een cultuur van verantwoorde openbaarmaking en iteratieve verbetering ondersteunen door deel te nemen aan discussies en nieuwe ideeën en informatie naar generatieve AI-stakeholders te brengen die verband houden met hun bedrijfsdoelstellingen. Leer meer over onze toewijding aan verantwoorde AI en extra verantwoorde AI-middelen om onze klanten te helpen.

Profiteer van het mogelijk maken van een betere organisatorische houding voor generatieve AI door de time-to-value in de bestaande beveiligingsprocessen van uw organisatie te deblokkeren. Evalueer proactief waar uw organisatie mogelijk processen nodig heeft die te belastend zijn gezien de generatieve AI-beveiligingscontext en verfijn deze om ontwikkelaars en wetenschappers een duidelijk pad te bieden om te starten met de juiste controles.

Beoordeel waar er mogelijkheden zijn om prikkels op één lijn te brengen, risico's te verminderen en een duidelijk zicht te bieden op de gewenste resultaten. Update de richtlijnen en verdedigingen om te voldoen aan de veranderende behoeften van AI/ML en de ontwikkeling van generatieve AI-applicaties om verwarring en onzekerheid te verminderen die ontwikkelingstijd kunnen kosten, het risico kunnen vergroten en de impact kunnen vergroten.

Zorg ervoor dat belanghebbenden die geen beveiligingsexperts zijn, zowel kunnen begrijpen hoe het bestuur, het beleid en de risicobeheerstappen van de organisatie van toepassing zijn op hun werklast, als risicobeheermechanismen kunnen toepassen. Bereid uw organisatie voor op het reageren op realistische gebeurtenissen en scenario's die zich kunnen voordoen met generatieve AI-toepassingen, en zorg ervoor dat de rollen van generatieve AI-bouwers en responsteams op de hoogte zijn van escalatiepaden en -acties in geval van bezorgdheid over verdachte activiteiten.

Conclusie

Om innovatie succesvol te commercialiseren met welke nieuwe en opkomende technologie dan ook, moet je beginnen met een mentaliteit waarin veiligheid voorop staat, voortbouwen op een veilige infrastructuurfundament en nadenken over hoe je de beveiliging op elk niveau van de technologiestapel vroegtijdig verder kunt integreren met een diepgaande verdediging. benadering. Dit omvat interacties op meerdere lagen van uw technologiestapel en integratiepunten binnen uw digitale toeleveringsketen, om de veerkracht van de organisatie te garanderen. Hoewel generatieve AI een aantal nieuwe beveiligings- en privacy-uitdagingen met zich meebrengt, kunt u uw organisatie helpen beschermen tegen veel voorkomende problemen en evoluerende bedreigingen als u fundamentele best practices op het gebied van beveiliging volgt, zoals het gebruik van diepgaande verdediging met gelaagde beveiligingsservices. U moet gelaagde AWS-beveiligingsservices implementeren in uw generatieve AI-workloads en grotere organisatie, en u concentreren op integratiepunten in uw digitale toeleveringsketens om uw cloudomgevingen te beveiligen. Vervolgens kunt u de verbeterde beveiligings- en privacymogelijkheden in AWS AI/ML-services zoals Amazon SageMaker en Amazon Bedrock gebruiken om verdere lagen van verbeterde beveiligings- en privacycontroles toe te voegen aan uw generatieve AI-applicaties. Door beveiliging vanaf het begin in te bedden, wordt het sneller, eenvoudiger en kosteneffectiever om te innoveren met generatieve AI, terwijl de naleving wordt vereenvoudigd. Dit zal u helpen de controle, het vertrouwen en de waarneembaarheid van uw generatieve AI-toepassingen voor uw werknemers, klanten, partners, toezichthouders en andere betrokken belanghebbenden te vergroten.

Aanvullende referenties

- Industriestandaardframeworks voor AI/ML-specifiek risicobeheer en beveiliging:

Over de auteurs

Christoffel Rae is een Principal Worldwide Security GTM Specialist die zich richt op het ontwikkelen en uitvoeren van strategische initiatieven die de adoptie van AWS-beveiligingsdiensten versnellen en opschalen. Hij heeft een passie voor het snijvlak van cyberbeveiliging en opkomende technologieën, met meer dan twintig jaar ervaring in mondiale strategische leiderschapsrollen bij het leveren van beveiligingsoplossingen aan media-, entertainment- en telecomklanten. Hij laadt zich op door te lezen, reizen, eten en wijn, nieuwe muziek te ontdekken en beginnende startups te adviseren.

Christoffel Rae is een Principal Worldwide Security GTM Specialist die zich richt op het ontwikkelen en uitvoeren van strategische initiatieven die de adoptie van AWS-beveiligingsdiensten versnellen en opschalen. Hij heeft een passie voor het snijvlak van cyberbeveiliging en opkomende technologieën, met meer dan twintig jaar ervaring in mondiale strategische leiderschapsrollen bij het leveren van beveiligingsoplossingen aan media-, entertainment- en telecomklanten. Hij laadt zich op door te lezen, reizen, eten en wijn, nieuwe muziek te ontdekken en beginnende startups te adviseren.

Elia Winter is een Senior Security Engineer bij Amazon Security, heeft een BS in Cyber Security Engineering en is doordrenkt van liefde voor Harry Potter. Elijah blinkt uit in het identificeren en aanpakken van kwetsbaarheden in AI-systemen, waarbij technische expertise wordt gecombineerd met een vleugje tovenarij. Elijah ontwerpt op maat gemaakte beveiligingsprotocollen voor AI-ecosystemen, waardoor digitale verdediging een magische flair krijgt. Elijah is gedreven door integriteit en heeft een beveiligingsachtergrond in organisaties in zowel de publieke als de commerciële sector, gericht op het beschermen van vertrouwen.

Elia Winter is een Senior Security Engineer bij Amazon Security, heeft een BS in Cyber Security Engineering en is doordrenkt van liefde voor Harry Potter. Elijah blinkt uit in het identificeren en aanpakken van kwetsbaarheden in AI-systemen, waarbij technische expertise wordt gecombineerd met een vleugje tovenarij. Elijah ontwerpt op maat gemaakte beveiligingsprotocollen voor AI-ecosystemen, waardoor digitale verdediging een magische flair krijgt. Elijah is gedreven door integriteit en heeft een beveiligingsachtergrond in organisaties in zowel de publieke als de commerciële sector, gericht op het beschermen van vertrouwen.

Ram Vital is een Principal ML Solutions Architect bij AWS. Hij heeft meer dan dertig jaar ervaring met het ontwerpen en bouwen van gedistribueerde, hybride en cloudapplicaties. Hij heeft een passie voor het bouwen van veilige en schaalbare AI/ML- en big data-oplossingen om zakelijke klanten te helpen met hun cloudadoptie en optimalisatietraject om hun bedrijfsresultaten te verbeteren. In zijn vrije tijd rijdt hij op zijn motor en wandelt hij met zijn 3-jarige Sheepadoodle!

Ram Vital is een Principal ML Solutions Architect bij AWS. Hij heeft meer dan dertig jaar ervaring met het ontwerpen en bouwen van gedistribueerde, hybride en cloudapplicaties. Hij heeft een passie voor het bouwen van veilige en schaalbare AI/ML- en big data-oplossingen om zakelijke klanten te helpen met hun cloudadoptie en optimalisatietraject om hun bedrijfsresultaten te verbeteren. In zijn vrije tijd rijdt hij op zijn motor en wandelt hij met zijn 3-jarige Sheepadoodle!

Navneet tuteja is dataspecialist bij Amazon Web Services. Voordat hij bij AWS kwam, werkte Navneet als facilitator voor organisaties die hun data-architecturen wilden moderniseren en uitgebreide AI/ML-oplossingen wilden implementeren. Ze heeft een ingenieursdiploma van de Thapar University en een master in statistiek van de Texas A&M University.

Navneet tuteja is dataspecialist bij Amazon Web Services. Voordat hij bij AWS kwam, werkte Navneet als facilitator voor organisaties die hun data-architecturen wilden moderniseren en uitgebreide AI/ML-oplossingen wilden implementeren. Ze heeft een ingenieursdiploma van de Thapar University en een master in statistiek van de Texas A&M University.

Emily Soward is een datawetenschapper bij AWS Professional Services. Ze heeft een Master of Science met onderscheiding in kunstmatige intelligentie van de Universiteit van Edinburgh in Schotland, Verenigd Koninkrijk, met de nadruk op natuurlijke taalverwerking (NLP). Emily heeft toegepaste wetenschappelijke en technische functies vervuld die gericht waren op productonderzoek en -ontwikkeling op basis van AI, operationele uitmuntendheid en governance voor AI-workloads die worden uitgevoerd bij organisaties in de publieke en private sector. Ze draagt bij aan klantbegeleiding als AWS Senior Speaker en recentelijk als auteur voor AWS Well-Architected in de Machine Learning Lens.

Emily Soward is een datawetenschapper bij AWS Professional Services. Ze heeft een Master of Science met onderscheiding in kunstmatige intelligentie van de Universiteit van Edinburgh in Schotland, Verenigd Koninkrijk, met de nadruk op natuurlijke taalverwerking (NLP). Emily heeft toegepaste wetenschappelijke en technische functies vervuld die gericht waren op productonderzoek en -ontwikkeling op basis van AI, operationele uitmuntendheid en governance voor AI-workloads die worden uitgevoerd bij organisaties in de publieke en private sector. Ze draagt bij aan klantbegeleiding als AWS Senior Speaker en recentelijk als auteur voor AWS Well-Architected in de Machine Learning Lens.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/