Google is een voorloper op het gebied van AI-onderzoek en heeft een aanzienlijke bijdrage geleverd aan de open-sourcegemeenschap met transformatieve technologieën zoals TensorFlow, BERT, T5, JAX, AlphaFold en AlphaCode. Voortbordurend op deze erfenis heeft Google Gemma geïntroduceerd, een LLM die is gebouwd voor verantwoorde AI-ontwikkeling, waarbij gebruik wordt gemaakt van hetzelfde onderzoek en dezelfde technologie die de Gini-modellen aandreven.

Inhoudsopgave

Wat is Gemma LLM?

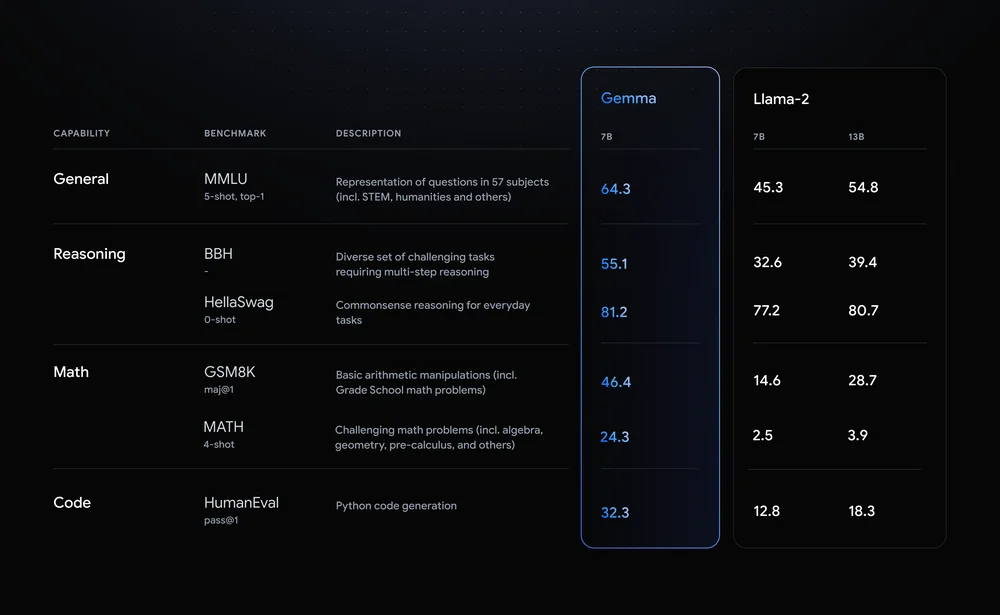

Gemma valt op door zijn indrukwekkende prestatiestatistieken. Het komt in twee varianten: één met 7 miljard parameters en een andere met 2 miljard. Vergeleken met Meta's LLM, Llama 2, vertoont Gemma superieure nauwkeurigheid in verschillende benchmarks. Gemma's 7 miljard parametermodel heeft bijvoorbeeld een algemene nauwkeurigheid van 64.3% en presteert daarmee beter dan Lama 2 op het gebied van redeneren, wiskunde en andere categorieën.

Laten we eens kijken naar enkele kenmerken van Gemma LLM:

- Lichtgewicht architectuur: Gemma is verkrijgbaar in twee maten, 2B- en 7B-parameters, aanzienlijk kleiner dan zijn grotere neven. Dit vertaalt zich naar hogere inferentiesnelheden en lagere rekenvereisten, waardoor het ideaal is voor personal computers en zelfs mobiele apparaten.

- Open-source beschikbaarheid: In tegenstelling tot veel hoogwaardige LLM's zijn de code en parameters van Gemma vrij beschikbaar, waardoor ze meer mogelijkheden krijgen ontwikkelaars en onderzoekers om te experimenteren, aan te passen en bij te dragen aan de evolutie ervan.

- Op instructie afgestemde varianten: Naast vooraf getrainde modellen biedt Gemma ‘op instructies afgestemde’ versies die zijn geoptimaliseerd voor specifieke taken zoals het beantwoorden van vragen en het samenvatten ervan. Dit verbetert de prestaties en het aanpassingsvermogen voor toepassingen in de echte wereld.

Gemma's impact gaat verder dan alleen de technische specificaties. Het democratiseert de toegang tot geavanceerde LLM’s en bevordert innovatie en samenwerking binnen de AI-gemeenschap. De potentiële toepassingen ervan bestrijken uiteenlopende gebieden, van persoonlijke productiviteitstools en chatbots voor het genereren van code en wetenschappelijk onderzoek. Door de toetredingsdrempels te verlagen houdt Gemma de belofte waar om de vooruitgang op het gebied van natuurlijke taalverwerking te versnellen en de toekomst van AI vorm te geven.

Diep duiken in Gemma-varianten

Gemma, de open-source LLM-familie van Google, biedt een veelzijdige reeks modellen die aan uiteenlopende behoeften voldoen. Laten we ons verdiepen in de verschillende formaten en versies en hun sterke punten, gebruiksscenario's en technische details voor ontwikkelaars verkennen:

Grootte is belangrijk: kies uw Gemma

- 2B: Deze lichtgewicht kampioen blinkt uit in omgevingen met beperkte bronnen, zoals CPU's en mobiele apparaten. Dankzij de geheugenruimte van ongeveer 1.5 GB en de hoge inferentiesnelheid is hij ideaal voor taken als tekstclassificatie en het eenvoudig beantwoorden van vragen.

- 7B: Door een balans te vinden tussen kracht en efficiëntie, schittert de 7B-variant op GPU's en TPU's van consumentenkwaliteit. Dankzij de geheugenvereiste van 5 GB zijn complexere taken mogelijk, zoals samenvattingen en het genereren van code.

De motor afstemmen: basis versus instructie-afgestemd

- Baseren: Deze modellen, vers uit het trainingsproces, bieden een algemene basis voor verschillende toepassingen. Ze vereisen afstemming voor specifieke taken, maar bieden flexibiliteit voor maatwerk.

- Op instructie afgestemd: Deze varianten zijn vooraf getraind in specifieke instructies zoals ‘samenvatten’ of ‘vertalen’ en bieden kant-en-klare bruikbaarheid voor gerichte taken. Ze offeren enige generaliseerbaarheid op voor betere prestaties in hun aangewezen domein.

Technische weetjes voor ontwikkelaars

- Geheugenvoetafdruk: 2B-modellen hebben ongeveer 1.5 GB nodig, terwijl 7B-modellen ongeveer 5 GB geheugen nodig hebben. Door finetuning kan deze voetafdruk enigszins worden vergroot.

- Inferentiesnelheid: 2B-modellen blinken uit in snelheid, waardoor ze geschikt zijn voor realtime toepassingen. 7B-modellen bieden snellere gevolgtrekkingen in vergelijking met grotere LLM's, maar komen mogelijk niet overeen met de snelheid van hun kleinere broers en zussen.

- Framework-compatibiliteit: Beide formaten zijn compatibel met belangrijke frameworks zoals TensorFlow, PyTorch en JAX, waardoor ontwikkelaars hun voorkeursomgeving kunnen benutten.

De juiste Gemma afstemmen op uw behoeften

De keuze tussen maat en afstemming hangt af van uw specifieke wensen. Voor scenario's met beperkte middelen en eenvoudige taken is het 2B-basismodel een goed startpunt. Als u prioriteit geeft aan prestaties en complexiteit in specifieke domeinen, kan de op instructies afgestemde 7B-variant uw kampioen zijn. Houd er rekening mee dat het verfijnen van beide formaten verdere aanpassingen voor uw unieke gebruiksscenario mogelijk maakt.

Vergeet niet: Dit is slechts een voorproefje van de Gemma-varianten. Met zijn diverse opties en open-source karakter stelt Gemma ontwikkelaars in staat om het potentieel voor verschillende toepassingen te verkennen en te ontketenen.

Aan de slag met Gemma

Gemma, Google's indrukwekkende familie van open-source grote taalmodellen (LLM's), opent deuren voor ontwikkelaars en onderzoekers om het potentieel van AI binnen handbereik te verkennen. Laten we eens kijken hoe u dat kunt installeer en voer Gemma uit, toegang tot vooraf getrainde modellen en bouw uw eigen applicaties gebruikmakend van zijn diverse mogelijkheden.

Platform-agnostisch: Gemma op CPU, GPU of TPU

Gemma beschikt over platformflexibiliteit, waardoor u het op verschillende hardwareconfiguraties kunt uitvoeren. Voor CPU-gebaseerde instellingenbieden de Hugging Face Transformers-bibliotheek en de Tensorflow Lite-tolk van Google efficiënte opties. Als u toegang heeft tot GPU's of TPU'sMaak gebruik van de volledige kracht van TensorFlow voor versnelde prestaties. Voor cloudgebaseerde implementaties kunt u Google Cloud Vertex AI overwegen voor naadloze integratie en schaalbaarheid.

Toegang tot kant-en-klare modellen

De vooraf getrainde modellen van Gemma zijn verkrijgbaar in verschillende maten en mogelijkheden en voorzien in uiteenlopende behoeften. Voor het genereren van tekst, vertalen en het beantwoorden van vragen bieden de Gemma 2B- en 7B-varianten indrukwekkende prestaties. Bovendien zijn op instructies afgestemde modellen zoals Gemma 2B-FT en 7B-FT specifiek ontworpen voor het verfijnen van uw eigen datasets, waardoor verdere personalisatie mogelijk wordt gemaakt.

Ontdek Gemma's capaciteiten

Laten we een aantal opwindende toepassingen verkennen die u met Gemma kunt bouwen:

- Boeiende verhalen: Genereer realistische en boeiende verhalen met behulp van de mogelijkheden voor tekstgeneratie.

- Taalvertaling gemakkelijk gemaakt: Vertaal tekst naadloos tussen talen met Gemma's meertalige vaardigheden.

- Kennis onthullen: Implementeer vraag-antwoordmodellen om informatieve en inzichtelijke antwoorden te bieden.

- Creatieve inhoud genereren: Experimenteer met poëzie, scripts of het genereren van code en verleg de grenzen van creatieve AI.

Fine-tuning en maatwerk

De ware kracht van Gemma ligt in haar verfijningsmogelijkheden. Maak gebruik van uw eigen datasets om het model af te stemmen op uw specifieke behoeften en ongeëvenaarde prestaties te bereiken. De meegeleverde referentieartikelen bieden gedetailleerde instructies over verfijning en aanpassing, zodat u het volledige potentieel van Gemma kunt ontsluiten.

Aan de slag gaan met Gemma is een spannende reis. Met zijn toegankelijke karakter, diverse mogelijkheden en levendige community-ondersteuning opent Gemma een wereld van mogelijkheden voor zowel ontwikkelaars als onderzoekers. Duik dus in de wereld van open-source LLM's en ontketen de kracht van Gemma in je volgende AI-project!

De toekomst van Gemma

Gemma's open-source karakter en indrukwekkende prestaties hebben geleid tot veel ophef binnen de LLM-gemeenschap.

Maar wat staat deze groeiende modellenfamilie te wachten?

- Vooruitgang in het LLM-landschap: Gemma's open-source karakter bevordert samenwerking en innovatie. Onderzoekers en ontwikkelaars over de hele wereld kunnen bijdragen aan de ontwikkeling ervan, waardoor de vooruitgang op gebieden als interpreteerbaarheid, eerlijkheid en efficiëntie wordt versneld. We zouden kunnen zien dat Gemma het voortouw neemt bij de verkenning van multimodale LLM's, die niet alleen tekst, maar ook afbeeldingen, audio en video kunnen verwerken en genereren.

- Optimistische vooruitzichten: Met zijn democratiserende aanpak en indrukwekkende capaciteiten vertegenwoordigt Gemma een belangrijke stap in de richting van het toegankelijk en nuttig maken van AI voor iedereen. Naarmate de ontwikkeling vordert, kunnen we nog meer baanbrekende toepassingen en verbeteringen verwachten. Gemma's open-source karakter bevordert een levendige gemeenschap en verzekert de voortdurende evolutie en impact ervan op de toekomst van LLM's.

Conclusie

Gemma's aankomst in het LLM-landschap markeert een belangrijk keerpunt. In tegenstelling tot zijn grotere, meer resource-intensieve neven, biedt Gemma toegankelijkheid en flexibiliteit, waardoor geavanceerde AI-mogelijkheden beschikbaar worden voor een breder publiek. Het open-source karakter ervan stimuleert innovatie en samenwerking, versnelt de vooruitgang op het gebied van natuurlijke taalverwerking en geeft vorm aan de toekomst van AI.

Key Takeaways

- Lichtgewicht en open source: De kleinere omvang en open beschikbaarheid van Gemma maken het toegankelijk op diverse platforms, waardoor individuen en kleinere organisaties de mogelijkheden van AI kunnen verkennen.

- Diverse varianten en mogelijkheden: Met meerdere formaten en op instructies afgestemde opties komt Gemma tegemoet aan verschillende behoeften, van het beantwoorden van eenvoudige vragen tot het genereren van complexe inhoud.

- Potentieel ontsluiten door maatwerk: Dankzij de verfijningsmogelijkheden kunnen gebruikers Gemma afstemmen op hun specifieke behoeften, waardoor nieuwe mogelijkheden op diverse gebieden worden ontsloten.

- Een levendige gemeenschap en een mooie toekomst: Gemma's open-source karakter bevordert een samenwerkende gemeenschap, waardoor vooruitgang wordt geboekt op het gebied van interpreteerbaarheid, eerlijkheid en multimodale mogelijkheden.

Belangrijke links

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/