Dit bericht is geschreven in samenwerking met Ilan Geller en Shuyu Yang van Accenture.

Bedrijven worden tegenwoordig geconfronteerd met grote uitdagingen als het gaat om het gebruik van hun informatie- en kennisbanken voor zowel interne als externe bedrijfsactiviteiten. Met voortdurend evoluerende activiteiten, processen, beleid en nalevingsvereisten kan het voor werknemers en klanten uiterst moeilijk zijn om op de hoogte te blijven. Tegelijkertijd maakt de ongestructureerde aard van veel van deze inhoud het tijdrovend om antwoorden te vinden met behulp van traditionele zoekopdrachten.

Intern kunnen werknemers vaak talloze uren besteden aan het zoeken naar informatie die ze nodig hebben om hun werk te doen, wat leidt tot frustratie en verminderde productiviteit. En als ze geen antwoorden kunnen vinden, moeten ze problemen escaleren of beslissingen nemen zonder volledige context, wat tot risico's kan leiden.

Extern kunnen klanten het ook frustrerend vinden om de informatie te vinden die ze zoeken. Hoewel zakelijke kennisbanken in de loop van de tijd de klantervaring hebben verbeterd, kunnen ze nog steeds omslachtig en moeilijk te gebruiken zijn. Of u nu op zoek bent naar antwoorden op een productgerelateerde vraag of informatie nodig heeft over openingstijden en locaties, een slechte ervaring kan leiden tot frustratie of, erger nog, tot het afhaken van klanten.

Hoe dan ook, naarmate kennisbeheer complexer wordt, biedt generatieve AI bedrijven een baanbrekende kans om mensen te verbinden met de informatie die ze nodig hebben om te presteren en te innoveren. Met de juiste strategie kunnen deze intelligente oplossingen de manier transformeren waarop kennis binnen een organisatie wordt vastgelegd, georganiseerd en gebruikt.

Om deze uitdaging aan te pakken, heeft Accenture samengewerkt met AWS om een innovatieve generatieve AI-oplossing te bouwen, genaamd Knowledge Assist. Door gebruik te maken van generatieve AI-services van AWS heeft het team een systeem ontwikkeld dat enorme hoeveelheden ongestructureerde bedrijfsinhoud kan verwerken en begrijpen.

In plaats van traditioneel zoeken op trefwoorden kunnen gebruikers nu vragen stellen en nauwkeurige antwoorden verkrijgen in een eenvoudige, conversatie-interface. Generatieve AI begrijpt de context en relaties binnen de kennisbank om gepersonaliseerde en nauwkeurige reacties te leveren. Naarmate het meer vragen beantwoordt, verbetert het systeem voortdurend de taalverwerking via machine learning (ML)-algoritmen.

Sinds de lancering van dit AI-ondersteuningsraamwerk hebben bedrijven dramatische verbeteringen gezien in het behoud van kennis en de productiviteit van werknemers. Door snelle en nauwkeurige toegang tot informatie te bieden en medewerkers in staat te stellen zichzelf te bedienen, vermindert deze oplossing de trainingstijd voor nieuwe medewerkers met meer dan 50% en worden escalaties tot wel 40% verminderd.

Met de kracht van generatieve AI kunnen ondernemingen transformeren hoe kennis wordt vastgelegd, georganiseerd en gedeeld binnen de organisatie. Door hun bestaande kennisbanken te ontsluiten, kunnen bedrijven de productiviteit van werknemers en de klanttevredenheid vergroten. Zoals de samenwerking van Accenture met AWS aantoont, ligt de toekomst van bedrijfskennisbeheer in AI-gestuurde systemen die evolueren door interacties tussen mens en machine.

Accenture werkt samen met AWS om klanten te helpen bij de implementatie Amazonebodem, maak gebruik van de meest geavanceerde fundamentele modellen zoals Amazone Titanen implementeer toonaangevende technologieën zoals Amazon SageMaker JumpStart en Amazone-inferentia naast andere AWS ML-services.

Dit bericht biedt een overzicht van een end-to-end generatieve AI-oplossing ontwikkeld door Accenture voor een productiegebruiksscenario met behulp van Amazon Bedrock en andere AWS-services.

Overzicht oplossingen

Een grote klant uit de publieke gezondheidszorg bedient elke dag miljoenen burgers en zij eisen gemakkelijke toegang tot actuele informatie in een steeds veranderend gezondheidslandschap. Accenture heeft deze generatieve AI-functionaliteit geïntegreerd in een bestaande FAQ-bot, waardoor de chatbot antwoorden kan geven op een breder scala aan gebruikersvragen. Door de mogelijkheid voor burgers om op een zelfbedieningsmanier toegang te krijgen tot relevante informatie te vergroten, bespaart de afdeling tijd en geld, waardoor de behoefte aan interactie met callcenteragenten afneemt. De belangrijkste kenmerken van de oplossing zijn onder meer:

- Hybride intentiebenadering – Maakt gebruik van generatieve en vooraf getrainde intenties

- Meertalige ondersteuning – Conversaties in het Engels en Spaans

- Conversatieanalyse – Rapporten over gebruikersbehoeften, sentiment en zorgen

- Natuurlijke gesprekken – Behoudt de context met mensachtige natuurlijke taalverwerking (NLP)

- Transparante citaten – Leidt gebruikers naar de broninformatie

De generatieve AI-oplossing van Accenture biedt de volgende voordelen ten opzichte van bestaande of traditionele chatbotframeworks:

- Genereert snel nauwkeurige, relevante en natuurlijk klinkende antwoorden op vragen van gebruikers

- Onthoudt de context en beantwoordt vervolgvragen

- Behandelt vragen en genereert antwoorden in meerdere talen (zoals Engels en Spaans)

- Leert voortdurend en verbetert reacties op basis van gebruikersfeedback

- Is eenvoudig te integreren met uw bestaande webplatform

- Neemt een uitgebreide opslagplaats van bedrijfskennis op

- Reageert op een menselijke manier

- De evolutie van de kennis is continu beschikbaar met minimale tot geen inspanning

- Maakt gebruik van een pay-as-you-use-model zonder kosten vooraf

De workflow op hoog niveau van deze oplossing omvat de volgende stappen:

- Gebruikers creëren een eenvoudige integratie met bestaande webplatforms

- Gegevens worden op dag 0 als bulkupload in het platform opgenomen en vervolgens op dag 1 en incrementele uploads.

- Gebruikersvragen worden in realtime verwerkt, waarbij het systeem naar behoefte wordt geschaald om aan de gebruikersvraag te voldoen.

- Gesprekken worden opgeslagen in applicatiedatabases (Amazon DynamoDB) ter ondersteuning van gesprekken die meerdere rondes duren.

- Het Anthropic Claude-basismodel wordt aangeroepen via Amazon Bedrock, dat wordt gebruikt om vraagantwoorden te genereren op basis van de meest relevante inhoud.

- Het Anthropic Claude-basismodel wordt gebruikt om zowel vragen als antwoorden van het Engels naar andere gewenste talen te vertalen om meertalige gesprekken te ondersteunen.

- Het Amazon Titan Foundation-model wordt via Amazon Bedrock aangeroepen om vectorinbedding te genereren.

- De relevantie van de inhoud wordt bepaald door de gelijkenis van de insluiting van onbewerkte inhoud en de insluiting van gebruikersquery's met behulp van de insluitingen van Pinecone-vectordatabases.

- De context wordt samen met de vraag van de gebruiker toegevoegd om een prompt te creëren, die wordt geleverd als invoer voor het Anthropic Claude-model. Het gegenereerde antwoord wordt via het webplatform teruggestuurd naar de gebruiker.

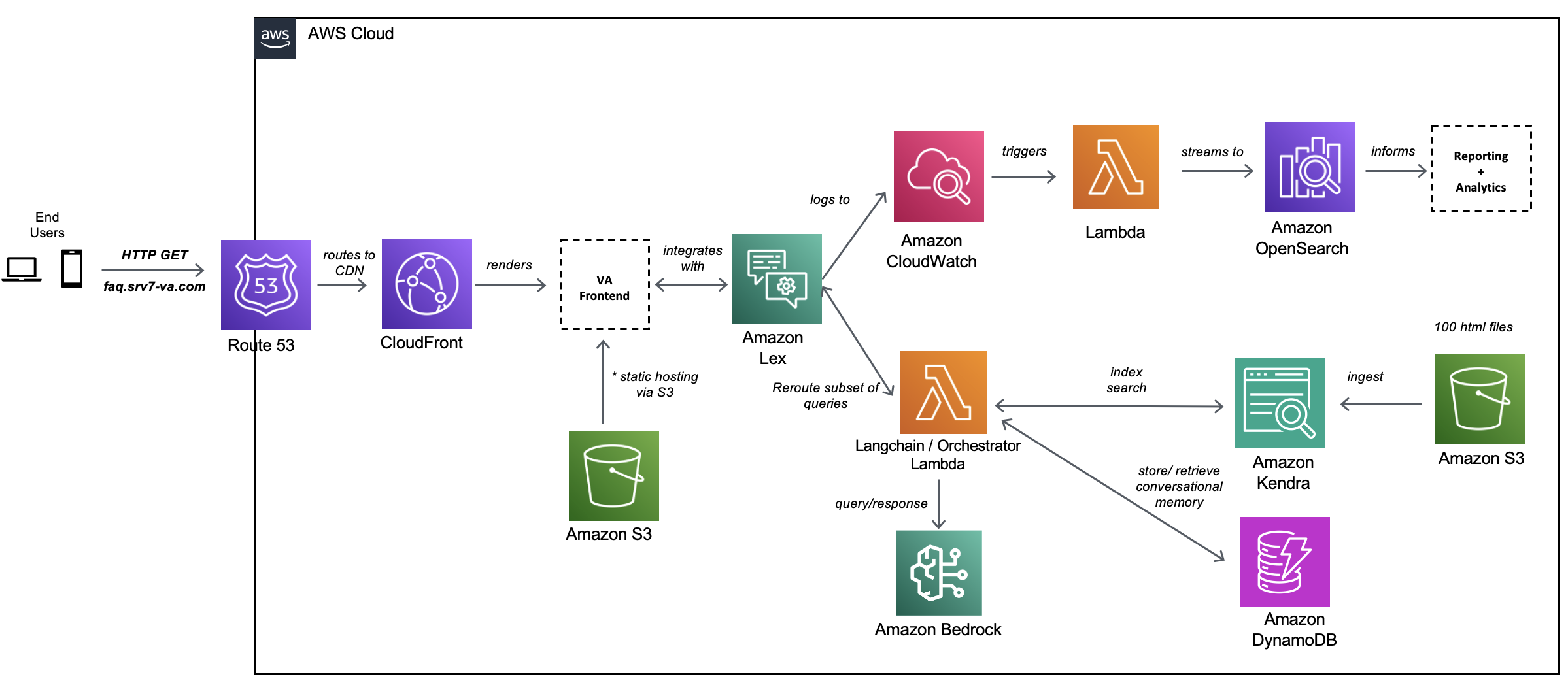

Het volgende diagram illustreert de oplossingsarchitectuur.

De architectuurstroom kan in twee delen worden begrepen:

In de volgende secties bespreken we verschillende aspecten van de oplossing en de ontwikkeling ervan in meer detail.

Model selectie

Het proces voor modelselectie omvatte regressietests van verschillende modellen die beschikbaar zijn in Amazon Bedrock, waaronder AI21 Labs, Cohere, Anthropic en Amazon Foundation-modellen. We hebben gecontroleerd op ondersteunde gebruiksscenario's, modelkenmerken, maximale tokens, kosten, nauwkeurigheid, prestaties en talen. Op basis hiervan hebben we Claude-2 geselecteerd als het meest geschikt voor deze gebruikssituatie.

Databron

We hebben een Amazon Kendra-index gemaakt en een gegevensbron toegevoegd met behulp van webcrawlerconnectoren met een rootweb-URL en mapdiepte van twee niveaus. Verschillende webpagina's zijn opgenomen in de Amazon Kendra-index en gebruikt als gegevensbron.

GenAI-chatbotverzoek- en reactieproces

Stappen in dit proces bestaan uit een end-to-end interactie met een verzoek van Amazon-Lex en een reactie van een groot taalmodel (LLM):

- De gebruiker dient het verzoek in bij de conversatie-front-end-applicatie die wordt gehost in een Amazon eenvoudige opslagservice (Amazon S3) bak erdoor Amazon Route 53 en Amazon CloudFront.

- Amazon Lex begrijpt de bedoeling en stuurt het verzoek door naar de orkestrator die wordt gehost in een AWS Lambda functie.

- De Orchestrator Lambda-functie voert de volgende stappen uit:

- De functie werkt samen met de applicatiedatabase, die wordt gehost in een door DynamoDB beheerde database. De database slaat de sessie-ID en gebruikers-ID op voor de gespreksgeschiedenis.

- Er wordt nog een verzoek naar de Amazon Kendra-index gestuurd om de top vijf van relevante zoekresultaten te verkrijgen en zo de relevante context op te bouwen. Met behulp van deze context wordt een aangepaste prompt geconstrueerd die vereist is voor het LLM-model.

- De verbinding wordt tot stand gebracht tussen Amazon Bedrock en de orkestrator. Er wordt een verzoek naar het Amazon Bedrock Claude-2-model geplaatst om het antwoord van het geselecteerde LLM-model te krijgen.

- De gegevens worden naverwerkt vanuit het LLM-antwoord en er wordt een antwoord naar de gebruiker verzonden.

Online rapportage

Het online meldproces bestaat uit de volgende stappen:

- Eindgebruikers communiceren met de chatbot via een CloudFront CDN front-endlaag.

- Elke verzoek/antwoord-interactie wordt mogelijk gemaakt door de AWS SDK en stuurt netwerkverkeer naar Amazon Lex (de NLP-component van de bot).

- Metagegevens over de verzoek/antwoord-koppelingen worden geregistreerd Amazon Cloud Watch.

- De CloudWatch-logboekgroep is geconfigureerd met een abonnementsfilter waarnaar aanmeldingen worden verzonden Amazon OpenSearch-service.

- Zodra ze beschikbaar zijn in de OpenSearch Service, kunnen logboeken worden gebruikt om rapporten en dashboards te genereren met Kibana.

Conclusie

In dit bericht hebben we laten zien hoe Accenture generatieve AI-services van AWS gebruikt om een end-to-end-aanpak voor digitale transformatie te implementeren. We hebben de hiaten in traditionele platforms voor het beantwoorden van vragen geïdentificeerd en de generatieve intelligentie binnen het raamwerk verbeterd voor snellere responstijden en het voortdurend verbeteren van het systeem terwijl we in contact komen met gebruikers over de hele wereld. Neem contact op met het Accenture Center of Excellence-team om dieper in de oplossing te duiken en deze oplossing voor uw klanten te implementeren.

Dit Knowledge Assist-platform kan worden toegepast op verschillende industrieën, inclusief maar niet beperkt tot gezondheidswetenschappen, financiële dienstverlening, productie en meer. Dit platform biedt natuurlijke, mensachtige antwoorden op vragen met behulp van geborgde kennis. Dit platform maakt efficiëntie, productiviteit en nauwkeurigere acties mogelijk die gebruikers kunnen ondernemen.

De gezamenlijke inspanning bouwt voort op de 15-jarige strategische relatie tussen de bedrijven en maakt gebruik van dezelfde bewezen mechanismen en versnellers die zijn gebouwd door de Accenture AWS-bedrijfsgroep (AABG).

Maak contact met het AABG-team op accentureaws@amazon.com om bedrijfsresultaten te stimuleren door te transformeren naar een intelligente data-onderneming op AWS.

Voor meer informatie over generatieve AI op AWS met behulp van Amazon Bedrock of Amazon Sage Maker, raden wij de volgende bronnen aan:

Ook meld u aan voor de AWS generatieve AI-nieuwsbrief, inclusief educatieve bronnen, blogs en service-updates.

Over de auteurs

Ilan Geller is de Managing Director bij Accenture met de nadruk op kunstmatige intelligentie, die klanten helpt bij het opschalen van kunstmatige intelligentie-applicaties en de Global GenAI COE Partner Lead voor AWS.

Ilan Geller is de Managing Director bij Accenture met de nadruk op kunstmatige intelligentie, die klanten helpt bij het opschalen van kunstmatige intelligentie-applicaties en de Global GenAI COE Partner Lead voor AWS.

Shuyu Yang is Genative AI and Large Language Model Delivery Lead en leidt ook CoE (Center of Excellence) Accenture AI (AWS DevOps professional) teams.

Shuyu Yang is Genative AI and Large Language Model Delivery Lead en leidt ook CoE (Center of Excellence) Accenture AI (AWS DevOps professional) teams.

Shikhar Kwatra is een AI/ML-specialistische oplossingsarchitect bij Amazon Web Services en werkt samen met een toonaangevende Global System Integrator. Hij heeft de titel verdiend van een van de jongste Indiase meesteruitvinders met meer dan 500 patenten op het gebied van AI/ML en IoT. Shikhar helpt bij het ontwerpen, bouwen en onderhouden van kostenefficiënte, schaalbare cloudomgevingen voor de organisatie, en ondersteunt de GSI-partner bij het bouwen van strategische brancheoplossingen op AWS.

Shikhar Kwatra is een AI/ML-specialistische oplossingsarchitect bij Amazon Web Services en werkt samen met een toonaangevende Global System Integrator. Hij heeft de titel verdiend van een van de jongste Indiase meesteruitvinders met meer dan 500 patenten op het gebied van AI/ML en IoT. Shikhar helpt bij het ontwerpen, bouwen en onderhouden van kostenefficiënte, schaalbare cloudomgevingen voor de organisatie, en ondersteunt de GSI-partner bij het bouwen van strategische brancheoplossingen op AWS.

Jay Pillai is een Principal Solution Architect bij Amazon Web Services. In deze rol fungeert hij als Global Generative AI Lead Architect en tevens als Lead Architect voor Supply Chain Solutions bij AABG. Als leider op het gebied van informatietechnologie is Jay gespecialiseerd in kunstmatige intelligentie, data-integratie, business intelligence en gebruikersinterfacedomeinen. Hij heeft 23 jaar uitgebreide ervaring met het werken met verschillende klanten in de bedrijfsdomeinen supply chain, juridische technologieën, onroerend goed, financiële diensten, verzekeringen, betalingen en marktonderzoek.

Jay Pillai is een Principal Solution Architect bij Amazon Web Services. In deze rol fungeert hij als Global Generative AI Lead Architect en tevens als Lead Architect voor Supply Chain Solutions bij AABG. Als leider op het gebied van informatietechnologie is Jay gespecialiseerd in kunstmatige intelligentie, data-integratie, business intelligence en gebruikersinterfacedomeinen. Hij heeft 23 jaar uitgebreide ervaring met het werken met verschillende klanten in de bedrijfsdomeinen supply chain, juridische technologieën, onroerend goed, financiële diensten, verzekeringen, betalingen en marktonderzoek.

Karthik Sonti leidt een wereldwijd team van Solutions Architects dat zich richt op het conceptualiseren, bouwen en lanceren van horizontale, functionele en verticale oplossingen met Accenture om onze gezamenlijke klanten te helpen hun bedrijf op een gedifferentieerde manier te transformeren op AWS.

Karthik Sonti leidt een wereldwijd team van Solutions Architects dat zich richt op het conceptualiseren, bouwen en lanceren van horizontale, functionele en verticale oplossingen met Accenture om onze gezamenlijke klanten te helpen hun bedrijf op een gedifferentieerde manier te transformeren op AWS.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/accenture-creates-a-knowledge-assist-solution-using-generative-ai-services-on-aws/