SEO 통찰력을 얻기 위해 수천 개의 도메인을 분석하는 것은 지루할 수 있습니다. 상당한 시간과 리소스가 필요한 경우가 많지만 API 기술을 사용하면 대량 도메인 검사를 보다 쉽게 수행하고 효율적으로 수행할 수 있습니다. 이를 통해 경쟁력 있는 틈새 시장을 더 쉽게 분석하고 더 나은 게스트 블로깅 기회를 찾을 수 있습니다. 이 기사에서는 SE Ranking의 API가 사용자가 대규모로 포괄적인 도메인 분석을 수행할 수 있도록 지원하는 방법을 살펴보겠습니다. 이것이 어떻게 작업 흐름을 크게 간소화하고 SEO 프로젝트에 더 나은 결과를 가져올 수 있는 귀중한 통찰력으로 변환되는지 알게 될 것입니다. 또한 이 API를 SEO 루틴에 통합할 수 있는 다양한 방법도 살펴보겠습니다.

바로 뛰어 들자!

TL; DR

여러 웹사이트에 대한 도메인 데이터를 얻으려면 API, 특히 경쟁 연구 과 백 링크 검사기 API. 이러한 API는 유기적 트래픽, 키워드 수, 도메인 신뢰 점수, 참조 도메인, 백링크 등과 같은 포괄적인 정보를 제공합니다. 더 좋은 점은 이러한 API를 활용하기 위해 코딩 기술이 필요하지 않다는 것입니다.

Python으로 도메인 분석 데이터를 얻으려면 Google Colab에서 코드를 실행해야 합니다. 실행되면 결과가 Google 스프레드시트에 표시됩니다. 각 측정항목을 개별적으로 보려면 표에 특정 수식을 적용하세요. 필요한 지표를 선택할 수 있습니다.

이 모든 데이터는 빠른 경쟁 및 틈새 분석을 수행하고 모든 도메인의 백링크 프로필을 평가하거나 다른 유형의 SEO 분석을 수행하는 데 도움이 됩니다.

API 개요: API란 무엇이며 어떻게 작동하나요?

SE Ranking 팀이 만들었습니다. 여러 API. 대규모 도메인 데이터 분석 및 기타 SEO 작업을 통해 작업을 단순화하도록 설계되었습니다. 이제 SE 순위 플랫폼에 수동으로 로그인하지 않고도 원시 데이터를 검색할 수 있습니다. 이는 수많은 데이터와 계정을 관리하는 회사에 이상적입니다(예: SEO 대행사).

이 API는 비즈니스 구독 로 작성되어야 합니다.

SE 순위를 사용하여 도메인을 대량으로 분석하려면 다음 두 가지 API를 사용하십시오. 경쟁 연구 과 백 링크 검사기.

XNUMXD덴탈의 경쟁사 조사 API 트래픽, 키워드 및 기타 측정항목을 포함하여 자연 검색결과와 유료 검색결과 모두에서 도메인 통계에 액세스할 수 있는 편리한 형식을 제공합니다. 한편, 백링크 검사기 API 백링크 프로필 분석을 수행하는 데 사용할 수 있는 데이터를 제공합니다. 두 API를 결합하면 이러한 도구의 플랫폼 버전에서 사용할 수 있는 거의 모든 수치 측정항목을 제공합니다.

다음은 사용 가능한 주요 지표 중 일부입니다.

경쟁 조사 API:

- 지정된 위치 내의 총 도메인 트래픽

- 지정된 위치에서 도메인이 순위를 매기는 키워드 수

- 새로 획득한 키워드 수

- SERP에서 삭제된 키워드 수

- 순위가 일정한 키워드 수

- 순위가 향상된 키워드 수

- 순위가 감소한 키워드 수

- 1~5위, 6~10위, 11~20위의 총 키워드 수

- 그리고 더

백링크 검사기 API:

- 도메인 신뢰 점수

- URL에 대한 총 백링크 수

- 해당 URL에 대한 총 추천 도메인 수

- dofollow/nofollow 백링크의 총 수

- 그리고 더

이것은 전체 목록이 아닙니다. 모든 매개변수는 당사에서 찾을 수 있습니다. 백링크 검사기 API 과 경쟁사 조사 API 문서.

API를 사용하여 작업 흐름을 최적화하는 방법

API를 완전히 활용하기 위해 코딩 방법을 알 필요는 없습니다. 제공된 Python 코드를 실행하고 Google Sheets를 통해 결과에 액세스하기만 하면 됩니다.

작업할 코드를 자세히 살펴보는 것부터 시작하겠습니다.

사용 가능한 코드

다음 두 스크립트 중 하나를 사용하여 도메인 분석을 수행할 수 있습니다.

1. [경쟁 조사 + 백링크 체커 API]

장점 : 한 번에 두 개의 모듈에서 더 많은 데이터를 얻을 수 있습니다.

단점 : 여전히 Backlink Checker 크레딧을 사용하고 있습니다. 처리할 데이터 양이 많기 때문에 코드 작동 속도가 느려집니다.

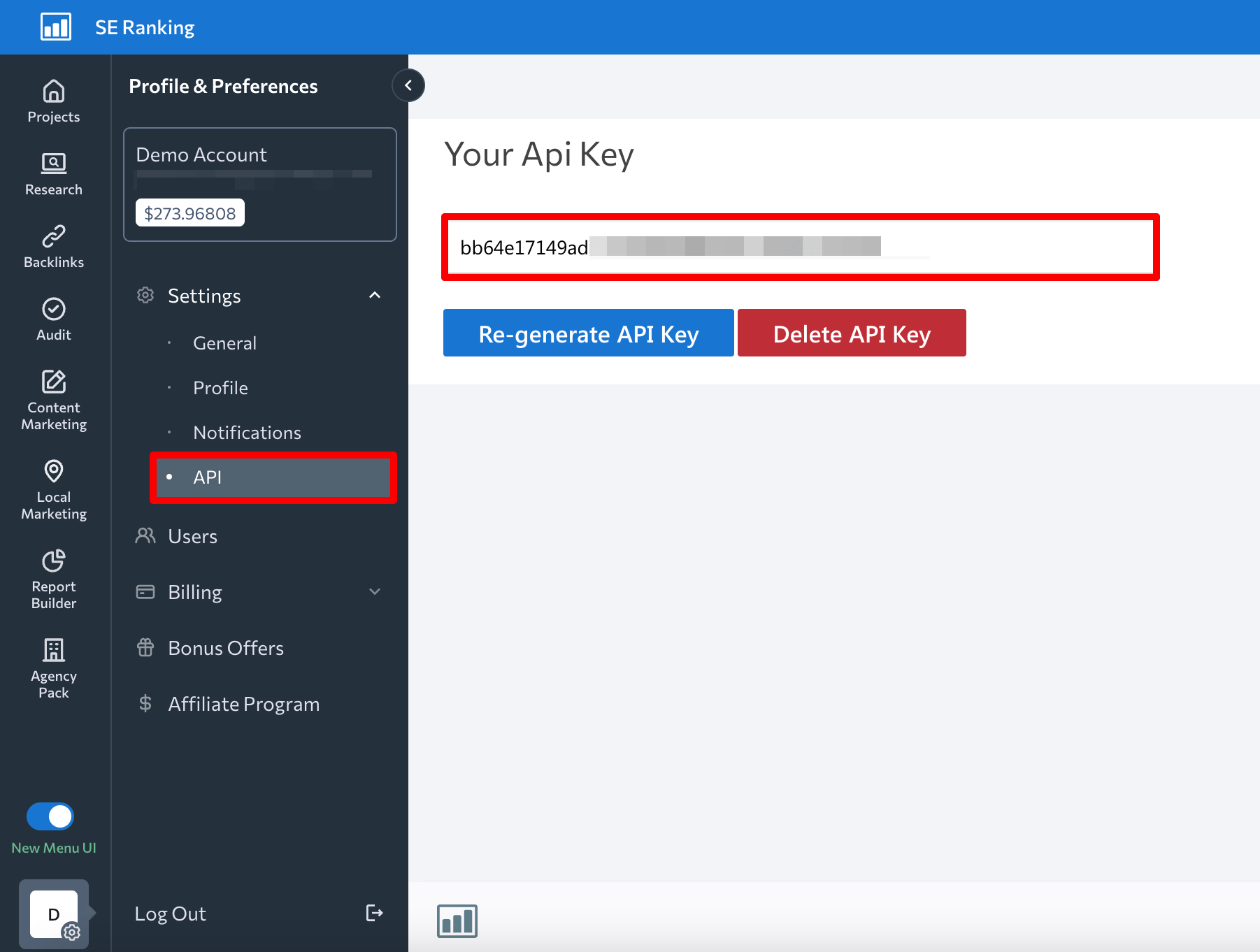

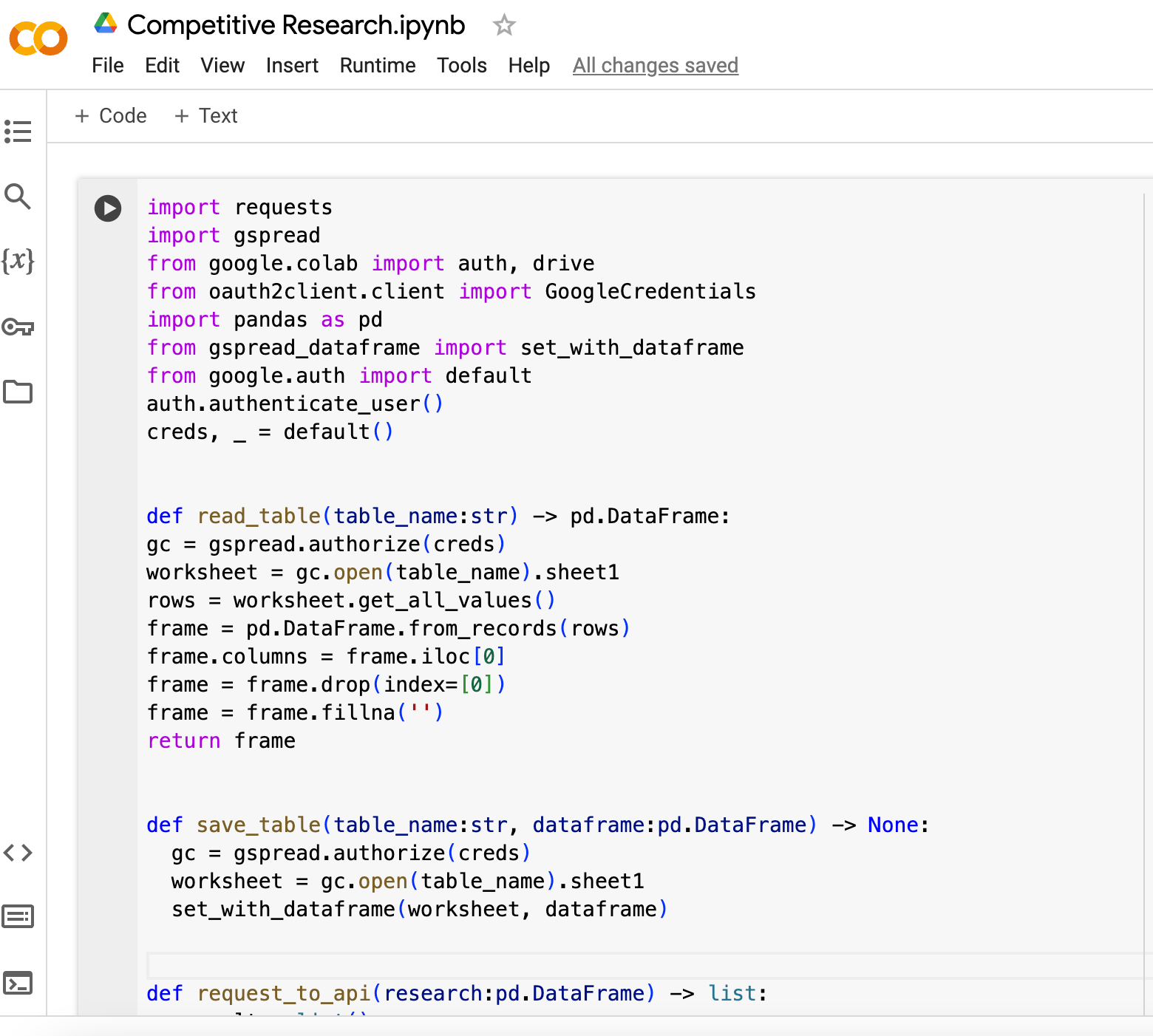

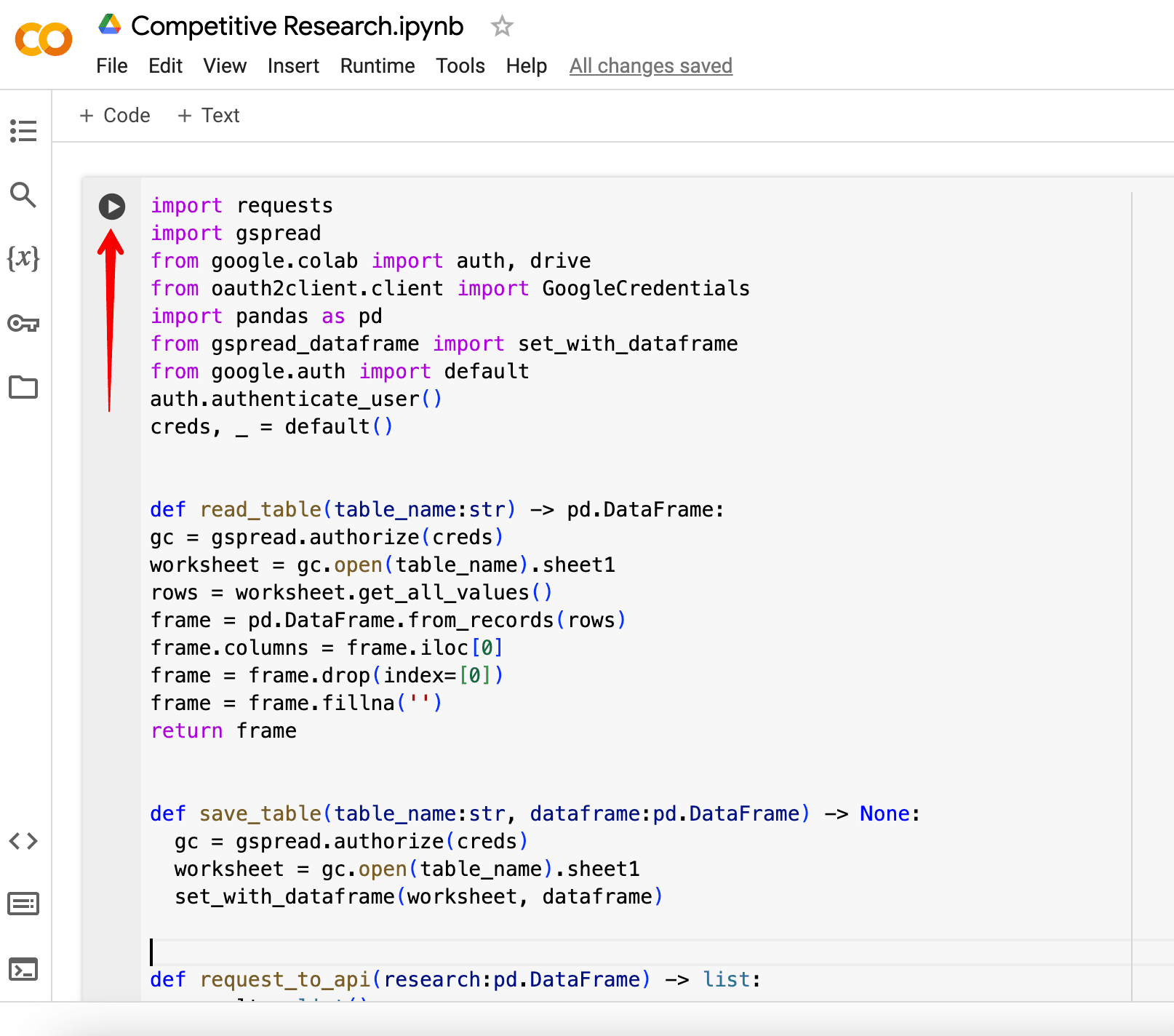

아래 코드를 복사하여 붙여넣어야 합니다. 구글 콜랩. 하지만 API 키를 api_key 매개변수. 이는 다음에서 찾을 수 있습니다. API SE Ranking 섹션 설정.

경쟁 연구 + 백링크 검사기 API 코드:

가져오기 요청 google.colab에서 gspread 가져오기 인증 가져오기, oauth2client.client에서 드라이브 가져오기 GoogleCredentials gspread_dataframe에서 pd로 팬더 가져오기 google.auth에서 set_with_dataframe 가져오기 기본 auth.authenticate_user() creds 가져오기, _ = default() def read_table(table_name:str) ) -> pd.DataFrame: gc = gspread.authorize(creds) 워크시트 = gc.open(table_name).sheet1 행 = worksheet.get_all_values() 프레임 = pd.DataFrame.from_records(rows) 프레임.columns = 프레임.iloc[ 0] 프레임 = 프레임.drop(index=[0]) 프레임 = 프레임.fillna('') 반환 프레임 def save_table(table_name:str, dataframe:pd.DataFrame) -> 없음: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 set_with_dataframe(worksheet, dataframe) def request_to_api(research:pd.DataFrame) -> list: result = index의 경우 list(), Research.iterrows()의 행: domain = row[' domain'] 연구_결과 = get_research_api_result(도메인) backlinks_result = get_backlinks_api_result(도메인) if (row['backlinks'] == '') else row['backlinks'] result.append([도메인, 연구_결과, backlinks_result]) 반환 결과 def get_api_headers() -> 문자열:

api_key = 'API 키 추가'

return dict(Authorization=api_key) def get_research_api_result(domain:str) -> str: params = dict(domain=domain) api_url = 'https://api4.seranking.com/research/uk/overview/?' 결과 = 요청.get(api_url, params=params, 헤더=get_api_headers()) 반환 결과.json() def get_backlinks_api_result(도메인:str) -> str: 보고서 = create_backlink_checker_report(도메인) Report_id = str(report.get(' report_id')) api_url = 'https://api4.seranking.com/backlink-reports/' + report_id + '/overview' 결과 = 요청.get(api_url, headers=get_api_headers()) delete_backlink_checker_report(report_id) 반환 결과. json() def create_backlink_checker_report(domain:str) -> str: params = dict(mode='domain', target=domain) api_url = 'https://api4.seranking.com/backlink-reports' result = 요청.포스트 (api_url, json=params, headers=get_api_headers()) return result.json() def delete_backlink_checker_report(report_id:str) -> 없음: api_url = 'https://api4.seranking.com/backlink-reports/' + Report_id request.delete(api_url, headers=get_api_headers()) def main(): table_name = 'competitive-research-API' table = read_table(table_name) result_table_requests_to_api = request_to_api(table) result_table_to_dataframe = pd.DataFrame(result_table_requests_to_api, columns=[' domain', 'result', 'backlinks']) save_table(table_name, result_table_to_dataframe) main()

2. [경쟁조사 API]

장점 : 스크립트가 더 빠르게 작동하고 크레딧을 소모하지 않습니다.

단점 : 획득하는 데이터가 적고 도메인 신뢰(도메인 권한), 백링크 수, 참조 도메인 등에 대한 정보를 받지 못합니다.

경쟁 연구 코드:

API 키를 입력하는 것을 잊지 마세요. api_key 매개 변수입니다.

가져오기 요청 google.colab에서 gspread 가져오기 인증 가져오기, oauth2client.client에서 드라이브 가져오기 GoogleCredentials gspread_dataframe에서 pd로 팬더 가져오기 google.auth에서 set_with_dataframe 가져오기 기본 auth.authenticate_user() creds 가져오기, _ = default() def read_table(table_name:str) ) -> pd.DataFrame: gc = gspread.authorize(creds) 워크시트 = gc.open(table_name).sheet1 행 = worksheet.get_all_values() 프레임 = pd.DataFrame.from_records(rows) 프레임.columns = 프레임.iloc[ 0] 프레임 = 프레임.drop(index=[0]) 프레임 = 프레임.fillna('') 반환 프레임 def save_table(table_name:str, dataframe:pd.DataFrame) -> 없음: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 set_with_dataframe(worksheet, dataframe) def request_to_api(research:pd.DataFrame) -> list: result = index의 경우 list(), Research.iterrows()의 행: domain = row[' domain'] 연구_결과 = get_research_api_result(도메인) result.append([도메인, 연구_결과]) 결과 반환 def get_api_headers() -> str:

api_key = 'API 키 추가'

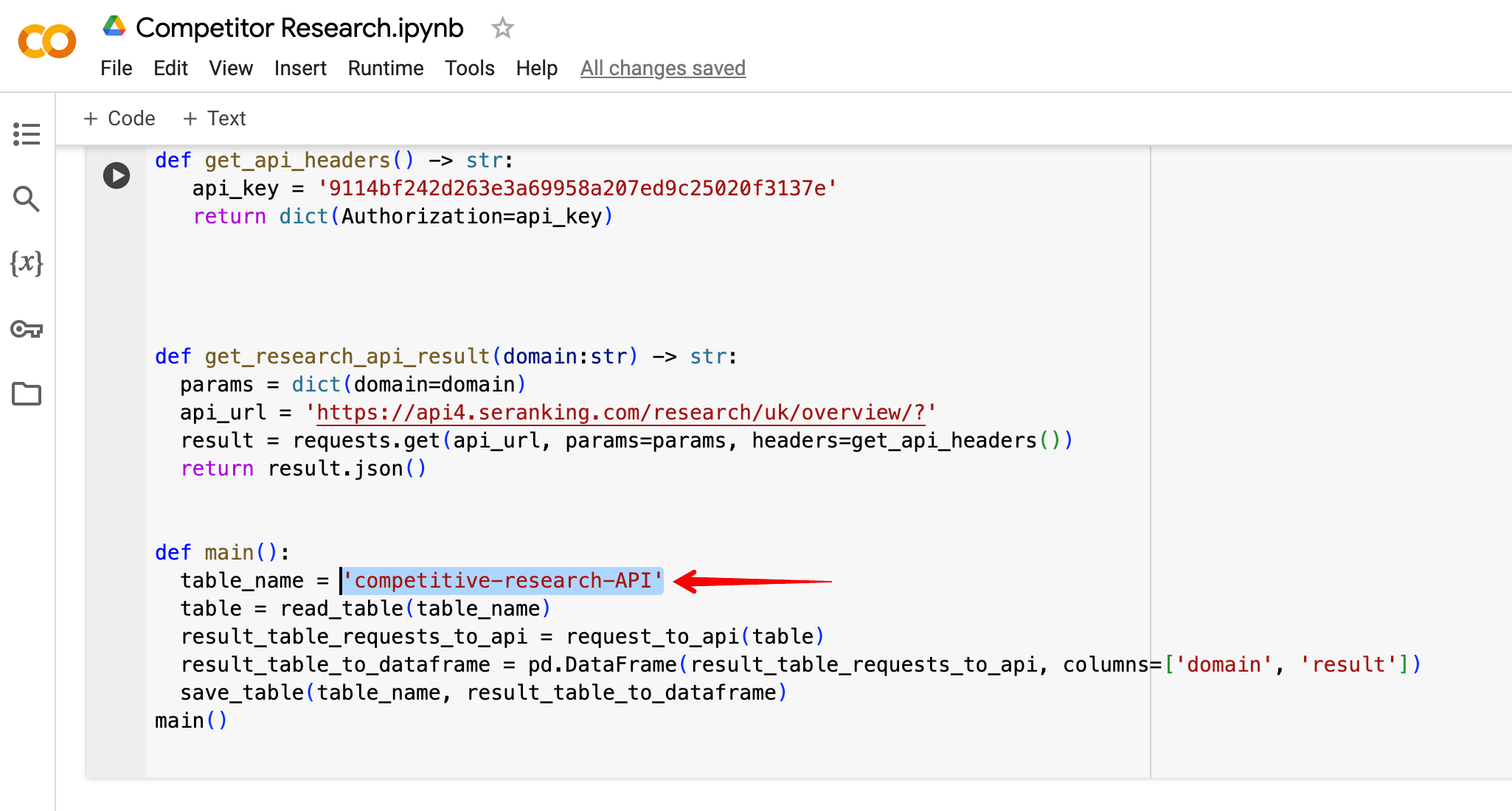

return dict(Authorization=api_key) def get_research_api_result(domain:str) -> str: params = dict(domain=domain) api_url = 'https://api4.seranking.com/research/uk/overview/?' result = request.get(api_url, params=params, headers=get_api_headers()) return result.json() def main(): table_name = 'competitive-research-API' table = read_table(table_name) result_table_requests_to_api = request_to_api(table) result_table_to_dataframe = pd.DataFrame(result_table_requests_to_api, columns=['domain', 'result']) save_table(table_name, result_table_to_dataframe) main()

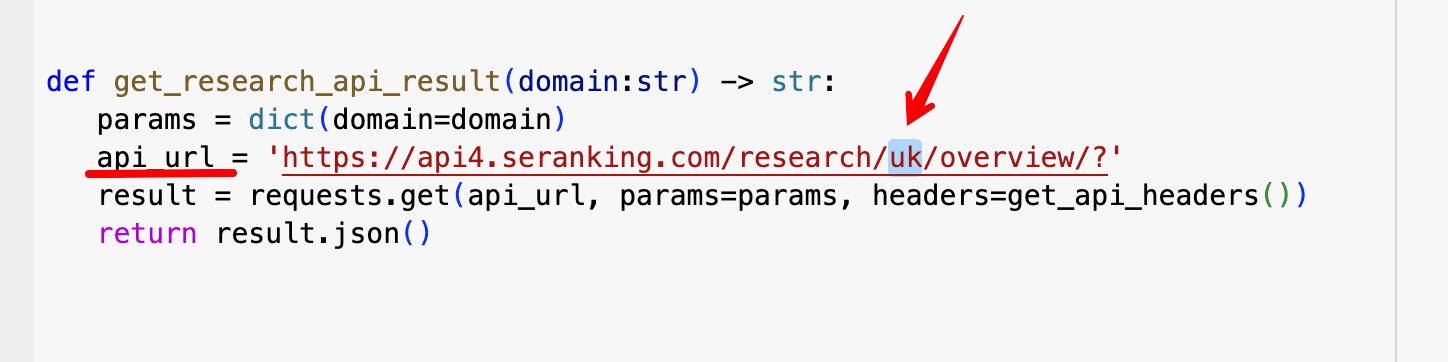

주의해야 할 몇 가지 주요 매개변수는 다음과 같습니다.

- API 키가 코드에 표시되는 방식은 다음과 같습니다.

- In api_url, 트래픽/키워드 데이터를 검색할 위치를 변경할 수 있습니다.

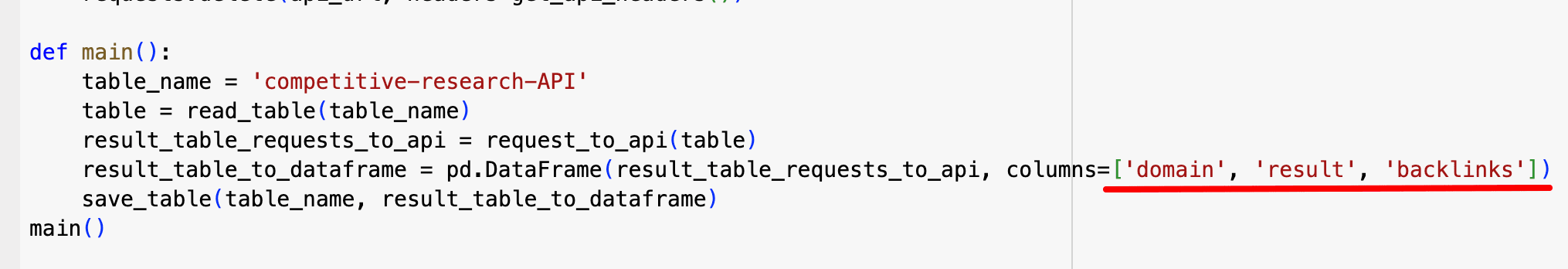

- Google 스프레드시트 파일의 열입니다.

이제 이러한 코드를 활용하는 단계별 가이드로 넘어가겠습니다.

그것을 사용하는 방법

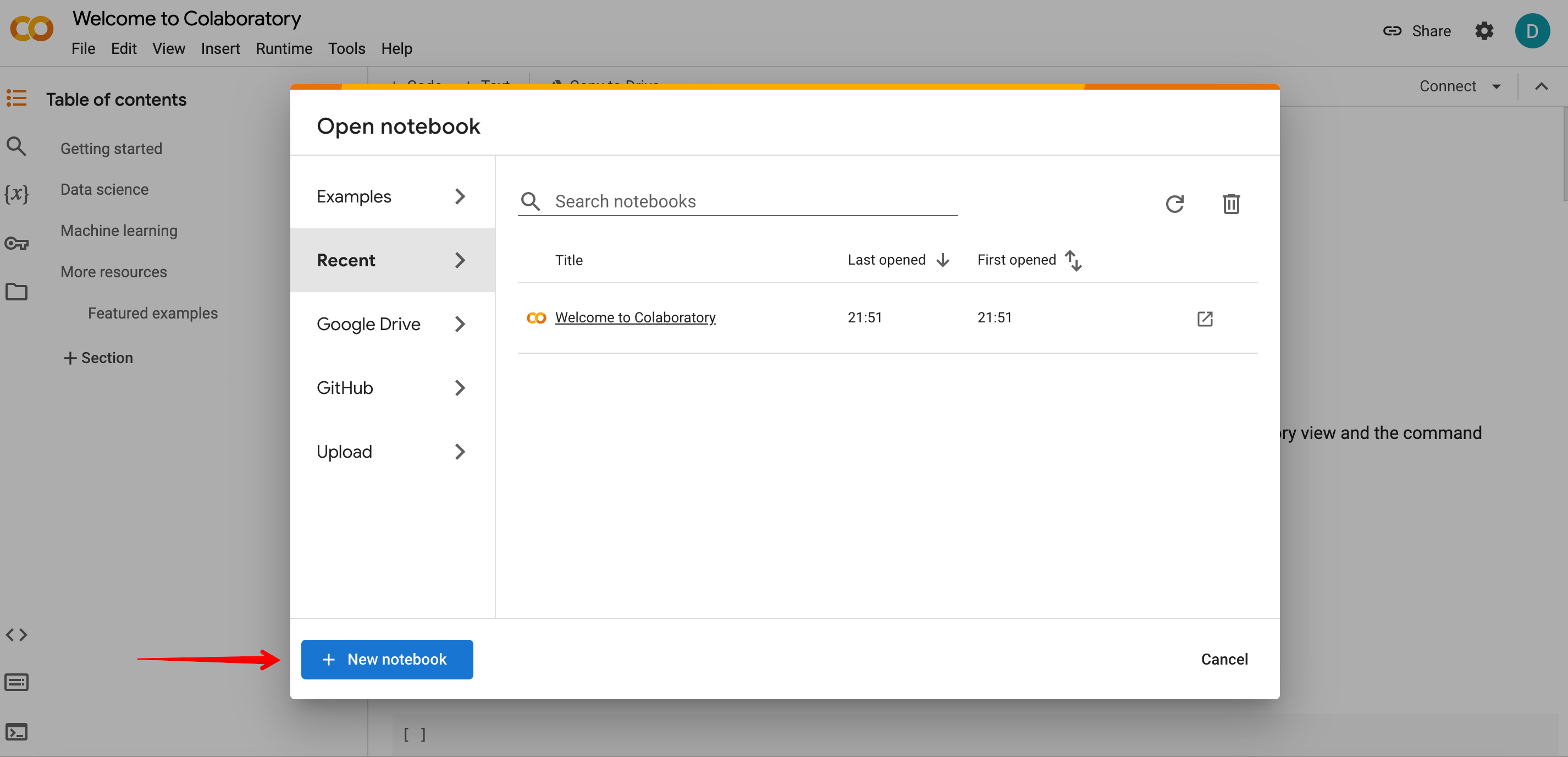

1 단계 엽니다 구글 콜랩, 새 노트북을 만들고 이전 섹션에서 제공된 두 코드 중 하나를 붙여넣습니다.

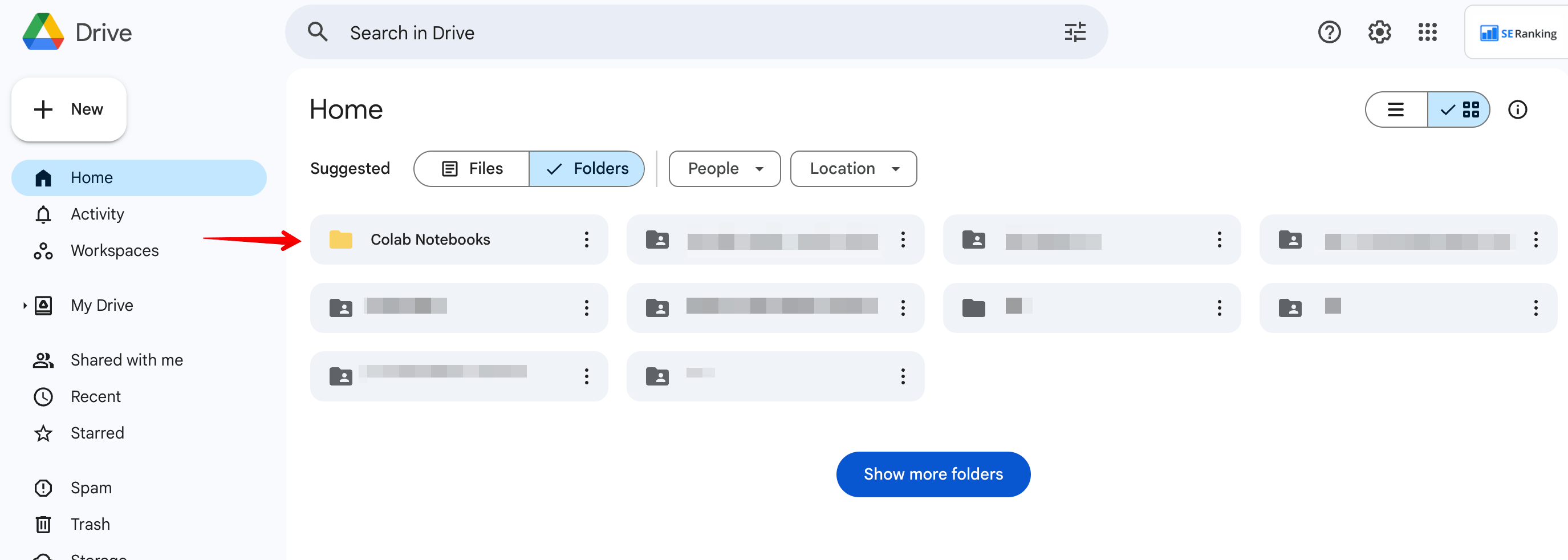

2 단계 열기 Colab 노트북 Google 드라이브에 폴더를 만들고 Google 시트 파일을 만듭니다.

참고: 파일 이름이 파일 이름과 정확히 일치하는지 확인하십시오. 테이블 _ 아래 예제와 같이 코드에서.

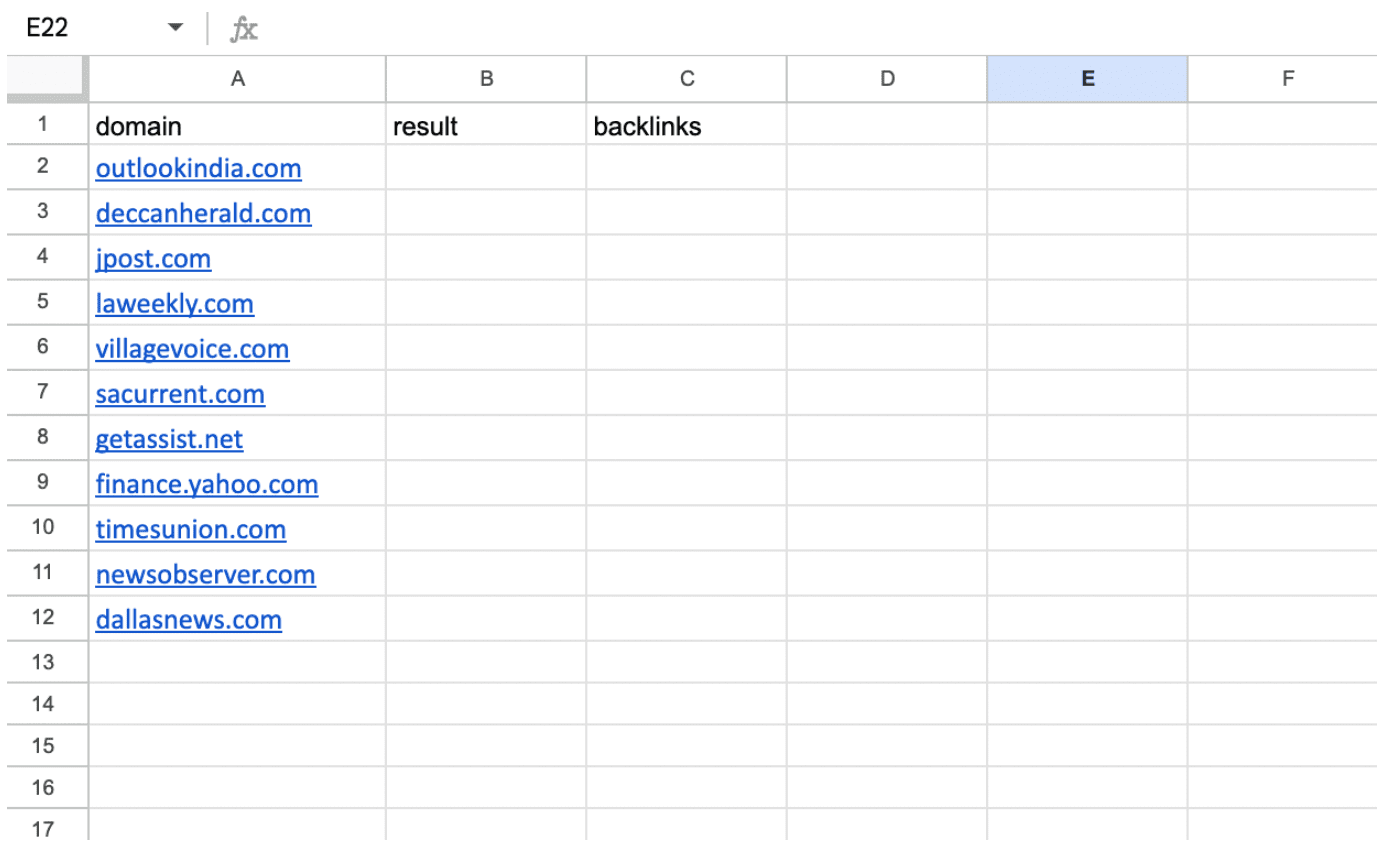

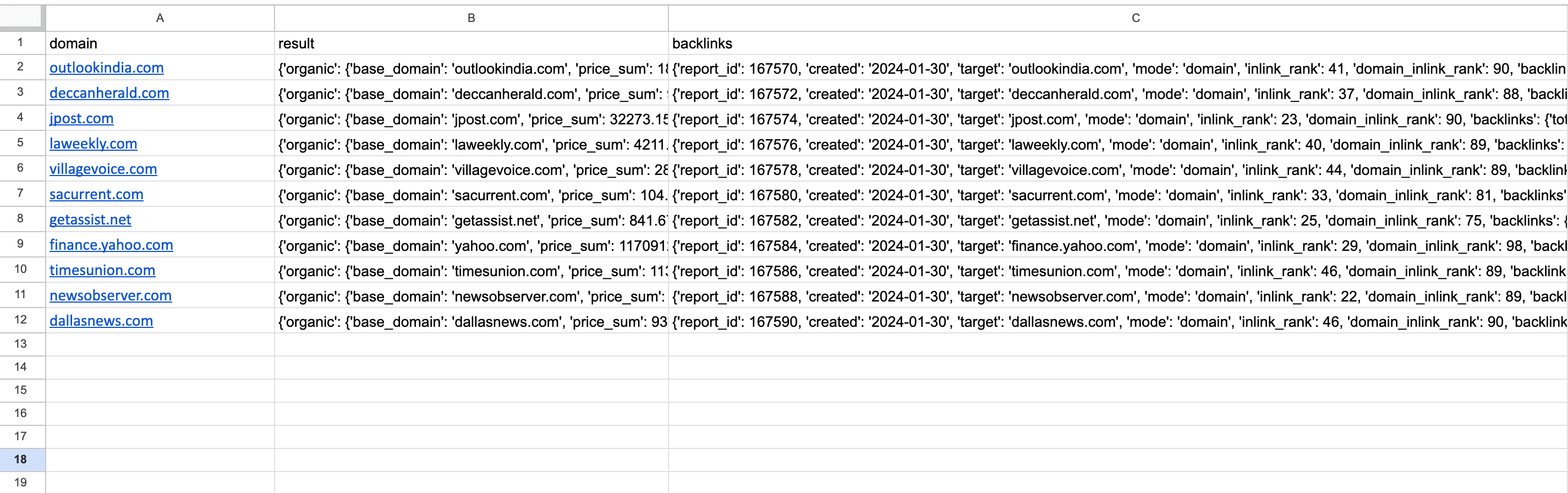

3 단계 사용 중인 스크립트에 따라 열에 이름을 지정합니다. 사용하는 경우 경쟁 연구 API 스크립트에서만 A열과 B열을 호출해야 합니다. 도메인 과 결과, 공손히. 에 대한 경쟁 연구 과 백링크 검사기 API 스크립트 외에도 도메인 과 결과 열이 있는 경우 세 번째 열을 추가해야 합니다. 백.

세 개의 열이 있는 두 번째 버전을 보여주는 아래 스크린샷을 참조하세요.

필요한 경우 열 이름을 바꾸고 이에 따라 코드를 업데이트할 수 있습니다.

그런 다음 첫 번째 열에 도메인을 입력하지 않고 도메인을 입력하세요. http:// 과 WWW.

4 단계 : Colab으로 이동하여 버튼을 클릭하여 코드를 실행하고 필요한 경우 액세스 권한을 부여하세요.

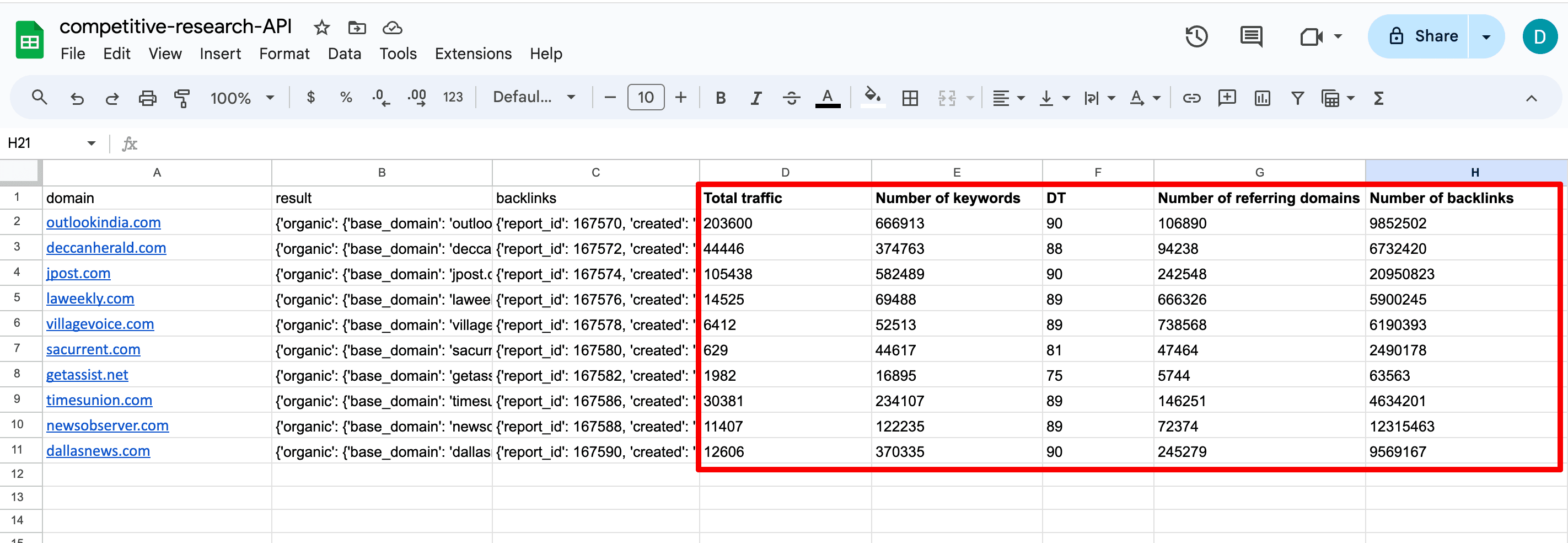

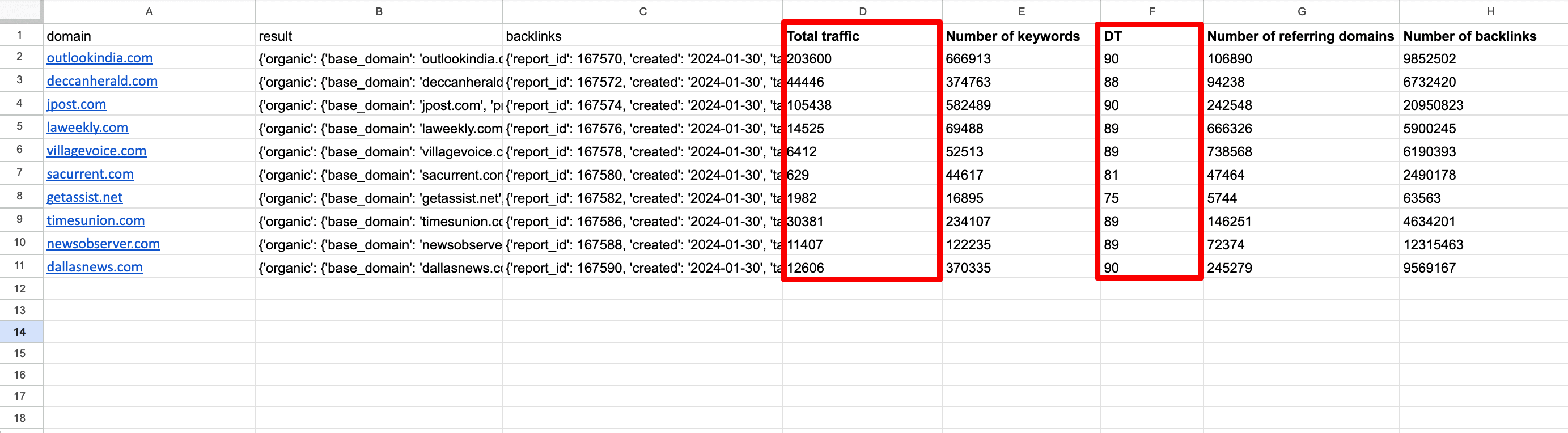

5 단계 : 스크립트 실행이 완료된 후 나중에 Google Sheets 파일을 다시 확인하여 결과를 확인하세요. 테이블은 다음과 같습니다.

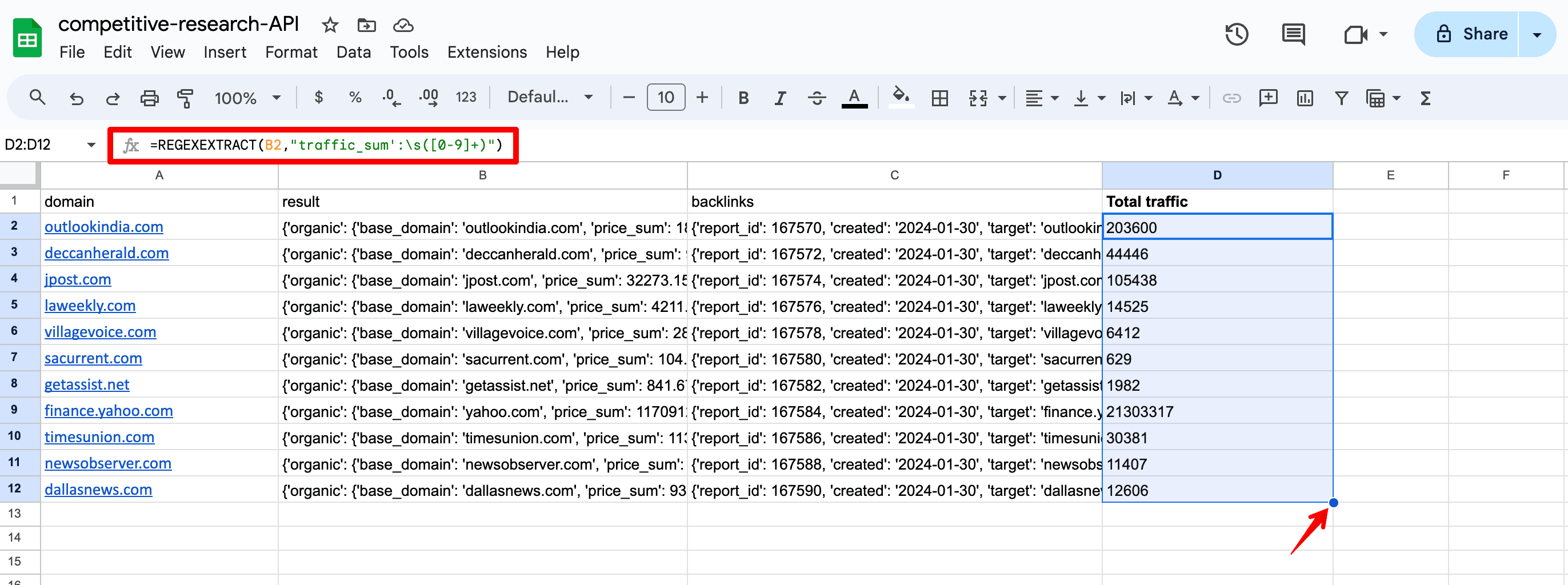

6 단계 지정한 측정항목을 분리하려면 JSON 데이터에서 추출하세요. 그냥 입력하세요 =REGEX추출 작동하거나 자신만의 솔루션을 생각해 보세요. 아래는 접근 공식이다. 트래픽_합계 지정된 위치의 총 유기적 트래픽을 나타내는 매개변수:

=REGEXEXTRACT(B2,”traffic_sum':s([0-9]+)”)

- B2 JSON 데이터가 포함된 열입니다(예: 결과 열). 다른 열의 데이터가 필요한 경우 수식에서 변경할 수 있습니다.

- 트래픽_합계 관심 측정항목입니다. 다른 데이터를 검색하려면 수식에서 이 매개변수를 변경할 수 있습니다.

- s([0-9]+) 공백 문자 바로 뒤에 하나 이상의 숫자가 오는 시퀀스를 검색하는 정규식입니다. 변경할 필요가 없습니다.

7 단계 첫 번째 셀에 수식을 입력한 후 아래로 끌어 수식을 모든 셀에 복사합니다. 목록에 있는 각 도메인에서 데이터를 얻어야 합니다.

다음은 중요한 도메인 데이터를 얻기 위해 수식에 사용할 수 있는 주요 측정항목 목록입니다.

- 키워드_개수 — 지정된 위치에서 도메인이 순위를 매긴 키워드의 총 수입니다.

- top1_5 — 상위 1~5위 안에 드는 총 키워드 수입니다.

- 키워드_신규_수 — 새 키워드의 총 개수입니다.

- domain_inlink_rank — 도메인 신뢰 점수.

- total_domains — URL에 대한 총 추천 도메인 수입니다.

- total_backlinks — URL에 대한 총 백링크 수입니다.

JSON 형식의 각 측정항목은 다음에서 찾을 수 있습니다. 백링크 검사기 API ( 백 열) 및 경쟁사 조사 API ( 결과 열) 문서.

API 사용 사례 탐색

이 데이터가 귀하에게 어떤 이점을 줄 수 있는지 궁금하십니까? API의 이점을 누릴 수 있는 SEO의 일부 영역을 살펴보겠습니다.

- 경쟁 및 틈새 시장 분석

유기적 트래픽, 키워드 수, 백링크 및 도메인 신뢰와 같은 요소를 기반으로 경쟁사(또는 틈새 시장의 도메인)의 강점을 평가할 수 있습니다. 이를 통해 틈새시장의 전반적인 경쟁력과 이러한 웹사이트와 비교하여 귀하의 위치를 가늠할 수 있습니다.

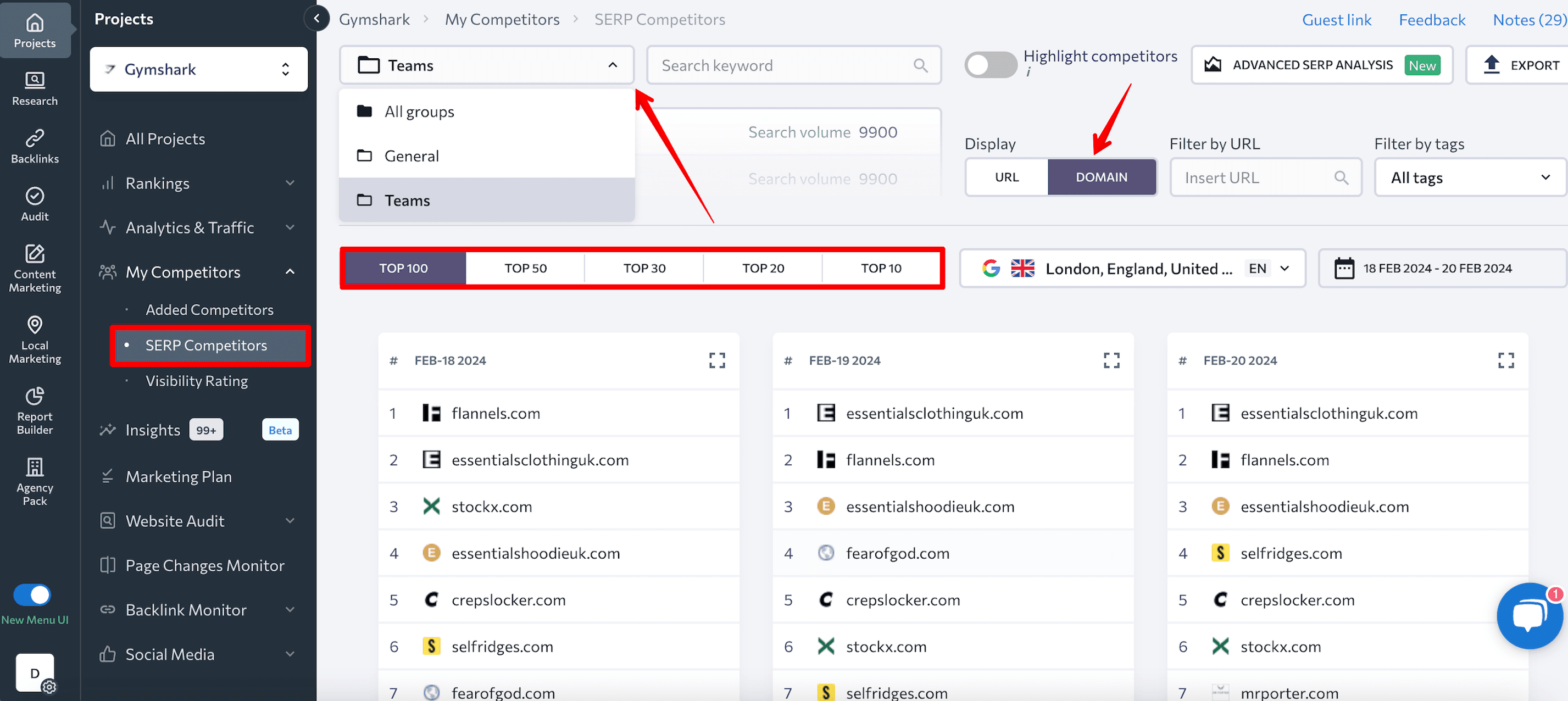

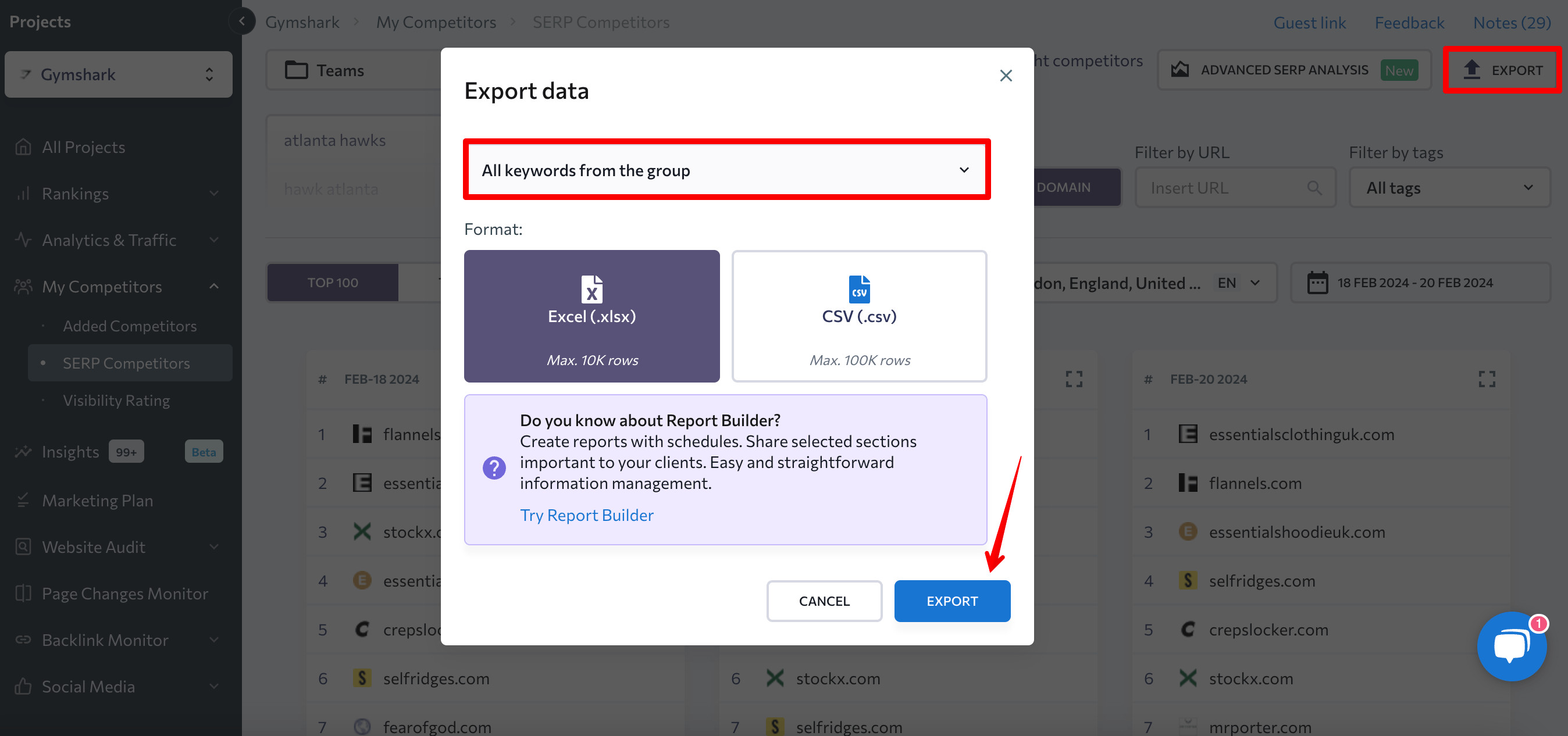

도메인 목록을 확장하고 틈새 시장에서 더 많은 웹사이트를 찾으려면 틈새 시장의 키워드에 대한 SERP 결과를 얻을 수 있습니다. SE랭킹을 이용해보세요 SERP 경쟁자 아래의 기능 내 경쟁자 이 정보를 얻으려면 탭을 누르세요.

방법은 다음과 같습니다.

- 드롭다운 메뉴에서 원하는 키워드 그룹을 선택합니다(이전에 프로젝트 내의 단일 그룹에 필요한 모든 키워드를 추가했는지 확인하세요).

- 필요한 SERP 결과 수(100/50/30/20/10)를 선택하세요.

- 선택 도메인 방법.

그런 다음 데이터를 내보냅니다. 선택 그룹의 모든 키워드 검사하려는 키워드에 대해 상위 10~100위 안에 드는 도메인 목록을 얻는 옵션입니다.

검사하려는 웹사이트를 선택한 후 이를 Google 스프레드시트 파일에 추가하고 도메인 SEO 분석을 수행하세요. 이러한 사이트의 유기적 트래픽, 키워드 수, 백링크, 참조 도메인 및 도메인 신뢰 점수를 비교합니다. 이는 틈새 시장의 경쟁 환경에 대한 귀중한 통찰력을 제공할 수 있습니다.

심층적인 경쟁 분석을 수행하려면 SE Ranking과 같은 전문 도구를 사용하십시오. 경쟁 연구 과 백 링크 검사기.

- 게스트 블로깅 및 디지털 PR

당신은 또한 링크 건물 잠재적인 협업 기회를 위해 연락할 가장 관련성이 높은 도메인을 정확히 찾아 노력합니다. API를 사용하여 빠른 초기 조사 연구를 수행하면 추가 리소스에 투자하기 전에 도메인 품질을 평가하는 데 도움이 됩니다.

예를 들어 유기적 트래픽과 도메인 신뢰 점수를 평가하여 심층 분석 및 추가 협업 지원을 위한 잠재적 소스를 정확히 찾아낼 수 있습니다. 이 접근 방식은 사이트 관련성 및 기타 중요한 질적 지표에 대한 통찰력을 제공하지 못할 수 있지만 캠페인을 위한 좋은 출발점이 됩니다.

최대 포장

SE Ranking의 API 기능은 여러 대규모 프로젝트를 동시에 관리하는 기업에 이상적인 솔루션입니다. 대규모 데이터 세트를 분석하고 SEO 프로세스를 자동화하는 프로세스를 원활하게 합니다.

우리가 제공한 API 코드와 가이드가 대량 도메인 분석 작업을 단순화하는 데 도움이 되기를 바랍니다. 우리는 코딩 기술이 없는 사람을 포함해 모든 사람을 위해 API를 설계했습니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://seranking.com/blog/bulk-domain-analysis-using-api/