概要

近年、人工知能 (AI) の分野では、生成 AI モデルの開発が目覚ましい勢いで進んでいます。これらのモデルは、 人間のようなテキストを生成する、画像、さらにはオーディオまで、かつては不可能だと考えられていたことの限界を押し広げます。これらのモデルの中で、Generative Pre-trained Transformer (GPT) は、自然言語処理 (NLP) における先駆的なブレークスルーとして際立っています。 GPT の複雑なアーキテクチャを調査し、GPT が生成 AI および NLP タスクをどのように簡単に処理するかを調べてみましょう。

目次

生成 AI モデルの台頭

生成 AI モデルは次のクラスです。 機械学習 テキスト、画像、音声などの新しいデータを最初から作成できるモデル。これらのモデルは膨大な量の既存データでトレーニングされ、基礎となるパターンと構造を学習できるようになります。トレーニングが完了すると、トレーニング データの特性を模倣した新しいオリジナルのコンテンツを生成できます。

生成 AI モデルの台頭は、深層学習技術、特にニューラル ネットワークの進歩によって促進されています。 深い学習 アルゴリズムは、データ内の複雑なパターンを捕捉するのに非常に効果的であることが証明されており、生成タスクに適しています。計算能力と大規模なデータセットへのアクセスが増加するにつれて、研究者はますます洗練された生成モデルをトレーニングできるようになりました。

GPTの謎

GPT モデルは、大規模言語モデル (LLM) の一種であり、次の機能を活用します。 ニューラルネットワーク 人間のようなテキストを理解して生成する。これらのモデルは、大規模なデータセットから学習したパターンに基づいて、新しい一貫したテキストを生成できるため、「生成的」です。これらは、膨大な量のテキスト データに対して初期トレーニング段階を受けるため、「事前トレーニング」されます。これにより、特定のタスクに合わせて微調整する前に、幅広い知識ベースを取得することができます。

「トランスフォーマー」アーキテクチャは、GPT モデルを前例のないレベルのパフォーマンスに押し上げた中心的なイノベーションです。 トランスフォーマー は、テキストなどの連続データを従来のモデルよりも効率的に処理するように設計されたニューラル ネットワークの一種です。これらは、モデルが出力を生成する際に入力のさまざまな部分の重要性を考慮できるようにする新しいアテンション メカニズムを採用しています。これにより、長距離の依存関係をキャプチャし、より一貫性のある文脈に関連したテキストを生成できるようになります。

GPT アーキテクチャの分析

GPT アーキテクチャは、生成機能、事前トレーニング アプローチ、トランスフォーマー ニューラル ネットワークという 3 つの主要なコンポーネントを強力に組み合わせたものです。これらの各柱は、GPT モデルが NLP タスクで優れたパフォーマンスを達成できるようにする上で重要な役割を果たします。

3 つの柱: ジェネレーティブ、事前トレーニング、トランスフォーマー

GPT モデルの「生成」側面とは、膨大な量のトレーニング データから学習したパターンに基づいて、新しい一貫したテキストを生成する機能を指します。従来の言語モデルは主にテキストの理解と分析に焦点を当てていました。これらとは異なり、GPT モデルは人間のようなテキスト出力を生成するように設計されており、さまざまなアプリケーションに非常に汎用性があります。

GPT モデルの「事前トレーニング済み」コンポーネントには、モデルが大量のテキスト データのコーパスにさらされる初期トレーニング フェーズが含まれます。この事前トレーニング段階で、モデルはデータ内の基礎となるパターン、構造、関係を捕捉する方法を学習します。これは、広範な知識ベースを効果的に構築するのに役立ちます。事前トレーニング段階は、モデルが微調整される前に言語についての一般的な理解を得ることができるため、非常に重要です。

「トランスフォーマー」アーキテクチャは、GPT モデルのニューラル ネットワーク バックボーンです。トランスフォーマーは、テキストなどの逐次データを従来のモデルよりも効率的に処理するように特別に設計された深層学習モデルです。これらは、モデルが出力を生成する際に入力のさまざまな部分の重要性を考慮できるようにする新しいアテンション メカニズムを採用しています。これにより、長距離の依存関係をキャプチャし、より一貫性のある文脈に関連したテキストを生成できるようになります。

GPT が一貫した文を生成する仕組み

GPT モデルは、前の単語またはトークンによって提供されるコンテキストに基づいて、シーケンス内の次の単語またはトークンを予測することによってテキストを生成します。このプロセスは、変圧器アーキテクチャ内の一連の計算を通じて実現されます。まず、入力テキストをトークン化し、それを数値表現 (埋め込み) に変換します。これらの埋め込みは、トランスの複数の層を通過します。ここで、アテンション メカニズムにより、モデルは入力のさまざまな部分間の関係をキャプチャし、コンテキストに関連した出力を生成できます。

モデルの出力は 確率分布 語彙全体にわたって、各単語またはトークンがシーケンス内の次の単語である可能性を示します。推論中、モデルはこの分布からサンプリングして次のトークンを生成し、入力シーケンスに追加します。このプロセスは、必要な出力長に達するか、停止条件が満たされるまで繰り返されます。

パフォーマンスを向上させるために大規模なデータセットを活用する

GPT モデルの主な利点の 1 つは、事前トレーニング段階で大規模なデータセットを活用できることです。これらのデータセットは、書籍、記事、Web サイト、ソーシャル メディアなど、さまざまなソースからの数十億の単語で構成されます。これにより、モデルは自然言語を多様かつ包括的に体験できるようになります。

事前トレーニング中に、モデルはテキスト生成プロセスと同様に、シーケンス内の次の単語またはトークンを予測する必要があります。ただし、モデルは新しいテキストを生成するのではなく、トレーニング データ内の基礎となるパターンと関係をキャプチャすることを学習します。この事前トレーニング段階は計算量が多くなりますが、非常に重要です。これにより、モデルは言語についての幅広い理解を深め、特定のタスクに合わせて微調整することができます。

事前トレーニング中に大規模なデータセットを活用することで、GPT モデルは膨大な知識ベースを取得できます。また、言語構造、慣用表現、文脈上のニュアンスについても深く理解することができます。この広範な事前トレーニングにより、モデルの強力な基盤が提供されます。これにより、タスク固有の微調整を比較的少なくするだけで、モデルが幅広い下流タスクで適切に実行できるようになります。

魔法の背後にあるニューラル ネットワーク

トランスフォーマー アーキテクチャは、GPT モデルを強化する中心的なイノベーションであり、NLP の分野に革命をもたらしました。従来とは異なり リカレントニューラルネットワーク (RNN) はシーケンシャル データを順次処理しますが、トランスフォーマーは、長距離の依存関係をキャプチャし、入力シーケンスを効率的に並列処理できる新しいアテンション メカニズムを採用しています。

トランスフォーマーのアーキテクチャは複数の層で構成されており、各層はマルチヘッド アテンション メカニズムとフィードフォワード ニューラル ネットワークという 2 つの主要コンポーネントで構成されています。アテンション メカニズムは、出力を生成するときに入力シーケンスのさまざまな部分の重要性を重み付けする役割を果たし、モデルがシーケンス内の離れた要素間のコンテキストと関係をキャプチャできるようにします。

フィードフォワード ニューラル ネットワーク層は、アテンション メカニズムの出力をさらに処理して洗練する役割を果たし、モデルが入力データのより複雑な表現を学習できるようにします。

トランスフォーマー アーキテクチャの並列処理とアテンション メカニズムは、NLP タスクにとって重要な、長いシーケンスの処理と長距離の依存関係のキャプチャにおいて非常に効果的であることが証明されています。このアーキテクチャにより、GPT モデルは最先端のパフォーマンスを達成できるようになりました。また、コンピューター ビジョンや音声認識など、さまざまな分野における他のトランスベースのモデルの開発にも影響を与えています。

変圧器の内部

トランスフォーマー アーキテクチャは、GPT モデルが NLP タスクで優れたパフォーマンスを達成できるようにするコア コンポーネントです。トランスフォーマーによるテキスト データの処理に含まれる主要な手順を詳しく見てみましょう。

トークン化: テキストを消化可能なチャンクに分割する

トランスフォーマーがテキストを処理できるようにするには、入力データをトークンと呼ばれる小さな単位に分割する必要があります。 トークン化 テキストをこれらのトークン (単語、サブワード、または個々の文字) に分割するプロセスです。このステップは、トランスフォーマーがさまざまな長さのシーケンスを処理し、まれな単語や語彙外の単語を効果的に表現できるようにするため、非常に重要です。トークン化プロセスには通常、単語の分割、句読点の処理、特殊文字の処理などの技術が含まれます。

単語の埋め込み: 単語を数値ベクトルにマッピング

テキストがトークン化されると、各トークンは単語埋め込みと呼ばれる数値ベクトル表現にマッピングされます。これらの単語の埋め込みは、それが表す単語の意味論的情報と構文情報を捕捉する高密度ベクトルです。トランスフォーマーはこれらの埋め込みを入力として使用し、ニューラル ネットワーク アーキテクチャによって効率的に操作できる数値形式でテキスト データを処理できるようにします。単語の埋め込みはトレーニング プロセス中に学習され、同様の意味を持つ単語は同様のベクトル表現を持つ傾向があり、モデルが意味関係とコンテキストをキャプチャできるようになります。

注意メカニズム: トランスフォーマーの心臓部

アテンション メカニズムは、トランスフォーマーを従来のニューラル ネットワーク アーキテクチャから区別する重要な革新です。これにより、モデルは出力を生成するときに入力シーケンスの関連部分に選択的に焦点を当てることができ、長距離の依存関係とコンテキストを効果的にキャプチャできます。の 注意メカニズム は、特定の出力要素に対する各入力要素の重要性を表すアテンション スコアを計算し、これらのスコアを使用して対応する入力表現に重みを付けることによって機能します。このメカニズムにより、トランスフォーマーはさまざまな長さのシーケンスを効果的に処理し、入力内の離れた要素間の関係をキャプチャできるようになります。これは、機械翻訳や言語生成などのタスクにとって重要です。

多層パーセプトロン: ベクトル表現の強化

注目の機構に加え、トランスも搭載 多層パーセプトロン (MLP)、フィードフォワード ニューラル ネットワークです。これらの MLP は、アテンション メカニズムによって生成されたベクトル表現をさらに処理および洗練するために使用され、モデルがデータ内のより複雑なパターンと関係をキャプチャできるようにします。 MLP はアテンション メカニズムの出力を入力として受け取り、一連の線形変換と非線形活性化関数を適用してベクトル表現を強化します。このステップは、下流のタスクに役立つ高レベルの特徴と表現をモデルが学習するために重要です。

GPT モデルのトレーニング

GPT モデルのトレーニングは、いくつかの重要なコンポーネントとテクニックを含む、複雑で計算量の多いプロセスです。

バックプロパゲーション: GPT をよりスマートにするアルゴリズム

GPT モデルのトレーニングの中核となるのはバックプロパゲーション アルゴリズムです。これは、トレーニング中に発生したエラーに基づいてモデルの重みとパラメーターを更新するための深層学習で広く使用されている手法です。その間 誤差逆伝播法、モデルの予測がグランド トゥルース ラベルと比較され、誤差がネットワークを通じて逆方向に伝播されて重みが調整され、全体的な誤差が最小限に抑えられます。このプロセスには、モデルのパラメーターに関する損失関数の勾配を計算し、損失を最小化する方向にパラメーターを更新することが含まれます。バックプロパゲーションは、モデルが間違いから学習し、徐々にパフォーマンスを向上させることができるため、トレーニング プロセスの重要なコンポーネントです。

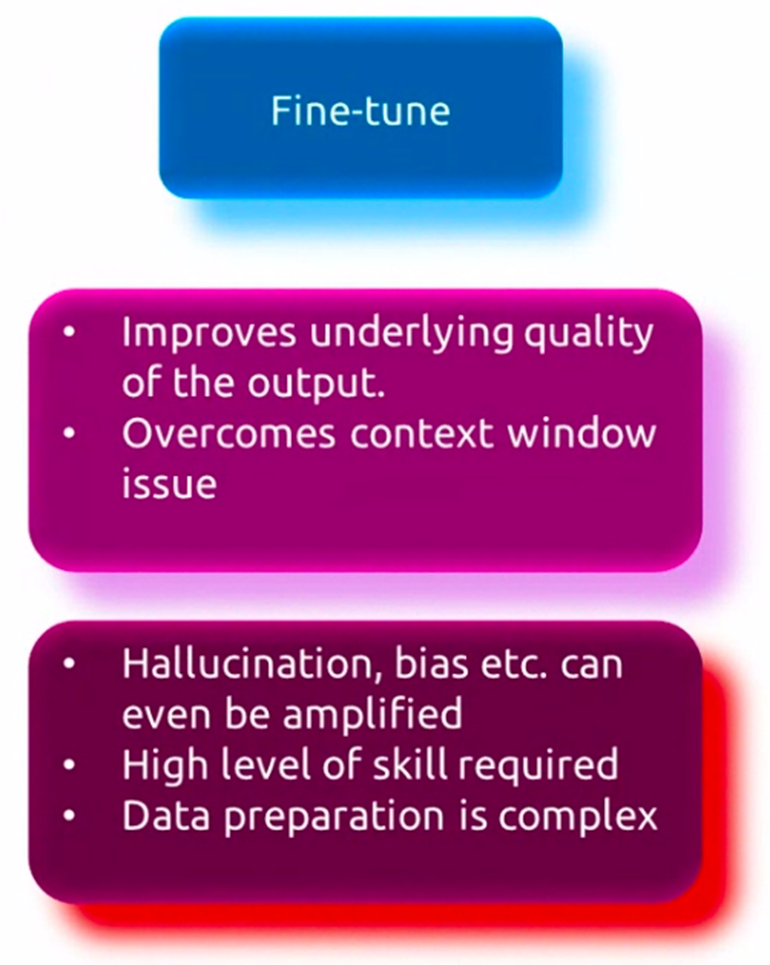

監視付き微調整

GPT モデルは、言語を幅広く理解するために大規模なデータセットで事前トレーニングされていますが、多くの場合、特定のアプリケーションで適切に実行するには、タスク固有のデータで微調整する必要があります。教師あり微調整として知られるこのプロセスには、質問応答、テキスト要約、機械翻訳などのターゲット タスクに関連する小規模なデータセットで、事前トレーニングされたモデルをさらにトレーニングすることが含まれます。その間 微調整、モデルの重みは、事前トレーニング中に取得した一般的な言語知識を保持しながら、当面のタスクに特有のパターンとニュアンスをよりよく捕捉するように調整されます。この微調整プロセスにより、モデルがターゲット タスクの特定の要件に特化して適応できるようになり、パフォーマンスが向上します。

教師なしの事前トレーニング

微調整の前に、GPT モデルは初期の教師なし事前トレーニング段階を経て、書籍、記事、Web サイトなどのさまざまなソースからの膨大な量のテキスト データにさらされます。このフェーズでは、モデルはシーケンス内の次の単語またはトークンを予測することによって、データ内の基礎となるパターンと関係を捕捉する方法を学習します。このプロセスは言語モデリングとして知られています。この教師なしの事前トレーニングにより、モデルは構文、セマンティクス、コンテキストなどの言語を幅広く理解できるようになります。このモデルは、テキスト データの膨大なコーパスでトレーニングされ、さまざまなトピック、スタイル、ドメインから学習できるようになります。この教師なし事前トレーニング フェーズは、計算量が多くなりますが、特定のタスクで後続の微調整を行うための強力な基盤をモデルに提供するため、非常に重要です。

GPT のアプリケーションとユースケース

GPT モデルは優れた多用途性を示しており、幅広い NLP タスクやアプリケーションに適用されています。これらの強力な言語モデルの主な使用例をいくつか見てみましょう。

言語の壁を打ち破る

GPT モデルの最も初期かつ最も顕著な応用例の 1 つは、機械翻訳の分野です。 GPT モデルは、人間のようなテキストを理解して生成する能力を活用して、異なる言語間で高精度かつ流暢に翻訳するようにトレーニングできます。これらのモデルは言語のニュアンスや複雑さを捉えることができ、正確なだけでなく、元のテキストの意図された意味や文脈を維持した翻訳を生成することができます。

テキストの要約

利用可能なテキスト データの量が増え続けるにつれて、 まとめる 長い文書や記事を簡潔で意味のある要約にまとめることの重要性がますます高まっています。 GPT モデルは、特定のテキストのコンテキストと重要なポイントを分析して理解して、元のコンテンツの本質を捉えた要約を生成できるため、このタスクに効果的であることが証明されています。このアプリケーションには、ニュース記事や研究論文の要約から、簡潔なレポートや要旨の作成まで、数多くの使用例があります。

チャットボットと会話型 AI

GPT モデルの最も顕著で広く採用されているアプリケーションの 1 つは、チャットボットやチャットボットの開発です。 会話型AI システム。これらのモデルは人間のような対話を行い、自然かつ状況に応じて適切な方法でユーザーのクエリや入力を理解し、応答することができます。 GPT を利用したチャットボットは、カスタマー サービス、電子商取引、ヘルスケアなどのさまざまな業界で、パーソナライズされた効率的な支援をユーザーに提供するために使用されています。

GPT の想像力豊かな可能性

GPT モデルは当初、言語の理解と生成タスクのために設計されましたが、一貫性のある想像力豊かなテキストを生成する能力により、クリエイティブ ライティングの領域に新たな可能性が開かれました。これらのモデルは、物語、詩、台本、さらには歌詞を生成するために微調整でき、作家やアーティストが新しい創造的な道を探求するための強力なツールを提供します。さらに、GPT モデルは、プロットの展開や登場人物の説明を提案したり、プロンプトや概要に基づいてパッセージ全体を生成したりすることで、執筆プロセスを支援できます。

GPT と生成 AI の未来

GPT モデルは有望ですが、克服すべき限界と課題、そして対処すべき倫理的考慮事項がまだあります。さらに、生成 AI の分野は急速に進化しており、新しいトレンドと最先端の研究がこれらのモデルの将来を形作っています。

現在の GPT モデルの制限と課題

優れた機能にもかかわらず、現在の GPT モデルには一定の制限があります。主な課題の 1 つは、生成されたテキストの根底にある意味とコンテキストを真に理解できないことです。一貫性のある流暢なテキストを作成できますが、特に複雑なトピックや専門的なトピックを扱う場合には、意味のない情報や事実に誤りのある情報が生成される場合があります。さらに、これらのモデルはトレーニング データにバイアスが存在する可能性があり、公平性や潜在的に有害な出力に関する懸念が生じます。

倫理的配慮と責任ある AI 開発

GPT モデルがより強力で普及するにつれて、倫理的考慮事項に対処し、これらのテクノロジーの責任ある開発と導入を確実にすることが重要です。プライバシー、セキュリティ、悪用や悪意のあるアプリケーションの可能性などの問題を慎重に検討する必要があります。研究者と開発者は、潜在的なリスクを軽減し、GPT モデルの安全かつ有益な使用を確保するために、倫理ガイドライン、ガバナンス フレームワーク、および堅牢な保護手段の開発に取り組む必要があります。

新しいトレンドと最先端の研究

生成 AI の分野は急速に進化しており、研究者は新しいアーキテクチャ、トレーニング方法、アプリケーションを模索しています。新しいトレンドの 1 つは、 マルチモーダルモデル さまざまなモダリティ (テキスト、画像、音声など) にわたってデータを処理および生成できます。言語生成のための強化学習アプローチもまた 1 つです。 GPT モデルと他の AI テクノロジーの統合 コンピュータビジョン & ロボット工学 はさらに別の傾向です。さらに、これらのモデルの解釈可能性、制御可能性、堅牢性を改善するための研究が行われています。研究者たちは、科学的発見、教育、ヘルスケアなどの分野でもその可能性を模索しています。

まとめ

GPT モデルは NLP の分野に革命をもたらしました。彼らは、言語翻訳、テキストの要約、会話型 AI、クリエイティブ ライティングなどのタスクで優れた能力を発揮しています。これらのモデルの中核となるのはトランス アーキテクチャです。これは、テキスト データ内の長距離の依存関係とコンテキストをキャプチャするための新しいアテンション メカニズムを採用しています。 GPT モデルのトレーニングには、大規模なデータセットに対する教師なしの事前トレーニングと、それに続く特定のタスクに対する教師ありの微調整という複雑なプロセスが含まれます。

GPT モデルは目覚ましい結果を達成しましたが、克服すべき限界と課題がまだあります。これには、真の理解の欠如、潜在的な偏見、倫理的懸念が含まれます。さらに、生成 AI の分野は急速に進化しており、研究者はこれらのモデルの限界を押し上げるための新しいアーキテクチャ、アプリケーション、および技術を模索しています。

GPT モデルが進化し続けるにつれて、倫理的考慮事項に対処し、責任ある AI 実践を開発することが重要です。これらの強力なモデルの可能性を最大限に活用するには、新たなトレンドや最先端の研究を調査することも重要です。一方で、潜在的なリスクを軽減することで、それらの安全かつ有益な使用を確保する必要があります。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/