最近の TechSpotの記事 Apple が、おそらく iOS 18 および A17 Pro で、ある種の生成 AI のリリースに向けて慎重に動いていることを示唆しています。これは、私のような Apple ユーザーだけでなく、生成 AI の実際のモバイルの機会をより広範に検証する上でも興味深いものです。正直なところ、さまざまな理由から、これは当然のこととは思えませんでした。 XNUMX 億以上のパラメーターでベースラインを設定しているモデルでは、パフォーマンスとメモリ需要の間のバランスを見つけるのは困難に見えます。電力消費が問題になるでしょうか?次に、法律と幻覚の問題がありますが、これらは慎重に限定された使用モデルを通じて管理できる可能性があります。明らかな課題にもかかわらず、製品のリリースについて他の企業よりも慎重になる傾向にあるこの企業が、成功への可能性のある道を見出していることは心強いことだと思います。彼らができるなら、他の人もできるはずです。 最近のブログ 私にとって啓発的なExpederaから。

ジェネレーティブ イメージの作成についての簡単な要約

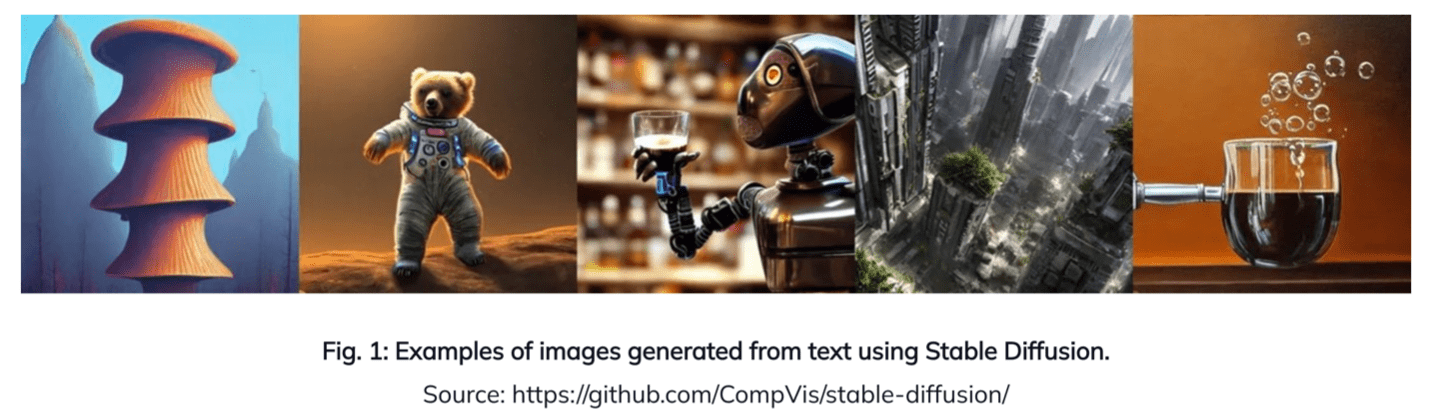

生成イメージング AI は、その可能性が模索され始めたばかりの分野です。私たちはすでに Zoom/Google Meet 通話の背景を変更することに慣れていますが、生成 AI はこれをさらに進化させます。今では、想像上の環境で、さまざまな特徴を備えたさまざまな衣装を着て自分自身を再イメージできるようになりました。イメージに敏感な消費者にとっては巨大な市場です。より現実的には、衣服を購入する前に、またはキッチンやバスルームを改造するときにオプションを検討する前に、仮想的に試着できるようにする必要があります。このテクノロジーはすでにクラウド (Bing Image Creator など) で利用可能ですが、クラウドベースのサービスには、特にプライバシーとコストの面であらゆる欠点があります。ほとんどの消費者は、モバイル デバイスを通じてそのようなサービスと対話することを望んでいます。より良い解決策は、これらのプラットフォームにローカル AI を組み込むことです。オープンソースの安定拡散モデルによる生成 AI は、このニーズを満たすハードウェア プラットフォームの優れた代替手段であり、より一般的には同様のコア テクノロジーに基づく LLM モデルの代替手段となります。

オンボードのメモリとパフォーマンスのバランスをエッジで確保できますか?

まず、安定拡散パイプラインを理解する必要があります。これは、プロンプト (「緑のゼリーの海の上に逆さまに浮かぶ海賊船が見たいです」) を処理するテキスト エンコーダーから始まります。このステップの後に、アルゴリズムの拡散部分を処理するノイズ除去ニューラル ネットワークが続き、複数回の反復を通じて、トレーニングされたパラメーターから最終画像の情報を作成します。私はこれを、プロンプトの要件と、プロンプトに一致する合成を作成するためのトレーニングとの間のマッチングである、従来の画像認識の一種の逆であると考えています。最後に、デコーダ ステージで、前のステップで構築されたデータから画像をレンダリングします。これらの各ステージはトランス モデルです。

Expedera ブログの著者である Pat Donnelly (ソリューション アーキテクト) が、アルゴリズム全体で必要なパラメータ、操作、およびデータ移動の詳細を説明していますが、ここでは再現しません。私にとって目立ったのは、膨大な数のデータの移動です。しかし、彼は、最適なスループットではなく、顧客との要件に基づいて、作業メモリを 8MB のみと想定しています。このことについて彼に尋ねたところ、このアクティビティの大部分を管理する操作は明らかに DDR インターフェイスに依存するだろうと彼は言いました。

これは、私が聞いたある学派からの転換です。つまり、モデルの実行では、パフォーマンス要件を満たすためにすべてをローカル メモリに保持する必要があるというものです。しかし、それには不当に大きなオンボード SRAM が必要になります。 DRAM は容量を処理するのに理にかなっていますが、別の考え方では、モバイル デバイスにそれほど多くの DRAM を搭載したい人はいないでしょう。それは高価すぎるでしょう。また、遅くて電力を消費します。

DRAM またはその他の種類のオフチップ メモリの方が合理的ですが、コストの問題はどうでしょうか? Apple に関する上記のリファレンスを参照してください。どうやら彼らはフラッシュメモリを検討しているかもしれないので、おそらくこのアプローチはそれほどワイルドではないかもしれません。パフォーマンスについてはどうですか?パット氏によると、Stable Diffusion 1.5 では、8 MB の内部メモリを搭載し、7 MHz で 750 GBps の外部メモリ帯域幅で動作する 12K MAC エンジンを想定すると、デノイザーでは 9.24 イメージ/秒、デノイザーでは 3.29 イメージ/秒を処理できるとのことです。デコーダネットワーク。これは消費者向けの非常に立派なパフォーマンスです。電力は非常に多くの要因に依存するため、特定するのは常に困難ですが、私が見た数字によれば、これは予想される民生用モデルにも問題ないはずです。

非常に有益な洞察です。エッジ用の大型トランス AI はオフチップ メモリに依存できないという理論は廃止する必要があるようです。もう一度 Expedera のブログを読むことができます こちら.

この投稿を共有する:

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://semiwiki.com/artificial-intelligence/341410-expedera-proposes-stable-diffusion-as-benchmark-for-edge-hardware-for-ai/