SEO に関する洞察を得るために何千ものドメインを分析するのは骨の折れる作業です。多くの場合、これには多大な時間とリソースが必要ですが、API テクノロジを使用すると、一括ドメイン チェックを実行するプロセスをよりアクセスしやすく効率的に行うことができます。これにより、競争力のあるニッチ市場を分析し、より良いゲスト ブログの機会を見つけることが容易になります。この記事では、SE Rank の API を使用して、ユーザーが大規模な包括的なドメイン分析をどのように実行できるかについて説明します。これが、ワークフローを大幅に合理化し、SEO プロジェクトのより良い結果をもたらす貴重な洞察にどのように変換されるかがわかります。この API を SEO ルーチンに統合するさまざまな方法についても説明します。

さっそく飛び込みましょう!

TL; DR

複数の Web サイトのドメイン データを取得するには、当社の API、特に 競争調査 & バックリンクチェッカー API。これらの API は、オーガニック トラフィック、キーワード数、ドメイン信頼スコア、参照ドメイン、バックリンクなどの包括的な情報を提供します。さらに良いことに、これらの API を利用するのにコーディングのスキルは必要ありません。

Python でドメイン分析データを取得するには、Google Colab でコードを実行する必要があります。実行すると、結果が Google スプレッドシートに表示されます。各メトリックを個別に表示するには、表に特定の数式を適用します。必要なメトリクスを選択できます。

このデータはすべて、競合分析やニッチ分析を迅速に実施したり、すべてのドメインのバックリンク プロファイルを評価したり、その他のタイプの SEO 分析を実行したりするのに役立ちます。

API の概要: API とは何か、またどのように機能するのか?

SE ランキング チームが作成した いくつかの API。これらは、大規模なドメイン データ分析とその他の SEO タスクの両方の作業を簡素化するように設計されています。 SE ランキング プラットフォームに手動でログインしなくても、生データを取得できるようになりました。これは、大量のデータとアカウントを管理する企業にとって理想的です (つまり、 SEO代理店).

この API は、 ビジネスサブスクリプション のみ。

SE ランキングでドメインを一括分析するには、次の 2 つの API を使用します。 競争調査 & バックリンクチェッカー.

競合他社調査API は、トラフィック、キーワード、その他の指標を含む、オーガニック検索結果と有料検索結果の両方からドメイン統計情報にアクセスするための便利な形式を提供します。一方、 バックリンクチェッカーAPI バックリンク プロファイル分析の実施に使用できるデータを提供します。これらの API を両方組み合わせると、これらのツールのプラットフォーム バージョンで利用可能なほぼすべての数値メトリクスが提供されます。

利用可能な主要な指標の一部を次に示します。

競合調査API:

- 指定された場所内のドメイン トラフィックの合計

- 指定された場所でドメインがランク付けされるキーワードの数

- 新規取得キーワード数

- SERPから削除されたキーワードの数

- 一貫したランキング順位を獲得したキーワードの数

- 順位が向上したキーワードの数

- 順位が下がったキーワードの数

- 1 ~ 5、6 ~ 10、および 11 ~ 20 位にランク付けされたキーワードの合計数

- もっと見る

バックリンク チェッカー API:

- ドメイン信頼スコア

- URL のバックリンクの総数

- URL の参照ドメインの合計数

- dofollow/nofollow バックリンクの総数

- もっと見る

これは完全なリストではありません。すべてのパラメータは、 バックリンクチェッカーAPI & 競合他社調査API ドキュメント。

API を使用してワークフローを最適化する方法

API を最大限に活用するためにコーディング方法を知る必要はありません。提供された Python コードを実行し、Google スプレッドシートを通じて結果にアクセスするだけです。

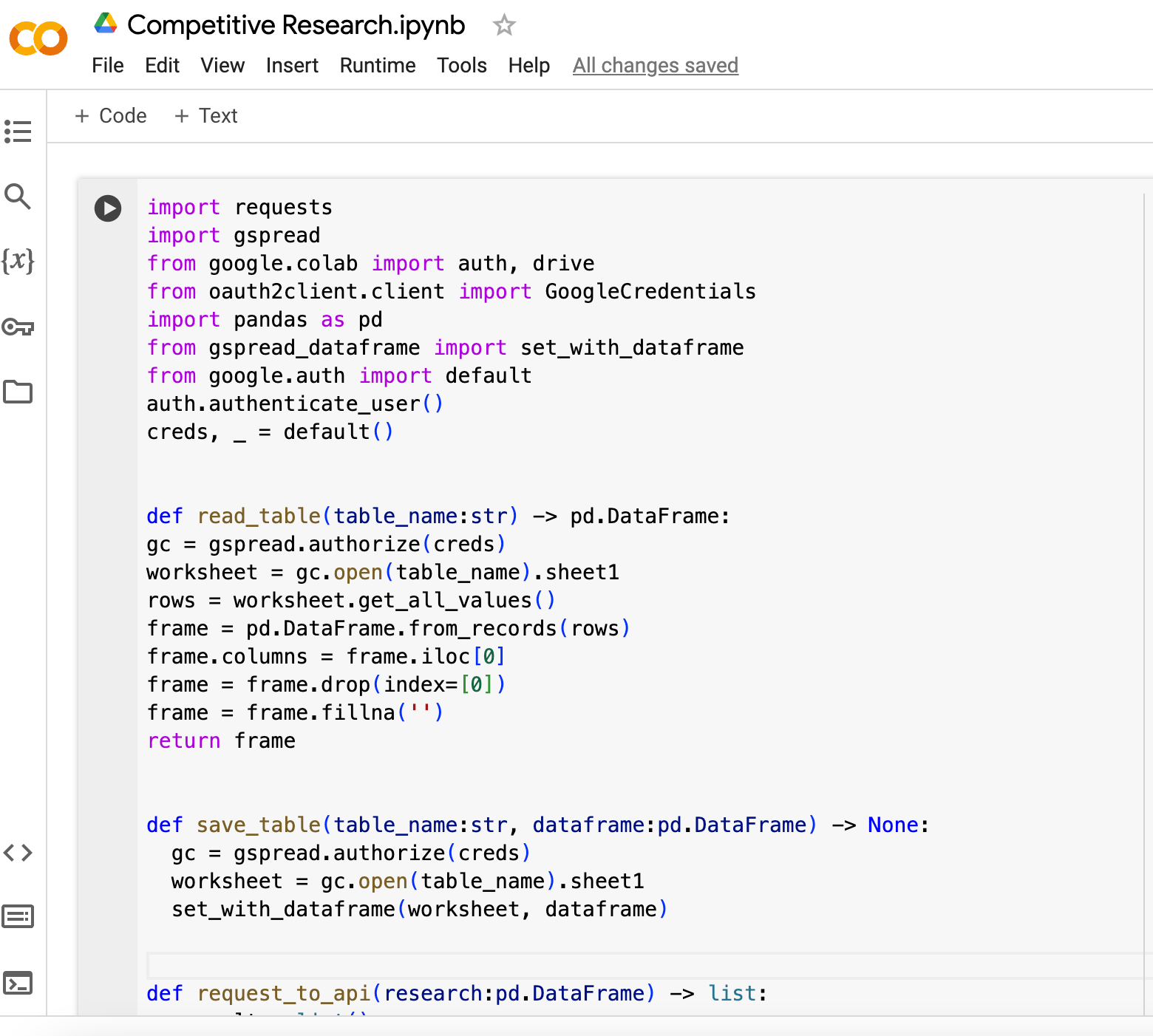

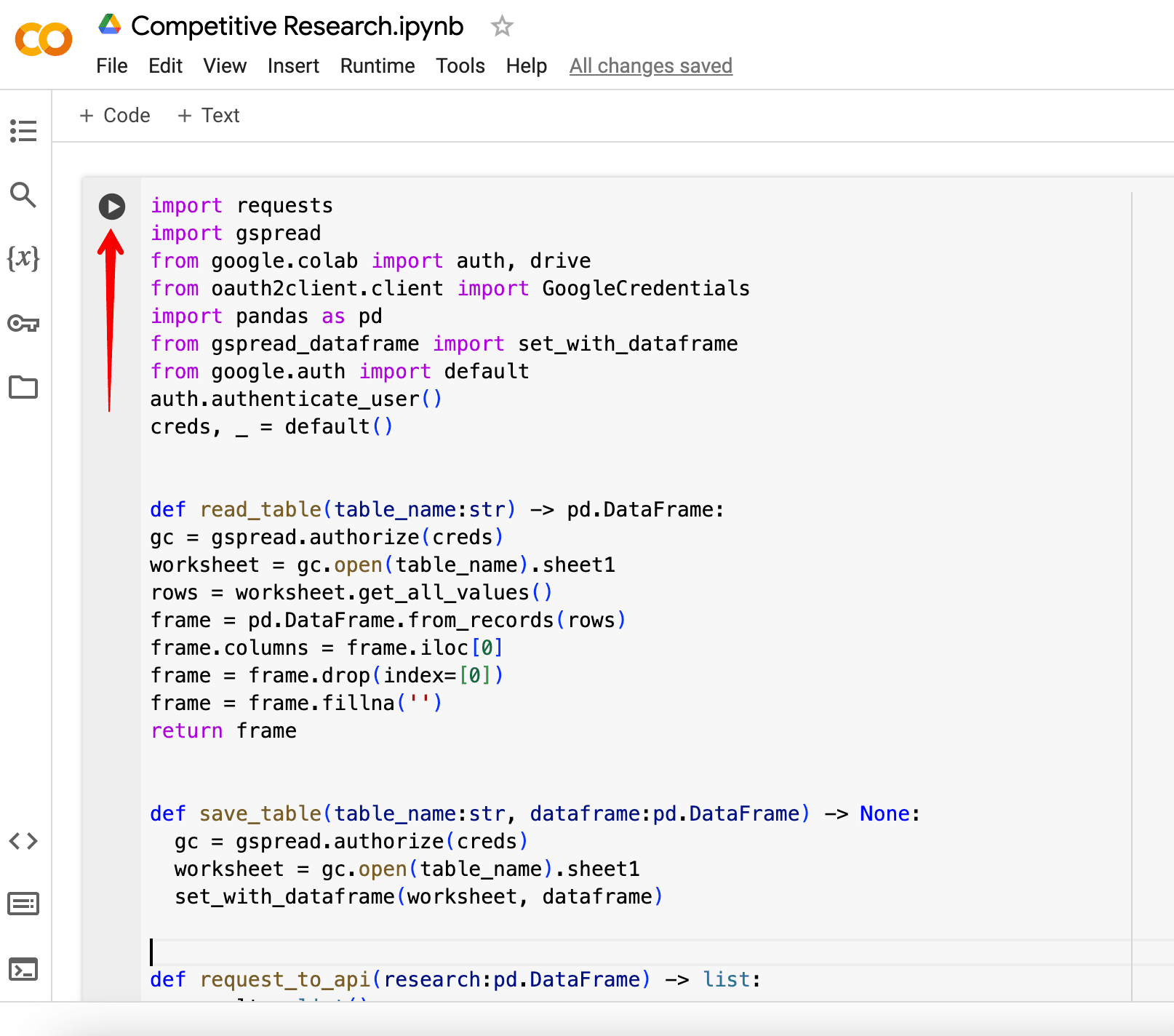

まずは、これから扱うコードを詳しく見てみましょう。

利用可能なコード

次の 2 つのスクリプトのいずれかを使用してドメイン分析を実行できます。

1. [競合調査 + バックリンクチェッカー API]

長所: 2 つのモジュールから一度により多くのデータを取得できます。

短所: バックリンク チェッカー クレジットは引き続き消費されます。処理するデータが大量になるため、コードの動作が遅くなります。

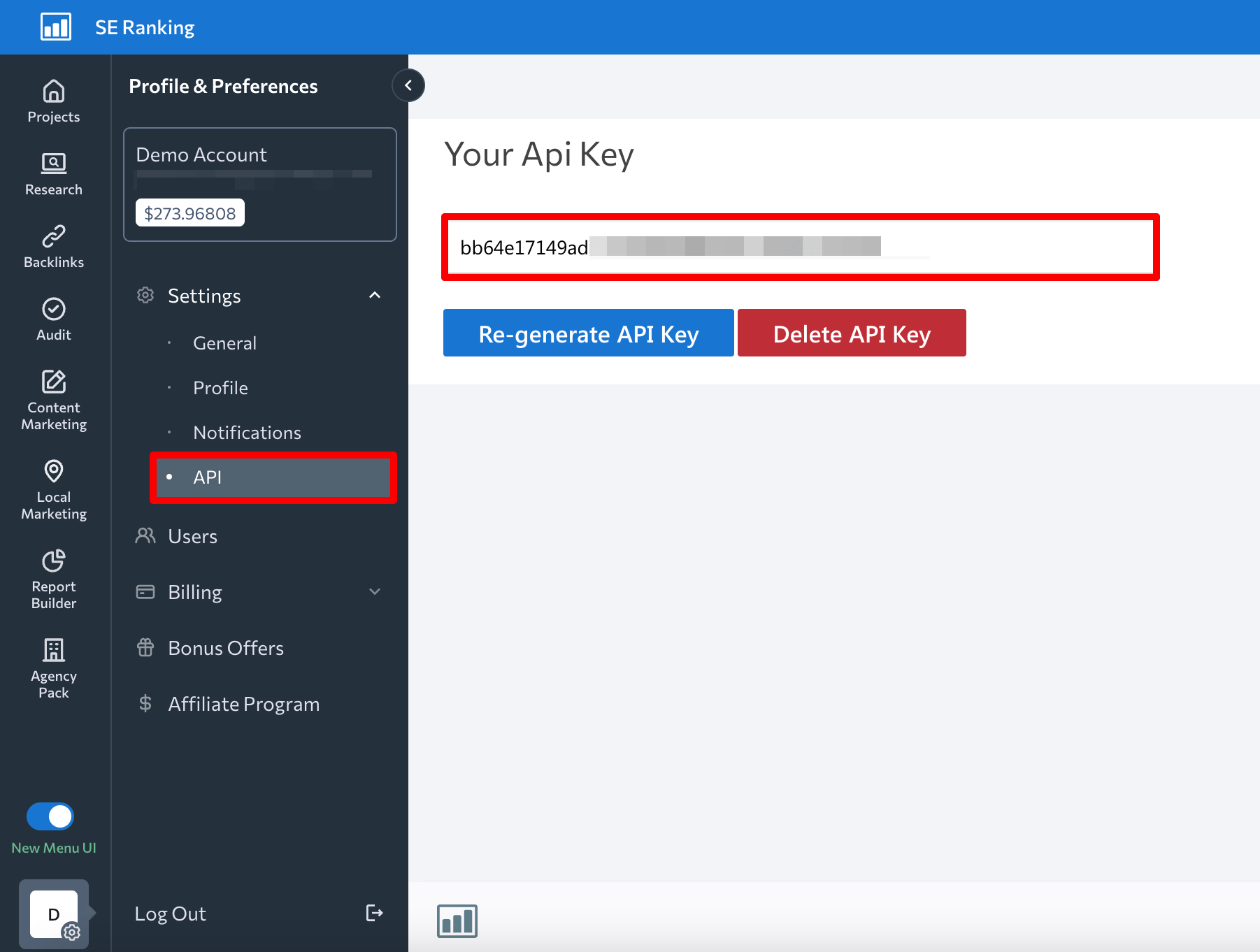

以下のコードをコピーして貼り付ける必要があります。 グーグルコラボ。ただし、API キーを api_key パラメータ。これは、 API SEランキングのセクション 設定.

競合調査 + バックリンク チェッカー API コード:

インポートリクエスト google.colab から gspread をインポート import auth、oauth2client.client からドライブ GoogleCredentials をインポート gspread_dataframe から pd としてパンダをインポート google.auth から set_with_dataframe をインポート デフォルトの auth.authenticate_user() creds、_ =default() def read_table(table_name:str) ) -> pd.DataFrame: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 rows = worksheet.get_all_values() Frame = pd.DataFrame.from_records(rows) Frame.columns = Frame.iloc[ 0] フレーム = フレーム.ドロップ(インデックス=[0]) フレーム = フレーム.フィルナ('') フレーム def を返す save_table(テーブル名:str, データフレーム:pd.DataFrame) -> なし: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 set_with_dataframe(worksheet, dataframe) def request_to_api(research:pd.DataFrame) -> list: result = list() インデックス、research.iterrows() の行:domain = row['ドメイン'] Research_result = get_research_api_result(domain) backlinks_result = get_backlinks_api_result(domain) if (row['backlinks'] == '') else row['backlinks'] result.append([domain, Research_result, backlinks_result]) return result def get_api_headers() -> str:

api_key = 'API キーを追加'

return dict(Authorization=api_key) def get_research_api_result(domain:str) -> str: params = dict(domain=domain) api_url = 'https://api4.seranking.com/research/uk/overview/?' result = request.get(api_url, params=params, headers=get_api_headers()) return result.json() def get_backlinks_api_result(domain:str) -> str: report = create_backlink_checker_report(domain) report_id = str(report.get(' report_id')) api_url = 'https://api4.seranking.com/backlink-reports/' + report_id + '/overview' result =requests.get(api_url, headers=get_api_headers()) delete_backlink_checker_report(report_id) 結果を返します。 json() def create_backlink_checker_report(domain:str) -> str: params = dict(mode='domain', target=domain) api_url = 'https://api4.seranking.com/backlink-reports' result =requests.post (api_url, json=params, headers=get_api_headers()) return result.json() def delete_backlink_checker_report(report_id:str) -> なし: api_url = 'https://api4.seranking.com/backlink-reports/' + report_id request.delete(api_url, headers=get_api_headers()) def main(): table_name = '競合調査 API' table = read_table(table_name) result_table_requests_to_api = request_to_api(table) result_table_to_dataframe = pd.DataFrame(result_table_requests_to_api, columns=['ドメイン', '結果', 'バックリンク']) save_table(table_name, result_table_to_dataframe) main()

2. 【競合調査API】

長所: スクリプトはより高速に動作し、クレジットを使い果たすことがありません。

短所: 取得するデータが少なくなり、ドメインの信頼性 (ドメイン権限)、バックリンクの数、参照ドメインなどに関する情報を取得できなくなります。

競合調査コード:

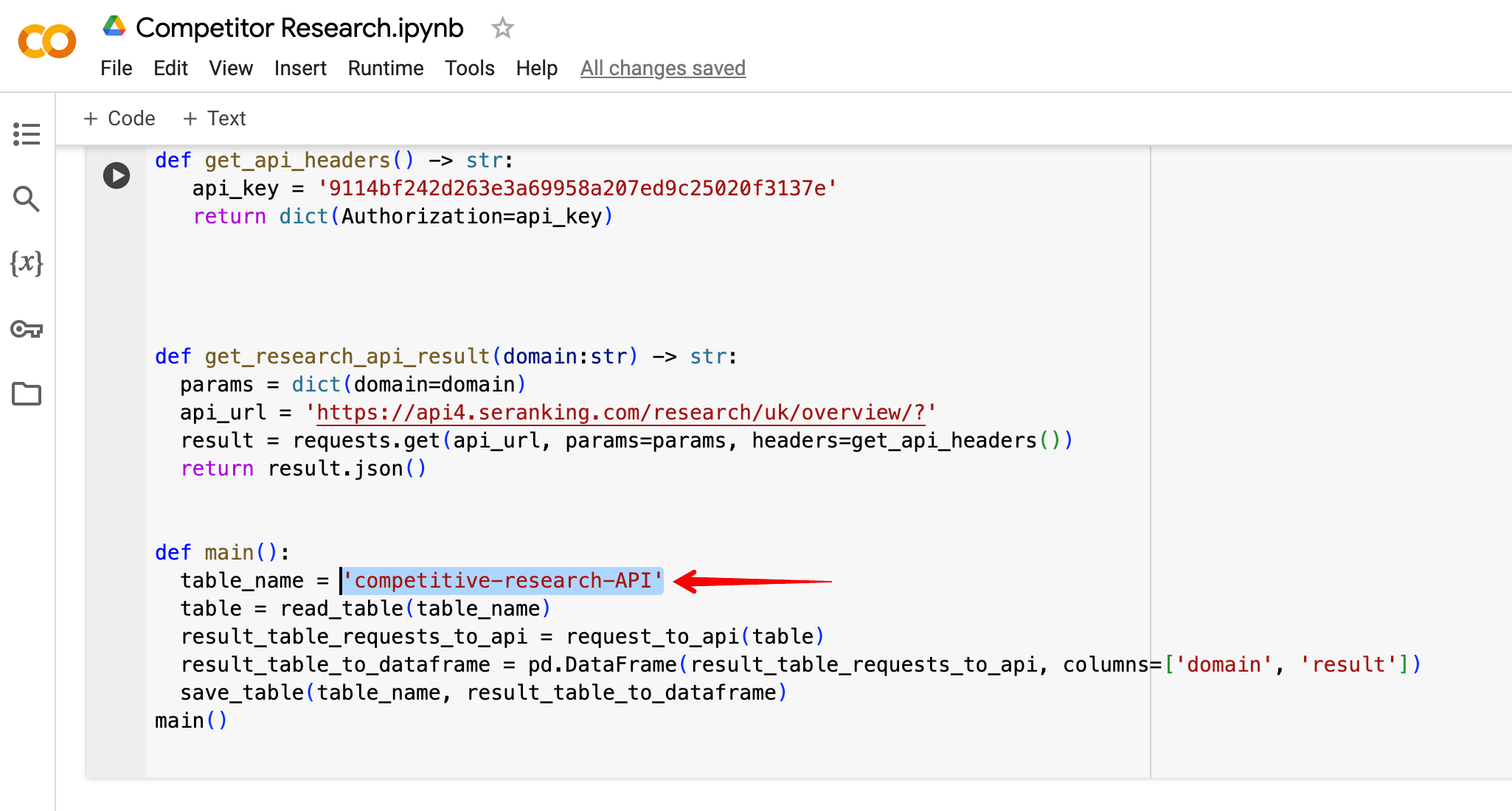

API キーを忘れずに入力してください。 api_key パラメータに一致する最初のデバイスのリモートコントロール URL を返します。

インポートリクエスト google.colab から gspread をインポート import auth、oauth2client.client からドライブ GoogleCredentials をインポート gspread_dataframe から pd としてパンダをインポート google.auth から set_with_dataframe をインポート デフォルトの auth.authenticate_user() creds、_ =default() def read_table(table_name:str) ) -> pd.DataFrame: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 rows = worksheet.get_all_values() Frame = pd.DataFrame.from_records(rows) Frame.columns = Frame.iloc[ 0] フレーム = フレーム.ドロップ(インデックス=[0]) フレーム = フレーム.フィルナ('') フレーム def を返す save_table(テーブル名:str, データフレーム:pd.DataFrame) -> なし: gc = gspread.authorize(creds) worksheet = gc.open(table_name).sheet1 set_with_dataframe(worksheet, dataframe) def request_to_api(research:pd.DataFrame) -> list: result = list() インデックス、research.iterrows() の行:domain = row['ドメイン'] Research_result = get_research_api_result(domain) result.append([domain, Research_result]) 結果を返します def get_api_headers() -> str:

api_key = 'API キーを追加'

return dict(Authorization=api_key) def get_research_api_result(domain:str) -> str: params = dict(domain=domain) api_url = 'https://api4.seranking.com/research/uk/overview/?' result = request.get(api_url, params=params, headers=get_api_headers()) return result.json() def main(): table_name = '競合調査 API' table = read_table(table_name) result_table_requests_to_api = request_to_api(table) result_table_to_dataframe = pd.DataFrame(result_table_requests_to_api, columns=['domain', 'result']) save_table(table_name, result_table_to_dataframe) main()

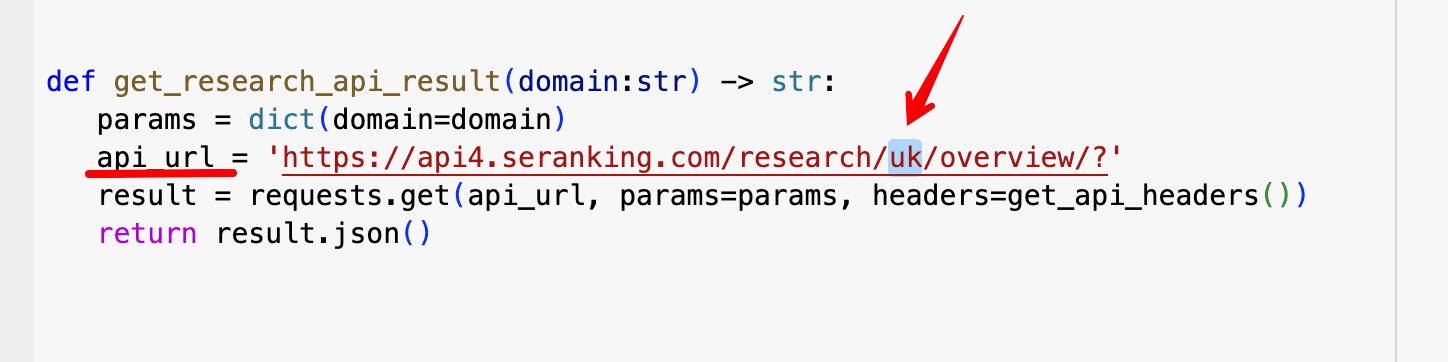

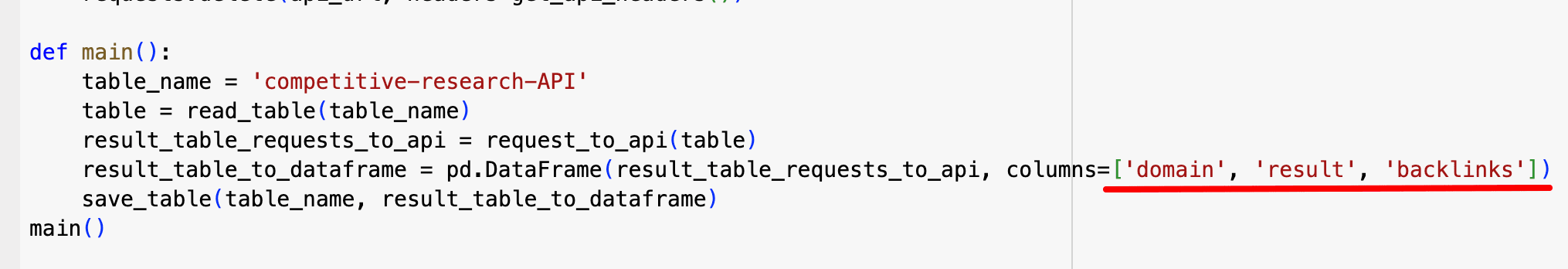

注意すべき重要なパラメータをいくつか示します。

- コード内で API キーがどのように表示されるかは次のとおりです。

- In api_urlでは、トラフィック/キーワード データを取得する場所を変更できます。

- これらは、Google スプレッドシート ファイル内の列です。

それでは、これらのコードを利用するためのステップバイステップのガイドに移りましょう。

それを使用する方法

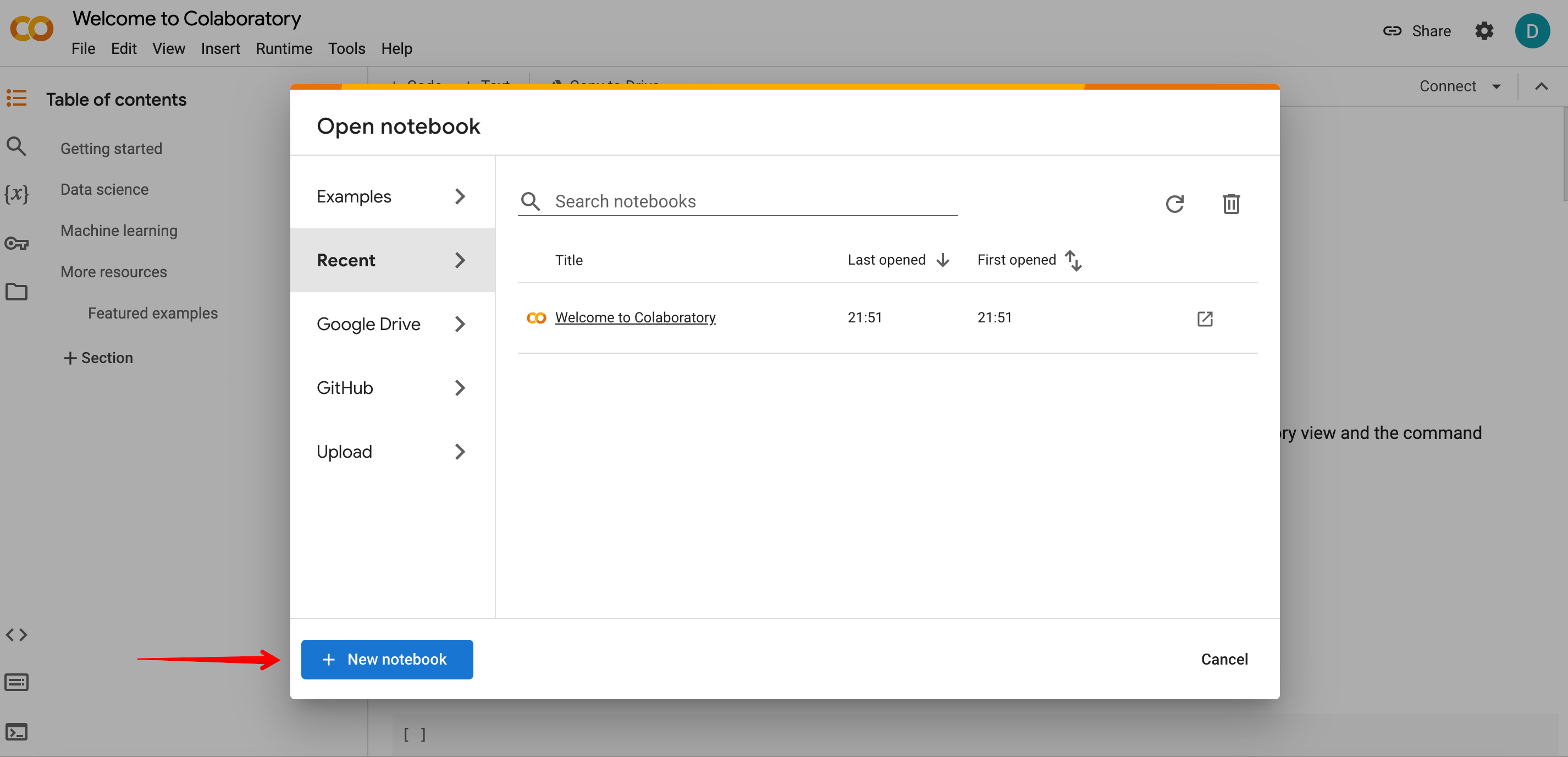

1ステップ。 Open グーグルコラボ、新しいノートブックを作成し、前のセクションで提供された 2 つのコードのいずれかを貼り付けます。

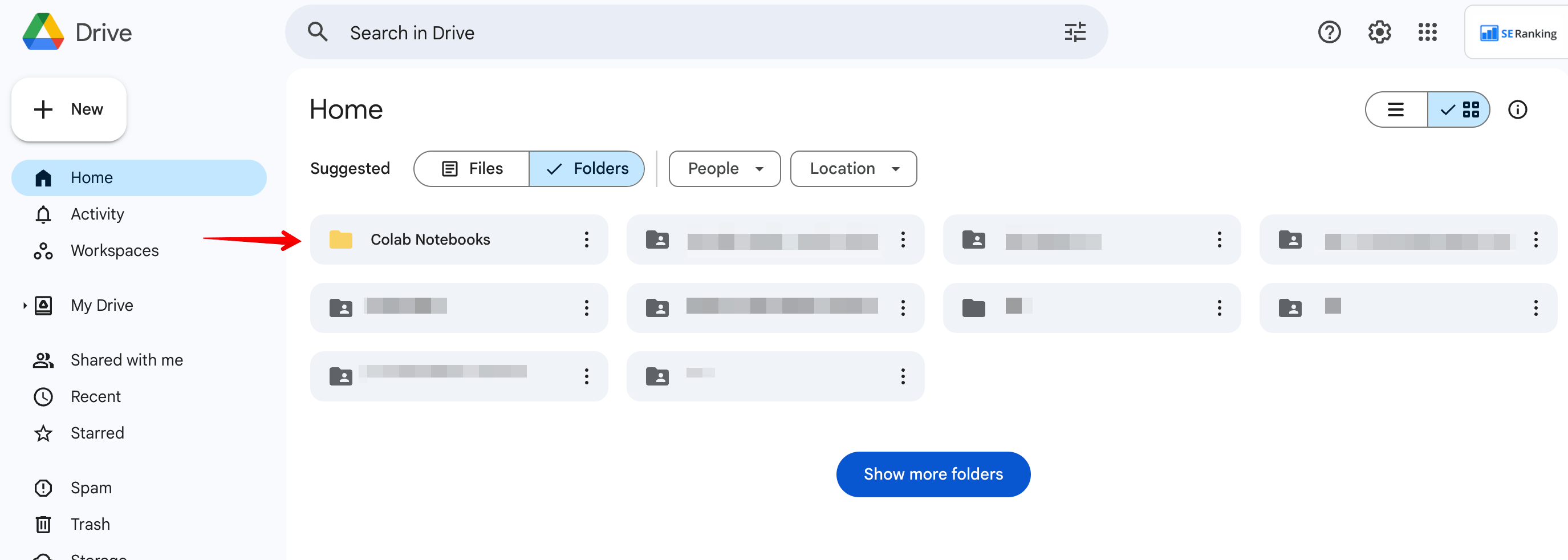

2ステップ。 Video Cloud Studioで コラボノートブック Google ドライブ内のフォルダーを作成し、Google シート ファイルを作成します。

注: ファイル名がファイル名と完全に一致していることを確認してください。 TABLE_NAME 以下の例に示すように、コード内で。

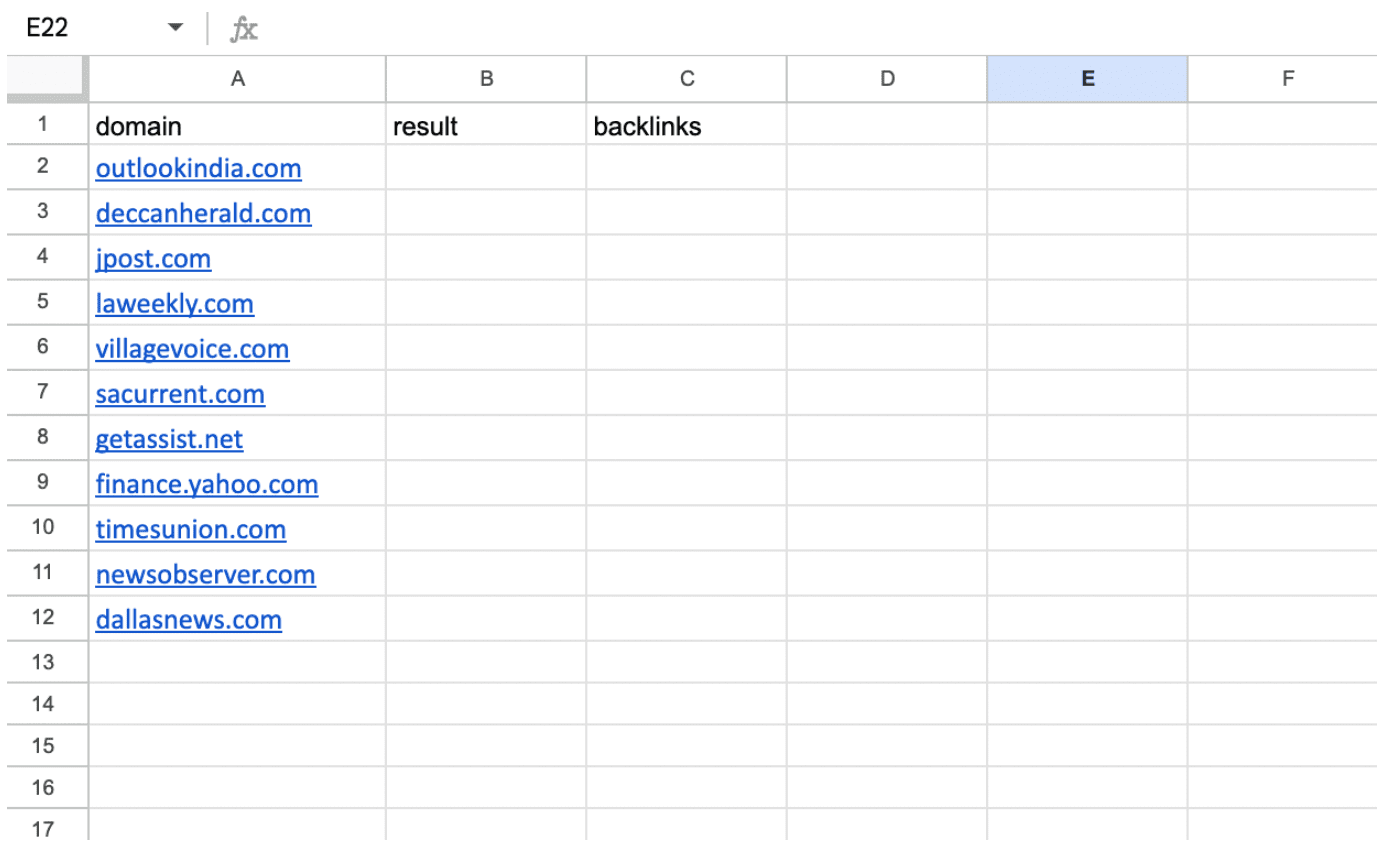

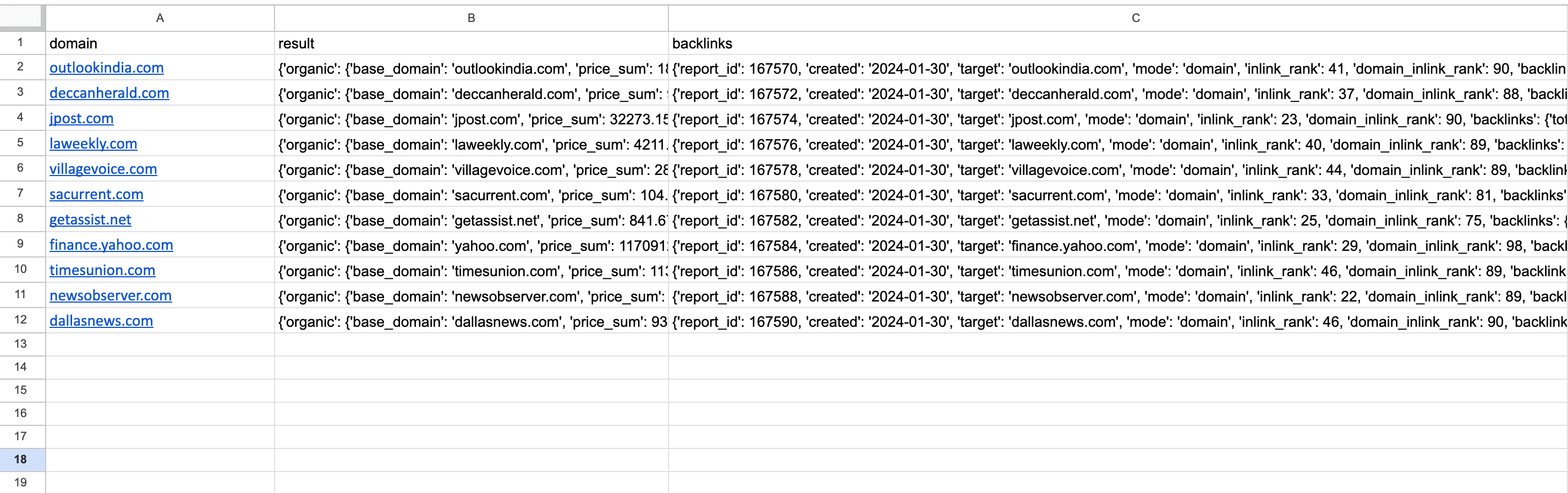

3ステップ。 使用されているスクリプトに基づいて列に名前を割り当てます。を使用する場合は、 競合調査API スクリプトのみを使用し、列 A と B を呼び出す必要があります。 ドメイン & 結果、 敬意を表して。のために 競争調査 & バックリンクチェッカーAPI スクリプトに加えて、 ドメイン & 結果 列の場合は、という 3 番目の列を追加する必要があります。 バックリンク.

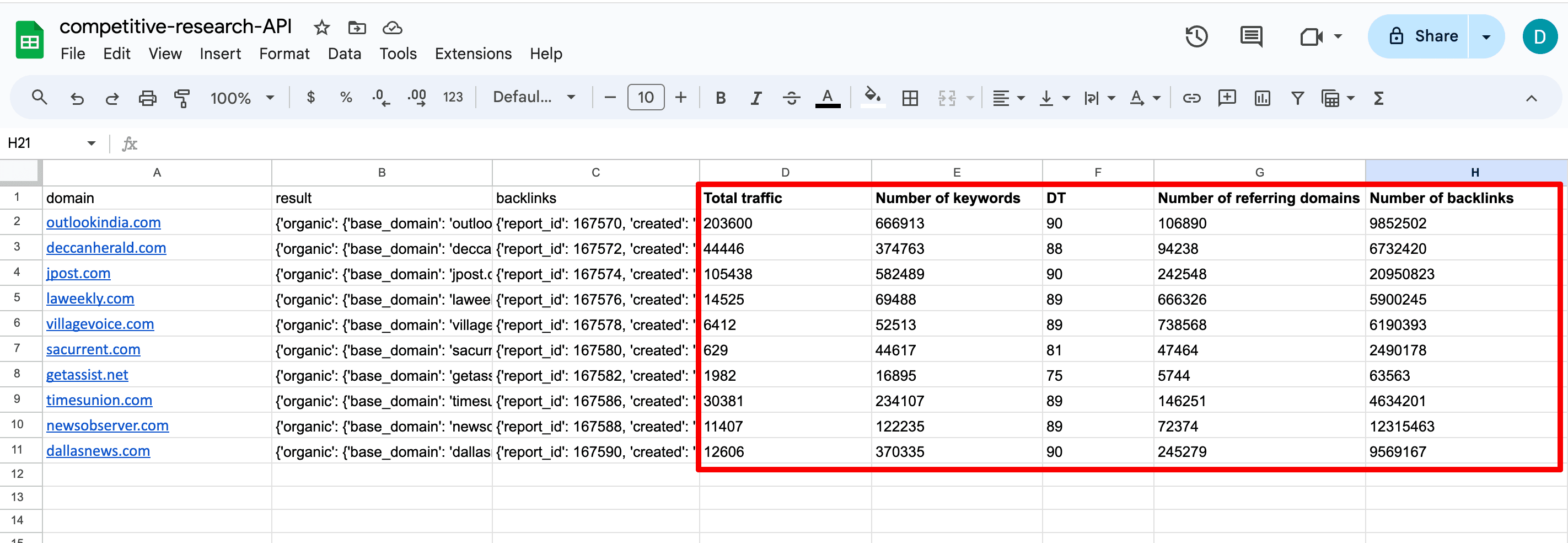

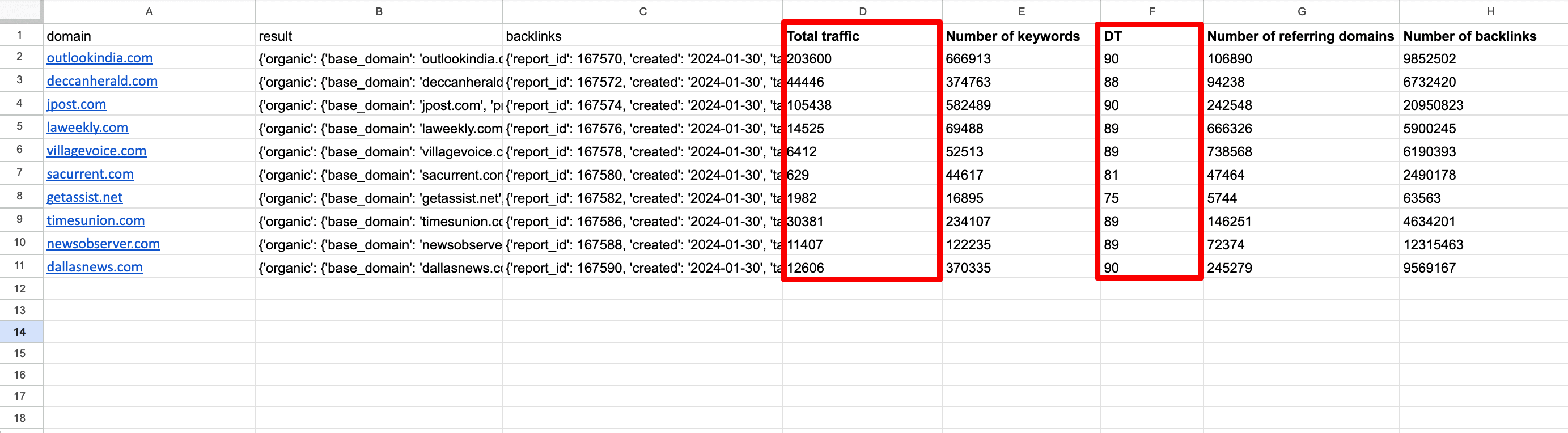

3 つの列を持つ 2 番目のバージョンを示す以下のスクリーンショットを参照してください。

必要に応じて、列の名前を変更し、それに応じてコードを更新できます。

次に、最初の列にドメインを入力します。 http:// & WWW.

ステップ4: Colab に移動し、ボタンをクリックしてコードを実行し、必要に応じてアクセスを許可します。

ステップ5: スクリプトの実行が完了したら、後で Google スプレッドシート ファイルに再度チェックインして結果を取得します。テーブルは次のようになります。

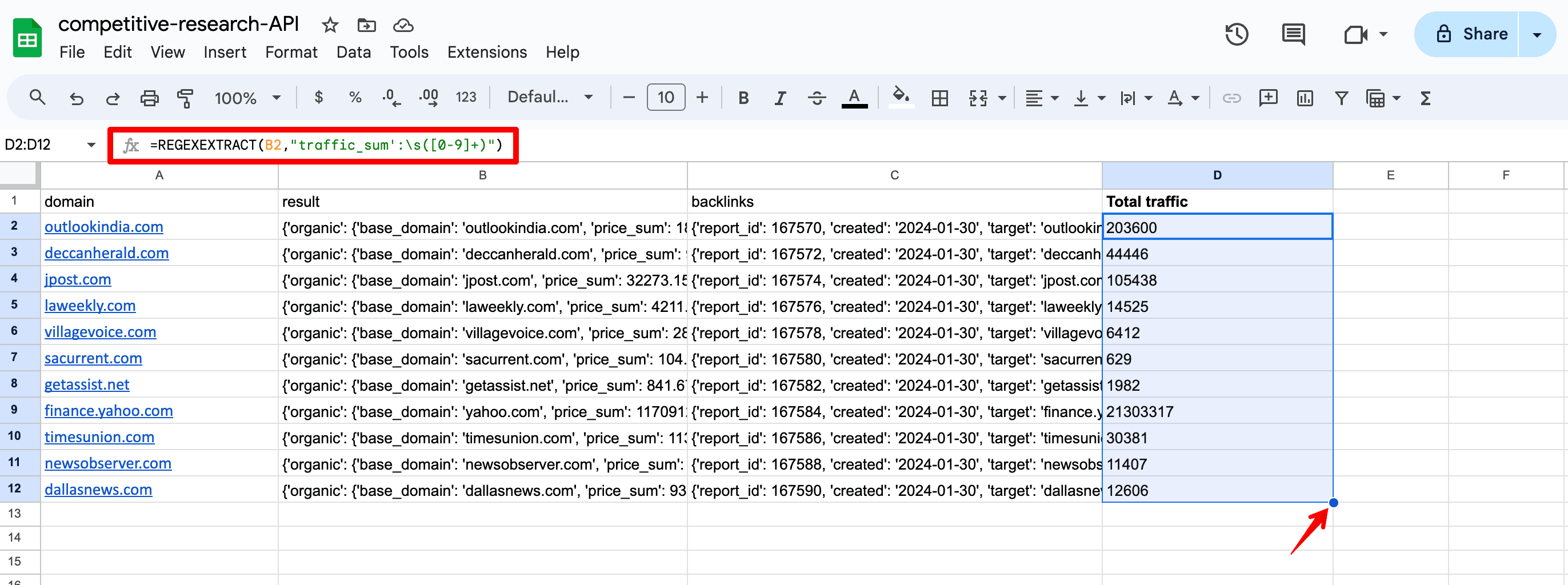

6ステップ。 指定したメトリクスを分離するには、JSON データからメトリクスを抽出します。を入力するだけです =正規表現抽出 機能するか、独自の解決策を考え出します。以下にアクセスするための式を示します。 トラフィック合計 パラメータ。指定された場所のオーガニック トラフィックの合計を表します。

=REGEXEXTRACT(B2,”traffic_sum':s([0-9]+)”)

- B2 JSON データを含む列です (つまり、 結果 カラム)。別の列のデータが必要な場合は、数式で変更できます。

- トラフィック合計 は関心のあるメトリックです。他のデータを取得する場合は、式内のこのパラメーターを変更できます。

- s([0-9]+) は、空白文字の直後に 1 つ以上の数字が続くシーケンスを検索する正規表現です。変更する必要はありません。

7ステップ。 最初のセルに数式を入力したら、それを下にドラッグしてすべてのセルに数式をコピーします。リスト上の各ドメインから必ずデータを取得してください。

重要なドメイン データを取得するために数式で使用できる主要なメトリクスのリストを次に示します。

- キーワード数 — 指定された場所でドメインがランク付けされるキーワードの合計数。

- トップ1_5 — 上位 1 ~ 5 位にランク付けされたキーワードの合計数。

- キーワード_新しい数 — 新しいキーワードの合計数。

- ドメインインリンクランク — ドメイン信頼スコア。

- total_domains — URL の参照ドメインの合計数。

- total_backlinks — URL のバックリンクの合計数。

これらの各メトリクスは、次の URL で JSON 形式で見つけることができます。 バックリンクチェッカーAPI (のために バックリンク コラム)と 競合他社調査API (のために 結果 コラム)書類。

API の使用例を調べる

このデータがどのように役立つか知りたいですか? API から恩恵を受けることができる SEO のいくつかの分野を見てみましょう。

- 競合分析とニッチ分析

オーガニックトラフィック、キーワードの数、バックリンク、ドメインの信頼性などの要素に基づいて、競合他社(またはニッチな分野のドメイン)の強さを評価できます。これは、ニッチ市場の全体的な競争力と、これらの Web サイトと比較した自社の立場を評価するのに役立ちます。

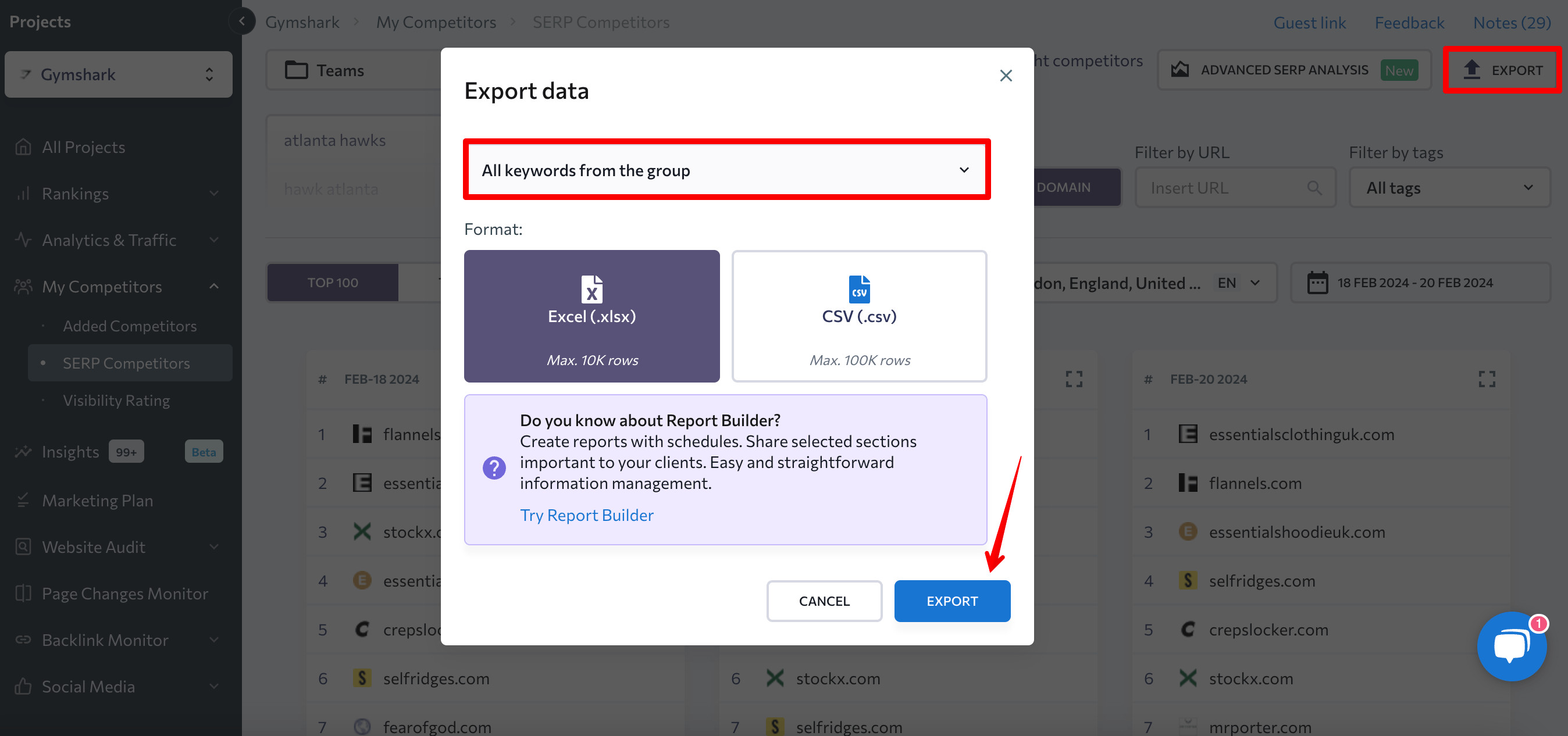

ドメイン リストを拡張し、ニッチ内からさらに多くの Web サイトを見つけるには、ニッチ内のキーワードの SERP 結果を取得できます。 SE ランキングを使用するだけです SERPの競合他社 の下の機能 私の競争相手 タブをクリックしてこの情報を取得します。

方法は次のとおりです。

- ドロップダウン メニューから目的のキーワード グループを選択します (必要なキーワードをすべてプロジェクト内の 1 つのグループに事前に追加していることを確認してください)。

- SERP から必要な結果の数を選択します (100/50/30/20/10)。

- 現在地に最も近い ドメイン モード。

![SE ランキングの SERP 競合他社機能 SE Rank の [My Competitors] タブにある SERP Competitors 機能](https://zephyrnet.com/wp-content/uploads/2024/02/how-to-conduct-bulk-domain-analysis-with-se-rankings-api-13.png)

次に、データをエクスポートします。を選択 グループのすべてのキーワード オプションを使用して、調べたいキーワードの上位 10 ~ 100 位にランク付けされているドメインのリストを取得します。

調査する Web サイトを選択したら、それらを Google スプレッドシート ファイルに追加し、ドメイン SEO 分析を実行します。これらのサイトのオーガニックトラフィック、キーワード数、バックリンク、参照ドメイン、ドメイン信頼スコアを比較します。これにより、ニッチ市場の競争環境に関する貴重な洞察が得られます。

詳細な競合分析を行うには、SE ランキングのような特殊なツールを使用します。 競争調査 & バックリンクチェッカー.

- ゲストブログとデジタル PR

効率化することもできます リンクの建物 潜在的なコラボレーションの機会を得るために、最も関連性の高いドメインを特定して連絡を取ることで、取り組みを強化します。 API を使用して簡単な初期調査を実施すると、さらなるリソースへの投資を開始する前にドメインの品質を評価できます。

たとえば、オーガニック トラフィックとドメイン トラスト スコアを評価して、潜在的なソースを特定して、より深い分析とさらなるコラボレーションの支援を行うことができます。このアプローチでは、サイトの関連性やその他の重要な定性的指標についての洞察は得られませんが、キャンペーンの開始点としては適しています。

包み込む

SE Rank の API 機能は、複数の大規模プロジェクトを同時に管理する企業にとって理想的なソリューションです。巨大なデータセットを分析し、SEO プロセスを自動化するプロセスをスムーズにします。

私たちが提供した API コードとガイドが、一括ドメイン分析作業の簡素化に役立つことを願っています。私たちは、コーディングスキルのない人も含めて、あらゆる人向けに API を設計しました。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://seranking.com/blog/bulk-domain-analysis-using-api/