さらに、これらの AI テクノロジーが、空港、航空機、さまざまな先進モビリティ システムなど、高価値で需要の高いインフラ内の既存のエコシステムにどのように適応し、変革できるかが重要な考慮事項となります。

革新的な AI テクノロジーを活用し、クランフィールド大学のプラットフォームの利点を活用して、 修士課程応用人工知能コース 多様なエンジニアリング領域にわたる応用 AI の将来のリーダーを育成することを目的としています。その主な目的は、世界中の安全性が重要なアプリケーション向けに信頼性の高い AI テクノロジーの開発と展開を迅速化することです。

グループ デザイン プロジェクト (GDP) は問題ベースの学習モジュールであり、GDP の目的は、学生が現実世界の問題を解決するためにリアルタイム AI ベースのシステムを設計、実装、検証、テストすることです。 GDP はまた、学生に共同エンジニアリング プロジェクトに取り組み、潜在的な顧客の要件を満たし、期限を守る経験を提供することも目的としています。

2022 年と 2023 年に、応用人工知能の修士課程に登録した学生は、刺激的で要求の厳しいグループ設計プロジェクトに割り当てられました。目的は、コースワークで得た応用 AI 知識を活用して、革新的で安全な空港製品を開発することでした。学生は XNUMX 人からなる小さなチームで働き、ソフトウェアとハードウェアのアーキテクチャ、AI モデルの開発とテスト、現実世界との関わりの側面を含むソリューションを設計するという任務を負っていました。

プロジェクトのトピックは意図的に幅広く、学生はグループ内で協力して、集合的な専門知識と興味に基づいて興味のある特定の分野を探索し、洗練することが求められました。このアプローチにより、創造性、チームワークが促進され、現実世界のシナリオにおける AI テクノロジーの実践的な応用についてのより深い理解が促進されました。

各グループは、次の機能を実現するスマート空港用のリアルタイム AI ソリューションを開発するように依頼されました。

- このシステムは、人間のユーザーを検出し、正確な姿勢検出と追跡に基づいてその姿勢と行動を推定できなければなりません。

- このシステムは、さまざまな群衆の行動を分類し、その理由、重要性、実現可能性を明確にすることができるものとします。

- AI モデルは、精度、コンピューティング、推論のさまざまな指標を使用して相互検証する必要があります。

- AI モデルは、これらの安全性が重要なアプリケーションにおける現在の AI テクノロジーの長所と短所をリアルタイムで実装できる必要があります。

- このシステムは、堅牢なパフォーマンスを実現するセンサー フュージョンを可能にする入力としてさまざまなセンサー ソースに依存できますが、非常に低コストでありながら効率的なソリューションも歓迎されます。

ケーススタディ 1: 航空機のメンテナンス環境での落下検知。

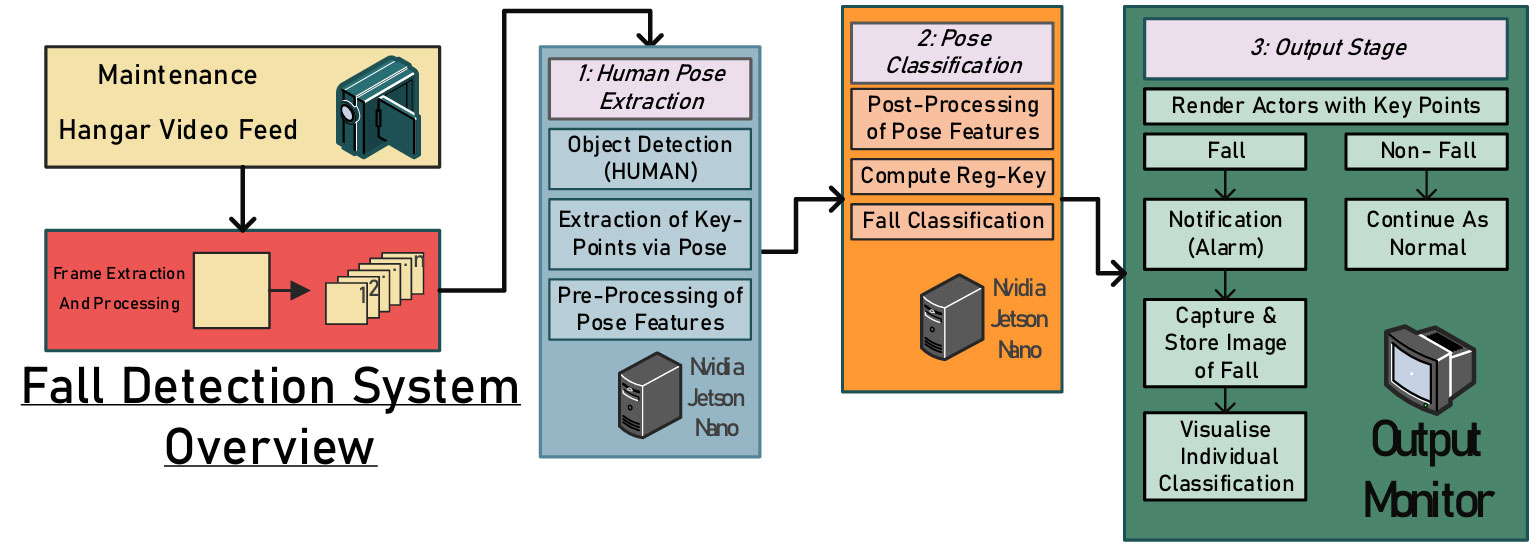

メンテナンス環境は、無人機械、危険エリア近くの不適切なフェンスや物理的警備員、乱雑な作業スペースなど、重大な危険をもたらします。これらのリスクの中でも、転倒による致命傷は驚くほど一般的です。致命的ではないインシデントを迅速に検出して報告することで、さらなる危害や死亡事故を防ぐことができます。したがって、この研究では、航空機のメンテナンス作業中に従業員を監視し、安全性を高め、事故を防止するための統合ビジョンベースのシステムを提案します (下図を参照)。

.fusion-gallery-1 .fusion-gallery-image {border:0px Solid #e2e2e2;}

設計されたモデルの初期トレーニングと検証結果から、既製の空港格納庫メンテナンス データセットが明らかに欠如していることは、対象者に近接して撮影された垂直カメラ アングルから撮影されたビデオからの画像に偏りがある可能性を示しています。クランフィールドの利点を活用して、このプロジェクトではクランフィールド大学のメンテナンス格納庫が選択され、データ収集に使用されました。

合計で約 50 本の短い (XNUMX ~ XNUMX 分) の短いビデオ (XNUMX ~ XNUMX 分) が録画され、転倒のあるものもあれば転倒のないものもありました。キャプチャされたビデオはフレームに分割され、MoveNet 姿勢推定ソフトウェア ライブラリを使用して注釈が付けられ、被験者の主要な関節位置のベクトル マップが生成されました。以下の図は、実験データのスナップショットをいくつか示しています。

.fusion-gallery-2 .fusion-gallery-image {border:0px Solid #e2e2e2;}

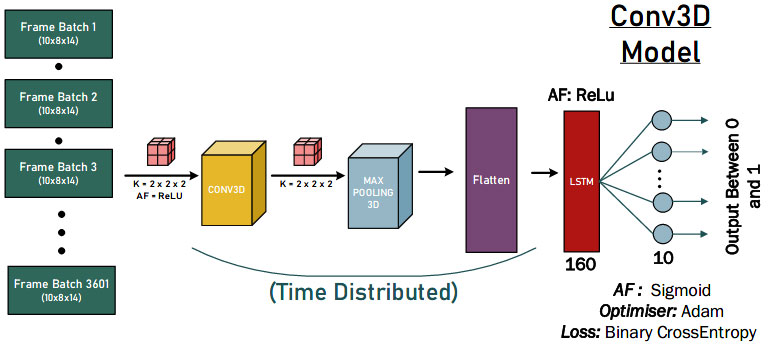

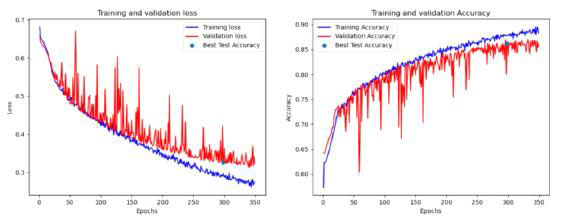

私たちの学生は、最も強力な AI モデルの設計を定量的に評価するために、1 次元、2 次元、および 3 次元の畳み込みニューラル ネットワークのアプローチをテストしました。以下の図は、3 次元畳み込みソリューションのデモンストレーションです。

.fusion-gallery-3 .fusion-gallery-image {border:0px Solid #e2e2e2;}

最後に、提案された AI ソリューションは、以下の図に示すように、落下動作に対して良好な検出結果を達成しました。いくつかの結論を導き出すことができます。まず、モデルの FP 分類が 0 であったことは、モデルが転倒を誤って分類していないことを示唆しています。第 940 に、各モデルには真陰性が 0 件あります。これは、俳優が転倒する前に、各テスト データに非転倒 (XNUMX として分類) の一部が含まれていることが原因である可能性があります。

.fusion-gallery-4 .fusion-gallery-image {border:0px Solid #e2e2e2;}

事例2:コンピュータビジョンとエッジAIを活用した心筋梗塞のバイタルサインの検出

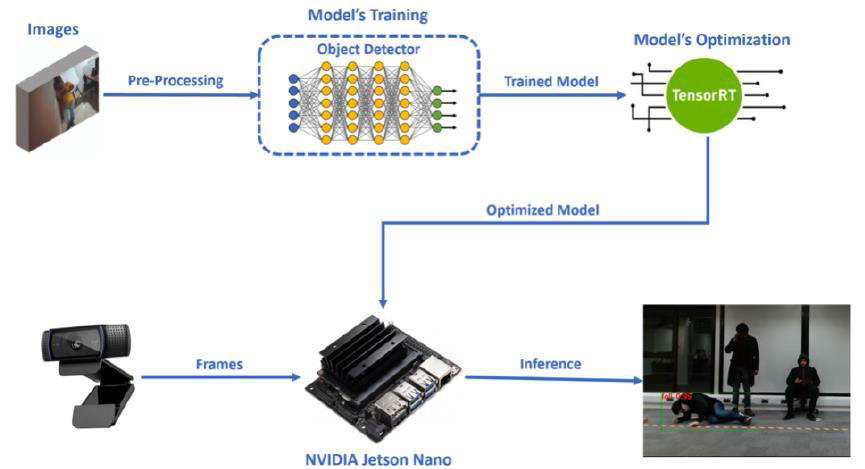

エッジ AI は、物理環境全体に配置されたデバイスへの人工知能アプリケーションの展開を指します。エンドユーザーが現実世界の課題に直面する状況で AI アルゴリズムを導入する場合、手頃な価格と使いやすさが重要な要素となります。このプロジェクトでは、私たちの学生は、空港での迅速な対応と救助のための、低コストで軽量の心臓発作検出モデルを提案しました。このプロセスは、次の図に示すように 4 つの主要な段階で構成されます。

.fusion-gallery-5 .fusion-gallery-image {border:0px Solid #e2e2e2;}

最初の段階では、クラス (胸の痛み、転倒) の境界ボックスに必要な注釈とともに、画像データセットの適切な選択と準備が行われます。

さらに、第 2 段階として、転移学習による物体検出器モデルのトレーニングが行われます。特定のステージは、PyTorch を使用して Google Colab で実行されました。その後、トレーニング段階の完了後、モデルは NVIDIA の Jetson Nano に挿入されました。これは、Edge AI コンピューター ビジョン アプリケーションに使用するために選択した組み込みデバイスでした。

システム設計の 3 番目の段階は、Jetson Nano でより効率的に実行できるようにするための、モデルの適切な変換と最適化でした。モデルの最適化は NVIDIA の TensorRT 推論エンジンを使用して実行され、特定のプロセスは Jetson Nano で実行されました (次の図を参照)。

.fusion-gallery-6 .fusion-gallery-image {border:0px Solid #e2e2e2;}

最後のステップは、Web カメラから受信したフレームを入力として使用して、Jetson Nano 上で最適化されたモデルを実行し、リアルタイムの物体検出プロセスを実行してクラス (胸の痛み、転倒) を検出します。このプロセスに加えて、Jetson Nano で実行される推論コードには 2 つの特定のシナリオがありました。最終的な推論結果は次の図に示されています。

.fusion-gallery-7 .fusion-gallery-image {border:0px Solid #e2e2e2;}

ケーススタディ 3: 群衆監視と社会的距離の分析

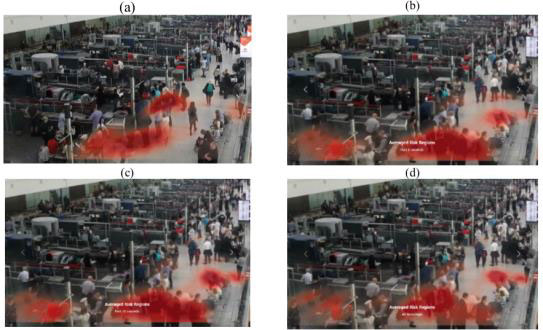

空港には毎日大量の乗客が流入しており、他の混雑した場所や組織と同様に、公共の安全を確保し、パンデミック時のリスクを軽減するための適切な対策が確実に実施されるようにする必要があります。このプロジェクトでは、私たちの学生たちは、空港全体にわたる多機能の群衆監視と分析を提供する統合コンピューター ビジョン ベースのシステムを提案しました。システムの出力は、群集ベースの分析とインテリジェンスの提供を通じて、空港管理スタッフと乗客の両方に利益をもたらすことを目的としています。

このシステムは、ビデオ監視フィードを使用して公共の場所の群衆を分析および監視するための統合プラットフォーム (下図を参照) で構成されています。特にスマート空港に焦点を当てていますが、基本的なフレームワークは、群衆の特性の分析と監視が役立つあらゆる公共の状況に適応できます。

.fusion-gallery-8 .fusion-gallery-image {border:0px Solid #e2e2e2;}

シーンから抽出されたポーズ特徴は、システムの下流モデルによって独自のタスクを実行するために使用されます。これには、人数カウント、対人距離推定、マスク オブジェクト検出、状態分類 (座っている、立っている、歩いている、横になっているなど)、および社会的クラスタリングが含まれます。次に、結果が結合されて、統合されたダッシュボードと監視システムが形成されます。ポーズ機能の一般的な使用を除いて、これらのタスクは、さまざまなモデリング アプローチによる特有の課題を表します。幸いなことに、モジュラー システム設計により、各タスクを抽象化し、異なるチーム メンバーがタスクを開発することができました。

.fusion-gallery-9 .fusion-gallery-image {border:0px Solid #e2e2e2;}

最後に、対話可能なインターフェイスは、すべてのダウンストリーム出力を 1 つのビューポートに統合するように設計されています (下の図を参照)。このアプリは、ダウンストリーム モデルによって作成されたデータ ファイルをリアルタイムでダッシュボードにアップロードし、シーンの現在の状態を分析できるようにします。いつでも、そのシーンのオリジナルの映像を、各人物から抽出されたポーズの特徴とともに、隣接するビデオ プレーヤーで表示できます。意思決定者は、箱ひげ図ビューとヒートマップ ビューを切り替えて、その後、データを受け取るフッテージを 2 つのドロップダウン メニューから変更できます。シーンに関する統計がビューポートの右端に表示されます。これらの統計は、総人のマスク状態、総リスクプロファイル、総人のポーズ状態、総人数、社会的距離の割合、および割合の箱ひげ図です。

.fusion-gallery-10 .fusion-gallery-image {border:0px Solid #e2e2e2;}

ケーススタディ 4: 空港での暴力行為の検知

最後に、私たちのグループの 1 つは、人間のポーズを推定し、監視映像内の暴力行為を分類する暴力検出フレームワークを開発することを目的としています (下図を参照)。このフレームワークは、ビデオ フレームから直接特徴を抽出するのではなく、ViTPose を使用して各フレーム内の人間のポーズを検出し、前処理してキー ポイント情報から特徴を抽出します。

.fusion-gallery-11 .fusion-gallery-image {border:0px Solid #e2e2e2;}

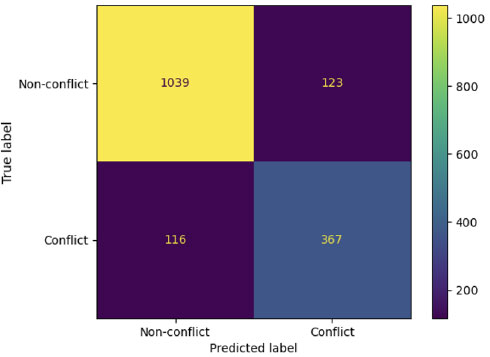

合計 1 のハイパーパラメータの組み合わせを持つ複数のデータセット (角度ベース、距離ベース、2 秒および 162 秒のシーケンス) を使用してさまざまなモデルを包括的に分析し、チームは最終的に特定の評価基準を満たすいくつかの有望なモデルを特定しました。以下の図に示すように、モデルは体のキーポイントの距離特徴を使用して、暴力行為に関する貴重な情報を抽出できると結論付けることができます。

.fusion-gallery-12 .fusion-gallery-image {border:0px Solid #e2e2e2;}

最後に、Saab UK と協力することで、学生は AI モデルを開発し、英国の多くの警察署で監視のために広く使用されている強力な状況認識プラットフォームである産業レベル プラットフォーム (SAFE) と統合することができます。 KAFKA ゲートウェイは AI エンジンに続いて適用され、さらなる表示とアラートのためにクライアント端末に転送されます。境界ボックスを使用して傍受されたビデオで暴力が検出された場合、SAFE クライアント レイアウトで傍受されたビデオを表示するモデル用に特別に設定したアラームがトリガーされ、詳細を含む警告メッセージが表示されます。最終的に、学生たちは DARTeC センターから AI モデルを導入し、人間の状況認識を強化するために Saab SAFE システムと通信することに成功しました。

.fusion-gallery-13 .fusion-gallery-image {border:0px Solid #e2e2e2;}

未来の応用AIエンジニアを育成する

これらは、修士課程 AAI コースからの興味深い GDP プロジェクトの厳選されたほんの数例です。最近では、AI との説明可能なインターフェイス、自律走行計画のための因果推論、自動運転車用の物理学に基づいた AI、および将来の空域管理などのより挑戦的な GDP プロジェクトが、在校生によって取り組まれています。私たちは、近いうちに修士課程の学生によってさらにエキサイティングな研究が発表されると信じています。

最終的なソリューションと結果がどれほど興味深いものであるかについては、GDP 中に学生が発表した次の研究出版物を確認してください。

- オシグベサン、アディエミ、ソレーネ・バラット、ハルキーラット・シン、ドンズィ・シア、シッダース・シン、ヤン・シン、ウェイシ・グオ、アントニオス・ツォルドス。 「姿勢推定による航空機整備環境における視覚ベースの落下検知」 2022 年のマルチセンサー融合とインテリジェント システムの統合に関する IEEE 国際会議 (MFI)、1 ~ 6 ページ。 IEEE、2022 年。

- フレイザー、ベンジャミン、ブレンダン・コップ、ガープリート・シン、オルハン・キーヴァン、トンフェイ・ビアン、バレンティン・ソンタグ、ヤン・シン、グオ・ウェイシー、アントニオス・ツォルドス。 「AIベースの群衆監視と社会的距離分析によるウイルス感染の削減」 2022 年のマルチセンサー融合とインテリジェント システムの統合に関する IEEE 国際会議 (MFI)、1 ~ 6 ページ。 IEEE、2022 年。

- Üstek, İ.、Desai, J.、Torrecillas, IL、Abadou, S.、Wang, J.、Fever, Q.、Kasthuri, SR、Xing, Y.、Guo, W.、Tsourdos, A.、2023 年、 2023月。スマート空港での ViTPose と分類モデルを使用した 797 段階の暴力検出。 802 年の IEEE スマート ワールド コングレス (SWC) (pp. XNUMX-XNUMX)。 IEEE。

- ブノワ、ポール、マルク・ブレッソン、ヤン・シン、ウェイシ・グオ、アントニオス・ツォルドス。 「姿勢推定を備えた CCTV カメラによるリアルタイムの視覚ベースの暴力行為の検出」 2023 年の IEEE スマート ワールド コングレス (SWC)、844 ~ 849 ページ。 IEEE、2023 年。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/