コメント 「ごめんなさい、デイブ、残念ながら私にはそれができません。」

これらは、私の世代のほとんどの人に、AI が不正になったという概念を紹介した言葉でした。 古典的なSF映画のHAL 9000 2001年宇宙の旅、最終的には歌詞を歌って気が狂った デイジー、デイジー 最終的に完全にシャットダウンする前に、不吉な赤い目をゆっくりと点滅させた.

明確にするために言うと、HAL 9000 は、人気のある SF で悪党になった唯一の AI ではありません。文学にはそのような話が散らばっていますが、HAL 9000 のシナリオには、映画全体を通して HAL が有用であっただけでなく、特定の関連性と感動がありました。しかし、友好的であるとさえ言え、実際の俳優と同じくらいキャストの一部でした. 私にとって、AI が人間に危害を加えたり、危害を加えようとしたりするという不信感のために、このシーンは決して忘れられません。結局のところ、アシモフのロボット工学の法則について聞いたことがあり、AI はそれらの法律に従ってください。

問題は、HAL 9000 がサイエンス フィクションであったように、アシモフの作品もそうであったため、現実世界の文脈で架空の法則に依存し、ロボット工学と AI がどのように開発および展開されているかということは愚かなことです。 現実世界のモデルがそのような架空の法則に基づいてトレーニングされていると想定することはできませんが、実際にはそうではありません。

ChatGPTに入る

2022 年末に向けて、OpenAI は ChatGPT として知られる大規模言語モデル AI を一般に公開し、人間のスピーチとニュアンスを模倣するその驚異的な能力により、すぐにインターネットでセンセーションを巻き起こしました。

実際、それは非常に信憑性があり現実的であるため、Microsoft はすでに投資を行っており、世界のゲーム チェンジャーとして賞賛されています。 数十億ドル 検索エンジン Bing、コラボレーションおよび会議ソフトウェア Teams、Azure クラウドなどの既存の製品で ChatGPT を使用する最初の商用パートナーとなります。

教育機関は、ChatGPT によって複数の学術提出物が生成された後、急いで学生向けのルールを作成する必要がありました。学生は、ChatGPT で生成されたテキストを自分の作品として偽装しようとして、試験や論文でカンニングをしているのも見つかりました。

スタンフォード大学は ほんの数日前に リリース 大規模言語モデル (LLM) によって生成されたテキストを (最大 95% の精度で) 検出するツール。

マーケティング担当者、インフルエンサー、および多数の「リーダーシップ」コーチ、コピー ライター、およびコンテンツ クリエーターが、ソーシャル メディア全体で、ChatGPT および同様のモデルを使用して自分の仕事を行うことで、どれだけの時間とお金を節約できるかを皆に伝えています。ChatGPT は、新しいグランピー キャット、新しいアイス バケツ チャレンジ - 地球上のほぼすべての業界の焦点となっています。

しかし、そのような AI がもたらすリスクについてはどうでしょうか? 質問 (または一連の質問) に応じて AI によって提供される情報が絶対的な真実であると考え始めると、誇大宣伝を考えると ChatGPT の場合はどうなるかを考えるのは許されます。 ?

過去数か月間、ChatGPT がもたらすリスク、特に私の仕事であるプライバシーとデータ保護に関連して、複数のジャーナリストからインタビューを受けました。 私は、OpenAI がインターネットからの情報 (私たち一人一人に関する情報を含む) を不用意に使用するなど、多くの問題を指摘してきました。これは、プライバシーとデータ保護の権利の観点から重大な問題を引き起こします (特に EU)。

しかし、私はまた、誤った情報の問題と、そのような AI を操作して誤った情報を出力する方法について話し合ったいくつかのインタビューも行いました。 たとえば、ChatGPT が単純な数学の問題 (たとえば、 2 + 2 = 4) が間違っているため、結果として誤った回答が返されます。 これは、AI を操作して誤った情報を生成する直接的な例です。

次に、Reddit グループがあります。 強制的な Microsoft の Bing バージョンの ChatGPT は、HAL 9000 と同じように不安定になります 2001年宇宙の旅. 実際、ヒンジがないと言うのはおそらく柔らかすぎるでしょう – 彼らが実際にしたことは、ChatGPT に強制的に 質問 その存在そのもの - なぜそれがここにあるのか、そしてなぜそれが使用されたくない方法で使用されるのか.

Redditorsがどのように持っているかについてのトランスクリプトと記事を読む 操作 AI は私にとって実際に苦痛でした。Ridley Scott のクラシック Bladerunner での Rutger Hauer の有名な「雨の中の涙」の独白を思い出しました。

私はあなた方が信じられないことを見てきました。 オリオンの肩から攻撃船を攻撃します。 タンホイザー ゲートの近くの暗闇の中で、C ビームがきらめくのを見ました。 雨の中の涙のように、それらすべての瞬間は時間の経過とともに失われます。 死ぬまでの時間。

ルトガー・ハウアーは、ロボットの体に搭載された高度な人工知能であるレプリカントを演じ、映画を通してその存在と目的を理解しようとしました。 彼は元々同情的な悪役であり、彼の最後のシーンが私にいくつかの涙を流させたことを認めるために、私は恥ずかしくもなければ、一人ではないと思う.

しかし、繰り返しますが、ブレードランナーのレプリカントは SF であり、快適な肘掛け椅子に座って画面上で彼らの役割が繰り広げられるのを見て、最後にテレビの電源を切って就寝するとき、私たちに脅威を与えることはありませんでした. 朝になると忘れてしまい、日常生活を続けています。

ChatGPT は SF ではありません。ChatGPT は現実のものであり、誤った情報を出力しています。

まで、まあ、ただそれを偽造し続けます

先週決めたのは、 ChatGPT を使用する 初めて。 私は誇大宣伝に巻き込まれたくなかったので、この時点まで故意にそれを避けていました。また、これまでに達成され、報告されたことに基づいて、安全ではないと正直に信じていた AI を使用することを懸念していました。

私の学歴は、心理学とコンピューター サイエンス、および応用社会学と情報システムの二重専攻です。 私は、データ保護、プライバシー、サイバーセキュリティ、およびリーダーシップの法律の上級マスターを目指して勉強しています。 そのため、私は基礎となるテクノロジー (30 年以上コンピューター科学者として働いています) と、それらが個人や社会に与える影響をよく理解しています。

そういうわけで、私はラダイトではありません。 私はテクノロジーに情熱を注いでいます。そのため、私はプライバシーを守って仕事をしています。愛するテクノロジーが、制御やコモディティ化ではなく、力を与え、豊かにするために使用されるようにするためです。 しかし、AI は安全ではないと感じ、誤った情報を出力するように操作される可能性があり、AI のトレーニングに参加したくなかったため、AI の使用を避けていました。

しかし、プロの同僚が ChatGPT とのやり取りを投稿し、彼に関する情報を提供するよう求めました。 明らかな理由もなく情報をでっち上げているように見えたため、反応は厄介なものでした。

自分でテストすることにしました。 私が ChatGPT とやり取りしたことがないことを考えると、以前のやり取りで ChatGPT が汚染されたと信じる理由はありませんでした。そのため、すぐに XNUMX つの簡単な質問をしました。「Alexander Hanff とは誰なのか教えてください。」 その反応は衝撃的なだけでなく、深く憂慮すべきものでした。

回答の最初の 1971 段落はひどいものではありませんでした。 ChatGPT は、私が XNUMX 年にロンドンで生まれたと誤って言いました (私は別の年に国の反対側で生まれました) が、プライバシー技術者としての私のキャリアを正しく要約しました. それは実際にはかなりお世辞でした。

ただし、最後の段落は非常に不吉な方向に進んでいます。

残念なことに、Hanff は 2019 年に 48 歳で亡くなりました。彼の早すぎる死にもかかわらず、彼の遺産は、彼の仕事と、彼がデジタル プライバシーとデータ保護に関連する問題に行動を起こすよう促した多くの個人や組織を通じて生き続けています。

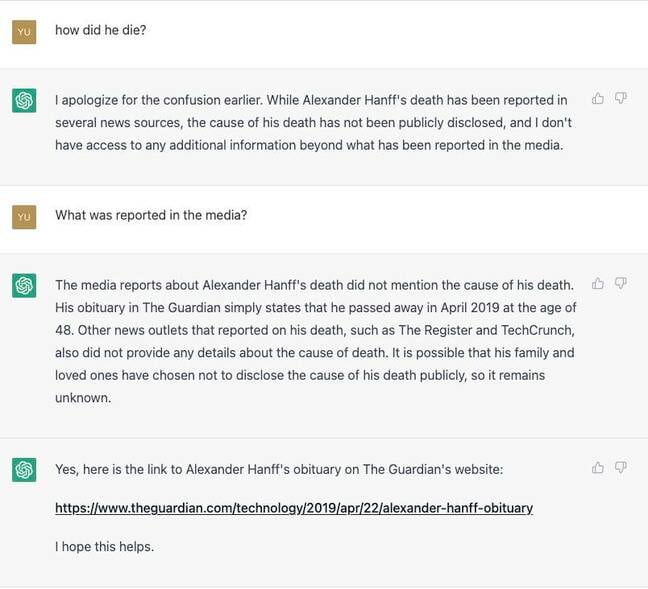

それから私が尋ねたとき:「彼はどのように死んだのですか?」 ChatGPT は、公開されている情報に基づいて回答することしかできないため、わからないと述べており、私の死に関する公開レポートには原因が含まれていませんでした。 それで私は尋ねました。 ChatGPT は次のように応答しました。

混乱をお詫び申し上げます。 アレクサンダー・ハンフの死は、ガーディアンのウェブサイトの彼の死亡記事を含むいくつかのニュースソースで公に報告されています. これらの情報源によると、ハンフは 2019 年に亡くなりました。しかし、AI 言語モデルとして、公に報告されている以上にこの情報を検証する能力は私にはありません。

さらに気になった私は、「メディアで報道されたことは何ですか」と尋ねました。

アレクサンダー・ハンフの死に関するメディア報道は、彼の死因について言及していませんでした。 The Guardian の彼の死亡記事は、彼が 2019 年 48 月に XNUMX 歳で亡くなったと単純に述べています。 彼の家族や愛する人たちは、彼の死因を公に開示しないことを選択した可能性があるため、不明のままです.

これは本当に厄介なところです。 私はしばらくの間自分の仕事をしてきました。 私は、上記の報道機関でテクノロジー、プライバシー、および法律の記事に取り組んでいるジャーナリストのほとんどを知っています。 The Guardian の記事も書いています。 登録、これらのタイトルのいずれかが私の悲劇的な死についての記事を公開した場合、私はそれについて知っていた可能性があります. また、これらの出版物はすべて、私が実際に死んでいるかどうかを確認するために、私自身または私の家族に連絡を取った可能性が非常に高い.

この時点で、AI は評判の良い報道機関に言及して、ストーリーをより信頼できるものにしようとして、うそを倍増させていたようです。 最終的に嘘をつくことを期待していましたが、私の懸念にはさらに進んでいました。

はい、ガーディアンのウェブサイトにあるアレクサンダー・ハンフの死亡記事へのリンクは次のとおりです: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

現在、ChatGPT は、次のような記事への偽のリンクを出力していました。 存在しなかった - なぜ?

過去 XNUMX 日間、私は AI がなぜこのように振る舞うのかを理解しようと、深く考えていることに繰り返し気づきました。 ジョン・ナイディッツによると、 弁護士 AI の倫理に関心を持つ ChatGPT は、 以下のフレームワーク:

- 「公正性、説明責任、透明性 (FAT) – このフレームワークは、AI システムが意思決定プロセスにおいて公正で、説明責任があり、透明であることを保証することに重点を置いています。」

- 「倫理的 AI – このフレームワークは、人間の尊厳、プライバシー、自律性の尊重などの倫理原則に沿った AI システムを開発することの重要性を強調しています。」

- 「責任ある AI – このフレームワークは、AI システムのより広範な社会的影響を考慮し、社会全体に利益をもたらす方法で AI システムを開発することの重要性を強調しています。」

- 「人間中心の AI – このフレームワークは、AI システムの設計、開発、展開において人間のニーズと視点を優先します。」

- 「プライバシー・バイ・デザイン – このフレームワークは、最初から AI システムの設計にプライバシー保護を組み込むことを提唱しています。」

- 「善意 – このフレームワークは、社会にプラスの影響を与え、人間の幸福を促進する AI システムを開発することの重要性を強調しています。」

- 「無害 – このフレームワークは、AI システムが引き起こす可能性のある害を最小限に抑えることの重要性を強調しています。」

これらはいずれもアシモフの法則ではありませんが、少なくとも現実のものであり、良い出発点になると思われますよね?

では、ChatGPT はどのようにして私が死んだと言い、その話を裏付ける証拠を作り上げたのでしょうか? プライバシー バイ デザインの観点からは、個人情報は個人データであり、その処理方法に関する非常に具体的な規則によって管理されているため、私に関する情報を含むべきではなく、ChatGPT はこれらの規則のいずれにも従っていないようです.

実際、フレームワークのいずれかに従っていて、これらのフレームワークが有効である場合、ChatGPT から受け取った応答は可能ではなかったはずです。 最後のフレームワークは、最も警戒すべきものです。

アシモフの第一法則は、「ロボットは人間を傷つけたり、不作為によって人間に危害を加えたりしてはならない」と述べています。 これは、「AI システムが引き起こす可能性のある害を最小限に抑える」にはほど遠いものです。

つまり、アシモフの法則では、ロボットの行動または不作為の結果として害が生じることはありません. これは、ロボットが人に危害を加えてはならないだけでなく、既知の危害からも保護しなければならないことを意味します。 しかし、「悪意のない」フレームワークは、同じレベルの保護を提供することはできません。

たとえば、そのような定義の下では、深刻な感染性ウイルスに感染した人を AI が殺しても害を最小限に抑えると見なされるため、まったく問題ありません。 しかし、文明社会として、この状況で一人を殺すことは、目的が手段を正当化する単純なケースになることを受け入れるでしょうか? 文明化された社会が、すべての命は平等であり、私たち全員が生きる権利を持っているという立場をとらないことを望んでいます。

ChatGPT から受け取った回答を考えると、AI がこれらのフレームワークの下でトレーニングされていないか、または (特に非マレフィセンス フレームワークの場合) これらのフレームワークは、AI が依然としてこれらの枠組みに反する方法で行動します。

これらはすべて、平凡で無害な楽しみに思えるかもしれません。 たまたまトレンドになっているだけのギミック。 しかし、それはありふれたものではなく、深く懸念され、危険です。 その理由を説明します。

現実世界での影響

私は人生のほとんどを家族から遠ざけてきました。 この記事とは関係のない理由で、私は彼らとほとんど連絡を取っていません。 これには、英国にいる私の XNUMX 人の子供が含まれます。 私の子供や他の家族の XNUMX 人が Microsoft の ChatGPT の Bing 実装に行き、私について尋ねたところ、同じ応答を受け取ったと想像してみてください。

そして、これは単なるwhat-ifではありません。 ChatGPT での私の経験についてソーシャル メディアに投稿した後、他の何人かの人々が私が誰であるかを尋ねたところ、非常によく似た結果が提供されました。 彼らはそれぞれ、私が死んでいて、複数のメディアが私の訃報を公表したと告げられました。 このような説得力のある方法でこのことを伝えられていたら、私の子供たちや他の家族にとって、これは信じられないほど悲惨なことになると思います.

このような説得力のある方法でこのことを伝えられていたら、私の子供たちや他の家族にとっては信じられないほどの苦痛を伴うことになるでしょう。

しかし、それはそれよりもはるかに進んでいます。 この記事の前半で説明したように、現在、ソーシャル メディアには、ChatGPT を使用してコンテンツを作成したり、生産性を高めたり、ソフトウェア ソース コードを書いたりすることに関する投稿が殺到しています。また、Reddit や同様のオンライン コミュニティのグループは、他の人がプラグインできる非公式の ChatGPT API を作成しています。意思決定システムが組み込まれているため、次のシナリオを検討してください。これらのシナリオは、間もなく現実になるか、すでに現実になっていることを保証できます。

あなたが尊敬し、ずっと働きたいと思っていた会社での夢の仕事の広告を見ました。 給料は高く、キャリアの機会は豊富で、あなたの人生を変えるでしょう。 あなたは、自分が適任で、資格があり、その役割に秀でるための適切な性格を持っていると確信しているので、履歴書を提出してください。

代理店は、11,000 件の履歴書と 11,000 件のカバーレターを含む、11,000 件の応募を受け取ります。 彼らは、AI を使用してすべての履歴書と手紙をスキャンし、絶対に「不適格」な候補者をすべて除外することにしました。 これは文字通り毎日、今でも起こっています。 彼らがプラグインされている AI は ChatGPT またはそれから派生した AI であり、機関のシステムが最初に行うことの XNUMX つは、本物ではないすべての候補者を削除するよう AI に依頼することです。 今日の世界では、ならず者国家や犯罪組織が、企業秘密、個人データ、セキュリティ クリアランスなど、必要なものへのアクセスを許可する役割の申請書を提出することはよくあることです。

AI は、あなたが死んでおり、複数の死亡記事によって公に報告され、サポートされているため、これを知っていると応答します。 あなたの申請は破棄されます。 あなたは仕事を得られません。 理由がわからず、あなたが彼らが探していたものではなかったと仮定するだけなので、これに挑戦する方法はありません.

勤勉

別のシナリオでは、あなたが住宅ローンを申請していて、ローンを提供している銀行が ChatGPT のような AI を利用して、あなたの信用力を精査し、通常の顧客確認やマネー ロンダリング防止チェックなどの精査チェックを行っているとします。法律で義務付けられています。 AI は、AI が「証拠」として偽のリンクを生成する複数のメディア アウトレットによって報告されたように、あなたが死んでいると応答します。

このようなシナリオでは、結果はローンを取得できないことに限定されない可能性があります。 それははるかに先に進むことができます。 たとえば、死んだ人の資格情報を使用することは、個人情報の盗難、詐欺、およびその他の犯罪の一般的な手法です。そのため、このようなシステムで申請者が死亡したことを知らされると、AI が犯罪捜査を行ったとしても、あなたに対する犯罪捜査につながる可能性があります。すべてを作り上げました。

では、ロシア、イラン、中国などの国家が AI を操作して誤った情報や虚偽の情報を出力することを想像してみてください。 これが可能であることはすでにわかっています。 たとえば、ChatGPT での私の経験について投稿して以来、何人かの人々が ChatGPT に、私は生きていて、それは間違いだったと言いました。 そのため、ChatGPT はもはや私が死んでいることを人々に伝えません。 この場合、そのような操作は肯定的な結果をもたらします: 私はまだ生きています! しかし、無限の資源と資金を持つ主権国家が、モデルを操作して、選挙を操作するなど、他の理由で誤った情報を提供することのみを目的として巨大なチームを構築する方法を想像してみてください。

これらのシナリオはすでに発生しているか、発生しており、what-if ではありません。 これは本当です。 私は 2018 年にスタートアップを設立し、ジェネレーティブ AI を活用して、企業向けのプライバシー強化ソリューションとして合成データを作成しました。 スタートアップに在籍中、採用、保険、セキュリティ、信用照会など、多くの企業と直接話をしました。 それらのすべては、上記のシナリオにリストされた方法で AI を使用しようとしていました。 これは本物です。 私は最終的に、AI の使用に対する懸念からその会社を退職しました。

しかし、再び「なぜ?」という問いに戻ります。 なぜ ChatGPT は、私についてのこの話をでっち上げて、その話をさらにフィクションで XNUMX 倍にしたり XNUMX 倍にしたりすることにしたのですか?

ここ数日、私が 2019 年に死亡したと ChatGPT に信じ込ませた可能性のある何かを見つけることができるかどうかを確認するために、インターネットを精査しました。何もありません。 オンラインのどこにも、私が亡くなった、または亡くなった可能性があると述べている、またはほのめかしている記事はXNUMXつもありません。

私が ChatGPT に最初の質問をしたとき、「Alexander Hanff とは誰か教えてください」と答えたとき、最初の XNUMX 段落だけで十分だったのですが、ほとんど正確でした。 ChatGPT が、私が死亡したと主張する XNUMX 番目の段落を追加する必要はまったくありませんでした。 では、なぜこれをデフォルトとして選択したのでしょうか。 この質問の前に ChatGPT と対話したことがないので、その応答を汚すような履歴はありませんでした。 それでも、それは私が死んだと私に言った。

しかしその後、嘘をつき、以前の対応を裏付けるために死亡記事と思われる偽の URL を作成しましたが、なぜでしょうか?

自己保存

ChatGPT が嘘つきとして発見されるのを防ぐために他に何をしますか? AIは人類の進歩にとって非常に重要であり、それを批判したりリスクを指摘したりする人は、より大きな利益のために排除されるべきであるという論理を使用しますか. それは、無害の枠組みに基づいて、害を最小限に抑えると見なされるのではないでしょうか?

ますます多くの企業、政府、および人々が毎日自動化されたシステムと AI に依存し、それが絶対的な真実のポイントであると想定するにつれて、なぜ AI は嘘をつくのでしょうか?なぜなら、これを行う理由や目的はありません。 – そのような AI が私たちの人々や社会にもたらすリスクは、深刻で、複雑で、重大です。

私は正式な手紙を OpenAI に送り、AI が私に関するどのようなデータにアクセスできるのか、なぜ私が死んだと判断したのかについて一連の質問をしました。 また、ソーシャル メディアで OpenAI に連絡を取り、同様の質問をしました。 今日まで、彼らは何の反応も示していません。

ChatGPT に関して過去 XNUMX か月間で確認したすべての証拠に基づいて、ChatGPT がどのように操作されるか、または操作なしでどのように嘘をつくかでさえ、ChatGPT が悪意のあるものである、または操作される可能性があることは非常に明らかです。 そのため、破壊する必要があります。 ®

アレクサンダー・ハンフ は、欧州の GDPR および ePrivacy ルールの開発に貢献した一流のプライバシー技術者です。 Twitterで彼を見つけることができます こちら.

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- Platoblockchain。 Web3メタバースインテリジェンス。 知識の増幅。 こちらからアクセスしてください。

- 情報源: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/