Quelle: rawpixel.com

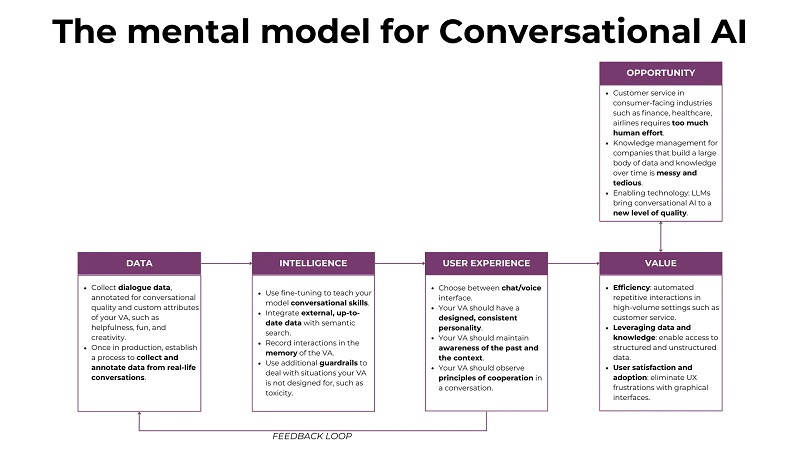

Conversational AI ist eine Anwendung von LLMs, die aufgrund ihrer Skalierbarkeit in vielen Branchen und Anwendungsfällen viel Aufsehen und Aufmerksamkeit erregt hat. Während Konversationssysteme schon seit Jahrzehnten existieren, haben LLMs den Qualitätsschub gebracht, der für ihre groß angelegte Einführung erforderlich war. In diesem Artikel werden wir das in Abbildung 1 dargestellte mentale Modell verwenden, um Konversations-KI-Anwendungen zu analysieren (vgl. KI-Produkte mit einem ganzheitlichen mentalen Modell entwickeln für eine Einführung in das mentale Modell). Nachdem wir die Marktchancen und den Geschäftswert von Konversations-KI-Systemen betrachtet haben, erläutern wir die zusätzlichen „Maschinen“ in Bezug auf Daten, LLM-Feinabstimmung und Konversationsdesign, die eingerichtet werden müssen, um Konversationen nicht nur möglich, sondern auch nützlich zu machen und angenehm.

1. Chance, Wert und Grenzen

Traditionelles UX-Design basiert auf einer Vielzahl künstlicher UX-Elemente, Wischen, Tippen und Klicken, was eine Lernkurve für jede neue App erfordert. Mithilfe von Konversations-KI können wir diese Hektik beseitigen und sie durch das elegante Erlebnis einer natürlich fließenden Konversation ersetzen, bei der wir die Übergänge zwischen verschiedenen Apps, Fenstern und Geräten vergessen können. Wir nutzen Sprache, unser universelles und vertrautes Kommunikationsprotokoll, um mit verschiedenen virtuellen Assistenten (VAs) zu interagieren und unsere Aufgaben zu erfüllen.

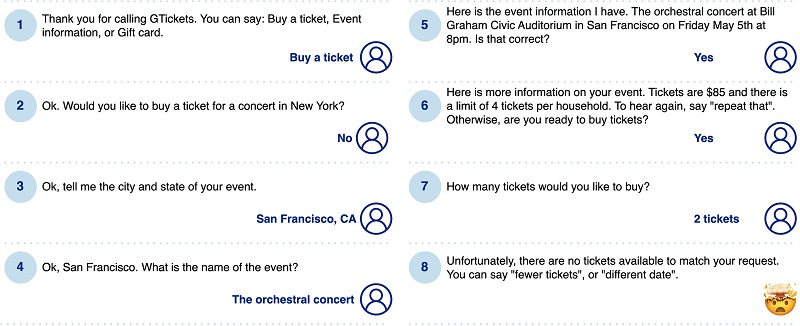

Konversations-UIs sind nicht gerade der neue Trend. Interaktive Sprachantwortsysteme (IVRs) und Chatbots gibt es seit den 1990er Jahren, und große Fortschritte im NLP gingen mit Hoffnungs- und Entwicklungswellen für Sprach- und Chat-Schnittstellen einher. Vor der Zeit der LLMs wurden die meisten Systeme jedoch im symbolischen Paradigma implementiert und basierten auf Regeln, Schlüsselwörtern und Konversationsmustern. Außerdem waren sie auf einen bestimmten, vorab definierten „Kompetenzbereich“ beschränkt, und Benutzer, die sich außerhalb dieser Bereiche bewegten, landeten bald in einer Sackgasse. Alles in allem waren diese Systeme mit potenziellen Fehlerquellen übersät, und nach ein paar frustrierenden Versuchen kehrten viele Benutzer nie wieder zu ihnen zurück. Die folgende Abbildung zeigt einen Beispieldialog. Ein Nutzer, der Karten für ein bestimmtes Konzert bestellen möchte, durchläuft geduldig einen ausführlichen Verhörablauf, nur um am Ende festzustellen, dass das Konzert ausverkauft ist.

Als unterstützende Technologie können LLMs Konversationsschnittstellen auf ein neues Niveau an Qualität und Benutzerzufriedenheit bringen. Konversationssysteme können jetzt ein viel umfassenderes Weltwissen, sprachliche Kompetenz und Konversationsfähigkeiten aufweisen. Mithilfe vorab trainierter Modelle können sie auch in viel kürzeren Zeiträumen entwickelt werden, da die mühsame Arbeit des Zusammenstellens von Regeln, Schlüsselwörtern und Dialogabläufen nun durch das statistische Wissen des LLM ersetzt wird. Schauen wir uns zwei herausragende Anwendungen an, bei denen Konversations-KI einen großen Mehrwert bieten kann:

- KUNDENSERVICE und ganz allgemein Anwendungen, die von einer großen Anzahl von Benutzern verwendet werden, die häufig ähnliche Anfragen stellen. Hier hat das Unternehmen, das den Kundensupport leistet, einen klaren Informationsvorsprung gegenüber dem Benutzer und kann diesen nutzen, um ein intuitiveres und angenehmeres Benutzererlebnis zu schaffen. Stellen Sie sich den Fall der Umbuchung eines Fluges vor. Bei mir, einem eher Vielflieger, passiert das ein bis zwei Mal pro Jahr. Zwischendurch vergesse ich oft die Details des Prozesses, ganz zu schweigen von der Benutzeroberfläche einer bestimmten Fluggesellschaft. Im Kundensupport der Airline hingegen stehen Umbuchungsanfragen im Mittelpunkt. Anstatt den Umbuchungsprozess über eine komplexe grafische Oberfläche offenzulegen, kann seine Logik für Kunden, die sich an den Support wenden, „versteckt“ werden und sie können die Sprache als natürlichen Kanal für ihre Umbuchung nutzen. Natürlich wird es immer noch einen „langen Schwanz“ weniger bekannter Anfragen geben. Stellen Sie sich zum Beispiel einen spontanen Stimmungsumschwung vor, der einen Geschäftskunden dazu drängt, seinen geliebten Hund als Übergepäck zu einem gebuchten Flug hinzuzufügen. Diese individuelleren Anfragen können an menschliche Agenten weitergeleitet oder über ein internes Wissensmanagementsystem abgedeckt werden, das mit dem virtuellen Assistenten verbunden ist.

- Wissensmanagement die auf einer großen Datenmenge basiert. Für viele moderne Unternehmen ist das interne Wissen, das sie im Laufe der Jahre des Betriebs, der Iteration und des Lernens angesammelt haben, ein zentraler Vermögenswert und Unterscheidungsmerkmal – wenn es auf effiziente Weise gespeichert, verwaltet und abgerufen wird. Da sie auf einer Fülle von Daten basieren, die in Tools für die Zusammenarbeit, internen Wikis, Wissensdatenbanken usw. verborgen sind, gelingt es ihnen oft nicht, diese in umsetzbares Wissen umzuwandeln. Wenn Mitarbeiter gehen, neue Mitarbeiter eingestellt werden und Sie die Dokumentationsseite, die Sie vor drei Monaten begonnen haben, nie fertigstellen, fällt wertvolles Wissen der Entropie zum Opfer. Es wird immer schwieriger, einen Weg durch das interne Datenlabyrinth zu finden und an die Informationen zu gelangen, die in einer bestimmten Geschäftssituation benötigt werden. Dies führt zu enormen Effizienzverlusten für Wissensarbeiter. Um dieses Problem zu lösen, können wir LLMs durch eine semantische Suche in internen Datenquellen erweitern. LLMs ermöglichen die Verwendung von Fragen in natürlicher Sprache anstelle komplexer formaler Abfragen, um Fragen anhand dieser Datenbank zu stellen. Benutzer können sich somit auf ihre Informationsbedürfnisse konzentrieren und müssen sich nicht mit der Struktur der Wissensdatenbank oder der Syntax einer Abfragesprache wie SQL befassen. Da diese Systeme textbasiert sind, arbeiten sie mit Daten in einem reichhaltigen semantischen Raum und stellen so sinnvolle Verbindungen „unter der Haube“ her.

Über diese Hauptanwendungsbereiche hinaus gibt es zahlreiche andere Anwendungen, wie z. B. Telemedizin, Assistenten für psychische Gesundheit und pädagogische Chatbots, die UX rationalisieren und ihren Benutzern schneller und effizienter einen Mehrwert bieten können.

Wenn dieser ausführliche Bildungsinhalt für Sie nützlich ist, können Sie dies tun Abonnieren Sie unsere AI Research Mailingliste benachrichtigt werden, wenn wir neues Material veröffentlichen.

2. Daten

LLMs sind ursprünglich nicht darauf trainiert, fließenden Smalltalk oder substanziellere Gespräche zu führen. Sie lernen vielmehr, bei jedem Inferenzschritt das folgende Token zu generieren, was schließlich zu einem zusammenhängenden Text führt. Dieses untergeordnete Ziel unterscheidet sich von der Herausforderung menschlicher Gespräche. Gespräche sind für Menschen unglaublich intuitiv, aber sie werden unglaublich komplex und nuanciert, wenn man einer Maschine das beibringen möchte. Schauen wir uns zum Beispiel den grundlegenden Begriff der Absichten an. Wenn wir Sprache verwenden, tun wir dies für einen bestimmten Zweck, nämlich unsere Kommunikationsabsicht – es könnte sein, Informationen zu übermitteln, Kontakte zu knüpfen oder jemanden zu bitten, etwas zu tun. Während die ersten beiden für einen LLM recht unkompliziert sind (sofern er die erforderlichen Informationen in den Daten gesehen hat), ist letzteres bereits eine größere Herausforderung. Das LLM muss nicht nur die zugehörigen Informationen kohärent kombinieren und strukturieren, sondern auch den richtigen emotionalen Ton in Bezug auf weiche Kriterien wie Formalität, Kreativität, Humor usw. festlegen. Dies ist eine Herausforderung für die Gesprächsgestaltung (vgl. Abschnitt 5), die eng mit der Aufgabe der Feinabstimmungsdatenerstellung verknüpft ist.

Der Übergang von der klassischen Sprachgenerierung zum Erkennen und Reagieren auf spezifische Kommunikationsabsichten ist ein wichtiger Schritt hin zu einer besseren Benutzerfreundlichkeit und Akzeptanz von Konversationssystemen. Wie alle Feinabstimmungsbemühungen beginnt diese mit der Zusammenstellung eines geeigneten Datensatzes.

Die Feinabstimmungsdaten sollten der (zukünftigen) realen Datenverteilung möglichst nahe kommen. Erstens sollte es sich um Konversationsdaten (Dialogdaten) handeln. Zweitens: Wenn Ihr virtueller Assistent auf eine bestimmte Domäne spezialisiert ist, sollten Sie versuchen, Feinabstimmungsdaten zusammenzustellen, die das erforderliche Domänenwissen widerspiegeln. Drittens: Wenn es typische Abläufe und Anfragen gibt, die in Ihrer Anwendung häufig wiederkehren, wie im Fall des Kundensupports, versuchen Sie, verschiedene Beispiele davon in Ihre Trainingsdaten zu integrieren. Die folgende Tabelle zeigt ein Beispiel von Konversations-Feinabstimmungsdaten aus dem 3K-Gesprächsdatensatz für ChatBot, das auf Kaggle frei verfügbar ist:

Das manuelle Erstellen von Konversationsdaten kann zu einem kostspieligen Unterfangen werden – Crowdsourcing und der Einsatz von LLMs zur Unterstützung der Datengenerierung sind zwei Möglichkeiten zur Skalierung. Sobald die Dialogdaten erfasst sind, müssen die Gespräche ausgewertet und kommentiert werden. Auf diese Weise können Sie Ihrem Modell sowohl positive als auch negative Beispiele zeigen und es dazu bringen, die Merkmale der „richtigen“ Gespräche aufzugreifen. Die Bewertung kann entweder mit absoluten Punktzahlen oder einer Rangfolge verschiedener Optionen untereinander erfolgen. Der letztgenannte Ansatz führt zu einer genaueren Feinabstimmung der Daten, da Menschen normalerweise besser darin sind, mehrere Optionen einzuordnen, als sie isoliert zu bewerten.

Wenn Ihre Daten vorhanden sind, können Sie Ihr Modell verfeinern und mit zusätzlichen Funktionen anreichern. Im nächsten Abschnitt befassen wir uns mit der Feinabstimmung, der Integration zusätzlicher Informationen aus dem Speicher und der semantischen Suche sowie der Verbindung von Agenten mit Ihrem Konversationssystem, um es in die Lage zu versetzen, bestimmte Aufgaben auszuführen.

3. Aufbau des Konversationssystems

Ein typisches Konversationssystem besteht aus einem Konversationsagenten, der die Komponenten und Funktionen des Systems orchestriert und koordiniert, beispielsweise das LLM, den Speicher und externe Datenquellen. Die Entwicklung von Konversations-KI-Systemen ist eine äußerst experimentelle und empirische Aufgabe, und Ihre Entwickler befinden sich in einem ständigen Hin und Her zwischen der Optimierung Ihrer Daten, der Verbesserung der Feinabstimmungsstrategie, dem Spielen mit zusätzlichen Komponenten und Verbesserungen und dem Testen der Ergebnisse . Auch nicht-technische Teammitglieder, darunter Produktmanager und UX-Designer, werden das Produkt kontinuierlich testen. Aufgrund ihrer Customer-Discovery-Aktivitäten können sie den Gesprächsstil und die Inhalte zukünftiger Nutzer gut vorhersehen und sollten dieses Wissen aktiv einbringen.

3.1 Vermittlung von Konversationskompetenzen für Ihr LLM

Für die Feinabstimmung benötigen Sie Ihre Feinabstimmungsdaten (vgl. Abschnitt 2) und ein vorab trainiertes LLM. LLMs wissen bereits viel über Sprache und die Welt, und unsere Herausforderung besteht darin, ihnen die Prinzipien der Konversation beizubringen. Bei der Feinabstimmung sind die Zielausgaben Texte, und das Modell wird optimiert, um Texte zu generieren, die den Zielen möglichst ähnlich sind. Für die überwachte Feinabstimmung müssen Sie zunächst die Konversations-KI-Aufgabe, die das Modell ausführen soll, klar definieren, die Daten sammeln und den Feinabstimmungsprozess ausführen und iterieren.

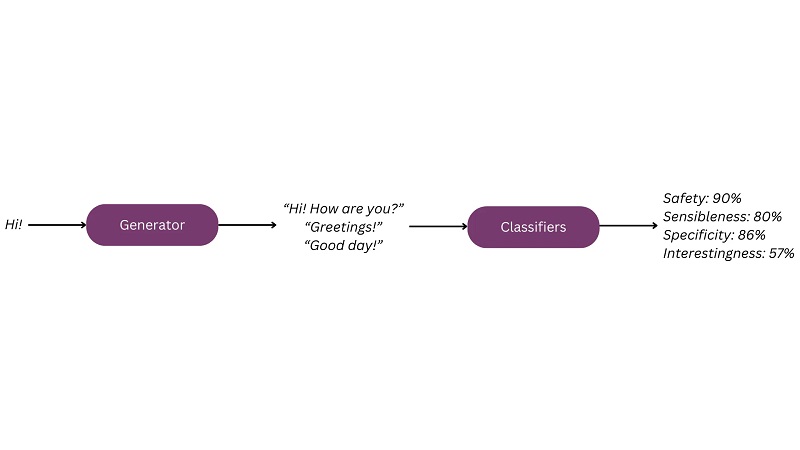

Mit dem Hype um LLMs sind verschiedene Methoden zur Feinabstimmung entstanden. Ein eher traditionelles Beispiel für die Feinabstimmung von Gesprächen finden Sie in der Beschreibung des LaMDA-Modells.[1] Die Feinabstimmung von LaMDA erfolgte in zwei Schritten. Zunächst werden Dialogdaten genutzt, um dem Modell Konversationskompetenzen beizubringen („generative“ Feinabstimmung). Anschließend werden die von Annotatoren während der Bewertung der Daten erstellten Beschriftungen verwendet, um Klassifikatoren zu trainieren, die die Ergebnisse des Modells anhand gewünschter Attribute bewerten können, darunter Sinnhaftigkeit, Spezifität, Interessantheit und Sicherheit („diskriminierende“ Feinabstimmung). Diese Klassifikatoren werden dann verwendet, um das Verhalten des Modells in Bezug auf diese Attribute zu steuern.

Darüber hinaus ist die sachliche Grundlage – die Fähigkeit, ihre Ergebnisse auf glaubwürdige externe Informationen zu stützen – ein wichtiges Merkmal von LLMs. Um eine sachliche Grundlage zu gewährleisten und Halluzinationen zu minimieren, wurde LaMDA mit einem Datensatz verfeinert, der Aufrufe an ein externes Informationsabrufsystem beinhaltet, wann immer externes Wissen erforderlich ist. So lernte das Modell, immer dann zunächst Sachinformationen abzurufen, wenn der Benutzer eine Anfrage stellte, die neues Wissen erforderte.

Eine weitere beliebte Technik zur Feinabstimmung ist Reinforcement Learning from Human Feedback (RLHF)[2]. RLHF „lenkt“ den Lernprozess des LLM von der einfachen, aber künstlichen Aufgabe zur Vorhersage des nächsten Tokens auf das Erlernen menschlicher Präferenzen in einer bestimmten Kommunikationssituation um. Diese menschlichen Vorlieben werden direkt in den Trainingsdaten kodiert. Während des Annotationsprozesses werden Menschen aufgefordert, entweder die gewünschte Antwort zu schreiben oder eine Reihe vorhandener Antworten zu bewerten. Das Verhalten des LLM wird dann optimiert, um die menschlichen Vorlieben widerzuspiegeln.

3.2 Hinzufügen externer Daten und semantische Suche

Über das Kompilieren von Konversationen zur Feinabstimmung des Modells hinaus möchten Sie Ihr System möglicherweise mit speziellen Daten erweitern, die während der Konversation genutzt werden können. Beispielsweise benötigt Ihr System möglicherweise Zugriff auf externe Daten wie Patente oder wissenschaftliche Arbeiten oder auf interne Daten wie Kundenprofile oder Ihre technische Dokumentation. Dies erfolgt normalerweise über eine semantische Suche (auch als Retrieval-Augmented Generation oder RAG bekannt)[3]. Die zusätzlichen Daten werden in Form semantischer Einbettungen in einer Datenbank gespeichert (vgl. Dieser Artikel für eine Erläuterung der Einbettungen und weitere Referenzen). Wenn die Benutzeranfrage eingeht, wird sie vorverarbeitet und in eine semantische Einbettung umgewandelt. Die semantische Suche identifiziert dann die Dokumente, die für die Anfrage am relevantesten sind, und verwendet sie als Kontext für die Eingabeaufforderung. Durch die Integration zusätzlicher Daten in die semantische Suche können Sie Halluzinationen reduzieren und nützlichere, sachlich fundierte Antworten liefern. Durch die kontinuierliche Aktualisierung der Einbettungsdatenbank können Sie außerdem das Wissen und die Reaktionen Ihres Systems auf dem neuesten Stand halten, ohne Ihren Feinabstimmungsprozess ständig neu durchführen zu müssen.

3.3 Gedächtnis und Kontextbewusstsein

Stellen Sie sich vor, Sie gehen auf eine Party und treffen Peter, einen Anwalt. Sie sind aufgeregt und beginnen mit der Präsentation des juristischen Chatbots, den Sie derzeit erstellen möchten. Peter sieht interessiert aus, beugt sich zu dir, ähm und nickt. Irgendwann möchten Sie seine Meinung dazu, ob er Ihre App nutzen möchte. Statt einer informativen Aussage, die Ihre Eloquenz entschädigen würde, hören Sie: „Ähm… was hat diese App nochmal gemacht?“

Der ungeschriebene Vertrag der Kommunikation zwischen Menschen setzt voraus, dass wir unseren Gesprächspartnern zuhören und unsere eigenen Sprechakte auf dem Kontext aufbauen, den wir während der Interaktion mitgestalten. In sozialen Situationen ist das Entstehen dieses gemeinsamen Verständnisses kennzeichnend für ein fruchtbares und bereicherndes Gespräch. In alltäglicheren Situationen wie der Reservierung eines Tisches im Restaurant oder dem Kauf einer Bahnfahrkarte ist dies eine absolute Notwendigkeit, um die Aufgabe zu erfüllen und dem Benutzer den erwarteten Mehrwert zu bieten. Dazu ist es erforderlich, dass Ihr Assistent den Verlauf des aktuellen Gesprächs, aber auch vergangener Gespräche kennt – er sollte beispielsweise nicht immer wieder nach dem Namen und anderen persönlichen Daten eines Benutzers fragen, wenn dieser ein Gespräch beginnt.

Eine der Herausforderungen bei der Aufrechterhaltung des Kontextbewusstseins ist die Auflösung von Koreferenzen, also das Verstehen, auf welche Objekte sich Pronomen beziehen. Menschen nutzen intuitiv viele kontextuelle Hinweise, wenn sie Sprache interpretieren – Sie können beispielsweise ein kleines Kind fragen: „Bitte nehmen Sie den grünen Ball aus der roten Schachtel und bringen Sie ihn mir“, und das Kind wird wissen, dass Sie den Ball meinen , nicht die Box. Für virtuelle Assistenten kann diese Aufgabe eine ziemliche Herausforderung sein, wie der folgende Dialog zeigt:

Assistent: Vielen Dank, ich werde jetzt Ihren Flug buchen. Möchten Sie auch eine Mahlzeit für Ihren Flug bestellen?

Benutzer: Ähm... kann ich später entscheiden, ob ich es will?

Assistent: Leider kann dieser Flug später nicht geändert oder storniert werden.

Hier erkennt der Assistent das Pronomen nicht it vom Benutzer bezieht sich nicht auf den Flug, sondern auf die Mahlzeit und erfordert daher eine weitere Iteration, um dieses Missverständnis zu beheben.

3.4 Zusätzliche Leitplanken

Hin und wieder benimmt sich selbst der beste LLM schlecht und hat Halluzinationen. In vielen Fällen handelt es sich bei Halluzinationen schlicht um Genauigkeitsprobleme – und Sie müssen akzeptieren, dass keine KI zu 100 % genau ist. Im Vergleich zu anderen KI-Systemen ist der „Abstand“ zwischen Nutzer und KI eher gering. Ein einfaches Genauigkeitsproblem kann schnell zu etwas werden, das als toxisch, diskriminierend oder allgemein schädlich wahrgenommen wird. Da LLMs darüber hinaus kein grundsätzliches Verständnis für den Datenschutz haben, können sie auch sensible Daten wie personenbezogene Daten (PII) preisgeben. Sie können diesen Verhaltensweisen entgegenwirken, indem Sie zusätzliche Leitplanken verwenden. Mit Tools wie Guardrails AI, Rebuff, NeMo Guardrails und Microsoft Guidance können Sie das Risiko Ihres Systems verringern, indem Sie zusätzliche Anforderungen an LLM-Ausgaben formulieren und unerwünschte Ausgaben blockieren.

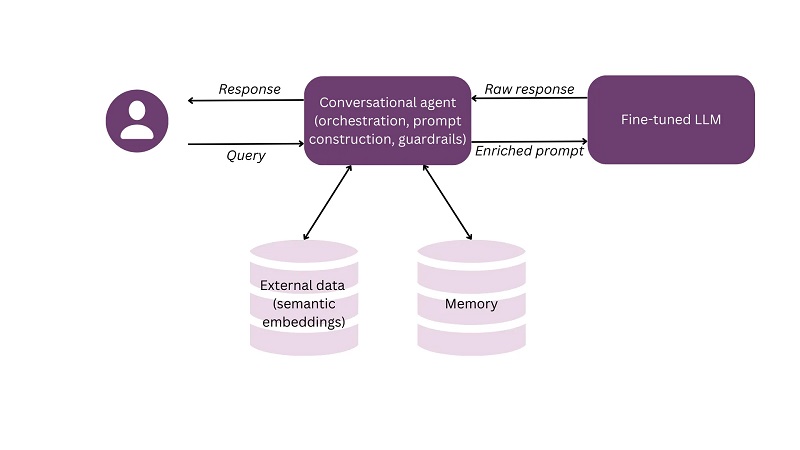

In der Konversations-KI sind mehrere Architekturen möglich. Das folgende Schema zeigt ein einfaches Beispiel dafür, wie das fein abgestimmte LLM, externe Daten und der Speicher von einem Konversationsagenten integriert werden können, der auch für die Eingabeaufforderungskonstruktion und die Leitplanken verantwortlich ist.

4. Benutzererfahrung und Konversationsdesign

Der Reiz von Konversationsschnittstellen liegt in ihrer Einfachheit und Einheitlichkeit über verschiedene Anwendungen hinweg. Wenn die Zukunft der Benutzeroberflächen darin besteht, dass alle Apps mehr oder weniger gleich aussehen, ist dann der Job des UX-Designers zum Scheitern verurteilt? Auf keinen Fall – Konversation ist eine Kunst, die Sie Ihrem LLM beibringen müssen, damit er Gespräche führen kann, die für Ihre Benutzer hilfreich, natürlich und angenehm sind. Gutes Konversationsdesign entsteht, wenn wir unser Wissen über menschliche Psychologie, Linguistik und UX-Design kombinieren. Im Folgenden betrachten wir zunächst zwei grundlegende Optionen beim Aufbau eines Konversationssystems, nämlich ob Sie Sprache und/oder Chat verwenden, sowie den größeren Kontext Ihres Systems. Dann schauen wir uns die Gespräche selbst an und sehen, wie Sie die Persönlichkeit Ihres Assistenten formen und ihm gleichzeitig beibringen können, sich an hilfreichen und kooperativen Gesprächen zu beteiligen.

4.1 Sprache versus Chat

Konversationsschnittstellen können per Chat oder Sprache implementiert werden. Kurz gesagt: Die Sprache ist schneller, während der Chat den Benutzern ermöglicht, privat zu bleiben und von erweiterten UI-Funktionen zu profitieren. Lassen Sie uns etwas tiefer in die beiden Optionen eintauchen, da dies eine der ersten und wichtigsten Entscheidungen ist, die Sie beim Erstellen einer Konversations-App treffen müssen.

Um zwischen den beiden Alternativen zu wählen, berücksichtigen Sie zunächst die physische Umgebung, in der Ihre App verwendet wird. Warum basieren beispielsweise fast alle Konversationssysteme in Autos, wie sie von Nuance Communications angeboten werden, auf Sprache? Denn die Hände des Fahrers sind ohnehin schon stark beansprucht und er kann nicht ständig zwischen Lenkrad und Tastatur wechseln. Dies gilt auch für andere Aktivitäten wie Kochen, bei denen Benutzer während der Nutzung Ihrer App im Fluss ihrer Aktivitäten bleiben möchten. Autos und Küchen sind größtenteils private Bereiche, sodass Benutzer die Freude an der Sprachinteraktion erleben können, ohne sich um die Privatsphäre sorgen oder andere stören zu müssen. Wenn Ihre App hingegen in einem öffentlichen Umfeld wie einem Büro, einer Bibliothek oder einem Bahnhof verwendet werden soll, ist Sprache möglicherweise nicht Ihre erste Wahl.

Nachdem Sie die physische Umgebung verstanden haben, betrachten Sie die emotionale Seite. Stimme kann gezielt eingesetzt werden, um Ton, Stimmung und Persönlichkeit zu vermitteln – stellt dies in Ihrem Kontext einen Mehrwert dar? Wenn Sie Ihre App für die Freizeit erstellen, kann die Stimme den Spaßfaktor erhöhen, während ein Assistent für die psychische Gesundheit mehr Einfühlungsvermögen bieten und einem möglicherweise unruhigen Benutzer mehr Ausdrucksmöglichkeiten bieten könnte. Wenn Ihre App hingegen Benutzer in einem professionellen Umfeld wie dem Handel oder Kundendienst unterstützt, kann eine anonymere, textbasierte Interaktion möglicherweise zu objektiveren Entscheidungen beitragen und Ihnen den Aufwand ersparen, ein übermäßig emotionales Erlebnis zu gestalten.

Denken Sie im nächsten Schritt über die Funktionalität nach. Über die textbasierte Oberfläche können Sie die Gespräche mit anderen Medien wie Bildern und grafischen UI-Elementen wie Schaltflächen bereichern. Beispielsweise ist in einem E-Commerce-Assistenten eine App, die Produkte durch die Veröffentlichung ihrer Bilder und strukturierten Beschreibungen vorschlägt, viel benutzerfreundlicher als eine App, die Produkte per Sprache beschreibt und möglicherweise ihre Identifikatoren bereitstellt.

Lassen Sie uns abschließend über die zusätzlichen Design- und Entwicklungsherausforderungen beim Erstellen einer Sprach-Benutzeroberfläche sprechen:

- Es gibt einen zusätzlichen Schritt der Spracherkennung, der stattfindet, bevor Benutzereingaben mit LLMs und Natural Language Processing (NLP) verarbeitet werden können.

- Stimme ist ein persönlicheres und emotionaleres Kommunikationsmedium – daher sind die Anforderungen an die Gestaltung einer konsistenten, angemessenen und angenehmen Persona hinter Ihrem virtuellen Assistenten höher, und Sie müssen zusätzliche Faktoren des „Stimmendesigns“ wie die Klangfarbe berücksichtigen , Stress, Tonfall und Sprechgeschwindigkeit.

- Benutzer erwarten, dass Ihr Sprachgespräch mit der gleichen Geschwindigkeit abläuft wie ein menschliches Gespräch. Um eine natürliche Interaktion per Sprache zu ermöglichen, benötigen Sie eine deutlich kürzere Latenz als beim Chat. Bei menschlichen Gesprächen beträgt die typische Lücke zwischen den Gesprächsrunden 200 Millisekunden. Diese schnelle Reaktion ist möglich, weil wir mit dem Aufbau unserer Gesprächsrunden beginnen, während wir der Rede unseres Partners zuhören. Ihr Sprachassistent muss mit diesem Grad an Gewandtheit in der Interaktion mithalten können. Im Gegensatz dazu konkurrieren Chatbots mit Zeitspannen von Sekunden, und einige Entwickler führen sogar eine zusätzliche Verzögerung ein, damit sich die Konversation wie ein getippter Chat zwischen Menschen anfühlt.

- Kommunikation über Sprache ist ein lineares, einmaliges Unterfangen – wenn Ihr Benutzer nicht verstanden hat, was Sie gesagt haben, steht Ihnen eine langwierige, fehleranfällige Klärungsschleife bevor. Daher müssen Ihre Ausführungen so prägnant, klar und informativ wie möglich sein.

Wenn Sie sich für die Sprachlösung entscheiden, stellen Sie sicher, dass Sie nicht nur die Vorteile im Vergleich zum Chat klar verstehen, sondern auch über die Fähigkeiten und Ressourcen verfügen, um diese zusätzlichen Herausforderungen zu bewältigen.

4.2 Wo wird Ihre Konversations-KI leben?

Betrachten wir nun den größeren Kontext, in den Sie Konversations-KI integrieren können. Wir alle kennen Chatbots auf Unternehmenswebsites – diese Widgets auf der rechten Seite Ihres Bildschirms, die auftauchen, wenn wir die Website eines Unternehmens öffnen. Persönlich besteht meine intuitive Reaktion meistens darin, nach der Schaltfläche „Schließen“ zu suchen. Warum das? Durch erste Versuche, mit diesen Bots zu „konversieren“, habe ich gelernt, dass sie spezifischere Informationsanforderungen nicht erfüllen können und ich am Ende trotzdem die Website durchforsten muss. Die Moral der Geschichte? Bauen Sie einen Chatbot nicht, weil er cool und trendy ist, sondern bauen Sie ihn, weil Sie sicher sind, dass er einen Mehrwert für Ihre Benutzer schaffen kann.

Über das umstrittene Widget auf einer Unternehmenswebsite hinaus gibt es mehrere spannende Kontexte, um die allgemeineren Chatbots zu integrieren, die mit LLMs möglich geworden sind:

- Copiloten: Diese Assistenten führen und beraten Sie durch bestimmte Prozesse und Aufgaben, wie GitHub CoPilot für die Programmierung. Normalerweise sind Copiloten an eine bestimmte Anwendung (oder eine kleine Suite verwandter Anwendungen) „gebunden“.

- Synthetische Menschen (auch digitale Menschen): Diese Kreaturen „emulieren“ echte Menschen in der digitalen Welt. Sie sehen aus, verhalten sich und sprechen wie Menschen und benötigen daher auch umfassende Konversationsfähigkeiten. Synthetische Menschen werden häufig in immersiven Anwendungen wie Spielen sowie erweiterter und virtueller Realität eingesetzt.

- Digitale Zwillinge: Digitale Zwillinge sind digitale „Kopien“ realer Prozesse und Objekte wie Fabriken, Autos oder Motoren. Sie werden verwendet, um das Design und Verhalten des realen Objekts zu simulieren, zu analysieren und zu optimieren. Interaktionen in natürlicher Sprache mit digitalen Zwillingen ermöglichen einen reibungsloseren und vielseitigeren Zugriff auf die Daten und Modelle.

- Datenbanken: Heutzutage sind Daten zu jedem Thema verfügbar, seien es Anlageempfehlungen, Codeschnipsel oder Lehrmaterialien. Oft ist es schwierig, die ganz spezifischen Daten zu finden, die Benutzer in einer bestimmten Situation benötigen. Grafische Schnittstellen zu Datenbanken sind entweder zu grobkörnig oder mit endlosen Such- und Filter-Widgets übersät. Vielseitige Abfragesprachen wie SQL und GraphQL sind nur für Benutzer mit entsprechenden Kenntnissen zugänglich. Konversationslösungen ermöglichen es Benutzern, die Daten in natürlicher Sprache abzufragen, während das LLM, das die Anfragen verarbeitet, diese automatisch in die entsprechende Abfragesprache umwandelt (vgl. Dieser Artikel für eine Erklärung von Text2SQL).

4.3 Prägen Sie Ihrem Assistenten eine Persönlichkeit ein

Als Menschen sind wir dazu veranlagt, uns zu anthropomorphisieren, das heißt, uns zusätzliche menschliche Eigenschaften zu verleihen, wenn wir etwas sehen, das vage einem Menschen ähnelt. Sprache ist eine der einzigartigsten und faszinierendsten Fähigkeiten der Menschheit, und Konversationsprodukte werden automatisch mit Menschen in Verbindung gebracht. Menschen stellen sich eine Person hinter ihrem Bildschirm oder Gerät vor – und es empfiehlt sich, diese bestimmte Person nicht der Fantasie Ihrer Benutzer zu überlassen, sondern ihr vielmehr eine einheitliche Persönlichkeit zu verleihen, die zu Ihrem Produkt und Ihrer Marke passt. Dieser Prozess wird als „Persona-Design“ bezeichnet.

Der erste Schritt beim Persona-Design besteht darin, die Charaktereigenschaften zu verstehen, die Ihre Persona aufweisen soll. Idealerweise erfolgt dies bereits auf der Ebene der Trainingsdaten. Wenn Sie beispielsweise RLHF verwenden, können Sie Ihre Annotatoren bitten, die Daten nach Merkmalen wie Hilfsbereitschaft, Höflichkeit, Spaß usw. zu ordnen, um das Modell darauf auszurichten die gewünschten Eigenschaften. Diese Eigenschaften können mit Ihren Markenattributen abgeglichen werden, um ein einheitliches Image zu schaffen, das Ihr Branding über das Produkterlebnis kontinuierlich fördert.

Über allgemeine Merkmale hinaus sollten Sie auch darüber nachdenken, wie Ihr virtueller Assistent mit bestimmten Situationen jenseits des „glücklichen Weges“ umgehen wird. Wie wird es beispielsweise auf Benutzeranfragen reagieren, die über seinen Rahmen hinausgehen, auf Fragen zu seiner Person antworten und mit beleidigender oder vulgärer Sprache umgehen?

Es ist wichtig, explizite interne Richtlinien für Ihre Persona zu entwickeln, die von Datenannotatoren und Gesprächsdesignern verwendet werden können. Auf diese Weise können Sie Ihre Persona gezielt gestalten und sie im gesamten Team und im Laufe der Zeit konsistent halten, während Ihre Anwendung mehreren Iterationen und Verfeinerungen unterzogen wird.

4.4 Gespräche hilfreich gestalten mit dem „Prinzip der Zusammenarbeit“

Hatten Sie jemals den Eindruck, mit einer Mauer zu sprechen, obwohl Sie tatsächlich mit einem Menschen gesprochen haben? Manchmal stellen wir fest, dass unsere Gesprächspartner einfach kein Interesse daran haben, das Gespräch zum Erfolg zu führen. Glücklicherweise laufen die Dinge in den meisten Fällen reibungsloser und der Mensch folgt intuitiv dem „Prinzip der Zusammenarbeit“, das vom Sprachphilosophen Paul Grice eingeführt wurde. Nach diesem Prinzip folgen Menschen, die erfolgreich miteinander kommunizieren, vier Maximen: Quantität, Qualität, Relevanz und Art.

Maxime der Menge

Das Quantitätsmaximum verlangt vom Redner, informativ zu sein und seinen Beitrag so informativ wie nötig zu gestalten. Auf der Seite des virtuellen Assistenten bedeutet dies auch, das Gespräch aktiv voranzutreiben. Betrachten Sie zum Beispiel diesen Ausschnitt aus einer E-Commerce-Mode-App:

Assistent: Was für Kleidungsstücke suchen Sie?

Benutzer: Ich suche ein Kleid in Orange.

Assistent: Nicht: Leider haben wir im Moment keine orangefarbenen Kleider.

Do: Leider haben wir keine Kleider in Orange, aber wir haben dieses tolle und sehr bequeme Kleid in Gelb: …

Der Benutzer hofft, Ihre App mit einem passenden Artikel zu verlassen. Wenn Sie das Gespräch abbrechen, weil Sie keine Elemente haben, die genau auf die Beschreibung passen würden, wird die Möglichkeit eines Erfolgs zunichte gemacht. Wenn Ihre App jedoch Vorschläge zu alternativen Artikeln macht, wirkt sie hilfreicher und lässt die Möglichkeit einer erfolgreichen Interaktion offen.

Insbesondere bei Sprachinteraktionen ist es wichtig, die richtige Balance zwischen der Bereitstellung aller Informationen, die der Benutzer möglicherweise für seinen Erfolg benötigt, und der Vermeidung einer Überforderung mit unnötigen Informationen zu finden, die die Interaktion trüben könnten.

Maxime der Qualität

Die Maxime der Qualität verlangt von Rednern, dass sie ehrlich sind und nichts sagen, was ihrer Meinung nach falsch ist oder für das es ihnen an ausreichenden Beweisen mangelt. Hier sind viel Subjektivität und persönliche Überzeugungen im Spiel – daher kann diese Maxime nicht direkt auf LLMs übertragen werden. Wie wir gesehen haben, neigen LLMs zu Halluzinationen, und dieses Risiko ist besonders hoch, wenn das Gespräch in weniger vertraute Gebiete abdriftet. Um irreführende Aussagen zu vermeiden und das Gespräch wieder in Gang zu bringen, können zusätzliche Leitplanken eingesetzt werden.

Maxime der Relevanz

Die Maxime der Relevanz verlangt von uns, – nun ja, relevant zu sein. Voraussetzung dafür ist, dass der virtuelle Assistent die wahre Absicht des Benutzers versteht. Hier ist ein Beispiel für einen Airline-Assistenten, der gegen diese Regel verstößt:

Benutzer: Ich brauche morgen früh einen Flug von Berlin nach Zürich.

Assistent: OK, ich habe die folgenden Flüge von Berlin nach Zürich für morgen früh gefunden. Flug BZ36294 verlässt Berlin um 6.30 Uhr und landet um 8 Uhr in Zürich. Flug BZ96294 verlässt Berlin um 8 Uhr morgens und landet um 9.30 Uhr. Flug BZ96294 verlässt Berlin um 8 Uhr morgens und landet um 9.30 Uhr in Zürich. Flug BZ95614 verlässt Berlin um 11 Uhr und landet um 12.30 Uhr in Zürich. Es besteht auch die Möglichkeit eines Anschlussfluges, in diesem Fall würden Sie Berlin um 11.45 Uhr verlassen und um 3 Uhr in Zürich ankommen.

Benutzer: Entschuldigung... könnten Sie das noch einmal wiederholen?

Der Assistent überhäuft den Benutzer mit detaillierten Informationen, die möglicherweise nicht relevant sind. Durch die Aufschlüsselung und die Anleitung des Benutzers, seinen Suchraum einzuschränken, wird der Dialog viel leichter verständlich:

Benutzer: Ich brauche morgen früh einen Flug von Berlin nach Zürich.

Assistent: Ok, ich habe Flüge gefunden, die um 6.30, 8 und 11 Uhr abfliegen. Um wie viel Uhr möchten Sie abreisen?

Benutzer: Ich muss vor 9 Uhr in Zürich sein.

Assistent: Okay, Sie können also den Flug BZ36294 nehmen. Es fährt um 6.30 Uhr ab und kommt um 8 Uhr an. Soll ich das Ticket für Sie kaufen?

Benutzer: Ja dank.

Maxime der Manieren

Schließlich besagt die Maxime der Manieren, dass unsere Sprechhandlungen klar, prägnant und geordnet sein sollten, wobei Mehrdeutigkeit und Unklarheit des Ausdrucks vermieden werden sollten. Ihr virtueller Assistent sollte technischen oder internen Jargon vermeiden und einfache, allgemein verständliche Formulierungen bevorzugen.

Während Grices Prinzipien für alle Konversationen unabhängig von einem bestimmten Bereich gelten, erfüllen LLMs, die nicht speziell für Konversationen ausgebildet sind, diese häufig nicht. Daher ist es beim Zusammenstellen Ihrer Trainingsdaten wichtig, über genügend Dialogbeispiele zu verfügen, damit Ihr Modell diese Prinzipien erlernen kann.

Der Bereich Conversational Design entwickelt sich ziemlich schnell. Unabhängig davon, ob Sie bereits KI-Produkte entwickeln oder über Ihren Karriereweg in der KI nachdenken, ermutige ich Sie, tiefer in dieses Thema einzusteigen (siehe die hervorragenden Einführungen in [5] und [6]). Da KI immer mehr zur Ware wird, werden gutes Design und eine vertretbare Datenstrategie zu zwei wichtigen Unterscheidungsmerkmalen für KI-Produkte.

Zusammenfassung

Fassen wir die wichtigsten Erkenntnisse aus dem Artikel zusammen. Zusätzlich bietet Abbildung 5 einen „Spickzettel“ mit den wichtigsten Punkten, den Sie als Referenz herunterladen können.

- LLMs verbessern die Konversations-KI: Large Language Models (LLMs) haben die Qualität und Skalierbarkeit von Konversations-KI-Anwendungen in verschiedenen Branchen und Anwendungsfällen erheblich verbessert.

- Konversations-KI kann Anwendungen mit vielen ähnlichen Benutzeranfragen (z. B. Kundenservice) oder die auf große Mengen unstrukturierter Daten zugreifen müssen (z. B. Wissensmanagement) einen großen Mehrwert bieten.

- Daten: Die Feinabstimmung von LLMs für Konversationsaufgaben erfordert hochwertige Konversationsdaten, die reale Interaktionen genau widerspiegeln. Crowdsourcing und LLM-generierte Daten können wertvolle Ressourcen für die Skalierung der Datenerfassung sein.

- Zusammenbau des Systems: Die Entwicklung von Konversations-KI-Systemen ist ein iterativer und experimenteller Prozess, der eine ständige Optimierung von Daten, die Feinabstimmung von Strategien und die Integration von Komponenten umfasst.

- Vermittlung von Konversationskompetenzen für LLMs: Zur Feinabstimmung von LLMs gehört es, ihnen beizubringen, spezifische Kommunikationsabsichten und -situationen zu erkennen und darauf zu reagieren.

- Hinzufügen externer Daten mit semantischer Suche: Durch die Integration externer und interner Datenquellen mithilfe der semantischen Suche werden die Antworten der KI verbessert, indem kontextbezogenere Informationen bereitgestellt werden.

- Gedächtnis und Kontextbewusstsein: Effektive Konversationssysteme müssen das Kontextbewusstsein aufrechterhalten, einschließlich der Verfolgung des Verlaufs des aktuellen Gesprächs und früherer Interaktionen, um aussagekräftige und kohärente Antworten zu liefern.

- Leitplanken setzen: Um verantwortungsvolles Verhalten zu gewährleisten, sollten Konversations-KI-Systeme Leitplanken einsetzen, um Ungenauigkeiten, Halluzinationen und Verletzungen der Privatsphäre zu verhindern.

- Persona-Design: Das Entwerfen einer konsistenten Persona für Ihren Gesprächsassistenten ist für die Schaffung eines zusammenhängenden und markenbezogenen Benutzererlebnisses von entscheidender Bedeutung. Persona-Merkmale sollten mit Ihren Produkt- und Markenattributen übereinstimmen.

- Sprache vs. Chat: Die Wahl zwischen Sprach- und Chat-Schnittstellen hängt von Faktoren wie der physischen Umgebung, dem emotionalen Kontext, der Funktionalität und den Designherausforderungen ab. Berücksichtigen Sie diese Faktoren, wenn Sie sich für die Schnittstelle für Ihre Konversations-KI entscheiden.

- Integration in verschiedene Kontexte: Konversations-KI kann in verschiedene Kontexte integriert werden, darunter Copiloten, synthetische Menschen, digitale Zwillinge und Datenbanken, jeweils mit spezifischen Anwendungsfällen und Anforderungen.

- Beachtung des Prinzips der Zusammenarbeit: Das Befolgen der Prinzipien Quantität, Qualität, Relevanz und Art in Gesprächen kann Interaktionen mit Konversations-KI hilfreicher und benutzerfreundlicher machen.

Bibliographie

[1] Heng-Tze Chen et al. 2022. LaMDA: Auf dem Weg zu sicheren, fundierten und qualitativ hochwertigen Dialogmodellen für alles.

[2] OpenAI. 2022. ChatGPT: Optimierung von Sprachmodellen für den Dialog. Abgerufen am 13. Januar 2022.

[3] Patrick Lewis et al. 2020. Retrieval-Augmented Generation für wissensintensive NLP-Aufgaben.

[4] Paul Grice. 1989. Studien zur Art und Weise der Worte.

[5] Cathy Pearl. 2016. Entwerfen von Sprachbenutzeroberflächen.

[6] Michael Cohen et al. 2004. Design der Sprachbenutzeroberfläche.

Hinweis: Sofern nicht anders angegeben, stammen alle Bilder vom Autor.

Dieser Artikel wurde ursprünglich veröffentlicht am Auf dem Weg zu Data Science und mit Genehmigung des Autors erneut auf TOPBOTS veröffentlicht.

Genießen Sie diesen Artikel? Melden Sie sich für weitere AI-Forschungsupdates an.

Wir werden Sie informieren, wenn wir weitere zusammenfassende Artikel wie diesen veröffentlichen.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.topbots.com/redefining-conversational-ai-with-large-language-models/