Einleitung

LeNet-5, ein bahnbrechendes Faltungs-Neuronales Netzwerk (CNN), das in den 1990er Jahren von Yann LeCun und seinem Team entwickelt wurde, war ein Wendepunkt in den Bereichen Computer Vision und Deep Learning. Diese bahnbrechende Architektur wurde ausdrücklich entwickelt, um die Erkennung handgeschriebener und maschinell gedruckter Zeichen zu revolutionieren. Im Gegensatz zu herkömmlichen Methoden führte LeNet-5 einen neuartigen Ansatz ein, der die Notwendigkeit einer manuellen Feature-Entwicklung überflüssig machte und Pixelbilder direkt über Faltungsschichten, Unterabtastung und vollständig verbundene Schichten verarbeitete. Sein Erfolg ging über die Zeichenerkennung hinaus, diente als Eckpfeiler für moderne Deep-Learning-Modelle und beeinflusste nachfolgende Architekturen in den Bereichen Computer Vision, Objekterkennung und Bildklassifizierung.

Yann LeCuns frühe Anwendung von Backpropagation-Algorithmen auf praktische Probleme legte den Grundstein für LeNet-5, das zum Lesen handgeschriebener Zeichen entwickelt wurde und sich bei der Identifizierung von Postleitzahlnummern des US-Postdienstes hervorgetan hat. Seine aufeinanderfolgenden Versionen und Anwendungen, wie beispielsweise die Fähigkeit, täglich Millionen von Schecks zu lesen, lösten bei Forschern einen Anstieg des Interesses aus, prägten die Landschaft neuronaler Netze und inspirierten die Entwicklung des Deep Learning.

Der Erfolg von LeNet-5 und nachfolgenden Anwendungen, beispielsweise Systemen, die Millionen von Schecks pro Tag lesen können, weckte bei Forschern großes Interesse an neuronalen Netzen. Während sich die heutigen leistungsstärksten neuronalen Netzwerkarchitekturen über LeNet-5 hinaus entwickelt haben, legten sein bahnbrechendes Design und seine Errungenschaften den Grundstein für zahlreiche nachfolgende Modelle und prägten und inspirierten Deep Learning maßgeblich. LeNet-5 bleibt ein Beweis für Innovation und ein dauerhaftes Symbol für die Entwicklung des maschinellen Lernens und der Bilderkennung.

Lernziele

- Entdecken Sie die historische Bedeutung und den Einfluss von LeNet-5 auf die Entwicklung von Deep Learning und Computer Vision.

- Vergleichen Sie LeNet-5 mit zeitgenössischen neuronalen Netzwerkarchitekturen und untersuchen Sie seinen grundlegenden Einfluss auf aktuelle Modelle im Deep Learning.

- Verstehen Sie die Architektur von LeNet-5, einschließlich seiner Faltungs-, Unterabtastungs- und vollständig verbundenen Schichten.

- Analysieren Sie praktische Anwendungen und Fallstudien, die die Wirksamkeit von LeNet-5 bei Bilderkennungsaufgaben veranschaulichen.

Dieser Artikel wurde als Teil des veröffentlicht Data Science-Blogathon.

Inhaltsverzeichnis

LeNet verstehen

LeNet, auch bekannt als LeNet-5, ist eine bahnbrechende Convolutional Neural Network (CNN)-Architektur, die von Yann LeCun und seinem Team in den 1990er Jahren entwickelt wurde. Es wurde speziell für handgeschriebene und maschinell gedruckte Zeichenerkennungsaufgaben entwickelt. Die Bedeutung von LeNet-5 liegt in der erfolgreichen Demonstration des hierarchischen Merkmalslernens und seiner Wirksamkeit bei der Zeichenerkennung. Seine Wirkung geht über seinen ursprünglichen Zweck hinaus, beeinflusst die Entwicklung moderner Deep-Learning-Modelle und dient als grundlegende Architektur für spätere Fortschritte in den Bereichen Computer Vision, Bilderkennung und verschiedene Anwendungen des maschinellen Lernens.

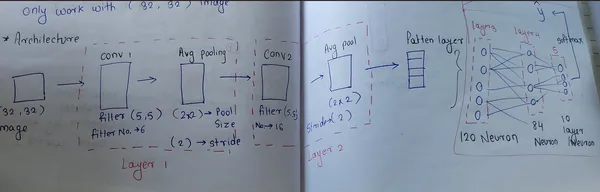

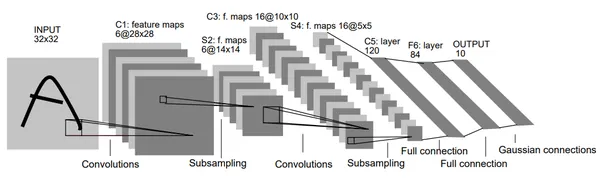

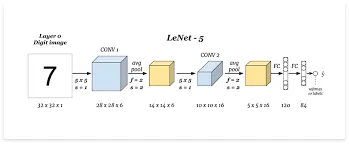

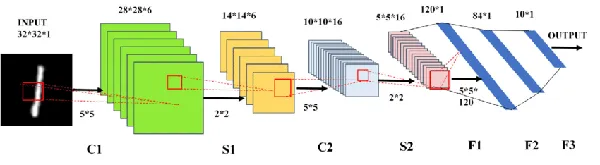

Die Architektur von LeNet

LeNet-5 ist ein Convolutional Neural Network (CNN) mit einer spezifischen Architektur, die bei Zeichenerkennungsaufgaben eingesetzt wird. Es besteht aus mehreren Schichten, mit Ausnahme der Eingabeschicht, die trainierbare Parameter enthält. Insbesondere verarbeitet es 32×32-Pixel-Bilder, die aussagekräftiger sind als die Zeichen in seiner Datenbank, und konzentriert sich auf die Zentrierung potenzieller Unterscheidungsmerkmale. Eingabepixelwerte werden für eine bessere Lerneffizienz normalisiert.

Die Architektur von LeNet kombiniert Faltungs-, Unterabtastungs- und vollständig verbundene Schichten mit spezifischen Konnektivitätsmustern. Es nutzt die Normalisierung für Eingabepixel und eine Reihe von Ebenen, um charakteristische Merkmale aus den Daten zu extrahieren und so ein effizientes Lernen zu ermöglichen. Darüber hinaus implementiert es einzigartige Strategien, um eine Sättigung der Aktivierungsfunktionen zu verhindern, und nutzt spezifische Verlustfunktionen für ein effizientes Training.

Einzigartige Strategien zur Verhinderung einer Sättigung

- Eingabeebene: LeNet verarbeitet 32×32-Pixel-Bilder, die aussagekräftiger sind als die Zeichen in der Datenbank, mit dem Ziel, potenzielle Unterscheidungsmerkmale in der Bildmitte zu erfassen.

- Faltungs- und Unterabtastschichten: Faltungsschichten Extrahieren Sie hauptsächlich Merkmale aus den Eingabedaten mithilfe lernbarer Filter oder Kernel. Jede Ebene umfasst mehrere Filter, die über die Eingabedaten (Bild) gleiten und elementweise Multiplikationen durchführen, um Feature-Maps zu erstellen. Die erste Ebene enthält 6 Filter der Größe 5×5, die mit der Tanh-Funktion aktiviert werden und zu Feature-Maps der Größe 28x28x6 führen. Nachfolgende Ebenen verwenden 16 Filter derselben Größe und erzeugen Feature-Maps im Format 10 x 10 x 16.

- Unterabtastungsebenen, auch Pooling-Schichten genannt, konzentrieren sich auf die Reduzierung der Dimensionalität der aus den Faltungsschichten erhaltenen Feature-Maps. Beim Pooling geht es um das Zusammenführen oder Downsampling der Feature-Maps, typischerweise durch Ermittlung des Maximalwerts (MaxPooling) oder Durchschnittswerts (AveragePooling) in definierten Regionen. Mit Filtergrößen von 2×2 und Schrittvariationen führen diese Ebenen nacheinander zu Feature-Map-Größen von 14x14x6 und 5x5x16.

- Vollständig verbundene Ebenen: Die Architektur umfasst vollständig verbundene Schichten mit der Bezeichnung Fx, die die endgültige Klassifizierung basierend auf den extrahierten Merkmalen verarbeiten. Eine vollständig verbundene Schicht mit 84 Neuronen und eine letzte Ausgabeschicht mit 10 Neuronen, wobei im ersteren die Tanh-Aktivierungsfunktion und im letzteren Softmax verwendet wird. Die Softmax-Funktion weist jeder Klasse Wahrscheinlichkeiten zu, wobei die höchste Wahrscheinlichkeit die Vorhersage bestimmt.

- Ausgabeschicht: LeNet verwendet Radialbasisfunktionseinheiten zur Klassifizierung mit unterschiedlichen Darstellungen von Zeichen zur Erkennung und Korrektur.

Schritt-für-Schritt-Workflow

[Input: 28x28x1]

|

[Conv2D: 6 filters, 5x5, tanh]

|

[Average Pooling: 2x2, stride 2]

|

[Conv2D: 16 filters, 5x5, tanh]

|

[Average Pooling: 2x2, stride 2]

|

[Flatten]

|

[Dense: 120, tanh]

|

[Dense: 84, tanh]

|

[Dense: 10, softmax (output)]

Faltungsschicht 1:

- Anzahl der Filter: 6

- Kerngröße: 5×5

- Aktivierungsfunktion: Tanh

- Eingabeform: 28x28x1

Durchschnittliche Poolingschicht 1:

- Poolgröße: 2×2

- Schritte: 2

Faltungsschicht 2:

- Anzahl der Filter: 16

- Kerngröße: 5×5

- Aktivierungsfunktion: Tanh

Durchschnittliche Poolingschicht 2:

- Poolgröße: 2×2

- Schritte: 2

Vollständig verbundene Schichten:

- Dichte Schicht mit 120 Einheiten und Tanh-Aktivierung.

- Dicke Schicht mit 84 Einheiten und Tanh-Aktivierung.

- Ausgabeschicht mit 10 Einheiten und Softmax-Aktivierung für die Klassifizierung mehrerer Klassen (MNIST-Datensatz).

Hauptmerkmale von LeNet

- CNN-Architektur: LeNet-5 war ein bahnbrechendes Faltungs-Neuronales Netzwerk mit einer strukturierten Architektur mit Faltungs- und Pooling-Schichten.

- Mustererkennung in handschriftlichen Ziffern: Ursprünglich für die handschriftliche Ziffernerkennung entwickelt und zeichnet sich durch hohe Genauigkeit bei der Identifizierung und Klassifizierung handgeschriebener Zeichen aus.

- Faltungs- und Pooling-Schichten: Einführung von Faltungsschichten zur Merkmalsextraktion und Pooling-Schichten zum Downsampling, wodurch das Netzwerk schrittweise hierarchische Darstellungen lernen kann.

- Aktivierung der Nichtlinearität: Verwendet Aktivierungsfunktionen für den hyperbolischen Tangens (tanh), die dem Netzwerk nichtlineare Fähigkeiten verleihen, die für die Erfassung komplexer Beziehungen innerhalb von Daten unerlässlich sind.

- Einfluss auf Deep Learning: Der Erfolg von LeNet-5 legte den Grundstein für zeitgenössische Deep-Learning-Modelle und beeinflusste maßgeblich die Entwicklung neuronaler Netze zur Bilderkennung und -klassifizierung.

Praktische Implementierung von LeNet:

Bibliothek importieren

Beginnen Sie mit dem Code zur Implementierung von LeNet-5 in TensorFlow mithilfe der Keras-API. Es ist ein guter Anfang, mit dem MNIST-Datensatz zu arbeiten.

import tensorflow as tf

from tensorflow import keras

from keras.datasets import mnist

from keras.layers import Dense, Flatten, Conv2D, AveragePooling2D

from keras.models import Sequential

from tensorflow.keras.utils import plot_modelDatensatz laden

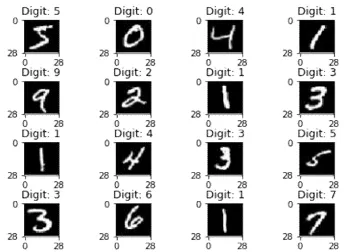

Laden Sie den MNIST-Datensatz für Trainings- und Testbilder. Diese Funktion lädt den Datensatz, der aus handgeschriebenen Ziffernbildern und ihren jeweiligen Beschriftungen besteht. Die Daten sind in Trainings- und Testsätze unterteilt.

(X_train, y_train), (X_test,y_test) = mnist.load_data()

Ausgang:

Umformen

Die Reshape-Funktion passt in diesem Zusammenhang die Form der Bilder an, um sie für die Verarbeitung in einem CNN geeignet zu machen. Die Form (28, 28, 1) bedeutet, dass die Bilder 28×28 Pixel groß sind und einen einzigen Kanal haben (Graustufenbilder). Diese Transformation ist notwendig, da die meisten CNNs erwarten, dass Bilder eine bestimmte Form haben, die oft als (Breite, Höhe, Kanäle) dargestellt wird.

#perfoming reshape

X_train = X_train.reshape(X_train.shape[0],28,28,1)

X_test = X_test.reshape(X_test.shape[0],28,28,1)

# Check the shape of data

X_train.shapeNormalisierung

Der von Ihnen bereitgestellte Codeausschnitt normalisiert die Bildpixelwerte in den Trainings- und Testdatensätzen. Durch Dividieren jedes Pixelwerts durch 255 wird sichergestellt, dass die Pixelwerte zwischen 0 und 1 liegen.

# Normalization ---> convert 0 to 1

X_train = X_train/255

X_test = X_test/255

Eine Hot-Codierung

Die Klassen für den MNIST-Datensatz werden in kategoriale Daten mit 10 Klassen umgewandelt. Jede Beschriftung wird in einen Vektor umgewandelt, in dem jedes Element eine Klasse darstellt, wobei 1 im Index der Klasse und 0 an anderer Stelle entspricht.

# One hot encoding

y_train = keras.utils.to_categorical(y_train,10)

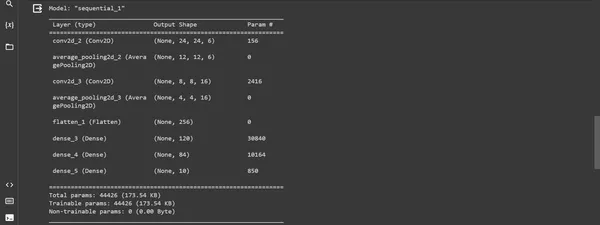

y_test = keras.utils.to_categorical(y_test,10)Modellbau

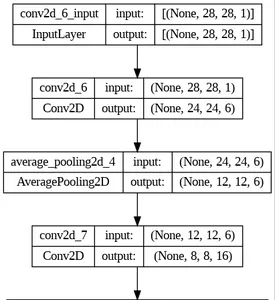

Dieser Codeausschnitt demonstriert die Erstellung des LeNet-5-Modells mithilfe der Keras Sequential API in TensorFlow. Es definiert die Schichten und ihre Konfigurationen und kompiliert das Modell mit einem Optimierer, einer Verlustfunktion und Metriken zur Auswertung.

model = Sequential()

# first layer

model.add(Conv2D(6, kernel_size=(5,5), padding="valid", activation="tanh", input_shape =(28,28,1)))

model.add(AveragePooling2D(pool_size=(2,2),strides=2, padding='valid'))

#second layer

model.add(Conv2D(16, kernel_size=(5,5), padding="valid", activation="tanh"))

model.add(AveragePooling2D(pool_size=(2,2),strides=2, padding='valid'))

# flatten layer

model.add(Flatten())

# ANN

model.add(Dense(120, activation='tanh'))

model.add(Dense(84, activation='tanh'))

model.add(Dense(10, activation='softmax'))

model.summary()Output:

Modellkompilierung

Das "kompilierenDie Methode bereitet das Modell auf das Training vor, indem sie die Optimierungsmethode, die Verlustfunktion und die zu überwachenden Metriken definiert.

model.compile(loss= keras.metrics.categorical_crossentropy, optimizer =keras.optimizers.Adam(),

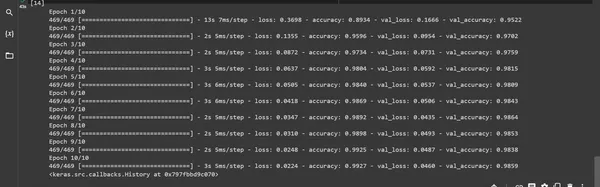

metrics= ['accuracy'])Modellausbildung: Die "passen Die Funktion trainiert das Modell anhand der bereitgestellten Trainingsdaten und validiert es anhand der Testdaten.

model.fit(X_train,y_train, batch_size=128,epochs=10 , verbose=1, validation_data=(X_test,y_test))Ausgabe:

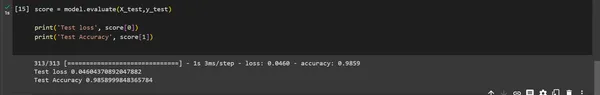

Modellbewertung

Das Modell "auswerten()" Die Funktion wird verwendet, um die Leistung des Modells anhand eines Testdatensatzes zu bewerten. Das Ergebnis liefert den Testverlust und die Testgenauigkeit.

score = model.evaluate(X_test,y_test)

print('Test loss', score[0])

print('Test Accuracy', score[1])

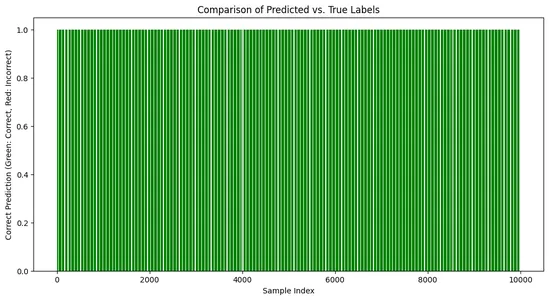

Visualisierung:

# Create a bar chart to visualize the comparison

import matplotlib.pyplot as plt

predicted_labels = np.argmax(predictions, axis=1)

# Compare predicted labels with true labels

correct_predictions = np.equal(predicted_labels, np.argmax(y_test, axis=1))

plt.figure(figsize=(12, 6))

plt.bar(range(len(y_test)), correct_predictions,

color=['green' if c else 'red' for c in correct_predictions])

plt.title('Comparison of Predicted vs. True Labels')

plt.xlabel('Sample Index')

plt.ylabel('Correct Prediction (Green: Correct, Red: Incorrect)')

plt.show()Ausgang:

Auswirkungen und Bedeutung von LeNet

Der Einfluss von LeNet geht weit über seine ursprüngliche Aufgabe hinaus. Sein Erfolg ebnete den Weg für eine tiefere Erforschung von Faltungs-Neuronalen Netzen (CNNs). Sein effizientes Design und seine Leistung bei Ziffernerkennungsaufgaben schaffen die Grundlage für Fortschritte in verschiedenen Computer-Vision-Anwendungen, einschließlich Bildklassifizierung, Objekterkennung und Gesichtserkennung.

- Revolution in der Erkennung handschriftlicher Zeichen: Der Erfolg von LeNet-5 bei der Erkennung handgeschriebener Ziffern und Zeichen führte zu einer Veränderung in verschiedenen praktischen Anwendungen, insbesondere bei der Erkennung von Postleitzahlen und Schecks. Seine Fähigkeit, Zeichen genau zu erkennen, trug zur weiten Verbreitung neuronaler Netze in diesen Anwendungen bei.

- Einfluss auf zukünftige Architekturen: Die architektonischen Designprinzipien von LeNet legten den Grundstein für zahlreiche nachfolgende CNN-Modelle. Sein innovativer Einsatz von Faltung, Unterabtastung und vollständig verbundenen Schichten inspirierte die Entwicklung komplexerer und anspruchsvollerer neuronaler Netzwerkarchitekturen für verschiedene bildbasierte Aufgaben.

- Förderung von Deep Learning: Der Erfolg von LeNet-5 zeigte das Potenzial von Deep-Learning-Netzwerken in der Bilderkennung und inspirierte zu weiterer Forschung und Entwicklung auf diesem Gebiet. Seine Auswirkungen auf die Forschungsgemeinschaft führten zu einem Paradigmenwechsel hin zur Nutzung tiefer neuronaler Netze für verschiedene visionsbasierte Aufgaben und legten den Grundstein für spätere Fortschritte in diesem Bereich.

Anwendung von LeNet

Die Auswirkungen von LeNet erstrecken sich auf zahlreiche reale Anwendungen. Von der Erkennung handgeschriebener Ziffern bei Postdiensten bis hin zur Revolutionierung des Gesundheitswesens durch Unterstützung bei der Analyse medizinischer Bilder haben die grundlegenden Konzepte von LeNet eine Vielzahl von Bereichen beeinflusst.

- Dokumentverarbeitung: Die Funktionen von LeNet werden beim Scannen und Analysieren von Dokumenten, beim Analysieren und Verarbeiten verschiedener Arten von Informationen, beim Extrahieren von Daten aus Dokumenten und bei der Automatisierung von Dateneingabeaufgaben in verschiedenen Branchen eingesetzt.

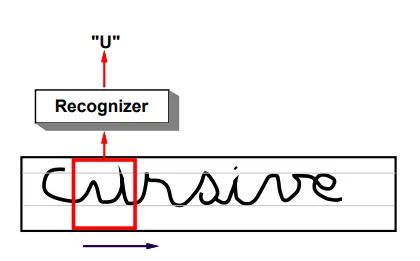

- Handschrifterkennung: Der Erfolg von LeNet bei der Erkennung handgeschriebener Zeichen und Ziffern ist nach wie vor von grundlegender Bedeutung für OCR-Systeme (Optical Character Recognition), die bei der Verarbeitung handgeschriebenen Textes in Bankschecks, Postdiensten und Formularen eingesetzt werden. Es eignet sich zum Digitalisieren historischer Dokumente und zum Erkennen handgeschriebener Informationen in verschiedenen Formaten.

- Biometrische Authentifizierung: Die Handschrifterkennungsfunktionen von LeNet wurden auf die Analyse von Unterschriften und Fingerabdrücken angewendet, um biometrische Authentifizierungsmethoden zu ermöglichen und Sicherheitssysteme zu verbessern.

- Echtzeit-Videoanalyse: Die grundlegenden Konzepte in LeNet dienen als Grundlage für Echtzeit-Videoanalysen wie Objektverfolgung, Überwachungssysteme, Gesichtserkennung und autonome Fahrzeuge.

- Bildklassifizierung: Die Prinzipien von LeNet beeinflussen moderne Bildklassifizierungssysteme. Zu den Anwendungen gehören die Klassifizierung und Kategorisierung von Objekten in Bildern für zahlreiche Bereiche, beispielsweise die Identifizierung von Objekten in Fotos, die Qualitätskontrolle in der Fertigung, die medizinische Bildanalyse und Sicherheitssysteme zur Objektidentifizierung.

Herausforderungen und Einschränkungen von LeNet

- Effizienz der Merkmalsextraktion: Mit der Entwicklung neuronaler Netzwerkarchitekturen verfügen neuere Modelle über effizientere Möglichkeiten zur Merkmalsextraktion, wodurch LeNet vergleichsweise weniger effizient bei der Identifizierung komplizierter Muster und Merkmale ist.

- Begrenzte Anpassungsfähigkeit: Seine Architektur, die für bestimmte Aufgaben wie die Erkennung handschriftlicher Zeichen konzipiert ist, ist möglicherweise nicht ohne wesentliche Änderungen direkt auf andere Domänen übertragbar.

- Skalierbarkeit: Obwohl es sich um ein bahnbrechendes Modell handelt, fehlt LeNet möglicherweise die Skalierbarkeit, um sich an moderne Datenverarbeitungs- und Deep-Learning-Anforderungen anzupassen.

- Überanpassung: LeNet kann beim Umgang mit komplexeren Datensätzen unter einer Überanpassung leiden, sodass zusätzliche Regularisierungstechniken erforderlich sind, um dieses Problem zu entschärfen.

Um diese Einschränkungen zu überwinden, haben Forscher komplexere CNN-Architekturen entwickelt und dabei ausgefeilte Techniken integriert, um diese Herausforderungen zu bewältigen und gleichzeitig die Leistung bei verschiedenen Aufgaben zu verbessern.

Zusammenfassung

LeNet ist als frühes Faltungs-Neuronales Netzwerk ein entscheidender Meilenstein im Deep Learning. Seine Einführung durch Yann LeCun und sein Team markierte einen Durchbruch, insbesondere bei der Erkennung handschriftlicher Zeichen und der Bildanalyse. Aufgrund der Einfachheit der Architektur und einer möglichen Überanpassung steht LeNet vor Herausforderungen bei der Anpassung an moderne komplexe Aufgaben und vielfältige Datensätze. Sein Erbe bleibt von entscheidender Bedeutung, inspiriert zu fortschrittlicheren Architekturen und spielt eine entscheidende Rolle bei der Entwicklung von Deep-Learning-Modellen.

Die Gründung von LeNet markierte einen entscheidenden Moment in der Geschichte des Deep Learning. Sein Erfolg bei Bilderkennungsaufgaben und -prinzipien hat den Grundstein für die Entwicklung moderner Faltungs-Neuronalnetze gelegt. Sein bleibendes Erbe prägt weiterhin die Landschaft der Computer Vision und der künstlichen Intelligenz.

Key Take Away

- Es führte das Konzept der Faltungs- und Unterabtastschichten ein und legte damit den Grundstein für moderne Deep-Learning-Architekturen.

- Obwohl LeNet zu seiner Zeit erhebliche Fortschritte gemacht hat, sind seine Grenzen bei der Verarbeitung vielfältiger und komplexer Datensätze deutlich geworden.

- Einführung von Faltungs- und Unterabtastschichten, die das Deep Learning revolutionieren.

Häufig gestellte Fragen

A: LeNet ist ein Convolutional Neural Network (CNN), das in den 1990er Jahren von Yann LeCun und seinem Team entwickelt wurde. Es wurde für die Erkennung handschriftlicher Zeichen und die Bildanalyse entwickelt.

A: Zu den Anwendungen von LeNet gehören optische Zeichenerkennung, Ziffern- und Buchstabenerkennung sowie Bildklassifizierungsaufgaben im Gesundheitswesen und in Sicherheitssystemen.

A: LeNet war als eine der ersten erfolgreichen Anwendungen von CNNs von entscheidender Bedeutung. Es diente als Eckpfeiler bei der Entwicklung neuronaler Netze für Bilderkennungsaufgaben.

A: Der Erfolg von LeNet führte zu einer Welle des Interesses an neuronalen Netzen und zu weiteren Fortschritten in den Bereichen Computer Vision und Deep Learning. Seine Designprinzipien und Architektur beeinflussten die Entwicklung vieler moderner KI-Modelle.

A: Die Architektur von LeNet führte das Konzept der hierarchischen Merkmalsextraktion durch Faltungsschichten ein. Ermöglicht eine effektive Mustererkennung, die in modernen Deep-Learning-Modellen zum Standard geworden ist.

Die in diesem Artikel gezeigten Medien sind nicht Eigentum von Analytics Vidhya und werden nach Ermessen des Autors verwendet.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.analyticsvidhya.com/blog/2023/11/lenet-architectural-insights-and-practical-implementation/