Det här är ett gästblogginlägg som skrivits tillsammans med Ben Veasey, Jeremy Anderson, Jordan Knight och June Li från Travelers.

Satellit- och flygbilder ger insikt i ett brett spektrum av problem, inklusive precisionsjordbruk, försäkringsriskbedömning, stadsutveckling och katastrofhantering. Utbildning av maskininlärningsmodeller (ML) för att tolka dessa data är dock flaskhalsade av kostsamma och tidskrävande mänskliga anteckningsinsatser. Ett sätt att övervinna denna utmaning är genom självövervakat lärande (SSL). Genom att träna på stora mängder omärkt bilddata lär sig självövervakade modeller bildrepresentationer som kan överföras till nedströmsuppgifter, såsom bildklassificering eller segmentering. Detta tillvägagångssätt producerar bildrepresentationer som generaliserar väl till osynliga data och minskar mängden märkt data som krävs för att bygga prestanda nedströmsmodeller.

I det här inlägget visar vi hur man tränar självövervakade syntransformatorer på överliggande bilder med hjälp av Amazon SageMaker. Resenärer samarbetade med Amazon Machine Learning Solutions Lab (nu känt som Generativt AI Innovation Center) för att utveckla detta ramverk för att stödja och förbättra användningsfall för flygbilder. Vår lösning är baserad på DINO algoritm och använder SageMaker distribuerade dataparallellt bibliotek (SMDDP) för att dela upp data över flera GPU-instanser. När förträningen är klar kan DINO-bildrepresentationerna överföras till en mängd olika nedströmsuppgifter. Detta initiativ ledde till förbättrade modellprestanda inom Traveller Data & Analytics-området.

Översikt över lösningen

Tvåstegsprocessen för att förträna syntransformatorer och överföra dem till övervakade nedströmsuppgifter visas i följande diagram.

I följande avsnitt ger vi en genomgång av lösningen med hjälp av satellitbilder från BigEarthNet-S2 dataset. Vi bygger på koden som finns i DINO-förvaret.

Förutsättningar

Innan du börjar behöver du tillgång till en SageMaker anteckningsbok instans och en Amazon enkel lagringstjänst (Amazon S3) skopa.

Förbered BigEarthNet-S2-datauppsättningen

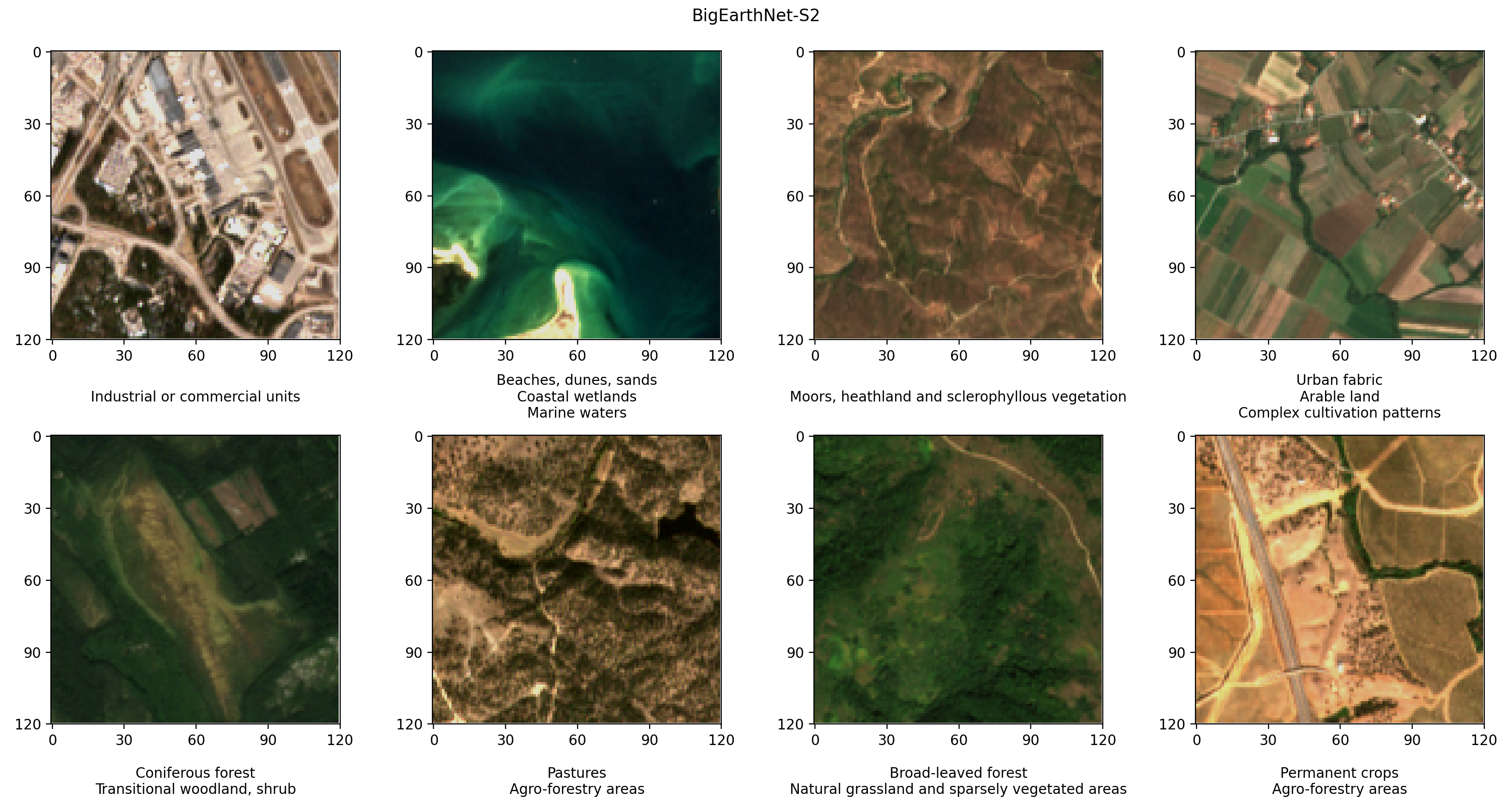

BigEarthNet-S2 är ett benchmark-arkiv som innehåller 590,325 2 multispektrala bilder som samlats in av Sentinel-2017-satelliten. Bilderna dokumenterar marktäcket, eller fysiska ytegenskaper, i tio europeiska länder mellan juni 2018 och maj 19. Typerna av marktäcke i varje bild, som betesmarker eller skogar, är kommenterade enligt XNUMX etiketter. Följande är några exempel på RGB-bilder och deras etiketter.

Det första steget i vårt arbetsflöde är att förbereda BigEarthNet-S2-datauppsättningen för DINO-utbildning och utvärdering. Vi börjar med att ladda ner datamängden från terminalen i vår SageMaker-anteckningsbokinstans:

Datauppsättningen har en storlek på cirka 109 GB. Varje bild lagras i sin egen mapp och innehåller 12 spektralkanaler. Tre band med 60 m rumslig upplösning (60 meter pixel höjd/bredd) är designade för att identifiera aerosoler (B01), vattenånga (B09) och moln (B10). Sex band med 20 m rumslig upplösning används för att identifiera vegetation (B05, B06, B07, B8A) och skilja mellan snö, is och moln (B11, B12). Tre band med 10 m rumslig upplösning hjälper till att fånga synligt och nära-infrarött ljus (B02, B03, B04, B8/B8A). Dessutom innehåller varje mapp en JSON-fil med bildens metadata. En detaljerad beskrivning av uppgifterna finns i BigEarthNet Guide.

För att utföra statistiska analyser av data och ladda bilder under DINO-träning, bearbetar vi de enskilda metadatafilerna till en gemensam geopandas Parquet-fil. Detta kan göras med hjälp av BigEarthNet Common och BigEarthNet GDF Builder hjälparpaket:

Den resulterande metadatafilen innehåller den rekommenderade bilduppsättningen, som exkluderar 71,042 XNUMX bilder som är helt täckta av årstidens snö, moln och molnskuggor. Den innehåller också information om förvärvsdatum, plats, marktäcke och tåg, validering och testdelning för varje bild.

Vi lagrar BigEarthNet-S2-bilderna och metadatafilen i en S3-hink. Eftersom vi använder äkta färgbilder under DINO-träning laddar vi bara upp de röda (B04), gröna (B03) och blå (B02) banden:

Datauppsättningen är cirka 48 GB stor och har följande struktur:

Träna DINO-modeller med SageMaker

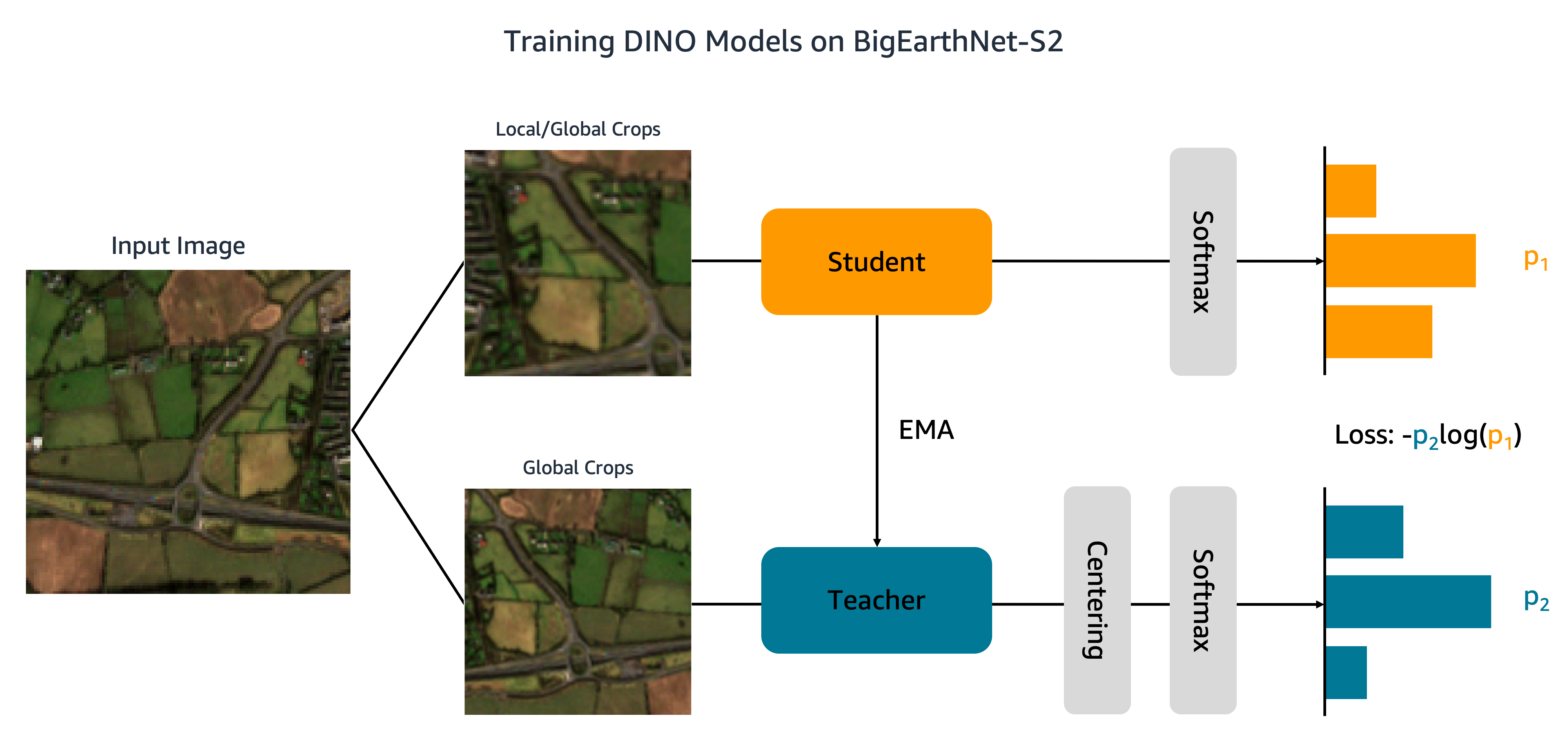

Nu när vår datauppsättning har laddats upp till Amazon S3 går vi över till att träna DINO-modeller på BigEarthNet-S2. Som visas i följande figur skickar DINO-algoritmen olika globala och lokala skördar av en indatabild till elev- och lärarnätverk. Elevnätverket lärs matcha utdata från lärarnätverket genom att minimera korsentropiförlusten. Elev- och lärarevikterna är sammankopplade med ett exponentiellt glidande medelvärde (EMA).

Vi gör två modifieringar av den ursprungliga DINO-koden. Först skapar vi en anpassad PyTorch-datauppsättningsklass för att ladda BigEarthNet-S2-bilderna. Koden skrevs ursprungligen för att bearbeta ImageNet-data och förväntar sig att bilder ska lagras klassvis. BigEarthNet-S2 är dock en datauppsättning med flera etiketter där varje bild finns i sin egen undermapp. Vår datauppsättningsklass laddar varje bild med hjälp av filsökvägen som lagras i metadata:

Denna datauppsättningsklass kallas in main_dino.py under träning. Även om koden innehåller en funktion för att en-hot-koda marktäckningsetiketterna, används dessa etiketter inte av DINO-algoritmen.

Den andra förändringen vi gör i DINO-koden är att lägga till stöd för SMDDP. Vi lägger till följande kod till init_distributed_mode funktion i util.py fil:

Med dessa justeringar är vi redo att träna DINO-modeller på BigEarthNet-S2 med SageMaker. För att träna på flera GPU:er eller instanser skapar vi en SageMaker PyTorch Estimator som matar in DINO-träningsskriptet, bild- och metadatafilens sökvägar och träningshyperparametrarna:

Den här koden anger att vi kommer att träna en liten visiontransformatormodell (21 miljoner parametrar) med en patchstorlek på 16 för 100 epoker. Det är bästa praxis att skapa en ny checkpoint_s3_uri för varje utbildningsjobb för att minska den initiala nedladdningstiden för data. Eftersom vi använder SMDDP måste vi träna på en ml.p3.16xlarge, ml.p3dn.24xlarge eller ml.p4d.24xlarge instans. Detta beror på att SMDDP endast är aktiverat för de största multi-GPU-instanserna. För att träna på mindre instanstyper utan SMDDP måste du ta bort distribution och debugger_hook_config argument från skattaren.

Efter att vi har skapat SageMaker PyTorch Estimator lanserar vi träningsjobbet genom att ringa till fit metod. Vi specificerar indataträningsdata med hjälp av Amazon S3 URI:er för BigEarthNet-S2 metadata och bilder:

SageMaker snurrar upp instansen, kopierar träningsskriptet och beroenden och börjar DINO-träning. Vi kan övervaka hur träningsjobbet fortskrider från vår Jupyter-anteckningsbok med hjälp av följande kommandon:

Vi kan också övervaka instansmätningar och visa loggfiler på SageMaker-konsolen under Träningsjobb. I följande figurer plottar vi GPU-användnings- och förlustfunktionen för en DINO-modell tränad på en ml.p3.16xlarge-instans med en batchstorlek på 128.

Under träning är GPU-användningen 83 % av ml.p3.16xlarge-kapaciteten (8 NVIDIA Tesla V100 GPU) och VRAM-användningen är 85 %. Förlustfunktionen minskar stadigt för varje epok, vilket indikerar att resultaten från student- och lärarnätverken blir mer lika. Totalt tar träningen cirka 11 timmar.

Överför lärande till nedströmsuppgifter

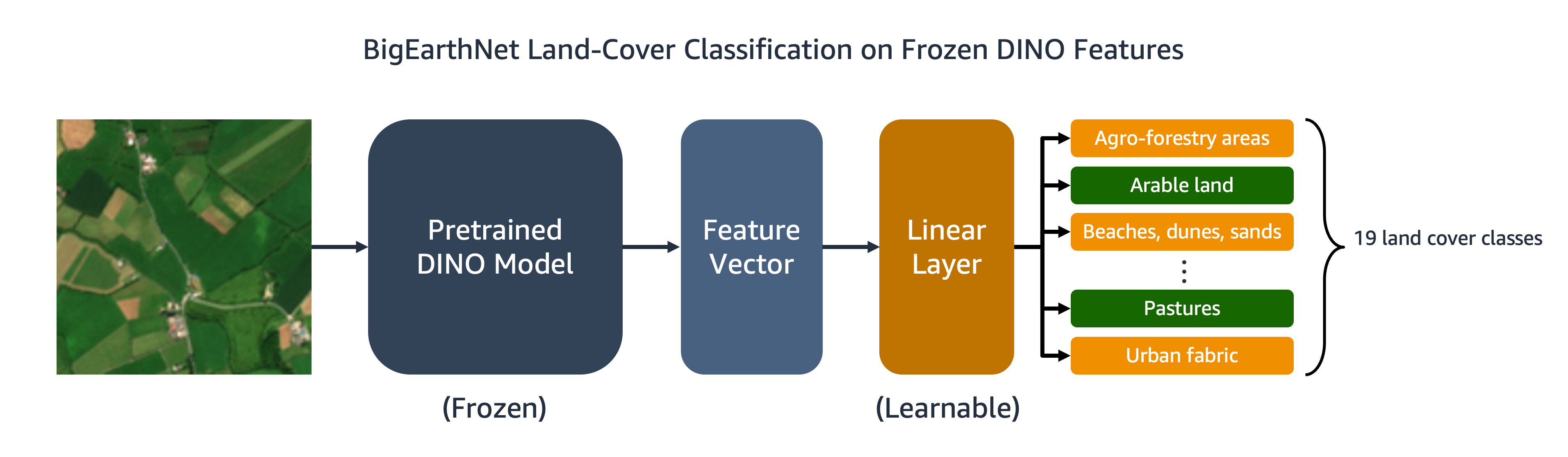

Vår utbildade DINO-modell kan överföras till nedströmsuppgifter som bildklassificering eller segmentering. I det här avsnittet använder vi de förtränade DINO-funktionerna för att förutsäga marktäckningsklasserna för bilder i BigEarthNet-S2-datauppsättningen. Som visas i följande diagram tränar vi en linjär klassificerare med flera etiketter ovanpå frusna DINO-funktioner. I det här exemplet är ingångsbilden associerad med åkermark och betesmarker.

Det mesta av koden för den linjära klassificeraren finns redan på plats i det ursprungliga DINO-förrådet. Vi gör några justeringar för vår specifika uppgift. Som tidigare använder vi den anpassade BigEarthNet-datauppsättningen för att ladda bilder under träning och utvärdering. Etiketterna för bilderna är one-hot-kodade som 19-dimensionella binära vektorer. Vi använder binär korsentropi för förlustfunktionen och beräkna genomsnittlig precision för att utvärdera modellens prestanda.

För att träna klassificeraren skapar vi en SageMaker PyTorch Estimator som kör träningsskriptet, eval_linear.py. Träningshyperparametrarna inkluderar detaljerna om DINO-modellarkitekturen och filsökvägen för modellens kontrollpunkt:

Vi börjar träningsjobbet med hjälp av fit metod, tillhandahåller Amazon S3-platserna för BigEarthNet-S2-metadata och träningsbilder och DINO-modellens kontrollpunkt:

När utbildningen är klar kan vi göra slutsatser om BigEarthNet-S2 testset med hjälp av SageMaker batch-transformation or SageMaker-bearbetning. I följande tabell jämför vi den linjära modellens genomsnittliga precision på testbilder med två olika DINO-bildrepresentationer. Den första modellen, ViT-S/16 (ImageNet), är den lilla kontrollpunkten för visiontransformatorer som ingår i DINO-förvaret och som var förtränad med hjälp av framvända bilder i ImageNet-datauppsättningen. Den andra modellen, ViT-S/16 (BigEarthNet-S2), är den modell vi producerade genom att förträna på överliggande bilder.

| Modell | Genomsnittlig precision |

|---|---|

| ViT-S/16 (ImageNet) | 0.685 |

| ViT-S/16 (BigEarthNet-S2) | 0.732 |

Vi finner att DINO-modellen förutbildad på BigEarthNet-S2 överförs bättre till marktäckningsklassificeringsuppgiften än DINO-modellen förutbildad på ImageNet, vilket resulterar i en 6.7 % ökning av den genomsnittliga precisionen.

Städa upp

Efter att ha slutfört DINO-utbildning och överföringsinlärning kan vi sanera våra resurser för att undvika avgifter. Vi stoppa eller ta bort vår anteckningsbok-instans och ta bort alla oönskade data eller modellartefakter från Amazon S3.

Slutsats

Det här inlägget demonstrerade hur man tränar DINO-modeller på överliggande bilder med SageMaker. Vi använde SageMaker PyTorch Estimators och SMDDP för att generera representationer av BigEarthNet-S2-bilder utan behov av explicita etiketter. Vi överförde sedan DINO-funktionerna till en nedströms bildklassificeringsuppgift, som innebar att förutsäga landtäckningsklassen för BigEarthNet-S2-bilder. För denna uppgift gav förträning på satellitbilder en ökning med 6.7 % i genomsnittlig precision jämfört med förträning på ImageNet.

Du kan använda den här lösningen som en mall för att träna DINO-modeller på storskaliga, omärkta flyg- och satellitbildersdatauppsättningar. För att lära dig mer om DINO och att bygga modeller på SageMaker, kolla in följande resurser:

Om författarna

Ben Veasey är Senior Associate Data Scientist på Travelers, som arbetar inom AI & Automation Accelerator-teamet. Med en djup förståelse för innovativ AI-teknik, inklusive datorseende, naturlig språkbehandling och generativ AI, är Ben dedikerad till att påskynda införandet av dessa tekniker för att optimera affärsprocesser och öka effektiviteten hos Travelers.

Jeremy Andersson är Director & Data Scientist på Travelers på AI & Automation Accelerator-teamet. Han är intresserad av att lösa affärsproblem med de senaste AI- och djupinlärningsteknikerna inklusive stora språkmodeller, grundläggande bildmodeller och generativ AI. Innan han började på resenärer tog Jeremy en doktorsexamen i molekylär biofysik från Johns Hopkins University och studerade även evolutionär biokemi. Utanför jobbet kan du hitta honom springa, träbearbeta eller omvilja sin trädgård.

Jordan Knight är en Senior Data Scientist som arbetar för resenärer på Business Insurance Analytics & Research Department. Hans passion är att lösa utmanande verkliga datorseendeproblem och att utforska nya toppmoderna metoder för att göra det. Han har ett särskilt intresse för den sociala påverkan av ML-modeller och hur vi kan fortsätta att förbättra modelleringsprocesser för att utveckla ML-lösningar som är rättvisa för alla. Jordan tog examen från MIT med en magisterexamen i Business Analytics. På fritiden kan du hitta honom som antingen klättrar, vandrar eller fortsätter att utveckla sina lite rudimentära matlagningsfärdigheter.

juni Li är datavetare på Travellers's Business Insurances Artificiell Intelligens-team, där hon leder och koordinerar arbetet i AI-bildportföljen. Hon brinner för att implementera innovativa AI-lösningar som ger betydande värde till affärspartners och intressenter. Hennes arbete har varit avgörande för att omvandla komplexa affärsutmaningar till möjligheter genom att utnyttja banbrytande AI-teknik.

Sourav Bhabesh är senior tillämpad forskare vid AWS Titan Labs, där han bygger FM-funktioner och -funktioner. Hans specialitet är Natural Language Processing (NLP) och brinner för djupinlärning. Utanför jobbet tycker han om att läsa böcker och att resa.

Laura Kulowski är en tillämpad forskare på Amazons Generative AI Innovation Center, där hon arbetar nära kunder för att bygga generativa AI-lösningar. På fritiden tycker Laura om att utforska nya platser på cykel.

Andrew Ang är Sr. Machine Learning Engineer på AWS. Förutom att hjälpa kunder att bygga AI/ML-lösningar tycker han om vattensporter, squash och tittar på rese- och matvloggar.

Mehdi Noori är en tillämpad vetenskapschef på Generative AI Innovation Center. Med en passion för att överbrygga teknik och innovation hjälper han AWS-kunder att låsa upp potentialen hos generativ AI, omvandla potentiella utmaningar till möjligheter för snabba experiment och innovation genom att fokusera på skalbar, mätbar och effektfull användning av avancerad AI-teknik och effektivisera vägen. till produktion.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- ChartPrime. Höj ditt handelsspel med ChartPrime. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/train-self-supervised-vision-transformers-on-overhead-imagery-with-amazon-sagemaker/