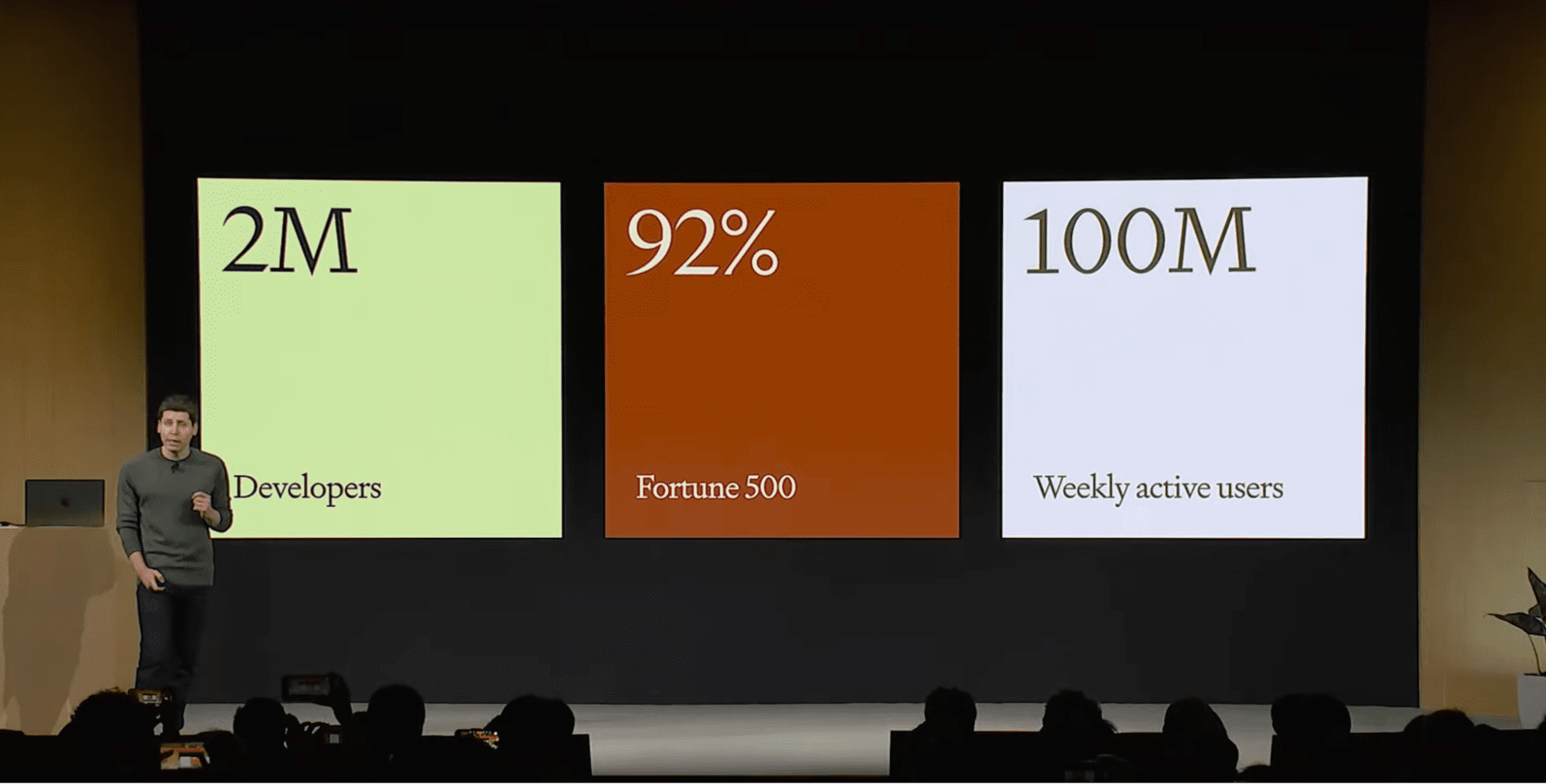

Sam Altman, OpenAI:s VD, presenterar produktanvändningssiffror på OpenAI Developer Day i oktober 2023. OpenAI överväger tre kundsegment: utvecklare, företag och allmänna användare. länk: https://www.youtube.com/watch?v=U9mJuUkhUzk&t=120s

På OpenAI Developer Day i oktober 2023, Sam Altman, OpenAI:s VD, visade en bild om produktanvändning inom tre olika kundsegment: utvecklare, företag och allmänna användare.

I den här artikeln kommer vi att fokusera på utvecklarsegmentet. Vi kommer att täcka vad en generativ AI-utvecklare gör, vilka verktyg du behöver behärska för det här jobbet och hur du kommer igång.

Medan ett fåtal företag är dedikerade till att göra generativa AI-produkter, är de flesta generativa AI-utvecklare baserade i andra företag där detta inte har varit det traditionella fokuset.

Anledningen till detta är att generativ AI har användningsområden som gäller ett brett spektrum av verksamheter. Fyra vanliga användningsområden för generativ AI gäller för de flesta företag.

Chatbots

Bild genererad av DALL·E 3

Medan chatbots har varit mainstream i mer än ett decennium, har majoriteten av dem varit hemska. Vanligtvis är den vanligaste första interaktionen med en chatbot att fråga den om du kan prata med en människa.

Framstegen inom generativ AI, särskilt stora språkmodeller och vektordatabaser, gör att det inte längre är sant. Nu när chatbots kan vara trevliga för kunder att använda, är alla företag upptagna (eller åtminstone borde vara upptagna) med att krypa för att uppgradera dem.

Artikeln Effekten av generativ AI på chatbots från MIT Technology Review har en bra överblick över hur chatbotarnas värld förändras.

Semantisk sökning

Sökning används på en mängd olika platser, från dokument till shoppingwebbplatser till själva internet. Traditionellt använder sökmotorer mycket nyckelord, vilket skapar problemet att sökmotorn behöver programmeras för att vara medveten om synonymer.

Tänk till exempel fallet med att försöka söka igenom en marknadsföringsrapport för att hitta delen om kundsegmentering. Du trycker på CMD+F, skriver "segmentering" och bläddrar igenom träffar tills du hittar något. Tyvärr missar du de fall där författaren till dokumentet skrev "klassificering" istället för "segmentering".

Semantisk sökning (söker vidare betyder) löser detta synonymproblem genom att automatiskt hitta text med liknande betydelser. Tanken är att du använder en inbäddningsmodell – en djupinlärningsmodell som konverterar text till en numerisk vektor enligt dess betydelse – och att sedan hitta relaterad text är bara enkel linjär algebra. Ännu bättre, många inbäddningsmodeller tillåter andra datatyper som bilder, ljud och video som indata, vilket låter dig tillhandahålla olika indatatyper eller utdatatyper för din sökning.

Precis som med chatbots försöker många företag förbättra sina webbsökningsmöjligheter genom att använda sig av semantisk sökning.

Denna handledning på Semantisk sökning från Zillus, tillverkaren av Milvus vektordatabasen, ger en bra beskrivning av användningsfallen.

Personligt innehåll

Bild genererad av DALL·E 3

Generativ AI gör innehållsskapande billigare. Detta gör det möjligt att skapa skräddarsytt innehåll för olika grupper av användare. Några vanliga exempel är att ändra marknadsföringstexten eller produktbeskrivningarna beroende på vad du vet om användaren. Du kan också tillhandahålla lokaliseringar för att göra innehåll mer relevant för olika länder eller demografi.

Denna artikel på Hur man uppnår hyperpersonalisering med generativa AI-plattformar från Salesforce Chief Digital Evangelist Vala Afshar täcker fördelarna och utmaningarna med att använda generativ AI för att anpassa innehåll.

Naturliga språkgränssnitt till programvara

När programvaran blir mer komplicerad och fullt utrustad, blir användargränssnittet uppsvällt med menyer, knappar och verktyg som användare inte kan hitta eller ta reda på hur de ska använda. Gränssnitt för naturliga språk, där användare vill förklara vad de vill ha i en mening, kan dramatiskt förbättra användbarheten av programvara. "Gränssnitt för naturligt språk" kan hänvisa till antingen talade eller maskinskrivna sätt att kontrollera programvara. Nyckeln är att du kan använda vanliga meningar som kan förstås av människor.

Business intelligence-plattformar är några av de tidigare användare av detta, med naturliga språkgränssnitt som hjälper affärsanalytiker att skriva mindre datamanipulationskod. Applikationerna för detta är dock ganska obegränsade: nästan varje funktionsrik mjukvara kan dra nytta av ett naturligt språkgränssnitt.

Denna Forbes-artikel om Omfamnar AI och naturliga språkgränssnitt från Gaurav Tewari, grundare och Managing Partner för Omega Venture Partners, har en lättläst beskrivning av varför naturliga språkgränssnitt kan hjälpa programvarans användbarhet.

För det första behöver du en generativ AI-modell! För att arbeta med text innebär det en stor språkmodell. GPT 4.0 är den nuvarande guldstandarden för prestanda, men det finns många alternativ med öppen källkod som Llama 2, Falcon och Mistral.

För det andra behöver du en vektordatabas. Pinecone är den mest populära kommersiella vektordatabasen, och det finns några alternativ med öppen källkod som Milvus, Weaviate och Chroma.

När det gäller programmeringsspråk tycks gemenskapen ha bestämt sig kring Python och JavaScript. JavaScript är viktigt för webbapplikationer och Python passar alla andra.

Utöver dessa är det bra att använda ett generativt ramverk för AI-applikationer. De två främsta utmanarna är LangChain och LlamaIndex. LangChain är ett bredare ramverk som låter dig utveckla ett brett utbud av generativa AI-applikationer, och LlamaIndex är mer fokuserat på att utveckla semantiska sökapplikationer.

Om du gör ett sökprogram, använd LlamaIndex; annars, använd LangChain.

Det är värt att notera att landskapet förändras mycket snabbt, och många nya AI-startups dyker upp varje vecka, tillsammans med nya verktyg. Om du vill utveckla en applikation, förvänta dig att byta delar av programvaran oftare än du skulle göra med andra applikationer.

Framför allt dyker nya modeller upp regelbundet, och den bästa prestanda för ditt användningsfall kommer sannolikt att ändras. Ett vanligt arbetsflöde är att börja använda API:er (till exempel OpenAI API för API och Pinecone API för vektordatabasen) eftersom de är snabba att utveckla. När din användarbas växer kan kostnaden för API-anrop bli betungande, så vid denna tidpunkt kanske du vill byta till verktyg med öppen källkod (ekosystemet Hugging Face är ett bra val här).

Som med alla nya projekt, börja enkelt! Det är bäst att lära sig ett verktyg i taget och senare ta reda på hur man kombinerar dem.

Det första steget är att skapa konton för alla verktyg du vill använda. Du behöver utvecklarkonton och API-nycklar för att kunna använda plattformarna.

En nybörjarguide till OpenAI API: Handledning och bästa praxis innehåller steg-för-steg-instruktioner om hur du konfigurerar ett OpenAI-utvecklarkonto och skapar en API-nyckel.

På samma sätt Bemästra vektordatabaser med Pinecone Tutorial: En omfattande guide innehåller detaljerna för att installera Pinecone.

Vad är Hugging Face? AI-gemenskapens Oasis med öppen källkod förklarar hur du kommer igång med Hugging Face.

Att lära sig LLM

För att komma igång med att använda LLM som GPT programmatiskt är det enklaste att lära sig hur man anropar API:et för att skicka en uppmaning och ta emot ett meddelande.

Även om många uppgifter kan uppnås med en enda utbyte fram och tillbaka med LLM, kräver användningsfall som chatbots en lång konversation. OpenAI tillkännagav nyligen en "trådar"-funktion som en del av deras Assistants API, som du kan lära dig om i Handledning för OpenAI Assistants API.

Detta stöds inte av alla LLM, så du kan också behöva lära dig hur du manuellt hanterar konversationens tillstånd. Du måste till exempel bestämma vilka av de tidigare meddelandena i konversationen som fortfarande är relevanta för den aktuella konversationen.

Utöver detta behöver du inte sluta när du bara arbetar med text. Du kan prova att arbeta med andra medier; till exempel transkribera ljud (tal till text) eller generera bilder från text.

Att lära sig vektordatabaser

Det enklaste användningsfallet för vektordatabaser är semantisk sökning. Här använder du en inbäddningsmodell (se Introduktion till textinbäddningar med OpenAI API) som omvandlar texten (eller annan inmatning) till en numerisk vektor som representerar dess betydelse.

Du infogar sedan dina inbäddade data (de numeriska vektorerna) i vektordatabasen. Att söka innebär bara att skriva en sökfråga och fråga vilka poster i databasen som motsvarar det du frågade efter.

Till exempel kan du ta några vanliga frågor om en av ditt företags produkter, bädda in dem och ladda upp dem i en vektordatabas. Sedan ställer du en fråga om produkten, och den kommer att returnera de närmaste matchningarna och konvertera tillbaka från en numerisk vektor till den ursprungliga texten.

Kombinera LLM och vektordatabaser

Du kanske upptäcker att det inte räcker att direkt returnera textinmatningen från vektordatabasen. Ofta vill man att texten ska bearbetas på ett sätt som besvarar frågan mer naturligt.

Lösningen på detta är en teknik som kallas retrieval augmented generation (RAG). Detta innebär att efter att du har hämtat din text från vektordatabasen, skriver du en uppmaning för en LLM och inkluderar sedan den hämtade texten i din prompt (du förstärka uppmaningen med hämtas text). Sedan ber du LLM att skriva ett mänskligt läsbart svar.

I exemplet med att svara på användarfrågor från vanliga frågor, skulle du skriva en uppmaning med platshållare, som följande.

"""

Please answer the user's question about {product}.

---

The user's question is : {query}

---

The answer can be found in the following text: {retrieved_faq}

"""

Det sista steget är att kombinera dina RAG-kunskaper med förmågan att hantera meddelandetrådar för att hålla en längre konversation. Voila! Du har en chatbot!

DataCamp har en serie med nio kod-medföljer för att lära dig att bli en generativ AI-utvecklare. Du behöver grundläggande Python-färdigheter för att komma igång, men alla AI-koncept lärs ut från grunden.

Serien undervisas av toppinstruktörer från Microsoft, Pinecone, Imperial College London och Fidelity (och jag!).

Du kommer att lära dig om alla ämnen som behandlas i den här artikeln, med sex kodkombinationer fokuserade på den kommersiella stacken av OpenAI API, Pinecone API och LangChain. De andra tre handledningarna är fokuserade på Hugging Face-modeller.

I slutet av serien kommer du att kunna skapa en chatbot och bygga NLP- och datorvisionsapplikationer.

Richie Cotton är dataevangelist på DataCamp. Han är värd för DataFramed-podden, han har skrivit 2 böcker om R-programmering och skapat 10 DataCamp-kurser om datavetenskap som har tagits av över 700 XNUMX elever.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.kdnuggets.com/4-steps-to-become-a-generative-ai-developer?utm_source=rss&utm_medium=rss&utm_campaign=4-steps-to-become-a-generative-ai-developer