Conheça o Mixtral 8x7B da Mistral AI. É muito inteligente para lidar com big data e pode ajudar em tarefas como tradução de idiomas e geração de código. Desenvolvedores de todo o mundo estão entusiasmados com seu potencial para agilizar seus projetos e melhorar a eficiência. Com seu design fácil de usar e recursos impressionantes, o Mixtral 8x7B está rapidamente se tornando uma ferramenta essencial para o desenvolvimento de IA.

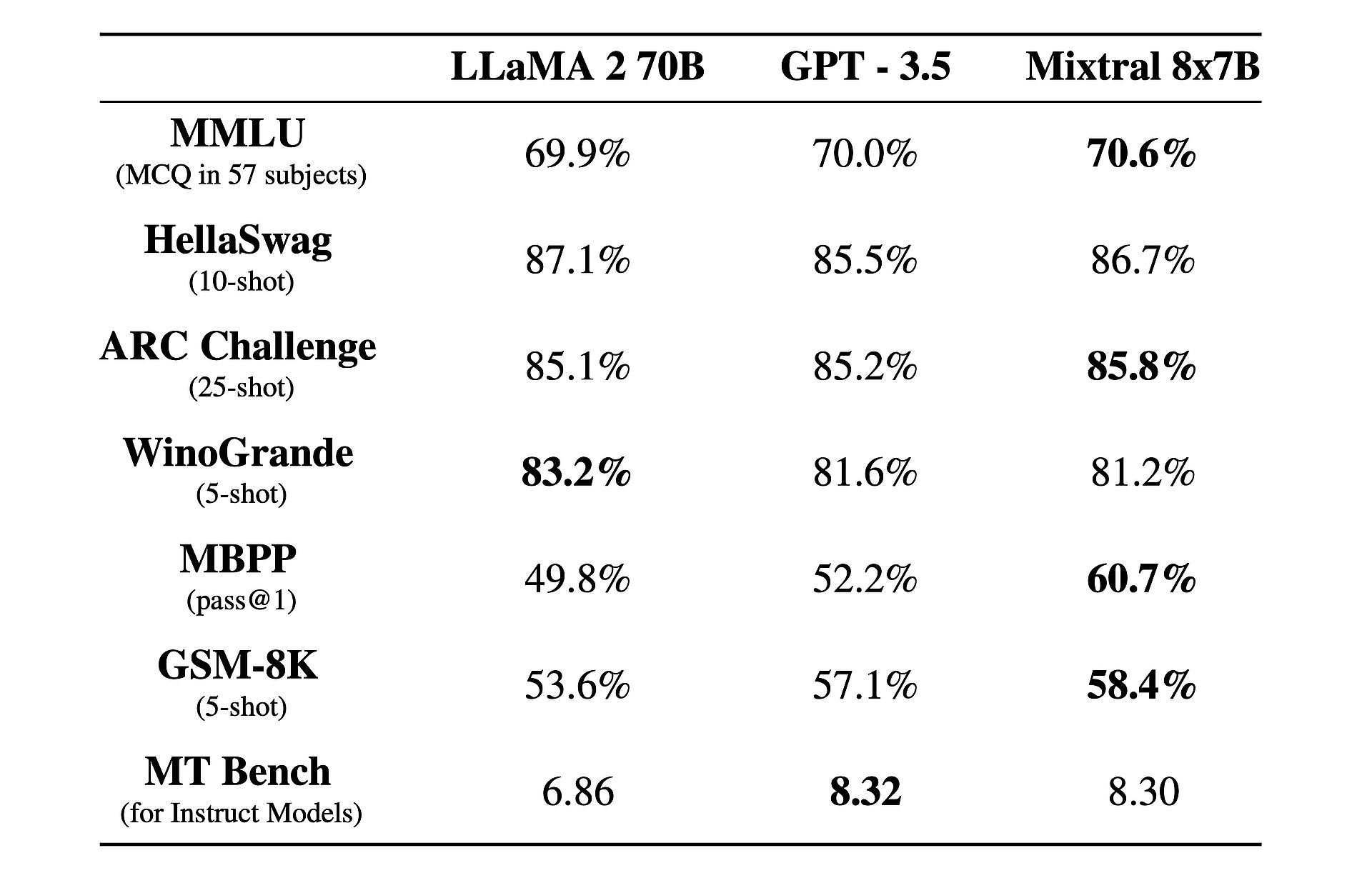

Além disso, há um fato interessante sobre isso: seu desempenho é melhor do que GPT-3.5 e lhama 2!

O que é Mixtral 8x7B?

Mixtral 8x7B é um modelo avançado de inteligência artificial desenvolvido pela Mistral AI. Ele usa uma arquitetura exclusiva chamada mistura esparsa de especialistas (SMoE) para processar grandes quantidades de dados com eficiência. Apesar de sua complexidade, o Mixtral foi projetado para ser fácil de usar e adaptável a diversas tarefas, como tradução de idiomas e geração de código. Ele supera outros modelos em termos de velocidade e precisão, tornando-o uma ferramenta valiosa para desenvolvedores. Além disso, está disponível sob a licença Apache 2.0, permitindo que qualquer pessoa o use e modifique livremente.

Quer aprender mais? Em sua essência, o Mixtral 8x7B opera como um modelo somente decodificador, aproveitando uma abordagem única onde um bloco feedforward seleciona entre oito grupos distintos de parâmetros, chamados de “especialistas”. Esses especialistas são escolhidos dinamicamente por uma rede de roteadores para processar cada token, melhorando a eficiência e o desempenho e minimizando a sobrecarga computacional.

Um dos principais pontos fortes da Mixtral reside na sua adaptabilidade e escalabilidade. Capaz pode lidar com contextos de até 32,000 tokens e oferecer suporte a vários idiomas, incluindo inglês, francês, italiano, alemão e espanhol. Mixtral capacita os desenvolvedores a realizar uma ampla gama de tarefas com facilidade e precisão.

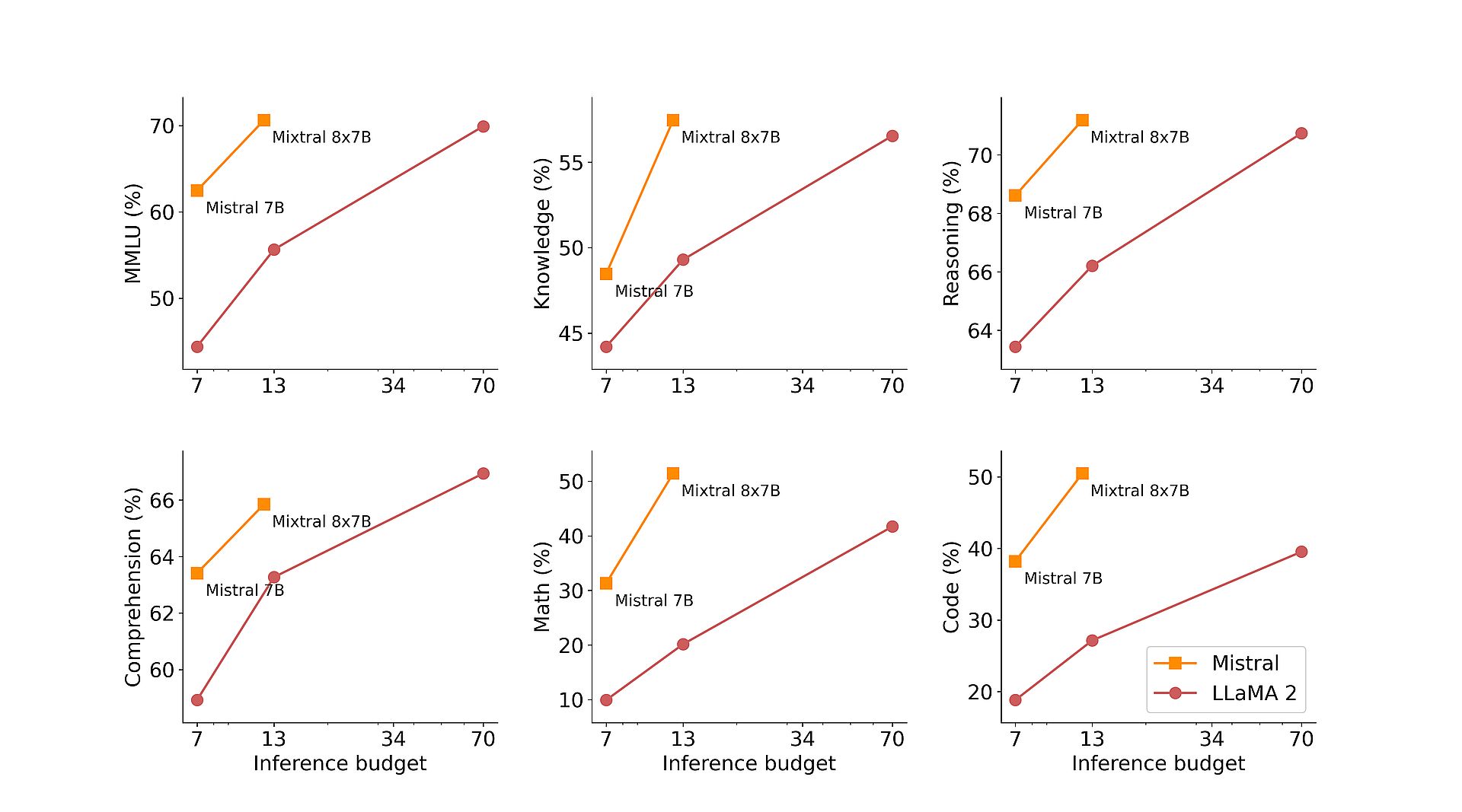

O que realmente diferencia a Mixtral é a sua relação desempenho-custo. Com um total impressionante de 46.7 bilhões de parâmetros, o Mixtral alcança uma eficiência notável ao utilizar apenas uma fração desses parâmetros por token, resultando em tempos de inferência mais rápidos e despesas computacionais reduzidas.

Além disso, o pré-treinamento da Mixtral em extensos conjuntos de dados extraídos da web aberta garante robustez e versatilidade em aplicações do mundo real. Seja na geração de código, na tradução de idiomas ou na análise de sentimentos, o Mixtral oferece resultados excelentes em vários benchmarks, superando modelos tradicionais como o Llama 2 e até mesmo superando o GPT3.5 em muitos casos.

Para aprimorar ainda mais suas capacidades, a Mistral AI introduziu o Mixtral 8x7B Instruct, uma variante especializada otimizada para tarefas de acompanhamento de instruções. Alcançando uma pontuação impressionante de 8.30 no MT-Bench, o Mixtral 8x7B Instruct solidifica sua posição como um modelo de código aberto líder para ajuste fino supervisionado e otimização de preferências.

Além de suas proezas técnicas, a Mistral AI está comprometida em democratizar o acesso ao Mixtral, contribuindo para o projeto vLLM, permitindo integração e implantação perfeitas com ferramentas de código aberto. Isso permite que os desenvolvedores aproveitem o poder do Mixtral em uma ampla gama de aplicações e plataformas, impulsionando a inovação e o avanço no campo da inteligência artificial.

Groq IA, e não Grok, critica Elon Musk com seu “LLM mais rápido”

Como usar Mixtral 8x7B

Mixtral 8x7B é acessível através do endpoint mistral-small do Mistral, que está no fase de testes betae. Se estiver interessado em obter acesso antecipado a todos os endpoints generativos e incorporados do Mistral, você pode cadastre-se agora. Ao registrar-se, você estará entre os primeiros a experimentar todos os recursos do Mixtral 8x7B e explorar suas soluções inovadoras.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/