Seguindo o sucesso lançamento do 'Código Llama 70B' em janeiro, a Meta lançou agora a última iteração de seu poderoso LLM de código aberto, Llama 3, na infraestrutura do Amazon AWS.

Em um e-mail para TechStartups, a Amazon revelou que “Meta Llama 3 agora está acessível através JumpStart do Amazon SageMaker.” Esta versão mais recente segue os passos de seu antecessor Llama 2 que está acessível no Amazon SageMaker JumpStart e Rocha Amazônica desde o ano anterior.

Apresentando dois tamanhos de parâmetro – 8B e 70B com comprimento de contexto de 8k – o Llama 3 promete atender a uma ampla gama de casos de uso com melhorias no raciocínio, geração de código e acompanhamento de instruções. A arquitetura do Llama 3 adota um design de transformador somente decodificador acoplado a um novo tokenizer, resultando em maior desempenho do modelo encapsulado em um tamanho de 128k.

“O Llama 3 vem em dois tamanhos de parâmetros – 8B e 70B com comprimento de contexto de 8k – que podem suportar uma ampla gama de casos de uso com melhorias no raciocínio, geração de código e acompanhamento de instruções”, escreveu a Amazon.

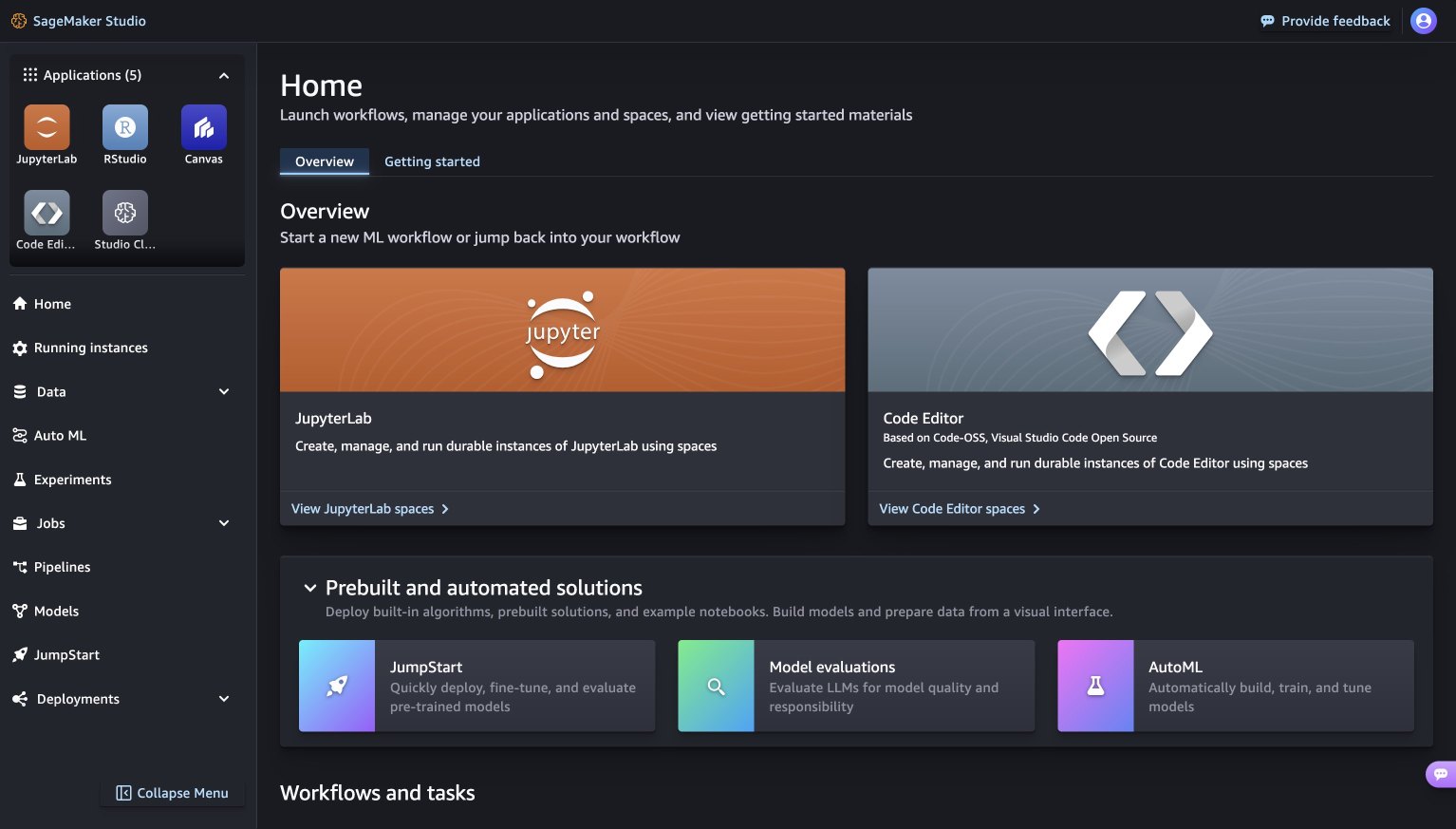

Se estiver usando o SageMaker Studio, você encontrará o SageMaker JumpStart ali mesmo, oferecendo um monte de coisas úteis, como modelos pré-treinados, notebooks e soluções prontas. Basta acessar a seção “Soluções pré-construídas e automatizadas” e está tudo pronto!

AWS SageMaker JumpStart (Fonte: Amazon AWS)

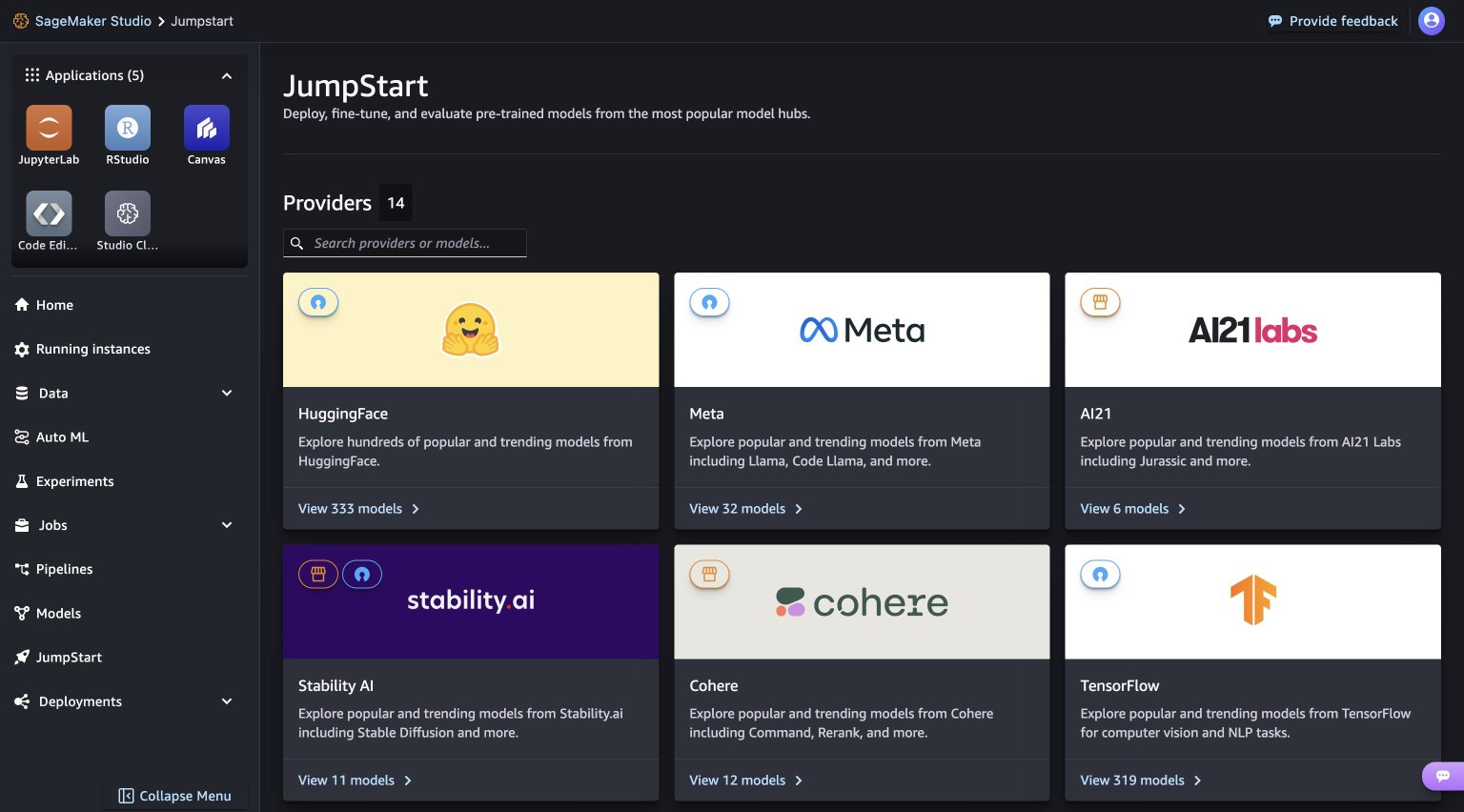

Quando você acessa a página SageMaker JumpStart, é bastante simples encontrar modelos diferentes. Basta navegar pelos hubs, que são basicamente seções com os nomes das pessoas que fornecem os modelos. Por exemplo, se você estiver procurando por modelos Llama 3, vá para o hub Meta. E se você não identificá-los imediatamente, não se preocupe – tente atualizar sua versão do SageMaker Studio desligando-o e reiniciando. Isso deve funcionar!

AWS JumpStart (Fonte: Amazon AWS)

Além disso, a Meta aprimorou os procedimentos pós-treinamento para reduzir significativamente as taxas de falsas recusas, melhorar o alinhamento e aumentar a diversidade nas respostas do modelo. Os usuários agora podem aproveitar as vantagens combinadas da capacidade do Llama 3 e dos controles de MLOps, aproveitando os recursos do Amazon SageMaker, como SageMaker Pipelines, SageMaker Debugger ou logs de contêiner. Além disso, o modelo será implantado dentro dos limites seguros da AWS sob seus controles de VPC, fortalecendo as medidas de segurança de dados.

Atualmente, a AWS é o único provedor de nuvem que fornece aos clientes acesso aos modelos básicos mais procurados e de última geração. A Amazon Bedrock assume consistentemente a liderança na disponibilização imediata destes modelos populares:

- Amazon Bedrock se destaca como o principal e exclusivo serviço gerenciado a oferecer todos os modelos Anthropic Claude 3 – Opus, Sonnet e Haiku – conforme disponibilidade geral.

- A AWS introduziu todos os modelos Mistral AI, incluindo Mistral Large, no Amazon Bedrock.

- A Amazon Bedrock liderou a disponibilização do Meta Llama 2 por meio de uma API gerenciada.

Funcionando como um serviço totalmente gerenciado, o Amazon Bedrock serve como destino para uma ampla seleção de modelos básicos de alto desempenho de titãs do setor, como AI21 Labs, Amazon, Anthropic, Cohere, Meta, Mistral AI e Stability AI, todos acessível através de uma única API. Além disso, fornece um conjunto abrangente de recursos que abrange agentes, proteções, bases de conhecimento e avaliação de modelos, capacitando as organizações a criar aplicações generativas de IA com ênfase em segurança, privacidade e IA responsável. Com dezenas de milhares de organizações em todo o mundo contando com o Amazon Bedrock, ele solidificou seu status como um player fundamental no domínio dos aplicativos generativos de IA.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://techstartups.com/2024/04/18/meta-launches-its-llama-3-open-source-llm-on-amazon-aws/