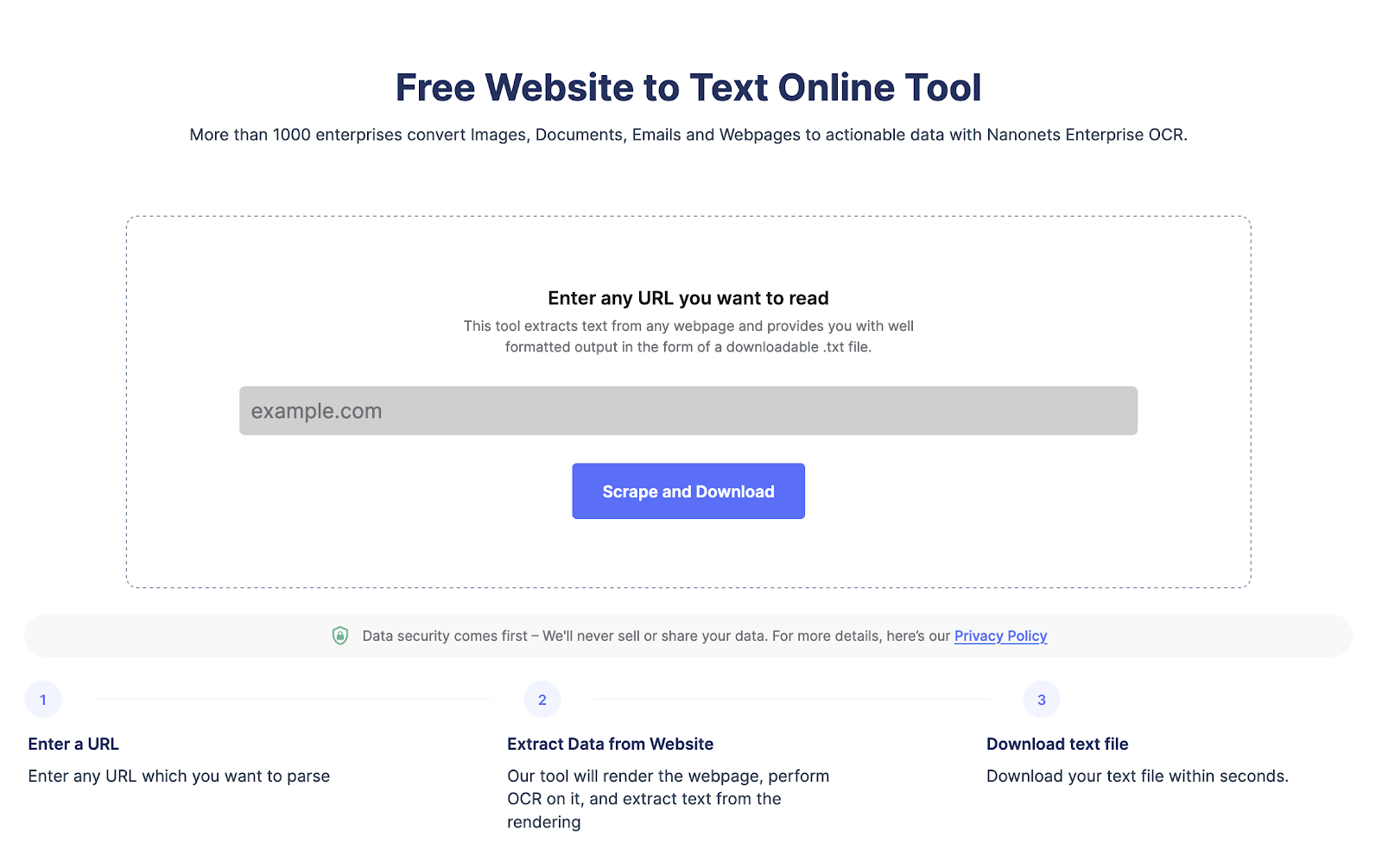

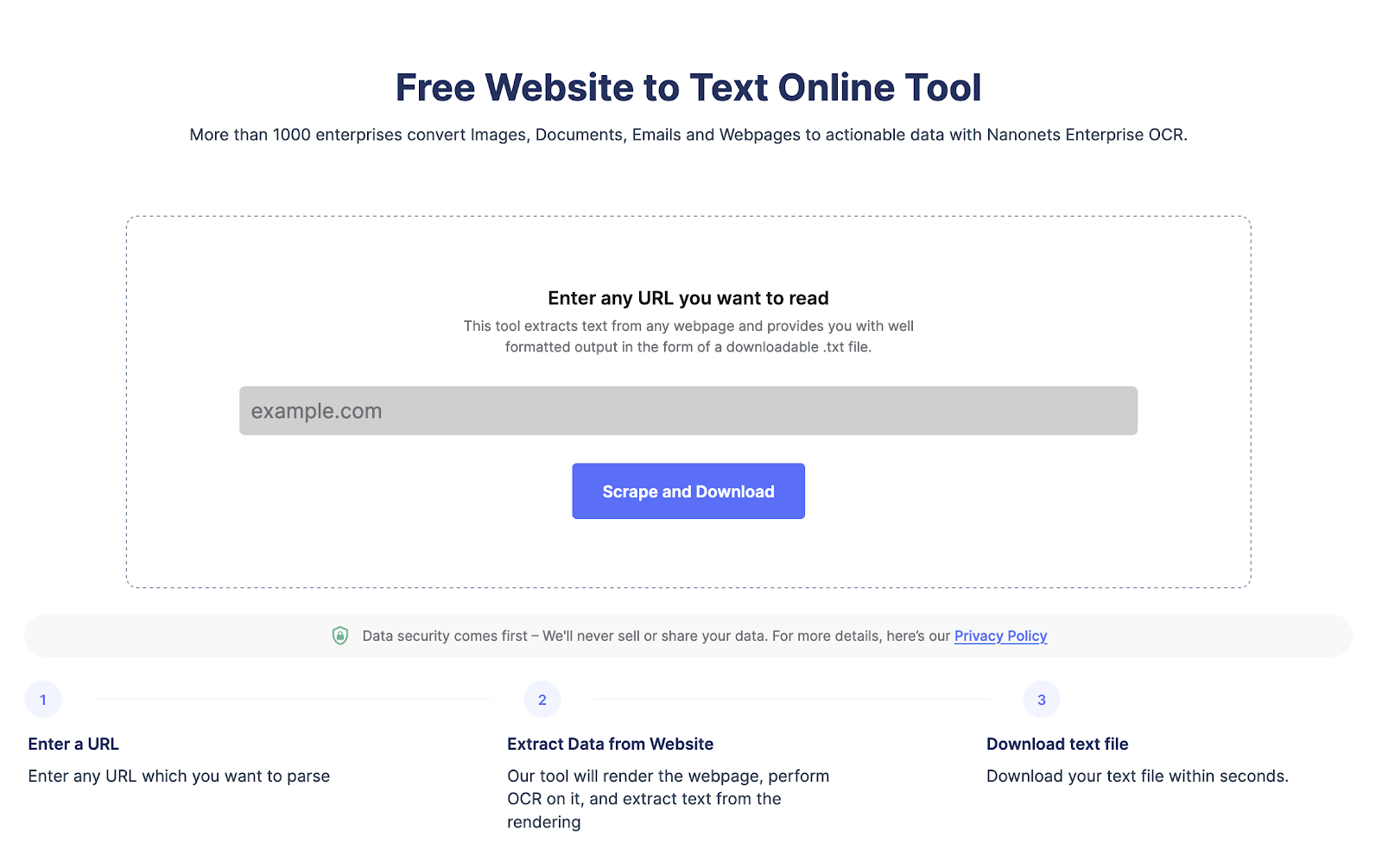

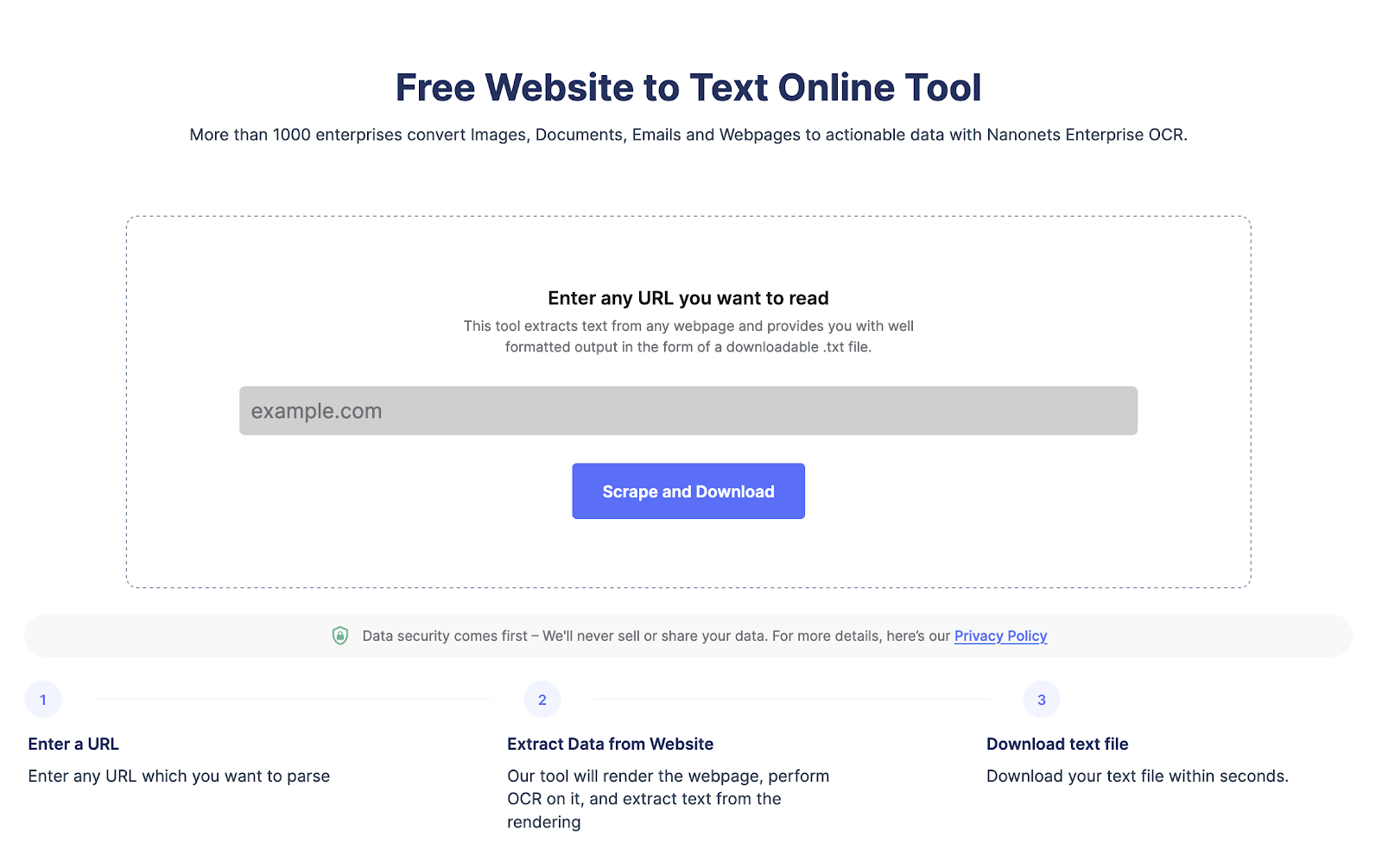

Wilt u gegevens van een webpagina extraheren?

Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Wat is Selenium Web Scraping?

Webscraping is het proces van het extraheren van gegevens van websites. Het is een krachtige techniek die een revolutie teweegbrengt in het verzamelen en analyseren van gegevens. Met enorme online gegevens is webschrapen een essentieel hulpmiddel geworden voor bedrijven en particulieren.

Selenium is een open-source webontwikkelingstool die wordt gebruikt om webbrowsingfuncties te automatiseren. Het is ontwikkeld in 2004 en wordt voornamelijk gebruikt om websites en apps automatisch te testen in verschillende browsers, maar het is nu een populaire tool geworden voor webscraping. Selenium kan worden gebruikt met meerdere programmeertalen, waaronder Python, Java en C#. Het biedt robuuste API's voor interactie met webpagina's, waaronder navigeren, klikken, typen en scrollen.

Selenium webschrapen verwijst naar het gebruik van de Selenium browserautomatiseringstool met Python om gegevens van websites te extraheren. Met Selenium kunnen ontwikkelaars programmatisch een webbrowser besturen, wat betekent dat ze met websites kunnen communiceren alsof ze menselijke gebruikers zijn.

Waarom Selenium en Python gebruiken voor webscraping?

Python is een populaire programmeertaal voor webscraping omdat het veel bibliotheken en frameworks heeft die het gemakkelijk maken om gegevens van websites te extraheren.

Het gebruik van Python en Selenium voor webschrapen biedt verschillende voordelen ten opzichte van andere webschraptechnieken:

- Dynamische websites: Dynamische webpagina's worden gemaakt met behulp van JavaScript of andere scripttalen. Deze pagina's bevatten vaak zichtbare elementen zodra de pagina volledig is geladen of wanneer de gebruiker ermee communiceert. Selenium kan met deze elementen communiceren, waardoor het een krachtig hulpmiddel is om gegevens van dynamische webpagina's te schrapen.

- Gebruikersinteracties: Selenium kan gebruikersinteracties zoals klikken, formulierinzendingen en scrollen simuleren. Hiermee kunt u websites schrapen die gebruikersinvoer vereisen, zoals inlogformulieren.

- Foutopsporing: Selenium kan worden uitgevoerd in debug-modus, waarmee u door het schraapproces kunt stappen en kunt zien wat de schraper bij elke stap doet. Dit is handig voor het oplossen van problemen wanneer er iets misgaat.

Vereisten voor webschrapen met Selenium:

Python 3 is op uw systeem geïnstalleerd.

Selenium-bibliotheek geïnstalleerd. Je kunt het installeren met behulp van pip met de volgende opdracht:

pip install SeleniumWebDriver geïnstalleerd.

WebDriver is een afzonderlijk uitvoerbaar bestand dat Selenium gebruikt om de browser te besturen. Hier zijn de links die ik heb gevonden om WebDriver te downloaden voor de meest populaire browsers:

Als alternatief, en dit is de gemakkelijkste manier, kunt u de WebDriver ook installeren met behulp van een pakketbeheerder zoals web driver-manager. Hierdoor wordt automatisch de juiste WebDriver voor u gedownload en geïnstalleerd. Om web driver-manager te installeren, kunt u de volgende opdracht gebruiken:

pip install webdriver-managerHaal binnen enkele seconden de volledige tekst uit de webpagina!

Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Een stapsgewijze handleiding voor seleniumwebschrapen

Stap 1: installeren en importeren

Voordat we beginnen, hebben we ervoor gezorgd dat we Selenium en een geschikte driver hebben geïnstalleerd. In dit voorbeeld gebruiken we de Edge-driver.

from selenium import webdriver

from Selenium.webdriver.common.keys import Keys

from Selenium.webdriver.common.by import ByStap 2: Installeer en open WebDriver

We kunnen een nieuw exemplaar van de Edge-driver maken door de volgende code uit te voeren:

driver = webdriver.Edge()Stap 3: Toegang tot de website via Python

Vervolgens moeten we toegang krijgen tot de website van de zoekmachine. In dit geval gebruiken we Bing.

driver.get("https://www.bing.com")Stap 4: Zoek specifieke informatie die u aan het schrapen bent

We willen het aantal zoekresultaten voor een bepaalde naam extraheren. We kunnen dit doen door het HTML-element te zoeken dat het aantal zoekresultaten bevat

results = driver.find_elements(By.XPATH, "//*[@id='b_tween']/span")Stap 5: Doe het samen

Nu we alle stukjes hebben, kunnen we ze combineren om de zoekresultaten voor een bepaalde naam te extraheren.

try:

search_box = driver.find_element(By.NAME, "q")

search_box.clear()

search_box.send_keys("John Doe") # enter your name in the search box

search_box.submit() # submit the search

results = driver.find_elements(By.XPATH, "//*[@id='b_tween']/span")

for result in results:

text = result.text.split()[1] # extract the number of results

print(text)

# save it to a file

with open("results.txt", "w") as f:

f.write(text)

except Exception as e:

print(f"An error occurred: {e}")Stap 6: Sla de gegevens op

Ten slotte kunnen we de geëxtraheerde gegevens opslaan in een tekstbestand.

met open(“results.txt”, “w”) als f:

f.write(text)Een proxy gebruiken met Selenium Wire

Selenium Wire is een bibliotheek die de functionaliteit van Selenium uitbreidt doordat u HTTP-verzoeken en -antwoorden kunt inspecteren en wijzigen. Het kan bijvoorbeeld ook worden gebruikt om eenvoudig een proxy voor uw Selenium WebDriver te configureren

Seleniumdraad installeren

pip install selenium-wireStel de proxy in

from selenium import webdriver

from Selenium.webdriver.chrome.options import Options

from seleniumwire import webdriver as wiredriver

PROXY_HOST = 'your.proxy.host'

PROXY_PORT = 'your_proxy_port'

chrome_options = Options()

chrome_options.add_argument('--proxy-server=http://{}:{}'.format(PROXY_HOST, PROXY_PORT))

driver = wiredriver.Chrome(options=chrome_options)Gebruik Selenium Wire om verzoeken te inspecteren en aan te passen.

for request in driver.requests:

if request.response:

print(request.url, request.response.status_code, request.response.headers['Content-Type'])In de bovenstaande code doorlopen we alle verzoeken van de WebDriver tijdens de webscraping-sessie. Voor elk verzoek controleren we of er een reactie is ontvangen en drukken we de URL, statuscode en het inhoudstype van de reactie af

Selenium gebruiken om alle titels van een webpagina te extraheren

Hier is een voorbeeld van Python-code die Selenium gebruikt om alle titels van een webpagina te schrapen:

from selenium import webdriver

# Initialize the webdriver

driver = webdriver.Chrome()

# Navigate to the webpage

driver.get("https://www.example.com")

# Find all the title elements on the page

title_elements = driver.find_elements_by_tag_name("title")

# Extract the text from each title element

titles = [title.text for title in title_elements]

# Print the list of titles

print(titles)

# Close the webdriver

driver.quit()In dit voorbeeld importeren we eerst de webstuurprogrammamodule van Selenium en initialiseren we vervolgens een nieuwe instantie van het Chrome-webstuurprogramma. We navigeren naar de webpagina die we willen schrapen en gebruiken vervolgens de methode find_elements_by_tag_name om alle titelelementen op de pagina te vinden.

Vervolgens gebruiken we een lijstbegrip om de tekst uit elk titelelement te extraheren en de resulterende lijst met titels op te slaan in een variabele met de naam titels. Ten slotte drukken we de lijst met titels af en sluiten we de instantie van het webstuurprogramma.

Houd er rekening mee dat u de Selenium- en Chrome-webstuurprogrammapakketten in uw Python-omgeving moet hebben geïnstalleerd om deze code te laten werken. Je kunt ze installeren met behulp van pip, zoals zo:

pip install selenium chromedriver-binaryZorg er ook voor dat u de URL in het stuurprogramma bijwerkt. verkrijg een methode om naar de webpagina te verwijzen die u wilt schrapen.

Conclusie

Kortom, webscraping met Selenium is een krachtig hulpmiddel om gegevens van websites te extraheren. Hiermee kunt u het proces van het verzamelen van gegevens automatiseren en u veel tijd en moeite besparen. Met Selenium kunt u net als een menselijke gebruiker communiceren met websites en de gegevens die u nodig hebt efficiënter extraheren.

Als alternatief kunt u tools zonder code gebruiken, zoals Nanonets' tool voor het schrapen van websites om eenvoudig alle tekstelementen uit HTML te extraheren. Het is volledig gratis te gebruiken.

Extraheer tekst van elke webpagina met slechts één klik. Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Veelgestelde vragen:

Is Selenium beter dan BeautifulSoup?

Selenium en BeautifulSoup zijn tools die verschillende doelen dienen bij webscraping. Terwijl Selenium voornamelijk wordt gebruikt voor het automatiseren van webbrowsers, is BeautifulSoup een Python-bibliotheek voor het ontleden van HTML- en XML-documenten.

Selenium is beter dan BeautifulSoup als het gaat om het schrapen van dynamische webpagina's. Dynamische webpagina's worden gemaakt met behulp van JavaScript of andere scripttalen. Deze pagina's bevatten vaak elementen die pas zichtbaar zijn als de pagina volledig is geladen of totdat de gebruiker ermee communiceert. Selenium kan met deze elementen communiceren, waardoor het een krachtig hulpmiddel is om gegevens van dynamische webpagina's te schrapen.

Aan de andere kant is BeautifulSoup beter dan Selenium bij het parseren van HTML- en XML-documenten. BeautifulSoup biedt een eenvoudige en intuïtieve interface voor het ontleden van HTML- en XML-documenten en het extraheren van de gegevens die u nodig hebt. Het is een lichtgewicht bibliotheek waarvoor geen webbrowser nodig is, waardoor het in sommige gevallen sneller en efficiënter is dan Selenium.

Samengevat, of Selenium beter is dan BeautifulSoup hangt af van de taak. Als u gegevens van dynamische webpagina's moet schrapen, dan is Selenium de betere keuze. Als u echter HTML- en XML-documenten moet parseren, dan is BeautifulSoup de betere keuze.

Moet ik Selenium of Scrapy gebruiken?

Selenium wordt voornamelijk gebruikt voor het automatiseren van webbrowsers en is het meest geschikt voor het schrapen van gegevens van dynamische webpagina's. Als u moet communiceren met webpagina's die elementen bevatten die niet zichtbaar zijn totdat de pagina volledig is geladen of totdat de gebruiker ermee communiceert, dan is Selenium de betere keuze. Selenium kan ook communiceren met webpagina's die authenticatie of andere gebruikersinvoerformulieren vereisen.

Scrapy daarentegen is een op Python gebaseerd webscraping-framework dat is ontworpen om gegevens van gestructureerde websites te schrappen. Het is een krachtige en flexibele tool die veel functies biedt voor het crawlen en scrapen van websites. Het kan worden gebruikt om gegevens van meerdere pagina's of websites te schrapen en complexe schraptaken uit te voeren, zoals het volgen van links en het omgaan met paginering. Scrapy is ook efficiënter dan Selenium wat betreft geheugen en verwerkingsbronnen, waardoor het een betere keuze is voor grootschalige webschrapprojecten.

Of u Selenium of Scrapy moet gebruiken, hangt af van de specifieke vereisten van uw webscrapingproject. Als u gegevens van dynamische webpagina's moet schrapen of moet communiceren met webpagina's die authenticatie of andere gebruikersinvoer vereisen, dan is Selenium de betere keuze. Als u echter gegevens van gestructureerde websites moet schrapen of complexe schraptaken moet uitvoeren, dan is Scrapy de betere keuze.

Welke taal is het beste voor webscraping?

Python is een van de meest populaire talen voor webscraping vanwege het gebruiksgemak, een grote selectie aan bibliotheken en krachtige scraping-frameworks zoals Scrapy, requests, beautifulSoup en Selenium. Python is ook gemakkelijk te leren en te gebruiken, waardoor het een uitstekende keuze is voor beginners

Veel programmeertalen kunnen worden gebruikt voor webscraping, maar sommige zijn beter geschikt voor de taak dan andere. De beste taal voor webscraping is afhankelijk van verschillende factoren, zoals de complexiteit van de taak, de doelwebsite en uw persoonlijke voorkeur.

Andere talen zoals R, JavaScript en PHP kunnen ook worden gebruikt, afhankelijk van de specifieke vereisten van uw webscrapingproject.

Waarom is selenium belangrijk bij webschrapen?

Selenium is om verschillende redenen een belangrijk hulpmiddel bij webschrapen:

Dynamische webpagina's schrapen: veel websites gebruiken tegenwoordig dynamische inhoud en gebruikersinteracties om gegevens weer te geven. Dit betekent dat veel inhoud op de website wordt geladen via JavaScript of AJAX. Selenium is zeer effectief in het schrapen van deze dynamische websites omdat het kan communiceren met elementen op de pagina en gebruikersinteracties zoals scrollen en klikken kan simuleren. Dit maakt het gemakkelijker om gegevens te schrapen van websites die sterk afhankelijk zijn van dynamische inhoud. Het is het meest geschikt voor het afhandelen van cookies en sessies, geautomatiseerd testen, cross-browser compatibiliteit en schaalbaarheid:

Kun je Selenium en BeautifulSoup samen gebruiken?

Ja, je kunt ze samen gebruiken. Selenium heeft voornamelijk interactie met webpagina's en simuleert gebruikersinteracties zoals klikken, scrollen en het invullen van formulieren. Aan de andere kant is BeautifulSoup een Python-bibliotheek die wordt gebruikt voor het ontleden van HTML- en XML-documenten en het extraheren van gegevens daaruit. Door Selenium en BeautifulSoup te combineren, kunt u een krachtige tool voor webschrapen maken om met webpagina's te communiceren en er gegevens uit te halen. Selenium kan dynamische inhoud en gebruikersinteracties aan, terwijl BeautifulSoup HTML kan ontleden en gegevens uit de paginabron kan extraheren.

Het is echter vermeldenswaard dat het gebruik van beide tools samen meer middelen kan vergen en langzamer kan zijn dan slechts één. Het is dus essentieel om de vereisten van uw webscrapingproject te evalueren en de juiste tools voor de klus te kiezen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://nanonets.com/blog/web-scraping-with-selenium/