Dit artikel is gepubliceerd als onderdeel van het Data Science-blogathon.

Bron: Canva

Introductie

In dit artikel heb ik een lijst samengesteld met twaalf belangrijke vragen over Transfer Learning die je als leidraad zou kunnen gebruiken om meer vertrouwd te raken met het onderwerp en ook om een effectief antwoord te formuleren om te slagen in je volgende studie. interview.

Sollicitatievragen over Transfer Learning

Hieronder volgen enkele interviewwinnende vragen met gedetailleerde antwoorden over Transfer Learning.

Vraag 1: Wat is Transfer Learning in NLP? Leg uit met voorbeelden.

Antwoord: Transfer Learning is een ML-benadering waarbij een model dat is getraind voor een brontaak, wordt hergebruikt voor andere gerelateerde taken (doeltaak).

Gewoonlijk worden modellen ontwikkeld en getraind om geïsoleerde taken uit te voeren. Om onze middelen echter goed te benutten en de trainingstijd te verkorten, kan de kennis die is opgedaan met een model dat in één taak wordt gebruikt (brontaak), opnieuw worden gebruikt als uitgangspunt voor andere gerelateerde taken (doeltaken).

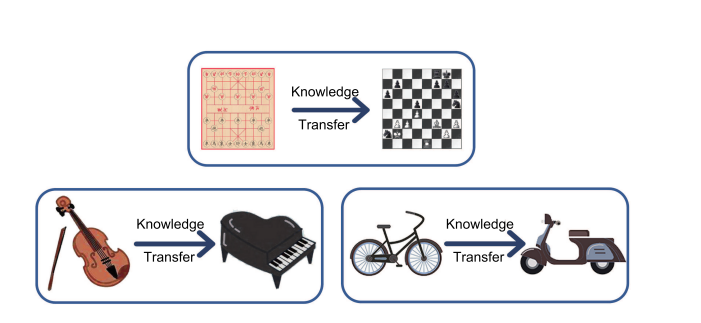

Hoe meer gerelateerde taken, hoe gemakkelijker het voor ons is om onze kennis over te dragen of te gebruiken. Enkele eenvoudige voorbeelden zijn:

In wezen is Transfer Learning geïnspireerd door het vermogen van mensen om kennis die is verzameld uit een gerelateerd domein (brondomein) over te dragen/te gebruiken/te generaliseren om de leerprestaties van de taak in het doeldomein te verbeteren. Laten we dit begrijpen met behulp van de volgende voorbeelden:

Voorbeeld 1: Laten we zeggen dat je weet hoe je Xiangqi moet spelen, en als je nu wilt leren schaken, gezien de overlap, zou het gemakkelijker voor je zijn om te leren, aangezien je de kennis van Xiangqi kunt toepassen/generaliseren tijdens het leren/spelen van schaken en leer snel.

Voorbeeld 2: Stel dat je weet hoe je viool moet spelen, dus op zijn minst enige kennis (d.w.z. muzieknoten/nuances, enz.) die je hebt verzameld tijdens het spelen/leren en begrijpen van de viool, kan worden toegepast bij het leren piano spelen en snel leren .

Voorbeeld 3: Evenzo, als u goed thuis bent in fietsen, zou het nuttig zijn om die "kennis / ervaring" te gebruiken terwijl u probeert te leren fietsen.

We leren niet alles vanaf het begin in elk van deze scenario's. We dragen kennis over en passen deze toe/generaliseren van wat we in het verleden hebben geleerd!

Afbeelding 1: we kunnen intuïtieve voorbeelden van overdrachtsleren afleiden (Bron: Arxiv)

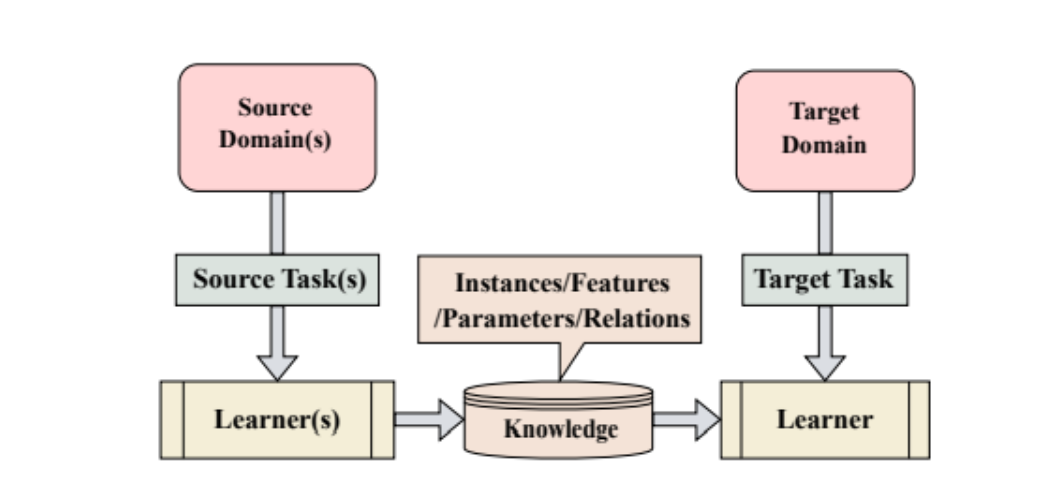

Tijdens overdrachtsleren verwijst de toepassing van kennis naar het benutten van de attributen en kenmerken van de brontaak, die worden toegepast en in kaart worden gebracht op de doeltaak.

Figuur 2: Illustratie van Transfer Learning waarbij kennis de vorm zou kunnen hebben van instanties/kenmerken/parameters/relaties (Bron: Arxiv)

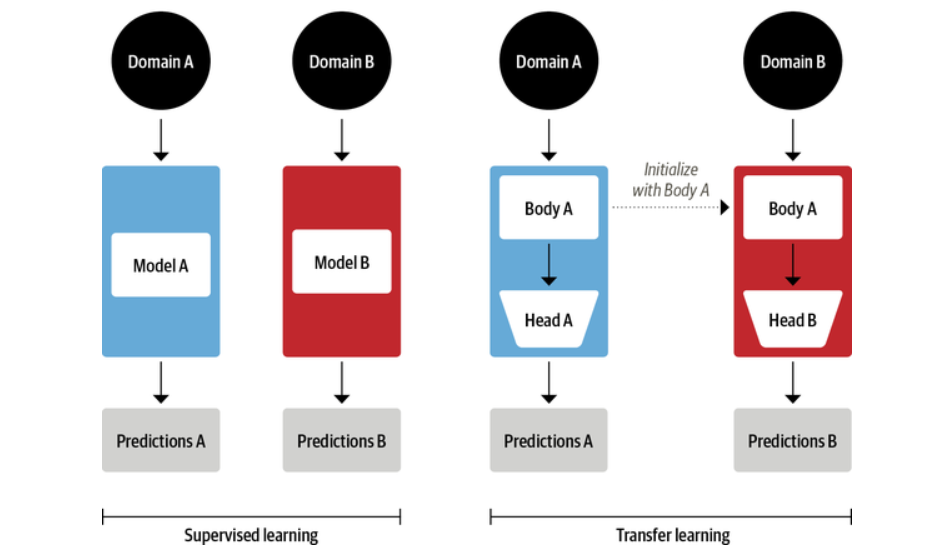

Tijdens overdrachtsleren wordt de basis van een vooraf getraind model (dat al heeft geleerd om 1 te doen) hergebruikt en wordt een ongetraind hoofd met een paar dichte lagen bevestigd (om 2 te leren). De lichaamsgewichten leren brede kenmerken van het brondomein, die worden gebruikt om een nieuw model voor de nieuwe doeltaak te initialiseren.

Figuur 3: Traditioneel begeleid leren (links) Vs. Transfer Learning (rechts) (Bron: NLP met boek Transformers)

Opmerking: De toegepaste kennis heeft niet noodzakelijkerwijs een gunstig effect op nieuwe taken. In vraag 9 gaan we hier op in.

Vraag 2: Waarom zouden we Transfer Learning gebruiken?

Antwoord: Wanneer de doeltaak weinig gerelateerd is aan het brondomein + de taak, is het aanbevolen om gebruik te maken van Transfer Learning, aangezien dit ons kan helpen bij de volgende aspecten:

1. Bespaart tijd: Het vanaf nul trainen van een groot model kost veel tijd, van enkele dagen tot weken. Deze behoefte kan worden ingeperkt door gebruik te maken van de vooraf getrainde modelkennis (bronmodel).

2. Bespaart hulpbronnen + zuinig + milieuvriendelijk: Omdat het niet nodig is om het model vanaf het begin te trainen. Daardoor spaart het hulpbronnen en is het economisch en milieuvriendelijk.

3. Helpt bij het bouwen van effectieve modellen wanneer gelabelde gegevens schaars zijn: In scenario's waarin we heel weinig data tot onze beschikking hebben, kan met behulp van transfer learning een effectief machine learning-model worden gebouwd met weinig trainingsdata.

4. Betere prestaties: Tijdens de positieve overdracht levert het vaak betere resultaten op dan een model dat is getraind met begeleid leren vanuit het niets.

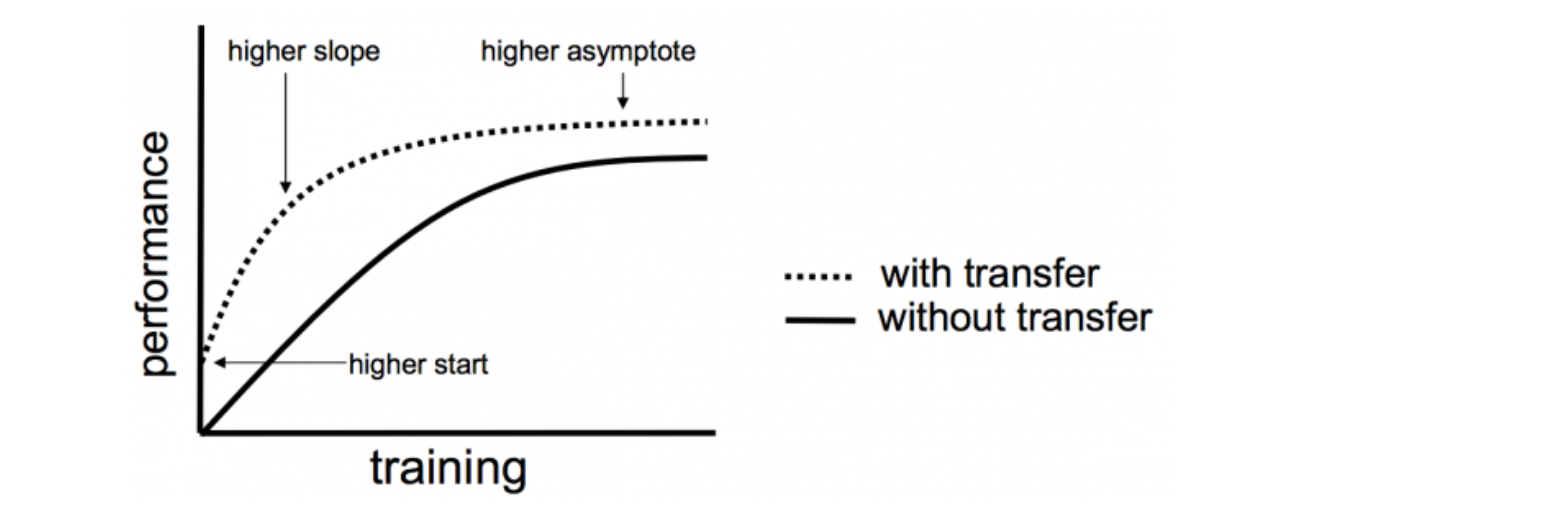

Figuur 4: Effect van Transfer Learning op de prestaties van het model (Bron: Machine Learning Mastery)

Vraag 3: Maak een lijst van de verschillende soorten overdrachtsleren.

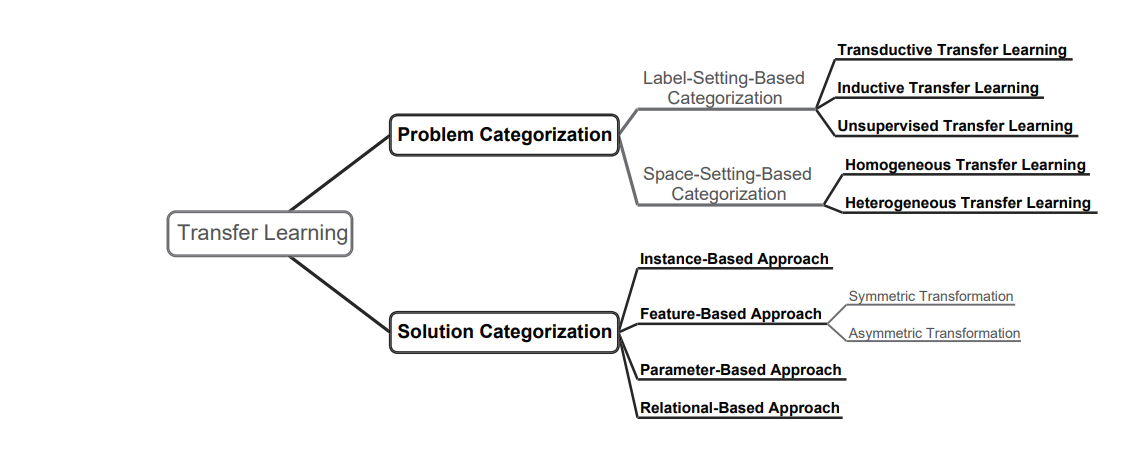

Antwoord: Transfer Learning kan worden ingedeeld op basis van Probleem en Oplossing. Het volgende diagram somt vrijwel alles op.

Figuur 5: Soorten overdrachtsleren (Bron: Arxiv)

1. Probleemcategorisatie:

Op label-instelling gebaseerde categorisering:

- Transductief overdrachtsleren

- Inductief overdrachtsleren

- Leren zonder toezicht

Op ruimte-instelling gebaseerde categorisering:

- Homogeen overdrachtsleren

- Heterogeen overdrachtsleren

2. Oplossingscategorisering:

- Op instanties gebaseerde benadering

- Op functies gebaseerde benadering

- Op parameters gebaseerde benadering

- Op relaties gebaseerde benadering

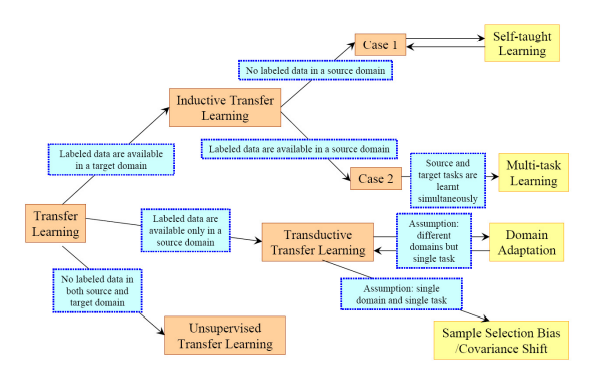

Vraag 4: Leg meer uit over op labels gebaseerde transferleercategorisering.

Antwoord: Zoals we eerder kort hebben besproken, kan Transfer Learning op basis van labelsetting als volgt worden geclassificeerd:

- Transductief overdrachtsleren

- Inductief overdrachtsleren

- Leren zonder toezicht

Afbeelding 6: Grafische weergave van op labels gebaseerd transferleren (Bron: Arxiv)

a) Inductief overdrachtsleren: Hierin zijn de bron- en doeldomeinen hetzelfde. De bron- en doeltaken verschillen echter nog steeds van elkaar.

Het model gebruikt inductieve vooroordelen van de brontaak om de prestaties van de doeltaak te helpen verbeteren.

Afhankelijk van het feit of het brontaakdomein al dan niet gelabelde gegevens heeft, kan inductief transferleren verder worden geclassificeerd als multitaskleren en autodidactisch leren (sequentieel leren).

Afbeelding 7: Soorten inductieve overdracht van leren (Bron: Arxiv)

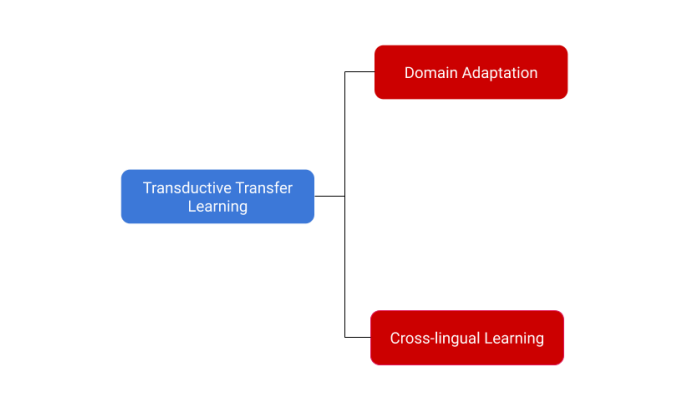

b) Transductief overdrachtsleren: Hierin hebben de bron- en doeltaken overeenkomsten. De overeenkomstige domeinen zijn echter verschillend.

Hierin heeft het brondomein veel gelabelde gegevens, terwijl het doeldomein geen gelabelde gegevens heeft, of als dat wel het geval is, zijn er maar heel weinig gelabelde voorbeelden.

Transductief overdrachtsleren kan verder worden ingedeeld in domeinaanpassing en meertalig leren.

Figuur 8: Soorten Transductief Transferleren (Bron: Arxiv)

c) Overdrachtsleren zonder toezicht:

Unsupervised learning verwijst naar het gebruik van AI-algoritmen om patronen in datasets te vinden, inclusief datapunten die noch geclassificeerd noch gelabeld zijn.

Unsupervised Transfer Learning lijkt sterk op Inductive Transfer Learning.

Ondanks de gelijkenis van het bron- en doeldomein, verschillen de bron- en doeltaken.

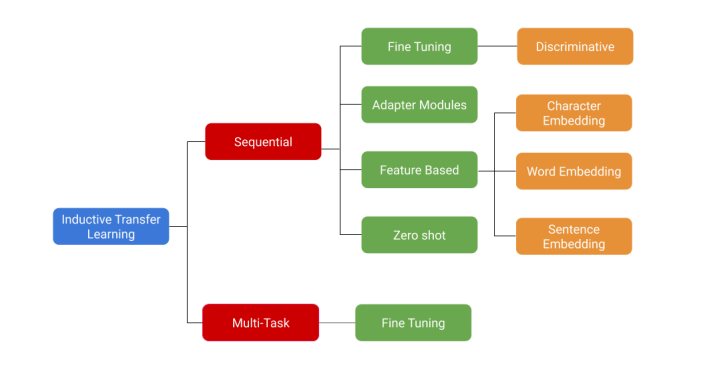

Vraag 5: Wat is sequentiële overdracht leren? Leg de typen uit.

Antwoord: Sequential Transfer Learning is het proces van het achtereenvolgens leren van meerdere taken. Laten we zeggen dat de kennis moet worden overgedragen naar meerdere taken (T1, T2, …. Tn). Bij elke tijdstap wordt een bepaalde taak aangeleerd. In tegenstelling tot leren met meerdere taken, is het langzamer maar heeft het enkele voordelen, vooral als alle taken niet beschikbaar zijn tijdens de training.

Sequentieel overdrachtsleren kan verder worden onderverdeeld in de volgende vier categorieën:

- Scherpstellen

- Adaptermodules

- Functie-gebaseerd

- Nul schot

1. Fijnafstemming: Een gegeven vooraf getraind model (M) met gewichten W wordt gebruikt om een nieuwe functie f te leren die de parameters f(W) = W' afbeeldt. De parameters kunnen op alle lagen worden gewijzigd of slechts op een beperkt aantal. Bovendien kan het leertempo voor de verschillende lagen verschillend zijn.

Het verfijnen van een vooraf getraind model op een enorme semi-gerelateerde dataset bleek een eenvoudige en effectieve aanpak voor veel problemen.

2. Adaptermodules: Een bepaald vooraf getraind model met gewichten W wordt geïnitialiseerd met een nieuwe reeks parameters die kleiner zijn dan W.

3. Functiegebaseerd: Het richt zich op het leren van enkele representaties op verschillende niveaus, bijvoorbeeld karakter, woord,

insluiting van zinnen of alinea's. De set inbeddingen (E) van model M blijft ongewijzigd.

4. Nulschot: Gegeven een voorgetraind model M met W, wordt er geen trainingsprocedure toegepast om nieuwe parameters te optimaliseren/leren.

Vraag 6: Wat is multitasken leren?

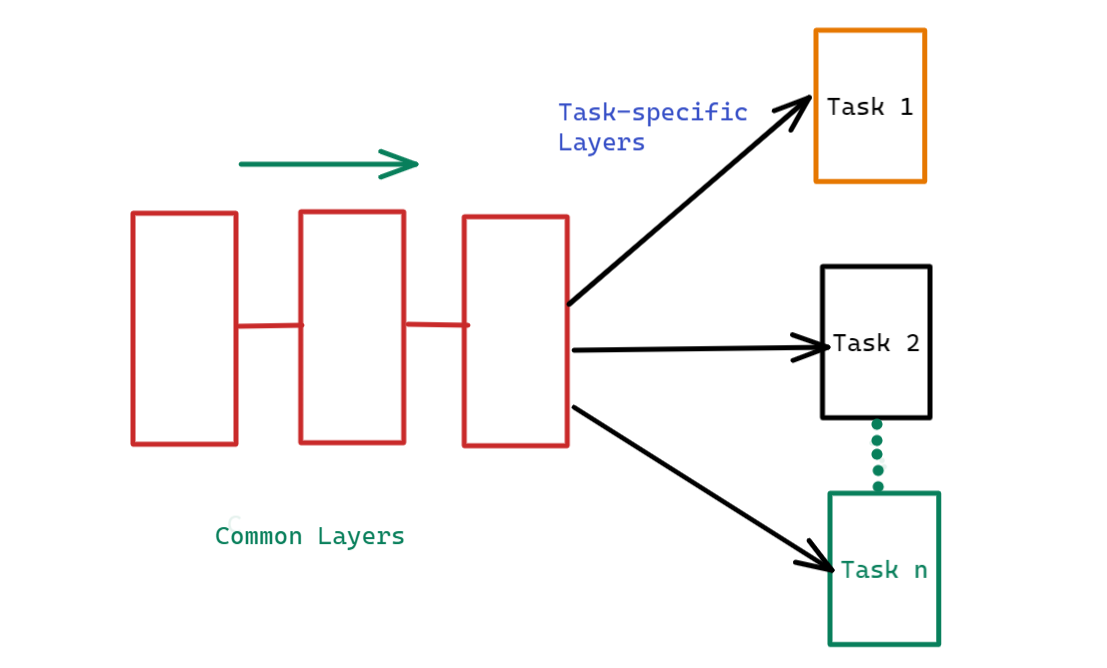

Antwoord: Multi-Task Learning is het proces waarbij meerdere taken tegelijkertijd worden geleerd. Voor een bepaald voorgetraind model M wordt het leren bijvoorbeeld overgebracht naar meerdere taken (T1, T2, · · ·, Tn).

Figuur 9: Leren met meerdere taken (Bron: Auteur)

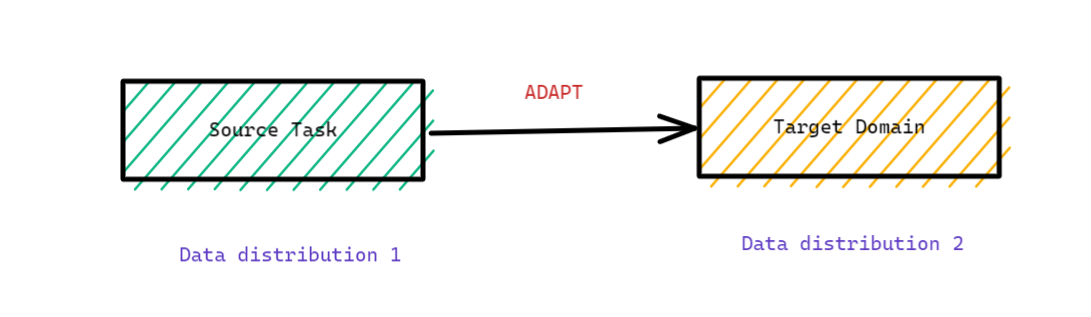

Vraag 7: Wat is domeinaanpassing?

Antwoord: Domeinaanpassing is het aanpassen van de brontaak aan een nieuw doeldomein. Dit wordt meestal gebruikt wanneer we willen dat het model een andere gegevensdistributie leert in het doeldomein. Er kan bijvoorbeeld een review worden geschreven over ziekenhuizen in het eerste domein (brondomein) en over klinieken in het tweede domein (doeldomein).

Domeinaanpassing is gunstig wanneer de nieuwe trainingstaak een andere verdeling heeft of wanneer we zeer weinig gegevens hebben.

Afbeelding 10: diagram dat de domeinaanpassing illustreert waarbij de brontaak met een bepaalde gegevensdistributie wordt aangepast aan het doeldomein van verschillende gegevensdistributie (Bron: auteur)

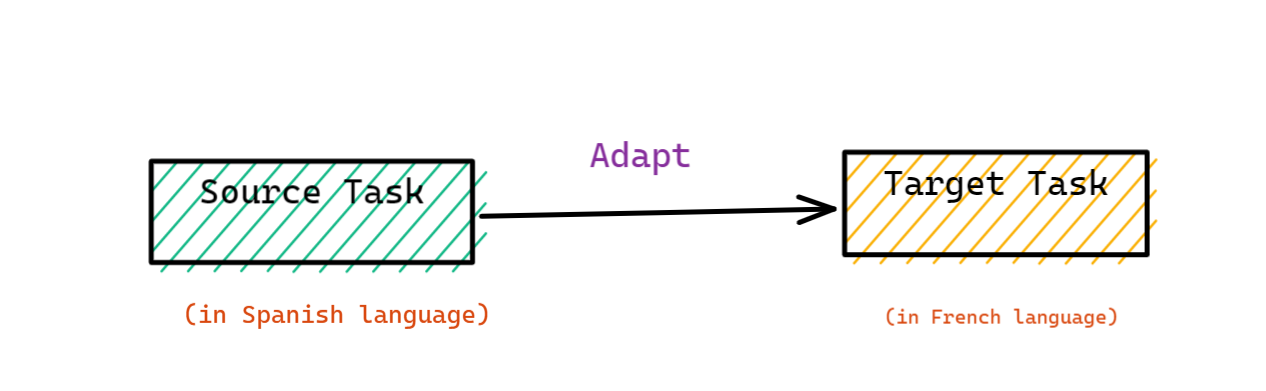

Vraag 8: Wat betekent meertalig leren?

Antwoord: Cross-lingual learning past de brontaak aan een andere taal in het doeldomein aan. Dit is gunstig wanneer we een taal met veel middelen gebruiken om overeenkomstige taken te leren in een taalomgeving met weinig middelen. Een model dat is getraind voor de Spaanse taal kan bijvoorbeeld worden afgestemd op de dataset in de Franse taal, wat geen positieve overdracht garandeert.

Afbeelding 11: diagram dat meertalig leren illustreert (Bron: auteur)

Vraag 9: Verbetert overdrachtsleren altijd de resultaten?

Antwoord: Nee. Soms heeft de overdrachtsmethode een negatieve invloed op de uitvoering van de nieuwe doeltaak, een zogenaamde "Negatieve overdracht.” Dit gebeurt meestal wanneer de bron- en doeltaken niet vergelijkbaar genoeg zijn, waardoor de eerste trainingsronde erg ver weg is.

Algoritmen komen niet altijd overeen met wat we als vergelijkbaar beschouwen, waardoor het een uitdaging is om de grondbeginselen en normen te begrijpen van welk type training voldoende is.

Daarom is een van de belangrijkste uitdagingen bij het werken met de overdrachtsleermethode het zorgen voor een positieve overdracht tussen gerelateerde taken en het voorkomen van de negatieve overdracht tussen minder gerelateerde taken.

Leren fietsen kan ons bijvoorbeeld niet helpen om snel viool te leren spelen.

Figuur 11: Schematische weergave van kennisoverdracht tussen niet-gerelateerde domeinen/taken

Bovendien garandeert de gelijkenis tussen de domeinen niet dat de kennisoverdracht het leren zal vergemakkelijken. Soms kunnen de overeenkomsten tussen de domeinen bedrieglijk zijn.

Ondanks dat Spaans en Frans bijvoorbeeld neolatijnse talen zijn met een hechte verwantschap, kunnen mensen die Spaans leren moeite hebben met het leren van Frans, zoals het gebruik van de verkeerde woordenschat of vervoeging. Dit gebeurt omdat het leren van de woordvorming, het gebruik, de uitspraak, de vervoeging, enz. in het Frans kan worden belemmerd door eerdere succesvolle vertrouwdheid met de taal in het Spaans.

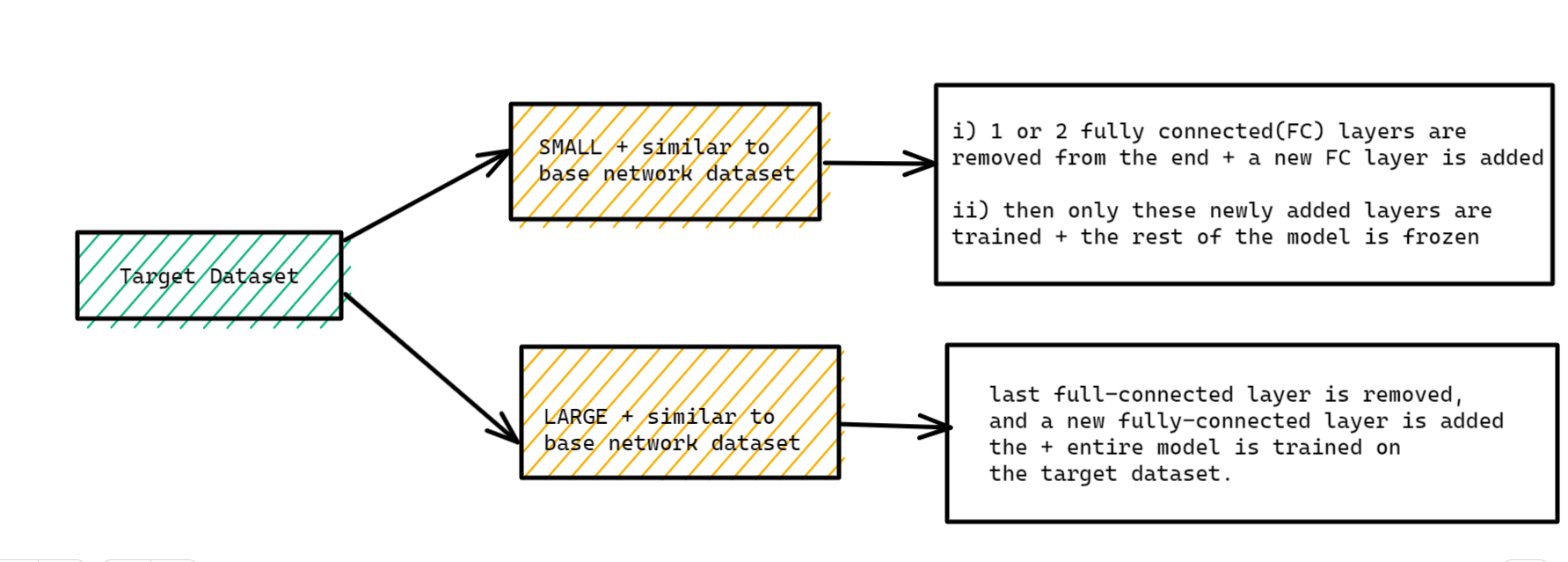

Vraag 10: Wat moeten we doen als we de doeldataset hebben die lijkt op de basisnetwerkdataset?

Antwoord: Het hangt er dus van af of de doeldataset klein of groot is.

Zaak 1:De doeldataset is klein + vergelijkbaar met de basisnetwerkdataset: aangezien de trainingsdataset klein is, kan het vooraf getrainde netwerk worden afgestemd op de doeldataset. Dit kan echter leiden tot overfitting. Bovendien kan de doeldataset ook verschillende klassen hebben, waardoor het aantal klassen in de doeltaak kan veranderen. In dergelijke gevallen worden een of twee volledig verbonden lagen vanaf het einde verwijderd en wordt een nieuwe volledig verbonden laag toegevoegd die voldoet aan het aantal nieuwe klassen. Nu worden alleen deze nieuw toegevoegde lagen getraind en de rest van het model is bevroren.

Zaak 2:De doeldataset is enorm + vergelijkbaar met de dataset van het basisnetwerk: aangezien we voldoende gegevens tot onze beschikking hebben, wordt de laatste volledig verbonden laag verwijderd en wordt een nieuwe volledig verbonden laag toegevoegd met het juiste aantal klassen. Nu wordt het hele model getraind op de doeldataset. Dit zorgt ervoor dat het model wordt afgestemd met behoud van dezelfde architectuur op een nieuwe grote dataset (doeldataset).

Afbeelding 12: diagram dat verschillende scenario's illustreert wanneer de doeldataset vergelijkbaar is met de dataset van het basisnetwerk

Vraag 11: Wat moeten we doen als we een doeldataset hebben die verschilt van een basisnetwerkdataset?

Antwoord: Nogmaals, het hangt ervan af of de doeldataset klein of groot is.

Zaak 1: Het doelwit dataset is klein + verschilt van de dataset van het basisnetwerk: Aangezien de doeldataset anders is, zal het niet helpen om gebruik te maken van de hoogwaardige functies van het vooraf getrainde model. In plaats daarvan moeten de meeste lagen vanaf het einde in een vooraf getraind model worden verwijderd, en vervolgens moeten nieuwe lagen worden toegevoegd die voldoen aan het aantal klassen in de nieuwe (dwz doel) dataset. Op deze manier kunnen de functies op laag niveau van de vooraf getrainde modellen worden benut en kan de rest van de lagen worden getraind om in de nieuwe dataset te passen. Soms is het nuttig om het hele netwerk te trainen na het toevoegen van een nieuwe laag aan het einde.

Zaak 2: De doeldataset is enorm + verschilt van de basisnetwerkdataset: Aangezien de doeldataset groot is en verschilt van het brondomein/de brontaak, zou de optimale aanpak zijn om de laatste lagen uit het vooraf getrainde model te verwijderen en nieuwe lagen met het juiste aantal klassen toe te voegen, waarna het hele netwerk moet worden getraind zonder een laag te bevriezen.

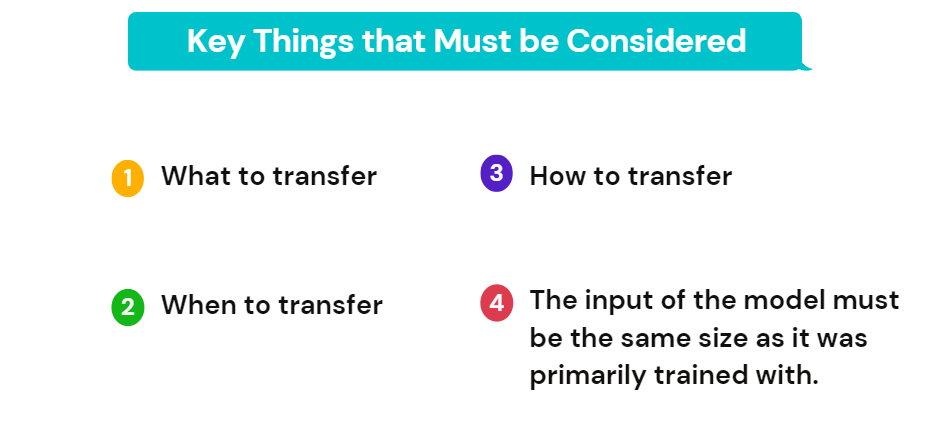

Vraag 12: Welke belangrijke zaken moeten worden overwogen tijdens overdrachtsleren?

Antwoord: Tijdens het proces van transferleren moeten de volgende kernvragen worden beantwoord:

Afbeelding 13: Belangrijkste zaken waarmee rekening moet worden gehouden tijdens het overdrachtsleren

Wat over te dragen: Dit is de eerste en meest cruciale stap in het hele proces. Om de doeltaak effectiever te maken, moet worden bepaald welk deel van de kennis bronspecifiek is en wat de bron en het doel met elkaar gemeen hebben.

Wanneer overstappen: Zoals we hebben besproken, vermindert kennisoverdracht soms de prestatie van de doeltaak (ook wel negatieve overdracht genoemd). Dit gebeurt meestal wanneer de bron- en doeldomeinen/taken niet vergelijkbaar zijn. We moeten ernaar streven om overdrachtsleren zo te gebruiken dat het de prestatie van de doeltaak verbetert en niet verslechtert. Daarom moet goed worden overwogen wanneer wel en wanneer niet moet worden overgedragen.

Hoe over te zetten: Als het wat en hoe is bepaald, schatten we in hoe we de kennis over domeinen/taken kunnen overdragen. Dit omvat het aanpassen van de bestaande algoritmen en verschillende technieken.

Ten slotte moet de invoer van het model dezelfde grootte hebben waarmee het in de eerste plaats is getraind. Als dat niet zo is, moet er een voorbewerkingsstap worden toegevoegd om de invoer te verkleinen.

Conclusie

Dit artikel behandelt de twaalf belangrijkste interviewwinnende vragen. Door deze interviewvragen als leidraad te gebruiken, kunt u de grondbeginselen van het onderwerp beter begrijpen en een effectief antwoord formuleren en presenteren aan de interviewer.

- Bij transferleren kan de kennis die is opgedaan met een model dat in de brontaak wordt gebruikt, worden hergebruikt als uitgangspunt voor andere gerelateerde doeltaken.

- Transfer Learning bespaart trainingstijd en middelen en helpt bij het bouwen van concurrerende modellen, zelfs wanneer gelabelde gegevens schaars zijn.

- Sequential Transfer Learning is het proces van het achtereenvolgens leren van meerdere taken. Laten we zeggen dat de kennis moet worden overgedragen naar meerdere taken (T1, T2, …. Tn).

- Het verfijnen van een vooraf getraind model op een enorme semi-gerelateerde dataset bleek een eenvoudige en effectieve aanpak voor veel problemen.

- Multi-Task Learning is het proces waarbij meerdere taken tegelijk tegelijkertijd worden geleerd. Voor een gegeven voorgetraind model M wordt het leren bijvoorbeeld overgebracht naar meerdere taken (T1, T2, · · ·, Tn).

- Tijdens de negatieve overdracht zijn we getuige van verslechtering van de prestaties van het model.

- Tijdens overdrachtsleren moeten we nadenken over wat we moeten overdragen, wanneer en hoe we moeten overdragen. Bovendien moet de invoer van het model dezelfde grootte hebben als waarmee het primair is getraind.

De in dit artikel getoonde media zijn geen eigendom van Analytics Vidhya en worden naar goeddunken van de auteur gebruikt.

Verwant

- Coinsmart. Europa's beste Bitcoin- en crypto-uitwisseling.Klik Hier

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2022/11/comprehensive-guide-for-interview-questions-on-transfer-learning/